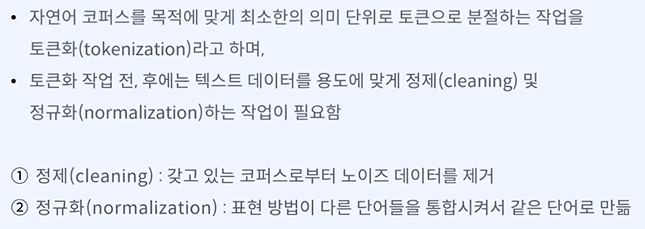

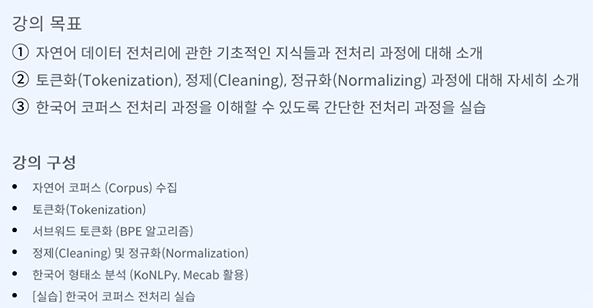

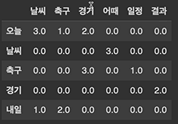

목표 - 수집한 자연어 코퍼스를 정제하는 과정 및 정규화 과정에 대해 이해할 수 있다. 정규화 - 대문자 -> 소문자, 다양한 이모지 통일 등 노이즈 - 판단 필요하다! -> 완벽하게 없애는 것은 힘들기 때문에 합의점이 필요하다. 분포가 너무 적은 것들은 제거도 한다. 쓰임이 없는 단어, 비효율적인 단어들 모델의 응답시간도 단축 가능하다. 정보량이 많지 않다. -> 무언가를 분류하는데 도움이 되지 않는다. 없다면 pip nltk로 설치도 필요하다. 대명사, 관사들이 들어있다. 내가 필요하다고 생각하다면 리스트에서 제거해주면 된다. 단어가 많이 줄어든 것을 볼 수 있다. 조사는 붙어있는데 어떻게 제거할까? 특수 문자중에서도 웃음과 같은 것은 긍정으로 볼 수 있지 않나...? 빈도에 따라 중요성도 생각해 볼..