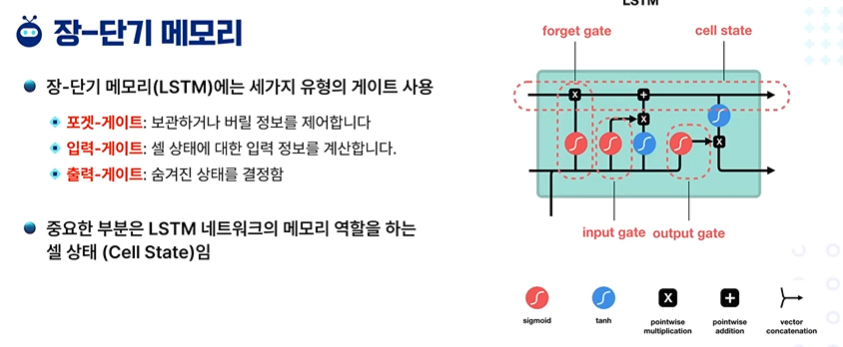

6주 차 - LLM1차시 - BERTBERT - Bidirectional Encoder Representations from Transformer로 Google의 모델이다.대규모 텍스트를 통해 언어 표현을 Pre-trained 하여 언어 이해를 하고, 나중에 Downstream으로 학습한다.Pre-training 모델ELMo - 양방향 LSTMBERT - 양방향 AttentionGPT - 단방향 AttentionEmbeddingToken Embedding : 단어 벡터를 이용해 후속 분류 작업 시행Segment Embedding : 임의의 두 문장을 구분하는데 사용([SEP] 토큰도 있지만 서로 보완해 준다.)Position Embedding : 트랜스포머와 달리 trigonometric 기반이 아니다...