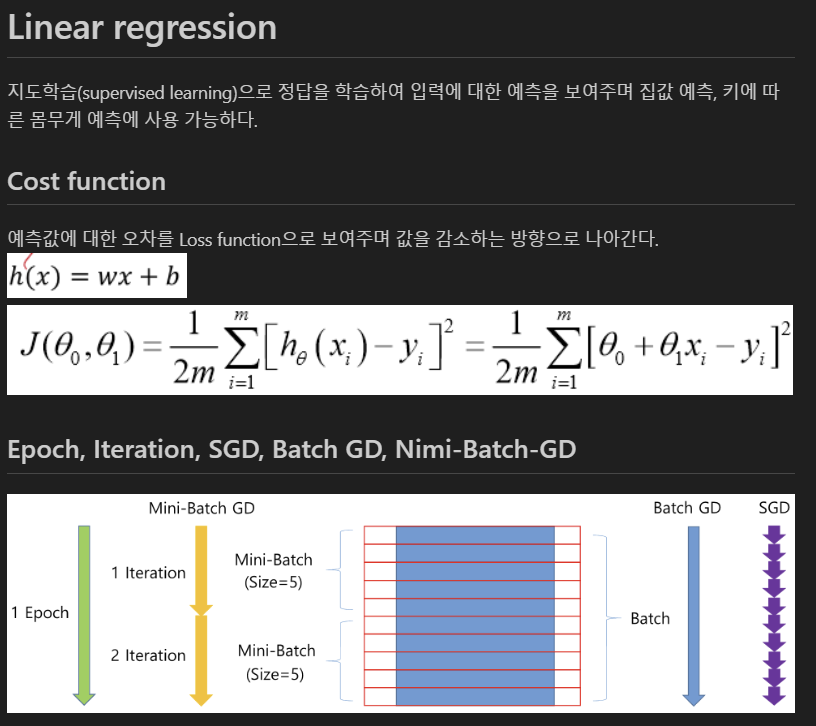

backpropagation backpropagation은 대부분의 인공지능의 파라미터 업데이트 방식이다. 우린 경사하강법을 통해 loss를 최소화 시키는 방향으로 학습한다. 기본적인 gradient 계산 방법이다. 이제 activation funcion(sigmoid, ReLU)와 여러 layer가 있는 NN에선 위와 같은 방식으로 backpropagation이 진행된다. 여기선 activation이 identity이기 때문에 미분하면 1이 나왔다. 여기선 첫번째 레이어의 파라미터를 구할 수 있게 된다. 그럼 저렇게 구한 미분값을 통해 학습률을 곱해서 원래의 파라미터에 빼게 된다. 이제 이러한 backpropagation에 여러 요소들을 추가하여 만든 optimization을 보겠따. optimizat..