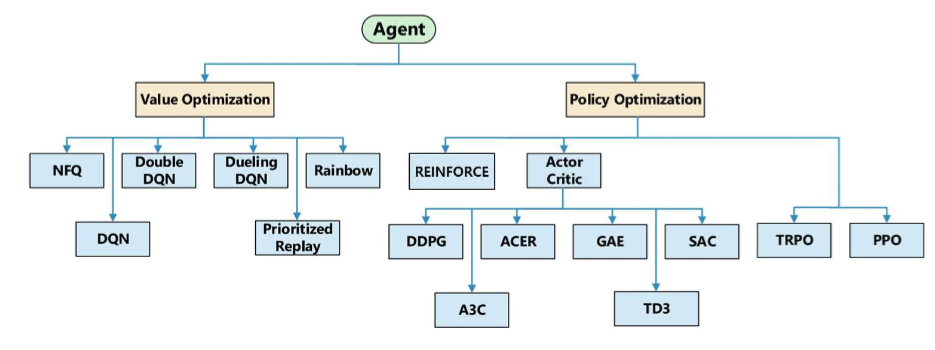

여태까지 진행했던 프로젝트의 끝이 났네요학습하는데 1000시나리오에 20시간도 넘게 걸리니 도저히 완벽하고, 다양한 학습에서 진행할 순 없더라고요그래도 한 시나리오는 완벽하게 끝내는 모델을 완성했습니다.https://kr.mathworks.com/matlabcentral/fileexchange/170616-rl-based-amr-controller RL-Based AMR ControllerUsing Reinforcement learning, we implemented AMR controller with MATLAB/Simulink.kr.mathworks.com코드는 여기서 확인해 볼 수 있습니다. https://www.youtube.com/watch?v=V8dMHNvj_tc발표 영상입니다.. ㅎㅎ.. 저..