기존 LiDAR,RADAR 구조에서 한계점을 느끼고 다시 작성하고 있습니다.

센서 퓨전을 하는데 오히려 리소스를 잡아먹어서 강화학습에 집중할 수 없는 것을 깨닫고 다시 센서 구성부터 변경을 진행하였습니다.

LiDAR와 Ultrasonic을 이용해 원거리, 근거리 정보 모두 잘 획득해 보려고 합니다.

데이터를 잘 획득하는 것을 볼 수 있습니다.

구성은 이렇게 되어있습니다.

이걸 Simulink로 빼서 루프를 돌리면 일단 해결입니다.

smulink로 빼서 scenario로 달리는 것이 아닌 input을 통해 변하는 것으로 바꾸면 위와 같이 변하게 됩니다.

이제 RL Agent에 관찰값으로 넣어줘야 합니다.

여기서부터 Agent를 설정해주고 환경을 설정해주고 해야하는데 이게 기억이 안나서 천천히 찾아보며 작성하겠습니다.

기본적인 구성하는 법이 여기 나와있네요

Custom Training Loop with Simulink Action Noise - MATLAB & Simulink - MathWorks 한국

다음 MATLAB 명령에 해당하는 링크를 클릭했습니다. 명령을 실행하려면 MATLAB 명령 창에 입력하십시오. 웹 브라우저는 MATLAB 명령을 지원하지 않습니다.

kr.mathworks.com

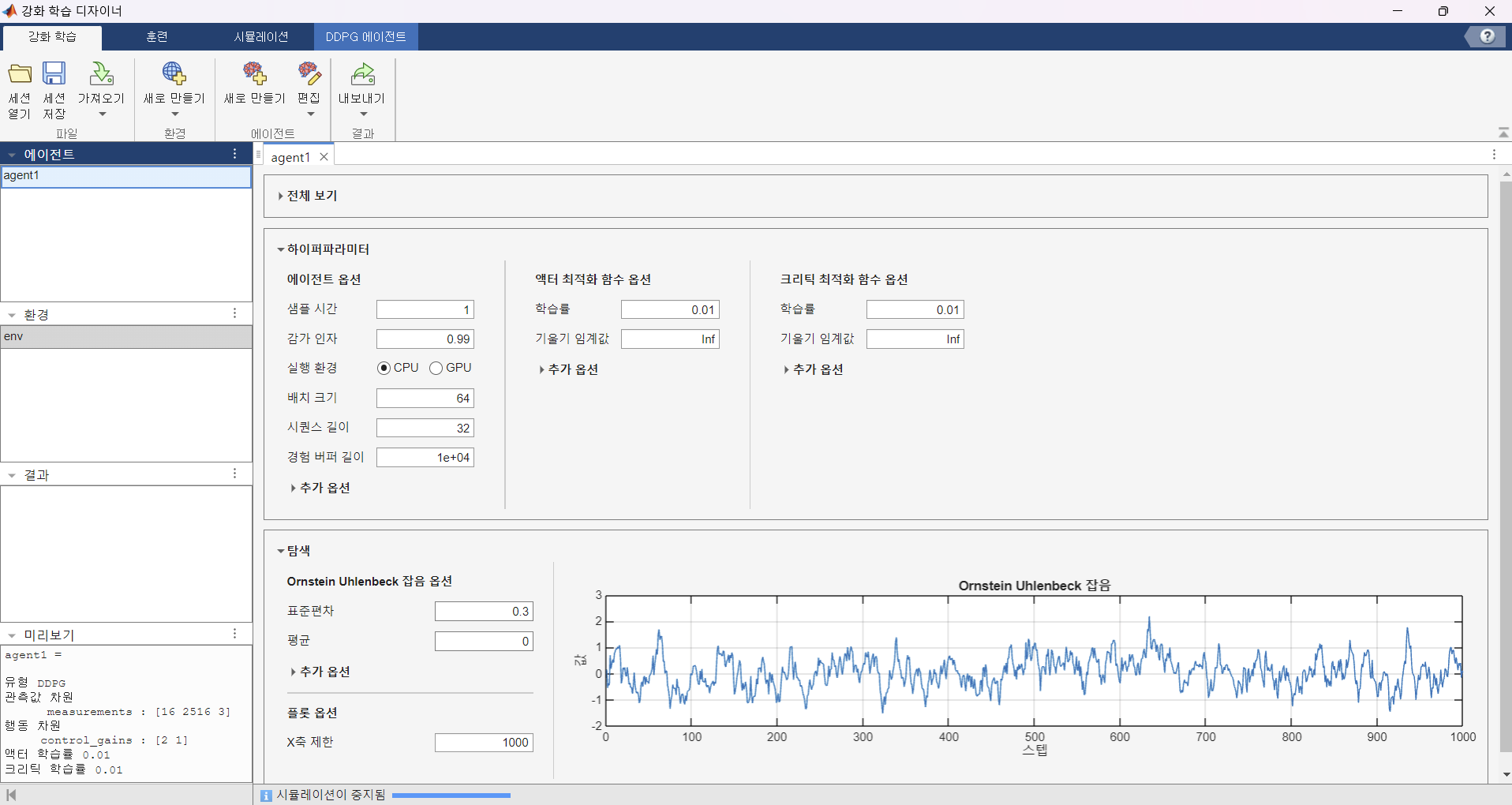

강화학습 디자이너 사용

Create Agents Using Reinforcement Learning Designer - MATLAB & Simulink - MathWorks 한국

다음 MATLAB 명령에 해당하는 링크를 클릭했습니다. 명령을 실행하려면 MATLAB 명령 창에 입력하십시오. 웹 브라우저는 MATLAB 명령을 지원하지 않습니다.

kr.mathworks.com

환경 만들기

https://kr.mathworks.com/help/reinforcement-learning/ug/create-custom-simulink-environments.html

Create Custom Simulink Environments - MATLAB & Simulink - MathWorks 한국

다음 MATLAB 명령에 해당하는 링크를 클릭했습니다. 명령을 실행하려면 MATLAB 명령 창에 입력하십시오. 웹 브라우저는 MATLAB 명령을 지원하지 않습니다.

kr.mathworks.com

clear; clc;

mdl = "RLmodel";

obsInfo = rlNumericSpec([16 2516 3]);

actInfo = rlNumericSpec([2 1], ...

LowerLimit = -1, ...

UpperLimit = 1);

obsInfo.Name = "measurements";

actInfo.Name = "control_gains";

agentBlk = mdl + "/RL Agent";

env = rlSimulinkEnv(mdl,agentBlk,obsInfo,actInfo);

하다보니 만들 긴 했는데 좀 확인해봐야 겠네요 ㅎ....

'인공지능 > 강화학습' 카테고리의 다른 글

| AI 경진대회 - Scenario Reader와 RL Agent 묶기 (1) | 2024.07.20 |

|---|---|

| AI 경진대회 준비 - MATLAB ultrasonic 센서 오류 (0) | 2024.07.17 |

| AI 경진대회 - 환경 구성하기 matlab Driving Scenario Designer (0) | 2024.07.15 |

| 강화학습 12강 - Deep RL 심화 (1) | 2024.06.09 |

| 강화학습 11강 - 강화학습 실습 예제 (1) | 2024.06.08 |