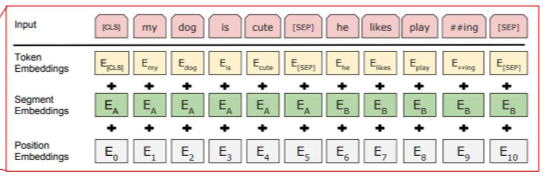

10강 - Language Modeling with GPTMasked LM - encoder에서 진행되는 과정으로 마스킹된 단어를 맞춘다.BERT가 Transformer의 Encoder를 사용하여 양방향 Self attention을 진행하여 마스킹된 단어 예측을 진행한다.LM - Decoder에서 진행되는 과정으로 다음 단어를 예측한다.input으로 이전 단어를 넣고 가장 높은 확률을 가지는 단어를 가지고 오는 것을 반복한다. == auto aggressiveGPT가 Transformer를 사용해 단방향 Self attention을 진행하고, 이전 컨택스트만 가지고 예측한다.n-gram : n개 단어까지만 확인해서 그 확률이 어떻게 되는지 보고, 높은 단어를 가지고 온다 - 통계적 방법앞의 문맥을 버리고..