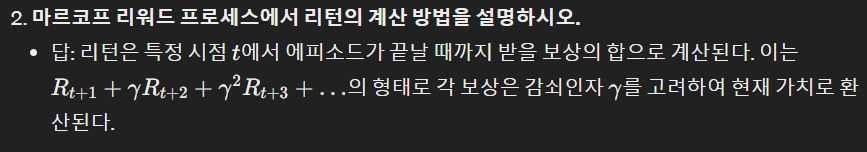

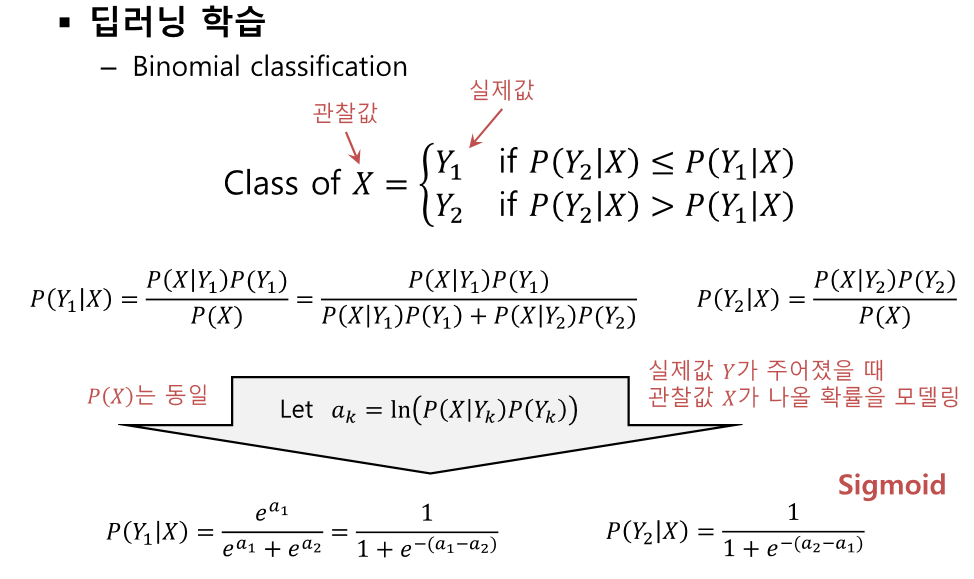

PDF 파일을 기반으로 다양한 유형의 딥러닝 문제를 만들어보겠습니다. 이는 해당 주제에 대한 이해를 평가하고 학습을 돕기 위한 것입니다.1. OX 문제문제: 딥러닝은 머신러닝과는 다르게 항상 인간의 개입 없이 데이터의 특징을 스스로 학습할 수 있다. (O/X)정답: X해설: 딥러닝은 인간의 뇌를 모방한 신경망 구조를 사용하여 복잡한 데이터의 패턴을 학습하지만, 특정 애플리케이션에서는 인간의 개입이 필요할 수 있습니다. 예를 들어, 레이블링 작업이나 데이터 전처리 과정에서는 인간의 도움이 필요할 수 있습니다.2. 서술형 문제문제: 머신러닝과 딥러닝의 주요 차이점 두 가지를 설명하시오.정답:구조적 차이: 머신러닝은 간단한 데이터 패턴 인식에 종종 사용되는 반면, 딥러닝은 인간의 뇌를 모방한 ..