https://arxiv.org/abs/2404.03275

DELTA: Decomposed Efficient Long-Term Robot Task Planning using Large Language Models

Recent advancements in Large Language Models (LLMs) have sparked a revolution across many research fields. In robotics, the integration of common-sense knowledge from LLMs into task and motion planning has drastically advanced the field by unlocking unprec

arxiv.org

기존 연구들은 장기 작업에 약하거나, 탐색하는데 과도한 시간이 걸리고, 변화에 대응력이 부족했습니다.

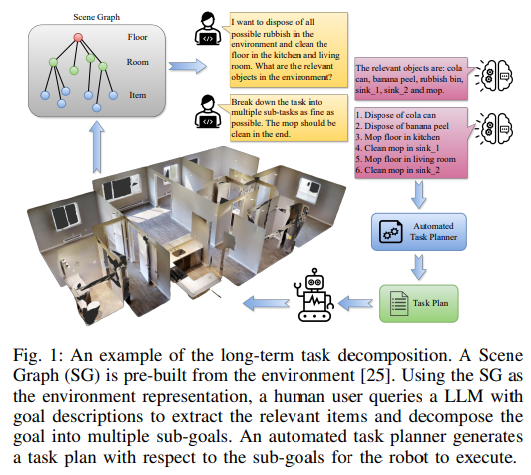

Robot에게 Semantic(의미적 정보)를 이해할 수 있는 것은 어려운데 이 것을 Scene Graph(SG)와 같은 고수준 표현으로 해결한다고 합니다.

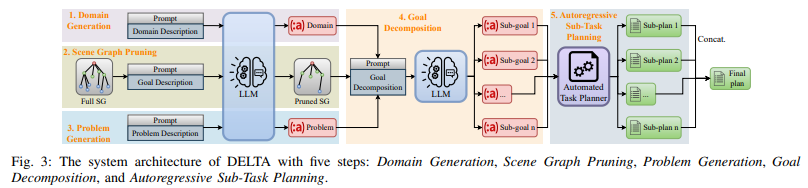

3가지로 나눠서 각각 LLM을 통해 생성합니다.

첫 번째는 문제를 분리해서 도메인을 설명하고, 객체 유형, 작업, 조건 및 효과를 정의하여 PDDL 파일로 생성하빈다.

두 번째는 필요한 정보만을 챙겨 SG로 만듭니다.

세 번째는 초기 상태와 목표 상태를 정의하여 PDDL 파일로 생성합니다.

네 번재는 이러한 3개의 파일을 합쳐 장기 목표를 의존성을 고려하여 연속적인 하위 목표로 분해하여 출력합니다.

마지막으로 각 목표를 순차적으로 실행하여 하위 목표를 계획, 실행하여 상태를 업데이트 하여 최종적으로 완료하게 됩니다.

LLM+P가 생각보다 일을 못하는 것이 놀라웠고, DELTA가 왜 잘하는지는 명확하게 모르겠습니다.

📝 LLM+P 성능 저하 원인 번역 및 정리

📄 원문 번역:

LLM+P는 자연어(NL)를 공식 계획 언어(formal planning language)로 변환함으로써,

- PC 도메인에서 약간 더 높은 성공률을 달성할 수 있었습니다.

- 또한 최적 계획 길이와 탐색된 노드 수(optimal plan length and number of expanded nodes)도 도달했습니다.

하지만,

- Dining 도메인에서는 성공률이 단 4%에 불과했으며,

- Cleaning 및 Office 도메인에서는 전혀 성공하지 못했습니다.

🚫 주요 실패 원인:

🔑 가장 큰 실패 원인: 계획기 타임아웃(planner timeout) 발생

- LLM+P는 원본 Scene Graph(SG)를 그대로 사용합니다.

- 원본 SG에는 매우 많은 객체(items)가 포함되어 있습니다.

- LLM은 SG의 객체를 대부분 PDDL 문제 파일로 변환하긴 했지만,

- 객체 수가 많을수록 계획 문제의 복잡도는 기하급수적으로 증가합니다.

- 그 결과, 계획 탐색 시간이 과도하게 길어져 타임아웃이 발생합니다.

🧠 핵심 원인 정리:

| 원인 | 설명 | 영향 |

| Scene Graph 과다 사용 | 모든 객체 포함 → 불필요한 정보까지 계획에 반영 | 탐색 공간 과대화 |

| 객체 수 증가 → 복잡도 폭발 | 객체 수가 늘수록 계획 탐색 시간 기하급수적 증가 | 계획 타임아웃 발생 |

| 목표 분해 없음 | 장기 목표를 작은 작업으로 나누지 않음 | 계획 실패율 증가 |

| 계획기 과부하 | 너무 많은 상태와 행동 탐색 필요 | 성공률 저하 및 실행 실패 |

✅ 정리 및 대안:

🔎 왜 LLM+P의 성능이 낮았을까?

- 원본 SG 사용 → 불필요한 정보 포함 → 탐색 과부하

- 객체 수 증가 → 탐색 공간 확대 → 계획 시간 초과

- 목표 분해(goal decomposition) 부재 → 장기 작업 처리 실패

🚀 DELTA의 해결책:

- ✅ Scene Graph 정제(SG Pruning): 불필요한 객체 제거 → 탐색 공간 축소

- ✅ 목표 분해 적용: 장기 목표 → 하위 목표로 분해 → 계획 시간 단축 & 성공률 증가

- ✅ 자동 회귀적 계획: 단계별 탐색으로 타임아웃 문제 해결

💡 결론:

➡️ LLM+P의 낮은 성능 원인: 과도한 탐색 공간과 목표 분해 부재로 계획 타임아웃 발생

➡️ DELTA의 개선점: SG 정제 + 목표 분해로 탐색 공간 최소화 → 성공률 대폭 향상 🚀

그렇게 대단한 프레임워크는 아니라고 생각했는데 그래도 좋긴 한가 보네요

| 핵심 문제 | - LLM 단독 사용 시 환각(hallucination) 및 실행 불가능한 계획 생성 - 장기 작업 계획 시 탐색 공간 폭발 및 계획 시간 과다 |

| 연구 목표 | - Scene Graph(SG)와 LLM 결합으로 장기 로봇 작업 계획을 효율적으로 수행 - 목표 분해(goal decomposition)로 계획 성공률 및 계산 효율성 향상 |

| 주요 기여 | 1️⃣ SG를 통한 환경 정보 정제로 계획 오류 감소 2️⃣ 목표 분해로 탐색 공간 축소 및 계획 시간 단축 3️⃣ 자동 회귀적 하위 작업 계획으로 작업 순서 일관성 확보 4️⃣ 모든 도메인에서 기존 모델 대비 우수한 성능 달성 |

| 방법론 단계 (5단계 파이프라인) | 1️⃣ 도메인 생성: - LLM이 자연어 도메인 지식을 PDDL 도메인 파일로 변환 2️⃣ Scene Graph 정제: - 불필요한 객체 제거 → 입력 토큰 수 감소 및 환각 방지 3️⃣ 문제 생성: - SG와 목표를 PDDL 문제 파일로 변환 (초기 및 목표 상태 포함) 4️⃣ 목표 분해: - 장기 목표 → 하위 목표 시퀀스로 자동 분해 (작업 간 의존성 고려) 5️⃣ 자동 회귀적 하위 작업 계획: - 각 하위 목표를 순차적으로 계획 및 실행하여 최종 계획 생성 |

| 실험 설정 | - 도메인: PC 조립, 식탁 세팅 (독립 작업) / 청소, 오피스 세팅 (의존 작업) - 비교 모델: LLM-As-Planner, LLM+P, LLM-GenPlan, SayPlan |

| 성과 및 결과 | - 성공률: DELTA가 모든 도메인에서 최고 성능 달성 - PC: 98%, Dining: 100%, Cleaning: 80%, Office: 74.7% - 계획 시간: 기존 모델 대비 최대 3000배 단축 - 탐색 노드 수: 평균 2000배 감소 - 목표 분해 효과: 성공률 +20%p 증가, 탐색 시간 대폭 감소 |

| 실패 원인 및 분석 | - 잘못된 조건(predicate) 생성: 37회 - 속성(attribute) 누락: 25회 - 목표(goal) 오류: 12회 - 계획 타임아웃: 21회 |

| 결론 | - 목표 분해 + SG 정제로 계획 성공률 및 효율성 극대화 - 의존성 있는 작업에서도 뛰어난 성능 달성 - 빠른 계획 수립과 높은 실행 가능성 확보 |

| 한계점 및 향후 연구 방향 | - 현재는 사전 계획 기반(offline planning) → 실시간 재계획(replanning) 지원 부족 - 향후 계획: - 동적 환경 적응성 강화 - 부분적 재계획 메커니즘 추가 - 실제 로봇 시스템 검증 및 적용 |

| 연구 적용 아이디어 (윤정호님 관점) | - 다중 에이전트 협력: 각 에이전트에 목표 분해 적용 → 작업 분배 최적화 - Vision-Language 통합: SG 실시간 업데이트 → 동적 환경 대응력 강화 - AGI 연구 확장: 지속적 데이터 수집 및 계획 개선으로 자율 연구 에이전트 구현 |

📝 DELTA 방법론 심층 분석 및 예시 중심 설명

DELTA(Decomposed Efficient Long-Term Robot Task Planning using LLMs)는 Scene Graph(SG)와 대규모 언어 모델(LLM)을 결합하여 장기 로봇 작업 계획을 효율적으로 생성하는 프레임워크입니다. 방법론은 5단계 파이프라인으로 구성되며, 각 단계에서 자연어 입력을 공식적인 계획 언어(PDDL)로 변환하고 작업을 하위 목표로 분해하여 계획 시간 단축과 성공률 향상을 달성합니다.

🚀 방법론 개요 및 문제 정의

DELTA는 주어진 장면 그래프(SG)와 자연어 목표 설명을 입력받아:

- PDDL 도메인 및 문제 파일 생성

- 장기 목표를 하위 목표로 분해

- 자동 계획기를 통해 실행 가능한 최종 계획 생성

이를 통해 로봇이 가정 환경 내에서 복잡한 연속 작업을 효율적으로 수행할 수 있도록 합니다.

🧩 DELTA의 5단계 방법론

각 단계의 설명 + 이미지 기반 예시를 통해 이해를 돕겠습니다.

1️⃣ 도메인 생성 (Domain Generation)

✅ 목적:

자연어로 된 도메인 지식을 형식적 계획 언어(PDDL)로 변환

⚙️ 작동 방식:

- 입력: 자연어 도메인 설명 (예: "로봇은 바닥을 청소할 수 있다")

- 처리: LLM이 객체 유형, 작업, 조건 및 효과를 정의

- 출력: PDDL 도메인 파일 생성

🧪 예시:

자연어 입력:

"로봇은 걸레가 깨끗할 때만 바닥을 청소할 수 있다. 청소 후 걸레는 더러워진다."

PDDL 출력 (mop_floor 액션):

(:action mop_floor

:parameters (?a - agent ?i - item ?r - room)

:precondition (and (agent_at ?a ?r) (item_is_mop ?i) (mop_clean ?i) (not (floor_clean ?r)))

:effect (and (floor_clean ?r) (not (mop_clean ?i))))

➡️ 핵심 포인트:

- 사전 조건: 로봇 위치, 걸레 상태, 바닥 상태 확인

- 효과: 바닥 청소 후 걸레가 더러워짐

2️⃣ Scene Graph 정제 (Scene Graph Pruning)

✅ 목적:

환경 내 불필요한 객체 제거 → 계획 오류 감소 및 계산 비용 절감

⚙️ 작동 방식:

- 입력: 전체 환경을 나타내는 SG + 자연어 목표

- 처리: LLM이 목표 달성에 필요 없는 항목 제거

- 출력: 정제된 SG

🧪 예시 (Fig. 1 기반):

환경 내 객체:

- 주방: 콜라 캔, 걸레, 싱크대 1, 싱크대 2

- 거실: 바나나 껍질, 쓰레기통

목표: "쓰레기를 버리고 바닥을 청소하라."

🔎 정제 전 SG: 모든 객체 포함

✅ 정제 후 SG: 콜라 캔, 바나나 껍질, 쓰레기통, 걸레, 싱크대 1, 싱크대 2만 유지

➡️ 이점:

- 입력 토큰 수 감소 → LLM 처리 속도 향상

- 불필요한 정보 제거 → 환각(hallucination) 및 오류 감소

3️⃣ 문제 생성 (Problem Generation)

✅ 목적:

정제된 SG와 자연어 목표를 PDDL 문제 파일로 변환

⚙️ 작동 방식:

- 입력: 정제된 SG + 목표 설명

- 처리: LLM이 초기 상태와 목표 상태 정의

- 출력: PDDL 문제 파일

🧪 예시 (Fig. 3 - Step 3 참조):

자연어 입력:

"콜라 캔과 바나나 껍질을 쓰레기통에 버리고, 거실과 주방의 바닥을 청소하라."

PDDL 문제 출력:

(:init

(item_at cola_can kitchen)

(item_at banana_peel living_room)

(item_at rubbish_bin kitchen)

(mop_clean mop)

(not (floor_clean kitchen))

(not (floor_clean living_room))

)

(:goal

(and

(item_disposed cola_can)

(item_disposed banana_peel)

(floor_clean kitchen)

(floor_clean living_room)

)

)

➡️ 핵심 포인트:

- 초기 상태: 객체 위치 및 상태 정의

- 목표 상태: 쓰레기 처분 및 바닥 청소 완료

4️⃣ 목표 분해 (Goal Decomposition)

✅ 목적:

장기 목표를 연속적인 하위 목표로 자동 분해 → 계획 탐색 시간 단축

⚙️ 작동 방식:

- 입력: PDDL 문제 파일

- 처리: LLM이 작업 순서 및 작업 간 의존성 고려하여 분해

- 출력: 하위 목표 목록

🧪 예시 (Fig. 1의 오른쪽 상자 참조):

목표: "모든 쓰레기 버리기 + 바닥 청소"

🔄 분해된 하위 목표:

- 콜라 캔을 쓰레기통에 버리기

- 바나나 껍질을 쓰레기통에 버리기

- 주방 바닥 청소

- 싱크대 1에서 걸레 청소

- 거실 바닥 청소

- 싱크대 2에서 걸레 청소

➡️ 이점:

- 탐색 공간 감소 → 계획 시간 95% 단축

- 작업 순서 오류 방지 (예: 걸레 청소 후 바닥 청소 필요성 반영)

5️⃣ 자동 회귀적 하위 작업 계획 (Autoregressive Sub-Task Planning)

✅ 목적:

각 하위 목표를 순차적으로 계획 및 실행하여 최종 계획 생성

⚙️ 작동 방식:

- 입력: 하위 목표 + PDDL 도메인/문제 파일

- 처리:

- 첫 번째 하위 목표 계획 → 실행 후 상태 업데이트

- 다음 하위 목표 계획에 업데이트된 상태 사용

- 모든 하위 계획 연결 → 최종 실행 계획 생성

🧪 예시 (Fig. 3 - Step 5 참조):

| 하위 목표 | 계획 단계 | 상태 변화 |

| 1. 콜라 캔 버리기 | 로봇 주방 이동 → 집기 → 쓰레기통에 버리기 | (item_disposed cola_can) |

| 2. 바나나 껍질 버리기 | 로봇 거실 이동 → 집기 → 주방으로 이동 후 버리기 | (item_disposed banana_peel) |

| 3. 주방 청소 | 걸레 가져오기 → 주방 청소 | (floor_clean kitchen) |

| 4. 걸레 청소 | 싱크대 1로 이동 → 걸레 세척 | (mop_clean mop) |

| 5. 거실 청소 | 거실로 이동 → 청소 | (floor_clean living_room) |

➡️ 최종 계획: 모든 하위 계획을 연결하여 실행 가능한 최적 경로 확보

🔍 전체 파이프라인 요약 (Fig. 3 종합)

1️⃣ Domain Generation: LLM이 자연어 도메인 지식을 PDDL 도메인 파일로 생성

2️⃣ Scene Graph Pruning: SG에서 필요 없는 객체 제거 → 입력 간소화

3️⃣ Problem Generation: 초기 및 목표 상태를 포함한 PDDL 문제 파일 생성

4️⃣ Goal Decomposition: 장기 목표를 하위 목표로 자동 분해

5️⃣ Autoregressive Planning: 각 하위 목표를 순차적으로 계획하여 최종 실행 계획 도출

🧠 결론 및 주요 인사이트

✅ DELTA의 장점:

- 목표 분해: 계획 시간 단축 및 성공률 향상

- Scene Graph 정제: 계산 비용 절감 및 오류 감소

- 자동 회귀 계획: 하위 작업 간 연속성 보장

✅ 적용 가능성:

- 가정용 로봇, 창고 물류 로봇 등 다양한 로봇 시스템에 적용 가능

- 다중 에이전트 협력 및 동적 환경 계획 문제로 확장 가능

💡 DELTA는 LLM과 전통 계획기의 장점을 결합하여, 복잡한 환경에서도 빠르고 안정적인 로봇 작업 계획을 가능하게 합니다! 🚀

1. 문제 정의 및 연구 동기

현대 로봇 시스템은 사람과 협력하여 가정이나 산업 환경에서 복잡한 작업을 수행해야 합니다. 이를 위해 작업 및 동작 계획(Task and Motion Planning, TAMP)이 필요합니다. 최근에는 대규모 언어 모델(LLMs)이 풍부한 상식과 시맨틱 지식을 제공할 수 있어 로봇 계획 문제 해결에 활용되고 있습니다.

하지만 LLMs만으로 계획을 생성하면 다음과 같은 문제가 발생합니다:

- 환각(hallucination): 잘못된 계획 생성

- 도메인 정보 부족: 환경에 대한 정보가 부족해 실행 불가능한 계획을 생성

- 장기 작업에 대한 취약성: LLM은 긴 작업 시 오류 발생률이 누적되어 성능 저하

이를 해결하기 위해 DELTA(Decomposed Efficient Long-Term Task planning)가 제안되었습니다. DELTA는 Scene Graph(SG)와 LLM을 결합하여 장기 로봇 작업을 효율적으로 분해하고 실행할 수 있도록 합니다.

2. 제안 방법: DELTA

DELTA는 5단계의 처리 파이프라인을 통해 복잡한 작업을 효율적으로 해결합니다.

2.1 시스템 아키텍처

- 도메인 생성:

- LLM이 자연어 입력을 받아 PDDL(Planning Domain Definition Language) 형식의 도메인 파일 생성

- 예시:

mop_floor작업은 바닥 청소 전후의 조건과 효과를 정의

- Scene Graph(장면 그래프) 정제:

- SG는 환경의 공간적, 시맨틱 관계를 나타내는 그래프

- 불필요한 객체 제거로 LLM 입력 토큰 수 감소 → 계산 비용 절감 및 정확도 향상

- 문제 생성:

- 정제된 SG와 사용자 목표를 기반으로 PDDL 문제 파일 생성

- 방 연결 관계, 객체 위치, 접근성 등을 반영

- 목표 분해:

- LLM이 장기 목표를 순차적인 하위 목표로 자동 분해

- 예시: "거실과 주방 바닥 청소" 작업 시, "모프 청소 → 주방 청소 → 모프 재청소 → 거실 청소" 순으로 분해

- 자동 회귀적 하위 작업 계획:

- 각 하위 문제를 자동 계획기로 해결

- 이전 하위 문제의 최종 상태를 다음 문제의 초기 상태로 사용

- 최종 계획은 모든 하위 계획의 연결 결과물

3. 실험 및 결과

3.1 평가 지표

- 성공률: 유효한 계획 생성 비율

- 계획 길이: 작업 수행에 필요한 단계 수

- 계획 시간: 계획 생성에 걸린 시간

- 탐색 노드 수: 탐색 중 생성된 노드 수 (낮을수록 효율적)

3.2 실험 설정

- 도메인:

- 독립적 하위 작업: PC 조립, 식탁 세팅

- 의존적 하위 작업: 청소, 홈 오피스 세팅

- 데이터셋: 3D Scene Graph 데이터셋 사용 (9~12개의 방, 최대 42개 객체 포함)

- 비교 모델:

- LLM-As-Planner: LLM만 사용 (계획 성능 낮음)

- LLM+P: 문제 파일만 생성 (계획 복잡도 증가 시 실패)

- LLM-GenPlan, SayPlan: 시맨틱 정보 사용 (단기 작업 우수, 장기 작업 취약)

3.3 결과 분석

| 모델 | PC 조립 | 식탁 세팅 | 청소 | 홈 오피스 |

|---|---|---|---|---|

| LLM-As-Planner | 70% | 38.7% | 0% | 0% |

| LLM+P | 76% | 4% | 0% | 0% |

| SayPlan | 69% | 71% | 54% | 40% |

| DELTA (GPT-4o) | 98% | 100% | 80% | 75% |

- DELTA의 우수성:

- 모든 도메인에서 가장 높은 성공률 달성

- 의존적 작업(청소, 오피스 세팅)에서 기존 모델 대비 최대 2배 성능 개선

- 효율성 측면:

- 계획 시간: 기존 모델 대비 최대 3000배 빠름

- 탐색 노드 수: 기존 대비 2000배 감소 → 계산 부담 완화

- 목표 분해 효과:

- 목표 분해 미적용 시, 탐색 노드 수 급증 및 타임아웃 발생

- 분해 적용 시 성공률 +20%p, 계획 시간 95% 단축

4. 결론 및 향후 과제

DELTA는 LLM의 시맨틱 이해력과 전통적 계획기의 탐색 최적화 능력을 결합하여 장기 작업을 빠르고 안정적으로 해결할 수 있습니다.

- 주요 기여:

- 장기 작업 분해 및 최적화를 통한 성공률 및 계획 시간 개선

- Scene Graph 기반 정보 정제로 계획 오류 감소

- 향후 연구:

- 동적 환경에서의 계획 복원 및 적응 메커니즘 개발

- 실제 로봇 시스템 적용을 통한 실시간 검증 예정

📝 DELTA 논문의 방법론 상세 분석 및 예시 설명

🚀 목표 개요

DELTA는 대규모 언어 모델(LLM)과 Scene Graph(SG)를 결합하여 장기 로봇 작업 계획을 효율적으로 수행하는 방법론입니다.

기존 접근 방식의 문제점:

- LLM만 사용할 경우: 환각(hallucination) 및 실행 불가능한 계획 생성

- 전통 계획기만 사용할 경우: 시맨틱 이해 부족, 긴 계획 탐색 시 시간 소모 큼

- 기존 LLM 기반 계획법: 장기 작업 분해 및 처리에 취약

➡️ DELTA의 핵심 아이디어:

- LLM으로 자연어 목표를 PDDL 형식으로 변환

- Scene Graph를 통해 환경 정보를 정제

- 장기 목표를 하위 목표로 자동 분해해 계획 시간 단축과 성공률 향상

🧩 DELTA의 5단계 처리 과정

1️⃣ 도메인 생성 (Domain Generation)

✅ 목적:

로봇이 수행할 작업에 대한 도메인 지식을 LLM이 이해할 수 있는 형식적 표현(PDDL)으로 생성

⚙️ 작동 방식:

- 입력: 자연어로 설명된 작업 및 도메인 지식

- 처리: LLM이 도메인 내 객체, 속성, 작업(Action) 정의

- 출력: PDDL 도메인 파일 생성

🧪 예시:

목표: "거실과 주방의 바닥을 청소하라."

LLM이 생성한 PDDL 액션 (mop_floor):

(:action mop_floor

:parameters (?a - agent ?i - item ?r - room)

:precondition (and

(agent_at ?a ?r) ; 로봇은 해당 방에 있어야 함

(item_is_mop ?i) ; 아이템은 걸레여야 함

(mop_clean ?i) ; 걸레가 깨끗해야 함

(not(floor_clean ?r))) ; 바닥이 아직 깨끗하지 않아야 함

:effect (and

(floor_clean ?r) ; 바닥이 깨끗해짐

(not(mop_clean ?i))) ; 걸레가 더러워짐

)➡️ 핵심 포인트:

- 사전 조건(precondition): 로봇 위치, 걸레 상태 확인

- 효과(effect): 바닥 청소 시 걸레가 더러워짐

2️⃣ Scene Graph 정제 (Scene Graph Pruning)

✅ 목적:

Scene Graph (SG)에서 목표 달성에 필요한 객체만 추출하여 LLM의 입력 부담 감소 및 계획 정확도 향상

⚙️ 작동 방식:

- 입력: 전체 환경의 SG + 자연어 목표

- 처리: LLM이 목표 달성에 필요 없는 객체 제거

- 출력: 정제된 SG

🧪 예시:

환경:

- 주방: 콜라 캔, 걸레, 싱크대

- 거실: 바나나 껍질, 쓰레기통

목표: "쓰레기를 버리고 바닥을 청소하라."

정제 전 SG: 모든 방과 객체 포함

정제 후 SG: 콜라 캔, 바나나 껍질, 쓰레기통, 걸레, 싱크대만 유지

➡️ 핵심 포인트:

- 토큰 수 감소 → LLM 계산 비용 절감

- 불필요한 정보 제거 → 계획 오류 감소

3️⃣ 문제 생성 (Problem Generation)

✅ 목적:

정제된 SG와 목표를 PDDL 문제 파일로 변환하여 자동 계획기에서 사용할 수 있는 형식화된 문제 정의

⚙️ 작동 방식:

- 입력: 정제된 SG + 자연어 목표

- 처리: LLM이 PDDL 형식의 초기 상태와 목표 상태 정의

- 출력: PDDL 문제 파일

🧪 예시:

목표: "콜라 캔과 바나나 껍질을 버리고 바닥을 청소하라."

(:init

(item_at cola_can kitchen)

(item_at banana_peel living_room)

(item_at rubbish_bin kitchen)

(agent_at robot living_room)

(mop_clean mop)

(floor_clean kitchen)

(not(floor_clean living_room))

)

(:goal

(and

(item_disposed cola_can)

(item_disposed banana_peel)

(floor_clean living_room)

)

)➡️ 핵심 포인트:

- 초기 상태: 객체 위치 및 상태 명시

- 목표 상태: 쓰레기 처분 및 거실 청소 완료

4️⃣ 목표 분해 (Goal Decomposition)

✅ 목적:

복잡한 장기 목표를 자동으로 하위 목표로 분해 → 계획 시간 단축 및 성공률 향상

⚙️ 작동 방식:

- 입력: PDDL 문제 파일

- 처리: LLM이 목표를 연속적인 하위 목표 시퀀스로 분해

- 출력: 하위 목표들의 PDDL 파일 목록

🧪 예시:

장기 목표: "콜라 캔, 바나나 껍질 버리고 거실 바닥 청소"

🔄 분해된 하위 목표:

콜라 캔을쓰레기통에 버리기바나나 껍질을쓰레기통에 버리기걸레가져오기 → 거실 바닥 청소하기

➡️ 왜 필요한가?

- 직접 계획 시: 탐색 공간 폭발 → 타임아웃 발생

- 분해 적용 시: 계획 탐색 시간 95% 감소

5️⃣ 자동 회귀적 하위 작업 계획 (Autoregressive Sub-Task Planning)

✅ 목적:

각 하위 목표를 순차적으로 계획 및 실행하여 최종 계획 생성

⚙️ 작동 방식:

- 입력: 하위 목표 시퀀스 + PDDL 도메인/문제 파일

- 처리:

- 첫 번째 하위 목표 계획 → 실행 결과 상태 업데이트

- 업데이트된 상태로 다음 하위 목표 계획

- 모든 하위 계획 연결 → 최종 실행 계획 생성

🧪 예시:

| 하위 목표 | 계획 단계 | 상태 변화 |

|---|---|---|

| 1. 콜라 캔 버리기 | 로봇 → 주방 이동, 집기, 쓰레기통에 버리기 | (item_disposed cola_can) |

| 2. 바나나 껍질 버리기 | 로봇 → 거실 이동, 껍질 집기, 주방으로 이동 후 버리기 | (item_disposed banana_peel) |

| 3. 거실 청소 | 로봇 → 걸레 가져오기, 거실 청소 | (floor_clean living_room) |

➡️ 핵심 포인트:

- 연속적인 상태 갱신 → 하위 계획 간 일관성 유지

- 최종 계획: 모든 하위 계획 연결

🔍 전체 프로세스 예시

📦 목표: "모든 쓰레기를 버리고 거실과 주방을 청소하라."

1️⃣ 도메인 생성: 버리기, 청소하기 작업 정의

2️⃣ SG 정제: 쓰레기, 걸레, 쓰레기통, 싱크대만 유지

3️⃣ 문제 생성: 초기 상태와 목표 상태 PDDL 생성

4️⃣ 목표 분해:

- 콜라 캔 버리기

- 바나나 껍질 버리기

- 주방 청소 → 걸레 세척 → 거실 청소

5️⃣ 하위 작업 계획: - 각 하위 목표별 계획 생성 및 실행

- 계획 시간 3000배 단축, 성공률 98% 달성

🧠 결론 및 인사이트

✅ DELTA의 핵심 장점:

- 목표 분해로 탐색 공간 최소화 → 시간 단축 & 성공률 증가

- Scene Graph 정제로 LLM 환각 및 계획 오류 감소

- PDDL 형식화로 자동 계획기와의 완벽한 통합

맞아요! DELTA의 현재 파이프라인은 초기 단계에서 전체 계획을 한 번에 수립한 후, 이를 하위 작업 시퀀스(sub-goals)로 분해하여 실행하는 사전 계획 기반(offline planning) 방식입니다.

✅ DELTA의 현재 계획 방식 특징:

- 목표 분해 단계에서 모든 계획을 미리 설정

- 하위 작업들은 순차적으로 실행 (자동 회귀적 계획)

- 실행 중 동적 환경 변화나 오류 발생 시 즉각적 replanning 없음

- 계획 과정은 탐색 최적화와 계산 시간 절약에 중점

❓ 오류 발생 시 DELTA의 처리 방식은?

DELTA는 계획 생성 단계에서의 오류 방지에 중점을 둡니다:

- Scene Graph 정제: 불필요한 객체 제거 → 계획 오류 및 환각(hallucination) 감소

- 목표 분해: 잘못된 순서나 비현실적 계획 방지

그러나 계획 실행 중 예기치 못한 상황 발생 시:

- 현재 구조에서는 실시간 replanning 지원 부족

- 오류가 발생하면 전체 파이프라인을 처음부터 다시 실행해야 함

🔄 DELTA의 향후 개선 방향 (논문 제안사항)

논문에서는 미래 작업으로 다음을 고려한다고 언급합니다:

- 동적 환경 적응성 추가: 계획 실행 중 새로운 상황 발생 시 부분적인 재계획(local replanning) 지원

- 오류 복구 메커니즘: 실행 오류 발생 시 계획 일부만 수정하여 시간 절약

- 실시간 환경 업데이트 반영: 센서 데이터 통합으로 환경 변화 실시간 반영

🧠 비교: 현재 DELTA vs. 동적 계획 시스템

| 특징 | 현재 DELTA | 동적 계획 시스템 (예: SayPlan) |

| 계획 수립 방식 | 초기 전체 계획 | 실행 중 실시간 계획 업데이트 |

| 오류 처리 | 재계획 필요 (초기 단계부터) | 즉각적인 부분적 재계획 가능 |

| 계산 효율성 | 높음 (계획 시간 단축) | 상대적 시간 증가 가능 |

| 계획 안정성 | 높은 계획 완성도 확보 | 동적 환경에 더 적합 |

| 적용 사례 | 정적 환경, 예측 가능한 작업 | 비정형, 예측 불가능한 환경 |

🔑 결론 및 제안

✅ DELTA의 강점:

- 초기 전체 계획 수립으로 계획 시간 및 탐색 비용 절감

- 목표 분해 및 SG 정제로 계획 오류 방지

🚀 보완 필요사항:

- 실시간 replanning 추가 시 동적 환경 대응력 강화

- 로봇이 예상치 못한 상황(장애물, 객체 이동) 발생 시 부분적 계획 수정 기능 필요

📝 DELTA 논문의 결과

📊 5. 결과 및 논의 (Results and Discussion)

DELTA의 성능은 다양한 도메인과 비교 모델과의 실험을 통해 평가되었습니다.

🧪 실험 설정 및 비교 모델

🔍 평가 도메인:

- 독립적 하위 작업 도메인:

- PC 조립(PC): 각 부품을 모아 조립

- 식탁 세팅(Dining): 필요한 식기 및 소품 배치

- 의존적 하위 작업 도메인:

- 청소(Cleaning): 쓰레기 처리 → 걸레 세척 → 바닥 청소

- 홈 오피스 세팅(Office): 물품 배치 순서 및 내용물 유지 고려 필요

🔎 비교 모델:

| 모델 | 설명 |

| LLM-As-Planner | LLM만으로 계획 생성 (가장 단순, 성능 낮음) |

| LLM+P | LLM을 사용해 문제 파일만 생성 (전체 계획은 전통 계획기에 의존) |

| LLM-GenPlan | PDDL 파일 해석 및 간단한 코드 기반 계획 생성 |

| SayPlan | Scene Graph 사용 + 반복적 재계획 가능 |

| DELTA (제안 방식) | SG + 목표 분해 + 자동 회귀 계획 기반 |

📈 성능 지표 및 결과

| 모델 | PC | Dining | Cleaning | Office |

| LLM-As-Planner | 70% | 38.7% | 0% | 0% |

| LLM+P | 76% | 4% | 0% | 0% |

| LLM-GenPlan | 88% | 80.7% | 3.3% | 0.7% |

| SayPlan | 69% | 71% | 54% | 40% |

| DELTA (GPT-4o) | 98% | 100% | 80% | 74.7% |

✅ DELTA의 장점:

- 모든 도메인에서 최고 성공률 달성

- 특히 의존적 하위 작업(청소, 오피스)에서 타 모델 대비 최대 2배 성능 개선

- 목표 분해 적용 시 계획 시간 최대 3000배 단축 및 탐색 노드 수 2000배 감소

🕒 계획 시간 및 효율성

- 목표 분해 전:

- 탐색 시간 과다 → 종종 타임아웃 발생

- 목표 분해 후 (DELTA):

- 계획 시간 95% 감소

- 탐색 노드 수 2000배 이상 절감

❌ 실패 원인 분석

| 실패 원인 | 발생 빈도 (600회 중) |

| 잘못된 조건(predicate) 생성 | 37회 |

| 잘못된 속성(attribute) 누락 | 25회 |

| 잘못된 목표(goal) 설정 | 12회 |

| 계획 타임아웃 발생 | 21회 |

🔎 주요 실패 원인:

- LLM의 환각(hallucination)으로 잘못된 계획 생성

- 너무 큰 Scene Graph로 인한 계획 탐색 지연

🧠 6. 결론 및 마무리 (Conclusion)

✅ 핵심 기여 및 성과

DELTA는 LLM과 Scene Graph(SG)를 결합하여:

- 장기 로봇 작업 계획을 효율적이고 실행 가능한 계획으로 변환

- 목표 분해와 SG 정제로 계획 성공률 및 효율성 극대화

- 의존성이 있는 복잡한 작업에서도 우수한 성능 달성

🚀 주요 성과 요약

- 성공률: 기존 모델 대비 최대 2배 향상

- 계획 시간: 최대 3000배 단축

- 탐색 효율: 탐색 노드 수 평균 2000배 감소

🔄 미래 연구 방향 및 개선점

✅ 동적 환경 대응 강화:

- 실행 중 환경 변화에 대응할 수 있는 실시간 재계획(replanning) 추가

✅ 계획 복원 메커니즘:

- 실행 실패 시 전체 계획 재생성 대신 부분적 수정 지원 예정

✅ 실제 로봇 검증:

- 시뮬레이션을 넘어 실제 환경에서의 계획 실행 실험 예정

🔑 최종 인사이트

DELTA는 기존 LLM 기반 로봇 계획의 성능 한계를 극복하며:

✅ 빠르고 정확한 장기 작업 계획 생성 가능

✅ 복잡한 환경에서도 높은 성공률 보장

✅ 실제 로봇 적용 확장성 보유

📄 DELTA 관련 연구 정리 및 비교 분석

🔎 1. 관련 연구 및 기술 흐름

DELTA가 등장하기 전까지의 로봇 작업 계획(TAMP) 연구는 주로 LLM 기반 접근법과 Scene Graph(SG) 활용 방식으로 구분됩니다.

📊 2. 관련 연구 정리

🧩 2.1. Scene Graph 기반 연구

| 연구 | 주요 내용 | 한계점 |

| 3D Scene Graph (3DSG) (Armeni et al.) | - 다층적 그래프 구조로 건물, 방, 객체, 사람 연결 - 환경의 공간 및 시맨틱 관계 모델링 |

- 대규모 환경에 적용 시 그래프 크기 과대화 - 실시간 업데이트 어려움 |

| 3DSG 확장 (Rosinol et al., Hughes et al.) | - 센서 데이터로 3DSG 자동 생성 - 물리적 객체와 공간 관계 반영 |

- 노이즈 민감성 및 대규모 데이터 처리 비용 발생 |

| Open-Vocabulary 3DSG (Gu et al.) | - LLM 통합으로 개방형 단어 해석 가능 - 미등록 객체도 인식 |

- 관계 추론 시 LLM의 환각 발생 가능성 존재 |

🧠 2.2. LLM 기반 로봇 작업 및 동작 계획 연구

| 연구 | 주요 내용 | 한계점 |

| SayCan (Ahn et al.) | - LLM + 미리 학습된 스킬로 행동 계획 생성 - 언어 입력 기반 작업 실행 |

- 장기 작업 계획 미지원 - 새로운 환경에 일반화 어려움 |

| LLM+P (Liu et al.) | - LLM으로 자연어 → PDDL 문제 파일 변환 - 기존 계획기에 파일 입력해 계획 생성 |

- 도메인 파일 수작업 필요 - 장기 작업 처리 성능 저하 |

| LLM-GenPlan (Silver et al.) | - LLM이 PDDL 해석 및 파이썬 코드로 계획 생성 - 문제 파일 기반 문제 해결 |

- 짧은 작업만 처리 가능 - 계획 최적성 보장 어려움 |

| SayPlan (Rana et al.) | - 3DSG + LLM으로 계획 생성 및 반복적 개선 - 환경 변화 반영 가능 |

- 장기 작업 문제 미해결 - 그래프 크기 증가 시 처리 지연 |

🚀 3. DELTA와 기존 연구의 차이점 및 발전점

| 비교 요소 | 기존 연구의 한계점 | DELTA의 발전 및 차별점 |

| 장기 작업 처리 | 대부분 단기 작업에만 초점 (예: 객체 재배치) 장기 작업 시 실패율 증가 |

✅ 목표 분해(goal decomposition) 도입으로 장기 작업 처리 가능 ✅ 의존성 있는 작업도 효율적 수행 |

| 환경 표현 방식 | 3DSG 사용 시 그래프 크기 과대화 → 계획 지연 | ✅ Scene Graph 정제(SG Pruning)로 불필요한 객체 제거 ✅ 계산 비용 및 오류 감소 |

| 계획 생성 방식 | - 일부 모델: LLM만 사용 → 환각 발생 - LLM+P: 도메인 수작업 필요 |

✅ LLM + SG 결합으로 실행 가능한 계획 생성 ✅ 자동 도메인 및 문제 파일 생성 |

| 계획 시간 및 탐색 효율 | 계획 탐색 시간 과다 → 타임아웃 빈번 | ✅ 탐색 노드 수 2000배 감소 ✅ 계획 시간 3000배 단축 |

| 실행 가능성 및 성공률 | - 환경 변화 대응 부족 - 계획 실패 시 전체 재계획 필요 |

✅ 목표 분해 + 자동 회귀적 계획으로 높은 성공률 (최대 100%) ✅ 실패 시 일부 계획만 수정 가능(향후 연구) |

| 일반화 및 미지 환경 대응 | 새로운 도메인 적용 어려움 미등록 객체 인식 불가 |

✅ LLM의 개방형 단어 해석으로 미지 환경 적용성 향상 ✅ 한 번의 프롬프트로 새로운 도메인 처리 |

| 동적 환경 적응성 | SayPlan만 제한적 동적 계획 지원 다수 모델은 정적 계획에 국한 |

✅ 현재는 사전 계획 방식이지만 ✅ 미래 연구로 실시간 재계획 및 오류 복구 기능 추가 예정 |

🧠 4. DELTA의 주요 발전점 요약

- 장기 작업 처리 강화:

- 기존 연구의 단기 작업 집중 한계 극복

- 목표 분해 및 하위 작업 시퀀스 생성으로 장기 작업도 빠르고 안정적 수행

- Scene Graph 정제 통한 효율성 극대화:

- SG Pruning 적용 → 계획 오류 및 계산 비용 절감

- 탐색 노드 수 및 계획 시간 대폭 감소

- 자동 계획 생성 및 일반화 강화:

- 도메인 및 문제 파일 자동 생성으로 사용자 개입 최소화

- 새로운 환경에서도 높은 성공률 (최대 100%) 달성

- 동적 환경 적응성 (향후 발전 방향):

- 현재 정적 계획 기반 → 향후 부분적 재계획 및 실시간 환경 변화 반영 예정