728x90

728x90

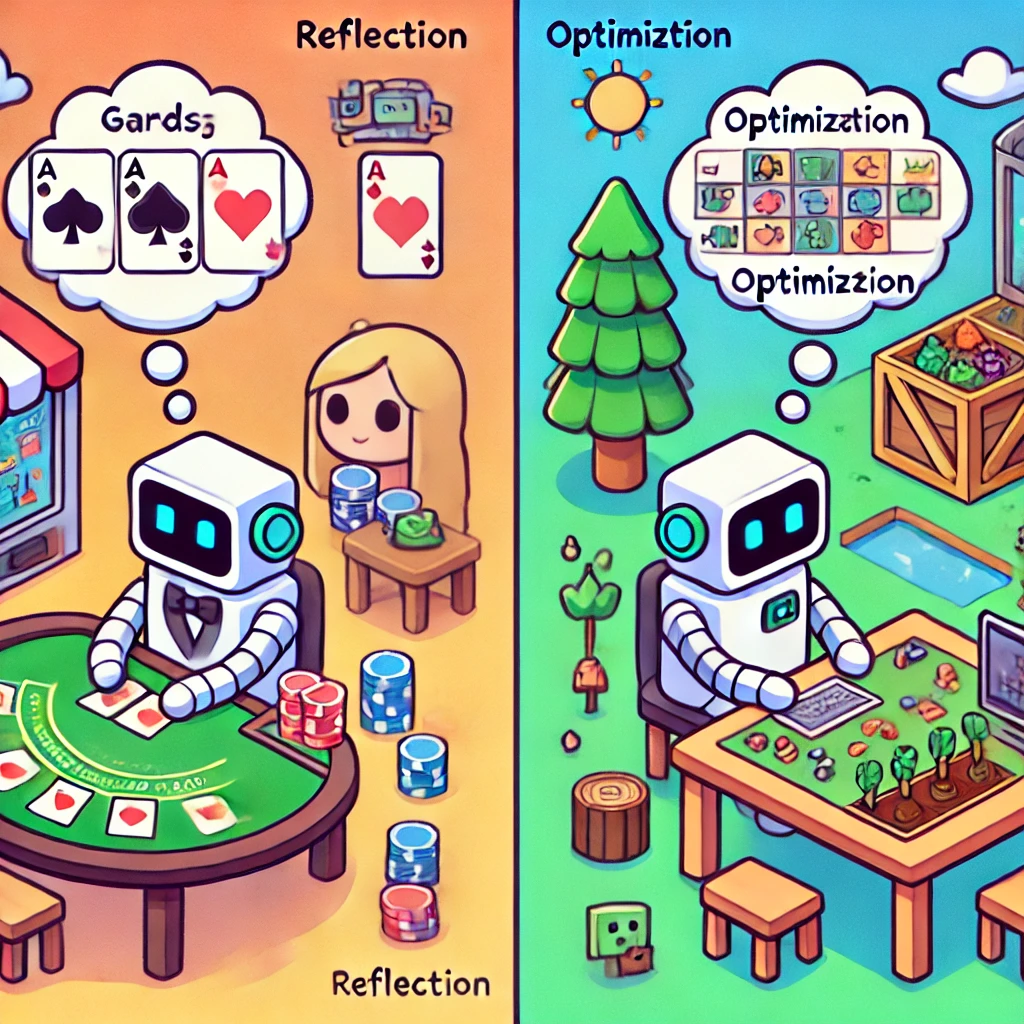

Agent-Pro

GITM

Agent-Pro와 GITM은 각각 특정 환경에서의 AI 에이전트 학습 및 적응을 목표로 하지만, 접근 방식과 적용 범위에서 차이를 보인다.

Agent-Pro는 불완전 정보 게임 환경에서 상대방의 행동을 반영하고 전략을 최적화하는 데 중점을 두며, 메모리 구조를 통해 정교한 행동 지침을 생성한다.

반면, GITM은 Minecraft와 같은 오픈월드 환경에서 텍스트 기반 지식을 활용해 목표를 분해하고 행동을 구조화하며, 강화학습의 비효율성을 극복한다.

GITM은 더 복잡하고 일반화 가능한 문제를 다루는 데 적합하지만, Agent-Pro는 게임 내 전략적 학습과 동적 적응에서 강점을 가진다.

두 접근법은 각각의 환경에 최적화되어 있으며, 현실 문제 해결을 위해 상호 보완적으로 활용될 가능성이 있다.

Agent-Pro와 Ghost in the Minecraft (GITM)의 비교

1. 두 논문의 공통점

- 목표:

- 두 연구 모두 지능형 에이전트 설계를 목표로 하며, 에이전트가 복잡한 환경에서 스스로 학습하고 적응하도록 만듦.

- Agent-Pro는 게임과 상대방의 행동에 적응하며 점진적으로 학습하는 방식.

- GITM은 Minecraft와 같은 오픈월드 환경에서 다양한 목표를 달성하며 전반적인 기술 트리를 마스터하도록 설계.

- 메모리 활용:

- Agent-Pro는 세계 믿음(World-Belief)과 자기 믿음(Self-Belief)으로 나뉜 메모리를 사용해 정보를 저장.

- GITM은 텍스트 기반의 메모리를 통해 에이전트가 이전 경험을 바탕으로 계획을 생성하고 조정.

- 피드백 기반 학습:

- 두 논문 모두 행동 피드백을 통해 전략을 수정하고 성능을 개선.

- LLM 활용:

- Agent-Pro와 GITM 모두 LLM을 통해 복잡한 목표를 세분화하거나, 행동 계획을 수립.

2. 차이점

2-1. 문제 설정

- Agent-Pro:

- 에이전트는 불완전 정보 게임(Blackjack, Texas Hold'em)에서 승리하는 것을 목표로 함.

- 게임과 상대방 행동에 대한 반영(Reflection)을 통해 전략을 최적화.

- GITM:

- Minecraft와 같은 오픈월드 환경에서 에이전트가 모든 기술 트리 아이템을 획득하도록 설정.

- 강화학습 기반 접근법의 비효율성을 극복하기 위해 설계.

2-2. 목표 분해 방식

- Agent-Pro:

- 게임 종료 후 실패 원인을 분석하고 정책 수준에서 새로운 전략을 생성.

- 행동 지침(Behavioral Guidelines)과 세계 모델(World Modeling)을 업데이트.

- GITM:

- LLM Decomposer를 통해 목표를 서브 목표로 세분화하고, 이를 다시 구조화된 행동(Structured Actions)으로 변환.

- 계획 단계에서 재귀적으로 목표를 나누며 수행 순서를 결정.

2-3. 학습 방식

- Agent-Pro:

- 과거 경험을 바탕으로 믿음과 행동 지침을 수정하며 점진적으로 학습.

- 실패 경험을 반영해 점진적 최적화를 수행.

- GITM:

- 텍스트 기반 지식을 활용해 외부 정보를 학습.

- 에이전트는 Minecraft Wiki 등에서 추출한 텍스트 기반 정보를 통해 효율적으로 계획을 세움.

- 학습 과정에서 구체적인 행동 피드백과 메모리를 활용해 학습 속도를 극대화.

2-4. 성능 개선 방식

- Agent-Pro:

- 깊이 우선 탐색(DFS)을 사용해 여러 정책 후보를 테스트하고 최적의 정책을 선택.

- 장기적인 행동 전략(예: 블러핑, 위험 최소화)을 학습.

- GITM:

- 구조화된 행동(Structured Actions)을 정의해 행동을 계획하고 실행.

- 목표 달성 실패 시 행동 계획을 재구성.

2-5. 실험 환경

- Agent-Pro:

- Blackjack, Texas Hold'em과 같은 카드 게임에서 상대방의 행동 패턴과 환경을 학습.

- GITM:

- Minecraft의 오픈월드에서 모든 기술 트리를 완료하는 것을 목표로 실험.

- 기존 강화학습 접근법보다 10,000배 이상의 학습 효율성을 보여줌.

3. 두 접근법의 장단점

Agent-Pro의 장점

- 적응성: 상대방의 행동 변화와 동적 환경에 적응.

- 전략적 학습: 장기적인 전략을 학습하고 최적화.

Agent-Pro의 한계

- LLM 의존성: 사용된 LLM의 성능에 따라 결과가 크게 달라짐.

- 계산 비용: DFS 기반 탐색에서 높은 계산 비용 발생 가능.

GITM의 장점

- 오픈월드 문제 해결: Minecraft와 같은 복잡한 환경에서도 모든 목표를 달성.

- 효율성: 텍스트 기반 지식을 활용하여 학습 효율성을 극대화.

- 계획 구조화: 구조화된 행동과 목표 분해로 복잡한 목표를 체계적으로 달성.

GITM의 한계

- 실세계 적용 가능성: Minecraft 외의 실제 문제에 대한 적용 사례 부족.

- 특화된 환경: 오픈월드 환경에 최적화된 설계로, 특정 게임 외의 일반화 가능성은 제한적.

4. 결론

- Agent-Pro는 상대방과의 상호작용이 중요한 환경에서 유리하며, 전략적 학습과 지속적인 반영에 강점을 가짐.

- GITM은 복잡한 오픈월드 환경에서 다단계 목표를 해결하는 데 뛰어난 성능을 보여줌.

두 접근법 모두 LLM 활용과 피드백 기반 학습에서 공통점을 가지지만, 적용 환경과 문제 해결 방식에서 차이를 보입니다. 연구 목적에 따라 두 프레임워크를 통합하거나 특정 환경에 맞게 최적화할 수 있을 것입니다. 추가 질문이 있다면 말씀해주세요!

표를 통해 분석한 내용을 정리해주고, 어떤 내용이 좀 더 발전한 내용인지 판단해줘

Agent-Pro와 Ghost in the Minecraft (GITM) 비교 표

항목 Agent-Pro GITM 발전된 내용

| 항목 | Agent-Pro | GITM | 발전된 내용 |

| 문제 설정 | 불완전 정보 게임(Blackjack, Texas Hold'em)에서 승리 전략 학습. | 오픈월드(Minecraft)에서 모든 기술 트리를 완료하는 범용적 에이전트 설계. | GITM은 더 광범위하고 현실에 가까운 문제 해결. |

| 메모리 구조 | 세계 믿음(World-Belief)과 자기 믿음(Self-Belief)으로 정보 저장. | 텍스트 기반 메모리로 외부 지식을 저장 및 활용. | GITM은 외부 지식 활용을 통해 효율적 학습 가능. |

| 학습 및 추론 방식 | 경험 기반 반영(Reflection)을 통해 새로운 정책 생성 및 최적화. | 목표를 세분화(Goal Decomposition)하고 텍스트 지식을 기반으로 구조화된 행동을 계획 및 실행. | GITM은 목표 분해 및 행동 계획이 더 정교함. |

| 강화 학습 대안 | LLM 활용과 경험 반영을 통해 정책 개선. | 강화학습(RL)을 배제하고 LLM과 외부 텍스트를 활용한 학습으로 효율성 극대화. | GITM은 RL의 비효율성을 극복. |

| 실험 환경 | 카드 게임(Blackjack, Texas Hold'em)에서 테스트. | Minecraft의 오픈월드 환경에서 실험, 기존 RL 대비 10,000배 효율적 학습. | GITM은 더 복잡하고 현실적인 환경을 다룸. |

| 장점 | 상대방 행동에 적응하는 능력, 전략적 장기 학습 가능. | 광범위한 목표를 처리, 텍스트 기반 정보 활용으로 높은 학습 효율성. | 각각 다른 강점을 가지며, 특정 상황에서 우위. |

| 한계점 | 모델 의존성(GPT-4 등)과 높은 계산 비용(DFS 기반 탐색). | 실제 문제(비게임 환경)로의 확장 사례 부족, Minecraft에 특화된 설계. | Agent-Pro는 일반화, GITM은 텍스트 활용. |

어떤 내용이 더 발전된 내용인가?

1. 문제 설정

- GITM은 Minecraft와 같은 복잡한 오픈월드 환경을 다루므로 Agent-Pro보다 더 일반화된 문제를 해결합니다. 이는 현실 세계 문제(예: 자율 로봇, 협상 시뮬레이션 등)로의 확장 가능성이 더 높습니다.

2. 메모리 구조

- GITM의 텍스트 기반 메모리는 외부 지식을 효율적으로 저장하고 활용할 수 있어, LLM과의 통합 학습에서 Agent-Pro보다 발전된 구조를 보입니다.

3. 학습 및 추론 방식

- GITM은 목표 분해(Goal Decomposition)와 구조화된 행동 계획(Structured Actions)을 통해 복잡한 문제를 체계적으로 해결하는 방식이 더 정교합니다. Agent-Pro는 게임 환경에서는 효율적이지만, 목표 설정이 명확하지 않은 환경에서는 제한적일 수 있습니다.

4. 강화 학습 대안

- GITM은 강화학습(RL)의 비효율성을 극복하고, LLM과 텍스트 지식을 결합하여 학습 효율을 극대화했습니다. Agent-Pro의 DFS 기반 정책 탐색은 계산 비용이 높아지는 한계가 있으므로, GITM의 접근이 더 발전적으로 보입니다.

5. 실험 환경

- GITM은 오픈월드 환경에서 에이전트의 능력을 검증하여 더 복잡한 문제를 해결할 가능성을 보여줍니다. Agent-Pro는 특정 게임 환경에 특화되어 있어, 일반화 가능성이 상대적으로 낮습니다.

결론: 발전된 내용

- GITM은 현실적이고 복잡한 문제 해결에 더 적합한 프레임워크를 제공합니다. 특히, 텍스트 기반 지식을 활용한 학습 방식과 목표 분해 전략은 Agent-Pro보다 일반화 가능성과 학습 효율 면에서 발전된 내용을 담고 있습니다.

- Agent-Pro는 전략적 학습과 상대방 행동 분석에 강점이 있으며, 특정 게임 환경에서는 GITM보다 더 적합할 수 있습니다. 그러나 GITM의 방법론은 더 광범위한 환경으로의 확장이 가능하다는 점에서 더 발전적이라고 판단됩니다.

추가로 심화된 비교가 필요하면 알려주세요!

728x90

'인공지능 > Agent' 카테고리의 다른 글

| Negotiation AI 2 (1) | 2024.12.12 |

|---|---|

| Negotiation AI 1 (3) | 2024.12.10 |