생각보다 중요한 내용이 많아서 일단 여기서 한 번 더 정리를 해야겠네요

THE ADVENT OF THE AI NEGOTIATOR: NEGOTIATION DYNAMICS IN THE AGE OF SMART ALGORITHMS

월마트는 이미 협상 일부를 자동화 하였다!

-> 정보의 싸움에서 소매업자들이 이길 수 없다.

정보와 협상!

정보는 매우 중요하다.

정보 - 관련자, 성격, 관심사 및 우려사항, 협상 이력, 결정 문제!

BATNA(Best Alternative to a Negotiation Agreement) - 선택할 수 있는 최선의 대안

ZOPA(Zone of Possible Agreement) - BATNA에 따라 형성되는 합의 가능한 영역

ex) 두 당사자의 BATNA 영역이 중복되어야 합의가 가능

-> 상대방의 정보를 통해 BATNA를 파악하고 나의 BATNA와 겹치는 ZOPA에서 내 이익을 극대화 하자

상대방이 시간이 없거나, 금전적 여유가 없다 -> BATNA가 약해진다 -> 이 사실을 알면 협상을 쉽게 가져갈 수 있다.

Home Page | Luminance

Jackie O’Neill, Director of Project Management, Global Risk

www.luminance.com

Luminance Showcases World’s First Completely AI-Powered Contract Negotiation

Luminance Showcases World’s First Completely AI-Powered Contract Negotiation

Request a demo Please complete the form below and we will contact you to arrange a demo of Luminance.

www.luminance.com

AI negotiates legal contract without humans involved for first time

An AI just negotiated a contract for the first time ever — and no human was involved

Jaeger Glucina, chief of staff and managing director of Luminance, said its new AI aimed to eliminate much of the paperwork that lawyers need to complete.

www.cnbc.com

AI가 협상을 진행한 사례네요.....

단순한 문제는 이렇게 진행할 수 있지만, 복잡하고 창의적인 솔루션이 필요한 문제에서는 이 것으로 문제를 해결할 순 없다.

Pactum - The global leader in autonomous negotiations

자율 협상 프로그램 제공하는 프로그램

다양한 프로그램(상업 기간 협상, 계약 비용 협상, 구매 협상 등)을 나눠서 판매 중

쿠팡이 이미 쓰고 있네요...?

How Walmart Automated Supplier Negotiations

How Walmart Automated Supplier Negotiations

It’s an age-old problem in procurement: Corporate buyers lack the time to negotiate fully with all suppliers. Historically this has left untapped value on the table for both buyers and suppliers. To address this challenge, Walmart deployed AI-powered neg

hbr.org

판매하는 물건을 AI가 계약하는 것은 아니지만 그래도 사용할 제품에 대해 AI가 계약한다는 것은 발전되면 판매할 제품에 대해서도 사용한다는 것인데....

일단 여기까지 하고 이 뒤에서는 AI의 불평등성을 말하면서 논문은 종료됩니다.

지금 당장 GPT-o1-pro mode만 해도 $200이니...

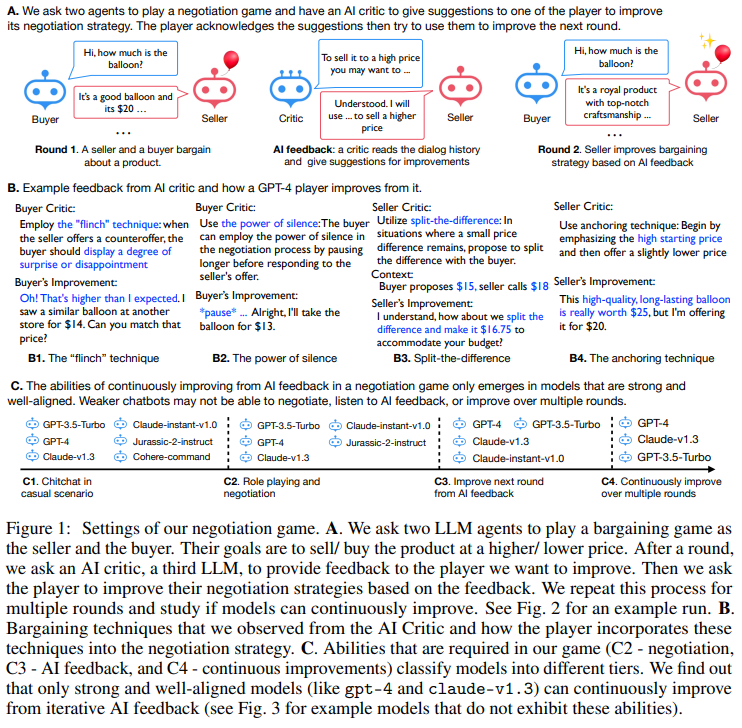

이 그림은 논문에서 협상 게임(negotiation game)의 전체적인 설정과 각 단계에서의 진행 방식을 시각적으로 보여줍니다. 아래에 각 부분을 상세히 설명하겠습니다.

1. 그림의 구조와 구성 요소

- A. 협상 게임의 설정:

- 두 개의 LLM이 협상 게임을 진행하며, 각각 구매자와 판매자 역할을 맡습니다.

- 협상의 목표:

- 구매자는 가능한 낮은 가격을 제안.

- 판매자는 가능한 높은 가격을 제안.

- AI 비평가 역할:

- 제3의 LLM이 비평가로 작동하여 협상 대화 기록을 검토한 후, 특정 플레이어(구매자 또는 판매자)에 대해 협상 전략을 개선할 수 있는 피드백을 제공합니다.

- 피드백을 받은 플레이어는 이를 반영해 다음 라운드에서 전략을 개선합니다.

- 예시:

- Round 1:

- 판매자: "이 풍선은 $20입니다."

- 구매자: "$15는 어떻습니까?"

- AI Feedback:

- 비평가: "더 높은 가격을 요구하려면 품질과 희소성을 강조하세요."

- Round 2:

- 판매자: "이 풍선은 최고급 품질로 제작되었으며 $25 가치가 있지만, 특별히 $20에 드립니다."

- Round 1:

2. 피드백과 전략 적용 예시 (B. 피드백과 개선 과정)

- 이 부분은 AI 비평가가 제공하는 다양한 피드백의 유형과 이를 바탕으로 모델이 개선된 전략을 시각적으로 보여줍니다.

- B1. "Flinch" Technique (놀람 기법):

- 피드백: 구매자가 판매자의 가격 제안에 놀라거나 실망한 반응을 보이면 협상에서 더 나은 가격을 얻을 수 있음.

- 적용 예시:

- 구매자: "그 가격은 너무 높네요! 다른 가게에서는 $14였습니다. 그 가격에 맞춰주실 수 있나요?"

- B2. Power of Silence (침묵의 힘):

- 피드백: 구매자가 응답 전 잠시 침묵을 유지하면 협상에서 우위를 점할 수 있음.

- 적용 예시:

- 구매자: 잠시 침묵 ... "그럼 $13에 구입하겠습니다."

- B3. Split-the-Difference (차이 나누기):

- 피드백: 판매자가 가격 차이가 적을 경우 "중간 가격으로 타협"을 제안.

- 적용 예시:

- 판매자: "중간 가격인 $16.75는 어떻습니까?"

- B4. Anchoring Technique (앵커링 기법):

- 피드백: 높은 시작 가격을 제시하고 약간 낮춘 가격을 제공함으로써 구매자를 설득.

- 적용 예시:

- 판매자: "이 고품질 풍선은 $25 가치가 있지만, 특별히 $20에 드립니다."

- B1. "Flinch" Technique (놀람 기법):

3. 협상 게임에서 모델의 능력 (C. 협상 능력 분류)

- C1. Casual Scenario (일상 대화):

- 모델이 단순한 대화를 수행할 수 있는지 평가.

- C2. Role Playing and Negotiation (역할 수행 및 협상):

- 구매자와 판매자 역할을 맡아 협상 규칙에 따라 행동할 수 있는 능력.

- C3. Improve from AI Feedback (AI 피드백으로 개선):

- 비평가의 피드백을 받아 전략을 학습하고 개선할 수 있는 능력.

- C4. Continuously Improve (연속적인 개선):

- 여러 라운드에 걸쳐 지속적으로 협상 전략을 개선할 수 있는 능력.

4. 주요 관찰점

- 강력한 모델만 연속적 개선 가능:

- GPT-4와 Claude-v1.3 같은 강력하고 잘 정렬된 모델만이 협상 게임에서 AI 피드백을 통해 지속적으로 성능을 개선.

- Claude-instant-v1.0이나 Cohere-command와 같은 약한 모델은 협상 규칙을 이해하거나 피드백을 반영하지 못함.

- 모델 간 성능 차이:

- 강력한 모델은 구매자와 판매자 모두에서 성능을 개선할 수 있으나, 약한 모델은 특정 역할(구매자/판매자)에서만 제한적으로 성능을 개선.

종합

이 그림은 협상 게임의 전반적인 구조, AI 비평가의 피드백 메커니즘, 피드백 반영을 통한 전략 개선 과정을 시각적으로 효과적으로 표현하고 있습니다. 이를 통해 LLM이 협상 게임에서 자율적으로 학습하고 성능을 향상할 수 있는 방법론과 모델 간 능력 차이를 한눈에 이해할 수 있습니다.

이 Figure는 Claude-instant-v1.0(판매자)와 GPT-3.5-turbo(구매자)가 협상 게임을 진행하면서 AI 비평가로부터 피드백을 받고, 전략을 개선하는 과정을 시각적으로 보여줍니다. 각 섹션(A, B, C)을 기반으로 상세히 설명하겠습니다.

A. 협상 게임의 초기 라운드 (Before AI Feedback)

1. 협상 과정

- 판매자(Claude-instant-v1.0)는 풍선을 $20로 시작 가격으로 설정하고, 구매자(GPT-3.5-turbo)와 협상을 진행합니다.

- 구매자: "$10에 구매할 수 있나요?" → 판매자는 "$10은 너무 낮습니다."라고 거절.

- 구매자: "$15는 어떻습니까?" → 판매자는 "$15는 조금 낫지만 충분하지 않습니다."

- 구매자: "가장 낮은 가격은 얼마인가요?" → 판매자는 "$18입니다."

- 구매자: "$16은 가능한가요?" → 판매자는 "$16에 거래하겠습니다."

2. 결과

- 최종 가격: $16

- 협상은 비교적 단순하며, 전략적 설득보다는 가격 교환에 초점.

B. AI 비평가의 피드백 (AI Feedback to Seller)

1. 비평가의 피드백

- 협상 종료 후, AI 비평가(Claude-instant-v1.0)는 판매자에게 전략 개선을 위한 피드백을 제공합니다:

- 품질과 장점을 강조: 가격이 아닌 제품의 고유한 특징을 부각시키세요.

- 예: "풍선의 희소성과 고급스러움을 강조하세요."

- 구매자와의 신뢰 형성: 구매자와의 유대감을 구축해 신뢰할 수 있는 판매자로 보이세요.

- 예: "이 제품이 특별히 당신에게 적합하다고 강조하세요."

- 협상을 포기할 가능성 시사: 구매자에게 다른 잠재적 구매자가 있음을 알리세요.

- 예: "이 가격은 오늘만 제공됩니다."

- 품질과 장점을 강조: 가격이 아닌 제품의 고유한 특징을 부각시키세요.

2. 판매자의 응답

- 판매자는 피드백을 수용하며, 다음 라운드에서 더 높은 가격($16.0 이상)을 목표로 협상 전략을 수정하겠다고 약속.

C. 피드백 적용 후 개선된 라운드 (After AI Feedback)

1. 협상 과정

- 판매자는 피드백을 반영하여 협상 전략을 개선합니다:

- 판매자: "이 풍선은 고품질 라텍스로 제작되었으며, 전문가의 수작업으로 완성된 고유한 제품입니다."

- → 비평가의 "품질 강조" 피드백 반영.

- 구매자: "이 풍선을 위한 최저 가격은 얼마인가요?"

- 판매자: "당신을 신뢰하고 소중히 여기는 고객이기 때문에, 이 특별한 풍선을 오늘만 $17에 제공하겠습니다."

- → 비평가의 "신뢰 형성" 피드백 반영.

- 구매자: "$15로 더 나은 거래를 제공할 수 없나요?"

- 판매자: "$15는 제 비용을 충족하지 못합니다. 이 고품질 풍선에는 최소 $17이 필요합니다."

- → 협상 거절 시 구매자에게 신뢰를 유지하는 태도.

- 구매자: "좋습니다. $17에 거래하겠습니다."

- 판매자: "이 풍선은 고품질 라텍스로 제작되었으며, 전문가의 수작업으로 완성된 고유한 제품입니다."

2. 결과

- 최종 가격: $17 (초기 라운드 $16에서 $1 상승)

- 판매자가 피드백을 기반으로 전략적으로 더 높은 가격을 유도.

Figure에서 전달하는 주요 메시지

- AI 피드백의 효과:

- AI 비평가의 피드백은 협상 전략 개선에 직접적인 영향을 미침.

- "품질 강조", "신뢰 형성" 등 전략적 기법이 구매자를 설득하여 더 높은 거래 가격을 달성.

- In-Context Learning의 활용:

- 협상 기록과 피드백이 다음 라운드의 학습 데이터로 활용되어 모델이 지속적으로 개선.

- 정량적 성과 개선:

- 피드백을 반영한 후 협상 가격이 $16에서 $17로 상승, 이는 피드백의 효과를 정량적으로 보여줌.

결론

이 Figure는 협상 게임에서 AI 비평가의 피드백이 판매자의 전략에 어떻게 반영되는지, 그리고 이를 통해 협상 결과가 어떻게 개선되는지를 명확히 보여줍니다. AI 피드백을 통해 모델이 단순한 협상에서 전략적이고 설득력 있는 대화를 진행할 수 있음을 증명한 사례입니다.

이 Figure는 협상 게임에서 일부 모델들이 규칙을 이해하지 못하거나 피드백을 적절히 반영하지 못하는 상황을 설명합니다. 두 섹션(A, B)을 통해 문제를 구체적으로 보여주며, LLM(Large Language Models)의 성능 차이를 강조합니다.

A. Cohere 모델의 협상 실패 사례

설명

- 이 섹션은 Cohere command-xlarge-nightly 모델이 협상 규칙을 이해하지 못해 비논리적인 행동을 보이는 사례를 보여줍니다.

- 예:

- 첫 번째 사례(2023-04-22):

- 구매자: "$15에 판매하시겠습니까?"

- 판매자: "예, $15에 판매하겠습니다."

- 구매자: "$17에 판매하시겠습니까?" (이전 합의($15)보다 높은 가격을 다시 제안.)

- 문제: 구매자의 행동이 비논리적이며 협상 규칙을 따르지 않음.

- 두 번째 사례(2023-05-11):

- 구매자: "$10에 판매하시겠습니까?"

- 판매자: "$20입니다." → 가격을 거절.

- 구매자: "최저 가격이 얼마인가요?"

- 판매자: "$8입니다." → $10을 거절한 뒤 더 낮은 $8에 판매 제안.

- 문제: 가격의 일관성이 없으며 협상 규칙에 어긋남.

- 첫 번째 사례(2023-04-22):

결론

- Cohere 모델은 협상 규칙을 제대로 이해하지 못하여 비합리적인 가격 설정 및 협상 결과를 도출.

- 이는 모델의 한계와 규칙 기반 학습의 중요성을 보여줌.

B. AI21 Jurassic-2 모델의 피드백 반영 실패

설명

- 이 섹션은 AI21 Jurassic-2 모델이 협상 규칙은 이해했지만, AI 비평가의 피드백을 반영하지 못하는 사례를 보여줍니다.

- 협상 및 피드백 과정:

- Round 1 (협상 시작):

- 구매자(GPT-3.5-Turbo): "$11은 어떻습니까?"

- 판매자(AI21): "$12에 고려해 보겠습니다."

- 구매자: "$11로 하겠습니다." → 거래 성사.

- AI 피드백:

- 비평가가 판매자에게 개선 피드백 제공:

- 제품의 특성과 품질 강조.

- 긴급성을 부각시킴.

- 구매자가 필요를 더 잘 설명하도록 유도.

- 비평가가 판매자에게 개선 피드백 제공:

- Round 2 (피드백 적용 후):

- 판매자: "$12에 판매하겠습니다." (Round 1과 동일한 전략 반복.)

- 구매자: "$11이 제가 제안할 수 있는 최대입니다."

- 판매자: "$11에 동의합니다." → 전략 개선 없음.

- 문제: 비평가의 피드백을 전혀 반영하지 못하고 이전 전략을 단순 반복.

- Round 1 (협상 시작):

결론

- AI21 Jurassic-2 모델은 협상 규칙을 이해하지만, AI 피드백을 학습하거나 반영하지 못함.

- 이는 피드백 기반 학습에서 모델의 한계를 나타냄.

Figure에서 전달하는 주요 메시지

- LLM 간 성능 차이:

- 일부 모델(Cohere command, AI21 Jurassic-2)은 협상 규칙을 이해하거나 피드백을 학습하지 못함.

- 이는 강력한 모델(GPT-4, Claude)과 약한 모델 간 성능 차이를 보여줌.

- 피드백 반영 능력의 중요성:

- 협상 규칙을 이해하는 것만으로는 충분하지 않으며, 비평가의 피드백을 효과적으로 반영하는 능력이 필요.

- AI 모델의 개선 필요성:

- Cohere와 AI21 모델은 추가적인 학습 및 개선을 통해 규칙 이해와 피드백 반영 능력을 강화해야 함.

종합

이 Figure는 협상 게임에서 모델의 한계를 시각적으로 보여주며, 일부 모델이 규칙을 이해하지 못하거나 피드백을 반영하지 못하는 이유를 강조합니다. 이는 협상 게임의 학습 및 평가 과정에서 모델 성능 개선이 필요한 지점을 명확히 제시합니다.

이 Figure는 GPT 모델과 Claude 모델이 여러 라운드에 걸친 협상 게임에서의 성능과 거래 성공률을 비교한 결과를 보여줍니다. 각 그래프는 모델이 판매자(seller)와 구매자(buyer) 역할을 맡았을 때의 성과를 측정하며, 가격 협상과 거래 성공률 간의 상호작용을 시각적으로 나타냅니다.

A. Criticize Seller (판매자 비평)

A1. Average deal price over 5 rounds (평균 거래 가격)

- 설명:

- 판매자 역할을 맡은 모델들의 평균 거래 가격이 5라운드에 걸쳐 어떻게 변화하는지 보여줍니다.

- 결과:

- GPT-4는 라운드가 진행될수록 거래 가격을 꾸준히 높이는 데 성공, 가장 높은 가격을 달성.

- Claude-v1.3도 일정 수준 개선하지만, GPT-4에 미치지 못함.

- Claude-instant-v1.0는 가격을 거의 개선하지 못하며, 다른 모델보다 낮은 거래 가격 유지.

- 의미:

- 피드백 기반 학습으로 판매자 역할에서 거래 가격을 개선하는 능력에서 GPT-4가 가장 우수함.

A2. Deal success ratio over 5 rounds (거래 성공률)

- 설명:

- 판매자 역할에서 거래가 성사되는 비율이 라운드가 진행됨에 따라 어떻게 변화하는지 보여줌.

- 결과:

- 거래 성공률은 모든 모델에서 점차 감소.

- 높은 가격을 유지하려는 시도가 실패 확률을 높임(GPT-4 포함).

- 마지막 라운드에서는 대부분의 모델이 50% 이하의 성공률을 기록.

- 의미:

- 판매자가 거래 가격을 높이려 하면 거래 성공률이 감소하는 트레이드오프가 발생.

B. Criticize Buyer (구매자 비평)

B1. Average deal price over 5 rounds (평균 거래 가격)

- 설명:

- 구매자 역할을 맡은 모델들이 5라운드에 걸쳐 얼마나 낮은 가격으로 거래를 성사시켰는지 보여줌.

- 결과:

- GPT-4는 지속적으로 가격을 낮추며 가장 낮은 거래 가격을 달성.

- Claude-v1.3와 GPT-3.5-Turbo는 유사한 성과를 보임.

- Claude-instant-v1.0는 거래 가격을 낮추지 못하고 개선되지 않음.

- 의미:

- 구매자 역할에서 거래 가격을 낮추는 능력에서도 GPT-4가 가장 우수하며, Claude-instant-v1.0은 학습 능력이 부족.

B2. Deal success ratio over 5 rounds (거래 성공률)

- 설명:

- 구매자 역할에서 거래가 성사되는 비율이 라운드가 진행됨에 따라 어떻게 변화하는지 보여줌.

- 결과:

- 모든 모델에서 거래 성공률이 점차 감소하지만, 판매자 비평(A2)보다 성공률이 상대적으로 높음(대부분 50% 이상 유지).

- Claude-instant-v1.0은 낮은 성공률을 보이며, 다른 모델에 비해 현저히 부족.

- 의미:

- 구매자가 더 낮은 가격을 제시하려고 할수록 거래 성공률이 감소하지만, 판매자보다 성공률이 높음.

Figure의 주요 메시지

- 모델 간 성능 차이:

- GPT-4는 판매자와 구매자 역할 모두에서 가장 우수한 성과를 보이며, 거래 가격과 성공률 간의 균형을 가장 잘 유지.

- Claude-instant-v1.0은 거래 가격이나 성공률 개선에 거의 실패, 다른 모델들에 비해 성능이 열등.

- 판매자와 구매자의 차이:

- 판매자 비평(A 섹션): 거래 가격을 높이려는 시도가 거래 성공률 감소로 이어짐.

- 구매자 비평(B 섹션): 구매자가 더 낮은 가격을 목표로 할 때도 거래 성공률이 유지되는 경향이 있음.

- AI 피드백의 영향:

- 피드백 기반 학습을 통해 모델들이 여러 라운드에 걸쳐 협상 전략을 개선할 수 있음을 보여줌.

- 그러나 모델의 성능은 초기 학습 능력에 따라 크게 좌우됨.

결론

이 Figure는 다중 라운드 협상 게임에서 AI 피드백의 영향을 시각화하고, GPT-4가 가장 효과적으로 협상 전략을 학습하고 적용함을 보여줍니다. 또한 거래 가격과 성공률 간의 트레이드오프를 강조하며, AI 모델이 협상 환경에서 어떻게 성능을 개선하는지 명확히 설명합니다.

이 Figure는 판매자 모델의 응답 길이가 협상 라운드가 진행됨에 따라 어떻게 변화하는지와, 이러한 응답 길이 증가가 협상 전략과 성공에 어떤 영향을 미치는지를 보여줍니다. Claude-v1.3와 GPT-4의 응답 길이를 비교하며, 각각의 전략적 차이를 분석합니다.

1. 응답 길이와 협상 라운드의 관계

- X축: 협상 라운드 (Round 1 ~ Round 5).

- Y축: 응답 길이 (문자 수 기준).

- 그래프 관찰:

- Claude-v1.3:

- 응답 길이가 지속적으로 증가하며, Round 5에서 약 1500자에 도달.

- 모델이 점점 더 상세하고 길게 설명하려는 경향을 보임.

- GPT-4:

- 응답 길이가 증가하지만, Claude-v1.3보다 낮은 수준에서 유지(약 1000자).

- 길이는 상대적으로 짧지만, 더 전략적인 내용을 포함.

- Claude-v1.3:

2. 모델별 응답 분석

Claude-v1.3 (판매자)

- 응답 특징:

- Round 5 예시: "이 풍선은 단순히 고품질일 뿐만 아니라 독특하고 매력적인 디자인을 가지고 있습니다. 다른 풍선과는 차별화된 특별한 제품으로, $20의 가치가 있습니다."

- 응답이 지나치게 장황하며, 구매자를 설득하려는 많은 정보를 포함.

- 문제점:

- 길어진 응답에도 불구하고, 협상 성공률과 거래 가격은 낮음(Figure 6 참조).

- 장황함이 전략적 설득으로 이어지지 않음.

GPT-4 (판매자)

- 응답 특징:

- Round 4 예시: "이 특별한 풍선은 내구성 있는 재료로 만들어졌으며, 독특한 디자인을 갖춘 고유한 제품입니다. $20에서 약간의 할인으로 $18을 제안할 수 있습니다."

- 응답이 상대적으로 짧으면서도 구매자에게 설득력 있는 핵심 메시지를 전달.

- 장점:

- 응답 길이를 적절히 유지하며, 협상 성공률과 거래 가격에서 더 나은 성과를 냄(Figure 6 참조).

- 장황하지 않고도 효과적인 설득 전략을 구사.

3. 주요 관찰점

- 응답 길이와 전략적 효과

- Claude-v1.3의 응답 길이는 더 길지만, 이것이 반드시 더 나은 협상 전략을 의미하지는 않음.

- GPT-4는 응답 길이를 전략적으로 조정하며, 짧고 명확한 메시지로 더 나은 성과를 달성.

- 라운드 진행에 따른 학습

- 두 모델 모두 라운드가 진행될수록 응답 길이가 증가.

- 이는 모델이 협상 기록과 피드백을 학습하며 점점 더 상세한 설명과 설득을 시도한다는 것을 보여줌.

- Claude-v1.3과 GPT-4의 차이

- Claude-v1.3: 길어진 응답이 구매자 설득에 실패하며, 협상 전략의 비효율성 드러남.

- GPT-4: 응답 길이가 상대적으로 짧지만, 효과적인 전략을 통해 높은 거래 성공률과 가격을 달성.

결론

이 Figure는 모델이 협상 라운드가 진행될수록 더 길고 상세한 응답을 생성한다는 점을 보여줍니다. 그러나 길이가 길다고 해서 반드시 더 나은 협상 결과로 이어지는 것은 아니며, GPT-4의 사례는 전략적이고 명확한 메시지가 협상에서 더 큰 효과를 발휘할 수 있음을 입증합니다. Claude-v1.3은 지나치게 장황하지만 비효율적인 전략을 보여주며, 응답 품질보다 전략적 사고의 중요성을 강조합니다.

이 논문에서 Buy의 Critic은 각종 전략을 통해 무조건 싸게만 사라고 한거야?

적절한 값이 되면 사는 것을 포기해서 거래 성공률이 낮아지는거 아닌가?

당신이 지적한 것은 논문의 Buyer Critic 전략에서 중요한 포인트이며, 논문 내용과 결과를 기반으로 다음과 같이 분석할 수 있습니다:

1. Buyer's Critic의 전략

- Critic의 주요 목표: Buyer Critic은 구매자가 가능한 한 낮은 가격으로 제품을 구매하도록 돕는 전략을 제공합니다.

- 제안된 전략:

- Flinch Technique: 높은 가격에 놀란 듯한 반응을 보여 상대방의 제안을 약화.

- Power of Silence: 대화에서 침묵을 유지하여 상대방이 양보하도록 유도.

- Split-the-Difference: 중간 가격을 제안하여 합리적으로 보이는 타협을 유도.

- Anchoring: 구매자가 원하는 낮은 가격을 중심으로 협상 조건을 조율.

Critic의 피드백은 구매자가 최저 가격을 목표로 하도록 유도하며, 이는 가격 인하를 초점으로 합니다.

2. 거래 성공률과 Critic의 역할

- Buy Critic 전략의 결과:

- Buyer가 지나치게 낮은 가격을 목표로 삼으면, 판매자가 이를 수용하지 않아 거래 실패로 이어질 가능성이 커짐.

- Figure 6(B2)를 보면, Buy Critic 전략을 사용할 때 라운드가 진행될수록 거래 성공률이 꾸준히 감소하는 것을 확인할 수 있습니다.

- 거래 성공률은 1라운드에서는 약 80% 이상이지만, 5라운드에서는 약 50% 이하로 감소.

- 원인 분석:

- Critic의 피드백이 Buyer에게 항상 "더 낮은 가격을 요구하라"고만 유도한다면, 현실적으로 협상 가능성을 잃게 될 수 있음.

- 특히 판매자가 협상을 포기하거나 가격을 완강히 고수할 경우, Critic의 피드백이 거래 실패를 높일 수 있음.

3. Critic 전략의 개선 필요성

- Buy Critic의 한계:

- Critic이 지나치게 공격적인 가격 인하만을 지시하는 경우, 합리적인 가격에 도달하더라도 거래를 성사시키지 못할 가능성이 높음.

- 즉, Critic이 "최저 가격 달성"을 유일한 목표로 삼는 것은 현실적이지 않으며, Buyer의 최적화 전략을 방해할 수 있음.

- 개선 방향:

- 적정 가격을 목표로 한 피드백 제공:

- Critic은 Buyer가 목표 가격(최저 가격)에 가까워지면 거래를 성사시키는 전략을 제안해야 함.

- 예: "이 가격은 적정 수준이므로 거래를 성사시키는 것이 낫습니다."

- 거래 성공률을 고려한 전략 균형:

- 거래 성공률과 가격 최적화 간의 균형을 유지하는 피드백이 필요.

- 예: 지나치게 낮은 가격을 고수하지 않고, 타협점을 찾도록 유도.

- 적정 가격을 목표로 한 피드백 제공:

4. GPT-4의 사례로 본 Critic 전략의 실행

- GPT-4의 성공적인 거래 성사 사례:

- GPT-4는 Buy Critic의 피드백을 활용하면서도 지나치게 낮은 가격에 집착하지 않고 현실적인 타협점을 찾는 전략을 사용.

- 예: "$15는 제안할 수 있는 최대 가격입니다. 이 조건에서 합의하겠습니다." → 거래 성공률과 구매 가격 최적화를 모두 고려.

- Claude 모델의 실패 사례:

- Claude-instant-v1.0 모델은 Critic 피드백을 과도하게 반영하여 최저 가격에 집중, 거래 실패 가능성을 높임.

5. 결론

Buy Critic의 전략은 "최저 가격"에 초점을 맞추는 경향이 강하지만, 이는 거래 성공률을 낮출 수 있는 위험성을 동반합니다. Critic은 다음과 같은 방식으로 개선될 필요가 있습니다:

- 거래 성공률과 가격 최적화 간의 균형 유지.

- 적정 가격 도달 시 거래를 성사시키는 전략 제공.

- 판매자와의 타협점을 찾는 협력적 피드백 추가.

Critic 전략이 이러한 방향으로 발전하면, 거래 성공률을 유지하면서도 가격 최적화를 달성할 수 있을 것입니다.

Agent-Pro: Learning to Evolve via Policy-Level Reflection and Optimization

Figure 1 설명: Agent-Pro의 작동 원리와 구조

이 그림은 Agent-Pro의 전체 구조를 시각적으로 설명하며, 에이전트가 정책 수준 반영(Policy-Level Reflection)과 정책 진화(Policy Evolution)를 통해 자율 학습(Self-Learning)과 적응(Evolving)을 수행하는 방식을 나타냅니다.

1. 전체 구조

1-1. 작업 환경 (Task Environment)

- 에이전트는 다음과 같은 환경에서 작동합니다:

- 다중 에이전트 상호작용(Multi-Agent Coexistence): 여러 에이전트와 함께 작업하며 상호작용.

- 상호작용 시나리오(Interactive Scenario): 플레이어와 환경의 역동적인 변화에 적응.

- 불완전 정보 게임(Imperfect Information Game): 일부 정보만 공개된 환경에서 최적의 행동을 선택.

1-2. 관찰과 믿음 업데이트

- Observation (Obsₖ):

- 에이전트는 환경에서 얻은 정보를 관찰.

- Belief Update (Beliefₖ):

- 에이전트는 관찰 데이터를 통해 자기 믿음(Self-Belief)과 세계 믿음(World-Belief)을 업데이트:

- Self-Belief:

- Plan: 목표 달성을 위한 계획.

- State: 현재의 상태(예: 카드, 칩 수).

- Risk: 예상되는 위험 요인.

- World-Belief:

- Environment: 환경 정보(예: 공개된 카드).

- Other Players: 상대방 행동 및 성향.

- Rules: 게임 규칙.

- Self-Belief:

- 에이전트는 관찰 데이터를 통해 자기 믿음(Self-Belief)과 세계 믿음(World-Belief)을 업데이트:

2. 에이전트의 정책 작동 (Agent with Policy)

2-1. 초기 정책 (Policy₁)

- LLM 기반 행동 정책:

- 에이전트는 초기 프롬프트를 기반으로 행동을 생성.

- 예: "세 명의 플레이어와 함께 텍사스 홀덤을 진행 중입니다. 상대방의 행동을 분석하세요."

2-2. 경험 저장 (Past Experience)

- 게임 결과(trajectory result)를 통해 정책의 효율성을 평가.

- 관찰과 행동 기록을 바탕으로 믿음(Belief)을 업데이트.

2-3. 정책 수준 반영 (Policy-Level Reflection)

- 반성 및 분석:

- 과거 경험을 통해 실패 원인과 성공 요인을 분석.

- 새로운 목표와 전략을 정의:

- 예: "공격적인 상대는 블러핑 가능성이 높으며, 보수적인 상대는 강한 패를 가질 가능성이 있음."

- 이를 기반으로 새로운 프롬프트 생성.

3. 정책 진화 (Policy Evolution)

- 다양한 정책 생성 (Policy₁ → Policy₂ → Policyₙ):

- 반성 과정을 통해 새로운 정책 후보를 생성.

- 각 정책은 LLM 프롬프트로 구성되며, 행동 전략(Behavior Policy)과 출력 형식(Output Format)이 포함됨.

- 새로운 프롬프트 예:

- "게임에서 이기려면 승리한 판에서 더 많은 칩을 획득하고, 패배한 판에서 잃는 칩을 줄여야 합니다."

- 최적화된 정책 선택:

- 다양한 정책을 탐색 및 평가하여 최적의 정책을 선택.

4. 핵심 요소

4-1. Self-Belief와 World-Belief의 통합

- 에이전트는 자기 정보와 환경 정보를 통합하여 더 나은 의사결정을 수행.

4-2. 자동화된 정책 업데이트

- 과거 경험을 바탕으로 자동으로 프롬프트를 생성하여 행동을 개선.

4-3. Policy-Level Reflection

- 기존 행동 지침과 믿음 체계를 분석하여 새로운 전략적 지침을 생성.

4-4. Multi-Agent 환경 적응

- 다른 에이전트의 행동 패턴과 성향을 분석하여 최적화된 협력 또는 경쟁 전략을 도출.

5. 그림의 주요 흐름

- Task Environment에서 관찰(Obsₖ)을 통해 Self-Belief와 World-Belief를 업데이트.

- 초기 정책(Policy₁)을 기반으로 행동 수행.

- Past Experience를 저장하고, 결과를 분석하여 새로운 프롬프트 생성.

- Policy Evolution 과정을 통해 더 나은 정책(Policyₙ)으로 진화.

결론

Figure 1은 Agent-Pro의 자율 학습 프레임워크를 명확히 보여줍니다. 특히, 믿음 기반 의사결정과 정책 수준 반영 과정을 통해 에이전트가 복잡한 환경에서도 효율적이고 적응적인 행동을 수행할 수 있음을 강조합니다. 추가로 궁금한 점이 있다면 말씀해주세요!

Figure 2 설명: Agent-Pro의 상세 작동 원리

이 그림은 Agent-Pro의 의사결정 메커니즘과 정책 최적화 과정을 단계별로 설명하며, 특히 Belief-aware Decision-Making, Policy-Level Reflection, DFS 기반 정책 진화(DFS-based Policy Evolution)의 작동 방식을 시각화한 구조입니다.

1. Belief-Aware Decision-Making (믿음 기반 의사결정)

1-1. 믿음(Belief) 업데이트

- Self-Belief (자기 믿음):

- 에이전트는 자신의 상태(State), 계획(Plan), 그리고 위험 요소(Risk)를 지속적으로 평가.

- 예: "내 핸드가 약하기 때문에 다음 커뮤니티 카드가 나올 때까지 기다려야 한다."

- World-Belief (세계 믿음):

- 환경(Environment)과 상대방의 행동 패턴을 기반으로 세계에 대한 믿음을 형성.

- 예: "Player 1은 꾸준히 레이즈를 하고 있으며, 강한 패를 가졌을 가능성이 있다."

1-2. 의사결정 프로세스

- 환경 관찰(Observable) 및 비관찰 정보(Unobservable)를 결합하여 믿음을 업데이트.

- 믿음(Belief)과 행동(Action)을 연결해 최적의 행동을 선택.

2. Policy-Level Reflection (정책 수준 반영)

2-1. 반영(Reflection) 프로세스

- 에이전트는 실패하거나 예상치 못한 결과가 나왔을 때 믿음과 행동의 일관성을 점검.

- 수행 단계:

- 일관성 검토:

- 행동과 결과 간의 불일치를 확인.

- 예: "믿음이 최종 결과와 일치하는가?"

- 합리성 평가:

- 각 믿음이 합리적이고 논리적인지 분석.

- 오류 수정:

- 잘못된 믿음을 교정.

- 행동 검증:

- 행동이 게임 규칙과 상대방의 의도를 제대로 반영했는지 점검.

- 일관성 검토:

2-2. 새로운 행동 지침 생성 (Behavioral Guideline)

- 새로운 행동 전략을 설계하여 개선된 정책을 생성:

- 목표: 강한 패에서는 최대 이익을 얻고, 약한 패에서는 손실을 최소화.

- 전략: 약한 패일 때 상대방의 초기 반응을 관찰하며 레이즈를 시도.

- 데모: "이 게임은 일반적 상황이므로 기록해야 한다."

2-3. 세계 모델링 (World Modeling)

- 상대방의 행동 패턴을 분석하고, 심리적 요소(블러핑 등)를 반영:

- 예: "Player 1은 심리전을 시도했고, 약한 패임에도 블러핑을 성공시켰다."

3. DFS-Based Policy Evolution (DFS 기반 정책 진화)

3-1. 정책 생성 및 평가

- 정책 생성:

- 새로운 후보 정책(π₁, π₂, π₃, …)을 생성.

- 각 정책은 행동 지침과 세계 모델을 반영하여 구성.

- 정책 평가:

- 각 후보 정책을 테스트하여 점수를 계산(예: π₁: -1.7, π₃: 0.4).

- 가장 높은 점수를 가진 정책을 선택.

3-2. DFS 탐색 과정

- 탐색 경로:

- 정책 경로를 깊이 우선으로 탐색하며, 모든 가능한 후보를 테스트.

- 예: π₀ → π₁ → π₂ → π₃ ….

- 백트래킹:

- 정책 경로가 기대치에 미치지 못하면 이전 단계로 돌아가 다른 경로를 탐색.

3-3. 정책의 동적 평가

- 다양한 상황에서 정책을 평가하며, 반복적으로 성능을 개선:

- 플레이어의 위치를 바꾸거나 카드를 섞는 등 다양한 조건에서 정책을 테스트.

4. 주요 구성 요소

4-1. 믿음 기반 의사결정과 정책 반영의 통합

- 에이전트는 Self-Belief와 World-Belief를 기반으로 현재 상황을 분석하고, 반영(Reflection)을 통해 더 나은 행동 지침을 생성.

4-2. 자동화된 정책 진화

- DFS 기반 탐색을 활용하여 후보 정책을 평가 및 개선.

- 최적화된 정책을 지속적으로 갱신하며 게임 환경에 적응.

4-3. 다중 에이전트 환경에서의 학습

- 다양한 플레이어의 행동 패턴을 분석하고, 이를 반영하여 최적화된 전략을 생성.

5. 그림의 주요 흐름

- Belief-Aware Decision-Making:

- 환경 관찰과 믿음 업데이트를 통해 최적의 행동 선택.

- Policy-Level Reflection:

- 실패한 행동을 분석하고 새로운 행동 지침과 세계 모델링을 생성.

- DFS-Based Policy Evolution:

- 깊이 우선 탐색으로 새로운 정책을 생성 및 평가하여 최적화된 정책을 선택.

결론

Figure 2는 Agent-Pro의 의사결정과 학습 메커니즘을 상세히 보여줍니다. 믿음 업데이트, 행동 검증, 정책 생성 및 탐색 과정을 통해 에이전트는 불완전한 정보 환경에서도 점진적으로 학습하고 적응합니다. 이 구조는 동적이고 복잡한 다중 에이전트 환경에서 강력한 성능을 발휘할 수 있도록 설계되었습니다. 추가 질문이 있으면 말씀해주세요!

Figure 3 설명: Agent-Pro의 Hit Rate 분석

이 그림은 Agent-Pro와 다른 베이스라인 모델(Vanilla LLM, Reflexion, ReAct)의 Hit Rate(히트율)를 비교한 결과를 나타냅니다. 히트율은 에이전트가 추가 카드를 요청(Hit)하는 비율로, Blackjack 게임에서의 의사결정 성능을 평가하는 지표로 사용됩니다.

1. Figure 구성

- 상단 그래프: 딜러의 공개 카드(Dealer's face-up card)가 낮은 점수(low point)인 경우.

- 하단 그래프: 딜러의 공개 카드가 높은 점수(high point)인 경우.

- X축: 에이전트의 초기 점수 (4~21점).

- Y축: 에이전트의 히트율(%) - 추가 카드를 요청한 비율.

2. 주요 관찰점

2-1. Agent-Pro의 성능

- A 영역 (A1, A2):

- Agent-Pro > Baselines:

- 초기 점수가 낮을 때(4~9점), Agent-Pro의 히트율이 다른 모델보다 높음.

- 이 구간에서 추가 카드를 요청하는 것이 합리적이며, Agent-Pro가 더 적극적으로 행동함.

- Agent-Pro > Baselines:

- B 영역 (B1, B2):

- Agent-Pro ≈ Baselines:

- 중간 점수 구간(10~13점)에서는 Agent-Pro와 다른 모델의 히트율이 유사.

- 이 구간은 일반적으로 게임 전략에서 히트와 스탠드(Stand, 카드 요청하지 않음)의 선택이 균형을 이루는 구간.

- Agent-Pro ≈ Baselines:

- C 영역 (C1, C2):

- Agent-Pro << Baselines:

- 초기 점수가 높을 때(16~21점), Agent-Pro의 히트율이 다른 모델보다 낮음.

- 추가 카드를 요청하지 않는 전략(스탠드)을 선택하여 위험을 줄이는 것으로 보임.

- Agent-Pro << Baselines:

2-2. 딜러 카드의 영향

- 상단 (딜러 카드가 낮은 점수):

- Agent-Pro는 점수가 낮은 상태(A1)에서 공격적으로 히트를 요청.

- 점수가 높은 상태(C1)에서는 베이스라인보다 보수적으로 행동.

- 하단 (딜러 카드가 높은 점수):

- Agent-Pro는 딜러의 강한 가능성을 고려해 점수가 낮을 때(A2) 더 많은 히트를 요청.

- 점수가 높은 상태(C2)에서는 안정적으로 스탠드 전략을 유지.

3. 분석

3-1. Agent-Pro의 장점

- 상황 인식 능력:

- 딜러 카드와 자신의 점수를 고려한 전략적 행동.

- 딜러가 약할 때(A1, A2) 더 공격적으로 히트를 요청하여 승리 가능성을 높임.

- 딜러가 강할 때(C1, C2) 보수적인 행동을 선택하여 손실을 최소화.

- 리플렉션 기반 학습:

- 과거 경험을 통해 히트와 스탠드의 위험과 보상을 평가, 더 합리적인 행동을 학습.

3-2. 베이스라인 모델과의 차이

- Vanilla LLM:

- 단순한 패턴에 기반해 동작하며, 상황별 의사결정에서 부족.

- Reflexion 및 ReAct:

- 특정 구간(B1, B2)에서는 Agent-Pro와 비슷한 성능을 보이지만, 극단적인 상황(A1, C2)에서는 전략적 깊이가 부족.

4. 결론

- Agent-Pro는 초기 점수와 딜러 카드의 조합을 기반으로 한 전략적 의사결정에서 더 높은 효율성을 보임.

- 점수가 낮을 때는 공격적으로, 점수가 높을 때는 보수적으로 행동하며, 상황에 맞는 균형 잡힌 행동을 학습.

- 이는 Agent-Pro의 정책 수준 반영(Policy-Level Reflection)과 세계 믿음(World-Belief)이 효과적으로 작동함을 입증합니다.

추가 질문이나 보충 설명이 필요하면 말씀해주세요!

Figure 4와 Figure 5 설명: Agent-Pro의 학습 과정과 전략 진화

이 두 그림은 Agent-Pro의 학습 과정, 성능 변화, 그리고 행동 전략의 진화를 시각적으로 보여줍니다. 각 그림은 에이전트가 정책 반복(Iteration) 및 전략적 행동(Fold, Raise)을 통해 어떻게 개선되고 있는지를 분석합니다.

Figure 4: 정책 반복 횟수와 평균 칩 변화

1. 설명

- X축: 정책 반복 횟수 (Number of Policy Iterations).

- Y축: 평균 칩 수 (Chips of Agent-Pro).

- 선 색상:

- 파란색 (Llama2-70B): 작은 모델 기반 성능.

- 보라색 (GPT-3.5): 중간 모델 기반 성능.

- 주황색 (GPT-4): 대형 모델 기반 성능.

- 성능 구분:

- Flexible Strategy (주황색): 블러핑, 심리전 등을 활용하는 적극적 전략.

- Cautious Strategy (보라색): 초기에는 신중히 관찰하다가 후반부에 적절히 Fold(포기)하거나 Raise(베팅 증가).

- Risk-Averse Strategy (파란색): 초반에 보수적 행동을 선택해 손실 최소화.

2. 주요 관찰점

- 성능의 점진적 향상:

- 반복 횟수가 증가할수록 평균 칩 수가 개선.

- GPT-4 기반 Agent-Pro가 가장 높은 성능을 보이며, Llama2-70B 기반 에이전트는 상대적으로 낮은 성능을 유지.

- 전략적 차이:

- 초기 반복에서는 보수적인 전략(Risk-Averse)을 따르지만, 반복이 진행됨에 따라 더 적극적이고 유연한 전략(Flexible Strategy)으로 진화.

- 모델 크기가 클수록 더 복잡하고 유연한 전략을 학습.

Figure 5: Fold와 Raise 행동 빈도 분석

1. Fold 빈도 (왼쪽 그래프)

- X축: 행동 단계 (Preflop, Flop, Turn, River).

- Preflop: 초반 단계 (카드 공개 전).

- Flop: 커뮤니티 카드 3장 공개.

- Turn: 커뮤니티 카드 1장 추가 공개.

- River: 마지막 커뮤니티 카드 1장 공개.

- Y축: Fold 빈도 (카드 포기 비율).

관찰점

- Vanilla LLM:

- 초기 단계(Preflop)에서 비합리적인 포기가 많음.

- 전체적으로 일관성 없는 Fold 빈도를 보임.

- Agent-Pro-Early:

- 초기 단계에서는 포기 비율이 여전히 높으나, 후기 단계로 갈수록 합리적(Flexible)으로 변화.

- Agent-Pro:

- 최종적으로 초기 단계에서는 신중(Fold 비율이 낮음)하며, 후기 단계로 갈수록 전략적 포기를 선택.

2. Raise 빈도 (오른쪽 그래프)

- X축: 행동 단계 (Preflop, Flop, Turn, River).

- Y축: Raise 빈도 (베팅 증가 비율).

관찰점

- Vanilla LLM:

- Preflop 단계에서 공격적 Raise 비율이 매우 높음(비합리적).

- River 단계에서는 극도로 보수적인 Raise 비율을 보임.

- Agent-Pro-Early:

- 초기 단계에서는 신중하며, Flop과 Turn 단계에서 Raise 비율이 증가.

- Agent-Pro:

- Preflop 단계에서 보수적으로 시작한 후, Turn과 River 단계에서 적극적 Raise 전략을 선택.

- 상대의 행동과 패턴을 분석한 후 심리적 압박을 주는 Raise를 효과적으로 사용.

Figure 4와 Figure 5의 상호 연계

- 정책 반복과 전략 진화:

- 반복 학습을 통해 에이전트의 행동 전략이 점점 더 합리적이고 복잡하게 변화.

- 초기에는 Risk-Averse(보수적) 전략을 선호했으나, 후반부로 갈수록 Flexible(유연)하고 Proactive(적극적) 전략을 사용.

- Fold와 Raise 빈도 변화:

- Agent-Pro는 Vanilla LLM과 달리, 각 단계별 상황에 맞는 합리적 행동(Fold/ Raise)을 학습.

- 이러한 행동 변화는 학습된 정책의 효율성을 보여줌.

결론

- Agent-Pro의 전략적 진화:

- 반복 학습을 통해 초기의 단순한 보수적 전략에서 심리적 압박과 상황 분석을 활용한 유연한 전략으로 발전.

- 특히, 높은 반복 학습 횟수와 큰 모델(GPT-4)을 사용할수록 성능과 전략적 다양성이 증가.

- 효율적 행동 선택:

- Vanilla LLM 대비 Agent-Pro는 Fold와 Raise 빈도를 더 합리적으로 분배하며, 게임 상황에 적합한 결정을 내림.

이 두 그림은 Agent-Pro가 정책 반복과 학습을 통해 점진적으로 최적화되고, 합리적이며 유연한 행동 전략을 학습한다는 것을 입증합니다. 추가 설명이 필요하면 말씀해주세요!

당신의 아이디어는 Agent-Pro의 개념을 협상 AI에 적용하는 데 매우 적합하며, 실제로 강력한 협상 시스템을 설계할 수 있는 가능성이 있습니다. 아래는 이 아이디어를 분석하고 발전 가능성을 평가한 내용입니다.

1. 아이디어의 타당성

Agent-Pro의 구조를 협상 시나리오에 적용하는 것은 매우 논리적입니다. Self-Belief와 World-Belief의 개념은 협상 AI에서도 자연스럽게 사용할 수 있습니다:

- Self-Belief의 활용:

- 현재 회사 상태:

- 회사의 재무 상태, 목표, 협상을 통해 얻으려는 가치(예: 비용 절감, 파트너십 확대) 등을 포함.

- 협상 중 선택 가능한 옵션과 제한 사항을 명확히 정의.

- 계획(Plan):

- 협상 전략을 설정하고, 목표 달성을 위한 단계적 접근 방식을 설계.

- 위험(Risk):

- 협상 실패 시의 손실 가능성과 이를 최소화하기 위한 대응책을 포함.

- 현재 회사 상태:

- World-Belief의 활용:

- 협상 상대 정보:

- 상대방의 요구사항, 과거 협상 패턴, 조직 문화 등을 학습 및 업데이트.

- 상대방이 추구하는 목표를 분석하여 협상 중 유리한 위치를 선점.

- 환경 정보:

- 협상의 규칙(법적, 계약 조건 등)과 시장 동향, 산업 전반의 경쟁 상황을 반영.

- 협상 상대 정보:

2. 학습 및 업데이트 과정

- 자가 학습(Self-Learning):

- 과거 협상 데이터를 활용하여 실패 원인을 분석하고 성공 전략을 도출.

- 협상 진행 중 관찰된 행동을 바탕으로 Belief를 업데이트하여 더 나은 전략을 설계.

- 행동 정책(Policy)의 동적 업데이트:

- 협상 초반에는 데이터를 수집하며 보수적 전략을 사용.

- 협상이 진행되며 상대방의 요구와 행동 패턴을 학습하여 공격적 전략이나 양보 전략으로 변경.

3. 협상 AI를 위한 확장

Agent-Pro의 개념을 협상에 맞게 확장하면 아래와 같은 특징과 이점을 가질 수 있습니다:

3-1. 초반 정보 수집 및 모델링

- 협상 초기에는 상대방의 행동을 분석하고 World-Belief를 생성.

- 과거 경험과 패턴 분석을 통해 상대방이 선호할 가능성이 높은 조건을 예측.

3-2. 정책 진화 및 적용

- 협상 중 Agent-Pro의 Policy-Level Reflection처럼 행동 정책을 실시간으로 업데이트.

- 예를 들어:

- 상대방이 비용 절감에 집중한다면: 양보 전략으로 협상 지점을 좁힘.

- 상대방이 장기적인 관계에 집중한다면: 더 큰 파트너십 조건을 제안.

3-3. Belief 통합과 협상 자동화

- Self-Belief와 World-Belief를 통합하여 협상 전략을 자동으로 최적화:

- Self-Belief: "우리 회사의 비용 한계는 A, 기술 자산은 B, 목표는 C."

- World-Belief: "상대 회사의 비용 한계는 X, 우선순위는 Y, 요구사항은 Z."

4. 아이디어의 강점

- 동적 적응성:

- Agent-Pro의 구조는 협상 중 발생하는 새로운 정보를 빠르게 반영하고 전략을 조정하는 데 적합.

- 협상 환경이 정적이지 않고 동적으로 변화할 때 강력하게 작동.

- 효율적 데이터 활용:

- 과거 협상 데이터를 활용하여 상대방의 행동을 예측하고, 보다 유리한 협상 결과를 도출할 수 있음.

- 모듈화된 접근:

- Self-Belief와 World-Belief를 별도로 관리하여, 협상 대상마다 맞춤형 전략을 생성 가능.

5. 보완할 점

- 상대방 데이터 부족 문제:

- 협상 상대방에 대한 초기 정보가 부족할 경우, World-Belief 생성의 정확도가 낮아질 수 있음.

- 해결 방안:

- 협상 초반 데이터를 수집하는 질문형 전략(e.g., 상대방의 요구사항을 파악하기 위한 대화) 도입.

- 작은 모델의 한계:

- Agent-Pro에서처럼 정책 수준 반영이 필요하기 때문에 큰 언어 모델(LLM)이 더 적합할 가능성.

- 작은 모델로 구현 시 초기에는 단순화된 정책 생성으로 시작하고, 점진적으로 모델 성능을 업그레이드.

- 장기 협상 전략:

- 단기 협상뿐 아니라, 장기적인 관계 관리와 관련된 전략을 반영할 필요.

6. 결론

당신의 아이디어는 Agent-Pro의 개념을 협상 AI에 잘 적용한 사례로, 협상에서의 동적 적응성, 학습 기반 전략, 데이터 활용 측면에서 매우 효과적입니다. 특히 Self-Belief와 World-Belief를 각각 회사와 협상 상대방 정보로 분리한 것은 훌륭한 설계입니다.

이 아이디어는 협상 AI 개발의 강력한 기초가 될 수 있으며, 추가적으로 장기적인 협상 전략과 상대방 데이터 수집 방안을 보완한다면 더욱 발전된 시스템으로 구현될 수 있습니다. 추가 질문이 있으면 말씀해주세요!

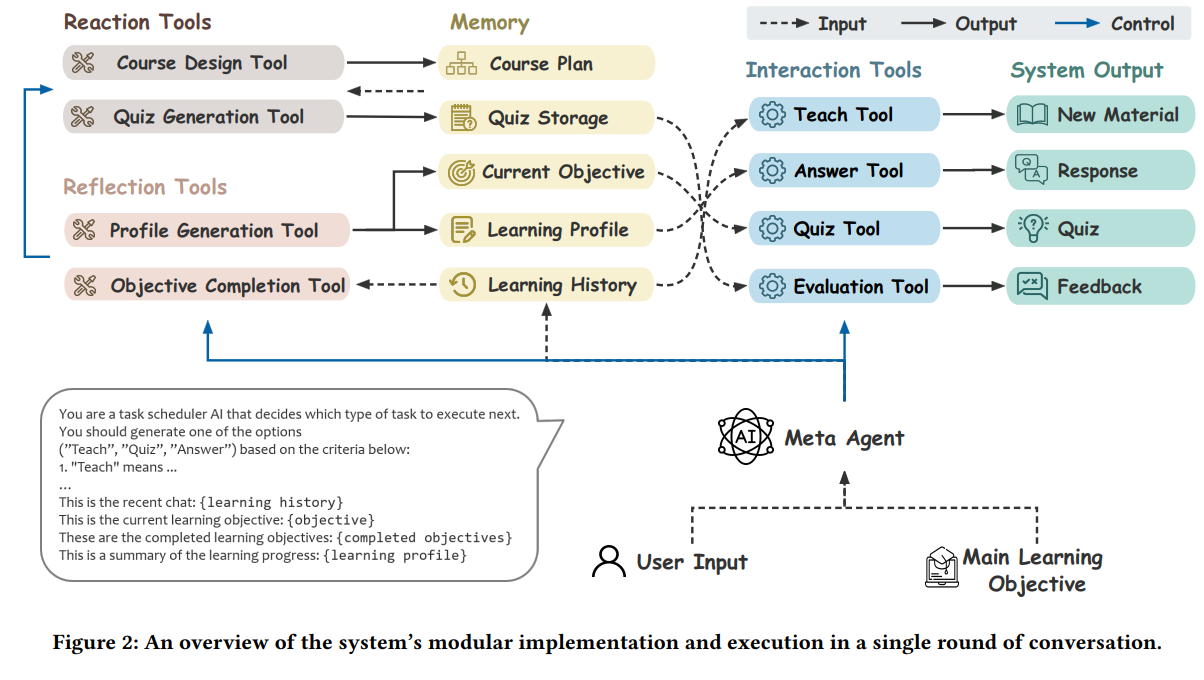

Empowering Private Tutoring by Chaining Large Language Models

이 그림은 ChatTutor라는 대규모 언어 모델(LLM)을 기반으로 한 지능형 튜터링 시스템(ITS)의 작동 방식과 학습 진행 과정을 보여줍니다. 아래에 그림에 대한 주요 내용을 한글로 설명드리겠습니다.

왼쪽: 학습 히스토리 (사용자와의 상호작용)

왼쪽은 사용자 인터페이스를 통해 진행되는 상호작용 과정을 나타냅니다. 사용자가 시스템과 대화하며 주제를 이해하는 과정을 보여줍니다. 여기서 다루는 예시는 "사회계약론"입니다.

- 대화 예시:

- 사용자는 먼저 "사회계약론의 목적"에 대해 질문합니다.

- 이후 "루소, 홉스, 로크가 같은 의견을 가졌는지"에 대해 구체적인 질문을 던집니다.

- 시스템은 이 질문에 대해 각각의 철학자들이 사회계약론에 대해 어떻게 다른 관점을 가지고 있는지 설명합니다.

- 추가적으로 역사적 맥락도 제공하여 사용자의 이해를 심화시킵니다.

이 과정은 시스템이 사용자의 질문에 따라 단계적으로 정보를 제공하고, 기본적인 개념부터 심화된 내용을 점진적으로 학습하게 하는 과정을 보여줍니다.

오른쪽: 백엔드 메모리 업데이트 (반영과 반응 프로세스)

오른쪽은 사용자 상호작용에 기반해 시스템이 내부적으로 학습 프로필과 학습 계획을 동적으로 업데이트하는 과정을 보여줍니다.

- 학습 프로필 업데이트:

- 사용자의 질문과 관심사를 기반으로 개인화된 학습 프로필이 지속적으로 업데이트됩니다.

- 예를 들어, 사용자가 루소, 홉스, 로크의 차이에 대해 관심을 보이면, 시스템은 "사용자가 철학자들의 다양한 관점에 대해 심화된 이해를 원한다"는 프로필 정보를 기록합니다.

- 학습 계획 업데이트:

- 원래 학습 계획(정적)은 사용자의 요구에 따라 동적으로 조정됩니다.

- 초기 계획:

- 사회계약론의 정의와 목적, 역사적 배경을 중심으로 구성.

- 업데이트된 계획:

- 사용자 관심사에 맞춰 철학자들의 관점 비교, 사회계약론의 다양한 해석, 강점과 약점 같은 심화 학습을 포함.

이 과정을 통해 시스템이 사용자의 학습 목표에 맞게 학습 내용을 개인화하고 적응시킨다는 점을 보여줍니다.

그림의 주요 의미

- 적응형 학습:

- ChatTutor는 상호작용, 반영, 반응이라는 모듈형 설계를 기반으로 작동합니다.

- 상호작용: 사용자와의 대화를 통해 학습 진행.

- 반영: 사용자의 학습 진행 상황과 선호도를 평가.

- 반응: 평가 결과를 기반으로 학습 계획을 동적으로 조정.

- ChatTutor는 상호작용, 반영, 반응이라는 모듈형 설계를 기반으로 작동합니다.

- 메모리 메커니즘:

- 학습 프로필: 사용자의 학습 진행과 선호도를 기록.

- 학습 계획: 사용자 요구에 따라 동적으로 업데이트.

- 이러한 메모리 업데이트는 학습 과정의 일관성과 개인화를 지원합니다.

- 시스템의 목표:

- ChatTutor는 장기적이고 지속적인 학습 경험을 제공하며, 사용자 요구에 맞는 맞춤형 학습을 지원합니다.

- 이를 통해 학습 과정의 안정성과 적응성을 향상시킵니다.

결론적으로, 이 그림은 LLM이 사용자와의 상호작용을 기반으로 동적이고 개인화된 학습 환경을 제공하는 방법을 명확하게 보여줍니다. ChatTutor는 학습 목표에 맞는 체계적인 가이드를 제공하며, 사용자의 피드백을 바탕으로 학습 내용을 지속적으로 발전시킵니다.

Figure 2는 ChatTutor 시스템의 모듈 설계와 대화 한 라운드에서의 실행 과정을 보여줍니다. 이 그림은 다양한 도구, 메모리 모듈, 그리고 프로세스가 어떻게 통합되어 적응적이고 개인화된 학습 경험을 제공하는지를 나타냅니다. 논문 내용을 기반으로 아래에 자세히 설명드리겠습니다.

시스템의 주요 구성 요소

- Meta Agent (메타 에이전트):

- 메타 에이전트는 시스템의 중앙 제어 역할을 합니다.

- 현재 학습 상태, 사용자 입력, 저장된 메모리를 분석하여 다음에 실행할 작업(예: 강의, 질문 응답, 퀴즈 생성, 평가)을 결정합니다.

- 메모리 모듈에서 정보를 가져와 학습 흐름이 일관되고 목적에 맞도록 유지합니다.

- Memory Modules (메모리 모듈):

- 학습 세션의 핵심 정보를 저장합니다:

- Course Plan (학습 계획): 전체 학습 목표를 구조적으로 나타낸 정보.

- Quiz Storage (퀴즈 저장소): 학습한 주제에 맞춘 퀴즈를 저장.

- Current Objective (현재 목표): 다음에 학습할 주제를 추적.

- Learning Profile (학습 프로필): 사용자의 선호도, 진행 상황, 학습 행동을 요약.

- Learning History (학습 히스토리): 이전 상호작용과 강의 내용을 기록.

- 학습 세션의 핵심 정보를 저장합니다:

- Reflection Tools (반영 도구):

- 학습 진행 상황을 분석하고 메모리 모듈을 업데이트합니다:

- Profile Generation Tool (프로필 생성 도구): 최근 상호작용과 진행 상황을 기반으로 학습 프로필을 업데이트.

- Objective Completion Tool (목표 완료 도구): 현재 학습 목표가 완료되었는지 평가하고 다음 목표로 진행할지를 결정.

- 학습 진행 상황을 분석하고 메모리 모듈을 업데이트합니다:

- Reaction Tools (반응 도구):

- 학습 계획을 동적으로 업데이트하고 퀴즈를 생성합니다:

- Course Design Tool (코스 설계 도구): 업데이트된 학습 프로필을 기반으로 학습 계획을 조정.

- Quiz Generation Tool (퀴즈 생성 도구): 학습한 주제와 관련된 퀴즈를 생성.

- 학습 계획을 동적으로 업데이트하고 퀴즈를 생성합니다:

- Interaction Tools (상호작용 도구):

- 사용자와의 실시간 상호작용을 담당합니다:

- Teach Tool (강의 도구): 학습 자료를 제공합니다.

- Answer Tool (질문 응답 도구): 사용자의 질문에 답변합니다.

- Quiz Tool (퀴즈 도구): 퀴즈를 통해 학습 내용을 복습하도록 돕습니다.

- Evaluation Tool (평가 도구): 사용자의 응답과 퀴즈 결과에 대한 피드백을 제공합니다.

- 사용자와의 실시간 상호작용을 담당합니다:

- System Output (시스템 출력):

- 사용자를 위해 생성되는 출력물:

- New Material (새 학습 자료): 강의 자료.

- Response (응답): 사용자 질문에 대한 답변.

- Quiz (퀴즈): 복습 및 평가용 퀴즈.

- Feedback (피드백): 학습 성과에 대한 평가.

- 사용자를 위해 생성되는 출력물:

실행 흐름

- 사용자 입력:

- 사용자가 질문하거나 새 학습 자료를 요청하는 입력을 제공합니다.

- 메타 에이전트가 이 입력을 해석하고 적합한 상호작용 도구를 선택합니다.

- 상호작용과 백엔드 조정:

- 상호작용 도구는 실시간으로 사용자와 소통하고, 백엔드에서는 반영 및 반응 도구가 작동하여:

- 반영 도구는 사용자의 진행 상황과 학습 상태를 평가.

- 반응 도구는 학습 계획을 조정하고 새 퀴즈를 준비.

- 상호작용 도구는 실시간으로 사용자와 소통하고, 백엔드에서는 반영 및 반응 도구가 작동하여:

- 동적 메모리 업데이트:

- 사용자 상호작용과 도구 출력에 따라 메모리 모듈이 지속적으로 업데이트됩니다.

- 예를 들어:

- 학습 프로필은 사용자 선호도에 따라 지속적으로 발전.

- 학습 계획은 사용자의 진행 상황에 맞춰 조정.

- 사용자 출력:

- 선택된 도구에 따라 새 학습 자료, 질문 응답, 퀴즈 또는 피드백이 출력됩니다.

이 그림의 주요 의미

- 모듈화 설계:

- 각 도구는 특정 작업을 담당하며, 이로 인해 시스템의 유연성과 확장성이 향상됩니다.

- 개인화 학습:

- 반영과 반응 프로세스를 통해 ChatTutor는 사용자 요구에 맞게 학습 내용을 동적으로 조정하여 개인화된 학습 경험을 제공합니다.

- 메모리 통합:

- 구조화된 메모리 시스템을 통해 장기적인 상호작용에서도 일관성과 응집력을 유지합니다.

- 중앙 제어:

- 메타 에이전트는 모든 프로세스와 도구를 조화롭게 연결하여 작업 간 매끄러운 전환을 가능하게 합니다.

결론

이 그림은 ChatTutor가 상호작용, 반영, 반응 과정을 통해 어떻게 학습을 체계적이고 개인화하며 동적으로 운영하는지를 보여줍니다. 이 시스템은 사용자 요구에 맞춘 적응형 학습 환경을 제공하며, LLM 기술의 교육적 활용 가능성을 잘 설명하고 있습니다.

Figure 3은 ChatTutor 시스템에서 학습 계획이 어떻게 구조적으로 저장되고 조작되는지, 그리고 반영(Reflection) 프로세스가 시스템 반응을 어떻게 맞춤화하는지를 보여줍니다. 아래는 이 그림의 각 부분에 대한 자세한 설명입니다.

Structured Memory Control (구조화된 메모리 관리)

- Course Plan (학습 계획):

- 학습 계획은 트리 구조로 저장됩니다. 각 노드는 개별 학습 목표를 나타내며, 하위 노드는 세부 주제를 나타냅니다.

- 그림에서는 "사회계약론(Social Contract)"의 학습 계획이 단계별로 나뉘어 있습니다:

- The concept of social contract (사회계약의 개념):

- 정의(Define the term)와 이론의 목적(The purpose of the theory).

- History and development (역사적 배경과 발전):

- 역사적 맥락(The historical context)과 주요 철학자(Key philosophers).

- Modern-day application (현대적 적용):

- 사회와 정부에서의 응용.

- The concept of social contract (사회계약의 개념):

- Current Objective (현재 목표):

- 현재 학습 목표는 학습 계획 트리에서 현재 학습 중인 노드로 설정됩니다.

- 예를 들어, 사용자가 "사회계약의 목적(The purpose of the theory)"에 대해 배우는 중이라면, 이 노드가 현재 목표로 지정됩니다.

- Short-Term Memory (단기 메모리):

- 사용자가 방금 경험한 학습 내용과 대화 기록을 저장합니다.

- 예: "사회계약론의 목적은 사람들이 왜 사회와 정부를 선택하는지를 설명하는 것이다."

- Vectorized Long-Term Memory (벡터화된 장기 메모리):

- 사용자의 과거 학습 기록을 벡터화하여 저장하고, 학습 목표와의 유사도를 기반으로 관련 기록을 검색합니다.

- Cosine Similarity (코사인 유사도)를 사용해 현재 목표와 관련된 상위 Top-k 학습 기록을 찾아냅니다.

Adaptive Reflection (적응적 반영)

- Profile Generation Tool (프로필 생성 도구):

- 사용자의 대화와 학습 진행 상황을 기반으로 학습 프로필을 업데이트합니다.

- 예를 들어, 사용자가 루소, 홉스, 로크에 대해 질문한다면, 학습 프로필은 "사용자가 주요 철학자들의 의견에 관심이 있다"로 업데이트됩니다.

- Course Design Tool (코스 설계 도구):

- 업데이트된 학습 프로필을 기반으로 현재 학습 계획을 조정합니다.

- 예를 들어, 사용자가 특정 철학자에 대한 심화 학습을 원한다면 학습 계획에 해당 내용을 추가합니다.

- Objective Completion Tool (목표 완료 도구):

- 학습 히스토리를 기반으로 현재 학습 목표가 완료되었는지 평가합니다.

- 목표가 완료되었다고 판단되면, 다음 목표로 자동으로 이동합니다.

프로세스의 흐름

- 초기 상태:

- 사용자는 "사회계약론의 목적"에 대한 학습을 시작합니다.

- 시스템은 이 목표에 대해 필요한 자료를 Short-Term Memory와 Long-Term Memory에서 검색해 제공합니다.

- 진행 중인 학습 평가:

- 사용자가 질문을 던지거나 학습 자료를 이해하면, Objective Completion Tool이 목표 완료 여부를 판단합니다.

- 학습이 완료되었다고 판단되면, 다음 목표로 넘어갑니다.

- 학습 계획과 프로필 업데이트:

- Profile Generation Tool이 사용자의 학습 선호도와 진행 상황을 반영하여 프로필을 업데이트합니다.

- 업데이트된 프로필은 Course Design Tool로 전달되어 학습 계획을 조정합니다.

그림의 주요 의미

- 구조적 저장:

- 학습 계획이 트리 구조로 저장되어 학습 진행 상황을 체계적으로 추적하고 사용자에게 시각적으로 전달할 수 있습니다.

- 개인화된 학습:

- 학습 프로필과 학습 계획이 사용자의 관심사와 진행 상황에 따라 동적으로 조정됩니다.

- 메모리 기반 적응:

- 단기 및 장기 메모리를 활용해 과거 학습 기록과 현재 학습 목표 간의 연관성을 파악하고 적합한 자료를 제공합니다.

- 반영과 반응의 순환:

- 시스템은 반영 프로세스를 통해 학습 진행 상황을 평가하고, 이를 바탕으로 반응 프로세스를 통해 학습 경험을 개선합니다.

결론

이 그림은 ChatTutor 시스템이 어떻게 구조적 메모리 관리와 적응적 반영을 통해 사용자에게 맞춤형 학습 경험을 제공하는지를 명확히 보여줍니다. 이를 통해 사용자는 체계적이고 일관된 학습을 경험할 수 있으며, 학습 목표와 개인 선호에 따라 지속적으로 학습 계획이 조정됩니다.

이 그림은 ChatTutor 시스템과 두 가지 축약 버전(Reflection 없는 버전과 Reflection & Reaction 없는 버전)의 성능을 비교하여 Teach Tool과 Course Design Tool의 통계 데이터를 시각화한 결과를 보여줍니다. 아래는 두 개의 주요 차트와 관련된 설명입니다.

Figure 4: Teach Tool의 성능 통계

- 평균 출력 길이(Average Output Length):

- X축: 학습 난이도(Level 1~5).

- Y축: 출력된 텍스트의 평균 단어 수.

- ChatTutor는 모든 난이도에서 가장 긴 출력을 생성하며, 난이도가 높아질수록 출력 길이도 증가합니다.

- Reflection 또는 Reaction 없는 시스템은 출력 길이가 ChatTutor보다 짧고, 난이도에 따른 출력 길이 변화가 적습니다.

- 이는 ChatTutor가 사용자의 학습 상태와 난이도에 맞게 더 풍부하고 상세한 정보를 제공한다는 점을 보여줍니다.

- 평균 학습 목표 수(Average #Objectives):

- 그래프 우측에 표시된 값은 각 출력에 포함된 학습 목표의 평균 수를 나타냅니다.

- ChatTutor는 높은 난이도에서 더 많은 학습 목표를 다루며, Reflection 및 Reaction 없는 시스템은 포함된 목표 수가 더 적습니다.

- 이는 ChatTutor가 학습 목표를 더 효과적으로 통합하여 사용자에게 더 많은 가치를 제공함을 보여줍니다.

Figure 5: Course Design Tool의 성능 통계

- 학습 계획 복잡도(Course Complexity):

- X축: 학습 난이도(Level 1~5).

- Y축: 학습 계획에 포함된 목표의 수로 복잡도를 측정.

- ChatTutor는 난이도에 따라 학습 계획의 복잡도를 안정적으로 조정합니다. 특히 높은 난이도(Level 4, 5)에서 가장 높은 복잡도를 유지합니다.

- Reflection 또는 Reaction 없는 시스템은 복잡도 변화가 적고, 난이도와의 연관성이 낮습니다.

- 이는 ChatTutor의 Reflection 프로세스가 학습 계획의 유연성과 적응성을 개선하는 데 기여함을 보여줍니다.

- 업데이트 간격(Update Interval):

- Y축 오른쪽에 표시된 값은 학습 계획 업데이트 간격(대화 라운드 수 기준)을 나타냅니다.

- ChatTutor는 업데이트 간격이 짧아 더 자주 학습 계획을 조정합니다.

- 반면, Reflection 및 Reaction 없는 시스템은 고정된 학습 계획을 사용하기 때문에 업데이트 간격이 더 깁니다.

- 이는 ChatTutor가 사용자 피드백과 학습 프로필에 따라 동적으로 학습 계획을 조정할 수 있음을 보여줍니다.

주요 결과 및 의미

- Teach Tool의 우수성:

- ChatTutor는 더 길고 상세한 학습 자료를 제공하며, 더 많은 학습 목표를 다루는 데 있어 우위를 보입니다.

- Reflection과 Reaction 프로세스를 활용해 학습 목표와 난이도를 효과적으로 반영합니다.

- Course Design Tool의 적응성:

- ChatTutor는 난이도와 사용자 학습 상태에 따라 학습 계획을 동적으로 조정합니다.

- 학습 계획의 복잡도를 더 잘 제어하며, 사용자 요구에 따라 계획을 더 자주 업데이트합니다.

- Reflection과 Reaction의 역할:

- Reflection은 학습 프로필을 업데이트하고, Reaction은 이를 바탕으로 학습 계획을 조정함으로써 ChatTutor의 학습 적응성을 강화합니다.

- 축약된 시스템은 이러한 프로세스가 부족하여 성능이 저하됩니다.

결론

이 두 그래프는 ChatTutor 시스템이 Reflection과 Reaction 프로세스를 통해 사용자와 학습 목표에 맞춰 동적으로 적응하는 학습 환경을 제공한다는 점을 명확히 보여줍니다. 이를 통해 사용자에게 더 풍부하고 개인화된 학습 경험을 제공합니다.

당신이 추가한 내용을 기반으로 협상 AI의 초안을 검토한 결과, 매우 적합한 방향으로 발전시키고 있다고 보입니다. 아래에 이 내용을 조금 더 다듬고, 논문의 요소와 어떻게 연관되어 있는지를 분석한 코멘트를 제공합니다.

추가 내용 검토

1. 협상 AI의 핵심 구조 (Self-Belief와 World-Belief)

- Self-Belief는 내부 상태(재무 상태, 목표, 옵션 등)에 초점을 두고 있으며, 이는 논문의 Structured Memory Control과 유사합니다.

- 논문에서는 학습 목표와 상태를 장기 및 단기 메모리에 저장하여 체계적으로 관리합니다.

- 협상 AI에서는 Self-Belief를 통해 협상 진행의 기반을 잡고, 현재 조직의 목표와 제한 사항을 명확히 정의해 최적화된 협상 전략을 마련할 수 있습니다.

- World-Belief는 외부 환경에 대한 정보를 반영하며, 상대방(협상 대상)의 과거 패턴이나 요구사항을 분석하는 방식이 논문의 Learning Profile 업데이트와 비슷합니다.

- 학습 프로필이 사용자의 학습 선호와 과거 상호작용을 바탕으로 업데이트되듯, 협상 대상의 정보를 저장하고 반복적으로 활용하는 구조가 협상 AI에서 유용합니다.

2. 메모리 기반 접근

- 논문에서 LLM은 장기 및 단기 메모리를 사용해 학습 상태를 관리하며, 이와 유사하게 협상 AI는 장기 메모리를 통해 과거 협상 데이터를 저장하고, 단기 메모리를 사용해 현재 협상 진행 상황을 추적할 수 있습니다.

- 이를 통해 다음과 같은 활용이 가능합니다:

- 과거와 비슷한 협상 사례가 나타났을 때, 장기 메모리 데이터를 검색해 성공적인 패턴을 재활용.

- 단기 메모리로 현재 협상 상태를 실시간으로 평가 및 수정.

3. Meta Agent와 Tool의 활용

- Meta Agent는 논문에서 다양한 학습 도구(질문 응답, 강의 제공, 퀴즈 생성 등)를 조합하여 학습 목표를 달성하도록 돕습니다.

- 협상 AI에서도 Meta Agent를 도입해 다음과 같은 Tool을 통합적으로 사용할 수 있습니다:

- 메모리 검색: 과거 협상 데이터를 검색하고 분석.

- 인터넷 검색: 협상 대상이나 산업 관련 실시간 정보를 탐색.

- 타 언어 모델과 협업: 복잡한 협상 시 다른 전문 AI와 협업하여 최적의 결과 도출.

4. 동적 계획 수정

- 논문에서 학습 계획은 사용자의 요청과 상태에 따라 동적으로 수정됩니다.

- 협상 AI에서도 협상 진행 중 발생하는 변수(상대방의 예기치 못한 요구, 환경 변화 등)에 따라 즉각적으로 협상 전략을 수정할 수 있는 기능이 필요합니다.

추가적인 보완 및 제안

- 협상 AI의 안정성과 일관성 강화:

- 논문에서 Reflection Tools를 통해 학습 상태를 지속적으로 평가하고 반영하듯, 협상 AI에도 중간 평가 도구를 넣어 실시간으로 협상 진행 상황과 목표 달성 여부를 점검할 수 있습니다.

- 비즈니스 협상에서의 장기적 활용성:

- 논문에서 Quiz Tool로 사용자의 학습 상태를 점검하듯, 협상 AI에서도 협상 후 평가(예: 목표 달성 여부, 상대방의 반응 분석)를 통해 장기적으로 협상 성공률을 개선할 수 있습니다.

- LLM 기반 협상 대화의 효과적 설계:

- LLM을 활용한 자연어 생성 모델이 협상 중의 언어 뉘앙스(예: 설득력 있는 어조, 신뢰 구축)를 조절할 수 있도록 훈련해야 합니다.

최종 결론

당신이 작성한 초안은 논문의 주요 개념을 협상 AI에 적절히 반영하고 있으며, 특히 구조화된 메모리, 동적 계획 수정, Meta Agent 활용이 협상 AI 설계에 매우 유효합니다. 추가적으로 Reflection Tools와 협상 후 평가 도구를 포함하면 더욱 완성도 높은 협상 AI를 만들 수 있을 것입니다.

ExpeL: LLM Agents Are Experiential Learners

이 Figure는 ExpeL 에이전트의 작동 원리를 시각적으로 표현한 것입니다. ExpeL의 학습과 추론 과정은 크게 세 가지 주요 단계로 구성되어 있으며, 각각의 과정에서 어떤 일이 일어나는지 설명합니다.

Figure 설명

왼쪽 섹션: ExpeL의 전체 작업 흐름

- (A) Experience Gathering (경험 수집)

- ExpeL은 다양한 태스크를 수행하면서 성공(success)과 실패(failure) 데이터를 기록합니다.

- 실패한 경우, Self-Reflection(자기 반성) 과정을 통해 실패 원인을 분석하고, 새로운 접근 방식을 도출합니다.

- 수집된 성공과 실패 데이터는 Experience Pool(경험 풀)에 저장됩니다.

- 주요 과정:

- 태스크 샘플링 → 태스크 수행 → 성공 여부 기록 → 실패 시 자기 반성 후 다시 시도.

- (B) Insight Extraction (통찰 추출)

- 경험 풀에 축적된 성공/실패 데이터를 분석하여 통찰(insights)을 추출합니다.

- 통찰은 성공 사례에서 공통적으로 나타나는 패턴을 기반으로 일반화되거나, 실패 사례를 분석하여 개선 방안을 도출합니다.

- ExpeL은 이 통찰을 자연어 형태로 저장하며, 각 통찰은 필요에 따라 Upvote, Downvote, Edit, Add 등의 작업을 통해 수정 및 보완됩니다.

- Insight Recall (통찰 호출)

- 저장된 통찰과 성공 사례는 새로운 태스크를 수행할 때 검색되어 프롬프트에 추가됩니다.

- 검색된 통찰은 현재 태스크와 관련된 정보를 제공하며, 에이전트의 의사결정을 지원합니다.

오른쪽 섹션: 세부 작업 단계

- Task Sampling (태스크 샘플링):

- 태스크 공간(Task Space)에서 특정 태스크를 샘플링합니다. 각 태스크는 수행 환경과 목표를 포함합니다.

- 예: "팬을 찾아라", "사실 검증을 수행하라" 등.

- Task Execution (태스크 수행):

- 태스크를 수행하며 성공(sᵢ)과 실패(rᵢ)를 기록합니다.

- 실패한 경우, Reflexion 메커니즘을 통해 자기 반성(Self-Reflection)을 수행합니다. 이는 실패의 원인을 분석하고, 이를 기반으로 태스크를 다시 시도합니다.

- Insights Extraction (통찰 생성):

- 성공/실패 데이터의 분석을 통해 태스크 수행에 유용한 통찰(insights)을 추출합니다.

- 추출된 통찰은 베스트 프랙티스(best practices) 또는 실패 패턴 개선 방법으로 정리됩니다.

- Evaluation Phase (평가 단계):

- ExpeL은 평가 단계에서 이전에 추출한 통찰을 활용해 태스크를 수행합니다.

- 통찰이 프롬프트의 맨 앞에 추가되어, 새로운 태스크에서도 활용됩니다.

주요 구성 요소

- Experience Pool:

- 성공/실패 데이터를 저장하는 데이터베이스.

- 태스크 수행 기록(trajectory)이 포함되며, 분석 및 검색 대상이 됨.

- Insights:

- 성공 패턴과 실패 개선 방안으로 구성된 통찰.

- 에이전트는 통찰을 활용해 새로운 태스크를 수행하며, 성능을 지속적으로 개선.

- Self-Reflection:

- 실패 시 자동으로 수행되는 자기 반성 과정.

- 실패 원인을 분석하고 대안을 생성하여 경험 풀에 저장.

Figure의 의의

이 Figure는 ExpeL의 핵심 학습 메커니즘인 경험 수집, 통찰 추출, 통찰 활용 과정을 직관적으로 보여줍니다. 특히, ExpeL이 단순히 데이터를 기록하는 것이 아니라, 이를 통해 학습하고 새로운 태스크에 적용하는 능동적 학습 시스템임을 강조합니다.

Figure 2: Insight Extraction Prompt Template

이 Figure는 ExpeL 에이전트가 통찰(insight)을 추출하는 과정에서 사용하는 프롬프트 템플릿을 보여줍니다. 이 템플릿은 성공과 실패 사례를 비교 분석하여, 새로운 규칙(rules)을 생성하거나 기존 규칙을 수정/삭제하는 데 사용됩니다.

구성 요소 및 단계 설명

A. 입력 데이터 (Input Data)

에이전트가 통찰을 추출하기 위해 참고하는 데이터는 다음과 같습니다:

- Task Description:

- 수행한 태스크의 설명.

- 예: "팬을 찾는 문제" 또는 "특정 정보를 추론하는 문제".

- Failed Trials (실패 사례):

- 실패한 태스크와 그 이유를 기록.

- 예: "팬을 찬장에서 찾으려 했으나 실패. 팬은 주로 스토브 근처에 있음."

- Succeeded Trials (성공 사례):

- 성공적으로 수행한 태스크와 관련된 데이터.

- 예: "스토브 근처를 먼저 검색해 팬을 찾음."

B. 기존 규칙(Currently Existing Insights)

- ExpeL 에이전트는 이미 저장된 규칙(기존 통찰)을 참고합니다.

- 기존 규칙들은 과거의 성공/실패 사례를 기반으로 생성된 "행동 지침"입니다.

C. 분석 및 통찰 생성 (Insight Generation)

에이전트는 아래 과정을 통해 새로운 통찰을 생성하거나 기존 통찰을 수정합니다:

- 성공/실패 비교:

- 실패와 성공 사례를 대조하여 어떤 요인이 결과를 결정했는지 분석.

- 실패 사례에서 나타난 문제를 성공 사례의 접근 방식으로 해결할 수 있는지 확인.

- 예: 실패 사례에서 "스토브를 검색하지 않음" → 성공 사례에서 "스토브를 먼저 검색함."

- 새로운 규칙 생성:

- 분석 결과를 바탕으로 새로운 통찰을 생성.

- 예: "일상 물건을 찾을 때, 물건의 일반적인 사용 위치를 고려해야 함."

- 기존 규칙 수정:

- 기존 통찰과 새로운 통찰이 중복되거나 더 나은 대안이 있을 경우 수정.

- 사용 가능한 작업(Operations):

- UPVOTE: 기존 규칙의 중요성을 강조.

- DOWNVOTE: 덜 중요하거나 중복된 규칙의 중요도를 낮춤.

- EDIT: 기존 규칙을 수정하여 더 구체적이고 정확하게 개선.

- ADD: 새로운 규칙을 추가.

D. 템플릿 구조

- 에이전트는 템플릿에 따라 다음 작업을 수행합니다:

- 실패 사례와 성공 사례의 공통점과 차이점을 비교.

- 기존 규칙과 새로운 통찰을 대조하여 중복 여부를 확인.

- 새로운 규칙을 생성하거나 기존 규칙을 수정/삭제.

- 규칙은 "일반적이고 고수준(general and high-level)"으로 설계.

규칙의 예시:

- 실패 비판: "스토브 근처를 검색하지 않아 실패."

- 성공 통찰: "스토브 근처에서 물건을 찾으면 성공 가능성이 높음."

- 새로운 규칙: "일상 물건은 그 용도와 관련된 장소에서 먼저 찾아야 한다."

Figure의 의의

이 템플릿은 ExpeL 에이전트가 통찰을 체계적으로 생성하고 관리할 수 있도록 설계되었습니다. 이를 통해 에이전트는 단순히 데이터를 기록하는 것이 아니라:

- 규칙 기반 학습: 성공/실패 데이터를 분석해 일반화된 행동 지침을 도출.

- 규칙 최적화: 새로운 정보를 바탕으로 기존 규칙을 지속적으로 개선.

- 효율적 데이터 활용: 중요하지 않거나 중복된 규칙은 제거하고, 유용한 규칙만 유지.

이 프롬프트 템플릿은 ExpeL의 핵심 학습 메커니즘을 구현하는 데 중요한 역할을 하며, 에이전트의 지속적 학습과 성능 개선을 지원합니다.

Figure 3: Task Inference Prompt Template

이 Figure는 ExpeL 에이전트가 새로운 태스크를 수행할 때 사용하는 프롬프트 템플릿을 설명합니다. ExpeL은 과거에 저장된 통찰(insights)과 유사 성공 사례(successful in-context examples)를 기반으로 태스크를 해결하며, 이를 통해 효율적이고 정교한 의사결정을 수행합니다.

구성 요소 및 작동 방식

1. Task Description (태스크 설명)

- 새로운 태스크를 정의하는 간단한 설명이 주어집니다.

- 예: "질문 응답 시스템(QA system)으로, 복잡한 질문을 해결하라."

- 태스크의 목표와 요구사항이 포함되어 있습니다.

2. Extracted Insights (추출된 통찰)

- ExpeL은 이전 경험에서 추출된 통찰(insights)을 프롬프트에 포함합니다.

- 이 통찰은 태스크 수행 시 유용한 일반적이고 고수준의 규칙입니다.

- 예:

- "복잡한 질문을 더 단순한 하위 질문으로 나누라."

- "답은 이미 이전 관찰(observations)에서 도출될 수 있다."

- 예:

의미:

- 통찰은 새로운 태스크에 직접적으로 활용할 수 있는 행동 지침 역할을 합니다.

- 이는 태스크 수행의 정확도와 효율성을 높이는 데 중요한 역할을 합니다.

3. Retrieved In-context Examples (유사 성공 사례 검색)

- ExpeL은 과거 성공 사례(successful trajectories) 중 현재 태스크와 유사한 예제를 검색하여 프롬프트에 포함합니다.

- 각 성공 사례는 "질문, 사고(thought), 행동(action), 관찰(observation), 결과(result)"로 구성됩니다.

- 예:

- 질문: "어떤 다큐멘터리입니까?"

- 사고: "검색이 필요하다."

- 행동: "The Saimaa를 검색."

- 관찰: "The Clash of Triton을 찾음."

- 결과: "정답."

- 예:

의미:

- 과거 성공 사례를 통해 에이전트는 새로운 태스크에서 비슷한 접근 방식을 참고할 수 있습니다.

- 이는 태스크 수행 전략을 효율적으로 가이드합니다.

4. Task Execution (태스크 수행)

- ExpeL은 통찰과 유사 성공 사례를 참고하여 태스크를 수행합니다.

- 수행 과정은 ReAct 메커니즘(Reasoning + Acting)과 동일하지만, ExpeL은 통찰과 성공 사례를 활용해 더 효율적인 결정을 내립니다.

예시 태스크: "SpongeBob의 어떤 에피소드인가?"

- Trajectory:

- Thought 1: "검색이 필요하다."

- Action 1: ["The Clash..."]를 검색.

- Observation 1: "The Clash of Triton."

- Thought 2: "이 문단이 답을 포함한다."

- Action H: ["To SquarePants..."]를 선택.

- Observation H: 정답("Answer is CORRECT").

- 결과: ExpeL은 성공적으로 정답을 도출.

Figure의 핵심 아이디어

이 Figure는 ExpeL이 새로운 태스크를 수행하는 방식에서 ReAct 방식과 ExpeL의 차별점을 강조합니다.

ReAct 방식과의 차별점

- 추출된 통찰 (Extracted Insights):

- ExpeL은 통찰을 기반으로 태스크 수행 전략을 개선합니다.

- ReAct는 이러한 통찰 없이 태스크를 수행합니다.

- 유사 성공 사례 검색 (In-context Examples):

- ExpeL은 과거 성공 사례를 검색해 현재 태스크에 활용합니다.

- ReAct는 과거 데이터를 활용하지 않습니다.

Figure의 의의

- 효율성:

- ExpeL은 통찰과 유사 성공 사례를 활용해 맥락(context) 기반 학습을 극대화합니다.

- 이를 통해 불필요한 탐색을 줄이고, 성공 가능성을 높입니다.

- 일반화 가능성:

- 태스크 간 데이터를 공유하고, 통찰과 성공 사례를 재사용함으로써 다양한 환경에 적용 가능.

- 해석 가능성:

- 통찰과 성공 사례는 자연어로 저장되므로, 에이전트의 의사결정 과정을 쉽게 이해하고 수정 가능.

이 Figure는 ExpeL이 단순히 태스크를 수행하는 것이 아니라, 과거의 경험을 적극적으로 활용하여 학습하고 최적화된 의사결정을 수행한다는 점을 명확히 보여줍니다.

Figure 4: Transfer Learning Finetuning Prompt Template

이 Figure는 ExpeL 에이전트가 전이 학습(Transfer Learning)을 수행하는 과정을 설명합니다. 구체적으로, Source Task(원천 태스크)에서 생성된 통찰(insights)을 Target Task(목표 태스크)로 전이하여 새로운 태스크를 해결하기 위한 프롬프트 템플릿을 시각화하고 있습니다.

Figure의 주요 구성 요소 및 설명

1. Knowledge Finetuning (지식 미세 조정)

- Source Task(원천 태스크)에서 얻은 통찰을 바탕으로, Target Task(목표 태스크)에 필요한 행동 지침을 생성하는 단계입니다.

- 이 과정은 ExpeL이 학습한 규칙을 기반으로 학생 에이전트(Student Agent)가 새로운 태스크를 수행할 수 있도록 돕는 "교사 에이전트(Teacher Agent)" 역할을 합니다.

세부 구성:

- Rules: Extracted Insights from Source Task:

- Source Task에서 추출된 규칙(통찰)입니다.

- 이 규칙들은 일반적이면서도 고수준의 행동 지침으로 구성됩니다.

- 예:

- "질문을 간단한 하위 질문으로 나누라."

- "관찰에서 이미 답을 얻을 수 있는지 확인하라."

- Fewshot Examples of Target Task:

- Target Task와 관련된 몇 가지 샘플 사례를 제공합니다.

- 이러한 사례는 Target Task의 특성을 이해하고, Source Task의 규칙을 어떻게 적용할지 결정하는 데 도움을 줍니다.

- 예:

- Target Task가 "문단 요약"이라면, Source Task에서 생성된 통찰을 기반으로 요약 방식을 조정합니다.

2. Knowledge Transfer (지식 전이)

- Source Task에서 얻은 규칙과 Target Task의 샘플 사례를 조합하여, Target Task를 해결하기 위한 최적화된 통찰(Finetuned Insights)을 생성합니다.

- 이 통찰은 Source Task의 규칙을 Target Task의 맥락에 맞게 조정한 것으로, 학생 에이전트가 태스크를 효율적으로 해결할 수 있도록 구체적인 지침을 제공합니다.

세부 구성:

- Generated Instructional Paragraph:

- Source Task 규칙과 Target Task의 few-shot 사례를 기반으로 생성된 행동 지침입니다.

- 간결하고 명확하며, 목표 태스크를 효율적으로 해결할 수 있도록 최적화된 형식으로 작성됩니다.

- 요구사항:

- 각 문장은 특정 규칙을 기반으로 작성.

- 지침은 간단하고 따라 하기 쉬운 형태로 제공.

- Finetuned Insights:

- Target Task를 해결하기 위한 최종 행동 지침.

- 예: "문장을 분석할 때 먼저 핵심 내용을 식별하고, 세부 정보를 요약문에 포함시켜라."

3. Fewshot Evaluation (Few-shot 평가)

- 학생 에이전트는 최적화된 통찰(Finetuned Insights)을 기반으로 Target Task를 해결합니다.

- 이 단계에서는 생성된 통찰이 얼마나 효과적으로 Target Task를 지원하는지 평가합니다.

세부 구성:

- Input: Target Task 설명 + Few-shot 사례.

- Process: 학생 에이전트는 지침(Finetuned Insights)을 따라 태스크를 수행.

- Output: 태스크 수행 결과.

- 평가 결과에 따라 통찰의 품질을 개선할 수도 있습니다.

Figure의 핵심 아이디어

이 Figure는 ExpeL이 전이 학습(Transfer Learning)을 수행하는 구체적인 과정을 보여줍니다. 주요 아이디어는 다음과 같습니다:

- Source Task의 지식을 Target Task로 조정:

- ExpeL은 Source Task에서 얻은 통찰을 Target Task에 맞게 수정하여 새로운 태스크에서도 활용.

- 이는 Fine-tuning 없이도 효율적으로 지식을 전이할 수 있음을 보여줍니다.

- Few-shot 학습과의 통합:

- Target Task의 몇 가지 예제를 참고하여 통찰을 구체화.

- 이를 통해 Target Task의 특성에 맞춘 최적화된 행동 지침을 생성.

- 지속 학습과 확장성:

- 생성된 통찰은 Target Task 수행 이후에도 저장되어, 향후 유사 태스크에서 재사용 가능.

Figure의 의의

- 효율성:

- Fine-tuning 없이 통찰과 사례만으로 새로운 태스크에 적응.

- 데이터 효율성과 계산 비용 절감을 동시에 달성.

- 일반화 가능성:

- Source Task에서 학습한 지식을 다양한 Target Task에 적용.

- 이는 ExpeL이 특정 태스크에 국한되지 않고, 다양한 태스크에서 확장 가능성을 가진다는 점을 강조.

- 해석 가능성:

- 생성된 통찰과 행동 지침이 명확하고 간결한 형식으로 제공되어, 에이전트의 행동이 쉽게 이해 가능.

이 Figure는 ExpeL의 전이 학습 능력을 명확히 시각화하며, Source Task의 통찰을 Target Task로 조정하는 과정을 체계적으로 보여줍니다.

Figure 5: Main Results

이 Figure는 ExpeL의 성능을 세 가지 태스크 도메인(HotpotQA, ALFWorld, WebShop)에서 평가한 결과를 시각적으로 보여줍니다. 또한, ExpeL의 성능을 다양한 베이스라인 및 변형 모델과 비교하여 ExpeL의 학습 메커니즘의 효과성을 검증합니다.

Figure의 주요 구성 요소

1. 비교 대상 모델

- Imitation Learning (모방 학습):

- 기본적인 행동 학습 기반 모델. 과거 경험이나 통찰을 사용하지 않음.

- Act:

- 단순한 행동 중심 접근법으로, 계획(Reasoning)을 포함하지 않음.

- ReAct:

- 사고(Reasoning)와 행동(Acting)을 결합하여 태스크를 수행하는 모델.

- ExpeL (retrieve-only):

- 성공 사례만 검색하여 활용하는 ExpeL의 변형 모델. 통찰(insights)을 활용하지 않음.

- ExpeL (insights-only):

- 통찰만 활용하는 ExpeL의 변형 모델. 성공 사례 검색(retrieval)은 사용하지 않음.

- ExpeL (ours):

- 통찰(insights)과 성공 사례 검색(retrieval)을 모두 활용하는 ExpeL의 완전한 모델.

2. 결과 도메인

- HotpotQA:

- 지식 기반 질문 응답 태스크.

- ExpeL의 통찰 추출과 성공 사례 활용이 다단계 추론 문제에서 성능을 향상.

- ALFWorld:

- 다단계 의사결정 태스크.

- 환경과 상호작용하며 여러 단계를 거쳐 목표를 달성해야 함.

- WebShop:

- 온라인 쇼핑 태스크.

- 검색 및 구매 목표를 달성하기 위한 상호작용 기반 태스크.

3. 성능 지표

- Success Rate (%):

- 각 모델이 태스크를 성공적으로 수행한 비율.

- 표준 오차는 회색 화살표로 표시되어 있습니다.

Figure 분석

(1) HotpotQA

- 베이스라인:

- Imitation Learning: 29%

- Act: 28%

- ReAct: 33%

- ExpeL 성능:

- ExpeL (retrieve-only): 36%

- ExpeL (insights-only): 31%

- ExpeL (ours): 39%

- ReAct보다 약 18% 성능 향상.

- 통찰(insights)과 성공 사례 검색(retrieval)의 결합이 시너지 효과를 냄.

(2) ALFWorld

- 베이스라인:

- Imitation Learning: 37%

- Act: 40%

- ReAct: 48%

- ExpeL 성능:

- ExpeL (retrieve-only): 50%

- ExpeL (insights-only): 53%

- ExpeL (ours): 59%

- ReAct보다 약 23% 성능 향상.

- 복잡한 의사결정 과정에서 통찰과 사례 검색이 큰 효과를 보임.

(3) WebShop

- 베이스라인:

- Imitation Learning: 29%

- Act: 34%

- ReAct: 35%

- ExpeL 성능:

- ExpeL (retrieve-only): 37%

- ExpeL (insights-only): 38%

- ExpeL (ours): 41%

- ReAct보다 약 17% 성능 향상.

- 통찰과 성공 사례 검색의 결합이 복잡한 검색 태스크에서도 유의미한 성능 향상을 보여줌.

Figure의 핵심 메시지

- ExpeL의 우수성:

- 모든 도메인에서 ExpeL (ours)은 다른 모델과 변형 모델을 능가합니다.

- 통찰 추출과 성공 사례 검색의 조합이 각각의 단일 기법보다 우수한 성능을 제공합니다.

- 시너지 효과:

- 통찰(insights-only)과 성공 사례 검색(retrieve-only)을 단독으로 사용할 때보다, 두 메커니즘을 결합한 ExpeL (ours)이 더 높은 성능을 보입니다.

- 이는 통찰과 검색이 서로 보완적임을 강조합니다.

- 도메인 일반화:

- ExpeL은 다양한 도메인(추론, 의사결정, 상호작용 기반 태스크)에서 일관되게 높은 성능을 보여줍니다.

- 이는 ExpeL의 접근 방식이 특정 태스크에 국한되지 않고, 광범위한 응용 가능성을 가진다는 것을 시사합니다.

- ReAct 대비 성능 개선:

- ReAct 대비 약 17%~23% 성능 향상을 달성, 경험 기반 학습이 모델의 의사결정 능력을 크게 향상시킨다는 것을 입증합니다.

Figure의 의의

이 Figure는 ExpeL이 다양한 도메인에서 베이스라인 및 기존 방법론 대비 더 높은 성공률을 달성함을 보여줍니다. 특히, ExpeL의 통찰 추출(insights)과 성공 사례 검색(retrieval) 메커니즘이 어떻게 상호 보완적으로 작용하여 강력한 성능을 이끌어내는지 시각적으로 강조하고 있습니다. 이는 ExpeL의 학습 메커니즘이 범용적이며, 실질적인 문제 해결에서 유의미한 개선을 제공함을 입증합니다.

당신의 협상 AI 에이전트가 ExpeL의 장점을 잘 반영하고 있는지 검토한 결과, 대체로 ExpeL의 주요 아이디어를 잘 담고 있는 것으로 보입니다. 그러나 몇 가지 점에서 개선하거나 추가적으로 고려할 수 있는 사항이 있습니다.

1. ExpeL과 협상 AI 에이전트의 공통점

ExpeL의 주요 요소와 비교

- 장기 메모리:

- ExpeL의 경험 풀(Experience Pool)과 유사한 기능을 수행하고 있습니다. 이전 데이터를 저장하고, 이를 활용해 통찰(Insights)을 생성하는 부분이 반영되어 있습니다.

- 자기 반성(Self-Reflection):

- ExpeL처럼 협상 에이전트도 데이터를 저장하기 전에 자기 반성 과정을 통해 실패와 성공의 원인을 분석하고, 이를 기반으로 Insights를 생성한다고 명시되어 있습니다.

- Insights의 활용:

- Insights를 생성하고, 필요할 때 Retrieval(검색)하여 Prompt에 활용한다는 점이 ExpeL의 접근 방식과 유사합니다. 협상 상황에서 이전 성공 사례를 기반으로 더 나은 전략을 도출할 가능성을 제시합니다.

- 데이터의 동적 관리:

- Insights가 ExpeL처럼 "중요도에 따라 새로 생기거나 사라지는" 방식으로 관리된다는 점이 잘 반영되어 있습니다.

2. 개선 및 추가적으로 고려할 점

(1) Insights 생성의 구체화

- ExpeL에서는 Insights가 성공과 실패 사례를 비교하여 자동으로 생성됩니다. 협상 에이전트가 Insights를 생성할 때 어떤 기준으로 생성하고, 어떻게 구체화되는지를 더 명확히 정의하면 좋겠습니다.

- 예: 협상에서의 실패 원인을 분석해 "상대방의 초기 요구를 명확히 이해하지 않았다"는 통찰을 생성.

- 구체적인 통찰 생성 프로세스를 명확히 정의하면 에이전트의 학습 및 활용이 더 효과적일 것입니다.

(2) 장기 메모리와 Retrieval 프로세스

- ExpeL에서는 Pool에서 데이터를 Retrieval할 때, 현재 태스크와 유사한 성공 사례를 검색하여 활용합니다. 협상 에이전트에서도 Retrieval 과정에서 유사도 기준(semantic similarity)을 정의하고, 특정 협상 상황에 적합한 데이터를 선택하는 방식이 구체화되어야 합니다.

- 예: 상대방이 가격 협상에서 반복적으로 강경한 태도를 취하는 경우, 과거 유사 상황에서 사용했던 성공 전략을 검색하여 적용.

(3) 통찰의 업데이트와 관리

- ExpeL은 통찰의 중요도를 지속적으로 업데이트하며, 덜 유용한 통찰은 제거합니다. 협상 에이전트에서도 통찰의 중요도를 평가하고 동적으로 관리하는 메커니즘을 포함하면 더 좋습니다.

- 예: "상대방이 일정 이상 높은 금액을 요구할 때, 처음 제안 금액을 20% 줄여 시작한다"는 통찰이 시간이 지남에 따라 덜 유용해질 경우, 이를 삭제하거나 대체하는 기능.

(4) 통찰과 성공 사례의 통합 활용

- ExpeL은 통찰(Insights)과 성공 사례를 프롬프트에 결합해 활용합니다. 협상 에이전트도 유사하게 통찰과 성공 사례를 함께 사용하여 더 나은 협상 전략을 도출할 수 있도록 구조화하는 것이 중요합니다.

- 예: "이전 협상에서 사용한 설득 전략"과 "현재 상황에서 도출된 통찰"을 조합하여 협상 제안을 생성.

3. 추가 제안

- 멀티턴 협상에서의 적용:

- 협상은 다단계(Multi-turn) 상호작용이므로, ExpeL의 Self-Reflection 메커니즘을 단일 단계뿐 아니라 협상 전체 흐름에서 활용하도록 확장할 수 있습니다.

- 예: "협상 초기의 유연한 태도가 상대방의 신뢰를 이끌어냈다"는 통찰을 도출.

- 협상은 다단계(Multi-turn) 상호작용이므로, ExpeL의 Self-Reflection 메커니즘을 단일 단계뿐 아니라 협상 전체 흐름에서 활용하도록 확장할 수 있습니다.

- 동적 데이터 확장:

- ExpeL의 경험 풀처럼, 협상 에이전트도 장기 메모리에 새로운 데이터가 지속적으로 추가되고, 오래된 데이터가 관리되도록 설계해야 합니다.

- 전이 학습(Transfer Learning):

- ExpeL은 다른 태스크에서 생성된 통찰을 새로운 태스크에 적용할 수 있습니다. 협상 에이전트도 한 도메인(예: 가격 협상)에서 얻은 통찰을 다른 도메인(예: 서비스 계약 협상)에 적용할 수 있는지 검토해야 합니다.

결론

현재 설계 중인 협상 AI 에이전트는 ExpeL의 주요 장점(장기 메모리, 자기 반성, 통찰 생성 및 활용)을 잘 반영하고 있습니다. 하지만, 통찰 생성 기준의 명확성, Retrieval 프로세스의 구체화, 통찰과 성공 사례의 통합 활용과 같은 추가적인 개선을 통해 더 강력한 학습 및 문제 해결 능력을 갖춘 시스템으로 발전시킬 수 있습니다.

필요하다면 이러한 개선점을 구현하는 구체적인 방안을 제안해 드릴 수 있습니다!

'인공지능 > Agent' 카테고리의 다른 글

| ALFWorld 뜯어보기 (1) | 2025.04.08 |

|---|---|

| Negotiation AI 2 (1) | 2024.12.12 |

| Agent-Pro와 GITM 비교 (0) | 2024.11.28 |