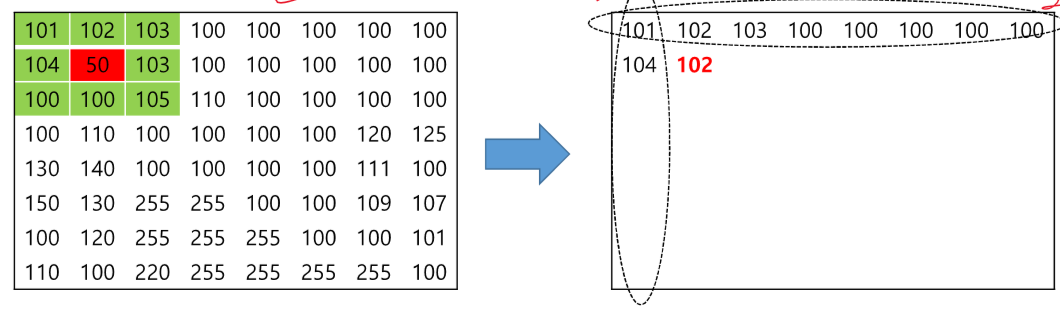

목표 - 언어 모델을 파인튜닝할 때 발생하는 문제들을 분석하고 평가하는 방법들에 대해 이해하기 위험하고 평향된 말이 들어왔을 때 모델이 답변을 잘 선택하도록 만들어야 한다. 언더 피팅과 오버비팅 (memorized) 일반화 - 우리가 추구하는 목표, 모르는 데이터에 대해 적절한 답변을 준다. 감정 분류 - 긍, 부정, 행복, 슬픔과 같은 감정 분류 자연어 추론 - 전제문장과 가설문장이 주어졌을 때 가설문장의 참, 거짓 등을 밝힌다. 의도 분류 - 정확한 의도 파악 다양한 분류 작업에서 사용된다. label이 늘어나도 행렬이 늘어나는 것이기 때문에 사용 가능하다. 항상 예시로는 암의 관측을 정확도의 오류의 위험성을 말합니다. 실제 정답이 negative인데 ture라고 한 경우 중요한 지표이다. 리콜이 낮..