728x90

728x90

목표 - 대량의 데이터로 언어 모델이 일반화된 지식을 갖도록 학습하는 사전 학습의 목적과 작동 원링 대해 이해하기

언어의 모호성과 중요성을 파라미터에 잘 적용시키는 것

미세조정 == fine tuning

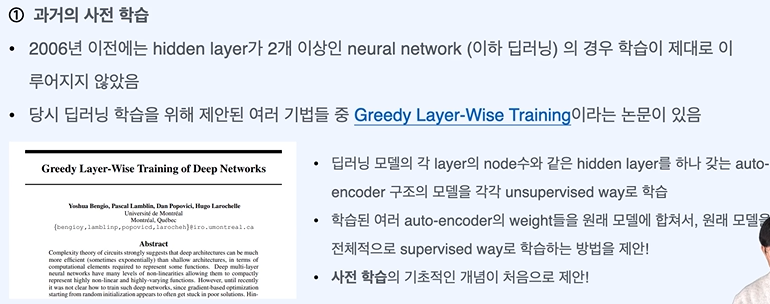

각각 학습한 뒤 합쳐서 새로 사용한다.

Fast txt나 Glove로 보완은 되었으나 모두 해결된 것은 아니다.

중요한 정보가 앞에 있을 경우 거의 전달되지 않는 문제

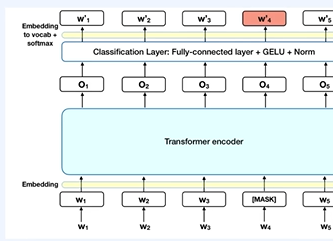

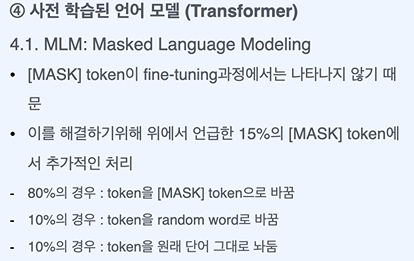

15% 정도 Mask를 사용하면 성능이 좋았다.

이렇게 하여 MASK 토큰을 원래 단어로 예측하도록 만든다.

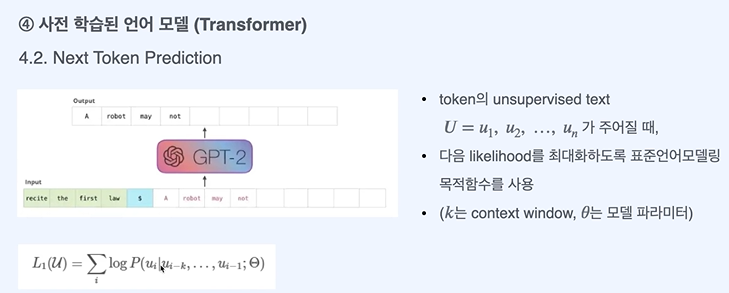

여기선 n개를 보고 그 뒤를 예측하고, 또 n개를 보고 그 뒤를 예측하는 것의 반복이다.

모델의 강건성과 불확실성을 개선할 수 있다.

728x90

'인공지능 > 자연어 처리' 카테고리의 다른 글

| 자연어 처리 모델 학습 - 파인 튜닝(Fine tuning)이란? (1) | 2024.03.29 |

|---|---|

| 자연어 처리 모델 학습 - 전이 학습(Transfer Learning)이란 (0) | 2024.03.29 |

| 자연어 처리 python 실습 - 간단한 답변 랭킹 모델 만들기 (1) | 2024.03.28 |

| 자연어 처리 문장 embedding 만들기 - BERT (0) | 2024.03.28 |

| 자연어 처리 문장 embedding 만들기 - GPT (0) | 2024.03.27 |