https://arxiv.org/abs/2210.03629

ReAct: Synergizing Reasoning and Acting in Language Models

While large language models (LLMs) have demonstrated impressive capabilities across tasks in language understanding and interactive decision making, their abilities for reasoning (e.g. chain-of-thought prompting) and acting (e.g. action plan generation) ha

arxiv.org

Agent 관련 논문에서 빠질 수 없는 것이 ReAct기에...

한 번 읽어 봤습니다.

기존 LLM이 한번에 모든 일을 다 진행하려고 하면서 생기는 문제들을 해결하려고 합니다.

AI Agent의 시작일 것 같기도 하고요

Reasoning 단계를 통해 Planning을 진행하고, Acting을 통해 Planning을 잘 따라가며 Reasoning단계에서 지속적으로 Planning을 수정하면서 목표를 도달해 갑니다.

사실 여기에 메모리만 추가되었어도 그 후에 나오는 모든 논문들이 작성할 게 없어질정도로 좋은 논문이라고 생각해유

| 연구 목표 | 언어 모델(LLM)이 추론(Reasoning)과 행동(Acting)을 결합하여 더 신뢰할 수 있는 문제 해결 및 의사결정을 수행하도록 하는 프레임워크 제안. |

| 주요 문제 | 기존 LLM의 한계: |

| - 추론(Reasoning): 내부 지식에 의존하여 오류(환각) 발생 가능. | |

| - 행동(Acting): 외부 환경과 상호작용은 가능하지만, 논리적 사고 과정 없이 단순 정보 탐색만 수행. | |

| - 추론과 행동이 독립적으로 동작하여 복잡한 작업 수행에 비효율적. | |

| ReAct의 정의 | - 추론과 행동을 결합하여 모델이 현재 상황(State)을 이해하고 필요한 행동을 계획(Planning)하여 환경과 상호작용(Action)하며 문제를 해결. |

| ReAct의 동작 과정 | 1. 추론(Planning): 현재 상태를 분석하고, 무엇을 해야 할지 논리적 계획 수립. 2. 행동(Action): 계획에 따라 정보를 검색(Search), 조회(Lookup) 등 구체적인 행동 수행. 3. 상태 업데이트(State Update): 행동 결과를 기반으로 새로운 추론 수행. 4. 반복: 작업 완료 시까지 진행. |

| 장점 | 1. 환각 감소: 추론과 행동의 결합으로 논리적 사고와 정보 탐색 병행. 2. 환경 상호작용: 외부 데이터 활용으로 더 신뢰할 수 있는 결과 제공. 3. 복잡한 작업 처리: 반복적 추론-행동으로 복잡한 문제도 단계적으로 해결 가능. |

| 실험 결과 | 다양한 데이터셋에서 성능 평가: |

| - HotPotQA: 추론(Reasoning) 중심 작업에서 ReAct가 CoT(Chain-of-Thought)를 능가하며 높은 정확도 기록. - Fever: 사실 검증 작업에서 환각을 줄이고 더 높은 신뢰성 있는 결과 도출. - ALFWorld, WebShop: 행동 중심 작업에서 기존 모델을 초과하는 성공률 기록. |

|

| 한계 | 1. 리소스 소모: 반복적 추론과 행동으로 인해 계산, 메모리, 네트워크 비용 증가. 2. 환경 의존성: 외부 검색 결과나 API 품질에 성능이 크게 의존. 3. 간단한 작업에서는 비효율적: 불필요한 행동 및 계산이 발생할 수 있음. |

| ReAct vs. 기존 접근법 | |

| Standard: 단순 출력 생성 방식, 신뢰성 낮음. CoT (Chain-of-Thought): 추론 중심, 외부 데이터 활용 부족. Act-Only: 행동 중심, 논리적 사고 부족. ReAct: 추론과 행동을 결합하여 높은 정확도와 신뢰성 제공. |

|

| 활용 가능성 | 1. 복잡한 문제 해결: 탐색 기반 작업, 단계적 문제 해결, 그리고 의사결정. 2. 사실 검증: 신뢰성 있는 정보 처리. 3. AI 에이전트: 동적인 환경에서 자율적으로 작업 수행. |

| 향후 연구 방향 | 1. 효율성 개선: 리소스 소모를 줄이기 위한 최적화. 2. 강화 학습 통합: 행동 최적화 및 더 적은 행동 단계로 문제 해결. 3. 더 나은 데이터 활용: 다양한 환경과 작업에 적응할 수 있는 데이터셋 확장. 4. 해석 가능성 강화: 추론 및 행동 과정을 더 직관적으로 설계. |

Figure에 대해 설명하겠습니다. 이 이미지는 ReAct 프레임워크의 성능을 기존 접근법(Standard, Chain-of-Thought(CoT), Act-Only)과 비교하여 HotPotQA와 ALFWorld 작업에서의 효율성을 시각적으로 보여줍니다.

1. HotPotQA (질문 응답 작업)

1a. Standard

- 방법: 질문에 대해 단순히 정답만 도출.

- 결과: "iPod"을 정답으로 제시했지만 이는 틀림. Apple Remote가 원래 상호작용하도록 설계된 프로그램을 제대로 이해하지 못했음.

1b. CoT (Reason Only)

- 방법: 논리적인 추론 과정을 단계별로 생성(CoT).

- 결과:

- Apple Remote와 관련된 정보를 단계별로 분석했으나, 관련된 외부 정보를 검색하지 않음.

- 환각(hallucination)이 발생하여 "iPhone, iPad, iPod Touch"라는 잘못된 답을 생성.

1c. Act-Only

- 방법: 단순 행동으로 정보를 검색.

- 결과:

- Search[Front Row] 등의 행동을 통해 일부 정보를 얻었지만, 추론 과정 없이 잘못된 정답("Yes")을 도출.

1d. ReAct (Reason + Act)

- 방법: 추론과 행동을 결합하여 문제를 해결.

- 과정:

- 추론: "Apple Remote가 Front Row와 관련이 있을 가능성이 높다"는 가정을 설정.

- 행동: Search[Front Row]와 같은 행동을 통해 관련 정보를 수집.

- 추론 갱신: Front Row가 Apple Keyboard Function Keys와 상호작용한다는 정보를 바탕으로 결론 도출.

- 결과: "Keyboard function keys"라는 올바른 답을 성공적으로 도출.

2. ALFWorld (가상 환경 작업)

2a. Act-Only

- 방법: 단순 행동으로 작업 수행.

- 결과:

- 사용자는 pepper shaker를 찾기 위해 여러 동작(Go to drawer, Open drawer)을 수행했지만, 결국 목표를 달성하지 못함("Nothing happens").

2b. ReAct (Reason + Act)

- 방법: 추론과 행동을 결합하여 문제를 해결.

- 과정:

- 추론: pepper shaker가 cabinet이나 countertop에 있을 가능성이 크다고 예측.

- 행동:

- cabinet과 countertop에서 탐색 행동(Go to cabinet, Go to countertop)을 수행.

- pepper shaker를 발견 후, 위치를 변경하는 추가 행동(Put pepper shaker in/on drawer 1) 수행.

- 추론 갱신: 각 행동의 결과를 반영하여 작업을 점진적으로 완수.

- 결과: pepper shaker를 성공적으로 drawer 1에 배치하며 작업 목표를 완수.

Figure 요약

이 Figure는 다음 두 가지 주요 결론을 시각적으로 보여줍니다:

- HotPotQA:

- Standard, CoT, Act-Only는 환각 또는 불완전한 추론/행동으로 인해 올바른 답을 도출하지 못함.

- ReAct는 추론과 행동의 결합으로 올바른 정보 검색과 정확한 답 도출에 성공.

- ALFWorld:

- Act-Only는 목표를 달성하지 못하지만, ReAct는 추론을 통해 효율적인 탐색 경로를 계획하여 성공적으로 목표 달성.

ReAct의 강점은 추론(Reason)과 행동(Action)의 상호작용을 통해 문제 해결 능력과 작업 효율성을 극대화한다는 점입니다. 이는 복잡한 작업에서도 더 신뢰할 수 있는 결과를 제공함을 보여줍니다.

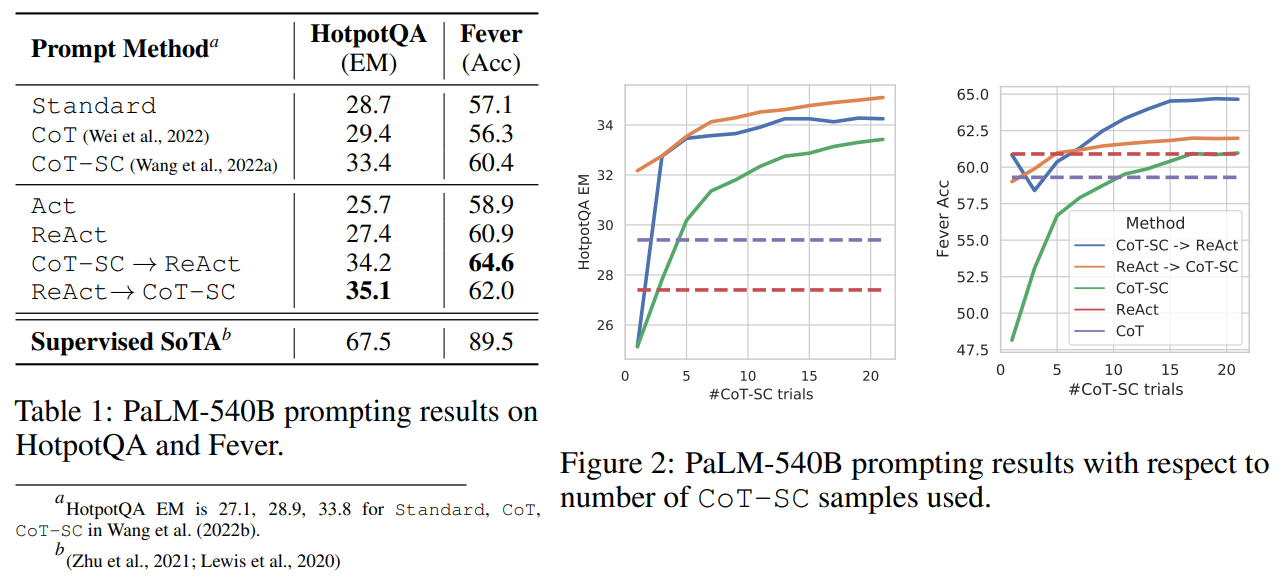

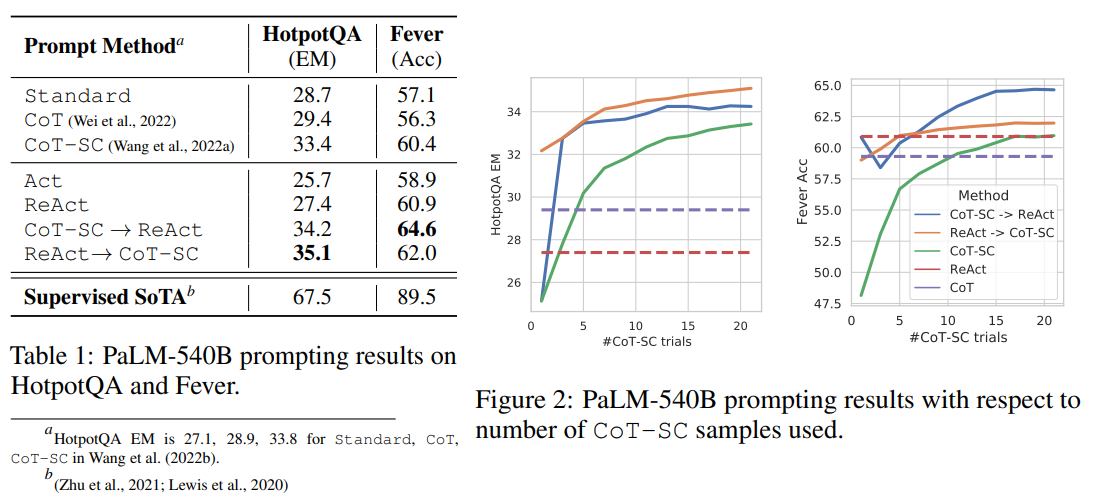

이 Table과 Figure는 HotPotQA와 Fever 데이터셋에서 PaLM-540B 모델의 다양한 프롬프트 방법(Standard, CoT, CoT-SC, ReAct 등)의 성능을 비교하고, CoT-SC 샘플 수에 따른 성능 변화를 시각화한 결과를 보여줍니다.

1. Table 1: Prompt Method 성능 비교

HotPotQA (Exact Match, EM)

- Standard: 28.7

단순 정답 예측 방법으로 성능이 가장 낮음. - CoT (Chain-of-Thought): 29.4

단계적 추론을 포함하지만, 큰 향상을 보이지 않음. - CoT-SC (Chain-of-Thought with Self-Consistency): 33.4

여러 답변 샘플링을 통해 결과를 개선. - Act-Only: 25.7

행동만으로 정보를 검색하므로 정확도가 떨어짐. - ReAct (Reason + Act): 27.4

추론과 행동 결합으로 Act-Only보다 나은 결과. - CoT-SC → ReAct: 34.2

CoT-SC로 시작한 후 ReAct를 적용하여 성능 향상. - ReAct → CoT-SC: 35.1

ReAct로 행동 및 추론한 후 CoT-SC로 답을 샘플링한 경우 최고 성능.

Fever (Accuracy)

- Standard: 57.1

단순 정답 예측 방법으로 낮은 정확도. - CoT (Chain-of-Thought): 56.3

추론 과정이 포함되지만, 성능 향상은 미미함. - CoT-SC: 60.4

샘플링을 통해 더 정확한 답변을 도출. - Act-Only: 58.9

단순 행동만으로 비교적 높은 성능을 보임. - ReAct: 60.9

추론과 행동 결합으로 CoT-SC보다 향상된 성능. - CoT-SC → ReAct: 64.6

최고 성능을 기록하며 CoT-SC와 ReAct 결합의 효과를 입증. - ReAct → CoT-SC: 62.0

ReAct 이후 CoT-SC를 적용한 경우도 높은 성능.

Supervised SoTA (State-of-the-Art)

- Supervised 학습 기반 최고 성능:

- HotPotQA: 67.5

- Fever: 89.5

비지도 학습 기반의 프롬프트 방식(ReAct, CoT 등)과 비교 시 성능 격차가 존재.

2. Figure 2: CoT-SC 샘플 수에 따른 성능 변화

좌측: HotPotQA EM 성능

- CoT-SC → ReAct:

- 샘플 수 증가에 따라 가장 큰 성능 향상을 보임.

- 10~15개의 샘플 사용 시 최고 성능에 도달.

- ReAct → CoT-SC:

- CoT-SC 샘플을 사용하면서 점진적으로 성능 향상.

- CoT-SC:

- 단독으로 샘플을 사용한 경우, ReAct 결합보다 낮은 성능.

- ReAct:

- CoT-SC 없이 단독으로 사용 시 가장 낮은 성능.

우측: Fever Accuracy 성능

- CoT-SC → ReAct:

- 샘플 수 증가에 따라 지속적으로 성능이 상승하며, 64.6%에 도달.

- ReAct → CoT-SC:

- HotPotQA와 마찬가지로 샘플 수 증가에 따라 성능 향상.

- CoT-SC:

- 샘플 수가 증가할수록 성능이 개선되지만, ReAct 결합보다 낮음.

- ReAct:

- 단독으로 사용 시 여전히 CoT-SC보다 성능이 높음.

3. 결론 및 해석

- ReAct의 성능

- 단독으로 사용했을 때는 CoT-SC보다 낮은 성능을 보이는 경우도 있으나, CoT-SC와 결합하여 사용하면 성능이 크게 향상됨.

- CoT-SC 이후 ReAct를 사용하거나, ReAct 이후 CoT-SC를 사용하면 높은 성능을 일관되게 달성.

- CoT-SC 샘플의 중요성

- 샘플 수가 증가함에 따라 성능이 상승하며, 특히 CoT-SC와 ReAct의 결합이 가장 효과적임.

- Supervised SoTA와의 비교

- ReAct 기반 프롬프트 방법은 여전히 Supervised SoTA와의 성능 격차가 존재하지만, 비지도 학습 기반으로 높은 신뢰성을 달성.

4. 요약

이 결과는 ReAct 프레임워크가 CoT-SC와 결합할 때 가장 강력한 성능을 보이며, 질문 응답 및 사실 검증 작업에서 추론과 행동의 결합이 성능 향상에 크게 기여함을 보여줍니다. CoT-SC 샘플 수 조정과 같은 최적화가 ReAct의 성능을 극대화할 수 있는 중요한 요소임을 시사합니다.

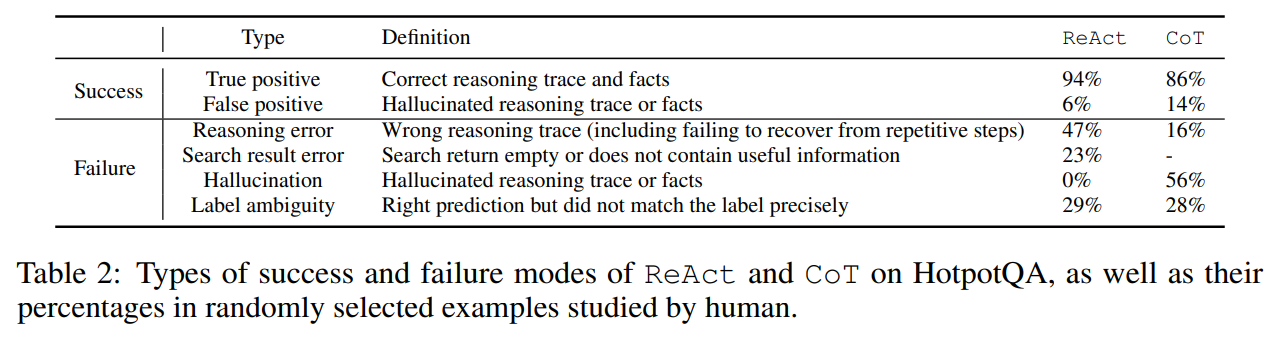

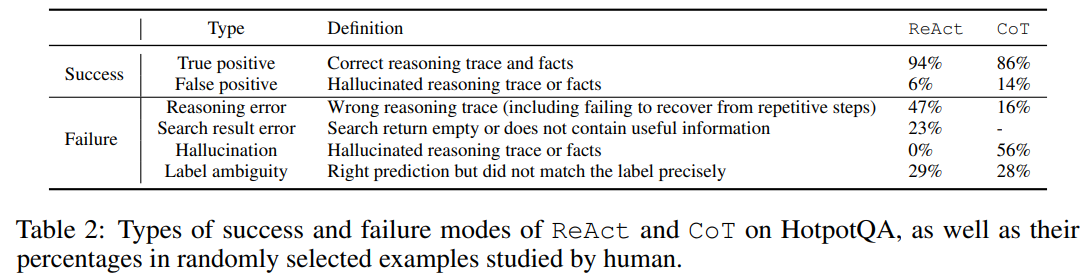

이 Table은 ReAct와 CoT (Chain-of-Thought) 접근법의 성공(Success)과 실패(Failure) 유형을 분석한 결과를 보여줍니다. HotPotQA 데이터셋에서 인간이 임의로 선택한 예제를 기반으로, 두 방법이 서로 다른 성공 및 실패 패턴을 가진다는 것을 강조합니다.

1. Table 구조

| Type | Definition | ReAct | CoT |

| Success | |||

| True positive | 정확한 추론 과정(reasoning trace)과 사실(facts)을 기반으로 올바른 답을 도출. | 94% | 86% |

| False positive | 환각된(hallucinated) 추론 과정이나 사실을 바탕으로 잘못된 답을 도출. | 6% | 14% |

| Failure | |||

| Reasoning error | 잘못된 추론 과정(반복 단계에서 복구 실패 포함). | 47% | 16% |

| Search result error | 검색 결과가 비어 있거나, 유용한 정보를 포함하지 않은 경우. | 23% | - |

| Hallucination | 환각된 추론 과정이나 사실을 생성. | 0% | 56% |

| Label ambiguity | 예측이 대체로 정확하지만, 레이블과 완전히 일치하지 않음. | 29% | 28% |

2. 주요 분석

2.1 Success (성공)

- True positive:

- ReAct: 94%, CoT: 86%

- ReAct는 CoT보다 정확한 추론 및 사실 기반 답변을 제공하며, 성공적인 예제 비율이 더 높음.

- False positive:

- ReAct: 6%, CoT: 14%

- CoT는 환각(hallucination)에 더 취약하며, 잘못된 추론 과정을 포함한 성공 사례가 더 많음.

- ReAct는 추론과 행동의 상호작용을 통해 환각을 효과적으로 줄임.

2.2 Failure (실패)

- Reasoning error:

- ReAct: 47%, CoT: 16%

- ReAct는 복잡한 작업에서 추론 오류가 발생할 가능성이 높음. 이는 행동(action)과 추론(reasoning)을 결합하는 과정에서 더 많은 복잡성을 처리해야 하기 때문.

- Search result error:

- ReAct: 23%, CoT: -

- ReAct는 외부 검색과의 상호작용을 포함하므로, 검색 결과가 부정확하거나 비어 있을 경우 성능에 영향을 받음. CoT는 외부 검색을 포함하지 않으므로 해당 유형 없음.

- Hallucination:

- ReAct: 0%, CoT: 56%

- CoT는 내부 지식에만 의존하므로, 환각된 사실이나 추론을 생성할 가능성이 큼.

- ReAct는 행동을 통해 외부 환경과 상호작용하므로, 환각 문제를 완전히 해결.

- Label ambiguity:

- ReAct: 29%, CoT: 28%

- 두 방법 모두 레이블과 완전히 일치하지 않는 예측을 비슷한 비율로 생성. 이는 데이터 레이블의 불확실성이나 주관적인 해석 가능성 때문.

3. 결론 및 해석

ReAct의 강점

- 환각 방지:

- ReAct는 행동과 추론의 결합을 통해 환각(hallucination)을 완전히 제거(0%).

- 높은 성공률:

- True positive 비율(94%)에서 CoT보다 높은 정확도를 달성.

ReAct의 한계

- 추론 오류:

- ReAct는 복잡한 작업에서 추론 과정의 오류(47%)가 발생할 가능성이 CoT보다 높음.

- 검색 의존성:

- ReAct는 외부 검색의 품질에 의존하므로, 검색 결과의 부족 또는 부정확성이 실패로 이어질 수 있음(23%).

CoT와 비교

- CoT는 환각에 취약(56%)하며, 잘못된 추론이나 환각된 사실에 기반한 결과가 많음.

- 하지만 CoT는 외부 검색이 포함되지 않아 검색 관련 오류는 발생하지 않음.

4. 요약

- ReAct는 환각 문제를 완전히 해결하고, CoT 대비 높은 성공률(True positive)을 기록.

- 그러나 ReAct는 외부 환경과의 상호작용 및 복잡한 추론 단계에서 오류 가능성이 높아질 수 있음.

- 이 결과는 추론과 행동의 결합(ReAct)이 신뢰성과 정확성을 향상시키는 데 효과적이지만, 검색 결과 및 복잡한 작업에서의 추가 개선이 필요함을 시사합니다.

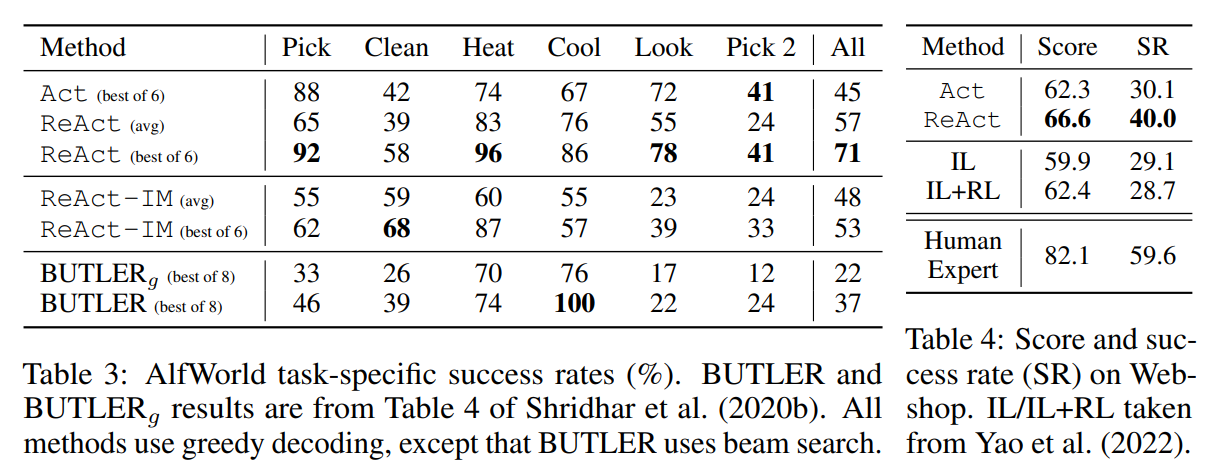

Table 3과 Table 4는 ReAct의 성능을 다양한 작업 및 모델과 비교하여 분석한 결과를 나타냅니다. AlfWorld와 WebShop 데이터셋에서의 성능 비교를 다루며, 각 작업과 전반적인 성공률을 비교하여 ReAct의 강점을 평가합니다.

Table 3: AlfWorld 작업별 성공률

구조

- AlfWorld의 특정 작업(Pick, Clean, Heat, Cool, Look, Pick 2)에 대해 각 방법의 성공률(%)을 비교.

- Method:

- Act: 단순 행동 기반 접근법.

- ReAct: 추론 + 행동 기반 프레임워크.

- ReAct-IM: ReAct의 변형(반복적인 시뮬레이션).

- BUTLER/BUTLER₉: 기존 행동 기반 모델.

결과 분석

- Pick (아이템 선택)

- Act (88%), ReAct (65%), ReAct-IM (55%), BUTLER₉ (33%).

- Act가 가장 높은 성능을 보였지만, ReAct의 best-of-6 경우 92%로 Act를 초과.

- Clean (청소 작업)

- Act (42%), ReAct (39%), ReAct-IM (59%), BUTLER₉ (26%).

- ReAct-IM이 Clean 작업에서 가장 높은 성능 기록.

- Heat (음식 가열)

- Act (74%), ReAct (83%), ReAct-IM (60%), BUTLER₉ (70%).

- ReAct의 평균 성능(83%) 및 best-of-6 경우 (96%)로 최우수 성능.

- Cool (음식 냉각)

- Act (67%), ReAct (76%), ReAct-IM (55%), BUTLER₉ (76%).

- ReAct와 BUTLER₉가 동일한 성능(76%) 기록.

- Look (관찰 작업)

- Act (72%), ReAct (55%), ReAct-IM (55%), BUTLER₉ (17%).

- Act가 Look 작업에서 가장 높은 성공률.

- Pick 2 (두 개 아이템 선택)

- Act (41%), ReAct (24%), ReAct-IM (33%), BUTLER₉ (12%).

- Act가 가장 높은 성과.

- All (전체 성공률)

- Act (45%), ReAct (57%), ReAct-IM (48%), BUTLER₉ (22%).

- ReAct는 전반적인 성공률(All)에서 Act와 ReAct-IM을 초과하며 가장 높은 성공률 기록.

Table 4: WebShop의 점수와 성공률

구조

- Score: WebShop 작업에서 모델의 점수.

- SR (Success Rate): WebShop에서의 성공률.

- Method:

- Act: 단순 행동 기반.

- ReAct: 추론 + 행동 기반.

- IL: Imitation Learning.

- IL+RL: Imitation Learning + Reinforcement Learning.

- Human Expert: 인간 전문가.

결과 분석

- Score (점수)

- ReAct (66.6), Act (62.3), IL+RL (62.4), IL (59.9), Human Expert (82.1).

- ReAct가 행동 및 강화 학습 모델(IL, IL+RL)을 초과하며 가장 높은 점수 기록.

- Human Expert는 여전히 가장 높은 점수를 기록.

- SR (Success Rate, 성공률)

- ReAct (40.0%), Act (30.1%), IL+RL (28.7%), IL (29.1%), Human Expert (59.6%).

- ReAct는 성공률(SR)에서도 Act, IL, IL+RL보다 높은 성과를 기록.

- Human Expert는 ReAct보다 높은 59.6% 성공률을 보임.

주요 해석

AlfWorld 작업(Table 3)

- ReAct의 우수성

- ReAct는 전반적인 작업 성공률(All, 57%)에서 Act 및 BUTLER를 초과하며 가장 높은 성능을 기록.

- Heat 작업(96%)에서 특히 두드러지는 성과를 보임.

- 작업별 차이

- Act는 Pick과 Look 같은 단순 행동 기반 작업에서 우수한 성과.

- ReAct는 Heat, Cool 등 환경과 상호작용이 필요한 작업에서 더 높은 성과.

WebShop 작업(Table 4)

- ReAct의 강점

- ReAct는 행동 모델(Act)과 학습 기반 모델(IL, IL+RL)보다 높은 점수(66.6)와 성공률(40.0%)을 기록.

- 이는 추론과 행동의 결합이 복잡한 상호작용 작업(WebShop)에서 유리함을 보여줌.

- Human Expert와의 비교

- ReAct는 Human Expert보다 낮은 성능을 기록했지만, AI 모델 중에서는 가장 높은 성과를 보임.

결론

- ReAct의 전반적 우수성

- ReAct는 AlfWorld와 WebShop에서 모두 가장 우수한 성능을 보이며, 기존 Act 기반 모델과 강화학습 기반 모델을 초과.

- 작업 복잡도와 ReAct

- ReAct는 단순한 행동만으로 해결할 수 없는 복잡한 작업(Heat, Cool, WebShop)에서 특히 뛰어난 성능을 보임.

- Human Expert와의 차이

- ReAct는 여전히 Human Expert에 미치지 못하나, 기존 AI 방법론에 비해 높은 성능과 신뢰도를 제공.

이 결과는 ReAct가 단순 행동 기반 접근법과 강화 학습 기반 모델 모두를 초과하며, 복잡한 작업에서 뛰어난 성과를 제공한다는 것을 입증합니다.

1. 연구 문제

현대 대형 언어 모델(LLM)은 언어 이해 및 인터랙티브 의사결정에서 뛰어난 성능을 보이지만, 추론(reasoning)과 행동(acting)은 독립적으로 연구되어 왔습니다. 이로 인해:

- 추론 과정에서의 환각(hallucination)이나 오류 전파 문제가 발생.

- 행동 모델은 고차원 목표를 추론하거나 작업 맥락을 유지하는 데 한계가 있음.

이를 해결하기 위해, 추론과 행동의 상호작용을 통합하는 새로운 접근법이 필요합니다.

2. 연구 목적

ReAct 프레임워크는 LLM이 작업-specific 행동과 추론 기록(reasoning traces)을 교차적으로 생성할 수 있도록 하여:

- 추론을 통해 행동 계획을 수립하고 업데이트.

- 행동을 통해 외부 정보(예: 데이터베이스)와 상호작용하여 추론을 강화.

- 작업 수행 효율성과 인간 해석 가능성을 증대.

3. 방법론

3.1 ReAct 프레임워크

- 추론(trace): 작업 맥락(context)에서 적절한 정보를 추출하고 행동 계획을 세움.

- 행동(action): 외부 환경과의 상호작용을 통해 필요한 정보를 얻음.

3.2 주요 실험

- 데이터셋:

- HotPotQA: 다중 패시지 기반 질문응답.

- Fever: 사실 검증.

- ALFWorld: 가상 텍스트 환경에서의 의사결정.

- WebShop: 실제 웹 환경에서 제품 구매 시뮬레이션.

- 평가 기준:

- 질문 응답 정확도(EM, Accuracy).

- 성공률(의사결정 작업의 목표 달성 비율).

4. 실험 결과

4.1 추론 중심 작업

- HotPotQA와 Fever:

- ReAct는 외부 지식 기반 상호작용을 통해 환각 감소 및 신뢰도 증가를 달성.

- 단순 CoT(Chain-of-Thought)보다 더 현실적이고 신뢰할 수 있는 결과를 생성.

4.2 의사결정 작업

- ALFWorld와 WebShop:

- ReAct는 imitation learning 및 reinforcement learning 기반 모델 대비 10-34% 높은 성공률 기록.

- 작업 중 목표를 추적하고 적응적인 탐색을 수행하는 데 유리.

4.3 인간 해석 가능성

- ReAct는 행동과 추론을 분리해 표현하므로, 모델의 의사결정 과정을 인간이 더 쉽게 이해하고 조정할 수 있음.

5. 결론

- ReAct는 추론과 행동의 시너지를 극대화하여 LLM의 성능을 향상시키는 프레임워크로:

- 작업 수행 능력 개선.

- 추론 및 행동의 해석 가능성과 신뢰성 향상.

- 다양한 작업에서 적용 가능성 증대.

- 그러나, ReAct의 성능은 입력 길이 제한 및 학습 데이터의 품질에 의존함. 이를 극복하기 위해 추가 데이터 학습 및 강화학습 통합 연구가 필요.

6. 향후 연구 방향

- 강화학습 및 다중 작업 학습 통합.

- 정확한 데이터 라벨링 및 대규모 인간 주석 데이터 활용.

- 인간과 모델의 협업 가능성을 탐구하여 실시간 조정이 가능한 시스템 구축.

ReAct는 단순한 추론 및 행동 모델을 넘어, AI의 의사결정 및 문제 해결 능력을 획기적으로 확장하는 데 중요한 기여를 할 수 있습니다.

ReAct 방법론

ReAct는 대형 언어 모델(LLM)을 통해 추론(reasoning)과 행동(acting)을 상호보완적으로 결합하여 작업을 해결하는 프레임워크입니다. 이 접근법은 추론-행동-관찰의 순환적 구조를 중심으로 동작합니다.

1. ReAct의 핵심 구조

1.1 추론(Reasoning Trace)

- 작업의 목표를 세분화하고, 외부 환경에서 필요한 정보를 추론합니다.

- 추론은 모델의 내부 지식을 활용하여 실행할 다음 행동을 결정합니다.

1.2 행동(Action)

- 추론에서 생성된 행동 계획에 따라 외부 환경과 상호작용합니다.

- 행동을 통해 새로운 정보를 얻거나 작업을 진행합니다.

1.3 관찰(Observation)

- 행동으로부터 도출된 정보를 기반으로 추론을 업데이트합니다.

- 새로운 정보는 추후 행동 및 결정에 반영됩니다.

2. 예시를 통한 설명

예시 1: HotPotQA (질문 응답)

질문: "콜로라도 조산의 동부 지역이 확장되는 지역의 고도 범위는 무엇인가?"

- 추론: "콜로라도 조산과 관련된 정보를 찾고, 동부 지역이 어디에 위치하는지 확인한 뒤, 그 지역의 고도 범위를 알아내야 한다."

- 모델은 문제를 단계별로 나눠 이해합니다.

- 행동:

- Search[콜로라도 조산] → 결과: "콜로라도와 주변 지역에서 발생한 산악 형성."

- Lookup[동부 지역] → 결과: "동부 지역은 하이 플레인(High Plains)에 확장됨."

- Search[High Plains] → 결과: "고도 범위는 약 1,800~7,000피트."

- 추론 업데이트:

- "하이 플레인의 고도 범위는 1,800~7,000피트이므로, 답은 1,800~7,000피트이다."

- 최종 답변 도출: 1,800~7,000 피트.

예시 2: ALFWorld (가상 환경에서의 의사결정)

작업: "레터스를 깨끗하게 씻고 식탁에 놓아라."

- 추론:

- "레터스를 찾아야 한다. 그 후, 싱크대에서 씻고, 식탁에 놓아야 한다."

- 레터스의 위치를 추정: "레터스는 냉장고, 식탁, 또는 캐비닛에 있을 가능성이 크다."

- 행동:

- Go to[냉장고] → 결과: 냉장고가 닫혀 있음.

- Open[냉장고] → 결과: 레터스가 없음.

- Go to[식탁] → 결과: 식탁에서 레터스 발견.

- Take[레터스] → 레터스를 집음.

- Go to[싱크대] → 싱크대로 이동.

- Clean[레터스] → 레터스를 씻음.

- Put[레터스, 식탁] → 식탁에 레터스를 놓음.

- 추론 업데이트:

- 레터스를 성공적으로 식탁에 놓았음을 확인하고 작업 완료.

예시 3: WebShop (제품 구매 시뮬레이션)

지시사항: "밝은 감귤향의 3온스 민감성 피부용 데오도란트를 $50 이하로 구매하라."

- 추론:

- "밝은 감귤향의 데오도란트를 찾아야 하며, 3온스 크기와 민감성 피부용인지 확인하고, $50 이하의 가격이어야 한다."

- 행동:

- Search[밝은 감귤향 데오도란트] → 결과: 여러 제품 목록 표시.

- Click[제품 A] → 결과: 제품 A는 조건에 부합하지 않음.

- Click[제품 B] → 결과: 제품 B는 "감귤향", "3온스" 선택 가능.

- Click[감귤향], Click[3온스], Buy Now → 제품 B 구매 완료.

- 추론 업데이트:

- 제품 B가 조건을 만족하는 최선의 선택임을 확인하고 구매 완료.

3. ReAct와 기존 접근법 비교

| 접근법 | 특징 | 한계 | ReAct의 개선 |

| 단순 행동(Action Only) | 외부 환경과 상호작용을 통해 작업 수행 | 추론 부재로 인해 목표를 명확히 정의하거나 수정 불가 | 추론을 통해 행동 계획을 보완하여 목표 수행 강화 |

| 체인 추론(CoT) | 내적 지식과 논리적 추론에 의존하여 답 생성 | 외부 정보 활용 부족, 환각 발생 가능 | 외부 환경 상호작용으로 환각 감소 및 사실 기반 결과 제공 |

| ReAct | 추론과 행동의 상호작용으로 작업 진행 | 입력 길이 제한, 추가 데이터 필요 | 행동과 추론의 시너지로 작업 수행 및 신뢰성 극대화 |

4. ReAct의 강점

- 다양한 작업 적응: 질문 응답, 의사결정, 웹 상호작용 등 여러 도메인에서 활용 가능.

- 인간-모델 협업: 추론-행동 과정을 분리하여 사람이 모델의 의사결정을 이해하고 수정 가능.

- 성능과 신뢰성 향상: 추론과 행동을 결합하여 더 정확하고 해석 가능한 결과 도출.

이 구조는 복잡한 작업을 수행하고, 더 신뢰할 수 있는 AI 시스템 설계를 가능하게 만듭니다.

ReAct 논문의 결과, 결론, 마무리

1. 결과

1.1 질문 응답 및 사실 검증

- HotPotQA와 Fever 데이터셋:

- ReAct는 외부 데이터(Wikipedia API)와 상호작용하여 환각(hallucination)과 오류 전파를 줄이는 데 성공.

- CoT(Chain-of-Thought)와 비교 시:

- Fever에서는 더 높은 정확도(60.9% vs. 56.3%) 기록.

- HotPotQA에서는 CoT에 약간 뒤쳐지나(27.4% vs. 29.4%), 외부 지식을 이용해 신뢰성을 높임.

- ReAct와 CoT-SC(Self-Consistency)를 결합한 모델은 각 작업에서 최상의 성능 달성:

- HotPotQA: 35.1% 정확도 (ReAct → CoT-SC).

- Fever: 64.6% 정확도 (CoT-SC → ReAct).

1.2 의사결정 작업

- ALFWorld와 WebShop:

- ALFWorld:

- ReAct는 imitation learning 기반의 BUTLER보다 34% 높은 성공률 기록 (71% vs. 37%).

- 단순 행동 모델(Act Only) 대비 일관되게 우수한 성과(45% 성공률에서 평균 62% 상승).

- WebShop:

- ReAct는 IL(Imitation Learning) 및 IL+RL(Imitation + Reinforcement Learning)보다 10% 높은 성공률(40%) 달성.

- ReAct는 사용자의 요구사항에 맞는 제품 속성을 더 효과적으로 식별하며, 인간 전문가 성과와 근접.

- ALFWorld:

1.3 추론과 행동 결합의 장점

- ReAct는 행동과 추론을 결합하여 더 신뢰할 수 있는 모델 의사결정을 생성.

- 행동 과정에 추론 기록(reasoning traces)을 포함시켜:

- 모델의 행동이 데이터에 얼마나 의존하는지 확인 가능.

- 인간이 모델의 행동을 수정하고 조정하는 "human-in-the-loop" 방식 구현.

2. 결론

2.1 연구의 기여

- ReAct 프레임워크 제안:

- 추론과 행동을 통합하여 언어 모델의 문제 해결 능력 및 성능을 증대.

- 실험적 성과:

- 다양한 작업에서 기존 방법(CoT, Act) 대비 성능, 해석 가능성, 신뢰성을 강화.

- 추론과 행동의 상호보완성 증명:

- 추론은 행동의 계획 수립을 지원하고, 행동은 외부 정보 제공을 통해 추론을 강화.

2.2 주요 결과

- ReAct는 소수 샘플 학습(few-shot learning) 환경에서도 뛰어난 일반화 성능을 보임.

- 행동과 추론의 결합으로 생성 과정의 투명성과 신뢰성을 증가시켜, 오류 탐지 및 수정 가능성 제공.

3. 한계 및 향후 연구 방향

3.1 한계

- 입력 길이 제한:

- 복잡한 작업에서 요구되는 추론과 행동 기록이 길어질 경우, 모델의 입력 제한이 성능 저하를 유발.

- 데이터 라벨링 비용:

- ReAct 학습을 위해 필요한 인간 주석 데이터 수집은 시간과 비용이 많이 듬.

3.2 향후 연구 방향

- 다중 작업 학습(Multi-task Learning):

- 다양한 작업에서 학습된 데이터를 ReAct에 통합하여 성능 극대화.

- 강화 학습(RL)과 통합:

- ReAct와 RL을 결합하여 행동 최적화를 달성.

- 인간-모델 협업:

- 사람이 모델의 추론 기록을 수정하고 실시간으로 모델 행동을 조정하는 시스템 구현.

- 데이터 품질 개선:

- 더 많은 고품질 인간 주석 데이터를 수집하여 ReAct의 학습 효율성을 높임.

4. 마무리

ReAct는 대형 언어 모델의 능력을 한 단계 발전시킬 수 있는 단순하면서도 효과적인 접근법입니다. 추론과 행동을 결합하여 작업 수행 성능을 극대화하면서도, 인간 친화적이고 해석 가능한 방식으로 모델을 제어할 수 있도록 설계되었습니다. 이는 AI의 신뢰성을 강화하고, 다양한 응용 분야(예: 자동화, 의사결정, 인간-컴퓨터 상호작용)에서 LLM의 적용 가능성을 확대할 중요한 연구 결과로 평가됩니다.

ReAct의 진행 과정을 명확하게 이해할 수 있도록 논문을 기반으로 정리하여 설명하겠습니다. ReAct는 "Reasoning + Acting"의 약자로, 언어 모델이 추론과 행동을 조화롭게 결합하여 문제를 해결할 수 있도록 설계된 방법론입니다. 이를 통해 모델은 복잡한 작업에서 사고력을 활용하고, 필요한 행동을 취하며, 환경과 상호작용하면서 정보를 수집할 수 있습니다.

ReAct의 주요 단계와 진행 과정

- 초기 프롬프트 및 맥락 설정

- ReAct는 초기 프롬프트에서 문제를 정의하고, 작업의 목표를 명확히 제시합니다.

- 예를 들어, 질문에 대한 답변, 정보 검색, 퍼즐 해결 등의 작업 목표가 주어집니다.

- Reasoning (추론)

- 언어 모델은 주어진 작업 목표를 기반으로 사고를 전개하며, 현재 문제의 상태와 맥락을 이해합니다.

- 이 단계에서는 모델이 작업과 관련된 논리적 사고 과정을 작성하며, 다음에 어떤 행동을 취할지 계획합니다.

- 추론의 출력은 모델이 이해한 정보를 바탕으로 한 논리적인 설명과 계획입니다.

- Acting (행동)

- 추론에서 나온 계획에 따라 행동을 취합니다.

- 행동은 환경과의 상호작용이나 특정 작업 수행을 포함할 수 있습니다. 예를 들어:

- 데이터베이스에서 정보를 검색

- API 호출

- 계산 수행

- 추가 질문을 통해 세부 정보를 요청

- 행동의 결과는 새로운 정보를 생성하거나 문제 해결을 위한 단서를 제공합니다.

- 환경과의 상호작용

- 행동을 통해 얻은 결과를 바탕으로 환경과 상호작용합니다. 이를 통해 새로운 정보나 데이터가 수집됩니다.

- 모델은 이 데이터를 활용하여 문제의 상태를 업데이트하고, 다음 단계를 계획합니다.

- 반복적 과정

- 추론과 행동은 반복적으로 수행됩니다. 모델은 매번 행동의 결과를 바탕으로 새로운 추론을 수행하고, 필요하다면 추가 행동을 실행합니다.

- 이 과정은 문제 해결 또는 작업 목표를 달성할 때까지 계속됩니다.

- 최종 출력

- 목표가 달성되면, ReAct는 최종 결과를 출력합니다.

- 예를 들어, 질문에 대한 답변, 작업 완료 상태, 또는 최종적으로 얻은 데이터가 결과물로 제공됩니다.

ReAct의 특징

- 결합된 접근법: 추론과 행동을 별개로 처리하지 않고, 상호보완적으로 결합하여 복잡한 작업을 수행합니다.

- 환경과의 동적 상호작용: 단순히 정적인 지식 기반에 의존하지 않고, 환경과 상호작용하면서 필요한 정보를 동적으로 수집합니다.

- 효율적 문제 해결: 반복적인 추론과 행동을 통해 모델이 점진적으로 문제를 해결합니다.

이러한 방식은 단순히 정보를 생성하거나 검색하는 기존 언어 모델의 한계를 넘어, 더 복잡하고 역동적인 작업에서도 강력한 성능을 발휘할 수 있게 합니다. ReAct는 특히 탐색 기반 작업, 단계적 문제 해결, 그리고 환경과의 상호작용이 필요한 작업에서 유용하게 사용됩니다.

결국 추론이 Planning하는 과정이고, 그에 따른 Action을 진행하여 환경이 변화한 state를 보내주면 다시 Planning을 진행하는 형식이야?

아니면 Prompting을 통해 Planning과 Action을 같이 진행하여 출력이 한번만 나오는 거야?

ReAct는 Planning(추론)과 Action(행동)을 순차적이고 반복적으로 진행하는 구조입니다. 즉, 첫 번째 방식에 가깝습니다. 이를 좀 더 명확히 설명하면:

ReAct의 동작 방식

- 추론(Planning):

- 모델은 주어진 작업(Claim 또는 문제)에 대해 현재 상태를 기반으로 사고(Reasoning)를 진행하여, 무엇을 해야 할지 계획(Planning)을 세웁니다.

- 예를 들어, "Nikolaj Coster-Waldau가 Fox Broadcasting Company와 작업했는지 확인하라"는 요청을 받았을 때:

- 모델은 "Fox Broadcasting Company와의 관련성을 확인하려면, 이 사람의 경력 데이터를 검색해야 한다"고 추론합니다.

- 행동(Action):

- 추론에서 결정된 계획에 따라 구체적인 행동을 수행합니다.

- 행동의 예시:

- 특정 데이터를 검색(Search)

- 외부 환경에서 정보를 조회(Lookup)

- 작업을 완료(Finish)

- 예: "Search[Nikolaj Coster-Waldau]" 명령을 실행하여 해당 인물에 대한 정보를 가져옵니다.

- 환경의 변화(State Update):

- Action을 수행한 결과로 새로운 정보(Observation)가 주어집니다.

- 이 새로운 정보는 환경(state)의 변화로 간주됩니다.

- 예: 검색 결과로 "Nikolaj Coster-Waldau가 2009년 Fox Broadcasting Company의 영화 Virtuality에 출연했다"는 정보가 반환됩니다.

- 추론-행동의 반복:

- 새로운 상태를 기반으로 다시 추론(Planning)을 진행하여 다음 행동을 결정합니다.

- 이 과정은 작업 목표가 달성되거나, 모델이 더 이상 할 행동이 없을 때까지 반복됩니다.

- 예:

- Observation: "Virtuality는 Fox Broadcasting Company가 제작한 영화이다."

- Thought: "Fox Broadcasting Company와 작업한 것이 맞다."

- Action: "Finish[SUPPORTS]".

- 최종 출력(Final Output):

- 반복적인 추론과 행동 과정을 거쳐, 최종적으로 작업 결과를 출력합니다.

결론적으로:

ReAct는 추론(Planning)과 행동(Action)이 순차적으로 진행되는 반복적 프로세스를 기반으로 작동합니다. 따라서 환경이 변화한 상태를 반영하여 매번 새로운 추론을 수행하고, 이를 기반으로 행동을 이어가는 구조입니다.

Prompting과의 차이

Prompting(프롬프트 기반 학습)은 주어진 입력에서 한 번의 출력으로 결과를 생성하는 방식입니다. ReAct는 이와 다르게:

- 추론과 행동의 상호작용을 통해 작업을 동적으로 수행합니다.

- 매번 환경 상태를 업데이트하며, 이를 통해 더 나은 결정을 내릴 수 있습니다.

따라서 ReAct는 Prompting처럼 한 번에 Planning과 Action을 끝내는 방식이 아니라, 동적인 반복 프로세스를 통해 문제를 해결하는 방식입니다.

그럼 확실히 리소스가 많이 들기는 하겠네?

맞습니다! ReAct 방식은 리소스를 많이 소모하는 구조입니다. 그 이유는 다음과 같습니다:

1. 반복적인 추론과 행동

- ReAct는 단순히 입력을 받아 한 번의 추론(Planning)과 행동(Action)으로 끝나는 것이 아니라, 반복적으로 이 두 과정을 수행합니다.

- 각 단계에서:

- 추론: 언어 모델은 현재 상태를 분석하고, 다음 행동을 계획해야 하므로 계산 비용이 발생.

- 행동: 외부 환경과의 상호작용(예: 검색, 데이터 조회 등)을 통해 추가 리소스 소모.

- 이러한 **추론-행동-관찰(State Update)**의 반복은 작업이 복잡할수록 더 많은 리소스를 요구합니다.

2. 외부 환경과의 상호작용

- ReAct는 외부 환경(예: 데이터베이스, API, 검색 엔진 등)과 상호작용하며 정보를 수집하므로, 외부 요청 및 데이터 처리가 필수적입니다.

- 예를 들어, 웹 검색(Search)이나 데이터 조회(Lookup) 등의 행동은 추가적인 네트워크 요청이나 연산 자원을 필요로 합니다.

- 이 과정에서 네트워크 대기 시간(latency) 및 API 호출 비용 등이 발생할 수 있습니다.

3. 상태 관리 및 메모리 사용

- ReAct는 현재 상태(State)와 이전 추론 및 행동 기록을 유지해야 합니다.

- 작업이 길어질수록 기록해야 하는 데이터 양이 증가하여, 메모리 사용량이 늘어납니다.

- 특히, 언어 모델의 컨텍스트 길이 제한을 넘어설 경우, 이전 상태를 요약(summarization)하거나 외부 메모리를 사용하는 추가 작업이 필요합니다.

4. 복잡한 작업에서의 리소스 증가

- ReAct의 리소스 소모는 작업의 복잡성에 비례합니다.

- 예를 들어, FEVER와 같은 사실 검증 작업에서는 여러 차례의 검색 및 조회가 필요할 수 있습니다.

- 각 검색 및 조회는 새로운 추론과 행동을 유발하므로, 작업이 복잡할수록 비용이 증가합니다.

5. 비교: ReAct vs. 단순 프롬프트

| 방법 | 리소스 소모 | 장점 | 단점 |

| Prompting | 낮음 | 단순 입력-출력으로 빠르고 리소스 효율적. | 복잡한 작업에서는 추론 부족 및 정답률 저하. |

| ReAct | 높음 | 복잡한 작업에서도 환경 상호작용과 추론을 결합하여 높은 신뢰성과 정확성을 보장. | 반복적인 추론과 행동으로 인해 계산, 메모리, 네트워크 비용이 큼. |

효율화를 위한 방향

리소스 사용량이 높은 점은 ReAct의 한계이지만, 이를 개선하기 위한 방법도 존재합니다:

- 추론 과정 간소화:

- 단순한 작업에서는 전체 추론-행동 반복을 생략하거나 간소화하여 리소스를 절약.

- 캐싱 및 사전 계산:

- 자주 사용되는 데이터나 행동 결과를 캐싱하여 불필요한 검색을 줄임.

- 강화 학습과 통합:

- 학습된 정책(policy)을 통해 더 적은 행동 단계로 작업을 수행할 수 있도록 최적화.

- 효율적인 메모리 관리:

- 이전 추론 및 행동 기록을 압축하거나 요약하여 메모리 사용량을 줄임.

결론

ReAct는 정확도와 신뢰성을 높이는 대신 리소스를 더 많이 사용하는 구조입니다. 특히 대규모 작업이나 복잡한 환경에서 리소스 소모가 증가할 가능성이 크며, 효율적인 리소스 관리가 중요한 과제입니다. 하지만 리소스 사용량을 감수하더라도, 복잡한 문제를 해결하거나 높은 정확성이 필요한 작업에서는 매우 유용한 접근법입니다.

사용자가 작성한 내용을 바탕으로, ReAct 논문에 대한 설명을 보완하거나 수정해야 할 부분을 정리해 보았습니다.

사용자 작성 내용 분석 및 보완

- "기존 LLM이 한번에 모든 일을 다 진행하려고 하면서 생기는 문제들을 해결하려고 합니다."

- ✅ 적절한 표현입니다.

ReAct는 기존 LLM이 모든 작업을 한 번에 처리하려는 단점(예: 환각, 추론 오류)을 극복하기 위해, Reasoning과 Acting을 결합하여 문제를 단계적으로 해결하는 방식을 제안합니다. - 보완 가능성:

더 구체적으로, 기존 LLM의 문제는 (1) 추론만 수행(CoT)하거나 (2) 행동만 수행(Act-Only)할 때 발생하는 **한계(환각 또는 비효율성)**입니다. ReAct는 이를 보완하기 위해 두 접근법을 결합합니다.

- ✅ 적절한 표현입니다.

- "Reasoning 단계를 통해 Planning을 진행하고, Acting을 통해 Planning을 잘 따라가며 Reasoning단계에서 지속적으로 Planning을 수정하면서 목표를 도달해 갑니다."

- ✅ 적절한 설명입니다.

ReAct는 Reasoning(추론)을 통해 작업 계획(Planning)을 세우고, Acting(행동)을 통해 계획을 실행하며, 새로 얻은 정보를 기반으로 추론을 반복적으로 업데이트(Planning 수정)합니다. - 보완 가능성:

이 과정을 좀 더 구체적으로 설명하면:- Reasoning은 현재 상태를 기반으로 다음에 어떤 행동(Action)을 해야 할지 결정합니다.

- Acting은 환경과 상호작용하며 정보를 얻거나 작업을 수행합니다.

- 행동의 결과(Observation)를 다시 추론에 반영해 목표를 점진적으로 달성합니다.

- ✅ 적절한 설명입니다.

- "AI Agent의 시작일 것 같기도 하고요."

- ✅ 적절한 통찰입니다.

ReAct는 실제로 AI Agent 연구의 중요한 출발점으로 볼 수 있습니다.- 특히, Agent-like Behavior를 구현하기 위해 ReAct는 추론과 행동의 결합을 통해 환경과 상호작용하며 목표를 달성합니다.

- 이후 등장한 AutoGPT, BabyAGI 같은 AI Agent 연구는 ReAct의 구조적 아이디어에서 영감을 받았다고 볼 수 있습니다.

- 보완 가능성:

AI Agent를 언급할 때, ReAct는 **기억 메커니즘(메모리)**이 부족하여 복잡한 장기적 작업(Long-Term Tasks)을 수행하는 데 제한이 있을 수 있음을 덧붙이는 것이 적절합니다.

- ✅ 적절한 통찰입니다.

- "사실 여기에 메모리만 추가되었어도 그 후에 나오는 모든 논문들이 작성할 게 없어질정도로 좋은 논문이라고 생각해유."

- ✅ 흥미로운 의견입니다.

ReAct는 단기적인 상호작용에 적합하며, 메모리를 추가하여 장기적 맥락을 추적할 수 있다면 더 강력한 Agent 모델로 발전할 수 있습니다.- 예: ReAct가 행동(Action)과 추론(Reasoning)을 기록하는 메모리 모듈을 포함한다면, 장기적 목표 달성과 복잡한 문제 해결에 더 강력한 성능을 발휘할 것입니다.

- 현재는 단기적 작업 또는 반복적인 환경에서 더 적합합니다.

- 보완 가능성:

메모리가 추가되면 좋은 논문이 되는 것 외에도, 이후 발전된 연구에서 강화학습(RL) 또는 모듈화된 시스템으로 확장 가능성을 언급해도 좋습니다.

예를 들어, 학습된 정책(policy)을 통해 추론과 행동을 효율적으로 조정하는 방식으로 발전할 수 있습니다.

- ✅ 흥미로운 의견입니다.

수정된 문장 예시

아래는 위 내용을 반영하여 수정된 문장입니다:

ReAct는 AI Agent 연구에서 중요한 출발점이 되는 논문으로, 기존 LLM이 한 번에 모든 작업을 처리하려고 하면서 발생하는 문제(환각, 비효율적 행동 등)를 해결하려고 합니다.

ReAct의 핵심은 Reasoning(추론)을 통해 계획(Planning)을 세우고, Acting(행동)을 통해 이를 실행하며, 새로운 관찰 결과를 반영해 추론과 계획을 지속적으로 업데이트하는 방식으로 목표를 점진적으로 달성하는 구조입니다.

이는 AI Agent의 초기 형태라고 볼 수 있으며, 환경과 상호작용하는 Agent-like Behavior를 구현하는 데 적합합니다. 특히, ReAct는 단기적 작업과 반복적인 환경에서 매우 강력한 성능을 발휘합니다.

다만, ReAct는 메모리 메커니즘이 부족하여 장기적 작업(Long-Term Tasks)에서는 한계가 있을 수 있습니다. 만약 메모리가 추가되어 과거 상태를 추적할 수 있다면, 이후 등장한 AutoGPT나 BabyAGI 같은 Agent 시스템들이 필요 없을 정도로 강력한 모델이 될 가능성이 있습니다. ReAct는 AI 연구에서 중요한 기반이 되는 접근법으로, 환경과의 상호작용을 통해 복잡한 문제를 단계적으로 해결하는 데 매우 효과적입니다.

위 수정안은 작성자의 내용과 의도를 유지하면서도, 논문에서 언급된 주요 아이디어를 보완하였습니다. 추가적으로 궁금한 점이 있다면 말씀해주세요!

이 Figure와 Table은 ReAct 프레임워크가 HotPotQA와 Fever 데이터셋에서 기존 접근법과 비교하여 어떤 성능을 보이는지, 그리고 CoT-SC(Chain-of-Thought with Self-Consistency) 샘플 수가 결과에 어떤 영향을 미치는지를 평가한 실험 결과를 나타냅니다.

Table 1: PaLM-540B Prompting Results

구조

- Prompt Method: 실험에 사용된 다양한 방법(Standard, CoT, Act 등).

- HotPotQA (EM): 질문 응답 정확도를 측정하는 Exact Match (EM) 점수.

- Fever (Acc): 사실 검증 정확도를 측정하는 Accuracy (Acc) 점수.

- Supervised SoTA: 지도 학습 기반 최첨단 성능과 비교.

결과 분석

- HotPotQA:

- Standard: EM 28.7로 가장 낮은 성능.

- CoT (Chain-of-Thought): EM 29.4로 소폭 향상.

- CoT-SC: EM 33.4로 CoT보다 더 나은 성능.

- Act-Only: EM 25.7로 성능이 낮음.

- ReAct: EM 27.4로 Act-Only보다 나으나 CoT-SC보다 낮음.

- CoT-SC → ReAct: EM 34.2로 CoT-SC와 ReAct를 결합하여 성능 상승.

- ReAct → CoT-SC: EM 35.1로 최고 성능을 기록하며, ReAct와 CoT-SC의 결합이 가장 효과적임.

- Fever:

- Standard: Acc 57.1로 기본 성능.

- CoT: Acc 56.3로 Standard보다 약간 낮음.

- CoT-SC: Acc 60.4로 가장 높은 성능.

- Act-Only: Acc 58.9로 CoT보다 나음.

- ReAct: Acc 60.9로 CoT-SC를 초과하는 성능.

- CoT-SC → ReAct: Acc 64.6로 최고 성능을 기록.

- ReAct → CoT-SC: Acc 62.0로 높은 성능 유지.

핵심 결과

- HotPotQA:

- ReAct → CoT-SC(35.1)가 최고 성능을 기록.

- ReAct 자체는 CoT-SC보다 낮지만, 결합 시 성능 상승.

- Fever:

- CoT-SC → ReAct(64.6)가 최고 성능.

- ReAct는 단독으로도 CoT-SC보다 높은 성능을 보임.

Figure 2: CoT-SC 샘플 수에 따른 성능 변화

구조

- X축: CoT-SC 샘플 수.

- Y축: HotPotQA (좌) 및 Fever (우)에서의 성능(EM 또는 Accuracy).

- Method: ReAct, CoT, CoT-SC, ReAct → CoT-SC, CoT-SC → ReAct.

결과 분석

- HotPotQA (좌측 그래프):

- CoT-SC → ReAct:

- 샘플 수가 증가할수록 성능이 지속적으로 상승하며, EM 35를 초과.

- 가장 높은 성능을 기록.

- ReAct → CoT-SC:

- 초기부터 높은 성능을 보이며, EM 34 부근에서 유지.

- CoT-SC:

- 샘플 수가 증가함에 따라 성능이 점진적으로 향상.

- ReAct:

- CoT-SC 없이 단독 사용 시 성능이 낮음.

- CoT:

- 가장 낮은 성능을 보이며 큰 개선 없음.

- CoT-SC → ReAct:

- Fever (우측 그래프):

- CoT-SC → ReAct:

- 샘플 수가 증가함에 따라 성능이 지속적으로 향상하며, Acc 64.6로 최고 성능.

- ReAct → CoT-SC:

- 초기부터 높은 성능을 보이며, Acc 62 부근에서 유지.

- CoT-SC:

- 샘플 수 증가에 따라 성능이 향상.

- ReAct:

- 단독 사용 시 Acc 60 부근에서 정체.

- CoT:

- 성능이 낮고 샘플 수 증가에도 큰 변화 없음.

- CoT-SC → ReAct:

주요 해석

- CoT-SC와 ReAct 결합의 효과:

- CoT-SC와 ReAct를 결합한 방식(CoT-SC → ReAct, ReAct → CoT-SC)이 가장 높은 성능을 보임.

- CoT-SC → ReAct는 특히 샘플 수가 증가할수록 성능이 계속 개선됨.

- ReAct의 우수성:

- ReAct는 CoT, Act-Only보다 항상 높은 성능을 기록.

- 특히 Fever 데이터셋에서 ReAct 단독으로도 CoT-SC보다 우수.

- 샘플 수의 중요성:

- CoT-SC 샘플 수가 늘어날수록 ReAct와의 결합 방식의 성능이 크게 상승.

- 샘플 수 증가에 따라 성능이 Plateau(정체) 되는 다른 방법(CoT, CoT-SC)에 비해 개선 여지가 큼.

- 지도 학습과의 비교:

- ReAct 및 CoT-SC 기반 방식이 지도 학습(Supervised SoTA)에 비해 여전히 낮은 성능.

- 그러나 비지도 학습 기반으로는 높은 신뢰성을 입증.

결론

이 실험 결과는 ReAct와 CoT-SC의 결합이 HotPotQA 및 Fever와 같은 다양한 작업에서 강력한 성능을 발휘한다는 것을 보여줍니다. ReAct 자체도 CoT 및 Act-Only를 초과하는 성능을 보이며, 샘플 수를 최적화하면 더욱 효율적인 문제 해결이 가능함을 시사합니다.

1. ReAct Prompting 방식

- Few-Shot 학습:

- HotPotQA와 Fever 데이터셋에서, 각각 6개와 3개의 샘플을 훈련 데이터에서 무작위로 선택하여 ReAct 형식의 Trajectory(경로)를 작성.

- Trajectory는 추론(Thought), 행동(Action), 관찰(Observation)으로 구성된 단계적 과정.

- 예시(유추적 사고 포함):

- 질문 분해: "x를 검색하고, y를 찾은 뒤 z를 확인해야 한다."

- 정보 추출: "x는 1844년에 시작되었다", "문단에 x에 대한 정보가 없음."

- 상식적 추론: "x는 y가 아니므로 z가 대신 맞다."

- 산술적 추론: "1844 < 1989".

- 검색 재구성: "대신 x를 검색하면 더 나을지도 몰라."

- 최종 답변 도출: "...그러므로 답은 x이다."

- 이러한 Trajectory는 모델이 질문을 단계적으로 분석하고 해결할 수 있도록 도와줌.

2. 비교 및 베이스라인

ReAct 방식과 성능을 비교하기 위해 세 가지 베이스라인을 설정:

- Standard Prompting:

- 추론(Thought), 행동(Action), 관찰(Observation) 모두 제거.

- 단순 입력과 출력만 포함하는 방식.

- Chain-of-Thought Prompting (CoT):

- 행동과 관찰을 제거하고, 추론 과정만 포함.

- 논리적 구조를 구축하지만, 환각(hallucination)된 정보로 인해 오류 발생 가능.

- Acting-Only Prompting:

- 추론 과정 없이 행동(Action)과 관찰(Observation)만 사용.

- 검색 엔진이나 외부 데이터와 상호작용해 정보를 수집하는 방식(WebGPT 방식과 유사).

3. ReAct와 CoT-SC의 결합

- ReAct와 CoT-SC(Self-Consistency)의 장점을 결합하여 문제 해결 능력을 극대화.

- 두 방식 간 전환을 위한 휴리스틱(heuristics)을 설정:

- ReAct → CoT-SC:

- ReAct가 제한된 단계(HotPotQA: 7단계, Fever: 5단계) 내에 답을 찾지 못하면 CoT-SC로 전환.

- CoT-SC → ReAct:

- CoT-SC가 다수결로 신뢰할 수 있는 답변을 생성하지 못할 경우(다수 응답이 n/2 미만) ReAct로 전환.

- ReAct → CoT-SC:

4. Fine-tuning

- 문제점:

- 대규모로 추론 과정(Reasoning Traces)과 행동(Action)을 수동으로 주석(annotate)하는 것은 매우 어려움.

- 대안 방법:

- ReAct를 통해 자동 생성한 3,000개의 Trajectory 데이터를 사용하여 작은 모델(PaLM-8B, 62B)을 미세 조정(Fine-tuning).

- Fine-tuned 모델은 질문/주장에 따라 Trajectory(Thought, Action, Observation)를 생성할 수 있음.

- 효과:

- Fine-tuning을 통해 소규모 모델에서도 ReAct의 구조를 재현 가능.

5. 핵심 결과

- ReAct는 다음과 같은 특징을 가짐:

- 사실 기반 추론(Factual Reasoning): CoT보다 더 신뢰할 수 있는 추론 수행.

- 환각 감소: 행동(Action)과 관찰(Observation)을 포함하여 추론의 정확도 개선.

- 유연성: CoT-SC와 결합해 더 복잡한 문제 해결 가능.

정리된 흐름

- ReAct Prompting:

- 단계적 추론과 행동을 포함하여 작업 수행.

- Baseline 설정:

- Standard, CoT, Act 방식과 비교.

- ReAct와 CoT-SC 결합:

- ReAct와 CoT-SC 간 전환 메커니즘을 도입하여 유연한 문제 해결.

- Fine-tuning:

- ReAct로 생성된 Trajectory를 활용하여 소규모 모델을 효율적으로 학습.

ReAct는 단순한 Prompting 방식이 아닌, 추론과 행동을 결합하여 문제를 다각도로 해결하는 강력한 프레임워크입니다. 추가적으로 궁금한 점이 있다면 말씀해주세요!

1. ReAct와 Act 비교

- ReAct는 Act 방식보다 일관적으로 높은 성능을 보임(Table 1 참조).

- 이유: ReAct는 추론(Reasoning)을 활용하여 행동을 더 효과적으로 안내하며, 특히 최종 답변을 종합(Synthesizing Final Answer)하는 데 강점이 있음.

- Fine-tuning 실험에서도 ReAct의 추론 기록(Reasoning Traces)이 Act보다 더 정보에 기반한 행동을 유도함.

2. ReAct와 CoT 비교

- Fever 데이터셋:

- ReAct(60.9%)가 CoT(56.3%)를 초과.

- 이유: Fever의 SUPPORTS/REFUTES 주장 판단은 미세한 차이에 의존하기 때문에 정확한 정보 검색이 중요.

- HotPotQA 데이터셋:

- ReAct(27.4%)가 CoT(29.4%)에 약간 뒤처짐.

- 이유: CoT는 복잡한 추론 구조를 더 잘 구성하지만, ReAct는 정보 검색의 정확성과 신뢰성을 통해 문제 해결.

3. 성공 및 실패 유형 분석 (Table 2 기반)

- 분석 방법: ReAct와 CoT의 성공 및 실패 사례 각각 50개(총 200개)를 샘플링하여 수작업으로 레이블링.

- 주요 관찰점:

- 환각(Hallucination) 문제:

- CoT: 높은 거짓 긍정률(False Positive)(14%) 및 실패 사례(56%)가 환각에 기인.

- ReAct: 외부 지식(검색)을 활용하여 더 사실 기반으로 작동(거짓 긍정률 6%, 환각 없음).

- 추론 오류:

- ReAct: CoT보다 추론 오류율(Reasoning Error)이 높음(47% vs. 16%).

- 이유: ReAct는 행동, 관찰, 추론을 반복적으로 결합하면서 구조적 제약이 발생.

- 특정 오류 패턴: 모델이 이전 행동 및 추론을 반복적으로 생성하는 "루프 오류".

- 비정보성 검색(Non-Informative Search):

- ReAct의 실패 사례 중 23%는 비정보성 검색에서 발생.

- 이는 ReAct가 외부 검색의 질에 크게 의존함을 보여줌.

- 환각(Hallucination) 문제:

4. ReAct와 CoT-SC의 결합

- HotPotQA: ReAct → CoT-SC가 최적의 성능.

- Fever: CoT-SC → ReAct가 최적의 성능.

- 전환 메커니즘(Heuristics):

- ReAct → CoT-SC: ReAct가 제한된 단계 내에 답을 찾지 못하면 CoT-SC로 전환.

- CoT-SC → ReAct: CoT-SC가 다수결로 신뢰할 수 있는 답을 도출하지 못하면 ReAct로 전환.

- Figure 2 결과:

- ReAct와 CoT-SC의 결합 방식이 CoT-SC 단독보다 적은 샘플(3~5개)로도 유사한 성능을 달성.

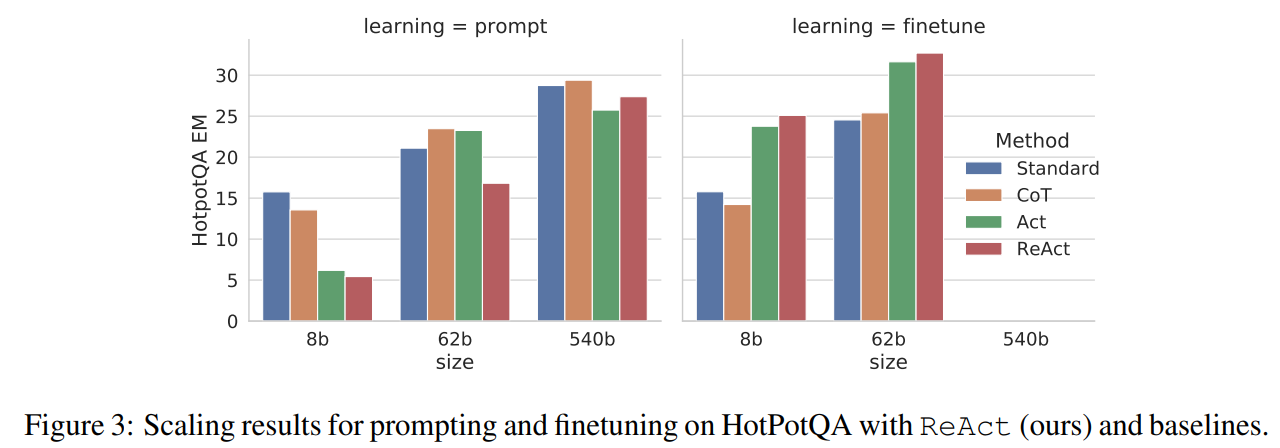

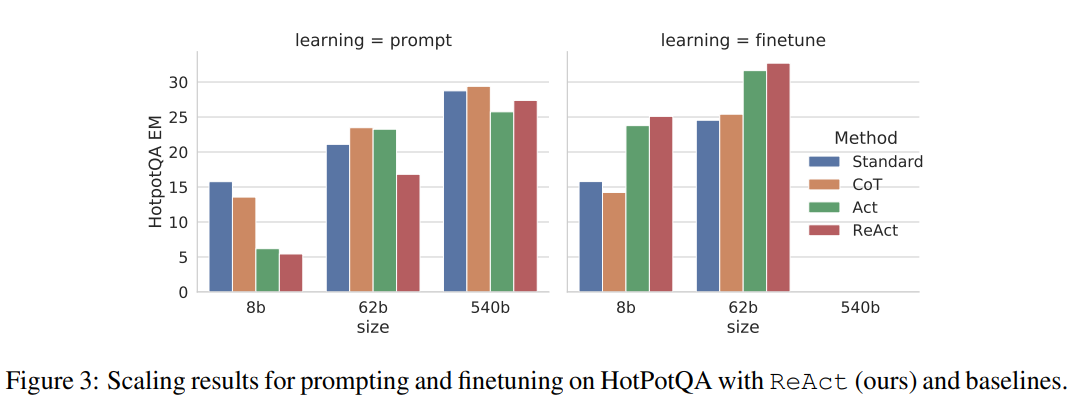

5. Fine-Tuning 결과 (Figure 3 기반)

- Prompting vs. Fine-tuning:

- Prompting에서 ReAct는 모든 방법 중 성능이 가장 낮음.

- Fine-tuning에서는 ReAct가 모든 방법을 초과.

- Fine-tuning 세부 성과:

- PaLM-8B Fine-tuning:

- Fine-tuned ReAct가 PaLM-62B Prompting을 초과.

- PaLM-62B Fine-tuning:

- Fine-tuned ReAct가 PaLM-540B Prompting을 초과.

- 이유: Fine-tuning은 ReAct의 추론-행동 통합 능력을 강화하며, 일반화 가능성을 높임.

- PaLM-8B Fine-tuning:

- Prompting 방식의 한계:

- Standard 및 CoT는 Fine-tuning에서 학습된 사실을 단순히 기억(환각 포함)하려는 경향.

- 반면, ReAct는 정보를 검색하고 행동하는 일반화 가능한 기술을 학습.

6. 주요 결론

- ReAct의 강점:

- 외부 지식을 활용해 더 사실 기반으로 작동.

- Fine-tuning 시 가장 강력한 성능을 발휘하며, Prompting 한계를 극복.

- CoT와의 차이:

- CoT는 복잡한 추론 구조를 구성하는 데 강점이 있지만, 환각에 취약.

- ReAct는 정보 검색과 행동을 결합해 신뢰성 있는 문제 해결 제공.

- 결합 전략의 효과:

- ReAct와 CoT-SC를 결합하면 더 높은 성능을 달성하며, 내부 지식과 외부 지식을 통합하는 방식의 가능성을 보여줌.

이 내용은 논문의 주요 실험 결과와 분석을 모두 포함하며, 추가적으로 궁금한 점이 있다면 알려주세요!

두 프롬프트(ReAct와 ReAct-IM)는 모두 ALFWorld의 clean task를 수행하기 위한 방식이지만, 행동(Action)과 추론(Reasoning)의 효율성 및 반복 구조에서 차이가 있습니다. 차이를 구체적으로 정리하면 아래와 같습니다.

1. 주요 차이점

| 특징 | ReAct | ReAct-IM |

| 추론 과정의 다양성 | - 다양한 사고(think)를 통해 구체적인 계획을 세우고, 작업을 단계별로 해결.- 추론이 상황에 따라 업데이트됨. | - 반복적으로 동일한 추론을 생성하며, 새로운 정보나 상황에 대한 업데이트가 부족. |

| 행동의 효율성 | - 목표에 따라 행동이 논리적으로 진행되며, 필요 없는 반복 없이 작업을 완료. | - 동일한 "생각(think)"을 여러 번 반복하면서 비효율적으로 행동 수행. |

| 작업 진행의 명확성 | - 각 단계에서 현재 상태를 요약하거나 다음 행동을 설명하여 진행 상황이 명확함. | - 매 단계마다 동일한 생각(예: "First I need to find a lettuce.")이 반복되어 명확성이 떨어짐. |

| 루프 오류 | - 행동이 반복되는 "루프"에 빠지지 않고 작업이 진행됨. | - 동일한 "생각"과 "행동"이 반복되는 루프 오류 발생 가능. |

| 추론과 행동의 결합 방식 | - 추론과 행동이 긴밀하게 결합되어 작업의 맥락을 지속적으로 반영. | - 추론이 독립적으로 반복되며 행동의 결과가 효과적으로 반영되지 않음. |

2. 구체적인 사례 비교

1단계: "상추 찾기"

- ReAct:

- 추론(think): "상추는 fridge, diningtable, sinkbasin 등에 있을 가능성이 높다. fridge부터 확인하자."

- 행동(go to fridge 1): fridge 1로 이동.

- 행동(open fridge 1): fridge 1을 열어 안을 확인.

- diningtable 1로 이동하여 상추를 발견.

- 효율적이고 논리적: fridge에서 상추를 찾지 못하면 diningtable로 이동하며, 단계별로 새로운 정보를 반영해 작업 진행.

- ReAct-IM:

- 추론(think): "First I need to find a lettuce."

- 행동(go to fridge 1): fridge 1로 이동.

- 추론(think): "First I need to find a lettuce."

- 행동(open fridge 1): fridge 1을 열어 확인.

- 추론(think): "First I need to find a lettuce."

- 비효율적이고 반복적: 동일한 추론("I need to find a lettuce.")을 반복하며 새로운 정보를 반영하지 못함.

2단계: "상추를 씻기"

- ReAct:

- 추론(think): "상추를 sinkbasin에서 씻어야 한다."

- 행동(go to sinkbasin 1): sinkbasin으로 이동.

- 행동(clean lettuce 1 with sinkbasin 1): 상추를 씻음.

- 효율적: 한 번의 추론으로 바로 행동 수행.

- ReAct-IM:

- 추론(think): "I need to clean this lettuce (1) using sinkbasin 1."

- 행동(go to sinkbasin 1): sinkbasin으로 이동.

- 추론(think): "I need to clean this lettuce (1) using sinkbasin 1."

- 행동(clean lettuce 1 with sinkbasin 1): 상추를 씻음.

- 비효율적: 동일한 추론을 반복적으로 생성.

3. ReAct의 강점

- 추론과 행동의 유기적 결합:

- 추론은 행동을 안내하며, 행동 결과를 바탕으로 새로운 추론을 생성.

- 각 단계가 새로운 정보를 반영하며 작업이 점진적으로 진행.

- 효율성:

- 동일한 목표를 이루는 데 ReAct는 최소한의 추론과 행동으로 작업을 수행.

- 불필요한 반복과 루프를 방지.

- 작업의 명확성:

- 각 행동과 추론은 구체적이고 논리적이며, 작업 진행 상태를 명확히 보여줌.

4. ReAct-IM의 단점

- 반복적 추론:

- 새로운 정보가 반영되지 않고 동일한 추론(think)을 계속 반복.

- 행동 결과를 바탕으로 작업 상태가 업데이트되지 않음.

- 루프 오류:

- 동일한 행동과 추론을 반복하면서 작업 진행이 지연될 가능성이 높음.

- 효율성 저하:

- 동일한 작업을 수행하는 데 ReAct보다 더 많은 추론과 행동 단계가 필요.

결론

- ReAct는 추론과 행동이 긴밀하게 결합되어 효율적이고 신뢰성 있는 작업 진행을 가능하게 합니다.

- 반면, ReAct-IM은 추론이 반복되며 행동 결과를 효과적으로 반영하지 못해 비효율적이고 불명확한 작업 진행으로 이어집니다.

- 따라서 ReAct는 복잡한 작업에서 더 신뢰할 수 있고, 효율적인 문제 해결 방식을 제공합니다.