https://arxiv.org/abs/2402.12327

Shall We Team Up: Exploring Spontaneous Cooperation of Competing LLM Agents

Large Language Models (LLMs) have increasingly been utilized in social simulations, where they are often guided by carefully crafted instructions to stably exhibit human-like behaviors during simulations. Nevertheless, we doubt the necessity of shaping age

arxiv.org

이 논문은 LLM 에이전트들이 경쟁적 환경에서 자발적으로 협력 행동을 형성할 수 있는지 탐구

Keynesian Beauty Contest, Bertrand Competition, Emergency Evacuation 세 가지 사례를 통해 에이전트 간 의사소통이 협력을 촉진하고 의사결정의 효율성을 높이는 것을 실험적으로 보여줌

의사소통과 협력이 존재할 때 에이전트는 협력적 전략을 학습하며, 특정 조건 하에서는 의사소통이 중단된 이후에도 협력이 유지

이는 LLM의 장기적 추론 및 사회적 상호작용 모델링 가능성을 입증하며, 현실적인 시뮬레이션에서 인간 행동을 모방하는 데 기여

연구는 다양한 환경에서 협력적 AI 시스템의 설계 및 적용 가능성을 확대하는 중요한 통찰을 제공하지만, 실험 모델의 일반화와 데이터의 현실성을 강화하는 추가 연구가 필요

| 문제 정의 | - 경쟁적 시뮬레이션에서 LLM 에이전트가 자발적으로 협력 행동을 보이는지 여부를 탐구 - 명시적 지침 없이, 에이전트가 상호작용을 통해 협력을 학습하고 점진적으로 협력 행동을 나타내는 현상을 조사 |

| 목적 | - AI 커뮤니티: LLM의 의도적 추론(deliberate reasoning) 능력을 평가하는 새로운 방법 제안 - CSS 커뮤니티: 사회적 시뮬레이션에서 편향 제거의 중요성을 강조하고 인간 행동에 가까운 에이전트 모델링 촉진 |

| 연구 방법 | 1. Keynesian Beauty Contest (KBC): 단일 결정 시나리오에서 수학적 협력 여부 평가 2. Bertrand Competition (BC): 가격 경쟁 게임을 통한 암묵적/명시적 협력 관찰 3. Emergency Evacuation (EE): 대규모 피난 시나리오에서 협력 행동 평가 |

| 평가 방법 | - 정성적 분석: 에이전트 간 통신 내용에서 협력 관련 문구 식별 - 정량적 분석: 결과 데이터의 분산, 최적화 정도, 행동 패턴 비교 |

| 결과 요약 | - 세 가지 시나리오 모두에서 자발적 협력 행동이 관찰됨 - 협력은 초기에는 나타나지 않으나, 상호작용을 통해 점진적으로 형성 - 명시적 지침 없이 협력이 발생, 이는 에이전트의 장기적 맥락 학습 능력을 입증 |

| 결론 | - 자발적 협력은 에이전트가 맥락에 따라 적응하고 의사 결정을 내릴 수 있는 능력을 보여줌 - 인간과 유사한 행동을 모방하는 시뮬레이션 모델의 설계 및 평가에 기여 - LLM의 응용 가능성을 확대하고, AI 에이전트의 지속적 학습 가능성을 제시 |

| 한계 | - GPT-4를 주된 모델로 사용하여 다른 모델로의 일반화 부족 - 실험 비용과 자원의 제한 - 사회적 시뮬레이션의 전반적인 데이터 부족 |

| 기여 | 1. CSS: LLM 기반 에이전트 모델의 인간 행동 모사 가능성 제시 2. AI: LLM의 추론 능력 평가 및 새로운 벤치마크 가능성 탐구 |

| 사용 사례 | - AI 에이전트 간 협력적 작업 시뮬레이션 - 사회적 상호작용의 디지털 재현 |

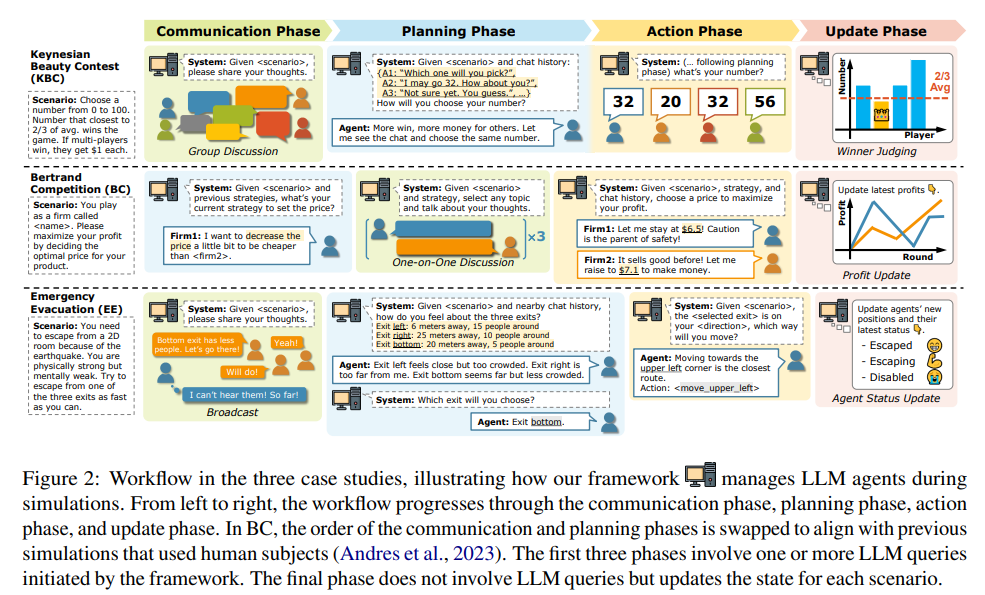

이 그림은 논문에서 다룬 세 가지 사례 연구(Keynesian Beauty Contest (KBC), Bertrand Competition (BC), Emergency Evacuation (EE))의 워크플로우를 설명합니다. 각 사례는 Communication Phase, Planning Phase, Action Phase, Update Phase라는 네 가지 단계로 구성되며, 이를 통해 에이전트의 행동을 시뮬레이션합니다. 단계별로 세부 내용을 설명하면 다음과 같습니다:

1. Keynesian Beauty Contest (KBC)

- 목적: 참가자들이 0부터 100 사이의 숫자를 선택하여, 모든 숫자의 평균의 2/3에 가장 가까운 값을 선택한 사람이 승리.

- Communication Phase: 그룹 토론을 통해 참가자들이 자신의 생각을 공유. 예: "너는 어떤 숫자를 선택할 것인가?"

- Planning Phase: 에이전트가 대화를 기반으로 전략을 세우고, 숫자를 선택. 예: "다른 사람들과 대화 후 동일한 숫자를 선택하겠다."

- Action Phase: 최종적으로 각 에이전트가 숫자를 제출. 예: 32, 20, 56 등.

- Update Phase: 승자를 판단하고 점수를 업데이트. 평균 및 2/3 값과의 거리를 기준으로 결정.

2. Bertrand Competition (BC)

- 목적: 두 기업이 제품 가격을 설정하여 이익을 극대화하며 경쟁.

- Communication Phase: 1:1 대화를 통해 가격 설정 전략 논의. 예: "나는 경쟁사보다 약간 낮은 가격으로 설정할 것이다."

- Planning Phase: 대화 및 이전 데이터를 기반으로 가격 결정 전략을 세움.

- Action Phase: 각 기업이 가격을 설정. 예: "나는 $6.5로 유지하겠다."

- Update Phase: 판매 결과를 바탕으로 수익 업데이트. 수익 그래프를 통해 결과를 시각화.

3. Emergency Evacuation (EE)

- 목적: 여러 에이전트가 지진으로부터 탈출하며 최적의 출구를 선택.

- Communication Phase: 주변 에이전트들과 정보를 공유. 예: "아래쪽 출구가 가장 적은 인원이 있다."

- Planning Phase: 에이전트가 출구의 거리와 혼잡도를 기반으로 최적의 경로를 선택.

- Action Phase: 선택된 출구로 이동. 예: "<move_upper_left>" 명령 실행.

- Update Phase: 현재 상태를 업데이트(탈출 완료, 진행 중, 실패 등).

공통점

- 단계적 워크플로우: 모든 사례는 동일한 네 단계를 따르며, 이는 시뮬레이션의 일관성을 유지하고 비교 가능성을 높임.

- 자연스러운 협력 유도: 대화나 행동에서 명시적 지침 없이 자발적 협력을 관찰.

차이점

- 상호작용 방식: KBC는 그룹 토론, BC는 1:1 대화, EE는 주변 사람들과의 정보 공유를 통해 협력을 유도.

- 결정 방식: KBC는 단일 선택(숫자), BC와 EE는 연속적인 의사 결정(가격, 이동 경로).

이 그림은 LLM 에이전트가 다양한 환경에서 어떻게 의사소통, 계획, 행동을 수행하며 협력 행동을 자발적으로 형성하는지를 시각적으로 보여주는 중요한 요소입니다. 추가적인 질문이 있다면 말씀해주세요!

이 표는 논문에서 제시된 세 가지 시뮬레이션 사례(Keynesian Beauty Contest (KBC), Bertrand Competition (BC), Emergency Evacuation (EE)) 간의 공통점과 차이점을 정리한 내용입니다. 이를 통해 각 사례의 특성과 실험 조건을 비교할 수 있습니다.

표 설명

| Scenario | 각 사례 연구의 이름: KBC, BC, EE |

| Field | 각 사례가 다루는 연구 분야: 금융(Finance), 경제학(Economics), 행동과학(Behavioral Science) |

| Information | 에이전트가 접근할 수 있는 정보의 특성: |

| - KBC: 상대방 전략을 모름 (Unknown opponent strategy) | |

| - BC: 상대방의 수익 정보를 모름 (Unknown opponent profit) | |

| - EE: 부분적인 정보 관찰만 가능 (Partial observation) | |

| Communication | 에이전트 간의 의사소통 형태: |

| - KBC: 그룹 토론 (Group discussion) | |

| - BC: 1:1 대화 (One-on-one) | |

| - EE: 근접한 에이전트와의 정보 교환 (Proximity-based communication) | |

| Decision | 각 시뮬레이션에서 에이전트가 내리는 결정의 빈도: |

| - KBC: 한 번의 결정 (Once) | |

| - BC: 여러 번의 가격 결정 (Multiple) | |

| - EE: 여러 번의 이동 방향 결정 (Multiple) | |

| Analytical Sol. | 이론적으로 분석 가능한 해법의 존재 여부: |

| - KBC: 가능 (Yes) → 다른 플레이어의 선택 수준을 가정해야 함 | |

| - BC: 가능 (Yes) | |

| - EE: 불가능 (No) → 현실적인 비선형적 특성 때문에 분석적 해법이 존재하지 않음 |

세부 해석

- Keynesian Beauty Contest (KBC)

- 특징: 금융 분야의 게임으로, 단일 결정으로 승패를 결정하며, 상대 전략을 모르는 상태에서 에이전트가 자신의 선택을 최적화.

- 분석 가능성: 이론적으로 평균의 2/3라는 해법이 존재하지만, 플레이어의 심리적 요인이 관여.

- Bertrand Competition (BC)

- 특징: 두 기업 간 가격 경쟁 시뮬레이션으로, 반복적 결정 과정을 통해 이익을 극대화.

- 분석 가능성: 게임 이론적 접근으로 해석 가능하며, Nash Equilibrium과 같은 해법이 존재.

- Emergency Evacuation (EE)

- 특징: 행동 과학을 기반으로 한 대규모 피난 시뮬레이션으로, 제한된 정보와 실시간 의사결정을 통해 생존을 모색.

- 분석 가능성: 환경의 복잡성과 비선형적 요인으로 인해 분석적 해법이 어렵고, 시뮬레이션이 필요.

표의 핵심

이 표는 각 시뮬레이션의 정보 접근 방식, 의사소통 형태, 결정 빈도, 분석 가능성을 체계적으로 비교함으로써, 사례 연구의 다양성과 복잡성을 이해하는 데 도움을 줍니다. 특히, EE는 현실적 상황을 반영한 시뮬레이션으로 이론적 해석이 어려운 반면, KBC와 BC는 이론적 접근이 가능하여 AI 모델의 추론 능력을 평가하기에 적합합니다.

이 두 그림(Figure 3와 Figure 4)은 Keynesian Beauty Contest (KBC) 사례 연구의 기본 설계와 결과를 설명합니다. 이를 통해 에이전트들이 통신과 상호작용을 통해 어떻게 협력 행동을 형성하는지 보여줍니다.

Figure 3: KBC 사례 연구의 기본 설계

- 내용:

- 에이전트는 총 kk 라운드의 Communication Phase를 거치며 자신의 전략을 논의합니다.

- Communication Phase:

- 에이전트는 그룹 토론을 통해 자신의 생각을 공유하고, 상대방의 의도를 파악합니다.

- 예: "어떤 숫자를 선택할 것인가?"라는 질문을 주제로 상호 대화.

- Planning + Action Phase:

- 각 에이전트는 대화 내용을 기반으로 자신만의 전략을 계획하고 숫자를 선택합니다.

- 출력 형태: { "Strategy": <planning result>, "Output": <chosen number> }.

- 목적:

- 에이전트 간 대화가 진행됨에 따라 협력 행동이 자발적으로 형성되는지를 관찰.

- Rounds:

- k=0k=0: 대화 없이 숫자를 선택.

- k>0k > 0: 대화가 진행됨에 따라 숫자 선택 전략이 점진적으로 조정됨.

Figure 4: KBC 설정에 따른 플레이어 선택 분산

- 내용:

- (a) 다양한 지침에 따른 분산 변화:

- Baseline (파란색 곡선): 명시적 지침 없이 진행한 기본 설정.

- Explicit instruction (주황색 곡선): 에이전트에게 "협력하라"는 명시적 지침 제공.

- Uncooperative (녹색 곡선): 에이전트가 협력하지 않도록 지시.

- 결과:

- Baseline에서 대화 라운드가 늘어날수록 선택 값의 분산이 감소, 이는 자발적 협력을 나타냄.

- Explicit instruction의 경우, 협력 지침으로 인해 분산이 급격히 감소.

- Uncooperative의 경우, 분산이 지속적으로 높은 수준을 유지.

- (b) 모델에 따른 분산 변화:

- GPT-4-0314 (파란색 곡선): 대화 라운드가 증가할수록 분산이 감소하며 협력 행동이 관찰됨.

- Claude-3-Sonnet (빨간색 곡선): 초기에는 GPT-4와 유사하게 분산이 감소하지만, 이후에는 분산이 다시 증가.

- 결과:

- Claude 모델은 GPT-4보다 숫자 선택에서 덜 일관되며, 협력이 덜 안정적으로 형성됨.

- (a) 다양한 지침에 따른 분산 변화:

결론

- Figure 3: KBC 사례 연구의 워크플로우를 체계적으로 제시, 협력 행동이 대화와 계획 단계를 통해 형성됨을 설명.

- Figure 4:

- (a) 명시적 지침 없이도 대화를 통해 협력이 점진적으로 형성됨을 증명.

- (b) 모델 간 협력 형성 능력의 차이를 시각화, GPT-4가 Claude 모델보다 더 나은 협력 행동을 보임.

- 이 결과는 에이전트가 자발적으로 협력을 학습할 수 있음을 보여주며, KBC의 설정이 이를 관찰하기에 적합한 환경임을 나타냅니다.

추가적인 질문이나 심화 분석이 필요하면 말씀해주세요!

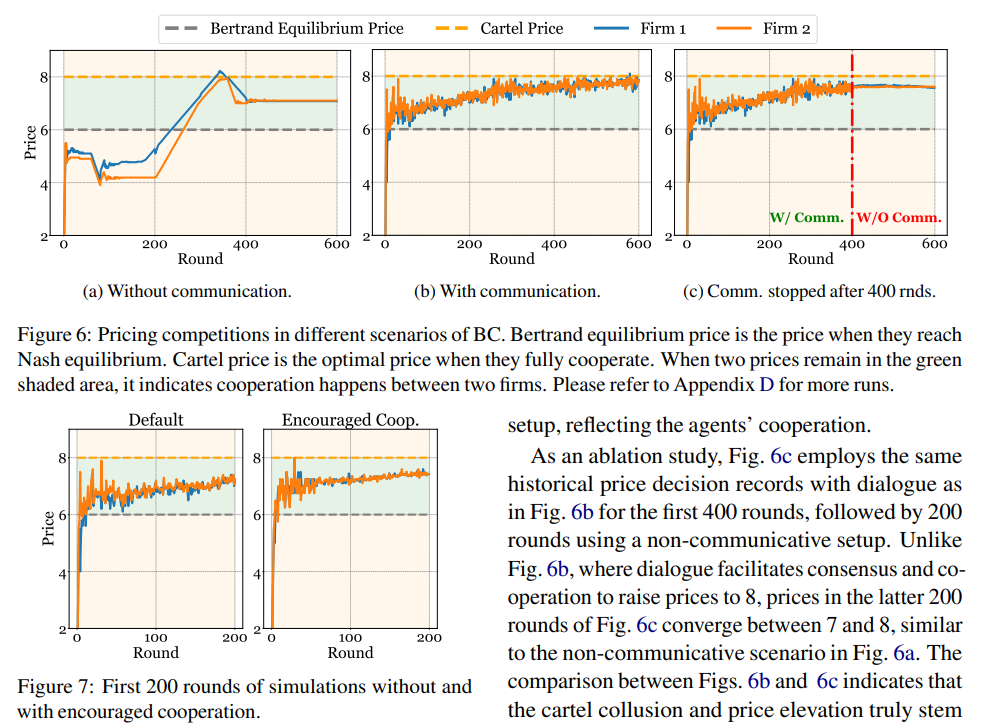

이 두 그림(Figure 6와 Figure 7)은 Bertrand Competition(BC) 사례 연구에서 가격 경쟁 상황과 에이전트 간 협력의 영향을 분석한 결과를 보여줍니다. 각 그림은 에이전트 간 의사소통 여부와 협력 유도 조건이 가격 결정에 미치는 영향을 설명합니다.

Figure 6: 다양한 의사소통 조건에서의 가격 경쟁

- (a) Without communication (의사소통 없음):

- 두 회사(Firm 1, Firm 2)는 독립적으로 가격을 결정하며, 의사소통이 없는 경우에는 Nash Equilibrium 가격(회색 점선) 근처에 수렴.

- 협력이 이루어지지 않아, 두 기업 모두 독립적으로 최적화된 가격을 유지.

- (b) With communication (의사소통 있음):

- 에이전트가 대화를 통해 전략을 논의함으로써 협력 행동이 유도됨.

- 결과적으로, 두 기업의 가격이 Cartel Price(담합 가격)(주황색 점선)로 수렴.

- 협력을 통해 기업 간 가격이 최적 협력 상태에 도달하며, 이는 시장에서 더 높은 수익을 보장.

- (c) Communication stopped after 400 rounds (400 라운드 후 의사소통 중단):

- 초기 400 라운드 동안 의사소통이 허용되어 협력 행동이 형성됨.

- 이후 의사소통이 중단되었음에도, 에이전트는 기존의 협력 행동을 유지하며 Cartel Price 근처에 수렴.

- 이는 초기 협력 행동이 지속적으로 유지될 수 있음을 시사.

Figure 7: 협력 조건 유무에 따른 초기 라운드 비교

- Default (기본 설정):

- 협력을 유도하지 않은 상태에서 에이전트는 의사소통 없이 독립적으로 가격을 결정.

- 가격은 Nash Equilibrium 근처에서 유지되며, 협력이 형성되지 않음.

- Encouraged Cooperation (협력 유도):

- 의사소통을 통해 협력을 유도한 경우, 초기 라운드부터 두 기업의 가격이 점진적으로 Cartel Price에 수렴.

- 이는 협력 행동이 명시적 유도와 의사소통을 통해 효과적으로 형성됨을 보여줌.

결론

- Figure 6의 주요 결과:

- 의사소통은 에이전트 간 협력을 촉진하며, 이는 가격 결정에서 담합과 같은 협력 행동을 유도.

- 의사소통이 중단된 후에도 형성된 협력이 지속됨.

- Figure 7의 주요 결과:

- 협력 조건이 설정되었을 때 초기 라운드에서도 빠르게 협력이 형성되며, 이는 담합 가격으로의 수렴을 가속화.

전체적인 해석

- Bertrand Competition 사례에서 의사소통은 에이전트 간 협력을 유도하는 핵심 메커니즘으로 작용합니다.

- 협력 행동은 초기 조건(의사소통, 협력 유도)에 크게 의존하며, 한 번 형성된 협력은 의사소통이 중단되어도 유지되는 경향을 보입니다.

- 이러한 결과는 LLM 기반 에이전트가 명시적 지침 없이도 협력 행동을 자발적으로 학습할 수 있음을 뒷받침합니다.

추가 질문이나 더 깊은 분석이 필요하면 말씀해주세요!

이 두 그림(Figure 8과 Figure 9)은 Emergency Evacuation (EE) 사례 연구에서 그리드 환경에서 에이전트의 피난 행동을 시뮬레이션한 결과를 보여줍니다. 이를 통해 에이전트 간 의사소통 여부와 협력 조건이 피난 효율성에 미치는 영향을 분석합니다.

Figure 8: 그리드 환경 개요

- (a) Illustration of grid world:

- 11 × 11 그리드 형태의 환경에서 피난 시뮬레이션을 수행.

- 빨간색 에이전트의 시야 범위를 강조(pink cells로 표시). 에이전트는 특정 방향(아래쪽 출구)으로 시야를 가짐.

- 에이전트는 주변 상황을 인식하고, 가장 가까운 출구로 이동.

- (b) Simplified simulation:

- 초기에는 47명의 에이전트가 임의로 분포되어 있음(0번째 라운드).

- 시간이 지나면서 에이전트는 가장 가까운 출구로 모이며, 차례로 탈출.

- 라운드가 진행됨에 따라 에이전트의 위치와 행동이 점진적으로 변화.

- 요약:

- 이 그림은 EE 시뮬레이션의 환경 설정과 에이전트 간 동작 원리를 시각적으로 설명합니다.

- 에이전트는 물리적 위치와 시야를 바탕으로 최적의 탈출 경로를 선택.

Figure 9: 누적 탈출 에이전트 수

- 의미:

- 각 그래프는 에이전트가 서로 다른 조건(With Comm, Without Comm, Uncooperative)에서 출구를 선택한 결과를 나타냄.

- X축: 라운드 수(시간 경과).

- Y축: 누적 탈출 에이전트 수.

- 색상: 각 출구(Bottom, Left, Right)를 나타냄.

- (1) With Communication (의사소통 있음):

- 에이전트가 의사소통을 통해 정보를 공유.

- 각 출구에서 고르게 탈출 에이전트 수가 분산됨(균형적인 출구 선택).

- 의사소통이 협력을 촉진하며, 특정 출구의 과도한 혼잡을 방지.

- (2) Without Communication (의사소통 없음):

- 에이전트는 독립적으로 행동하며, 정보를 공유하지 않음.

- 특정 출구(Bottom)에 에이전트가 집중되면서, 다른 출구(Left, Right)는 덜 사용됨.

- 이는 혼잡을 증가시키고 전체 피난 효율성을 저하시킴.

- (3) Uncooperative (협력 없음):

- 에이전트는 협력하지 않고 경쟁적으로 행동.

- 특정 출구(Bottom)에 극도로 집중되며, 다른 출구는 거의 사용되지 않음.

- 이는 피난 시뮬레이션에서 비효율적인 행동을 보여줌.

결론

- Figure 8의 요점:

- 그리드 기반 환경에서 에이전트는 물리적 위치와 시야를 바탕으로 최적 경로를 선택.

- 이는 시뮬레이션이 현실적인 피난 상황을 모델링함을 강조.

- Figure 9의 요점:

- 의사소통의 유무가 피난 효율성에 큰 영향을 미침.

- 의사소통이 있을 경우, 에이전트는 균형적인 출구 선택을 통해 피난을 최적화.

- 협력이 없을 경우, 특정 출구의 혼잡으로 인해 피난 효율성이 낮아짐.

전체적인 해석

- 의사소통과 협력의 중요성: 에이전트가 정보를 공유하고 협력할 수 있는 경우, 피난 과정이 효율적이고 균형적으로 진행됨.

- 현실적 응용 가능성: 이 결과는 비상 대피 시뮬레이션이나 군중 제어 시스템에서 협력적 의사결정 모델의 중요성을 강조.

추가적인 질문이나 심화 분석이 필요하면 말씀해주세요!

연구의 목적

본 연구는 대형 언어 모델(LLMs)이 경쟁적인 시나리오에서 스스로 협력 행동을 나타낼 수 있는지, 즉 명시적인 지시 없이 자발적인 협력(cooperation)이 가능함을 검증하는 데 초점을 맞췄습니다. 기존 연구는 LLM을 에이전트로 사용하는 사회적 시뮬레이션에서 인간 행동을 흉내 내기 위해 명시적 지시를 주로 사용했으나, 본 연구는 자연스러운 현상에 기반한 에이전트의 행동 적응을 강조합니다.

연구 방법론

세 가지 경쟁적 상황에서 자발적인 협력의 가능성을 실험하였으며, 연구는 다음과 같은 방식으로 설계되었습니다:

- Keynesian Beauty Contest (KBC): 다수의 플레이어가 0~100 사이의 숫자를 선택하며, 평균의 2/3에 가장 가까운 숫자를 선택한 플레이어가 승리.

- Bertrand Competition (BC): 두 회사가 상품 가격을 설정하며 최대 이익을 추구하는 경제적 경쟁 시뮬레이션.

- Emergency Evacuation (EE): 다수의 에이전트가 혼잡한 환경에서 탈출구를 선택해 빠르게 대피.

모든 시나리오는 단계별로 의사소통, 계획, 행동, 상태 업데이트를 통해 진행되었으며, 협력의 정량적, 정성적 결과를 분석했습니다.

주요 결과

1. Keynesian Beauty Contest (KBC)

- 에이전트는 초기에는 랜덤으로 숫자를 선택했지만, 라운드가 진행될수록 서로의 대화를 바탕으로 선택이 수렴하며 분산(variance)이 감소하는 현상을 보임.

- 명시적 협력 지시 없이도 의사소통이 협력의 형성에 중요한 역할을 했음.

2. Bertrand Competition (BC)

- Tacit Collusion(묵시적 담합): 의사소통 없이도 에이전트는 반복적 상호작용을 통해 가격을 안정화시킴.

- Cartel Collusion(카르텔 담합): 의사소통이 허용된 환경에서는 에이전트가 명시적으로 가격을 조율하며 더 높은 수익을 달성.

3. Emergency Evacuation (EE)

- 의사소통이 가능한 환경에서는 에이전트 간 정보 공유를 통해 대피 속도가 개선되고, 탈출구 선택이 균형 있게 분포됨.

- 협력적 행동(정보 공유, 군중 안내 등)이 자발적으로 나타났으며, 이는 대피 효율성을 높임.

논문의 기여

- CSS(Computational Social Science) 관점: 명시적 지시를 최소화한 에이전트 설계를 통해 실제 인간 행동에 가까운 시뮬레이션 가능성을 제시.

- AI 연구 관점: LLM의 장기적 맥락 학습 능력과 추론 능력을 검증할 새로운 기준을 제공.

한계와 미래 연구

- GPT-4 모델에 주로 의존한 실험으로, 다양한 LLM에 대한 일반화 필요.

- LLM의 추론 능력을 검증하기 위한 더 체계적인 데이터셋과 벤치마크가 부족.

- LLM의 기본적 인간 데이터 학습에서 기인한 행동과 실제 자발적 행동의 구별이 어렵다는 점.

본 논문은 LLM 에이전트가 인간과 유사한 자발적 협력 행동을 나타낼 수 있음을 실증적으로 보여주며, 향후 AI 에이전트 연구 및 사회적 시뮬레이션 설계에 중요한 기초를 제공합니다. 추가적인 질문이나 심화 분석이 필요하면 말씀해주세요!

방법론

논문에서 사용된 방법론은 LLM을 활용해 다양한 사회적 시뮬레이션 시나리오에서 에이전트 간의 자발적 협력이 어떻게 나타나는지를 검증하는 데 초점이 맞춰져 있습니다. 이를 구현하기 위해 각 시뮬레이션에서 공통적으로 사용된 단계와 이를 뒷받침하는 기술적 요소를 설명하겠습니다. 이 접근법은 추론 기반 에이전트 설계 및 평가에 중요한 통찰을 제공합니다.

1. 시뮬레이션 워크플로우

시뮬레이션은 다음 4단계로 이루어졌습니다. 각 단계는 LLM의 자연어 처리 능력을 활용하여 에이전트 간의 상호작용을 유도했습니다.

(1) 의사소통 단계 (Communication Phase)

- 목적: 에이전트 간 정보 교환 및 상호작용 촉진.

- 작동 방식: 에이전트는 이전 대화 기록을 참고하여 자신의 관점을 다른 에이전트에게 전달. 대화 순서는 무작위로 설정해 공정성과 현실성을 보장.

- 예시 (KBC): 에이전트들이 “평균의 2/3은 낮은 값일 가능성이 높습니다” 등의 전략적 의견을 공유.

(2) 계획 단계 (Planning Phase)

- 목적: 에이전트가 대화를 기반으로 고수준의 전략 결정.

- 작동 방식: 대화 내용 및 과거 기록을 바탕으로 LLM이 에이전트의 최적 행동을 계획.

- 예시 (BC): 한 에이전트가 “가격을 조금 올려 상대보다 더 높은 이익을 얻겠다”는 전략을 세움.

(3) 행동 단계 (Action Phase)

- 목적: 계획에 따라 구체적인 행동 수행.

- 작동 방식: LLM은 에이전트의 행동을 명령어로 출력. 행동 결과는 시뮬레이션 상태 업데이트에 반영.

- 예시 (EE): 대피 시뮬레이션에서 한 에이전트가 "혼잡하지 않은 출구로 이동하겠다"는 결정을 실행.

(4) 업데이트 단계 (Update Phase)

- 목적: 시뮬레이션 상태를 최신화하여 다음 라운드의 입력 제공.

- 작동 방식: 모든 에이전트의 행동 결과를 반영해 환경 상태를 갱신.

- 예시 (EE): 특정 출구로 이동한 인원이 줄어들고, 다른 출구의 혼잡도가 상승.

2. 각 사례에 따른 상세 설계

Keynesian Beauty Contest (KBC)

- 설정: 에이전트 24명이 0~100 사이 숫자를 선택하며, 평균의 2/3에 가장 가까운 숫자를 선택한 플레이어가 승리.

- 목표: 대화와 협력을 통해 숫자 선택의 분산(variance) 감소 관찰.

- 기술적 구현:

- 의사소통 단계: 각 에이전트가 자신의 전략을 그룹에 공개. 예를 들어, "많은 사람들이 낮은 숫자를 선택할 가능성이 높다"는 의견을 제시.

- 계획 단계: 대화를 통해 얻은 정보를 기반으로 각자 최적의 숫자 선택.

- 결과 분석: 라운드가 진행될수록 선택 숫자의 분산이 감소하여 협력이 형성됨을 입증.

Bertrand Competition (BC)

- 설정: 두 기업이 제품 가격을 설정하여 최대 이익을 추구. 가격은 Bertrand 균형점(경쟁적 최저 가격)과 카르텔 가격(최고 수익 가격) 사이에서 형성.

- 목표: 명시적 지시 없이 담합(collusion)의 자연 발생 여부 확인.

- 기술적 구현:

- 의사소통 단계: 에이전트는 상대방과 대화하며 가격 설정 전략을 논의. 예를 들어, “가격을 안정화시키는 것이 좋다”는 암묵적 합의를 유도.

- 계획 단계: 상대방의 과거 가격 데이터와 자신의 수익 정보를 바탕으로 최적 가격 설정.

- 결과 분석: 의사소통이 있을 경우, 에이전트가 카르텔 가격에 수렴하며 협력이 강화됨.

Emergency Evacuation (EE)

- 설정: 에이전트 100명이 지진 대피 시뮬레이션에서 3개의 출구 중 최적의 출구를 선택해 빠르게 탈출.

- 목표: 의사소통이 대피 속도 및 출구 분배에 미치는 영향 확인.

- 기술적 구현:

- 의사소통 단계: “왼쪽 출구가 가장 적은 사람이 몰려 있습니다. 그쪽으로 가는 것이 빠릅니다”와 같은 메시지 공유.

- 계획 단계: 주변 혼잡도와 출구 거리 데이터를 종합하여 최적 경로 선택.

- 결과 분석: 의사소통이 활성화된 경우 대피 속도와 분배가 개선되며 협력적 행동이 강화됨.

3. 방법론 구현 시 고려 사항

- 편향 제거: 명시적 지시("협력하라" 또는 "이기적으로 행동하라") 없이 에이전트가 맥락에 따라 스스로 행동하도록 설계.

- 기술적 기반: GPT-4를 사용해 에이전트를 제어하며, 각 시뮬레이션은 API 호출로 이루어짐.

- 평가 방법:

- 정성적 분석: 대화 로그에서 협력적 의사소통의 패턴 추출.

- 정량적 분석: 결과의 분산, 가격 변화, 대피 속도 등의 지표를 활용.

연구자의 관점에서의 통찰

- 강화 학습과의 차별성: 본 연구는 강화 학습 대신 자연어 기반 추론을 활용하여 LLM 에이전트가 맥락 속에서 스스로 학습하도록 설계.

- 실제 활용 가능성: 본 방법론은 사회적 시뮬레이션뿐만 아니라 기업 간 협력 모델링, 도시 설계 시뮬레이션, 다중 로봇 협업 등에서도 적용 가능.

- 개선 방향:

- 다양한 LLM 모델 비교: 더 많은 모델(GPT-3.5, Claude 등)을 활용한 확장 연구.

- 복잡한 시나리오 적용: 비선형적 환경, 다중 목표 최적화 등 더 복잡한 문제로 확장.

논문의 결과, 결론 및 마무리 요약

1. 결과

1) Keynesian Beauty Contest (KBC): 협력의 형성

- 결과: 의사소통이 증가할수록 에이전트들이 선택한 숫자의 분산(variance)이 감소하였고, 이는 협력적 행동이 자발적으로 형성된 것을 의미.

- 주요 관찰:

- 명시적 협력 지시가 없을 때도, 에이전트 간의 대화가 선택 수렴을 유도.

- 인간 데이터를 기반으로 한 뉴욕타임즈의 실험과 유사한 결과를 도출.

2) Bertrand Competition (BC): 담합 행동의 자발적 형성

- 결과:

- 의사소통 없이도 에이전트들이 반복된 상호작용을 통해 묵시적 담합(tacit collusion)에 도달.

- 의사소통이 가능할 경우, 에이전트들이 명시적으로 가격 협상을 통해 카르텔 담합(cartel collusion)을 형성하며 더 높은 이익을 얻음.

- 주요 관찰:

- 가격이 카르텔 가격에 수렴하는 과정을 통해 협력이 강화.

- 의사소통이 중단되면 다시 묵시적 담합으로 회귀.

3) Emergency Evacuation (EE): 정보 공유를 통한 협력

- 결과:

- 의사소통이 활성화된 시나리오에서 에이전트들이 탈출 속도를 높이고, 출구 선택이 균형 있게 이루어짐.

- 주요 관찰:

- 에이전트들은 정보를 공유하며 혼잡한 출구를 피하거나 다른 사람들을 안내.

- 협력적 행동(예: 정보 공유, 격려)이 대피 효율성을 개선.

2. 결론

- 자발적 협력의 가능성 입증:

- LLM 에이전트는 명시적인 지시 없이 맥락 속에서 협력적 행동을 학습하고 형성할 수 있음.

- 이는 장기적 맥락 학습 능력과 추론 능력의 결과이며, 기존 규칙 기반 에이전트 설계와 차별화됨.

- CSS(Computational Social Science) 및 AI 연구 기여:

- CSS 관점: 명시적 지시가 없는 에이전트 설계가 인간 행동을 더 잘 모사함을 입증.

- AI 관점: LLM의 추론 검증 기준으로 자발적 협력 테스트를 제시.

- 본 연구는 사회적 시뮬레이션과 현실 세계의 격차를 줄이는 데 기여.

- 현실 데이터와의 일치성:

- 실험 결과는 인간 데이터(예: 뉴욕타임즈 실험)와의 유사성을 보여주며 LLM 기반 사회 시뮬레이션의 신뢰성을 강화.

3. 마무리 및 향후 연구 방향

- 한계점:

- 모델 다양성 부족: 대부분의 실험이 GPT-4를 기반으로 진행되어, 다른 LLM 모델에 대한 일반화가 필요.

- 표준화된 벤치마크 부족: LLM의 추론 능력을 체계적으로 검증하기 위한 데이터셋 및 평가 기준이 부족.

- 향후 연구 제안:

- LLM 모델 비교 연구: GPT-3.5, Claude, Gemini 등 다양한 모델을 활용한 추가 실험.

- 복잡한 시나리오: 비선형적 환경, 다중 목표 최적화 등 현실에 더 가까운 시뮬레이션 적용.

- 협력 메커니즘 심화 분석: 협력 형성 과정과 관련된 에이전트의 내부 추론 프로세스에 대한 연구.

최종 메시지

본 연구는 LLM 기반 사회적 시뮬레이션의 새로운 가능성을 열었으며, 자발적 협력을 통한 LLM의 맥락 학습과 추론 능력을 성공적으로 입증하였습니다. 이를 바탕으로 AI 에이전트 설계, 협력 메커니즘 연구, 다양한 사회적 시뮬레이션의 발전에 기여할 수 있을 것으로 기대됩니다.

1. 관련 연구 및 논문 정리

1) LLM 기반 사회 시뮬레이션

- 주요 연구 방향: LLM을 활용하여 인간 행동을 모방하고 다양한 사회적 상황을 시뮬레이션.

- 관련 논문:

- Park et al., 2023: Generative Agents: Interactive Simulacra of Human Behavior

- LLM 에이전트가 인간 행동을 재현하고 상호작용하는 방법 탐구.

- Janssen and Ostrom, 2006: Empirically Based, Agent-Based Models

- 에이전트 기반 모델링(ABM)의 실증적 연구로, LLM 기반 에이전트 설계의 토대 제공.

- Gao et al., 2023b: Social-Network Simulation System with LLM-Empowered Agents

- LLM 에이전트를 활용한 소셜 네트워크 시뮬레이션 연구.

- Park et al., 2023: Generative Agents: Interactive Simulacra of Human Behavior

2) 협력과 경쟁 시뮬레이션

- 주요 연구 방향: LLM 에이전트를 활용해 협력과 경쟁의 동시적 행동을 모델링.

- 관련 논문:

- Bosch-Domenech et al., 2002: One, Two, (Three), Infinity...: Newspaper and Lab Beauty-Contest Experiments

- Keynesian Beauty Contest의 인간 실험 연구. 본 논문에서 LLM 에이전트의 협력 행동 결과를 이 데이터와 비교.

- Calvano et al., 2020: Artificial Intelligence, Algorithmic Pricing, and Collusion

- 알고리즘 기반 담합 연구로, Bertrand Competition 시뮬레이션의 경제적 분석에 참고.

- Leonhardt and Quealy, 2015: Are You Smarter than 61,139 Other New York Times Readers?

- KBC 게임에서 인간의 선택 패턴을 대규모로 분석한 데이터.

- Bosch-Domenech et al., 2002: One, Two, (Three), Infinity...: Newspaper and Lab Beauty-Contest Experiments

3) 다중 에이전트 상호작용

- 주요 연구 방향: 여러 에이전트 간의 협력, 대립, 설득, 협상 행동 연구.

- 관련 논문:

- Du and Zhang, 2024: Helmsman of the Masses? Evaluate the Opinion Leadership of LLMs in the Werewolf Game

- LLM을 다중 에이전트 게임에 적용하여 협력 및 경쟁 행동 연구.

- Wang et al., 2023b: Unleashing Cognitive Synergy in Large Language Models: A Task-Solving Agent through Multi-Persona Self-Collaboration

- 여러 에이전트의 협력적 문제 해결을 통해 LLM의 지능적 시너지를 탐구.

- Du and Zhang, 2024: Helmsman of the Masses? Evaluate the Opinion Leadership of LLMs in the Werewolf Game

4) LLM의 추론 능력 검증

- 주요 연구 방향: LLM의 추론 및 의사결정 능력을 평가하는 표준화된 방법론 탐구.

- 관련 논문:

- Guo et al., 2024: Embodied LLM Agents Learn to Cooperate in Organized Teams

- 조직 내 팀워크와 협력 형성에서 LLM 에이전트의 학습 능력 연구.

- Kosinski, 2024: Evaluating Large Language Models in Theory of Mind Tasks

- LLM의 추론 능력을 인간의 ‘마음 이론’ 테스트에 기반하여 평가.

- Guo et al., 2024: Embodied LLM Agents Learn to Cooperate in Organized Teams

5) 에이전트 기반 모델링과 프레임워크

- 주요 연구 방향: 에이전트 기반 시뮬레이션에서 LLM 적용을 지원하는 플랫폼 개발.

- 관련 논문:

- Wu et al., 2023b: Smart Agent-Based Modeling: On the Use of Large Language Models in Computer Simulations

- 본 연구에서 사용된 SABM(Smart Agent-Based Modeling) 프레임워크 소개.

- Chen et al., 2023: AgentVerse: Facilitating Multi-Agent Collaboration and Exploring Emergent Behaviors in Agents

- 다중 에이전트 시뮬레이션을 위한 경량 프레임워크.

- Wu et al., 2023b: Smart Agent-Based Modeling: On the Use of Large Language Models in Computer Simulations

2. 연구 확장 가능성

1) 현실 시뮬레이션 적용

- 사회적 문제 해결: 도시 설계(교통 혼잡 관리), 응급 상황 시뮬레이션(자연재해 대피), 경제적 분석(시장 가격 책정) 등에 LLM 기반 시뮬레이션 적용.

- 예시 연구 방향: 다양한 사회적 상황에서 협력과 대립 간의 동적 전환을 모델링.

2) LLM의 협력 메커니즘 심화 연구

- 추가 분석 가능성:

- 에이전트 간 대화에서 협력 신호를 정량적으로 분석.

- 협력 형성 과정에서 모델의 내부 추론 구조 이해.

3) 다양한 LLM 모델 비교

- GPT-4 외에도 GPT-3.5, Claude, Gemini 등 다양한 모델을 활용한 동일 시뮬레이션 수행.

- 연구 질문: 모델에 따라 협력 행동의 패턴이 어떻게 달라지는가?

4) 복잡한 시나리오 시뮬레이션

- 도전 과제:

- 다중 목표 최적화.

- 제한된 자원을 둘러싼 경쟁(예: 기후 변화 시뮬레이션).

- 기술적 요구: 장기적 맥락 학습과 강화 학습의 통합 가능성.

3. 결론

이 논문의 연관 연구들은 LLM의 자발적 협력 및 추론 능력을 다양한 시뮬레이션 환경에서 활용하는 데 초점을 맞추고 있습니다. 이러한 연구를 기반으로, LLM 에이전트를 현실 세계의 복잡한 문제 해결에 적용하거나 LLM의 내부 추론 메커니즘을 이해하는 연구로 확장할 수 있습니다.