https://arxiv.org/abs/2208.07004?utm_source=chatgpt.com

AI for Global Climate Cooperation: Modeling Global Climate Negotiations, Agreements, and Long-Term Cooperation in RICE-N

Comprehensive global cooperation is essential to limit global temperature increases while continuing economic development, e.g., reducing severe inequality or achieving long-term economic growth. Achieving long-term cooperation on climate change mitigation

arxiv.org

음

이 모델은 LLM이 아니라 연속적인 공간에서의 강화학습이었습니다...

따란~

협상이 있어야 생산율도 올라가고, 지구 온난화도 막는다는 논문이었습니다...

이 논문에서의 Agent = Reinforcement Multi-Agent 입니다. AI Agent가 아닙니다..

논문에서 다루고 있는 내용을 체계적으로 정리하겠습니다.

1. 해결하려는 문제

- 기후 변화와 협력 문제: 글로벌 기후 협력은 온실가스 감축과 경제 성장 사이의 균형을 맞추는 복잡한 게임 이론적 문제로, 각 지역(에이전트)이 자신의 이익을 추구하면서 협력하지 않으면 공공재의 비극이 발생할 수 있음.

- 문제의 특징:

- 기후 협정에는 강제적 집행 권한이 없음.

- 각 에이전트는 상이한 사회적, 경제적 목표를 가짐.

- 장기적 협력 유도와 불확실성 하의 정책 효과 예측이 어려움.

2. 사용한 방법

- RICE-N 모델:

- 기존 RICE(Regional Integrated Climate-Economy) 모델을 확장하여 국제 무역, 관세, 협상 프로토콜 등을 포함.

- 여러 지역 간 상호작용(경제, 기후, 협상)을 시뮬레이션.

- 다중 에이전트 강화학습(MARL):

- 각 지역(에이전트)은 강화학습을 통해 행동 정책을 학습.

- 에이전트 간 협력, 경쟁, 교섭 과정을 학습하여 최적의 행동 전략 도출.

- 협상 프로토콜:

- 다양한 협상 방식(단일, 양자, 다자 협상)을 모의 실험.

- 협상이 에이전트 행동 및 글로벌 경제/기후 지표에 미치는 영향을 분석.

- 강화학습 알고리즘:

- PPO와 A2C를 사용하여 에이전트 정책 최적화.

- 정책은 에이전트의 지역적 특징(인구, 기술 수준, 자본 등)과 글로벌 상태를 입력으로 받아 행동 결정.

3. 결과

- 기본 시뮬레이션 결과:

- 협상이 없을 경우, 글로벌 온도 상승과 경제적 손실이 극대화됨.

- 협상이 있을 경우, 온도 상승이 억제되고 경제적 생산성과 소비가 개선됨.

- 효과적인 협상 프로토콜:

- 양자 협상 프로토콜로도 온도 상승을 줄이는 데 효과적.

- 다자 협상(Climate Club)을 통해 강력한 감축 효과와 협력 동기 부여 가능.

- Pareto Frontier:

- 경제 성장과 기후 변화 억제 간의 최적 트레이드오프 점을 설정.

- 다양한 협상 시나리오를 통해 Pareto Frontier의 범위를 측정.

4. 한계점

- 단순화된 모델링:

- 현실 세계의 복잡한 기후 및 경제적 요소를 완벽히 반영하지 못함.

- 지역별 세부적 특성을 간과하거나 단순화.

- 현실 적용성 부족:

- 시뮬레이션과 현실 간의 격차(예: 정책 실행력, 외부 요인) 존재.

- 협상 실패 또는 부정적 행동(합의 불이행 등)의 예측 한계.

- 계산 자원 문제:

- 시뮬레이션 및 강화학습에 필요한 컴퓨팅 자원이 상당함.

- 이는 탄소 배출 증가로 이어질 가능성 있음.

5. 논문의 타당성과 아쉬운 점

- 타당성:

- 기후 협력을 위한 AI 기반 접근법의 가능성을 보여줌.

- 강화학습과 게임 이론을 결합한 시뮬레이션으로 현실적인 통찰 제공.

- 다자간 협상 및 국제적 합의의 전략적 결과를 예측할 수 있는 유용한 도구.

- 아쉬운 점:

- 복잡한 사회적, 정치적 요인(예: 국가 간 불평등, 정책 변화 등)이 충분히 반영되지 않음.

- 협상 프로토콜의 다양성을 더 확대하거나, 더욱 정교한 경제적, 환경적 모델을 구축할 필요.

- 시뮬레이션의 결과가 실제 정책으로 바로 전환될 수 있는지에 대한 구체적 검토 부족.

6. AI Agent 연구 방향

- 다중 에이전트 학습 확장:

- 논문에서 제안한 협상 프로토콜을 AI Agent 간 협력 및 경쟁 관계에 적용.

- 현실적 요소 추가:

- 더 정교한 사회적, 정치적 변수(예: 법적 집행 가능성, 기술 이전 메커니즘 등) 반영.

- 정책 추천 시스템:

- 강화학습 결과를 기반으로 정책 시뮬레이션 및 자동 추천 시스템 개발.

- 지속 가능성 평가:

- AI Agent가 지속 가능한 환경 목표와 경제 목표를 동시에 충족할 수 있는지 평가.

논문의 논의는 AI Agent를 활용해 복잡한 협상 문제를 해결하는 데 있어 매우 유용한 기반을 제공합니다. 이를 기반으로 사용자의 연구에 구체적인 방향성을 설정하는 데 도움이 되길 바랍니다!

논문을 기반으로 관련된 연구와 논문에 대해 정리해줘

논문 내용을 기반으로 유사하거나 관련된 연구들을 체계적으로 정리했습니다. 아래의 연구는 논문과 연결되는 기후 협력, 다중 에이전트 강화학습(MARL), 게임 이론, 통합 평가 모델(IAM) 분야의 중요한 참고 자료들입니다.

1. 통합 평가 모델(IAM) 관련 연구

IAM(Integrated Assessment Model)은 기후 변화와 경제적 영향을 동시에 분석하는 모델로, 논문의 RICE-N 모델도 이에 기반하고 있습니다.

- DICE 및 RICE 모델:

- Nordhaus, W. D. (2007): A Review of the Stern Review on the Economics of Climate Change

- DICE(Dynamic Integrated model of Climate and Economy)는 전 세계를 하나의 단위로 보고 기후와 경제 간 상호작용을 분석.

- RICE는 이를 지역별로 확장한 버전으로, 각 지역의 독립적 정책 선택과 상호작용을 모델링.

- Nordhaus, W. D. (2007): A Review of the Stern Review on the Economics of Climate Change

- RICE 모델의 확장:

- Lessmann, Marschinski, and Edenhofer (2009): The Effects of Tariffs on Coalition Formation in a Dynamic Global Warming Game

- RICE 모델에 무역과 관세를 추가해 지역 간 상호작용의 현실성을 높임.

- Lessmann, Marschinski, and Edenhofer (2009): The Effects of Tariffs on Coalition Formation in a Dynamic Global Warming Game

IAM의 한계로는 불확실성, 기술 변화, 에이전트 간 상호작용 부족 등이 지적되며, 논문의 RICE-N은 이러한 단점을 보완하려는 시도로 볼 수 있습니다.

2. 기후 협력과 게임 이론 연구

기후 변화와 관련된 게임 이론은 협력과 경쟁 간의 딜레마를 설명하는 데 사용됩니다.

- 기후 협력의 딜레마:

- Hardin, G. (1968): The Tragedy of the Commons

- 공공재 문제를 다루며, 개별 이익 추구가 집단적 실패로 이어질 수 있음을 설명.

- Schelling, T. C. (1980): The Strategy of Conflict

- 협상과 갈등 해결의 전략적 측면을 논의하며, 기후 협력 문제에 간접적으로 적용 가능.

- Hardin, G. (1968): The Tragedy of the Commons

- 기후 클럽 이론:

- Nordhaus, W. (2015): Climate Clubs: Overcoming Free-Riding in International Climate Policy

- "기후 클럽" 개념 제안: 회원국 간 최소 감축율 및 비회원국에 대한 관세 부과를 통해 협력을 유도.

- Nordhaus, W. (2015): Climate Clubs: Overcoming Free-Riding in International Climate Policy

- 비균형적 협상과 형평성:

- Klinsky et al. (2017): Why Equity is Fundamental in Climate Change Policy Research

- 형평성은 기후 협력에서 중요한 역할을 하며, 선진국과 개발도상국 간 역사적 책임 차이를 고려해야 함.

- Klinsky et al. (2017): Why Equity is Fundamental in Climate Change Policy Research

3. 다중 에이전트 강화학습(MARL) 연구

MARL은 여러 에이전트가 협력하거나 경쟁하면서 학습하는 프레임워크로, 논문의 RICE-N에 활용되었습니다.

- MARL과 협력:

- Foerster et al. (2017): Learning with Opponent-Learning Awareness

- 에이전트가 상대의 학습 과정을 인식하며 학습하는 방법을 제안.

- Jaques et al. (2019): Social Influence as Intrinsic Motivation for Multi-Agent Deep Reinforcement Learning

- 사회적 영향력을 내재적 동기로 활용해 에이전트 간 협력을 촉진.

- Foerster et al. (2017): Learning with Opponent-Learning Awareness

- MARL과 기후 변화:

- Mai, Zhang, and Lesage-Landry (2021): Multi-Agent Reinforcement Learning for Renewable Integration in the Electric Power Grid

- 전력망에서 에너지 소비를 최적화하기 위해 다중 에이전트 학습을 활용.

- Mai, Zhang, and Lesage-Landry (2021): Multi-Agent Reinforcement Learning for Renewable Integration in the Electric Power Grid

- 협상 모델링과 학습:

- Cao et al. (2018): Emergent Communication through Negotiation

- 에이전트 간 협상이 자발적으로 발생하는 시뮬레이션 환경을 제시.

- Cao et al. (2018): Emergent Communication through Negotiation

4. 기후 정책 및 협상 관련 사례 연구

실제 기후 협상과 정책 설계에 대한 경험적 연구는 이론적 모델의 현실성을 평가하는 데 중요합니다.

- 기후 정상회의의 효과:

- Chan et al. (2022): Assessing the Effectiveness of Orchestrated Climate Action from Five Years of Summits

- 국제 기후 정상회의의 효과성을 평가하며, 정책적 불일치가 실질적 감축 성과를 저해한다고 분석.

- Chan et al. (2022): Assessing the Effectiveness of Orchestrated Climate Action from Five Years of Summits

- 정치적 협상의 영향:

- Rochedo et al. (2018): The Threat of Political Bargaining to Climate Mitigation in Brazil

- 브라질에서 정치적 협상이 기후 감축 목표에 미치는 부정적 영향을 분석.

- Rochedo et al. (2018): The Threat of Political Bargaining to Climate Mitigation in Brazil

5. 추가 연구 아이디어

논문과 관련된 연구에서 확장할 수 있는 연구 방향:

- 동태적 협상 모델:

- 협상 주체 간 신뢰와 평판 시스템을 강화한 시뮬레이션 연구.

- 정책 시뮬레이션 강화:

- 실제 국가별 데이터(인구, 경제, 탄소 배출)를 기반으로 시뮬레이션을 더욱 현실적으로 구성.

- 다목적 최적화:

- 경제 성장과 온도 상승 억제 간의 트레이드오프를 최적화하는 AI 정책 설계.

이 논문과 관련된 연구들은 AI를 활용해 복잡한 글로벌 협력을 모델링하고 해결 방안을 제시하는 데 중요한 참고 자료로 활용될 수 있습니다. 이를 기반으로 사용자의 AI Agent 연구를 심화시키는 데 기여할 수 있기를 바랍니다.

논문을 기반으로 방법론에 대해 자세하고, 명확하게, 예시를 포함해서 정리해줘

논문의 방법론을 명확하게 이해하기 위해 체계적으로 정리하겠습니다. 이를 위해 논문에서 제안한 주요 방법론과 예시를 단계별로 설명합니다.

1. 핵심 방법론

논문은 RICE-N 모델과 다중 에이전트 강화학습(MARL)을 기반으로 국제 기후 협력 문제를 해결하고자 합니다. 방법론의 주요 구성 요소는 다음과 같습니다:

1.1 RICE-N 모델

RICE-N은 기존 RICE(Regional Integrated Climate-Economy) 모델을 확장하여 기후 변화와 경제적 상호작용을 시뮬레이션합니다.

- 특징:

- 각 지역(에이전트)은 독립적인 정책(감축률, 투자, 무역 관세 등)을 선택.

- 에이전트 간 무역, 협상, 상호작용을 포함하여 현실성을 강화.

- 협상 프로토콜과 행동의 경제적, 환경적 영향을 시뮬레이션.

- 구성:

- 경제-기후 모듈:

- CO2 배출 → 대기 중 탄소 농도 → 온도 상승 → 경제적 피해.

- 각 지역은 자본(K), 노동(L), 기술 수준(A)을 조합해 생산량(Y)을 산출.

- 온도 상승으로 인한 경제 손실은 "피해 함수"로 계산.

- 무역 및 관세 모듈:

- 지역 간 상품 교환과 관세 정책을 시뮬레이션.

- 관세는 상대 지역에 감축 행동을 유도하는 메커니즘으로 활용.

- 경제-기후 모듈:

1.2 다중 에이전트 강화학습(MARL)

RICE-N에서 각 지역은 독립적 에이전트로 모델링되며, MARL을 통해 최적의 정책을 학습합니다.

- 강화학습 개념:

- 에이전트는 현재 상태(observation)를 기반으로 행동(action)을 선택.

- 행동의 결과로 얻은 보상(reward)을 바탕으로 정책(policy)을 업데이트.

- 목표는 장기적인 누적 보상(utility)을 극대화하는 최적의 정책을 찾는 것.

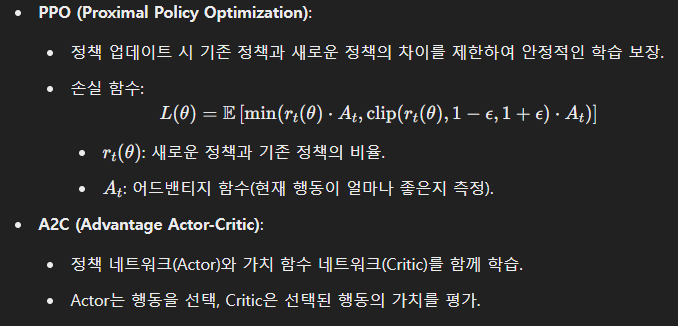

- 강화학습 알고리즘:

- 논문은 Proximal Policy Optimization(PPO)와 Advantage Actor-Critic(A2C)을 사용.

- 에이전트 간 상호작용을 반영해 행동 정책을 동적으로 최적화.

2. 협상 프로토콜

RICE-N의 핵심은 협상 프로토콜을 시뮬레이션에 통합하여 기후 협력의 효과를 분석하는 것입니다. 협상 프로토콜의 주요 유형은 아래와 같습니다.

2.1 기본 협상 없음

- 에이전트는 각자 최적의 행동을 선택하지만, 협상 없이 독립적으로 행동.

- 예: 각 지역이 자신의 경제 이익을 극대화하며 온실가스 감축 없이 생산성을 유지.

2.2 양자 협상 (Bilateral Negotiation)

- 두 지역 간 감축 목표를 설정하는 협상.

- 예시:

- 지역 A가 지역 B에게 다음을 제안:

- "나는 30% 감축할 테니, 너는 20% 감축하라."

- 지역 B는 이 제안을 수락하거나 거부.

- 제안이 수락되면, 양측은 합의된 감축 목표를 따름.

- 지역 A가 지역 B에게 다음을 제안:

- 결과:

- 협상 덕분에 온도 상승이 억제되고, 무역이나 관세를 통해 협력 강화.

2.3 다자 협상 (Multilateral Negotiation)

- 여러 지역이 동시에 협상에 참여.

- Climate Club 모델:

- 클럽에 가입한 지역은 최소 감축률(예: 20%)을 유지해야 하며, 비회원국에 높은 관세를 부과.

- 예시:

- 클럽 내 지역 A, B, C는 감축률 20% 이상을 유지.

- 비회원국 D에게 15% 관세 부과.

- 결과:

- 클럽 내 지역 간 협력이 강화되고, 비회원국의 감축 행동을 유도.

3. 학습 및 평가

3.1 강화학습 모델링

- 각 지역 에이전트는 학습을 통해 다음 행동을 최적화:

- 관찰 값: 현재 온실가스 배출량, 경제적 상태, 협상 제안.

- 행동: 감축률 설정, 관세 부과, 무역 결정.

- 보상: 지역 소비, 경제 생산성, 온도 상승 억제 등.

- 예시:

- 지역 A가 무역 관세를 줄이면 지역 B와 협력이 증가해 장기 보상이 개선.

3.2 평가 지표

- 기후 지표(C): 온도 상승 억제 수준.

- 경제 지표(E): 글로벌 경제 성장률.

- Pareto Frontier로 기후와 경제 간 트레이드오프를 시각화.

4. 예시 시뮬레이션 결과

논문에서 제공한 시뮬레이션 결과:

- 협상 없는 경우:

- 온도 상승이 급격히 증가.

- 경제적 불균형 심화.

- 양자 협상 도입:

- 온도 상승이 억제되고, 경제적 생산성이 약간 감소.

- 다자 협상 도입:

- 온도 상승 억제와 경제 성장 간 최적 균형 달성.

5. 방법론 확장 가능성

논문의 방법론을 기반으로 확장할 수 있는 아이디어:

- 강화학습 개선:

- 에이전트 간 상호작용을 더 정교하게 모델링.

- 신뢰와 평판 시스템 추가.

- 현실적 데이터 통합:

- 실제 지역별 탄소 배출 및 경제 데이터를 활용해 시뮬레이션의 정확성 향상.

- 정책 시뮬레이션:

- 시뮬레이션 결과를 정책 추천 시스템으로 연결하여 실제 정책 설계에 활용.

이러한 방법론은 글로벌 기후 협력을 AI와 결합하여 현실적인 해결책을 제시하는 데 강력한 도구로 작용할 수 있습니다.

그럼 여기서 사용된 모델에 대해 자세하게 설명하고, 어떻게 학습하는지, 최적화 하는지 말해줘

논문에서 사용된 모델과 학습 및 최적화 과정을 체계적으로 정리했습니다.

1. 사용된 모델

1.1 RICE-N 모델

RICE-N은 지역별 기후-경제 상호작용과 협상을 시뮬레이션하는 통합 평가 모델(IAM)입니다.

- 모델 구성 요소:

- 경제 모듈:

- 생산 함수 Y_i=A_i⋅K_i^γ⋅L_i^(1−γ):

- Y_i: 지역 ii의 생산량.

- A_i: 기술 수준.

- K_i: 자본.

- L_i: 노동.

- γ: 자본 탄력성.

- 기술 성장과 인구 변화 모델:

- 기술 수준은 장기 경제 성장률 η, 단기 성장률 g_A, 감쇠 계수 δ_A로 결정.

- 인구는 수렴 인구 L_A와 성장률 g_l에 따라 변화.

- 생산 함수 Y_i=A_i⋅K_i^γ⋅L_i^(1−γ):

- 기후 모듈:

- 탄소 배출량, 대기 중 탄소 농도, 온도 상승, 경제적 손실을 연계.

- 온도 상승은 경제적 생산성을 감소시키는 피해 함수로 작용.

- 무역 및 관세 모듈:

- 지역 간 무역을 모델링하고, 관세로 협력을 유도.

- Armington 탄력성을 기반으로 지역 간 수입품과 자국 상품의 소비 패턴 결정.

- 경제 모듈:

- 협상 프로토콜:

- 각 에이전트는 협상 프로토콜을 통해 합의를 도출.

- 합의는 에이전트 행동을 제한하거나 보상을 조정.

2. 학습 과정

2.1 다중 에이전트 강화학습(MARL)

각 지역(에이전트)은 강화학습을 통해 최적의 정책을 학습하며, 상호작용이 강화학습 과정에 포함됩니다.

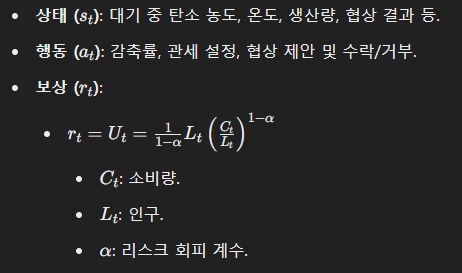

- 강화학습 개요:

2.2 학습 절차

- 정책 학습:

- 정책 π_i(a_t | s_t)는 상태 s_t에서 행동 a_t를 선택하는 확률 분포.

- 각 에이전트는 자신의 정책을 강화학습으로 최적화하여 장기 보상을 극대화.

- 학습 알고리즘:

- PPO (Proximal Policy Optimization):

3. 최적화

강화학습 과정에서 에이전트의 학습은 정책 최적화를 통해 이루어집니다.

3.1 손실 함수 설계

- 정책 손실:

- 에이전트가 현재 상태에서 최적의 행동을 선택하도록 유도.

- PPO와 같은 제한을 적용하여 학습 안정성 확보.

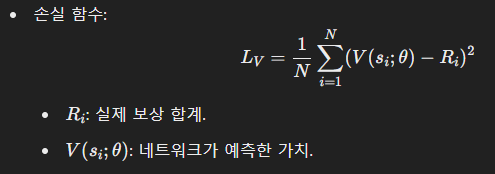

- 가치 손실:

- 가치 네트워크는 현재 상태의 장기 보상을 정확히 예측하도록 학습.

3.2 최적화 알고리즘

- Gradient Descent:

- 손실 함수의 기울기를 계산하여 정책 네트워크의 파라미터를 업데이트.

- Exploration vs Exploitation:

- 초기에는 새로운 행동을 탐색(exploration)하도록 확률 분포를 넓게 설정.

- 학습이 진행되면서 최적 행동을 선택(exploitation)하는 방향으로 조정.

3.3 다중 에이전트 간 상호작용

- 상태 관찰 공유:

- 각 에이전트는 협상 결과나 다른 에이전트의 행동을 관찰.

- 관찰된 정보를 기반으로 정책을 조정.

- 보상 공유:

- 에이전트 간 협력 수준에 따라 보상을 공유하거나 벌칙을 부과.

4. 예시

4.1 협상 없는 경우

- 행동: 각 에이전트는 경제적 생산성을 극대화하는 감축률(0%) 선택.

- 결과: 온도 상승과 경제적 불균형 심화.

4.2 양자 협상

- 행동: 지역 A가 지역 B에게 "나는 20% 감축, 너는 15% 감축" 제안.

- 결과: 양측이 감축률 합의에 도달, 온도 상승이 억제되고 무역량 증가.

4.3 다자 협상

- 행동: 다자 협상(Climate Club)에서 최소 감축률 25% 설정.

- 결과: 클럽 내 지역은 감축률을 유지하며, 비회원국은 관세를 통해 압박받음.

5. 결론

논문에서 사용된 모델은 강화학습을 활용해 에이전트가 복잡한 환경에서 협력적 행동을 학습하도록 설계되었습니다. 최적화 과정은 정책 업데이트 안정성과 협력 효과를 극대화하는 방향으로 진행됩니다. 이러한 접근법은 현실적인 기후 협력 문제를 해결하기 위한 강력한 도구로 사용될 수 있습니다.

그럼 이건 단순한 연속적인 공간에서 활동하는 강화학습 모델이지 LLM이 아니구나...?

습니다. 이 논문에서 사용된 RICE-N 모델과 다중 에이전트 강화학습(MARL)은 연속적인 공간에서 활동하는 강화학습 모델로, 대규모 언어 모델(LLM: Large Language Model)과는 본질적으로 다릅니다. 아래에 두 모델의 차이점과 논문의 접근 방식을 정리했습니다.

1. RICE-N 모델과 강화학습의 특성

- 주된 작업 공간:

- RICE-N 모델은 지역별 기후와 경제적 의사결정이라는 연속적이고 수치적인 공간에서 작동.

- 각 에이전트는 감축률, 무역, 협상 등 명확히 수량화된 행동을 수행.

- 강화학습 모델:

- 각 에이전트는 정책(policy)을 학습하며, 이 정책은 특정 상태에서 특정 행동을 선택하는 확률 분포.

- 보상 함수(예: 경제적 생산성과 온도 상승 억제)가 에이전트의 학습 목표를 결정.

- 의사결정 방식:

- MARL은 상태-행동-보상이라는 강화학습의 전형적 구조를 따릅니다.

- 에이전트 간 상호작용이 게임 이론적 상황(협력/경쟁)으로 모델링됨.

2. LLM(대규모 언어 모델)의 특성

- 작업 공간:

- LLM은 텍스트 데이터를 기반으로 작동하며, 주로 자연어 처리(NLP) 문제를 해결.

- 단어, 문장, 문맥 등 비정형 데이터(텍스트)를 다룹니다.

- 학습 방식:

- LLM은 확률적 언어 생성 모델로, 다음 단어나 문장을 예측하기 위해 대규모 데이터에서 사전학습.

- 강화학습(RLHF: Reinforcement Learning with Human Feedback)을 통해 인간의 피드백 기반으로 추가 조정 가능.

- 의사결정 방식:

- 텍스트 생성, 요약, 번역, 질의응답 등의 작업을 수행하며, 특정 작업에 맞게 미세 조정(fine-tuning) 가능.

- 의사결정은 텍스트를 통해 표현되는 고차원 언어 공간에서 이루어짐.

3. 논문에서 사용된 방법론과 LLM의 차이

강화학습 기반 RICE-N:

- 연속적 공간:

- 기후 경제 데이터를 수치적으로 다루며, 강화학습을 통해 행동 최적화.

- 상태 기반 학습:

- 상태(state)와 행동(action)이 명확히 정의된 구조적 환경에서 학습.

- 다중 에이전트:

- 지역별 에이전트 간 상호작용(협력, 경쟁, 협상)이 중심.

LLM:

- 비정형 데이터:

- 텍스트 기반의 데이터 처리에 특화.

- 문맥 기반 학습:

- 언어의 문맥적 의미를 이해하고, 예측 및 생성.

- 개별 에이전트:

- 하나의 모델이 전체 문맥을 이해하고 행동 결정.

4. 결론: RICE-N의 역할과 LLM의 가능성

- RICE-N의 역할:

- 이 논문은 강화학습 기반 접근법을 통해 기후 협력 문제를 해결하는 데 초점을 맞춤.

- 경제-기후 모델과 협상 시뮬레이션은 LLM이 아닌 연속적 행동 공간에서의 최적화 문제로 정의됨.

- LLM의 가능성:

- 만약 LLM을 결합한다면, 협상 과정에서 자연어 기반 의사소통(예: 협상 제안 생성, 감정 분석 등)에 사용 가능.

- 예를 들어, 협상 에이전트가 자연어로 협상 내용을 설명하거나, 인간-에이전트 협력에서 언어를 매개로 사용.

추가 연구 방향

- LLM과 RICE-N 통합:

- 협상 단계에서 LLM을 사용해 자연어로 협상 프로토콜 생성 및 분석.

- RICE-N이 강화학습으로 최적 정책을 학습하는 동안, LLM이 언어적 맥락에서 협력의 질을 향상.

이 논문은 기본적으로 강화학습 모델 중심이지만, LLM과의 결합으로 더 발전된 AI 에이전트를 설계할 가능성을 제공합니다.

그럴 수 있습니다! 논문에서 말하는 "Agent"는 기후 협력 시뮬레이션에서 각 지역(혹은 국가)을 대표하는 독립적인 강화학습 기반의 Multi-Agent 시스템입니다. 이는 우리가 일반적으로 생각하는 AI Agent(예: LLM 기반의 지능형 시스템)와는 다소 다릅니다. 이를 명확히 이해하기 위해 두 개념을 비교해 보고, Multi-Agent가 논문에서 어떤 역할을 하는지 다시 정리하겠습니다.

1. AI Agent vs. Multi-Agent

AI Agent

- 정의:

- 자연어 처리(NLP), 이미지 생성, 데이터 분석 등 특정 작업을 수행하는 AI 시스템.

- 일반적으로 인간과의 인터랙션, 자율적 의사결정, 학습 및 환경 적응 능력을 포함.

- 예시:

- OpenAI의 ChatGPT: 자연어로 대화하며 정보를 제공.

- AlphaGo: 바둑에서 최적의 수를 두기 위해 학습한 AI.

- 작업 공간:

- 고차원 언어 공간, 이미지 공간 등 비정형 데이터 기반.

Multi-Agent 시스템

- 정의:

- 여러 개의 독립적인 에이전트가 상호작용하며 특정 목표를 달성하는 시스템.

- 강화학습(MARL)을 사용해 각 에이전트가 개별적이면서도 협력적인 정책을 학습.

- 예시:

- 논문의 RICE-N: 국가별 에이전트가 협상 및 정책을 학습하여 기후 변화를 해결.

- StarCraft II AI: 팀 단위의 전략적 플레이를 학습하는 에이전트.

- 작업 공간:

- 명확히 정의된 상태(state)-행동(action)-보상(reward) 공간.

2. 논문에서의 Multi-Agent 역할

논문의 에이전트는 기후와 경제 정책을 학습하고 실행하는 독립적인 지역/국가 모델로, 각 에이전트는 강화학습 기반으로 작동합니다.

2.1 에이전트의 기능

- 정책 최적화:

- 각 에이전트는 자신의 지역 경제와 환경 목표를 동시에 달성하기 위해 최적의 행동(예: 감축률, 무역 결정)을 학습.

- 협상 및 경쟁:

- 다자간 협상에서 감축률 합의 및 관세 결정과 같은 상호작용 수행.

- 장기적 보상 극대화:

- 각 에이전트는 장기적인 경제 성장과 온도 상승 억제를 목표로 보상을 최적화.

2.2 협상의 맥락에서 에이전트

- 협상 프로토콜 참여:

- 에이전트는 감축률과 같은 협상 제안을 생성하거나 수락/거부함.

- 예: "내가 20% 감축하면 너는 15% 감축해라."

- 결과 학습:

- 협상 결과가 각 지역의 보상(경제적 성과와 기후 영향)에 영향을 미침.

- 강화학습을 통해 다음 협상에서 더 나은 제안을 학습.

3. 왜 AI Agent로 오해할 수 있었는가?

- "Agent" 용어의 다의성:

- "Agent"는 AI 연구에서 자율적 행동 주체를 포괄적으로 지칭.

- LLM 기반의 언어적 AI도 Agent로 불리지만, 논문에서는 구체적으로 Multi-Agent 시스템을 의미.

- 강화학습과 일반 AI의 혼동:

- 논문에서 "AI"를 다루지만, 이는 자연어 처리나 인간-기계 인터페이스가 아닌, 강화학습 환경의 AI를 의미.

4. AI Agent를 Multi-Agent에 적용한다면?

논문에서의 Multi-Agent 시스템에 AI Agent를 결합하면 다음과 같은 발전 가능성이 있습니다:

- 협상 과정의 언어적 표현:

- 각 에이전트가 협상 내용을 자연어로 설명하고 제안하도록 LLM을 통합.

- 예: "이 협상이 장기적으로 경제 성장을 어떻게 지원할지 설명."

- 의사결정에 언어 모델 사용:

- LLM을 활용해 에이전트의 정책 결정을 더 직관적이고 설명 가능하게 설계.

- 인간과 협력:

- 인간-에이전트 협상 시뮬레이션에서 LLM 기반 에이전트가 중재 역할을 수행.

5. 결론

논문의 에이전트는 기후 협력 시뮬레이션에서 강화학습 기반의 Multi-Agent 시스템입니다. 이는 기존 AI Agent(Large Language Models, 자율 시스템 등)와는 다르지만, 두 개념을 결합하면 기후 협력 문제를 더 직관적이고 현실적으로 접근할 수 있는 가능성을 제공합니다.

추후 연구에서 AI Agent의 언어적 표현과 Multi-Agent의 수치적 최적화를 결합하면 더욱 혁신적인 기후 협력 시스템을 개발할 수 있을 것입니다!

'기타' 카테고리의 다른 글

| 동역학 13주차 정리 (1) | 2024.12.08 |

|---|---|

| 동역학 12주차 정리 (0) | 2024.12.07 |

| 역사와 한국의 영토 12주차 - 한 일 관계 (0) | 2024.12.02 |

| 역사와 한국의 영토 11주차 - 강점기 이전의 독도 (1) | 2024.12.01 |

| ChatGPT로 면접 준비하기 (1) | 2024.11.23 |