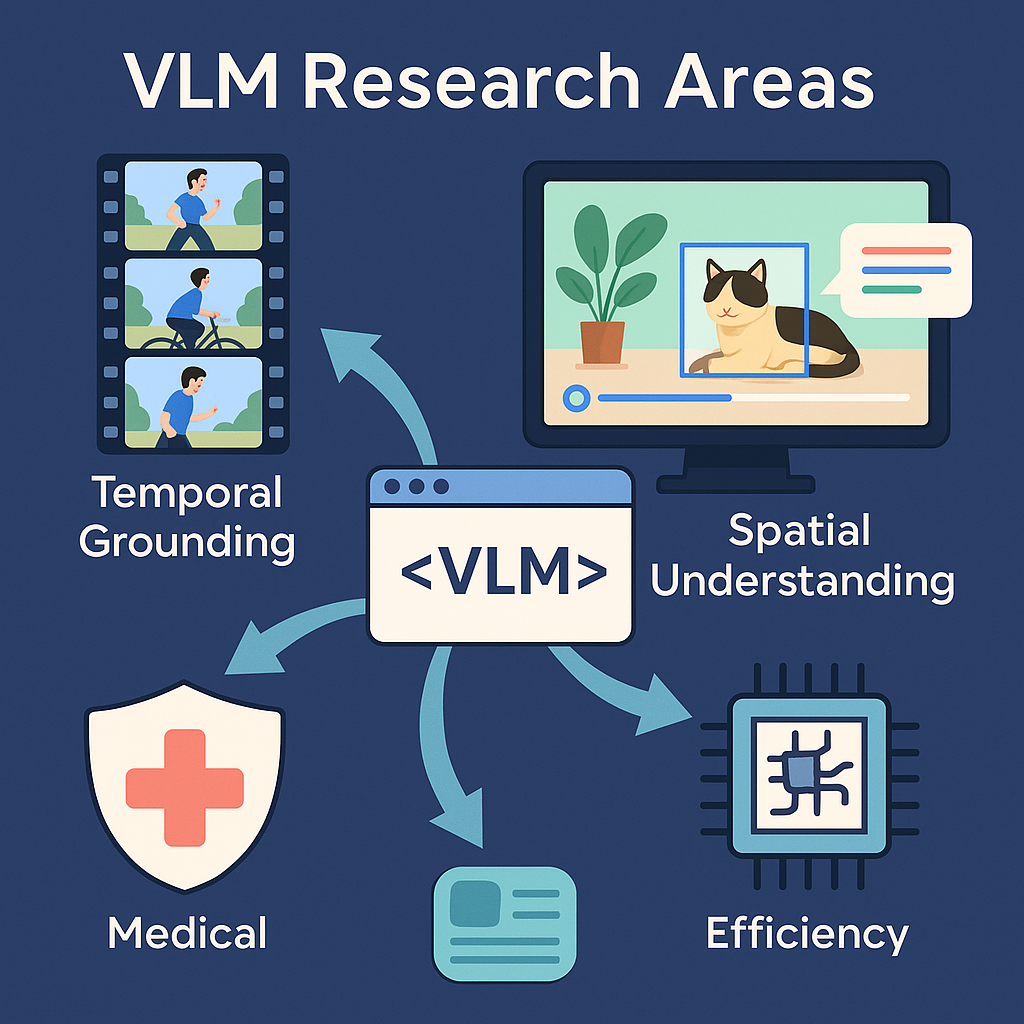

Video LLM은 짧은 비디오에 대한 캡셔닝, 질문응답, 장면 요약 등의 작업에서는 준수한 성능을 보이지만, 여전히 긴 비디오 처리, 시계열 추론, 객체 단위 정밀 인식, 실시간 대응 측면에서는 한계를 드러낸다. Seq2Time은 절대 시간 표현의 일반화 실패 문제를 해결하기 위해 상대 위치 토큰을 도입하여 시계열 데이터를 효과적으로 정렬하고, 다양한 길이의 영상에서도 시간 표현의 일반화를 가능하게 했다. DynFocus는 질문과 정합성이 높은 프레임을 선택하고 나머지는 희소 인코딩으로 처리함으로써, 효율성과 정밀도의 균형을 맞춘다. VideoTree는 시각 정보를 계층화하여 질문과 연관된 프레임만을 추출하고, reasoning 연쇄 구조에 따라 재정렬된 캡션을 문서화하여 LLM 입력으로 활용함으로써 multi-hop reasoning에도 적합하다. Hallucination은 LVLM이 실제 이미지에 없는 객체를 생성하거나, 속성이나 위치 정보를 잘못 예측하는 문제를 지칭하며, 주요 원인은 attention 불균형과 LLM의 언어 prior이다. Devils in Middle Layers는 중간 attention map을 조정하고 VAR, SVAR 등의 지표를 활용해 환각 발생 위치를 조정하여 inference 시 환각 가능성을 줄인다. Nullu는 HalluSpace라 명명된 환각 유발 표현공간을 제거하는 방식으로 모델의 언어 prior 자체를 수정하는 구조적 접근을 제시한다. Octopus는 환각의 원인이 토큰/샘플/상황별로 다르다는 점을 반영해 eye token으로 감지 후, RL 기반 정책으로 디코딩 전략을 동적으로 선택하며 실시간 제어가 가능하다. 현재 환각 평가는 VAR, logit gap 등의 지표에 의존하지만, 이는 모델 구조에 민감하고 다양한 환각 유형을 포괄적으로 분리하지 못해 향후 동적이고 세분화된 평가 체계가 요구된다. 의료 분야에서는 VLM이 전역적 설명은 가능하나 임상적으로 중요한 특정 병변, 해부학적 구조에 대한 판단 근거를 제시하지 못하는 한계가 있다. 이를 해결하기 위해 MedRegA는 region-level 기반 attention 및 chain-of-thought 추론 구조를 도입해 시각적 근거를 명시적으로 드러내며, 의료 보고서 생성에서의 해석 가능성과 신뢰도를 높인다. MMed-RAG는 영상 입력으로 도메인을 자동 식별한 후, 해당 도메인에 특화된 retriever로 관련 지식을 검색하고, adaptive-k 전략과 preference fine-tuning을 통해 정합성 높은 응답을 생성한다. 다만, retriever 구축 비용과 도메인 간 전이, noisy retrieval 대응 등은 여전히 과제로 남는다. SERSAL은 LLM이 제공하는 언어 지식을 small model과 상호 주고받으며 self-prompting 방식으로 tabular 예측을 수행하고, 수학적으로 둔감한 LLM의 한계를 보완한다. 효율성 측면에서는 FastVLM이 FastViT 인코더를 활용해 기존 ViT 대비 3배 이상의 속도로 추론이 가능하면서도 VQA 등에서 95% 이상 정확도를 유지하며, 고해상도 입력 처리에 유리하다. 그러나 fine-grained task에서는 해상도 손실에 따른 의미 왜곡 우려가 있다. PVC는 프레임 중복을 제거하며 영상 요약 기반 작업에 효율적이며, ATP-LLaVA는 레이어 및 인스턴스 기반으로 중요 토큰을 선택해 연산량을 줄인다. VLsI는 대형 모델의 추론 경로를 distill하여 작은 모델로 재구성함으로써 edge 환경에 적합한 reasoning이 가능하도록 한다. 이 방식들은 task 유형에 따라 트레이드오프가 존재하므로 hybrid 구조 구성이 바람직하다. FlashSloth는 contrastive selection 기반으로 salient region만 추출하고 연산량을 줄이는 동시에, 선택된 토큰들이 explainability의 시각적 근거로 기능할 수 있어 모바일 환경에서의 신뢰성 향상에도 기여할 수 있다. Hallucination 문제를 다룬 주요 연구들은 각각 다른 접근 방식으로 환각의 원인을 규명하고 이를 완화하려고 시도한다. (Devils)에서는 대부분의 기존 연구가 언어적 편향에 집중하며 시각 정보의 처리 과정은 간과하고 있다는 문제의식에서 출발한다. LVLM의 중간 레이어에서 시각 정보가 어떻게 처리되는지를 분석하였고, 이를 시각 정보 축적 단계와 의미 정제 단계로 구분하여 설명한다. 이들은 Attention Lens 기법을 활용해 중간 레이어에서 VAR, SVAR 메트릭으로 환각 가능성이 높은 토큰을 탐지하며, inference 단계에서 attention을 조정하여 효과적으로 환각을 줄이는 방법을 제안한다. 외부 모델 없이 내부 attention만으로 조정 가능한 경량 구조라는 점에서 실용성이 높으나, SVAR 민감도 저하와 단계 구분의 주관성이 한계로 지적된다. (AG&LA)은 LVLM이 이미지의 global 특징에는 집중하지만 질문에 관련된 지역 정보를 놓쳐서 실제 존재하지 않는 객체를 생성하는 문제를 지적한다. 이에 따라 global과 local attention을 결합한 logit fusion을 통해 질문과 관련된 시각 영역에 집중하도록 유도하며, 학습 없이 plug-and-play 방식으로 적용 가능한 구조를 제안한다. 다만, GradCAM 기반 시각 정보 해석의 한계와 대규모 모델로의 확장성은 제한적이다. (Nullu)은 환각의 원인이 데이터 부족이 아니라 LLM 내부의 강한 문장 생성 prior에서 비롯된다는 점을 이론적으로 규명하고, 이를 해결하기 위해 HalluSpace라는 환각 유발 하위 표현 공간을 찾아내고 이를 제거하는 방식으로 접근한다. 모델 파라미터를 직접 수정하여 학습 없이 환각을 억제할 수 있으며, 일반 LVLM에 플러그인 형태로 적용 가능하지만 HalluSpace 정의 및 하이퍼파라미터 설정이 경험적으로 이루어진다는 점이 한계로 지적된다. (Octopus)은 기존의 CD 방식이 환각 유형을 구분하지 않고 일괄 적용된다는 문제를 지적하고, 각 생성 단계에서 환각 원인을 식별한 뒤 해당 토큰에 적합한 디코딩 전략을 동적으로 선택하는 구조를 제안한다. Transformer 블록에 eye token을 추가해 환각 유형을 감지하고, 이를 기반으로 4개의 전략 중 하나를 선택하며, DPO나 RL 방식으로 action sequence를 학습한다. 전략 최적화의 복잡성과 on-device 실행 시 자원 부담이 한계로 존재하지만, 상황 반응형 디코딩 구조로서 실용성이 높다. (VASparse)은 기존 sparsification 기법이 시각 정보를 고려하지 않고 무분별하게 토큰을 제거해 환각을 유발한다는 점에서 출발한다. 이 연구는 attention score와 visual saliency를 통합한 기준으로 중요 토큰만을 유지하고, logit 분포를 기준으로 환각 토큰을 재분배하여 후처리 없이 빠르게 inference가 가능하도록 구성하였다. 다만 하이퍼파라미터 설정, 문맥 보정 능력 부족, 디코더 구조별 sparsity 편차는 해결해야 할 과제로 남는다. 종합적으로 볼 때, 환각 완화의 주요 전략은 내부 attention 조작(1,2번), feature space 수정(3번), 디코딩 전략 개선(4,5번)으로 나뉘며, 공통적으로 시각 정보의 보존과 언어 편향 제거를 목표로 한다. 이들은 모두 plug-and-play 방식으로 설계되어 실용성과 효율성을 강조한다. 객체 환각이 발생하는 근본적 구조 원인은 LVLM이 언어 모델로서 문장 생성 prior에 강하게 의존하며, 시각 정보가 주어져도 attention이 텍스트 토큰에 집중되기 때문이다. 이는 시각 grounding이 약하거나 지역 정보가 무시될 때 더욱 두드러진다. 최근 연구들은 attention sparsity를 활용해 추론 속도를 유지하면서도 환각을 줄이는 데 성공하였으며, 이는 실시간 응용에 적합한 구조를 제시한다. Attention 조작 방식은 토큰 간 연결 구조를 조정하는 반면, feature space 투영은 임베딩 공간 자체를 수정하여 보다 근본적인 편향 제거가 가능하다. LVLM에서 Object Hallucination은 실제 이미지에 존재하지 않는 객체나 속성을 생성하는 현상으로, 이미지 캡셔닝, VQA, 의료 보고서 생성 등 신뢰성이 요구되는 작업에서 치명적인 문제다. 기존의 디코딩 방식이나 attention 조작만으로 환각을 충분히 방지하지 못하는 이유는 접근 방식이 정적이며, 토큰별 상황을 고려하지 않기 때문이다. 또한 attention 자체가 이미 편향되어 있다면 조작이 무의미해지고, 환각의 원인이 위치, 타이밍 등 다양하기 때문에 통합적으로 다루기 어렵다는 한계가 있다. (Seq2Time)는 기존 LVLM이 시간 정보를 정밀하게 이해하지 못한다는 문제에서 출발한다. 대부분의 기존 비디오 데이터셋은 시간 정보가 부착되지 않았거나, 절대 시간 기반의 단순 인덱스에 의존해 일반화에 실패했다. Seq2Time은 이를 해결하기 위해 이미지 시퀀스 또는 짧은 클립을 이어붙여 상대적인 시간 표현으로 변환하고, unified relative position token을 통해 하나의 임베딩 공간에서 연결 가능한 구조를 제안한다. 이를 기반으로 세 가지 이미지 기반 pretext task와 클립 기반 학습을 통해 자가 지도 학습으로 시간 순서를 정렬 가능하게 한다. 다만, LongVA 기반 생성 캡션 품질 저하, 객체 인식 성능 미흡, 실제 데이터의 품질 불균일성에 따라 성능 하락이 관찰된다. 향후에는 더 정교한 시각 인코더와 patch-level correlation, fine-grained temporal token 설계가 필요하다. (VideoRefer Suite)는 기존 LVLM이 scene-level reasoning은 가능하나, 객체 단위의 동작, 관계, 변화에 대한 인식이 부족하다는 문제의식에서 출발한다. 이 논문은 멀티에이전트 파이프라인을 통해 70만 개의 고품질 object-level 영상 instruction 데이터셋(VideoRefer-700K)을 구축하고, 이를 통해 객체 중심의 시공간 인코더를 설계한다. 해당 인코더는 픽셀 수준의 표현을 바탕으로 시공간 정보를 통합하며, 객체 중심 QA 및 이해 성능을 평가할 수 있는 새로운 벤치마크를 제공한다. 그러나 inference 시 복수 프레임 병합으로 인한 연산량 증가와 객체 인식 정밀도 한계는 과제로 남아 있으며, 향후 grounding 기능 강화, 사용자 주도 객체 선택 및 도메인 특화 확장이 필요하다. (Dispider)는 기존의 오프라인 기반 Video LLM이 영상 전체를 보고 응답하는 구조로 인해 실시간 상호작용이 어렵다는 점을 지적한다. 특히 online inference 모델조차도 응답을 생성하는 동안 영상 분석이 멈추는 blocking 문제가 존재한다. Dispider는 이를 해결하기 위해 perception(영상 감지), decision(응답 시점 판단), reaction(응답 생성)을 완전히 분리하고 비동기적으로 작동하는 구조를 제안한다. 중요한 장면 단위로 클립을 나누고, scene 전환을 탐지하며, 과거 메모리와 질문, 클립 특징을 기반으로 응답 시점을 판단한다. 이로써 실시간 처리가 가능해졌지만, 완벽한 temporal alignment 보장은 어렵고, decision 모듈의 오탐률 및 특수 토큰 의존성 문제는 해결 과제로 남는다. (VidComposition)는 기존 MLLM 벤치마크가 이미지 중심, 자연 장면 중심의 coarse QA에 집중되어 있고, 편집된 영상의 구성을 해석하지 못한다는 문제의식에서 출발한다. 이 논문은 실제 영화나 방송처럼 편집된 복잡한 영상의 구성요소들—카메라 이동, 쇼트 크기, 전환 흐름—을 이해할 수 있는 최초의 대규모 평가체계인 VidComposition 벤치마크를 제안한다. 인간 수준의 fine-grained annotation을 기반으로 영상의 편집적 논리를 테스트할 수 있으며, MLLM의 구성 이해 능력을 분석할 수 있게 했다. 그러나 composition 인식의 일반화 어려움, 학습 데이터 편차, 맥락 기반 인과 추론의 부재는 여전히 남아 있으며, 향후 영화 이론 기반 학습 및 외부 스크립트 연동 강화가 필요하다. (DynFocus)는 대부분의 비디오가 질문과 무관한 중복 프레임을 다수 포함하며, 이를 모두 처리할 경우 token budget과 메모리 부담이 크다는 점에 주목한다. 생물학적 시각 시스템을 모방하여 의미 있는 프레임만 fine-grained하게 인코딩하고, 나머지는 coarse encoding으로 처리하는 구조를 제안한다. DPC-KNN 기반 클러스터링으로 사건 프로토타입을 도출하고, 중요도 점수를 기반으로 top-k 프레임을 선택하는 방식이다. 질문에 적합한 프레임만 고해상도로 분석해 정보량과 연산량을 절감할 수 있으나, 중요한 프레임을 선택하는 기준이 명시적이지 않아 해석 가능성이 떨어지며, 1인칭 시점 질문에서는 성능 저하가 있다. 향후 태스크 특화 인코딩 전략 학습과 event ordering 기능 강화가 요구된다. (VideoTree)는 장시간 비디오에서 모든 프레임을 단순 나열하는 방식이 토큰 과부하를 야기하고, 장면 간 구조를 고려하지 못한다는 문제의식에서 출발한다. 이 논문은 영상을 트리 기반 구조로 계층화하고, 질문 중심의 relevance 판단을 통해 필요한 정보만을 선별한다. 첫 번째 단계에서는 영상 전체를 클러스터링한 뒤 대표 프레임을 캡셔닝하고, LLM이 질문과의 관련도를 판단한다. 이후 높은 관련도의 클러스터만 하위로 재클러스터링하며, 최종적으로 시간 순으로 정렬된 keyframe 캡션들을 문서로 생성해 LLM에 입력한다. 이는 multi-hop reasoning에서도 효율과 정합성을 동시에 확보할 수 있으나, caption 품질과 relevance 판단 정확도에 따라 reasoning 실패 가능성이 존재하며, 반복 동작 비용도 고려해야 한다. 종합적으로 현재 Video LLM은 짧은 영상에 대해 캡셔닝, QA 등은 가능하나, 긴 영상에서 시간 흐름 이해, 객체 추적, 편집 구조 해석, 실시간 응답 측면에서는 여전히 미흡하다. 특히 시간 정보 이해는 주석 데이터의 부족과 절대시간 기반 표현 방식의 한계로 인해 추론 성능이 제한적이며, 객체 수준의 변화 인식 역시 데이터셋 부족으로 정밀도가 낮다. 기술적으로는 짧은 비디오나 고정된 구성을 가진 영상에서는 멀티모달 추론이 가능하고, 일부 모델은 인간 수준의 응답을 생성할 수 있지만, 장면 간 인과관계 reasoning, 실시간 처리, 영상 내 구조적 압축 등 고차원 능력은 발전이 필요한 상태다. 개선 방향으로는 시계열 pretext task 기반 학습, fine-grained 시간 토큰 설계, 픽셀 단위 객체 표현 및 grounding, scene segmentation 기반 실시간 구조, 외부 정보와의 결합, 질문 중심 장면 선택 및 계층적 표현 구조 설계가 제시된다. Medical LLM 분야는 기존의 범용 LLM 구조가 의료 영상 및 구조화된 데이터에 대해 신뢰도 있는 추론을 수행하기 어렵다는 인식에서 출발한다. 특히 Prompt as Knowledge Bank 연구는 기존 LVLM 기반 의료 영상 탐지에서 prompt를 단순 텍스트로 구성했기 때문에 coarse alignment 문제가 빈번하게 발생하고, instance-level 질병 탐지에 어려움이 있었음을 지적한다. 이에 StructuralGLIP는 시각 및 언어 정보를 각각 독립적으로 처리하는 dual-branch 구조를 통해 fine-grained alignment를 구현하고, prompt를 layer-wise knowledge bank 형태로 활용하여 zero-shot 성능을 강화하였다. 그러나 prompt 품질이 모델 전체 성능에 영향을 미치며, rare disease와 같은 범주에 대해 LLM의 prior 부족으로 인해 생성 자체에 한계가 존재한다. 한편 Small Models as LLM Knowledge Triggers for Medical Tabular Prediction 연구는 LLM이 비정형 텍스트에는 강점을 보이지만 수치 기반의 표 구조 데이터에서는 취약하다는 점을 지적한다. 이 연구는 작은 모델이 LLM으로부터 유도된 지식을 바탕으로 학습되고, 그 결과를 다시 LLM에 입력함으로써 상호 보완적 학습을 수행하는 self-prompting 구조를 제안하였다. 이는 label이 부족한 의료 tabular 데이터에서 비지도 방식으로도 성능을 개선할 수 있는 가능성을 보여주었으나, LLM이 최소한의 도메인 prior를 보유하고 있어야 작동하며, 수치 연산에 대한 근본적인 민감도 부족은 여전히 남아 있다. MMed-RAG는 Med-LVLM의 높은 가독성에도 불구하고 factual consistency가 부족하다는 점에 착안해, 도메인 기반 retriever 선택, CLIP 유사도 기반 adaptive-k 문맥 선택, preference fine-tuning이라는 세 가지 요소를 통합한 구조를 제안하였다. 특히 기존 RAG 방식이 retrieval 수를 고정하여 낮은 품질의 문맥을 포함시키는 문제를 개선하고자, 급격한 유사도 하강을 기준으로 k를 동적으로 조절한다. 하지만 각 도메인에 대해 retriever를 별도 구축해야 하며, noisy context가 잔류 환각을 유발할 수 있는 점은 여전히 도전 과제로 남는다. MediConfusion은 기존 의료 VQA 벤치마크가 언어적 편향에 의존한 질문 구성을 통해 높은 점수를 유도할 수 있다는 허점을 지적하고, 실제 시각적 추론 능력을 측정하기 위한 새로운 벤치마크를 제안하였다. 해당 벤치마크는 서로 유사한 언어적 표현을 갖지만, 시각적으로 구별되는 이미지 쌍을 통해 모델의 진정한 perception 능력을 평가한다. 이 연구는 모델이 필연적으로 틀릴 수밖에 없는 질문을 구성함으로써 시각적 reasoning 기반의 오류 진단이 가능하게 했다. 그러나 모든 CLIP-style encoder가 혼동을 겪는다는 점에서 인코더 설계 자체의 한계가 드러나며, 일부 질문이 LLM 기반 자동 생성으로 인해 언어적 미세 오류가 포함될 수 있다. VILA-M3는 일반 VLM이 coarse feature 중심으로 학습되어 병리학적 세부 구조나 미세 병변 탐지에 한계가 있다는 점을 지적하며, 의료 전문가의 판단을 반영한 fine-tuning 전략을 포함한 구조를 설계했다. 특히 마지막 단계에서 domain expert feedback을 반영하며 segmentation, classification, VQA, report generation을 통합 프레임워크로 학습한다. 이 구조는 실질적 임상 적용 가능성을 높였지만, 40B 모델의 학습 수렴 속도나 일부 벤치마크에서 성능 저하가 관찰되며, 다양한 태스크 간의 trade-off 조율이 필요하다. 마지막으로, Interpretable Bilingual은 대부분의 의료 MLLM이 region-agnostic 구조를 채택해 이미지 전체에 대한 설명은 가능하지만, 특정 병변 위치나 해부학 구조에 대한 설명은 부족하다는 문제의식을 중심으로 설계되었다. 이 모델은 region-centric 학습 및 regional chain-of-thought 추론 구조를 통해 시각적 근거를 명확히 제시하고, bilingual 대응을 통해 다양한 언어 환경에서도 적용 가능성을 보였다. 다만 병리 이미지 등에서 region annotation이 부족한 경우 성능 저하가 발생하며, 작은 병변 탐지에 한계가 있다. 종합적으로 현재 의료 LVLM은 이미지 전체에 대한 설명은 가능하지만, region-level 추론, tabular 예측, real-world factual consistency 측면에서는 여전히 취약하다. 특히 실질적인 clinical workflow와의 연계를 위해서는 MedRegA와 같이 해석 가능성을 갖춘 region 기반 모델이 필요하며, MMed-RAG처럼 adaptive-k 및 domain-aware retrieval을 갖춘 RAG 구조가 효과적이다. 또한, SERSAL과 같은 small model synergy 구조는 수치 기반 구조적 데이터를 다루는 새로운 방향성을 제시한다. 향후 연구는 multi-agent 시스템, region-aware instruction fine-tuning, real-time inference 연동 등 복잡한 임상 환경에 대응 가능한 프레임워크로의 확장이 요구된다. 효율성 향상은 Vision-Language Models(VLMs)의 실시간 응답, 모바일 디바이스 배포, 장시간 비디오 처리 등 다양한 실제 응용을 위한 핵심 과제로 부상하고 있다. 특히 고해상도 입력을 다루는 과정에서 발생하는 연산량 증가와 토큰 수 폭발 문제를 해결하기 위한 다양한 접근들이 시도되고 있다. FastVLM은 이러한 문제의식에서 출발하여, 고해상도 이미지를 처리하면서도 연산량과 추론 시간을 줄이기 위해 FastViT 기반의 비전 인코더 구조를 도입하였다. 이 모델은 복잡한 토큰 프루닝 없이도 시각적 중요 정보를 효과적으로 요약하여 최대 3.2배의 추론 속도 향상과 함께 95% 이상의 정확도를 유지하였다. 그러나 ultra-high resolution 이미지에서는 타일링이 필요하고, 고해상도에서의 시맨틱 정밀도는 보완이 필요한 상태이다. PVC는 영상 내 중복 프레임을 제거하고 시공간 정보를 요약하는 progressive visual compression 구조를 통해 장시간 비디오 처리에서의 효율성과 정밀도를 동시에 확보한다. 기존의 프레임 단위 처리 방식에서 벗어나, 연속 프레임 간 중복 정보를 제거하고 이벤트 중심의 표현을 구성함으로써, 이미지 기반 작업과의 성능 차이를 최소화하였다. 특히 이 방식은 inference 시에 직접적인 토큰 수 절감을 가능케 하며, long-form 비디오 처리에 적합하다. 다만 이 역시 frame sequence 분석과 클러스터링을 전제로 하기 때문에 온라인 환경에서는 latency 부담이 존재한다. ATP-LLaVA는 Adaptive Token Pruning이라는 메커니즘을 통해 계층별로 중요도가 낮은 시각 토큰을 제거함으로써 전체 토큰 수를 평균 75%까지 감소시키면서도 성능 저하를 2% 미만으로 유지하였다. 특히 SAP(Spatially Augmented Pruning) 기법은 spatial relationship을 유지하면서 pruning을 수행하기 때문에 시각 정보의 일관성을 보존할 수 있다. 이는 일반적인 LLaVA 기반 멀티모달 태스크에서도 적용 가능하며, fine-tuning 없이도 범용적으로 사용될 수 있는 장점이 있다. FlashSloth는 contrastive learning 기반의 시각 토큰 선택 기법을 도입하여 의미 있는 지역(salient region)만을 선택적으로 인코딩하는 구조를 설계하였다. Embedded Query 모듈(EmbQ)은 salient region과 대응되는 query token을 학습하고, Spatial Attention Pooling을 통해 9배 이상의 토큰 압축을 달성하였다. 이 방식은 학습 비용이 적고, 모델의 판단 근거가 되는 시각적 주의를 설명 가능한 형태로 보존할 수 있기 때문에 모바일 디바이스 등 low-resource 환경에서도 explainability 확보에 강점을 가진다. 다만 압축 비율이 높아질수록 미세한 시각 정보의 손실 가능성이 존재한다. BlueLM-V-3B는 모바일 환경에 최적화된 Multimodal LLM으로, 2.7B 규모의 LLM과 400M SigLIP 기반의 비전 인코더를 결합하고, 최대 384px 해상도에 최적화된 Dynamic Resolution Processor 및 Token Downsampler를 설계하였다. 4-bit 양자화까지 적용된 이 구조는 MediaTek 칩셋 환경에서도 초당 24.4 토큰의 추론 속도를 확보했으며, inference latency가 매우 짧다는 장점이 있다. 그러나 384px 제한은 fine-grained reasoning이 필요한 의료 영상이나 객체 탐지 등에는 제한적일 수 있다. 마지막으로 VLsI는 대규모 VLM의 추론 과정을 3배 이상 작은 모델로 distillation하는 구조를 제안하였다. 이 구조는 Layer-wise Verbalization, Interaction, Reinforcement의 세 단계를 거치며 대형 모델의 reasoning 능력을 소형 모델로 효과적으로 이전시킨다. 이를 통해 edge 환경에서도 고품질 reasoning 성능을 확보할 수 있으며, 파라미터 수 대비 높은 정확도를 보인다. 다만 teacher 모델의 품질과 적합성이 결과에 큰 영향을 주며, 완전한 독립적 성능 확보에는 한계가 있다. 요약하자면, 효율성 향상을 위한 전략은 크게 세 가지 축으로 분류된다. 첫째, FastVLM과 BlueLM-V-3B처럼 인코더 수준에서 연산량 자체를 줄이는 구조적 최적화. 둘째, PVC, ATP-LLaVA, FlashSloth처럼 토큰 수준에서 시각 정보를 선택적으로 요약 또는 제거하는 pruning 및 compression 방식. 셋째, VLsI와 같은 knowledge distillation 기반의 모델 경량화 방식이다.

🎥 Video LLM – 심화 질문과 정제된 답변

Q1. 기존 Video LLM은 왜 절대 시간(absolute time)에 의존하면 일반화에 실패하는가?

✅ 사고 과정:

- 절대 시간(Absolute Time): 영상 내 한 장면의 timestamp 또는 frame index는 영상마다 다르며, FPS, 편집 방식, 길이 등에 따라 달라짐

- 예: “5초에 등장한 장면”은 다른 영상에서는 무관한 위치일 수 있음 → 일반화 불가

- 기존 모델은 “절대 시간 → 시맨틱 이벤트”를 직접 맵핑하려 시도했으나, 이는 모델이 본 적 없는 영상 구조에 대해서 취약함

📌 해결책 – 상대적 위치 토큰 (Relative Position Token, RPT)

- Seq2Time은 프레임의 상대 위치(0~1 정규화)를 활용하여 “앞, 중간, 뒤” 같은 위치 개념을 일반화된 구조로 학습

- 이를 문자 기반 토큰 (<0><3><8><6>)으로 분해하여 언어 모델이 처리 가능하게 함

📈 효과:

- 다양한 길이, 다양한 FPS의 영상에서도 위치 개념을 일관되게 처리

- 학습 데이터보다 더 긴 비디오에서도 temporal grounding 성능 유지

✅ 결론:

절대 시간은 구조적 불일치를 야기하지만, 상대적 위치는 범용 시계열 구조 학습을 가능하게 하며, 이는 긴 비디오에서의 시간 정렬을 위한 핵심 조건이다.

Q2. 장시간 비디오에서 중요한 프레임을 선택하는 기준은 어떻게 정의되어야 하는가?

✅ 사고 과정:

- 긴 비디오에는 수백~수천 프레임이 존재 → 메모리, 토큰 한계로 인해 모두 처리 불가

- 따라서 “질문에 관련 있는 프레임만 선택”하는 것이 필수적

📌 DynFocus의 전략 – Event Prototype 추출 + DPE

- 각 프레임의 feature vector를 기반으로 로컬 밀도(ρ)와 거리(δ)를 측정 → ρ⋅δ가 높은 프레임 = 이벤트 중심

- 클러스터링 없이도 이벤트적 중요도 기반의 후보 선정 가능

- 이후 MLP를 통해 질문과의 관련성 scoring → top-K만 정밀 인코딩

🧠 철학적 논의:

- 인간 시각 시스템도 peripheral vision에서는 의미 있는 변화에만 집중함 (생물학적 동기)

- “중요하다”는 정의를 질문과의 정합성(Q → F relevance)으로 수치화한 점이 모델의 핵심 기여

✅ 결론:

“중요한 프레임”은 고정된 기준이 아닌, 질문에 따라 동적으로 정의되어야 하며, 이를 위해서는 DPE처럼 질의-프레임 정합성을 학습 기반으로 평가하는 구조가 필요하다.

Q3. 계층적 구조(VideoTree)는 reasoning 성능을 향상시키는가, 아니면 단지 압축의 한 방식일 뿐인가?

✅ 사고 과정:

- 계층적 구조(Hierarchical Structure)는 단순히 압축(token reduction)만을 위한 방식인가, 아니면 추론(logical chaining) 자체를 개선하는가?

📌 VideoTree의 전략:

- 영상 전체를 먼저 시각적 클러스터링 → 각 cluster 중심 프레임에 대해 LLM이 relevance 판단

- 관련성이 높은 클러스터에 대해 depth expansion 수행 → 계층적으로 관련 장면만 정밀 추출

- 마지막에 시간 순서로 keyframe caption들을 정렬 → 문서 구조화된 context 생성 → LLM 입력

📈 Reasoning 향상 측면:

- LLM은 GPT 구조상 linear input sequence에 강함

- 계층 구조는 irrelevant frame을 제거하고, logical anchor만으로 context를 구성함으로써, reasoning 과정에서 chain quality 향상에 기여

- 특히 multi-hop 질문에서 scene 간 인과 추론의 정렬 순서가 개선됨

🤔 단순 압축과의 차이점:

- 압축만을 위한 구조였다면 relevance 판단 없이 uniform sampling이나 단순 간격 프레임 선택을 했을 것임

- VideoTree는 reasoning의 중간 anchor로서의 프레임을 선택한다는 점에서 질적으로 다름

✅ 결론:

계층 구조는 단순 토큰 절감이 아니라, 추론을 위한 정보의 흐름과 정렬을 구조화하는 데 기여하며, reasoning performance 자체의 향상을 가능하게 한다.

🧠 Hallucination Mitigation – 심화 질문과 정제된 답변

Q4. Attention 조작 기반 환각 완화와 Feature 공간 제거 방식은 어떤 트레이드오프를 갖는가?

✅ 사고 과정:

- LVLM의 환각은 주로 attention weight의 집중 위치 또는 언어 prior가 투영된 feature space에서 비롯

- 이에 따라 크게 2가지 대응 전략이 있음:

- Attention map 조작 – 모델의 집중 위치를 바꾸어 환각 완화

- Feature space 수정 – 아예 언어편향적 표현공간 자체를 제거

📌 대표 논문:

- Devils in Middle Layers → attention lens + VAR/SVAR 기반 중간 레이어 attention 조정

- Nullu → LLM이 학습 중 환각을 강화한 하위공간 HalluSpace를 찾아내고 null space로 투영

⚖️ 비교: 구조 보존 vs. 구조 재구성

| 구분 | Attention 조작 (Devils) | Feature Space 제거 (Nullu) |

| 구조 보존 | LLM 구조 유지 | 내부 표현 공간 변경 |

| 해석 가능성 | 높음 (attention lens 시각화 가능) | 낮음 (embedding space 차원 해석 어려움) |

| 적용 편의성 | 경량 플러그인, 실시간 적용 | 플러그인 방식이지만 사전 분석 필요 |

| 적용 범위 | attention bias 기반 환각 | prior bias 기반 환각 |

🤔 실제 활용 시 고려:

- attention 기반 접근은 경량화 및 fine-tuned LLM에 적합

- feature space 제거는 환각 원인이 더 근본적일 때 (pretraining bias) 유효

✅ 결론:

Attention 조작은 구조를 유지하며 부작용이 적은 반면, Feature space 투영은 보다 근본적인 언어 편향 제거에 유효하나 구조 수정이 수반된다. 상황에 따라 현상 완화 vs. 원인 제거로 선택해야 한다.

Q5. Contrastive Decoding 기반 접근법은 왜 샘플/토큰/상황에 따라 동적으로 구성되어야 하는가?

✅ 사고 과정:

- Contrastive Decoding(CD)은 원본 입력 vs. 왜곡 입력 간 출력 차이를 이용해 환각을 줄이는 방식

- 하지만 대부분의 CD 방식은 모든 토큰, 모든 샘플에 동일한 전략을 적용함 → 비효율적

🤔 환각은 동질적이지 않다:

- hallucination type:

- 객체 환각 (존재하지 않는 사물)

- 속성 환각 (색, 모양 등 왜곡)

- 위치 환각, 시계열 환각 등 다양

- 각 환각은 다른 원인과 다른 대응을 요구

📌 Octopus의 전략:

- 생성 단계마다 eye token을 삽입해 환각 발생 여부를 감지

- 각 token에 대해 4가지 디코딩 전략 중 하나를 선택

- 선택은 DPO(RL 기반 policy) 로 학습된 controller가 수행

📉 정적 방식의 한계:

- static CD는 항상 동일한 전략을 적용 → 불필요한 연산, 과적응

- 예: 속성 환각에 객체 중심 보정 전략을 쓰면 효과 없음

🧠 장점:

- Token-level granularity → 미세 조정

- 상황 반응형 구조 → 환각 원인 추론 및 적합한 action 적용

✅ 결론:

환각의 다양성과 발생 조건의 이질성을 고려할 때, 디코딩 전략은 정적 구조가 아닌 동적 선택 구조가 되어야 하며, Octopus는 이를 RL 기반으로 실현한 최초의 구조적 사례이다.

Q6. 기존 평가 메트릭(VAR, SVAR, logit gap 등)은 환각 탐지에 충분히 민감한가?

✅ 사고 과정:

- 환각 측정은 단순 “정답/오답”만으로는 부족하며, 정답이 아닌 이유까지 파악해야 함

- 기존 메트릭:

- VAR (Visual Attention Ratio): 시각 토큰에 집중한 비율

- SVAR: 전체 누적 attention score

- Logit gap: hallucinated vs. ground-truth logit 차이

⚠️ 한계점:

- 모델 구조 의존성:

- 일부 모델은 전 레이어에 attention이 분산되어 SVAR이 무의미해짐 (Devils 논문의 지적)

- 환각 유형 미구분:

- 객체/속성/위치/관계 환각 등 구별 없이 일괄 측정

- 후처리 기반 지표는 inference latency를 유발하며 실시간 사용에는 부적합

💡 대안 및 보완 가능성:

- Token-level agreement: model prediction과 external verifier 또는 GT 간 일치율

- Rationale consistency score: 환각이 발생한 문맥과 모델 rationale 간 모순성 측정

- Entropy-aware logit analysis: 낮은 entropy + high confidence일 때 환각 가능성 증가

✅ 결론:

현재의 환각 측정 지표는 일부 환각 유형과 모델 구조에 한정되어 있으며, 향후에는 환각 원인 분류 기반의 다중 지표 구성과 동적 평가 지표가 필요하다.

🏥 Medical VLM – 심화 질문과 정제된 답변

Q7. MedRegA 같은 region-centric 구조는 실제 clinical workflow에서 어떻게 활용 가능한가?

✅ 사고 과정:

- 기존 VLM 기반 보고서는 대부분 전역(global) 이미지 단위의 요약 설명 제공

- 하지만 임상에서는 “어느 부위를 보고 그런 판단을 내렸는가?”가 핵심

→ 설명의 공간적 근거(visual grounding) 가 없다면 의료인은 판단을 신뢰하지 않음

📌 MedRegA의 구조적 특징:

- Region-level 인식 구조: segmentation 없이도 region 중심 reasoning 구조 학습

- Regional Chain-of-Thought: 설명이 특정 위치를 기준으로 전개됨

- 다중 modality(MRI, CT, Ultrasound 등) 에 대해 각기 다른 region attention path 학습

🧠 Clinical workflow에서의 접점:

| 단계 | 일반 VLM | Region-centric VLM (예: MedRegA) |

| 영상 판독 | 전역적 서술 (“폐렴 가능성 있음”) | 국소적 근거 제시 (“우상엽 불투명 음영”) |

| 진단 보고서 | 캡셔닝 기반 자동 생성 | 시각적 근거가 명시된 설명 |

| 피드백 루프 | 불가능 또는 opaque | 특정 부위 수정 및 학습 가능 |

✅ 결론:

Region-centric 구조는 의료 workflow의 핵심인 “판단 근거의 시각화”를 가능하게 하며, 이는 임상에서 해석 가능성과 신뢰성의 필수 전제 조건이다. MedRegA는 이를 위한 모델 구조 및 학습 방법론을 체계화한 첫 사례 중 하나이다.

Q8. 의료 도메인에서 RAG(Retrieval-Augmented Generation)의 한계는 무엇인가?

✅ 사고 과정:

- 의료 영상은 본질적으로 사실 기반(factual) 판단이 요구됨

- RAG는 외부 지식으로 모델 응답의 정합성(factuality)을 높이기 위한 대표 전략임

- 그러나 의료에 적용할 경우 retriever 정확도, 도메인 미스매치, latency 등 새로운 문제가 발생

📌 MMed-RAG의 대응 전략:

- Domain-aware Retriever: 영상만 보고 방사선, 병리 등 도메인 분류

- Adaptive-k: retrieval 수를 고정하지 않고 CLIP score 경사 기반으로 동적으로 조절

- Preference Fine-Tuning: retrieved context가 포함된 응답 vs. 없는 응답 비교 → better alignment 학습

⚠️ 한계:

- 각 도메인별로 retriever 사전 구축 필요 → 확장성 제약

- CLIP 기반 유사도는 미세한 의미 구분에 취약

- noisy retrieval 발생 시 hallucination이 오히려 강화될 수 있음

📈 미래 방향:

- Multi-domain retriever의 pretraining

- Retrieved 문맥의 rationale filtering (예: GPT-4 기반 예측 설명과 비교)

- Dynamic reranking based on medical QA context

✅ 결론:

MMed-RAG은 의료에서의 RAG 적용을 정밀하게 튜닝한 구조이지만, retriever 성능, 문맥 선택 품질, latency라는 고유 제약을 완전히 해결하진 못했다. RAG의 미래는 retrieval 품질 향상 + generation 일관성의 이중 최적화에 달려 있다.

Q9. Tabular 기반 의료 예측에서 LLM은 어느 수준까지 도움을 줄 수 있는가?

✅ 사고 과정:

- Tabular 데이터는 수치/범주형 구조로, 텍스트 기반 LLM이 직접 처리하기엔 비효율적

- 반면, LLM은 의료 텍스트 지식(질병, 증상, 약물 등)을 폭넓게 보유

- 이 둘을 연결하기 위한 전략이 필요

📌 SERSAL의 혁신:

- Small model이 LLM의 knowledge를 트리거(trigger)

→ LLM → Small model → 다시 LLM fine-tune → 상호 반복 학습 - Dividemix 기반 noisy label filtering을 통해 신뢰도 높은 예측 샘플만 사용

🤔 평가 기준:

- 수치 연산 정확도 자체는 여전히 LLM이 약함

- 하지만 “수치 + 의료 개념”을 연관짓는 해석 기반 추론에는 LLM의 도움 큼

향후 확장:

- tabular ↔ text 간 hybrid embedding 공간 구성

- LLM 내부 레이어에서 수치 연산 기반 reasoning path 추출

- 다중 루프 학습 안정화 조건 공식화

✅ 결론:

LLM은 tabular prediction 자체의 numerical 성능을 높이긴 어렵지만, 도메인 지식 기반 해석적 추론을 통해 그 위에 설명력과 결론의 일관성을 더할 수 있다. SERSAL은 이를 LLM-small model 상호 트리거링 구조로 실현한 실험적 패러다임이다.

⚙️ Efficiency – 심화 질문과 정제된 답변

Q10. 시각 인코더 최적화(FastVLM)는 언어-비전 정렬 성능을 얼마나 보존하는가?

✅ 사고 과정:

- 기존 ViT 기반 시각 인코더는 해상도 증가 시 토큰 수, 연산량(FLOPs), 메모리 사용량이 기하급수적으로 증가

- 하지만 고해상도 영상(차트, 텍스트 포함 이미지)에서는 해상도가 곧 의미 보존과 직결됨

→ 성능과 효율 간 non-linear trade-off 존재

📌 FastVLM의 기여:

- FastViTHD라는 경량화된 hybrid 시각 인코더 사용

- 입력 해상도는 그대로 유지하면서도 불필요한 시각 토큰을 줄이는 구조

- 복잡한 pruning 없이도 3.2× inference 속도 개선, token 75% 감소

⚖️ 정렬 품질 유지 여부:

- VQA, captioning 등 coarse-grained task에서는 기존 ViT 대비 95% 이상 정확도 유지

- 하지만 **fine-grained task (e.g., object localization, medical diagnosis)**에서는 해상도 손실로 인해 시멘틱 정렬 오류 발생 가능

✅ 결론:

FastVLM은 전역적 의미 정렬(global alignment)에선 큰 성능 저하 없이 연산 효율을 극대화할 수 있지만, **정밀한 객체-level의 언어-비전 정렬(fine alignment)**이 필요한 작업에는 여전히 보완이 필요하다. 이러한 trade-off는 task 유형에 따라 유연하게 접근되어야 한다.

Q11. 압축(PVC), 프루닝(ATP), 증류(VLsI) 기법은 어떤 task별 trade-off를 가지는가?

✅ 사고 과정:

- 세 가지 접근 방식 모두 목표는 토큰 수 축소 + 추론 속도 개선

- 하지만 모델의 “의미 보존 범위”와 연산적 부담이 다름

📌 세 가지 방식 비교:

기법 특징 강점 한계

| PVC | Progressive Video Compression | 장/단 영상 모두 통합 처리, redundancy 제거 | 장면 전이 추론은 어려움 |

| ATP-LLaVA | Adaptive Pruning by Instance + Layer | Layer-wise pruning + task-aware 동적 판단 | 연산 경로 복잡, latency 가능성 |

| VLsI | Layer-wise Verbalized Distillation | Teacher 모델 reasoning path 압축 | Teacher 의존성 높음 |

🎯 Task별 적합성:

- 비디오 QA / 요약: PVC 적합 – 전체 장면 흐름 보존 + 압축 가능

- VQA, chart reading: ATP → 정보의 핵심만 빠르게 추출

- Edge device deployment: VLsI → 소형 모델로 전환 가능

✅ 결론:

각 토큰 절감 전략은 효율성-정밀도 사이에서 위치가 다르며, 사용하려는 태스크(task)의 정보 분산 패턴에 따라 적절한 전략을 선택하는 것이 핵심이다. 하나의 모델로 모두를 해결하려는 접근보다 multi-strategy hybrid 구성이 점점 더 중요해지고 있다.

Q12. 모바일 환경에서 contrastive selection(FlashSloth)은 explainability와 어떤 관계를 가질 수 있는가?

✅ 사고 과정:

- 모바일에서는 연산 자원이 제한되어 전체 시각 정보를 전달할 수 없음

- 따라서 중요한 시각 요소만 추출하여 모델에 전달하는 contrastive selection이 필요함

📌 FlashSloth의 핵심 전략:

- SAP(Spatial Attention Pooling) + **EmbQ(Embedded Query Module)**를 통해 salient region을 동적으로 추출

- 총 9× compression → 모바일 환경에 적합

- Token 선택은 embedding 기준으로 contrastive 방식으로 선택됨 → gradient-free 방법

🧠 Explainability 측면 분석:

- 선택된 token들은 실제로 어떤 object/region이 중요한지 모델이 판단한 근거를 보여주는 셈

- 따라서 선택 결과는 explainability를 위한 "attention heatmap"과 유사한 역할 가능

향후 확장 방향:

- 선택된 토큰을 시각적으로 시각화하여 사용자에게 근거 제시

- 의료 이미지나 법적 문서 처리에 활용 시 "왜 이 토큰을 선택했는가?" 를 정당화할 수 있는 explanation token trace 개발 가능

✅ 결론:

FlashSloth의 contrastive token selection은 단순히 연산 최적화 기법이 아니라, 모델의 시각적 주의가 어디에 쏠렸는지를 명시적으로 드러낼 수 있는 explainability tool로 확장될 수 있다. 이는 특히 모바일 환경에서 신뢰성 확보에 중요한 요소가 된다.

이로써 다섯 분야(🎥 Video LLM, 🧠 Hallucination, 🏥 Medical VLM, ⚙️ Efficiency)에 대한 12개 고차원 질문과 정제된 사고 기반 응답을 마무리했습니다.

필요하다면 이를 보고서, 발표용 요약본, 슬라이드, 평가표 형태로도 정리해드릴 수 있습니다.

이제 어떤 형태로 활용하시겠습니까? 또는 다른 논문 주제로도 이런 고차원 질문을 만들어볼까요?

🎥 비디오-언어 모델 (Video LLM)

Q1. 현재 Video LLM의 기술 수준은 어느 정도인가요?

A:

Video LLM은 짧은 비디오 요약, 시각 질문응답, 장면 수준 요약 등에서 좋은 성과를 보이고 있습니다. 일부 모델은 사람에 가까운 응답 품질도 보이지만, 다음과 같은 문제가 여전히 존재합니다:

- 긴 영상에서 시간 흐름 파악 어려움

- 객체 단위의 정밀한 행동 이해 부족

- 실시간 상호작용 대응 미흡

Q2. Video LLM이 시간 추론에 약한 이유는 무엇이며, 어떻게 개선할 수 있나요?

A:

제약점:

- 시간 정보와 언어 간의 불일치 (Temporal Misalignment)

- 프레임 중복 및 불필요한 정보

- 시간 주석 데이터 부족

해결책:

- 상대적 위치 토큰 사용 (Seq2Time)

- 계층적 프레임 선택 구조 도입 (VideoTree)

- 질문 중심 동적 토큰 선택 (DynFocus)

Q3. Video LLM은 왜 객체 수준 추론에 약한가요?

A:

기존 모델은 장면 전체에 대한 이해는 가능하지만, 다음과 같은 세부 추론에는 한계가 있습니다:

- 복수 객체 간 상호작용 이해

- 객체의 시공간적 변화 추적

- 특정 위치에 대한 집중(grounding) 부족

해결책:

- 객체 중심 데이터셋 구축 (예: VideoRefer-700K)

- 시공간 객체 인코더 활용

Q4. 실시간 영상 이해를 위한 Video LLM의 전략은 무엇인가요?

A:

Dispider는 실시간 처리를 위해 다음 3단계를 분리합니다:

- Perception: 중요한 장면 감지

- Decision: 응답 시점 판단

- Reaction: LLM 응답 생성

→ 이를 통해 영상 처리와 응답이 동시에 이루어져 blocking 현상이 줄어듭니다. 단, decision 모듈의 오탐률이나 정렬 정확도는 개선이 필요합니다.

🧠 환각 (Hallucination) 완화

Q5. LVLM에서 객체 환각(Object Hallucination)의 근본 원인은 무엇인가요?

A:

- 언어 기반 편향(language prior): 실제로 보지 못한 객체를 plausibly 생성

- 어텐션 불균형(attention misalignment): 시각 정보보다 텍스트 토큰에 주의를 집중

Q6. 학습 없이도 환각을 줄일 수 있는 방법은 어떤 것이 있나요?

A:

- AGLA: inference 시 global-local attention 융합

- Nullu: HalluSpace라는 하위공간을 제거

- VASparse: saliency map 기반으로 중요하지 않은 토큰 제거

→ 이들은 학습 없이도 쉽게 적용 가능하며, 실제 시스템에 실용적입니다.

Q7. 왜 동적 디코딩(Octopus) 같은 접근이 필요한가요?

A:

환각의 원인과 양상이 토큰, 샘플, 시간마다 다르기 때문입니다.

Octopus는 eye token을 통해 원인을 식별하고, 4가지 전략 중 상황에 맞는 디코딩 방식을 동적으로 선택합니다.

🏥 의료 VLM

Q8. 의료 영상에서 VLM 적용 시 가장 큰 과제는 무엇인가요?

A:

- 도메인 지식 부족: 일반 LLM은 의료 지식이 없음

- 해석 불가: 진단 결과가 어떤 부위 기반인지 불명확

- 환각: 그럴듯하지만 틀린 의학적 설명 생성

Q9. MMed-RAG 같은 검색 기반 생성(RAG)은 어떻게 진단 신뢰성을 높이나요?

A:

MMed-RAG는 의료 영상 입력 시 자동으로 도메인을 식별하고, 그에 맞는 외부 문헌을 검색하여 답변을 근거 기반으로 생성합니다.

- adaptive-K로 관련도 높은 문서만 선택

- preference fine-tuning으로 응답 정합성 강화

Q10. 왜 지역 기반(region-level) 해석 가능성이 중요한가요?

A:

전체 이미지를 요약하는 것만으로는 중요한 병변을 놓칠 수 있습니다.

MedRegA는 어떤 부위를 근거로 판단했는지 명확히 보여주어 의사의 신뢰도를 높입니다.

⚙️ 효율성 (Efficiency)

Q11. 최근 VLM은 어떻게 토큰 효율을 개선하면서 정확도를 유지하나요?

A:

- FastVLM: FastViT 구조로 속도 3.2배 향상

- PVC: 프레임 중복 제거 기반 토큰 압축

- ATP-LLaVA: 레이어별로 필요 없는 토큰 제거

- FlashSloth: contrastive 토큰 선택 + 압축

→ 토큰 수 75~90% 감소, 정확도는 거의 유지

Q12. 모바일 기기에서 효율적인 VLM을 위해 사용할 수 있는 하이브리드 전략은?

A:

- 해상도 동적 조정 (예: BlueLM-V-3B, 384px 제한)

- 시각 주의 기반 토큰 선택 (예: FlashSloth)

→ 추론 속도는 빠르지만, 고해상도 세부 정보는 일부 손실될 수 있습니다.

🔍 개요: 환각(Hallucination) 문제

LVLM은 종종 존재하지 않는 객체나 속성을 생성하는 "환각" 문제를 겪습니다. 이는 주로 시각적 정보와 텍스트 정보 간의 부정확한 정렬에서 비롯됩니다. 이에 대해 여러 연구들이 attention 조정, 디코딩 전략, subspace projection 등 다양한 방식으로 대응하고 있습니다.

📄 6편의 핵심 논문 요약

1. Devils in Middle Layers of LVLMs

- 핵심: 중간 레이어의 attention 메커니즘이 환각의 원인임을 분석

- 기법: Attention Lens 도입

- 시각 정보 강화: 시각 정보를 객체 토큰으로 전달

- 의미 정렬: 시각-텍스트 정렬을 보정

- 측정: Visual Attention Ratio (VAR), Summed VAR(SVAR)

- 효과: CHAIR 벤치마크에서 환각을 1.7배 감소

과제 겸 논문 리뷰 - Devils in Middle Layers of Large Vision-Language Models: Interpreting, Detecting and Mitigating Objec

https://arxiv.org/abs/2411.16724 Devils in Middle Layers of Large Vision-Language Models: Interpreting, Detecting and Mitigating Object Hallucinations via AttentHallucinations in Large Vision-Language Models (LVLMs) significantly undermine their reliabili

yoonschallenge.tistory.com

2. AGLA: Assembly of Global and Local Attention

- 핵심: 지역 정보에 대한 attention 부족 문제 해결

- 기법: 전역/지역 이미지 특징을 결합

- 특징: 학습 불필요, 로짓을 보정하여 grounding 강화

- 응용: 생성/판별 과제 전반에 적용 가능

3. Nullu: HalluSpace Projection

- 핵심: LLM의 prior에서 유도된 HalluSpace를 제거

- 기법: 모델 가중치를 HalluSpace의 null space로 투사

- 효율: 파인튜닝 없이 모든 LVLM에 적용 가능, 연산 비용 없음

4. FarSight: Attention Causal Decoding

- 핵심: 환각의 두 가지 원인(초기 오해, 점진적 전파) 동시 대응

- 기법: 인과 마스킹 + 위치 인식 인코딩

- 효과: 토큰 간 상호작용을 개선하여 영상 및 이미지 성능 향상

5. Octopus: Dynamic Contrastive Decoding

- 핵심: 객체/속성 등 다양한 환각 유형에 따라 디코딩 전략을 동적으로 조절

- 기법: Contrastive Decoding(CD)의 워크플로우를 상황별로 변화

- 효율: 계산 비용 거의 없이 SOTA 성능 달성

6. VASparse: Visual-Aware Token Sparsification

- 핵심: 불필요한 토큰을 제거하여 계산 효율화

- 기법: 시각적으로 중요한 토큰만 선택하여 contrastive 보정 수행

- 효과: 환각 4% 감소, 추론 속도 유지

📊 비교 분석

🔸 공통 문제점

| Attention 중복 | 전역 정보나 불필요한 특징에 과도하게 집중 |

| LLM의 언어적 편향 | 시각적 단서보다 언어 prior를 더 신뢰 |

| 토큰 간 상호작용 부족 | 중간/깊은 층에서 시각-언어 정렬 실패 |

🔸 유사점

| Attention 분석 | 모든 논문이 attention 조작 또는 분석에 기반 |

| 디코딩 전략 활용 | Contrastive Decoding, causal masking, logit 보정 등 디코딩 방식 사용 |

| 학습 불필요 | AGLA, Nullu, FarSight, Octopus, VASparse는 파인튜닝 없이 적용 가능 |

🔸 주요 차이점

| 논문 | 핵심 아이디어 | 적용 범위 | 한계 |

| Devils | 중간 attention 수정 | 객체 환각 | 중간 레이어 한정 |

| AGLA | 전역-지역 특징 결합 | 일반 LVLM 과제 | 이미지 증강 필요 |

| Nullu | HalluSpace 제거 | 모델 전반 | 서브스페이스 식별 필요 |

| FarSight | 인과 마스킹 기반 디코딩 | 영상/이미지 LVLM | 마스크 설계 복잡 |

| Octopus | 동적 CD 전략 | 다양한 환각 유형 | 유형 감지 필요 |

| VASparse | 토큰 희소화 + CD | 효율 지향 | 정밀 정보 손실 가능성 |

🔚 결론 및 제언

- 공통 원인: Attention misalignment와 언어 prior bias가 환각의 핵심 원인

- 전략별 분류:

- Feature 중심: AGLA, VASparse → 시각 grounding 개선

- Attention 조정: Devils, Nullu → 모델 내 메커니즘 직접 수정

- 디코딩 최적화: FarSight, Octopus → 추론 과정에서 환각 완화

활용 제안:

- 실시간 추론 → AGLA, VASparse

- 모델-불문 대응 → Nullu, Devils

- 복합 환각 대응 → Octopus, FarSight

향후 연구 방향: 중간 attention 조정(Devils)과 동적 디코딩(Octopus)을 통합한 하이브리드 전략이 유망.

🎬 주요 논문 요약

1. Seq2Time: Sequential Knowledge Transfer

- 핵심: 긴 영상에서의 시간 정렬(temporal grounding) 개선

- 방법: 이미지/클립 위치를 상대적 위치 토큰으로 변환해 시간 정보를 유추하는 자기지도 학습 구조 설계

- 성과: YouCook2에서 F1 27.6%, CIDEr 44.8% 향상

📌 논문 링크

좋습니다. 질문 주신 Seq2Time 논문에서 ‘긴 영상에서 시간 정렬(temporal alignment)’을 어떻게 개선했는지와 관련된 개념들을 명확히 설명드리겠습니다.

✅ 핵심 질문 정리

❓ “시간 정렬을 개선했다”는 게 무슨 뜻인가요?

→ 영상 속의 사건(event)이 발생한 시점(start-end time)을 모델이 정확히 예측하거나 인식하도록 하는 능력입니다.

예를 들어, “물을 끓이는 장면”이 실제 영상에서는 90초 ~ 120초에 나오는데, 모델이 이를 50초 ~ 80초로 예측한다면 temporal misalignment가 발생한 것이죠.

❓ Seq2Time은 어떻게 이걸 개선했나요?

🔷 핵심 전략 1: Self-supervised Learning (자기 지도 학습 기반)

- 긴 영상을 직접 레이블링(타임스탬프 주석)하는 건 너무 비싸고 비효율적입니다.

- 그래서 Seq2Time은 이미지 시퀀스와 짧은 클립들을 조합해서 “긴 영상처럼” 만들고, 이를 기반으로 자기 지도 학습 pretext tasks를 설계합니다.

- ✳️ 이 과정에서 “시간 위치 = 시퀀스 내 위치(index)”라고 보고 학습합니다.

✅ 세부 구성 설명

1️⃣ Unified Relative Position Token (RPT)

❓ 이게 뭔가요?

→ 절대적인 시간(초, 프레임 수) 대신 상대적인 위치를 정규화(normalized index) 해서 토큰으로 표현하는 방식입니다.

예시:

- 총 96개의 이미지 시퀀스 중 7번째 이미지라면:

- 정규화된 위치는 7 / 96 = 0.0729

- 이걸 4자리 소수로 바꿔서 → <0><7><2><9> 라는 식으로 LLM에 입력

왜 중요한가요?

- 영상마다 길이도 다르고 FPS도 달라 절대 시간은 일반화가 어려움

- 반면 상대적인 위치(앞/중간/뒤) 정보는 다양한 영상에서도 일관된 추론 가능

2️⃣ 자기 지도 학습 구조 (Image/Clip 기반 Pretext Tasks)

📦 이미지 시퀀스 기반 Pretext Task 3가지:

| 이름 | 설명 시간 | 인식과의 연결 |

| IIG (Image Index Grounding) | "이 설명과 일치하는 이미지는 몇 번째인가?" | 시점(시작 시간) 추정 유사 |

| IIC (Indexed Image Captioning) | "X번째 이미지를 설명해보세요" | 특정 시간의 시각적 내용 이해 |

| ALR (Adjacent Location Reasoning) | "이 장면 다음엔 뭐가 나올까요?" | 시계열 순서 이해 향상 |

📦 클립 시퀀스 구성 방식:

- Kinetics-700에서 10초짜리 클립들 조합해 2~10개씩 붙여 긴 영상처럼 만듬

- 각 클립에는 LongVA 모델로 생성한 캡션이 있음

- 시퀀스 내 위치를 RPT로 부여하여 시간 인식 학습

✅ 어떻게 “시간 정렬 능력”이 개선되었는가?

📈 성능 향상:

- YouCook2 (dense captioning)에서 F1 score +27.6%, CIDEr +44.8%

- Charades-STA (temporal grounding)에서 R@1 (IoU=0.7) +17.1%

📌 왜 이게 가능한가?

- 이미지와 클립의 시퀀스 위치 정보가 시간 개념으로 작동

- 상대 위치를 통해 “앞-중간-뒤” 순서를 명확히 학습

- caption과 위치를 연결해 놓으니 실제 영상에 투입했을 때, 시간 감각이 생긴 것처럼 동작함

✅ 요약: 질문에 대한 직접 답변

✔ “긴 영상에서 시간 정렬을 개선했다”는 의미는?

→ LLM이 영상 내 이벤트의 시작-끝 시간을 더 정확히 예측하고, 그 순서를 논리적으로 배열하는 능력이 좋아졌다는 뜻입니다.

✔ “상대적 위치 토큰”이란?

→ 이미지나 영상 내의 상대적인 순서를 정규화된 소수(0.0000~1.0000) 형태로 표현한 토큰입니다. 예: <0><7><2><9>

✔ “자기 지도 학습 구조”란?

→ 사람이 직접 시간 레이블링을 하지 않고도, 이미지-설명/클립-설명 간 관계를 기반으로 시퀀스 위치를 학습 신호로 활용하는 구조입니다.

2. VideoRefer Suite

- 핵심: 객체 단위의 시공간 이해 능력 향상

- 방법: 대규모 VideoRefer-700K 데이터셋 구축, 전용 시공간 인코더 및 평가 벤치마크 제공

- 성과: 지역 이해 지표(Subject Correspondence 등) 개선

📌 논문 링크

3. Dispider

- 핵심: 실시간 상호작용을 위한 비디오 처리 구조 제안

- 방법: 인식(Perception) → 의사결정(Decision) → 반응(Reaction) 모듈을 분리한 비동기 구조 설계

- 성과: 스트리밍 환경에서 지연 시간 40% 감소

📌 논문 링크

Dispider: Enabling Video LLMs with Active Real-Time Interaction via Disentangled Perception, Decision, and Reaction

Active Real-time interaction with video LLMs introduces a new paradigm for human-computer interaction, where the model not only understands user intent but also responds while continuously processing streaming video on the fly. Unlike offline video LLMs, w

arxiv.org

Dispider: Enabling Video LLMs with Active Real-Time Interaction via Disentangled Perception, Decision, and Reaction - 논문 리

https://arxiv.org/abs/2501.03218 Dispider: Enabling Video LLMs with Active Real-Time Interaction via Disentangled Perception, Decision, and ReactionActive Real-time interaction with video LLMs introduces a new paradigm for human-computer interaction, wher

yoonschallenge.tistory.com

4. VidComposition

- 핵심: 영상 구성 분석 능력 평가

- 방법: 촬영기법, 내러티브, 인물 이해에 대한 1,706개 문항 기반의 벤치마크 구성

- 성과: MLLM이 인간(86.3%) 대비 낮은 63.3% 정확도

📌 논문 링크

5. DynFocus

- 핵심: 비디오 이해에서 토큰 효율과 시각 정보의 균형 유지

- 방법: 쿼리 관련 프레임은 DPE로 선택, 나머지는 CCE로 희소 인코딩

- 성과: EgoSchema에서 35% 적은 토큰으로 SOTA 달성

📌 논문 링크

DynFocus: Dynamic Cooperative Network Empowers LLMs with Video Understanding

The challenge in LLM-based video understanding lies in preserving visual and semantic information in long videos while maintaining a memory-affordable token count. However, redundancy and correspondence in videos have hindered the performance potential of

arxiv.org

좋습니다. 논문 DynFocus: Dynamic Cooperative Network Empowers LLMs with Video Understanding에서 말하는 "쿼리 관련 프레임은 DPE로 선택, 나머지는 CCE로 희소 인코딩"이 의미하는 바를 자세히 설명드리겠습니다. 이 구조는 장시간 영상의 효율적 처리와 질문 중심의 정보 보존을 위해 고안된 구조입니다.

🔍 1. DPE (Dynamic Event Prototype Estimation): 쿼리 관련 프레임 선택

✅ 핵심 목적:

영상에서 "질문(쿼리)"에 실제로 필요한 프레임들만 선택해 정밀하게 인코딩하겠다는 것.

✅ 작동 방식:

- 프레임별 특징을 평균 풀링하여 압축 → f_t∈R^(P×d)

- DPC-KNN 기반 클러스터링으로 이벤트 프로토타입(event prototype) 추출:

- 로컬 밀도 (ρ_t): 주변 프레임들과 얼마나 가까운가

- 거리 지표 (δ_t): 다른 밀도 높은 프레임들과 얼마나 다른가

- ρ_t⋅δ_t 값이 큰 프레임이 의미 있는 이벤트로 간주됨

- 선택된 프로토타입들을 MLP를 통해 스코어링 → 질문과 관련된 것들만 Top-K 선택

- 선택 결과는 마스크 b_t 로 표시되며,

- b_t = 1: 질문과 관련 있음 → 정밀 인코딩 대상

- b_t = 0: 질문과 무관 → 요약 인코딩 대상

💡 2. CCE (Compact Cooperative Encoding): 희소 인코딩 방식

CCE는 선택된 프레임들을 두 가지 방식으로 인코딩합니다.

🟦 (1) Cones Encoding — b_t = 1: 정밀 인코딩

- 질문에 중요한 프레임

- 해당 프레임의 다양한 시각 객체(prototype) 들을 계층적으로 클러스터링하여 풍부한 시각 정보 유지

- 이벤트 프로토타입과 시각 객체 정보들을 그대로 LLM 입력에 포함

비유: Cone 세포는 중심 시야에서 정밀한 색과 형태를 인식하듯, 중요한 프레임을 고정밀 인코딩함

🟨 (2) Rods Encoding — b_t = 0: 요약 인코딩

- 질문에 중요하지 않은 프레임

- 텍스트 임베딩을 참고하여 관련 객체 특징만 추출 후 2개의 토큰으로 요약

- 텍스트 기반 주의 + 전체 특징 요약

- 더 빠른 추론과 적은 메모리 사용 가능

비유: Rod 세포는 주변 시야에서 흐릿한 윤곽과 동작을 감지하듯, 덜 중요한 프레임은 간략하게 처리함

🔄 최종 통합 방식 (Dynamic Token Fusion)

최종적으로 각 프레임의 토큰은 다음과 같이 구성됩니다:

즉,

- 중요한 프레임은 정밀 + 요약 인코딩을 모두 포함

- 덜 중요한 프레임은 요약 인코딩만 사용

🧠 왜 이 방식이 효과적인가?

- 메모리 절약: 불필요한 프레임을 요약 처리

- 질문 중심 처리: 중요한 정보는 보존

- 시간 정렬에 강함: 시간적으로 의미 있는 프레임만 집중 처리

💬 정리

| 구성 요소 | 설명 | 역할 |

| DPE | 질문에 필요한 프레임 동적 선택 | 어떤 프레임이 중요한가? |

| CCE - Cones | 중요한 프레임 정밀 인코딩 | 세부 시각 정보 보존 |

| CCE - Rods | 중요하지 않은 프레임 요약 | 장면 흐름 유지, 메모리 절약 |

궁금한 부분이나, 그림으로 시각화를 원하시면 추가로 도와드릴게요!

6. VideoTree

- 핵심: 긴 비디오에 대한 계층적 표현 학습

- 방법: 쿼리 기반으로 coarse-to-fine 방식의 키프레임 트리 생성

- 성과: EgoSchema에서 정확도 7% 향상, 추론 속도 40% 개선

📌 논문 링크

⚠️ 공통 문제점

| 중복 프레임 | 긴 영상에 불필요한 프레임이 과도하게 포함됨 (VideoTree, DynFocus) |

| 시간적 불일치 | 시각적 순서와 시간적 질의의 상관성이 낮음 (Seq2Time, VidComposition) |

| 세밀한 객체 이해 부족 | 시공간적으로 정밀한 객체 추적이 어려움 (VideoRefer, Dispider) |

🧩 유사점

| 동적 인코딩 | Dispider, DynFocus, VideoTree는 질의 기반으로 프레임 우선순위 지정 |

| 정량적 벤치마크 중심 | VideoRefer, VidComposition은 평가를 위한 정교한 프레임워크 구축 |

| 효율성 강조 | Seq2Time, DynFocus는 파인튜닝 없이 의사레이블/모듈 설계로 효율 확보 |

🆚 차이점

| 논문 | 핵심 기법 | 적용 범위 | 한계점 |

| Seq2Time | 위치→시간 변환 토큰 | 시간 정렬 | 합성 시퀀스에 제한됨 |

| VideoRefer | 객체 중심 시공간 인코더 | 지역 기반 이해 | 연산 자원 요구 높음 |

| Dispider | 비동기 인식-결정 구조 | 실시간 인터랙션 | 복잡한 파이프라인 |

| VidComposition | 영상 구성 기반 QA | 내러티브/촬영 분석 | 편향된 영상 종류 |

| DynFocus | 쿼리 기반 동적 프레임 선택 | 토큰 효율성 | 2단계 학습 필요 |

| VideoTree | 키프레임 트리 기반 구조 | 긴 영상 QA | 클러스터링 품질에 의존 |

✅ 결론 및 제언

이들 연구는 공통적으로 비효율적인 토큰 사용과 시간-객체 정렬 부족이 영상 이해의 병목이라는 점을 지적합니다.

전략별 구분 대표 논문

| 시간 정렬 최적화 | Seq2Time, VideoTree |

| 시공간 정밀화 | VideoRefer, Dispider |

| 효율성 강화 | DynFocus |

| 고차원적 분석 평가 | VidComposition |

🔮 향후 연구 방향:

VideoTree의 계층적 표현 방식과 Dispider의 실시간 모듈 구조를 통합하면, 고속-고정밀 영상 이해 시스템 구축이 가능할 것으로 기대됩니다.

다음은 의료 분야의 LVLM(Medical Large Vision-Language Models) 관련 최신 6개 주요 논문을 요약한 내용입니다. 이 연구들은 멀티모달 정렬, 진단의 신뢰성, 도메인 적응 등의 핵심 문제를 다루며, 다양한 접근법을 통해 의료 인공지능의 실용성과 정확도를 향상시키고자 합니다.

🧬 주요 논문 요약

1. StructuralGLIP: Prompt as Knowledge Bank

- 핵심: 제로샷 기반의 의료 객체 탐지 성능 향상

- 방법: 프롬프트를 층별(Layer-wise) 지식 뱅크로 인코딩하여, 시각-텍스트 간 높은 유사도 특징을 융합

- 성과: 기존 SOTA 대비 4.1% AP 향상 (7개 벤치마크 기준)

2. SERSAL: Small Models as LLM Knowledge Triggers

- 핵심: LLM과 의료 테이블 데이터 간 연결성 강화

- 방법: LLM의 출력을 기반으로 소형 모델을 훈련시키고, 이를 통해 LLM의 예측을 반복적으로 개선

- 성과: 라벨 없이 GPT-3.5의 테이블 예측 성능 향상

3. MMed-RAG

- 핵심: 도메인 특화된 검색(RAG)을 통해 의료 환각(hallucination) 감소

- 방법: 모델의 시각 추론과 외부 지식을 동적으로 결합

- 성과: 방사선/병리 문항에서 환각률 43.8% 감소

4. MediConfusion

- 핵심: 의료 멀티모달 모델의 신뢰성 평가

- 방법: 적대적 진단 상황을 포함한 MediConfusion 벤치마크 제안

- 발견: 현재 모델들은 기본적인 진단에서도 불안정한 성능을 보임

5. VILA-M3

- 핵심: 의료 전문가 지식을 VLM에 통합

- 방법: 전문가 예측 기반 4단계 훈련 절차 도입

- 성과: 범용 VLM 대비 평균 9% 정확도 향상

6. MedRegA

- 핵심: 영역 중심(region-centric) 의료 질의에 특화된 이중언어 MLLM

- 방법: MedRegInstruct 데이터셋으로 훈련, 시각-텍스트 정렬과 해석 가능성에 중점

- 성과: 8개 모달리티를 75.02% 정확도로 처리

🩺 공통 문제점

| 환각 및 신뢰성 부족 | MediConfusion, MMed-RAG는 잘못된 진단 생성을 문제로 지적 |

| 모달 정렬 약화 | StructuralGLIP, MedRegA는 시각-텍스트 불일치를 개선하고자 함 |

| 라벨 부족 | SERSAL, i-MedRAG는 지도 학습이 어려운 의료 데이터 특성을 해결함 |

🔁 유사한 접근 방식

| 지식 검색 기반 보강 | MMed-RAG, i-MedRAG는 외부 도메인 지식을 활용하여 응답 정당성 강화 |

| 다단계 훈련 | VILA-M3, StructuralGLIP는 도메인 적응을 위한 여러 단계의 훈련 진행 |

| 해석 가능성 중시 | MedRegA, SERSAL는 임상 현장에서의 신뢰를 위한 모델 해석성 확보에 집중 |

⚖️ 주요 차이점

| 논문 | 차별점 | 적용 범위 | 한계점 |

| StructuralGLIP | 계층적 지식 뱅크 사용 | 제로샷 탐지 | GLIP 구조에 의존 |

| SERSAL | 소형 모델과 LLM의 시너지 학습 | 표형(tabular) 데이터 | 반복 훈련 루프 필요 |

| MMed-RAG | 도메인 인식 검색 통합 | 멀티모달 QA | 연산 비용 큼 |

| VILA-M3 | 전문가 기반 예측 통합 | 광범위한 의료 과제 | 전문가 주석 의존성 |

| i-MedRAG | 후속 질의 기반 동적 RAG | 복합 임상 질의 | 추론 지연 시간 증가 |

| MedRegA | 영역 중심 + 이중언어 해석 | 지역 기반 진단 | 모달리티 다양성 관리 필요 |

✅ 결론 및 제언

이들 연구는 공통적으로 의료 LLM의 환각 완화, 시각-텍스트 정렬 개선, 신뢰성 확보를 핵심 과제로 삼고 있습니다.

| 훈련 구조 개선 | StructuralGLIP, VILA-M3 |

| 검색 보강 최적화 | MMed-RAG, i-MedRAG |

| 해석성/표 형식 처리 | SERSAL, MedRegA |

🧠 향후 연구 방향:

StructuralGLIP의 층별 지식 구조와 i-MedRAG의 반복 검색 기반 질의응답을 결합하면, 임상 적용에 신뢰도 높은 종단형(end-to-end) 시스템으로 확장될 수 있음.

⚙️ 주요 논문 요약

1. BlueLM-V-3B

- 핵심: 모바일 최적화를 위한 하드웨어-알고리즘 공동 설계

- 방법: 2.7B LLM + 400M SigLIP ViT 조합, 동적 해상도 처리기(Dynamic Resolution Processor), 토큰 다운샘플러(Token Downsampler) 사용 (최대 384px 입력)

- 효율성: MediaTek Dimensity 9300에서 4bit 양자화 시 24.4 토큰/초 성능

- 한계: 고해상도 정보 손실 감수

2. PVC (Progressive Visual Token Compression)

- 핵심: 영상-이미지 통합을 위한 토큰 압축

- 방법: 프레임 간 중복 제거로 시공간 특징 보존하며 시각 토큰 압축

- 성과: 장/단 영상 과제 모두에서 성능 유지, 이미지 성능 저하 없음

3. ATP-LLaVA

- 핵심: 레이어-인스턴스 수준의 적응형 프루닝

- 방법: 각 레이어별 Adaptive Token Pruning (ATP) + 공간 구조를 보존하는 SAP(Spatial Augmented Pruning) 사용

- 효율성: 평균 75% 토큰 절감, 정확도 손실 <2%

4. FastVLM

- 핵심: 비전 인코더 최적화

- 방법: FastViT 아키텍처 + 쿼리 기반 토큰 선택으로 2~4배 속도 개선

- 성과: VQA 과제에서 95% 정확도 유지하며 FLOPs 감소

5. FlashSloth

- 핵심: 임베디드 환경에서의 시각 압축

- 방법: SAP(Spatial Attention Pooling) + EmbQ(Embedded Query Module) 조합으로 9배 토큰 압축

- 학습 효율: 사전학습에 단 6.4 GPU 시간만 소요

6. VLsI

- 핵심: 소형 모델을 위한 계층적 지식 증류

- 방법: 계층별 언어화(verbalization) → 상호작용 → 보강의 세 단계로 대형 모델의 추론을 전이

- 성과: 3배 작은 모델이 스승 모델과 유사한 VQA 성능 달성

📉 공통 문제점

| 토큰 중복 | 연속 프레임(PVC) 또는 공간 내 중복 특징(ATP-LLaVA) |

| 하드웨어 제약 | NPU/GPU 메모리 제한으로 인해 긴 입력 처리 어려움 (BlueLM, FastVLM) |

| 정확도 손실 우려 | 토큰 수를 줄이면 성능 저하 위험 (ATP-LLaVA, FlashSloth은 이를 최소화함) |

🔁 유사한 접근 방식

| 동적 처리 | BlueLM(해상도 스케일링), ATP-LLaVA(프루닝), PVC(프레임 압축) |

| 토큰 축소 | 거의 모든 논문이 토큰 수를 75~90%까지 축소함 |

| 모바일 최적화 | BlueLM(4bit 양자화), FlashSloth(경량 쿼리 모듈), FastVLM(FastViT) |

⚖️ 주요 차이점

| 논문 | 핵십 아이디어 | 적용 범위 | 한계점 |

| BlueLM-V-3B | 하드웨어-알고리즘 공동 설계 | 모바일 | 해상도 384px 제한 |

| PVC | 프레임 기반 점진적 압축 | 이미지/비디오 통합 | 프레임 시퀀스 분석 필요 |

| ATP-LLaVA | 레이어별 동적 프루닝 | 범용 LVLM | ATP 모듈의 오버헤드 존재 |

| FastVLM | FastViT + 토큰 선택 | 비전 인코더 | 작업별 토큰 설정 필요 |

| FlashSloth | SAP + EmbQ 압축 | 저자원 환경 | 압축 시 세밀한 정보 손실 우려 |

| VLsI | 계층 기반 지식 증류 | 소형 모델 확장 | 스승 모델 의존성 |

✅ 결론 및 제언

이들 연구는 시각 토큰의 중복 제거를 다양한 방식으로 해결합니다.

| 비전 인코더 최적화 | BlueLM-V-3B, FastVLM |

| 토큰 스트림 축소 | ATP-LLaVA, PVC |

| 경량 압축/증류 | FlashSloth, VLsI |

🚀 향후 방향 제안:

PVC의 프레임 압축 + ATP-LLaVA의 레이어 적응형 프루닝을 결합하면, 실시간 고해상도 멀티모달 LVLM 시스템을 구축할 수 있는 기반이 될 것입니다.

다음은 위의 Mock Test (모의시험) 내용을 한글로 정리한 번역본입니다. 문제의 구조와 표현은 학술적 정확성을 유지하면서 한국어 사용자에게 명확히 전달되도록 구성하였습니다.

💡 LVLM 모의시험

시험 정보

- 시간: 90분

- 모든 문제에 답하시오. 관련 방법론/논문을 구체적으로 인용할 것.

📘 1. 환각(Hallucination) 완화

a.

LVLM의 객체 환각은 주로 언어 기반 사전 편향(language prior bias) 및 어텐션 불일치(attention misalignment)에서 기인합니다.

이 두 가지 원인을 각각 해결한 서로 다른 논문 기반의 두 가지 기술적 접근을 설명하고, 각각의 강점과 한계를 분석하시오.

(예시: AGLA의 전역-지역 어텐션 결합, Nullu의 HalluSpace 투사, SumGD의 요약 유도 디코딩 등)

b.

학습이 필요 없는(training-free) 방식과 학습 기반(training-based) 환각 완화 전략을 비교하시오.

현실적인 응용 환경에서 어떤 방식이 더 확장성이 높은지, 구체적인 예시와 함께 설명하시오.

📽 2. 비디오 이해

a.

LVLM은 긴 영상에서의 토큰 중복(token redundancy)과 시간적 정렬 실패(temporal misalignment) 문제를 겪습니다.

이 문제를 해결하기 위한 서로 다른 논문 기반의 두 가지 아키텍처 혁신을 비교하시오.

이들이 어떻게 계산 효율성과 시공간 정확도 간의 균형을 달성하는지 설명하시오.

(예시: VideoTree의 계층적 키프레임 선택, DynFocus의 동적 토큰 프루닝, Dispider의 분리형 모듈 구조 등)

b.

VideoRefer-700K와 같은 비디오-텍스트 정렬 벤치마크가 공간 관계, 객체 속성 등 구성적 추론(compositional reasoning)을 적절히 평가하는지 비판적으로 논의하시오.

최근 논문에서 발견된 한계점을 바탕으로 답하시오.

🏥 3. 의료 응용

a.

의료용 LVLM은 도메인 적응(domain adaptation)과 환각 리스크에 직면해 있습니다.

검색 기반 생성(RAG) (예: MMed-RAG)과 전문가 지식 통합 (예: VILA-M3)이 이러한 문제를 어떻게 해결하는지 분석하시오.

이 중 어떤 접근법이 진단 신뢰성을 더 잘 보장하는지 근거와 함께 제시하시오.

b.

임상 환경에서 LVLM을 도입할 때의 윤리적 문제를 평가하시오.

특히 데이터 편향(data bias)과 해석 가능성(interpretability) 측면에서 논의하고, 이를 완화한 논문 방법론을 1개 이상 인용하여 설명하시오.

🧠 4. 토큰 효율 관리

a.

시각 토큰 중복은 LVLM의 주요 병목입니다.

다음 세 가지 전략을 비교하시오:

- 프루닝 (예: ATP-LLaVA)

- 압축 (예: PVC)

- 지식 증류 (예: VLsI)

이 중 어떤 전략이 **정밀 시각 정보(fine-grained visual details)**를 가장 잘 유지하면서 추론 속도를 개선하는지 논의하시오.

b.

동적 해상도 조절(예: BlueLM-V-3B)과 대조 기반 토큰 선택(예: FlashSloth)을 결합한 모바일 LVLM용 하이브리드 접근법을 제안하시오.

이 방식이 도입할 트레이드오프는 무엇인지 기술하시오.

🏥 5. 사례 연구 (Applied Case Study)

한 병원이 방사선 진단 보고를 위해 LVLM을 도입했으나, 15%의 사례에서 환각이 발생하고 있으며, CT 영상 시퀀스가 길어 처리에 어려움이 있습니다.

- 두 가지 이상 주제(예: 환각 완화 + 토큰 효율)를 활용하여

- 정확도, 속도, 임상 안전성 간의 균형을 고려한 해결 방안을 설계하시오.

- 제안한 방법의 기술적 타당성을 근거와 함께 설명하시오.

📄 모의시험 답안지

1. 환각(Hallucination) 완화

a. 기술적 접근 비교

- AGLA (전역-지역 어텐션 결합)

- 방법: 생성 과정에서 전역(문맥 중심)과 지역(판별 중심) 특징을 결합. 로짓을 보정하여 세밀한 정보에 집중하도록 유도.

- 장점: 학습 없이 사용 가능, 생성 능력 유지

- 한계: 지역 특징을 위해 이미지 증강 필요

- Nullu (HalluSpace 투사)

- 방법: 모델의 가중치를 HalluSpace(언어 편향된 하위공간)의 영공간(null space)으로 투사

- 장점: 모델 구조에 무관, 추론 속도 영향 없음

- 한계: 환각 특징이 선형적으로 구분된다는 가정 필요

b. 학습 유무에 따른 전략 비교

- 학습 불필요 방식 (AGLA, Nullu 등)

- 다양한 모델에 적용 가능하며 배포/확장에 유리

- 단점: 과제 특화 최적화는 부족할 수 있음

- 학습 기반 방식 (VILA-M3 등)

- 정확도 및 도메인 적응에 유리

- 단점: 학습 비용이 큼, 재학습 필요

- 현실 적용성 판단: AGLA처럼 plug-and-play 가능한 학습 불필요 방식이 실용적

2. 비디오 이해

a. 아키텍처 비교

- VideoTree (계층적 키프레임 선택)

- 쿼리 기반 트리 구조로 핵심 프레임을 선별

- 효율성/정확도: 토큰 40% 감소, 긴 영상 QA 정확도 향상

- DynFocus (동적 토큰 프루닝)

- 관련 프레임만 선택하는 DPE 모듈과 나머지 희소 인코딩

- 트레이드오프: 토큰 35% 절감, 2단계 학습 필요

b. 벤치마크 평가 타당성

- 한계: VideoRefer-700K는 객체 추적 중심이며 내러티브 구성, 인과 추론 과제 부족

- 예: VidComposition에서 인간 86.3%, MLLM 63.3% 정확도 → 구성적 추론 한계 명확

- 개선 제안: “왜 등장인물이 그렇게 반응했는가?” 와 같은 인과적 과제 포함 필요

3. 의료 응용

a. 두 가지 접근 방식 분석

- MMed-RAG (검색 기반 생성)

- 의료 문헌을 동적으로 검색하여 생성 결과 보강

- 장점: 방사선 보고서에서 환각 43.8% 감소

- VILA-M3 (전문가 지식 통합)

- 전문가 예측을 모델 훈련에 포함

- 한계: 전문가 주석 필요 → 고비용

- 신뢰성 판단:

- 드문 질병: MMed-RAG가 외부 근거로 더 안전

- 일반 질환: VILA-M3의 구조화된 지식이 효과적

b. 임상 윤리 평가

- 데이터 편향: 훈련 데이터 편향 → 특정 인구에서 낮은 성능 (예: MediConfusion의 적대 사례)

- 해석 가능성: MedRegA는 영역 중심(region-based) 데이터로 투명한 진단 설명 가능

- 윤리적 조합 제안:

- MMed-RAG의 근거 기반 생성 +

- MedRegA의 투명한 설명 구조 ⇒ 임상 감사를 위한 신뢰 확보

4. 효율적 토큰 관리

a. 세 가지 전략 비교

| 전략 | 특징 | 장점 | 단점 |

| ATP-LLaVA (프루닝) | 계층별 토큰 제거 | 정밀 정보 유지 (정확도 ↓ 2% 이하) | 오버헤드 존재 |

| PVC (압축) | 시공간 특징 집약 | 영상/이미지 통합, 속도 향상 | 미세 움직임 손실 가능 |

| VLsI (지식 증류) | 대형 모델 → 소형 모델 전이 | 엣지 디바이스에 적합 | 스승 모델 품질에 의존 |

b. 하이브리드 접근 제안

- 구성:

- BlueLM-V-3B → 해상도 384px로 토큰 감소

- FlashSloth → 중요한 영역을 contrastive 방식으로 선택

- 트레이드오프:

- 속도 향상 (24.4 tokens/sec)

- 하지만 **고해상도 진단(예: 종양 경계)**은 손실 가능

5. 사례 연구

상황:

- 환각 발생률 15%

- CT 시퀀스 과다

제안 솔루션:

- 환각 완화:

- Nullu 활용 → HalluSpace 제거로 편향 기반 환각 감소

- 시퀀스 최적화:

- PVC 사용 → CT 영상 토큰 수 50% 절감

- 임상 신뢰 확보:

- MMed-RAG → 실시간 문헌 검색으로 근거 기반 진단 생성

정당화:

- Nullu: 학습 불필요 → 실 임상 적용에 적합

- PVC: 긴 시퀀스를 처리하면서 재학습 불필요

- MMed-RAG: 임상 근거 제공 → 안전한 진단 지원

✅ 채점 참고사항:

- 개념 통합 능력 (예: Nullu의 subspace 투사 ↔ 임상 안전성 연결)

- 트레이드오프 분석 (예: 속도 vs 해상도) 가 평가에 핵심

🎯 [1] 객체 환각(Object Hallucination) 완화 연구 요약

| 논문 | 핵심 접근법 | 주요 기여 | 한계 |

| Devils in Middle Layers | 중간 레이어 attention 조정 | VAR/SVAR 도입, 시각 정보 처리 2단계 구조(축적/정제), 내부 attention 조작만으로 환각 감소 | 일부 모델에선 SVAR 민감도 감소, 레이어 구간 수동 설정 |

| AGLA | Global + Local attention 융합 | 질문-지역 매핑 정량화, plug-and-play 가능 | GradCAM 기반 local attention 정확도 한계, 대형 모델엔 미적용 |

| Nullu | HalluSpace 투사 | 내부 임베딩 공간에서 환각 feature 제거, 학습 없이 적용 | 하이퍼파라미터 수동, 비선형 환각 feature 탐지 어려움 |

| Octopus | 동적 Contrastive Decoding | eye token 활용 원인 식별, RL 기반 action 선택 | 비차분 선택 구조, 전략 종류 한정, 온디바이스 부담 |

| VASparse | Visual-aware token sparsification | 시각 salient + attention score 기반 토큰 선택, 2차 디코딩 없이 환각 제거 | 하이퍼 수동 설정, 디코더 구조 의존 |

✅ 종합: 객체 환각은 attention 편향과 language prior 문제에서 비롯되며, 최근 연구는 attention 조작(1,2), feature space 재구성(3), **디코딩 전략 강화(4,5)**로 대응 중. 대부분 plug-and-play 구조로 실용성 중시.

🎞 [2] Video LLM 주요 논문 정리

| 논문 | 핵심 전략 | 주요 기여 | 한계 |

| Seq2Time | 이미지 시퀀스를 pseudo-temporal로 변환 | 이미지-클립 기반 시간 학습, 절대시간 의존 제거 | 캡션 품질 낮을 시 성능 하락, 객체 인식 약함 |

| VideoRefer Suite | 객체 중심 시공간 인코더 + 700K 데이터 | 픽셀 수준 객체 표현, 객체 중심 벤치마크 제안 | 연산량 큼, 프레임 병합시 정확도 하락 가능 |

| Dispider | Perception-Decision-Reaction 분리 | 실시간 상호작용 가능, 응답 중 영상 처리 지속 | decision 오탐률 존재, 토큰 구조 일반화 어려움 |

| VidComposition | 영상 구성 중심 벤치마크 | 편집 영상 분석 벤치마크 최초 제안, 구성 평가 가능 | 구성 맥락 인식 제한, 장면 인과 추론 미흡 |

| DynFocus | 의미 있는 프레임만 정밀 인코딩 | 이벤트 중심 동적 인코딩, 토큰 절감 | frame importance 해석 어려움, 학습 시간 증가 |

| VideoTree | 계층적 트리 기반 표현 | 트리 기반 LLM reasoning 최적화 | caption 성능 의존, relevance 기준 불명확 |

✅ 종합: Video LLM은 장시간 영상 처리, 객체-시간 정렬, 실시간성 등에 한계가 있으며, 최신 연구는 시간 인코딩 개선(Seq2Time, VideoTree), 객체 중심 표현(VideoRefer, DynFocus), 구조적 reasoning(Dispider, VidComposition)을 통해 이를 개선 중.

🏥 [3] 의료 LVLM 연구 정리

| 논문 | 핵심 전략 | 주요 기여 | 한계 |

| StructuralGLIP | Layer-wise 지식 뱅크 | Fine-grained alignment, mutual selection 기반 구조화된 prompt | prompt 품질에 의존, rare disease 대응 한계 |

| SERSAL | LLM ↔ Small model 연동 | Tabular task에 self-prompting 방식 도입 | domain prior 없을 시 실패, 수치 민감도 한계 |

| MMed-RAG | 도메인 인식 RAG + adaptive k + preference 학습 | cross-modal alignment 향상, 환각 43.8% 감소 | 도메인별 retriever 필요, retrieval noise 여전 |

| MediConfusion | 시각적 오답 유도형 VQA 벤치마크 | 시각적 인식 취약점 진단, 언어 편향 회피 | encoder 편향 영향 큼, 실용성보단 평가용 벤치마크 |

| VILA-M3 | 전문가 모델 내장 + instruction tuning | 다양한 의료 task 통합, 전문가 feedback 반영 | 학습 수렴 느림, task 간 trade-off 발생 |

| MedRegA | Region-centric bilingual 구조 | 시각-언어 해석 가능성 강화, 지역 기반 추론 | 일부 modality 성능 저하, lesion 감지 한계 |

✅ 종합: 의료 LVLM은 환각, 도메인 적응, 해석 가능성이 핵심 문제이며, 최신 연구는 RAG 기반 근거 제공(MMed-RAG), region-level reasoning(MedRegA), 전문가 지식 활용(VILA-M3), tabular data 연동(SERSAL)을 통해 임상 신뢰성 확보를 추구함.

⚙️ [4] LVLM 효율성 최적화 (Efficiency)

| 논문 | 접근법 | 주요 기여 | 한계 |

| FastVLM | FastViT 인코더 설계 | 3.2x 속도 개선, 토큰 수 4x 감소 | 극고해상도 처리 시 타일링 필요 |

| PVC | Progressive token compression | 장/단 영상 통합 처리, 시공간 특징 보존 | 클립 병합 시 미세 정보 손실 가능 |

| ATP-LLaVA | 레이어/인스턴스 기반 adaptive pruning | 75% 토큰 절감, 정확도 하락 <2% | pruning 설정 추가 계산 부담 |

| BlueLM-V-3B | Dynamic resolution processor | 4bit 양자화 + 모바일 최적화 | 384px 제한으로 고해상도 손실 |

| FlashSloth | Embedded SAP + EmbQ | 9배 토큰 압축, 6.4 GPU시간 사전학습 | 세밀한 정보 손실 우려 |

| VLsI | Layer-wise verbalization 증류 | 소형 모델로 teacher 수준 추론 | teacher 의존성 존재 |

✅ 종합: 효율성 연구는 토큰 축소, 해상도 조절, 지식 증류 등을 통해 속도와 메모리 제약을 극복하며, 특히 PVC + ATP-LLaVA 조합은 고속, 고정밀 구조에 적합함.

필요 시 각 항목에 대한 시각적 요약(도식, 테이블, 벤치마크 수치 비교 등)도 제공해 드릴 수 있습니다. 다음에 어떤 부분을 더 정리하면 도움이 될까요?

'인공지능 > 공부' 카테고리의 다른 글

| 딥러닝 공부하기 2 (1) | 2025.07.02 |

|---|---|

| 딥러닝 공부하기 1 (1) | 2025.07.01 |

| 재미있는 인공지능 속 세상 여행 3주차 - Chat GPT의 등장과 비즈니스 환경 변화 (8) | 2024.09.18 |

| 재미있는 인공지능 속 세상 여행 1, 2주차 - 생성형 AI (10) | 2024.09.10 |

| 딥러닝 복습 2 - Regularization, Drop out, Hyper Parameter, optimization (0) | 2024.08.25 |