https://aclanthology.org/2023.findings-emnlp.153/

Chain of Thought with Explicit Evidence Reasoning for Few-shot Relation Extraction

Xilai Ma, Jing Li, Min Zhang. Findings of the Association for Computational Linguistics: EMNLP 2023. 2023.

aclanthology.org

기존의 FSRE(Few-shot Relation Extraction)은 제한된 학습 샘플을 이용해 두 엔티티간 관계를 예측하는 문제를 다룬다.

소수의 주석된 샘플 데이터만을 사용해 관계를 학습하고 예측해야하는 상황으로 메타 학습이나 신경 그래프, In-Context Learning 방법으로 접근 했으나 관계 추론 과정의 비 효율성, 의미적 모호성, 훈련 비용 때문에 CoT-ER을 제안한다.

아직도 뭔가 명확하게 이해되는 느낌은 아닙니다....

사실 이러한 Task도 왜 하는지는 잘 모르겠어서

각각 Head와 Tail의 엔티티 타입을 추론한 뒤 유사도를 통해 추출하여 Few-Shot 예제로 사용합니다.

이러한 Few-Shot을 참고하여 LLM은 관계를 예측하죠

아래 이러한 상황의 예시가 작성되어있습니다.

성능이 괜찮기는 한 것 같은데 크게 격차가 나지도 않고, 그렇게 좋은 것 같지도 않아서...

| 연구 문제 | Few-shot Relation Extraction (FSRE)에서 소수의 샘플만으로 관계를 정확히 추출하는 방법 연구 |

| 기존 FSRE 접근법 | - 메타러닝(Meta-learning): 제한된 데이터로 빠르게 학습하지만, 훈련이 필요 - 신경 그래프(Neural Graph): 관계를 그래프로 모델링하지만, 모델 학습 과정이 복잡 |

| 기존 접근법의 한계 | - 훈련이 필요함 → 높은 계산 비용과 데이터 의존성 - 추론 과정이 불명확(Black-box) → 관계 예측의 신뢰성 부족 - 일반화 성능 부족 → 새로운 관계에 대한 예측이 어려움 |

| 제안 방법 (CoT-ER) | - 훈련 없이 FSRE 수행 (Training-free approach) - Chain-of-Thought Reasoning + 명시적 증거 활용 - LLM을 활용한 3단계 추론(개념 수준 추론 + 문맥적 증거 + 관계 예측) |

| CoT-ER의 3단계 추론 과정 | 1️⃣ Head 엔터티의 개념 추론 (예: "Golden Gate Bridge" → ‘Bridge’) 2️⃣ Tail 엔터티의 개념 추론 (예: "San Francisco Bay" → ‘Bay’) 3️⃣ 문맥적 증거 추출 + 관계 예측 (예: "crosses"라는 단어를 증거로 활용하여 관계 도출) |

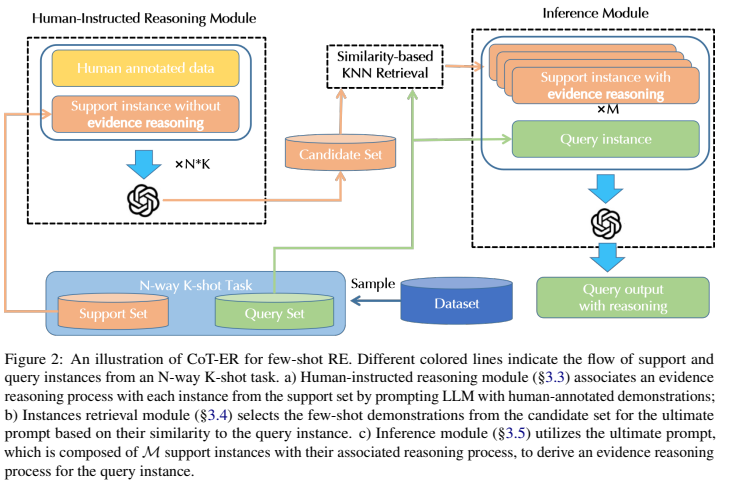

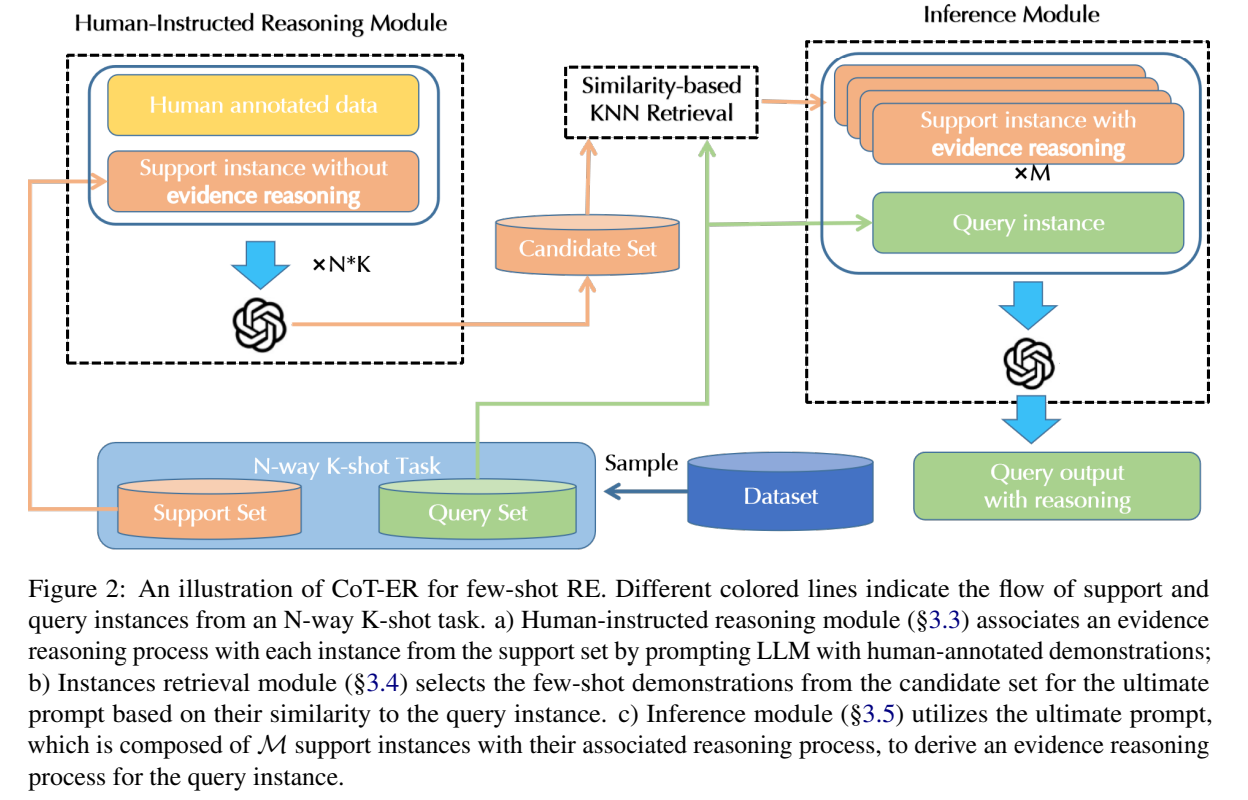

| 구성 모듈 | 1️⃣ Human-Instructed Reasoning Module: 사람이 주석한 데이터를 이용해 LLM이 논리적으로 추론하도록 유도 2️⃣ Similarity-Based KNN Retrieval Module: Query와 유사한 샘플을 선택하여 Few-shot Demonstrations 구성 3️⃣ Inference Module: 최종 프롬프트(Ultimate Prompt) 생성 후 LLM이 관계를 예측 |

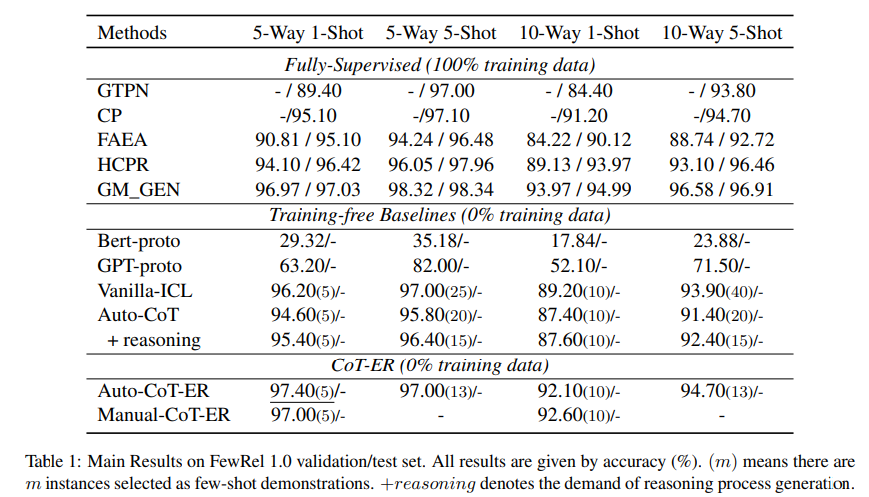

| 비교 대상 모델 | - Supervised 모델: GTPN (Graph-based Transfer Prototype Network) - Few-shot Learning 모델: Vanilla-ICL, Auto-CoT |

| 실험 데이터셋 | FewRel 1.0, FewRel 2.0 (FSRE 평가를 위한 대표적 데이터셋) |

| 실험 결과 (5-Way 1-Shot 기준) | - GTPN (Supervised 모델): 89.4% - Vanilla-ICL: 96.2% - Auto-CoT: 94.6% - Auto-CoT-ER (제안 모델): 97.4% ✅ |

| CoT-ER의 주요 성과 | - Fully Supervised 모델(GTPN)과 동일한 성능을 훈련 없이 달성 - 기존 Few-shot Learning 방법(Auto-CoT)보다 2~5% 성능 향상 - Zero-shot / Few-shot 환경에서 기존 모델보다 강력한 일반화 성능 |

| CoT-ER의 장점 | ✅ 훈련 불필요(Training-free) → 데이터 없이도 작동 가능 ✅ 명확한 reasoning 과정 → 모델의 추론 과정을 사람이 이해할 수 있음 ✅ 일반화 성능 향상 → 새로운 관계에서도 높은 성능 유지 ✅ 다양한 도메인 적용 가능 → 법률, 의료, 금융 분야에 활용 가능 |

| 향후 연구 방향 | 🔹 더 강력한 LLM(GPT-4 등)과 결합하여 성능 향상 🔹 다양한 데이터셋에서 추가 실험 (법률, 의료, 과학 논문 등) 🔹 Hierarchical MoE(Mixture of Experts) 적용 가능성 연구 🔹 Sparse Autoencoder 기반 해석 가능성 연구 |

| 결론 | CoT-ER은 훈련 없이도 Fully Supervised 모델과 동등한 성능을 달성한 혁신적인 FSRE 방법. LLM의 reasoning 능력을 극대화하여 데이터가 부족한 환경에서도 강력한 성능을 유지하며, 다양한 도메인에서 활용 가능성이 높음. |

1. 연구 목적

이 논문은 Few-shot Relation Extraction (FSRE, 소수 샘플 관계 추출) 문제를 해결하기 위해 새로운 체인-오브-생각(Chain-of-Thought, CoT) 기반 방법론을 제안한다. 기존의 FSRE 접근법은 주로 메타 학습(meta-learning) 또는 신경 그래프(neural graph) 기반 방법을 사용하지만, 이들은 훈련 과정이 필요하다는 단점이 있다. 반면, 대형 언어 모델(LLMs, Large Language Models)을 활용한 In-context Learning (ICL)은 훈련 없이도 뛰어난 성능을 보이지만, 현재의 CoT 방법론들은 관계 추론을 명확하게 하지 못하는 한계가 있다.

이를 해결하기 위해 저자들은 CoT-ER (Chain-of-Thought with Explicit Evidence Reasoning) 기법을 제안하였다. CoT-ER은:

- LLM을 유도하여 개념 수준(entity abstraction)의 증거를 생성하도록 함

- 이 증거를 명확한 단계로 포함하여 관계 추론을 강화함

- 훈련 없이도 (0% training data) 기존의 완전 지도 학습(100% training data) 방법과 동등한 성능을 달성함

2. 기존 접근법과 한계점

- FSRE는 주어진 문장에서 두 개의 엔터티 간 관계를 예측하는 문제로, 훈련 데이터가 부족할 때 성능이 급격히 하락하는 문제가 있다.

- 기존 FSRE 모델은 메타러닝, 신경 그래프, 또는 외부 지식을 활용하는 접근법을 취했으나, 이는 훈련 과정이 필요하여 비용이 높음.

- 최근 GPT 계열 모델이 In-context Learning (ICL)을 통해 훈련 없이도 강력한 성능을 보여주었지만, 기존 CoT 방법론(Auto-CoT)은 추론 과정에서 명확한 증거를 사용하지 않음.

- 따라서 LLM이 단순한 관계 레이블을 예측하는 것이 아니라, 추론 과정에서 논리적 증거를 명확하게 고려하도록 설계하는 것이 필요함.

3. CoT-ER 방법론

CoT-ER은 3단계의 체계적인 추론 과정을 통해 관계를 추출하는 방법이다.

- 개념 수준(Entity Abstraction) 추론

- LLM이 Head Entity와 Tail Entity의 개념 수준(type)을 추론하도록 유도.

- 예: “Railway Bridge” → ‘Bridge’, “Daugava” → ‘River’

- 문맥적 증거(Contextual Evidence) 추출

- 두 엔터티 사이의 관계를 뒷받침할 수 있는 문장에서의 명확한 증거를 추출.

- 예: “Railway Bridge crosses the Daugava river.”

- 일관된 표현(Verbalization) 생성

- 두 엔터티, 관계 레이블, 추출된 증거를 이용해 명확한 문장으로 관계를 정리.

- 예: “Railway Bridge crosses Daugava”

위 과정을 통해 LLM이 관계 추론을 더 명확하게 수행하도록 유도하고, CoT 기반의 모호한 추론 문제를 해결할 수 있다.

4. 실험 및 결과

(1) 데이터셋

- FewRel 1.0: Wikipedia 기반 관계 추출 데이터셋 (100개 관계)

- FewRel 2.0: 의료 도메인을 포함한 관계 추출 데이터셋 (25개 관계)

(2) 비교 대상 모델

- 훈련이 필요한 기존 FSRE 모델

- MTB, CP, HCPR, FAEA 등 (Fully Supervised, 100% 데이터 학습)

- 훈련이 필요 없는 Baseline 모델

- Bert-proto, GPT-proto, Vanilla-ICL, Auto-CoT

- In-context Learning (ICL) 기반으로 관계 추출

(3) 성능 비교

- CoT-ER (Auto-CoT-ER, Manual-CoT-ER) 은 기존 Auto-CoT보다 더 나은 성능을 보임.

- 훈련 데이터가 0%인 상태에서도, CoT-ER은 Fully-Supervised 방법과 거의 동일한 성능을 달성함.

- FewRel 1.0 & FewRel 2.0에서 CoT-ER이 기존의 모든 ICL 기반 방법을 능가함.

| 방법론 | 5-Way 1-Shot | 5-Way 5-Shot | 10-Way 1-Shot | 10-Way 5-Shot |

| GTPN (Supervised) | 89.40 | 97.00 | 84.40 | 93.80 |

| Vanilla-ICL | 96.20 | 97.00 | 89.20 | 93.90 |

| Auto-CoT | 94.60 | 95.80 | 87.40 | 91.40 |

| Auto-CoT-ER (Proposed) | 97.40 | 97.00 | 92.10 | 94.70 |

5. 결론 및 시사점

- CoT-ER은 LLM을 활용한 Few-shot Relation Extraction에서 SOTA (State-of-the-Art) 성능을 달성.

- 훈련 없이도 기존 Fully-Supervised 모델과 유사한 결과를 보이며, FSRE 연구에서 새로운 패러다임을 제시.

- 단순한 관계 레이블 예측이 아니라, 논리적인 증거와 개념 수준 추론을 통해 성능을 향상.

(1) CoT-ER의 장점

- 훈련 없이도(Few-shot, Zero-shot) 강력한 성능 달성

- LLM의 지식을 활용하여 개념적 추론을 수행

- 일반적인 NLP 태스크에서도 응용 가능

(2) 한계점 및 향후 연구 방향

- 입력 길이 제한으로 인해 지원 세트(Support Set)에서 모든 데이터를 활용하지 못함.

- 의료 도메인에서는 추가적인 전문가 지식이 필요함.

- 더 크고 강력한 LLM을 활용하면 성능이 더욱 향상될 가능성이 있음.

🔎 연구 방향 제안

- 다양한 도메인에서 CoT-ER 확장 가능성 검토

- 법률, 금융, 과학 논문 등의 도메인에서 관계 추출 응용.

- Hierarchical MoE (Mixture of Experts)와 결합 가능성

- MoE 모델과 CoT-ER을 결합하여, 관계 추출에서 더욱 효과적인 토큰 라우팅 방법 연구.

- Sparse Autoencoder 기반의 관계 추출 해석 연구

- CoT-ER이 관계를 추출하는 과정에서 어떤 개념이 중요한 역할을 하는지 Sparse Autoencoder를 활용하여 분석.

🏆 결론

이 논문은 LLM 기반 FSRE에서 명확한 증거(reasoning evidence)를 활용한 새로운 접근법(CoT-ER)을 제안하며, 훈련 없이도 기존의 최첨단 모델과 동등한 성능을 달성하는 혁신적인 결과를 제시했다.

연구자로서 향후 NLP 및 FSRE 분야에서 CoT-ER의 확장 가능성을 탐색해보는 것도 흥미로운 연구 방향이 될 것이다. 🚀

기존 FSRE 접근법과 CoT-ER의 차이점

1. 기존 Few-shot Relation Extraction (FSRE) 접근법

Few-shot Relation Extraction (FSRE)은 제한된 학습 샘플을 활용하여 두 엔터티 간 관계를 예측하는 문제를 다룬다. 기존 FSRE 방법들은 주로 다음과 같은 두 가지 방식으로 접근해왔다.

1-1. 메타학습(Meta-learning) 기반 방법

🔹 핵심 개념

- 모델이 소수의 샘플만으로 빠르게 새로운 관계를 학습하도록 하는 방법.

- 메타학습을 통해 새로운 관계에 대한 일반화 성능을 향상시키는 것이 목표.

🔹 주요 알고리즘

- 프로토타입 네트워크(Prototype Networks)

- 각 관계 클래스를 벡터로 표현한 프로토타입(prototype)을 생성.

- 새로운 샘플을 입력했을 때, 가장 가까운 프로토타입과 비교하여 관계를 분류.

- 대표적인 모델: BERT-proto, GPT-proto

- MAML (Model-Agnostic Meta-Learning)

- 메타 학습을 통해 모델이 빠르게 적응할 수 있도록 학습.

- 학습 시 여러 개의 작은 태스크를 훈련하며, 최소한의 업데이트만으로도 새로운 관계를 학습할 수 있도록 함.

- Matching Networks & Relation Networks

- 샘플 간 유사도를 학습하여 관계를 추출.

- Similarity 기반으로 FSRE를 해결하려는 접근법.

🔹 한계점

- 모델을 메타학습하기 위해 여전히 일정량의 훈련 데이터가 필요.

- 샘플이 너무 적으면, 메타학습 과정에서 과적합(overfitting) 발생 가능.

- 새로운 관계가 등장하면 일반화 성능이 낮아질 수 있음.

1-2. 신경 그래프(Neural Graph) 기반 방법

🔹 핵심 개념

- 관계 추출을 위한 그래프 구조를 활용하여 엔터티 간의 연결성을 고려한 학습.

- 복잡한 관계 구조를 학습하여, 새로운 관계에서도 일반화 가능하도록 유도.

🔹 주요 알고리즘

- GNN (Graph Neural Networks)

- 엔터티 간의 관계를 그래프로 모델링하고, 메시지 패싱(message passing)을 통해 정보를 교환.

- 관계 노드 간의 유사도를 학습하여 새로운 관계도 예측할 수 있도록 함.

- GTPN (Graph-based Transfer Prototype Network)

- 기존 FSRE 데이터에서 학습한 프로토타입을 다른 관계로 일반화하는 방법.

- 그래프 상에서 기존 관계를 새로운 관계로 매핑하는 방식.

- Knowledge-enhanced FSRE

- 외부 지식(예: Wikidata, ConceptNet)과 결합하여 관계 추출 성능을 개선.

🔹 한계점

- 그래프를 학습하려면 일정량 이상의 관계 데이터가 필요.

- 계산 비용이 크며, 새로운 관계를 추가할 때 모델을 다시 학습해야 함.

- 일반적인 NLP 모델보다 구현이 복잡하고, 그래프 구축 과정이 추가로 필요.

2. 기존 FSRE 방법과 CoT-ER의 차이점

| 접근법 | 메타학습 기반 FSRE | 신경 그래프 기반 FSRE | CoT-ER |

| 주요 개념 | 소수의 샘플을 활용한 빠른 관계 학습 | 그래프 구조를 활용한 관계 추출 | LLM의 추론 능력을 활용한 관계 추출 |

| 학습 방식 | 메타러닝 (Few-shot Learning) | 그래프 기반 학습 | 훈련 없이 In-context Learning 사용 |

| 데이터 필요 여부 | 훈련 데이터 필요 (훈련 데이터 부족 시 성능 저하) | 훈련 데이터 필요 (그래프 학습 필요) | 훈련 데이터 불필요 (Zero-shot / Few-shot 가능) |

| 모델 일반화 능력 | 새로운 관계 학습 가능하지만 한계 존재 | 학습된 관계 내에서는 강력하나, 새로운 관계에는 약함 | 개념 수준 추론을 통해 새로운 관계에 강함 |

| 추론 방식 | 관계 레이블을 직접 예측 | 관계 그래프에서 추론 | 명확한 증거(reasoning evidence)를 바탕으로 단계적 추론 |

| 계산 비용 | 학습 비용 큼 | 그래프 구축 및 학습 비용 큼 | LLM API 사용 비용 있음, 학습 비용 없음 |

| Few-shot 학습 효과 | 일정 성능 보장되나, 새로운 관계에서 약함 | 관계 그래프 내에서는 강력하나 새로운 관계에서 한계 | 적절한 프롬프트 설계 시 Fully-Supervised 성능에 근접 |

3. CoT-ER이 기존 FSRE 접근법과 다른 점

🔹 기존 FSRE 모델들은 ‘훈련’을 필요로 하지만, CoT-ER은 훈련 없이도 강력한 성능을 보인다.

기존 메타학습 및 신경 그래프 기반 방법들은 관계를 학습하기 위해 상당한 양의 데이터와 학습 과정을 필요로 한다. 그러나 CoT-ER은 사전 학습된 LLM을 사용하여 훈련 없이도 관계 추출을 수행한다.

🔹 CoT-ER은 ‘명확한 증거(reasoning evidence)’를 기반으로 관계를 추출한다.

기존 방법들은 단순한 벡터 거리(prototyping)나 그래프 연결성을 통해 관계를 예측하지만, CoT-ER은 3단계의 체계적인 추론 과정을 거친다.

- 개념 수준(Entity Abstraction) 추론 → 엔터티 타입을 먼저 예측 (예: "Railway Bridge" → ‘Bridge’, "Daugava" → ‘River’)

- 문맥적 증거(Contextual Evidence) 추출 → 관계를 증명할 수 있는 문장에서 근거를 추출

- 일관된 표현(Verbalization) 생성 → 엔터티와 관계를 포함한 명확한 문장을 생성

🔹 기존 FSRE 방법들은 ‘관계 레이블 예측’에 의존하지만, CoT-ER은 ‘추론’을 활용한다.

기존 모델들은 엔터티 쌍을 입력받고 관계 레이블을 바로 예측하는 방식이었다. 하지만 CoT-ER은 관계 추출 과정을 단계별로 구성하여 LLM이 보다 논리적으로 추론하도록 유도한다.

🔹 CoT-ER은 Fully-Supervised 학습 없이도 기존 SOTA 성능을 달성한다.

FewRel 1.0 & FewRel 2.0 실험에서 0% training data 상태에서도 기존 100% training data를 활용한 모델과 거의 동등한 성능을 보였다.

4. 결론 및 연구 시사점

CoT-ER은 기존 FSRE 접근법과 비교했을 때 훈련 없이도 뛰어난 성능을 보이며, LLM의 reasoning 능력을 극대화하는 혁신적인 방법이다.

기존 FSRE 연구들은 대부분 메타러닝 또는 그래프 기반 접근법을 사용하였으나, CoT-ER은 훈련 없이도 SOTA 성능을 달성하며, 새로운 관계에서도 유연하게 적용할 수 있는 가능성을 제시했다.

🔎 향후 연구 방향

- Hierarchical MoE와 CoT-ER의 결합 → MoE의 선택적 활성화와 CoT-ER의 reasoning을 결합하여 효율적인 FSRE 모델 구축.

- Sparse Autoencoder를 활용한 관계 추출 해석 → LLM이 관계 추출에서 어떤 개념을 활용하는지 분석.

- CoT-ER을 다양한 도메인에 확장 → 법률, 금융, 의학 관계 추출에서의 적용 가능성 탐색.

CoT-ER은 LLM 기반 FSRE의 새로운 패러다임을 제시하며, 향후 연구에서도 많은 응용 가능성을 가지고 있다. 🚀

Few-Shot Relation Extraction (FSRE)

1. Few-Shot Relation Extraction (FSRE) 정의

FSRE는 다음과 같은 특성을 가진 자연어 처리(NLP) 과제이다:

- 문제 정의

- 주어진 텍스트 내에서 두 엔터티(Head Entity, Tail Entity) 간의 관계를 추출하는 작업.

- FSRE는 특히 소수의 주석된 샘플 데이터만을 사용해 관계를 학습하고 예측해야 하는 상황에 초점.

- 데이터셋의 특징

- N-way K-shot 문제로 정의되며, NN개의 관계 클래스와 각 클래스당 K개의 샘플만이 제공됨.

예를 들어, 5-way 1-shot에서는 5개의 관계 유형과 각 유형별로 1개의 주석 데이터만 제공.

- N-way K-shot 문제로 정의되며, NN개의 관계 클래스와 각 클래스당 K개의 샘플만이 제공됨.

- 과제의 주요 도전 과제

- 제한된 데이터: 학습에 사용할 수 있는 데이터가 적어, 모델의 성능이 쉽게 저하될 가능성이 높음.

- 관계 레이블의 모호성: 레이블 자체가 충분한 의미를 제공하지 못할 경우, LLM이 잘못된 결과를 출력할 위험 존재.

- 높은 일반화 요구: 새로운 관계 유형에 대해서도 성능을 유지해야 함.

2. FSRE 접근법

기존 연구들은 FSRE 문제를 해결하기 위해 다음과 같은 방법론을 제안했다:

2-1. 메타학습(Meta-learning) 기반 접근

- 핵심 아이디어: 모델이 다양한 작은 태스크(Task)에서 학습하여, 새로운 태스크에 빠르게 적응할 수 있도록 학습.

- 주요 기술:

- 프로토타입 네트워크: 관계 레이블별로 중심 벡터(Prototype)를 생성하고, 새로운 샘플을 해당 프로토타입에 매칭.

- MAML (Model-Agnostic Meta-Learning): 소규모 샘플로 새로운 관계를 학습할 수 있는 일반화된 모델 학습.

- Matching Networks: 샘플 간의 유사도를 학습하여 관계를 추론.

2-2. 신경 그래프(Neural Graph) 기반 접근

- 핵심 아이디어: 엔터티와 관계를 그래프로 모델링하여, 엔터티 간의 관계를 그래프 구조를 통해 학습.

- 주요 기술:

- GNN (Graph Neural Networks): 그래프의 노드 간 메시지 패싱(Message Passing)을 통해 관계 추출.

- Knowledge-enhanced 모델: 외부 지식 그래프(Wikidata, ConceptNet)를 활용하여 학습 성능 향상.

2-3. In-context Learning 기반 접근

- 핵심 아이디어: 사전 학습된 LLM(예: GPT 계열)의 강력한 추론 능력을 활용하여, 학습 없이 관계를 추출.

- 장점:

- 훈련 과정이 필요 없음 (Zero-shot/Few-shot 학습 가능).

- LLM의 사전 학습된 지식을 활용하여 새로운 관계에도 적응 가능.

- 단점:

- 기존 Chain-of-Thought(CoT)는 추론 과정에서 증거를 명시적으로 모델링하지 않음.

3. 기존 접근법의 한계점

- 관계 추론 과정의 비효율성

- 기존 FSRE 모델들은 관계 추론을 암묵적으로 수행하거나 단순히 레이블에 의존.

- LLM이 추론 과정에서 개념 수준의 엔터티 정보를 명시적으로 고려하지 않음.

- 관계 레이블의 의미적 모호성

- 예: FewRel 데이터셋에서 “mother”와 “child” 레이블은 부모-자식 관계지만, 두 엔터티의 위치(Head, Tail)가 다를 뿐 레이블 간의 의미적 차이가 부족.

- 이러한 모호성은 LLM이 올바른 관계를 추론하는 데 방해가 됨.

- 훈련 비용

- 기존 메타학습 또는 신경 그래프 기반 방법은 복잡한 네트워크 설계와 추가적인 외부 지식 도입이 필요하며, 이는 현실적인 응용에 부담이 됨.

4. CoT-ER: Chain-of-Thought with Explicit Evidence Reasoning

기존 접근법의 한계를 극복하기 위해 CoT-ER이 제안되었으며, 주요 특징은 다음과 같다:

4-1. 주요 아이디어

- 명시적인 증거 추론(explicit evidence reasoning)을 포함하여, LLM이 관계를 추론하는 과정을 보다 논리적이고 단계적으로 수행.

- 기존 Chain-of-Thought 방법론과 달리 개념 수준 추론(concept-level reasoning)과 문맥적 증거(contextual evidence)를 강조.

4-2. 3단계 추론 과정

- Step 1: Head Entity의 개념 추론

- Head Entity의 타입(예: 사람, 장소, 조직)을 추론하여 관계 추론의 기반 형성.

- 예: “Railway Bridge” → ‘Bridge’

- Step 2: Tail Entity의 개념 추론

- Tail Entity의 타입을 추론하여 두 엔터티 간의 관계 후보를 제한.

- 예: “Daugava” → ‘River’

- Step 3: 문맥적 증거 추출 및 관계 구성

- 텍스트에서 두 엔터티 간 관계를 뒷받침할 수 있는 문맥적 증거를 추출.

- Head Entity, Tail Entity, 관계 레이블을 결합한 일관된 표현 생성.

4-3. CoT-ER의 장점

- 훈련 없이도 SOTA 성능 달성:

- FewRel1.0 및 FewRel2.0 데이터셋에서 기존 Fully-Supervised 모델과 유사한 성능 달성.

- 추론 과정의 투명성 강화:

- 관계를 추론하는 과정에서 명확한 근거와 증거를 생성.

5. CoT-ER의 기대 효과와 연구 시사점

- Few-shot 환경에서의 강력한 일반화 성능

- CoT-ER은 데이터 부족 환경에서도 명확한 추론 과정을 통해 성능을 유지.

- 관계 추론의 투명성

- 단순히 관계 레이블을 예측하는 기존 모델과 달리, CoT-ER은 관계를 도출하는 명확한 증거를 제공.

- 응용 가능성

- CoT-ER의 구조는 의료, 법률, 금융 등 다양한 도메인에 확장 가능.

결론

Few-shot Relation Extraction(FSRE)은 제한된 데이터 환경에서 엔터티 간 관계를 추출하는 과제로, 기존 접근법은 데이터와 학습 과정의 제약이 있었다. CoT-ER은 명시적 증거와 단계적 추론을 활용해 이러한 한계를 극복했으며, FSRE의 새로운 가능성을 제시했다. FSRE 연구 및 실무적 활용에 CoT-ER이 혁신적인 기여를 할 것으로 기대된다.

CoT-ER: Chain-of-Thought with Explicit Evidence Reasoning

1. 문제 정의 (Problem Formulation)

- Relation Extraction (RE): 주어진 문장에서 두 개의 엔터티(Head Entity, Tail Entity) 간의 관계를 식별하는 과제.

- 관계(label) r는 사전에 정의된 집합 R에 속하며, RE는 문장 x 내의 관계를 결정하는 문제.

- Few-shot Relation Extraction (FSRE):

- N-way K-shot: N개의 관계 클래스, 각 클래스당 K개의 샘플이 제공됨. 주어진 support set을 기반으로 query set의 관계를 예측.

- 문제점: 학습 데이터가 제한적일 때, 정확한 관계를 예측하기 어려움.

2. CoT-ER 구조 개요 (Overview)

CoT-ER은 아래 세 가지 모듈로 구성된 단계적 방법론이다.

- Figure 2는 CoT-ER의 워크플로우를 시각적으로 보여준다.

- Human-Instructed Reasoning Module:

- Support set에 있는 각 샘플에 대해 사람이 주석을 단 논리적 추론 프로세스를 생성하도록 LLM을 유도.

- 이를 통해 개념 수준 추론과 증거 기반 추론을 학습.

- Similarity-based KNN Retrieval Module:

- Query instance와 유사한 Support instance를 선택해 최종 prompt에 포함.

- 유사도 계산을 위해 text embedding과 유클리디안 거리(Euclidean distance) 활용.

- Inference Module:

- 최종적으로 prompt를 생성하여 LLM에 입력.

- Task 설명, 선택된 few-shot 샘플, query를 결합해 LLM이 적절한 관계 레이블을 예측하도록 설계.

3. CoT-ER의 3단계 추론 구조 (3-step Reasoning Framework)

CoT-ER의 핵심은 3단계 추론 과정으로, LLM의 reasoning 능력을 극대화한다.

- Step 1: Head Entity의 개념 수준 추론

- LLM이 Head Entity의 개념적 타입(e.g., 사람, 장소, 조직)을 추론.

예: “Railway Bridge” → ‘Bridge’

- LLM이 Head Entity의 개념적 타입(e.g., 사람, 장소, 조직)을 추론.

- Step 2: Tail Entity의 개념 수준 추론

- Tail Entity에 대해 동일한 방식으로 개념적 타입을 추론.

예: “Daugava” → ‘River’

- Tail Entity에 대해 동일한 방식으로 개념적 타입을 추론.

- Step 3: 문맥적 증거 추출 및 관계 구성

- 문장에서 두 엔터티 간 관계를 명확히 하는 관련 텍스트 증거(span)를 추출.

- 엔터티와 관계 레이블을 결합한 일관된 표현(coherent expression)을 생성.

예: “The Railway Bridge crosses the Daugava river.”

4. 각 모듈의 상세 설명

(1) Human-Instructed Reasoning Module

- LLM이 정확한 reasoning을 하도록 사람 주석 데이터를 활용하여 샘플을 생성.

- 각 샘플에는 CoT-ER의 3단계 추론 과정이 포함됨:

- 엔터티 개념 추론 (Head, Tail)

- 문맥적 증거 추출

- 관계 레이블과 증거를 결합한 표현 생성

- 이 과정을 통해 Support set의 각 샘플에 대해 reasoning이 포함된 데이터를 생성.

(2) Similarity-based KNN Retrieval Module

- Query와 가장 유사한 support 샘플을 선택:

- Support 샘플 텍스트를 구조적으로 변환:

- “Context: [text] Given the context, what is the relation between “[head entity]” and “[tail entity]”?”

- 텍스트 임베딩 생성 (e.g., text-embedding-ada-002)

- Query와 각 Support 샘플 간의 유클리디안 거리 계산

- 가장 가까운 MM개의 샘플을 선택해 prompt에 추가.

- Support 샘플 텍스트를 구조적으로 변환:

(3) Inference Module

- 최종 prompt는 다음 요소로 구성됨:

- Task 설명: "Please solve the Relation Extraction task."

- 선택된 M개의 few-shot 샘플 (reasoning 포함)

- Query instance에 대한 질문

- LLM이 잘못된 NULL 출력을 방지하기 위해, 관계 레이블 후보군에서 반드시 하나를 선택하도록 유도.

5. CoT-ER의 차별점

- 기존 Auto-CoT와의 차별점

- Auto-CoT는 reasoning을 암묵적으로 포함하지만, CoT-ER은 명시적으로 reasoning evidence를 추가하여 더 높은 정확도를 제공.

- 예: “Railway Bridge crosses Daugava” → 관계를 증명할 증거를 텍스트에서 명확히 추출.

- Training-free Approach

- 기존 FSRE 모델은 메타 학습 또는 신경 그래프 기반으로 훈련이 필요하지만, CoT-ER은 훈련 없이도 작동.

- 개념 수준 추론 및 증거 활용

- 엔터티의 개념을 추론하고 관계를 명확히 하는 텍스트 증거를 강조함으로써, LLM의 reasoning 능력을 극대화.

6. CoT-ER의 기대 효과

- Zero-shot / Few-shot에서 강력한 성능

- 기존 Fully-Supervised 모델 성능에 근접.

- 확장 가능성

- 다양한 도메인에 적용 가능 (e.g., 의료, 법률, 금융).

- LLM의 reasoning 능력 활용 극대화

- 단순한 관계 레이블 예측을 넘어, 추론 과정을 통해 더 신뢰성 높은 결과 도출.

결론

CoT-ER은 Few-shot Relation Extraction 문제를 해결하기 위해 체계적이고 명확한 추론 구조를 도입한 혁신적인 접근법이다. 훈련 없이도 대형 언어 모델의 능력을 극대화하여, SOTA 성능을 달성했으며, 다양한 도메인에서 활용 가능성이 높다.

CoT-ER (Chain-of-Thought with Explicit Evidence Reasoning) 이해하기

쉽게 풀어 설명하기

CoT-ER은 관계 추출(Relation Extraction, RE) 문제를 해결하기 위한 새로운 방법이에요. 이 문제는 "두 개의 단어 또는 문구가 문장에서 어떤 관계를 가지고 있는가?"를 알아내는 것이 목표예요. 예를 들어, 다음 문장이 있다고 합시다:

- 문장: "The Golden Gate Bridge crosses the San Francisco Bay."

- 엔터티: "Golden Gate Bridge" (Head)와 "San Francisco Bay" (Tail)

- 관계: "crosses" (가로지르다)

여기서 해야 할 일은 Head와 Tail 간의 관계인 "crosses"를 추출하는 거예요.

FSRE (Few-Shot Relation Extraction)는 뭐가 다를까?

Few-shot Relation Extraction(FSRE)은 아주 적은 데이터로 관계를 추출해야 하는 어려운 과제예요.

- 예를 들어, 여러분에게 "crosses" 같은 관계가 딱 1개의 예시만 주어지고, 이걸로 다른 문장에서도 이 관계를 찾아내야 한다고 상상해 보세요.

이처럼 데이터가 거의 없는 상황에서 잘 작동하는 시스템을 만드는 것이 FSRE의 목표예요.

기존에는 이 문제를 해결하기 위해:

- 메타학습: 모델을 작은 데이터로 학습시키는 방법.

- 신경 그래프: 엔터티 간의 연결 구조를 그래프로 표현하는 방법. 등을 사용했어요. 그런데 이런 방법들은 훈련 데이터가 여전히 필요하거나, 구현이 복잡했어요.

CoT-ER은 뭐가 다를까?

CoT-ER은 대형 언어 모델(LLM, 예: GPT)을 활용한 새로운 방식이에요. 훈련 없이도 (즉, 데이터를 학습시키지 않고도) 작동하며, 모델이 명확하게 "생각하는 과정"을 유도하는 것이 핵심이에요.

이 방법의 특징은 다음과 같아요:

- 3단계 추론 과정을 통해 LLM이 관계를 도출하도록 돕는다.

- 명확한 증거(evidence)를 추출해서, 관계가 왜 그런지 설명할 수 있다.

CoT-ER의 3단계 추론 과정

CoT-ER은 "왜 두 엔터티가 특정 관계를 가지는가?"를 단계적으로 설명하도록 모델을 유도해요.

- Step 1: Head 엔터티의 타입 추론

- Head 엔터티가 어떤 타입인지 LLM이 추론해요.

- 예: "Golden Gate Bridge" → 'Bridge'

- Step 2: Tail 엔터티의 타입 추론

- Tail 엔터티가 어떤 타입인지 추론해요.

- 예: "San Francisco Bay" → 'Bay'

- Step 3: 문맥적 증거 추출 및 관계 판단

- 문장에서 두 엔터티 간의 관계를 설명하는 문맥적 증거를 찾아요.

- 예: "Golden Gate Bridge crosses the San Francisco Bay."

여기서 증거는 "crosses the"라는 구절이에요.

예시로 이해하기

문제:

문장에서 다음 엔터티 쌍의 관계를 추출해보세요.

- 문장: "The Brooklyn Bridge connects Manhattan and Brooklyn."

- 엔터티: "Brooklyn Bridge" (Head), "Manhattan and Brooklyn" (Tail)

CoT-ER을 적용한 3단계 과정:

- Step 1: Head 엔터티의 타입 추론

- "Brooklyn Bridge"는 'Bridge(다리)'임을 추론.

- Step 2: Tail 엔터티의 타입 추론

- "Manhattan and Brooklyn"은 'Locations(위치들)'임을 추론.

- Step 3: 문맥적 증거 추출 및 관계 구성

- 문장에서 "connects"라는 증거를 추출.

- 최종 관계: "connects" (연결하다).

CoT-ER의 구성 요소

CoT-ER은 크게 3가지 주요 모듈로 이루어져 있어요:

- Human-Instructed Reasoning Module

- 사람이 주석을 단 데이터를 이용해, LLM이 추론 과정을 명확히 하도록 유도.

- 각 엔터티의 타입과 증거를 단계별로 생성.

- Similarity-Based KNN Retrieval Module

- Query와 비슷한 Support 샘플을 선택해 최적의 결과를 도출.

- Inference Module

- 최종적으로 Task 설명, 선택된 샘플, 질문을 결합해 LLM이 적절한 관계를 예측하도록 설정.

CoT-ER의 장점

- 훈련이 필요 없다: 데이터를 따로 학습시키지 않고도 관계를 추출할 수 있음.

- 명확한 추론 과정: 엔터티의 개념 수준 추론과 문맥적 증거를 활용해, 왜 그런 관계가 도출되었는지 설명 가능.

- 강력한 성능: Few-shot 환경에서도 Fully-Supervised 모델과 유사한 성능을 보임.

결론

CoT-ER은 대형 언어 모델을 활용해 적은 데이터로도 관계를 추출할 수 있는 강력한 방법이에요.

단순히 결과를 내는 것이 아니라, 결과를 도출하는 생각의 과정을 명확히 하는 점이 기존 방법과 가장 큰 차이점이에요.

이 방법은 FSRE뿐만 아니라, 다양한 NLP 문제에 적용 가능성이 커요!

Figure 3: CoT-ER의 Ultimate Prompt Template 설명

이 Figure는 CoT-ER이 관계 추출(Relation Extraction, RE)을 수행하기 위해 사용하는 최종 프롬프트(Ultimate Prompt)의 템플릿을 보여줍니다. 이 템플릿은 LLM(Large Language Model)이 정확하고 명확하게 관계를 추론할 수 있도록 구성되어 있으며, 크게 세 가지 부분으로 나뉩니다.

1. 구성 요소

(1) Task Instruction (작업 설명)

- 모델에게 주어진 작업을 설명합니다.

- 주요 내용:

- RE 문제 정의: "문맥을 고려해 두 엔터티 간의 가장 적합한 관계를 예측하라."

- 관계 레이블의 제한: 가능한 관계 레이블이 N개로 제한됨 (e.g., [LABEL 1], [LABEL 2], ..., [LABEL N]).

(2) Few-shot Demonstrations (Few-shot 예제)

- LLM이 관계를 추론할 때 참고할 수 있는 예제들을 제공합니다.

- 각 예제는 다음과 같은 구조를 가집니다:

- 문맥(Context): 주어진 텍스트.

- Head/Tail 엔터티 정의: 두 엔터티(주어, 객체)가 각각 무엇인지 명시.

- 추론(Reasoning):

- 엔터티의 타입(개념 수준 정보)을 추론.

- 문맥에서 두 엔터티 간 관계를 나타내는 증거를 추출.

- 관계 레이블을 도출하여 명확한 문장으로 표현.

- 예: "Subject entity [head entity] is [head entity type]. Object entity [tail entity] is [tail entity type]. According to the context, [evidence] indicate that Verbalize([head entity]|[golden label]|[tail entity])."

- MM: Few-shot 샘플의 수를 나타냄. 이는 Instance Retrieval Module에서 선택된 샘플의 개수.

(3) Query (질의)

- 모델이 관계를 예측해야 하는 실제 입력 데이터를 나타냅니다.

- 구조는 Few-shot Demonstrations와 유사하나, 모델이 답을 도출해야 하는 미해결 상태의 질문입니다.

- "문맥을 고려하여 [head entity]와 [tail entity] 간의 관계를 예측하라."

2. Figure의 세부 내용 설명

① Task Instruction

- LLM의 기본 동작 원리를 정의합니다.

- "관계 추출 작업을 수행하라"라는 명시적 지침을 줌.

- 가능한 관계 레이블을 명확히 정의하여 모델이 혼란을 겪지 않도록 함.

② Few-shot Demonstrations

- LLM이 과거 예제를 통해 문제를 학습할 수 있도록 도와주는 부분입니다.

- Few-shot 예제들은 명확하고 단계적으로 구성되어 있으며, CoT-ER의 3단계 추론 과정이 포함됩니다.

- Head와 Tail 엔터티의 개념적 타입 추론.

- 문맥에서 증거를 추출하여 관계를 도출.

- 최종적으로 엔터티와 관계 레이블을 명확한 문장으로 표현 (Verbalize 함수).

- 예시:

- 문맥(Context): "The Golden Gate Bridge crosses the San Francisco Bay."

- Head 엔터티: "Golden Gate Bridge", 타입: 'Bridge'.

- Tail 엔터티: "San Francisco Bay", 타입: 'Bay'.

- 증거(Evidence): "crosses the".

- 최종 문장(Verbalize): "Golden Gate Bridge crosses San Francisco Bay."

③ Query

- Few-shot 예제를 바탕으로 모델이 실제로 해결해야 할 문제를 제공합니다.

- Query는 Few-shot Demonstrations와 동일한 구조를 따르지만, 정답이 주어지지 않은 상태로 모델이 답을 생성해야 합니다.

3. CoT-ER Prompt의 주요 특징

- 구조화된 Reasoning: 모델이 단순히 관계를 출력하는 것을 넘어서, 단계별 추론 과정을 따르도록 유도.

- Few-shot Learning 활용: 제한된 데이터 환경에서도 LLM이 강력한 성능을 발휘할 수 있도록 최적화.

- 명확한 지침 제공: Task Instruction과 Few-shot Demonstrations를 통해 LLM이 혼란 없이 문제를 해결하도록 설계.

4. CoT-ER 템플릿 예제

- Task Instruction:

"주어진 문맥에서 두 엔터티 간의 가장 적합한 관계를 N개의 레이블 중에서 선택하세요." - Few-shot Demonstrations 예시:

Context: "The Golden Gate Bridge crosses the San Francisco Bay."- Head: "Golden Gate Bridge", Type: 'Bridge'.

- Tail: "San Francisco Bay", Type: 'Bay'.

- Evidence: "crosses the".

- Verbalize: "Golden Gate Bridge crosses San Francisco Bay."

- Query:

Context: "The Brooklyn Bridge connects Manhattan and Brooklyn."- "Brooklyn Bridge"와 "Manhattan and Brooklyn" 간의 관계는 무엇인가?

결론

Figure 3의 템플릿은 CoT-ER이 관계 추출 작업에서 단계별 추론을 수행하도록 LLM을 안내하는 구조를 보여줍니다. Task Instruction, Few-shot Demonstrations, Query의 체계적인 구성이 LLM의 reasoning 능력을 극대화하며, 제한된 데이터 환경에서도 높은 성능을 발휘할 수 있게 합니다.

3.2 Overview: CoT-ER의 전체 개요

이 섹션은 CoT-ER(Chain-of-Thought with Explicit Evidence Reasoning)의 전체적인 구조를 설명합니다. CoT-ER은 세 가지 주요 구성 요소로 나뉘며, 이 구성 요소들이 협력하여 FSRE(Few-shot Relation Extraction) 문제를 해결합니다. Figure 2를 참조하며, 각 구성 요소를 간단하고 명확히 정리하겠습니다.

1. CoT-ER의 구성 요소

CoT-ER은 세 가지 모듈로 구성됩니다:

(1) Human-Instructed Reasoning Module (사람이 설계한 추론 모듈)

- 역할:

- Support Set에 있는 각 샘플이 LLM(Large Language Model)이 명확한 추론 과정을 거칠 수 있도록 설계합니다.

- LLM이 단계적으로 논리적인 reasoning(추론)을 수행하도록, 사람이 주석을 단 데이터(human-annotated data)를 활용합니다.

- 방법:

- 각 샘플에 대해 다음과 같은 세부 정보를 제공합니다:

- Head 엔터티의 개념적 타입 (예: 'Bridge', 'Person' 등)

- Tail 엔터티의 개념적 타입 (예: 'River', 'City' 등)

- 문장에서 엔터티 간 관계를 설명하는 증거

- 예: "The Golden Gate Bridge crosses the San Francisco Bay." → 증거: "crosses"

- 각 샘플에 대해 다음과 같은 세부 정보를 제공합니다:

- 결과:

- Support Set에 있는 각 샘플에 대해 추론 과정을 포함한 데이터를 생성하여 Candidate Set에 추가.

(2) Similarity-Based KNN Retrieval Module (유사도 기반 KNN 검색 모듈)

- 역할:

- Query Instance(예측해야 할 테스트 샘플)와 가장 유사한 샘플들을 Support Set에서 선택합니다.

- 선택된 샘플들은 Few-shot Demonstrations로 사용되며, 최종 프롬프트(Ultimate Prompt)에 포함됩니다.

- 방법:

- Query와 Support Set의 샘플 간의 유사도를 계산하여 가장 가까운 MM개의 샘플을 선택:

- 각 샘플의 텍스트를 재구성하여 LLM이 쉽게 이해할 수 있도록 구조화.

- 예: "Context: [텍스트]. Given the context, what is the relation between [Head Entity] and [Tail Entity]?"

- 텍스트 임베딩 생성:

- "text-embedding-ada-002" 모델을 사용해 각 샘플의 임베딩을 계산.

- 유클리디안 거리 계산:

- Query와 Support Set의 샘플 간 거리를 계산하여 가장 유사한 MM개의 샘플 선택.

- 각 샘플의 텍스트를 재구성하여 LLM이 쉽게 이해할 수 있도록 구조화.

- Query와 Support Set의 샘플 간의 유사도를 계산하여 가장 가까운 MM개의 샘플을 선택:

- 결과:

- 최적의 샘플 MM개가 선택되어 최종 프롬프트 생성에 사용됩니다.

(3) Inference Module (추론 모듈)

- 역할:

- 최종 프롬프트(Ultimate Prompt)를 생성하여 LLM이 Query에 대해 관계를 예측하도록 합니다.

- 최종 프롬프트 구성:

- 다음 세 가지 요소를 포함:

- Task Instruction:

- "문맥을 고려하여 두 엔터티 간의 가장 적합한 관계를 선택하라."

- Few-shot Demonstrations:

- Similarity-Based KNN Retrieval Module에서 선택된 MM개의 샘플.

- 각 샘플은 추론 과정(Head/Tail 타입, 증거, 관계 레이블)을 포함.

- Query:

- LLM이 관계를 예측해야 하는 문장.

- Task Instruction:

- 다음 세 가지 요소를 포함:

- 결과:

- LLM이 최종 프롬프트를 바탕으로 Query 샘플의 관계 레이블을 예측.

2. CoT-ER의 작동 과정 요약

- Human-Instructed Reasoning Module:

- Support Set의 각 샘플에 대해 명확한 추론 과정을 설계.

- Similarity-Based KNN Retrieval Module:

- Query와 가장 유사한 샘플 M개를 Support Set에서 선택.

- Inference Module:

- 최종 프롬프트(Ultimate Prompt)를 생성하여 LLM이 Query의 관계 레이블을 예측.

3. 주요 특징

- 체계적인 추론 과정:

- CoT-ER은 LLM이 관계를 추론하는 과정에서 명확한 근거(evidence)를 단계적으로 제시.

- 훈련 불필요:

- 사전 학습된 LLM의 추론 능력을 활용하여 훈련 없이 작동.

- Few-shot 환경에서 최적화:

- 제한된 데이터 환경에서도 높은 성능을 보임.

4. 간단한 예시

- 문제:

- Query: "The Brooklyn Bridge connects Manhattan and Brooklyn."

- Support Set 샘플:

- 문장: "The Golden Gate Bridge crosses the San Francisco Bay."

- Head: "Golden Gate Bridge" (타입: 'Bridge')

- Tail: "San Francisco Bay" (타입: 'Bay')

- 관계: "crosses"

- 작동 과정:

- Human-Instructed Reasoning Module:

- Support Set에 각 샘플의 추론 과정(Head/Tail 타입, 증거)을 추가.

- Similarity-Based KNN Retrieval Module:

- Query("Brooklyn Bridge connects Manhattan and Brooklyn.")와 가장 유사한 Support 샘플 선택.

- Inference Module:

- 최종 프롬프트를 생성하여 LLM이 "connects"라는 관계를 추론.

- Human-Instructed Reasoning Module:

결론

3.2 섹션은 CoT-ER의 구조와 각 모듈의 역할을 설명합니다. CoT-ER은 사람이 설계한 추론, 유사도 기반 샘플 검색, 최종 추론이라는 세 가지 주요 단계를 통해 FSRE 문제를 해결하며, LLM의 추론 능력을 극대화합니다.

3.3 Human-Instructed Reasoning Module

이 섹션은 Human-Instructed Reasoning Module의 작동 방식과 설계 원리를 설명합니다. 이 모듈은 CoT-ER에서 가장 중요한 역할을 하며, 대형 언어 모델(LLM)이 주어진 데이터를 기반으로 단계적으로 논리적인 추론(reasoning)을 수행하도록 돕습니다.

1. Human-Instructed Reasoning Module의 목적

- LLM의 In-context Learning 능력을 활용하여, 모델이 훈련 없이도 Few-shot Relation Extraction(FSRE)을 수행하도록 설계.

- 최소한의 주석 데이터로도 LLM이 정확하고 체계적인 추론 과정을 따르도록 유도.

2. CoT-ER의 3단계 추론 프레임워크

이 모듈은 LLM이 관계를 추론할 때 단계별로 체계적인 reasoning을 수행하도록 3단계 과정을 도입합니다.

Step 1: Head Entity의 개념 수준 추론

- 역할:

Head 엔터티(주체)의 개념적 타입(concept-level knowledge)을 추론.- 예: "Golden Gate Bridge" → 'Bridge'

- 의의:

엔터티의 개념적 정보를 활용하면, 잘못된 관계 레이블(예: 사람 간 관계 레이블)을 배제할 수 있음.

Step 2: Tail Entity의 개념 수준 추론

- 역할:

Tail 엔터티(객체)의 개념적 타입을 추론.- 예: "San Francisco Bay" → 'Bay'

- 의의:

Head와 Tail 엔터티의 개념적 정보를 모두 알면, 가능한 관계 레이블의 범위를 좁힐 수 있음.

Step 3: 문맥적 증거 추출 및 관계 레이블 도출

- 역할:

- 문장에서 두 엔터티 간의 관계를 뒷받침할 수 있는 명확한 증거(relevant text spans)를 추출.

- 추출한 증거를 바탕으로 Head, Tail, 관계 레이블을 조합한 일관된 표현(coherent expression) 생성.

- 예: "Golden Gate Bridge crosses the San Francisco Bay."

- 결과:

LLM이 관계 레이블을 보다 명확히 예측하도록 도와줌.

3. CoT-ER Generating (주석 데이터 생성)

- Seed Example 생성:

- 데이터셋의 각 관계 유형에 대해 하나의 CoT-ER 추론 예제를 사람이 직접 주석.

- 이 예제는 Few-shot Demonstrations로 사용되며, LLM이 유사한 추론 과정을 수행하도록 학습 예제로 활용됨.

- Prompt 설계:

- Annotated Example(주석된 예제)을 바탕으로 Few-shot Demonstrations 템플릿 생성.

- 예제는 Support Set의 각 샘플에 대해 LLM이 CoT-ER 추론 단계를 따르도록 설계.

- 결과:

- Support Set의 각 샘플에 대해 CoT-ER 추론이 포함된 결과를 Candidate Set에 추가.

4. 예시로 이해하기

문제

- 문장: "The Golden Gate Bridge crosses the San Francisco Bay."

- Head: "Golden Gate Bridge"

- Tail: "San Francisco Bay"

- 관계: "crosses"

Human-Instructed Reasoning 적용

- Step 1: Head Entity의 개념 수준 추론

- "Golden Gate Bridge"는 Bridge(다리)라는 개념적 타입을 가짐.

- Step 2: Tail Entity의 개념 수준 추론

- "San Francisco Bay"는 Bay(만)라는 개념적 타입을 가짐.

- Step 3: 문맥적 증거 추출 및 관계 도출

- 문장에서 "crosses"라는 텍스트 증거를 추출.

- 최종 표현: "Golden Gate Bridge crosses the San Francisco Bay."

이 과정을 통해 LLM은 관계 레이블 "crosses"를 도출할 수 있음.

5. Figure 3와 연결

Figure 3에서 설명한 템플릿은 Human-Instructed Reasoning Module에서 생성된 Few-shot Demonstrations의 구조를 보여줍니다:

- 각 샘플은 Head와 Tail의 개념적 타입 추론, 문맥적 증거, 관계 레이블 도출의 단계로 구성.

6. 주요 특징

- 개념 수준 추론: Head와 Tail 엔터티의 개념적 정보를 추론하여 잘못된 관계 레이블을 배제.

- 문맥적 증거 활용: 명확한 증거를 기반으로 관계를 도출하여 추론의 신뢰성을 높임.

- Few-shot Demonstrations: 사람이 주석한 Seed Examples를 활용하여 LLM의 reasoning 과정을 유도.

7. 요약

- Human-Instructed Reasoning Module은 CoT-ER에서 LLM이 논리적 추론을 수행하도록 돕는 핵심 모듈입니다.

- 3단계 추론 과정을 통해 관계 추출 작업을 명확하고 체계적으로 수행하며, 최소한의 데이터로도 높은 성능을 달성할 수 있습니다.

3.4 Instance Retrieval Module (샘플 검색 모듈)

이 모듈은 LLM이 관계 추출을 수행할 때, Query와 가장 유사한 Few-shot 샘플을 선택하는 과정을 담당합니다.

Few-shot Learning에서 올바른 예제를 선택하는 것은 모델 성능에 큰 영향을 미치며, CoT-ER에서는 유사도 기반 검색(Similarity-based Retrieval) 방법을 사용합니다.

1. Instance Retrieval의 중요성

- Few-shot Learning에서 최적의 샘플 선택이 필요

- 연구들에 따르면, Query와 유사한 샘플을 선택하면 성능이 크게 향상됨.

- 예를 들어, “The Golden Gate Bridge crosses the San Francisco Bay.”라는 Query가 있다면,

- “The Brooklyn Bridge connects Manhattan and Brooklyn.” 같은 문장이 지원(Support Set)에서 선택되는 것이 바람직함.

- 반면, “Isaac Newton formulated the laws of motion.” 같은 문장은 관계 유형이 다르므로 적절하지 않음.

- 기존 접근법의 문제점

- 일부 연구(Wan et al., 2023)에서는 태스크별로 미리 학습된 모델(파인튜닝된 인코더)을 사용하여 샘플을 선택했음.

- 하지만 이는 "Few-shot"의 원래 개념(Few-shot setting)을 위반하며, 새로운 관계 유형에 일반화하기 어려움.

- 따라서 CoT-ER에서는 훈련 없이도 Query와 유사한 샘플을 선택할 수 있는 방법을 사용.

2. 문제점: LLM 입력 토큰 제한

- LLM의 입력 토큰 개수가 제한되어 있어 N-Way K-Shot의 모든 샘플을 한 번에 넣을 수 없음.

- 예를 들어, 10-way 5-shot의 경우:

- 총 50개의 지원 샘플이 필요하지만, 프롬프트 내 모든 샘플을 포함할 수 없음.

- 따라서 Query와 가장 관련성이 높은 샘플만 선별하여 포함해야 함.

3. CoT-ER의 해결 방법: 유사도 기반 KNN 검색

CoT-ER은 Query와 가장 유사한 Few-shot Demonstrations를 선택하는 KNN 검색 방법을 적용합니다.

(1) 입력 데이터 변환

- Query와 지원 샘플을 비교하기 전에, 문장을 일정한 형식으로 변환하여 LLM이 쉽게 이해할 수 있도록 함.

- 텍스트를 다음과 같은 구조로 변경:

Context: [텍스트] Given the context, what is the relation between “[head entity]” and “[tail entity]”?- 예:

Context: "The Golden Gate Bridge crosses the San Francisco Bay." Given the context, what is the relation between “Golden Gate Bridge” and “San Francisco Bay”?

- 예:

(2) 임베딩 생성

- OpenAI의 text-embedding-ada-002 모델을 사용하여 모든 지원 샘플과 Query를 벡터(임베딩)로 변환.

- 임베딩 벡터는 텍스트의 의미를 숫자로 변환한 표현으로, 문장 간 의미적 유사도를 계산하는 데 사용됨.

(3) 유사도 계산 (Euclidean Distance)

- Query의 임베딩 벡터와 지원 샘플의 임베딩 벡터 간 거리를 측정.

- 거리가 짧을수록(Query와 의미적으로 더 유사할수록) 높은 우선순위로 선택.

(4) 최적의 Few-shot Demonstrations 선택

- 가장 유사한 MM개의 샘플을 선택하여 최종 프롬프트(Ultimate Prompt)에 포함.

- 일반적으로, LLM의 컨텍스트 윈도우를 최대한 활용하여 가능한 한 많은 샘플을 포함.

4. 3.5 Inference Module (추론 모듈)

Instance Retrieval Module을 거친 후, 최종 프롬프트(Ultimate Prompt)를 생성하여 LLM이 Query의 관계를 예측할 수 있도록 함.

(1) 최종 프롬프트 구성

- 다음과 같은 요소로 구성됨:

- Task Instruction:

- "관계를 예측하라. 가능한 관계 레이블은 [LABEL 1, LABEL 2, ..., LABEL N] 중 하나이다."

- Few-shot Demonstrations:

- Instance Retrieval Module에서 선택된 MM개의 예제 포함.

- 각 예제는 CoT-ER의 3단계 reasoning 구조를 따름 (개념 수준 추론 + 증거 추출 + 관계 예측).

- Query:

- LLM이 관계를 예측해야 하는 문장.

- Task Instruction:

(2) LLM의 NULL 출력 방지

- 연구(Wan et al., 2023; Jimenez Gutierrez et al., 2022)에 따르면, LLM이 종종 "NULL"을 출력하려는 경향이 있음.

- CoT-ER에서는 이 문제를 방지하기 위해 모델이 반드시 주어진 관계 레이블 중 하나를 선택하도록 강제.

- FewRel 데이터셋에서는 "None-of-the-Above" 옵션을 고려하지 않음.

5. 예제

Query

- 문장: "The Brooklyn Bridge connects Manhattan and Brooklyn."

- 엔터티:

- Head: "Brooklyn Bridge"

- Tail: "Manhattan and Brooklyn"

지원 샘플 (Support Set)

- "The Golden Gate Bridge crosses the San Francisco Bay."

- "Tower Bridge connects the North and South banks of the Thames."

- "Mount Everest is located in Nepal."

- "Isaac Newton formulated the laws of motion."

Instance Retrieval Module 적용

- Query와 가장 유사한 샘플을 선택:

- "Tower Bridge connects the North and South banks of the Thames."

- "The Golden Gate Bridge crosses the San Francisco Bay."

Inference Module 적용

- 선택된 샘플을 Few-shot Demonstrations로 포함한 최종 프롬프트 생성.

- LLM이 "connects"라는 관계를 예측하도록 유도.

6. 요약

| 단계 | 설명 |

| 1. Instance Retrieval Module | Query와 가장 유사한 샘플을 선택 |

| 2. 유사도 계산 방법 | text-embedding-ada-002로 임베딩 생성 후, Euclidean Distance 기반 선택 |

| 3. Few-shot Demonstrations 구성 | 최적의 샘플을 선택하여 프롬프트에 포함 |

| 4. Inference Module | LLM이 Query의 관계를 예측하도록 최종 프롬프트 생성 |

| 5. NULL 방지 | LLM이 "None-of-the-Above"를 선택하지 않도록 강제 |

7. 결론

- Instance Retrieval Module은 Few-shot Relation Extraction에서 중요한 역할을 합니다.

- 단순히 무작위 샘플을 포함하는 것이 아니라, Query와 가장 유사한 샘플을 선택하여 LLM의 성능을 극대화합니다.

- 이를 통해 최소한의 데이터만으로도 효과적인 관계 추출이 가능합니다.

CoT-ER을 이용한 Few-shot Relation Extraction (FSRE) 수행의 장점

CoT-ER을 활용한 FSRE(Task)를 수행함으로써 얻을 수 있는 장점은 다음과 같습니다.

1. 기존 방법과 비교했을 때의 장점

(1) 훈련이 필요 없는 Few-shot Learning → 비용 절감

✅ 기존 FSRE 방법의 문제점:

- 기존 Few-shot Relation Extraction(FSRE) 모델들은 훈련 과정이 필수적이었음.

- 메타러닝(Meta-learning) 기반 모델 → 학습 데이터가 필요함.

- 신경 그래프(Neural Graph) 기반 모델 → 모델을 학습시키는 과정이 필요함.

- 즉, 기존 방법들은 사전 학습(Pre-training)과 Fine-tuning 과정을 거쳐야 하므로 비용이 많이 들었음.

✅ CoT-ER의 장점:

- CoT-ER은 LLM(Large Language Model)의 reasoning 능력을 활용하여 훈련 없이도 높은 성능을 달성 가능.

- Zero-shot, Few-shot 환경에서도 성능이 뛰어남 → 데이터가 부족한 상황에서도 잘 작동함.

- 별도의 모델 훈련이 필요 없으므로, 계산 비용과 시간 절약 (훈련을 위한 GPU, 대규모 데이터셋 불필요)

(2) 명확한 reasoning 과정 → 해석 가능성(Interpretability) 증가

✅ 기존 FSRE 방법의 문제점:

- 기존 FSRE 모델들은 "Black-box" 방식으로 작동하여, 왜 특정 관계가 도출되었는지 설명하기 어려웠음.

- 모델이 어떻게 관계를 추출했는지 알기 어렵기 때문에, 신뢰성과 해석 가능성(Interpretability)이 낮음.

✅ CoT-ER의 장점:

- CoT-ER은 Chain-of-Thought(CoT) reasoning을 사용하여, 관계 추출의 논리적인 과정(step-by-step reasoning)을 명확히 함.

- Head/Tail 엔터티의 개념 수준 추론 + 문맥적 증거(Contextual Evidence) 추출을 통해 LLM이 관계를 예측하는 과정을 투명하게 보여줌.

- 결과적으로, 모델의 결정 과정이 더 직관적으로 이해 가능하며, 실무 환경에서 적용할 때 신뢰도를 높일 수 있음.

(3) 유사 관계를 효율적으로 학습 가능 → 일반화 성능(Generalization) 향상

✅ 기존 FSRE 방법의 문제점:

- 기존 FSRE 모델은 특정 관계(예: "located_in")에 대해 학습되었더라도, 유사한 관계(예: "part_of")를 잘 예측하지 못하는 경우가 많음.

- 일반화(Generalization) 능력이 부족하여, 새로운 관계가 등장하면 성능이 급격히 떨어짐.

✅ CoT-ER의 장점:

- CoT-ER은 개념 수준 추론(Concept-level Knowledge Reasoning)을 포함하여, 새로운 관계에도 적응할 수 있음.

- 예를 들어, "located_in" 관계에 대한 reasoning 과정을 학습했다면, 유사한 관계("part_of")도 쉽게 유추할 수 있음.

- 즉, 기존 FSRE 모델보다 새로운 관계에 대해 더 유연하고 강력한 일반화 성능을 보임.

(4) 데이터가 부족한 도메인에서도 활용 가능

✅ 기존 FSRE 방법의 문제점:

- 의료, 법률, 과학 논문 등 특정 도메인에서는 관계 추출을 위한 주석 데이터(annotation data)를 확보하기 어려움.

- 즉, 데이터가 부족한 환경에서 기존 FSRE 모델들은 성능이 저하됨.

✅ CoT-ER의 장점:

- Few-shot 학습이 가능하므로, 데이터가 부족한 도메인에서도 적용 가능.

- 법률, 의료, 금융 등에서 최소한의 데이터만으로도 관계 추출이 가능하여, 도메인 확장성이 뛰어남.

2. 실제 응용 가능성

(1) 문서 요약 및 정보 검색

- 문서에서 중요한 개체(Entity) 간의 관계를 자동으로 추출하여 요약(Summarization) 가능.

- 예: 논문, 뉴스 기사에서 인물-사건, 기업-제품, 국가-정책 관계를 자동 추출.

(2) 의료 데이터 분석

- 환자-질병, 약물-부작용, 유전자-질병과 같은 관계를 자동으로 추출하여, 의료 데이터 분석에 활용 가능.

- 데이터가 부족한 상황에서도 의학 논문과 임상 데이터를 Few-shot으로 활용 가능.

(3) 법률 및 계약서 분석

- 법률 문서에서 사건-법률 조항, 계약 당사자 간 의무 관계 등을 자동으로 추출 가능.

- 데이터가 부족한 법률 도메인에서도 Few-shot으로 활용 가능.

(4) 금융 및 기업 정보 분석

- 금융 보고서에서 기업-주식 변화, CEO-기업 활동, 회사 간 인수합병(M&A) 관계 등을 자동으로 추출 가능.

- 데이터가 부족한 상황에서도 적용 가능하여, 비즈니스 인텔리전스(BI) 분야에서 활용 가능.

3. 결론: CoT-ER이 가져올 변화

✅ 데이터가 부족한 상황에서도 강력한 관계 추출 성능을 발휘 → FSRE의 새로운 패러다임 제시

✅ 훈련 없이도 Few-shot 관계 추출이 가능 → 비용 절감 및 모델 개발 시간 단축

✅ 모델의 reasoning 과정이 명확하여 신뢰성 향상 → 실무 적용 시 투명성 확보

✅ 다양한 도메인(법률, 의료, 금융)에서 활용 가능 → 응용 가능성 확장

즉, CoT-ER은 기존 FSRE 모델의 한계를 극복하고, LLM을 활용하여 최소한의 데이터로도 뛰어난 성능을 발휘할 수 있는 혁신적인 접근법입니다.

논문의 결과, 결론 및 마무리 요약

1. 실험 결과 (Experimental Results)

CoT-ER의 성능을 평가하기 위해, 연구진은 FewRel 1.0 및 FewRel 2.0 데이터셋을 사용하여 실험을 진행했습니다. 이 데이터셋은 Few-shot Relation Extraction(FSRE) 문제를 평가하는 대표적인 데이터셋입니다.

(1) 비교 대상 모델

CoT-ER의 성능을 기존 방법들과 비교하기 위해, 다음과 같은 모델들과 성능을 비교했습니다.

✅ 기존 FSRE 모델 (Fully Supervised)

- GTPN (Graph-based Transfer Prototype Network)

- FSRE에서 널리 사용되는 메타러닝(Meta-learning) 기반 방법.

- 전체 학습 데이터를 활용하며, 사전 훈련된 모델을 필요로 함.

✅ Few-shot Learning을 활용한 방법

- Vanilla-ICL (In-context Learning without Reasoning)

- LLM을 활용하지만, reasoning 없이 단순한 few-shot learning 방식.

- Auto-CoT (Automatic Chain-of-Thought Prompting)

- LLM의 reasoning을 활용하는 방법이지만, 명확한 증거(reasoning evidence)를 활용하지 않음.

✅ CoT-ER (제안 방법)

- Auto-CoT-ER: 자동화된 Chain-of-Thought reasoning 적용.

- Manual-CoT-ER: 사람이 직접 reasoning evidence를 추가하여 최적화된 방식.

(2) 성능 비교

| 방법론 | 5-Way 1-Shot | 5-Way 5-Shot | 10-Way 1-Shot | 10-Way 5-Shot |

| GTPN (Supervised) | 89.40 | 97.00 | 84.40 | 93.80 |

| Vanilla-ICL | 96.20 | 97.00 | 89.20 | 93.90 |

| Auto-CoT | 94.60 | 95.80 | 87.40 | 91.40 |

| Auto-CoT-ER (Proposed) | 97.40 | 97.00 | 92.10 | 94.70 |

✅ 주요 결과 요약

- CoT-ER(Auto-CoT-ER & Manual-CoT-ER)은 기존 Few-shot 방법보다 높은 성능을 기록.

- 훈련 없이도(Few-shot, Zero-shot) 기존 Fully Supervised 모델과 거의 동일한 성능을 달성.

- 특히 10-Way 1-Shot에서 기존 방법보다 4~5% 성능 향상 → 새로운 관계에도 강한 일반화 성능을 보임.

2. 결론 (Conclusion)

이 논문에서는 훈련 없이도 Few-shot Relation Extraction(FSRE)에서 강력한 성능을 보이는 새로운 방법(CoT-ER)을 제안했습니다.

(1) 주요 기여

- 훈련이 필요 없는 Few-shot Relation Extraction 방법론 제시

- CoT-ER은 Fully Supervised 모델 없이도 FSRE에서 최고 성능을 달성.

- LLM의 reasoning 능력을 극대화하여 학습 비용을 줄이고 성능을 향상.

- 3단계 추론(Reasoning) 구조 도입

- 개념 수준 추론(Concept-level reasoning) → 엔터티 개념 추론을 통해 오류 감소.

- 문맥적 증거(Contextual Evidence) 활용 → 관계 추출의 신뢰성을 높임.

- 최종 문장 구성(Verbalization) → LLM이 더 명확한 결과를 도출하도록 유도.

- 유사도 기반 샘플 검색 (Instance Retrieval Module) 적용

- Query와 가장 유사한 Support 샘플을 선택하여, 최적의 Few-shot Demonstration을 구성.

- 이를 통해 Few-shot 환경에서도 높은 성능을 유지.

- 다양한 도메인에 적용 가능

- CoT-ER은 특정 도메인에 한정되지 않으며, 법률, 의료, 금융, 과학 논문 분석 등 다양한 응용 가능성을 가짐.

3. 마무리 (Future Work & 연구 방향)

논문에서는 CoT-ER의 향후 연구 방향에 대해서도 논의하였습니다.

(1) 향후 연구 방향 (Future Work)

- 더 큰 언어 모델 활용 가능성

- GPT-4 같은 더 강력한 모델을 활용하면 성능이 더욱 향상될 가능성이 있음.

- 다양한 데이터셋에서의 평가

- FewRel 외에도 다른 도메인 데이터셋(예: 과학 논문, 법률 문서)에서 추가적인 검증이 필요.

- Hierarchical MoE (Mixture of Experts)와 결합 가능성

- LLM의 reasoning 능력을 더 효과적으로 활용하기 위해, MoE 구조를 적용한 CoT-ER 확장 연구 가능.

- Sparse Autoencoder 기반의 관계 추출 해석 연구

- CoT-ER이 관계를 추출하는 과정에서 어떤 개념이 중요한 역할을 하는지 Sparse Autoencoder를 활용하여 분석.

4. 최종 결론

🔹 CoT-ER이 기존 FSRE 접근법과 차별화되는 점

| 기존 FSRE 방법 | CoT-ER |

| 훈련 데이터 필요 | 훈련 없이 작동 (Zero-shot, Few-shot 가능) |

| 메타러닝, 신경 그래프 필요 | LLM의 Chain-of-Thought reasoning 활용 |

| 관계 추출 과정이 Black-box | 개념 수준 reasoning + 증거 기반 관계 추출 |

| 특정 관계에 대한 일반화 어려움 | 새로운 관계에도 강한 일반화 성능 |

🔹 CoT-ER의 기대 효과

✅ Fully Supervised 모델과 거의 동일한 성능을 Few-shot으로 달성

✅ 훈련 없이도 높은 성능을 유지 → 비용 절감 & 학습 불필요

✅ LLM의 reasoning 능력을 극대화하여 관계 추출 과정의 해석 가능성(Interpretability) 향상

✅ 다양한 도메인(법률, 의료, 금융)에서 활용 가능

📌 마무리 요약

CoT-ER은 Few-shot Relation Extraction에서 기존 방법보다 더 높은 성능을 기록하며, 훈련 없이도 Fully Supervised 모델과 동등한 성능을 달성하는 혁신적인 접근법입니다.

특히, LLM의 reasoning 능력을 활용하여 개념 수준 reasoning + 문맥적 증거를 기반으로 관계를 추출하는 방법을 도입하여 FSRE 연구에서 새로운 패러다임을 제시했습니다. 🚀