https://aclanthology.org/2023.findings-emnlp.101/

What Makes Chain-of-Thought Prompting Effective? A Counterfactual Study

Aman Madaan, Katherine Hermann, Amir Yazdanbakhsh. Findings of the Association for Computational Linguistics: EMNLP 2023. 2023.

aclanthology.org

CoT는 LLM의 성능을 높이는데 사용되는 방법입니다.

그러나 CoT를 통한 성능 증가의 이유는 아직 밝혀지지 않았고, 패턴, 기호, 잘못된 정보, 조작을 진행하여 다양한 조건에서 테스트를 진행합니다.

이러한 결과를 보면 CoT는 Few-Shot과 똑같이 예시를 주는 것입니다.

안에 숫자가 변경되어 기호가 된다고 해도, 패턴에 의해서 동일하게 문제를 푸는 것 이네요

그런데 구조가 조금씩 변경되거나 완전 다른 패밀리 모델에서도 실험한 것은 아니라 다양성은 부족해 보입니다.

그래도 CoT에서 예시의 중요성을 다시 한번 느낀 논문이었습니다.

| 연구 목적 | - Chain-of-Thought Prompting(COT)의 효과가 발생하는 근본적인 이유를 체계적으로 분석 - 기호(Symbols)와 패턴(Patterns)의 역할과 중요성 규명 - COT가 reasoning을 수행하는지 또는 단순히 학습된 패턴을 따르는지 이해 |

| 기본 개념 | - COT: 복잡한 문제를 단계적으로 해결하도록 유도하는 프롬프트 설계 기법 - 반사실적 프롬프트(Counterfactual Prompting): 프롬프트의 특정 요소(기호, 패턴 등)를 조작하여 모델의 응답 변화를 관찰 |

| 연구 질문 | 1. COT에서 기호(Symbols)는 어떤 역할을 하는가? 2. 패턴(Patterns)이 COT 성능에 미치는 영향은 무엇인가? 3. 모델은 실제로 reasoning을 수행하는가, 아니면 단순히 학습된 패턴을 따르는가? |

| 사용 모델 | - PaLM-62B (Google) - GPT-3 (OpenAI) - CODEX (OpenAI) - PaLM-540B |

| 데이터셋 및 태스크 | - GSM-8K: 초등학교 수준 수학 문제 (Mathematical Reasoning) - DATE: 날짜 계산 (Commonsense Reasoning) - SPORTS: 스포츠 상식 문제 (Commonsense Reasoning) - SORTING: 숫자 정렬 (Symbolic Reasoning) |

| 연구 방법 | - 프롬프트의 기호(Symbols)와 패턴(Patterns)을 변형하여 모델의 반응 변화 분석 - 기호 변형 방법: 1. Abstract Symbols: 심볼을 추상적 플레이스홀더로 대체 2. OOD Symbols: 분포 밖 심볼로 대체 - 패턴 변형 방법: 1. 패턴 제거 2. 패턴 왜곡 3. 비정형적 패턴 삽입(Yoda 스타일) |

| 주요 결과 | 1. Symbols (기호의 역할): - 기호를 추상적 플레이스홀더로 대체하거나 OOD 심볼을 사용해도 대부분 태스크에서 성능에 큰 영향이 없음. - 하지만 SPORTS 태스크에서는 기호가 명확히 정의되지 않을 경우 성능이 저하됨. 2. Patterns (패턴의 역할): - 패턴이 일관되게 제공되지 않으면 성능이 크게 감소. - 특히 수학 문제(GSM-8K)에서는 계산식 패턴(예: 5 + 4 = 9)이 중요. - Yoda 스타일로 텍스트 변형 시, 날짜 계산(DATE)과 스포츠 상식 문제(SPORTS) 성능이 크게 하락. 3. Attention Analysis: - 심볼이 변경된 경우에도 Attention 패턴은 거의 동일, 즉 모델은 심볼보다는 패턴과 구조에 의존. |

| 결론 | 1. COT는 reasoning을 수행하는 것이 아니라, 학습된 패턴을 따르는 경향이 강함. 2. 기호보다는 패턴과 텍스트 구조가 모델 성능에 더 중요한 역할을 함. 3. COT는 문제 해결 방식을 리마인드(Remind)시키는 역할을 하며, reasoning 능력을 강화하는 것은 아님. 4. 특정 태스크(SPORTS 등)에서는 기호와 문맥이 명확해야 높은 성능을 보임. |

| 연구 한계 | - COT와 모델 성능의 관계가 특정 데이터셋(GSM-8K, DATE 등)에 한정됨. - 모델이 reasoning을 수행한다는 확실한 증거를 제시하지 못함. - Attention 분석만으로 모델의 내부 추론 과정을 완전히 설명하기 어렵다. |

| 향후 연구 방향 | 1. 강건한 COT 프롬프트 설계: - 비정형적 문장 스타일(Yoda 스타일)에도 강인한 성능을 보이는 프롬프트 개발 2. Reasoning 능력 강화: - 단순 패턴 매칭을 넘어, 모델이 실제로 reasoning을 수행하도록 유도하는 기법 연구 3. 기호와 패턴의 상호작용 연구: - 기호가 패턴과 결합될 때 태스크 성능에 미치는 영향 심층 분석 |

| 인공지능 연구에 미치는 영향 | - COT의 본질적 한계를 이해함으로써, 더 효과적이고 강건한 프롬프트 설계에 대한 통찰 제공. - 패턴과 심볼의 역할을 명확히 규명하여, 태스크별 최적화 프롬프트 설계 가능. - LLM(대형 언어 모델)의 reasoning 능력 개발과 개선에 중요한 기초 자료 제공. |

| Symbols (기호) | - 심볼은 모델의 성능에 일부 영향을 주지만, 패턴과 비교했을 때 중요도가 낮음. - 특정 태스크(SPORTS)에서는 심볼과 문맥의 명확성이 중요. |

| Patterns (패턴) | - 모델은 reasoning보다는 학습된 패턴을 기반으로 문제를 해결. - 패턴의 일관성이 깨지면 성능이 크게 저하되며, 특히 수학 문제에서 계산식 형태의 패턴이 중요. |

| Attention Analysis | - 심볼이 변경되더라도 Attention 패턴은 크게 변하지 않음. - 이는 모델이 reasoning이 아닌 패턴과 구조에 의존함을 시사. |

| Yoda 스타일 텍스트 | - 텍스트 구조가 비정형적일 경우 모델의 성능이 저하됨. - DATE와 SPORTS 태스크에서 특히 민감하게 반응. |

| OOD Symbols (분포 밖 심볼) | - 수학 문제와 날짜 계산에서는 OOD 심볼이 큰 영향을 미치지 않음. - 하지만 SPORTS 태스크에서는 분포 밖 심볼(OOD)을 사용할 경우 성능이 크게 저하됨. - SORTING 문제에서는 큰 숫자 사용 시 성능이 향상됨(60.6% → 80.0%). |

1. 연구의 배경 및 문제 정의

Chain-of-Thought Prompting(COT)은 LLM의 성능을 크게 향상시키는 것으로 알려져 있으나, 그 정확한 메커니즘은 완전히 밝혀지지 않았다. 기존 연구에서는 COT의 효과를 인간의 사고 과정과 비교하며 설명하지만, 단순한 직관적 해석에 불과하다. 본 연구는 COT의 효과가 왜, 어떻게 발생하는지를 체계적으로 분석하기 위해 반사실적(Counterfactual) 프롬프트 기법을 활용한다.

2. 연구 방법: 반사실적 프롬프트(Counterfactual Prompting)

기존의 few-shot prompting에서 특정 요소를 조작하여 모델의 반응 변화를 분석하는 방식으로, 프롬프트에서 변경하는 주요 요소는 다음과 같다.

- Symbols (기호)

- 숫자, 날짜, 특정 인물 등의 개별 요소를 변경 (예: 숫자를 그리스 문자로 대체)

- 질문과 문장 구조는 유지한 채, 숫자와 기호만 변형하여 모델이 기호 자체에 의존하는지 분석

- Patterns (패턴)

- 논리적 사고 과정의 형식을 변경 (예: 수식 순서를 변경)

- 특정 문장 구조를 유지하는지 또는 어순을 바꾸었을 때 성능이 저하되는지 분석

- Surface-Level Features (표면적 요소)

- 문장 스타일 변경 (예: Yoda 스타일 문장, 수동태 변환)

- 문장의 단어 순서를 바꾸었을 때 모델의 성능이 저하되는지 분석

- Incorrect Information (잘못된 정보)

- Few-shot 예제에서 일부 정보를 고의적으로 틀리게 주었을 때 성능 변화 관찰

- 틀린 정보가 있을 경우 모델이 이를 무시하는지, 오히려 성능 향상이 일어나는지 분석

3. 실험 설정

- 대상 모델: PaLM-62B, GPT-3, CODEX

- 평가 데이터셋: 네 가지 주요 유형의 태스크를 선정하여 분석

- 수학적 문제 해결 (Mathematical Reasoning) - GSM-8K

- 상식적 문제 해결 (Commonsense Reasoning)

- 스포츠 관련 사실 판단

- 날짜 관련 연산

- 기호적 문제 해결 (Symbolic Reasoning) - 숫자 정렬(SORTING)

- 평가 기준: 정답률(accuracy) 및 모델의 주의(attention) 패턴 분석

4. 주요 실험 결과

(1) Symbols (기호)

- 프롬프트에서 숫자를 그리스 문자(α, β, γ)로 대체해도 성능에 거의 영향을 미치지 않음.

- 그러나 패턴을 유지하지 않으면 성능이 크게 저하됨.

- 즉, 숫자 자체보다 문장 구조와 패턴이 더 중요한 역할을 함.

(2) Patterns (패턴)

- 논리적 패턴(예: 수학 문제에서 "A+B=C" 형식)을 유지해야 성능이 높게 유지됨.

- 패턴이 없거나 불일치하면 성능이 20~30% 감소.

- 예를 들어, 수학 문제에서 수식 없이 답을 직접 제공하면 성능이 급락.

(3) 잘못된 정보가 포함된 경우

- 수학 문제에서는 예제의 수식이 틀려도 모델 성능에 큰 영향을 주지 않음.

- 그러나 상식적 문제(예: 스포츠 관련 질문)에서는 틀린 정보가 포함되면 성능이 크게 저하.

- 일부 경우, 오히려 틀린 정보가 성능을 향상시키는 경우도 발견됨 (예: SORTING 문제).

(4) Surface-Level Manipulations (표면적 조작)

- 문장 스타일을 요다(Yoda) 스타일로 변경 → 성능 저하

- 문장을 수동태로 변환 → 성능 저하

- 문장 어순을 바꾸거나 단어 순서를 무작위로 섞으면 → 성능이 크게 떨어짐

- 즉, 모델은 문장의 구조적 패턴을 학습하며, 단순한 단어의 의미가 아닌 표현 방식 자체에 영향을 받음.

5. 분석: Chain-of-Thought(COT)가 효과적인 이유

(1) COT는 문제 해결 방법을 전달하는 역할

- 모델은 학습된 정보를 바탕으로 reasoning하는 것이 아니라, 주어진 패턴을 그대로 따라간다.

- 즉, "이 문제는 이렇게 푸는 것이다"라는 것을 명시적으로 알려주는 것이 핵심.

(2) COT는 상식적 정보를 보완하는 역할

- 문제 속에 명시적으로 주어지지 않은 상식(common sense)을 보완하는 기능이 있음.

- 예제에서 논리적 연결고리를 만들어 주면, 모델이 이를 기반으로 더 나은 답을 생성.

(3) COT는 어려운 문제와 희귀한 개념에서 더 효과적

- 특히 긴 문제나 어려운 개념, 드물게 등장하는 개념에 대해 COT가 성능을 향상시킴.

- 예를 들어, 스포츠 상식 문제에서 COT를 사용하면 웹에서 거의 등장하지 않는 희귀한 스포츠 용어까지도 올바르게 이해하는 경향을 보임.

6. 결론 및 시사점

- COT의 효과는 "기호(symbols)" 자체가 아니라, "패턴(patterns)"과 "텍스트 스타일"에 의해 결정됨.

- 특히 문장 구조, 패턴, 사고 방식의 표현 방법이 모델의 성능에 큰 영향을 미침.

- 따라서 COT는 모델이 새로운 것을 배우게 하는 것이 아니라, 기존 정보를 "리마인드" 시키는 역할을 한다.

(향후 연구 방향)

- 더 효과적인 COT 기법 개발

- "Concise Chain-of-Thought (CCOT)": 더 짧은 COT 프롬프트로도 효과 유지

- 불필요한 토큰을 제거하여 효율적인 COT 설계

- COT를 활용한 강건한 프롬프트 설계

- 패턴의 일관성 유지: 단순한 패턴 변화에도 모델 성능이 영향을 받으므로, 최적의 패턴 설계 필요

- 잘못된 정보 처리 기법 연구: 틀린 정보가 포함될 경우 어떻게 보완할지에 대한 연구 필요

- LLM의 reasoning 능력 강화

- 단순한 패턴 매칭이 아닌, 실제 reasoning 능력을 향상시키는 방법 연구

- "Pattern-Only COT" vs. "Generalizable COT" 비교 연구

7. 연구의 한계

- 연구에서 사용한 COT는 특정 데이터셋과 모델(GPT-3, PaLM-62B)에 한정됨.

- LLM 내부에서 실제로 reasoning이 일어나는지를 검증하는 것이 아니라, 프롬프트의 변화에 따른 출력 패턴만 분석.

- 따라서 LLM이 진정한 추론 능력을 갖추었는지에 대한 근본적인 질문은 여전히 남아 있음.

8. 최종 정리

- COT의 효과는 기호(symbols)가 아닌, 패턴(patterns)과 텍스트 스타일의 일관성에 의해 결정됨.

- COT는 학습이 아니라 "문제 해결 방법을 리마인드" 시키는 역할을 한다.

- 향후 연구에서는 더 효율적인 COT 프롬프트 설계 및 reasoning 능력 강화가 필요.

이 논문은 LLM의 reasoning 방식과 prompting 전략을 최적화하는 데 중요한 통찰을 제공하며, 향후 AGI 개발 및 언어 모델의 강건성 확보에도 큰 영향을 미칠 연구로 평가된다. 🚀

본 연구에서는 COT의 효과가 발생하는 근본적인 원인을 밝히기 위해 반사실적(Counterfactual) 프롬프트 기법을 사용하였다. 즉, 기존의 COT 프롬프트에서 특정 요소를 체계적으로 변경하고, 이에 따른 모델의 응답 변화를 분석하는 방식이다. 이를 통해 COT가 단순한 기호(Symbols) 때문인지, 혹은 패턴(Patterns)이나 문장 스타일 때문인지를 명확히 구분하는 것을 목표로 하였다.

1. 실험 설계 및 데이터셋

연구진은 다음과 같은 실험 조건을 설정하여 LLM이 COT를 활용하는 메커니즘을 파악하고자 하였다.

(1) 대상 모델

- PaLM-62B (Google DeepMind)

- GPT-3 (text-davinci-002, OpenAI)

- CODEX (code-davinci-002, OpenAI)

이 모델들은 모두 COT를 사용했을 때 강력한 reasoning 성능을 보인 것으로 알려져 있으며, 이를 비교 분석하여 공통적인 COT 메커니즘을 밝히는 것이 본 연구의 핵심 목표 중 하나였다.

(2) 평가 데이터셋 및 태스크 선정

연구진은 COT의 효과가 다양한 태스크에서 어떻게 달라지는지를 분석하기 위해 4가지 유형의 reasoning 태스크를 선정하였다.

| 테스크 유형 | 설명 | 예제 데이터 셋 |

| 수학적 문제 해결 (Mathematical Reasoning) | 초등학교 수준의 수학 문제 해결 | GSM-8K |

| 상식적 문제 해결 (Commonsense Reasoning) | 일반적인 상식 기반 추론 | BIG-Bench (스포츠 & 날짜 reasoning) |

| 기호적 문제 해결 (Symbolic Reasoning) | 숫자 정렬(Sorting) 등 기호 기반 문제 | Sorting Task |

이러한 태스크를 통해 연구진은 COT의 효과가 특정한 유형의 reasoning에 한정되는지, 혹은 일반적인 원리로 적용되는지를 분석할 수 있었다.

2. 반사실적 프롬프트(Counterfactual Prompting) 기법

연구진은 프롬프트를 구성하는 핵심 요소를 분해하고, 이를 개별적으로 변경하여 LLM의 반응 변화를 측정하였다.

(1) Symbols (기호) 조작

- 기호(symbols)를 변경해도 성능이 유지되는지 분석

- 숫자, 날짜, 인물 등의 기호를 변경

- 예제: 숫자(1,2,3) → 그리스 문자(α,β,γ) 변환

예제:

✅ 원본 COT 프롬프트 (GSM-8K 수학 문제)

Q: "Shawn has five toys. He got two toys from his mom and dad. How many toys does he have now?"

T: "Shawn started with 5 toys. He got 2 more toys. 5 + 2 = 7."

A: "The answer is 7."

🔄 반사실적 프롬프트 (숫자를 기호로 변경)

Q: "Shawn has α toys. He got β toys from his mom and dad. How many toys does he have now?"

T: "Shawn started with α toys. He got β more toys. α + β = π."

A: "The answer is π."

✅ 결과: 숫자를 변경해도 모델의 성능에 큰 영향이 없었음.

➡️ 즉, 숫자 자체보다는 문제의 구조(패턴)가 더 중요한 역할을 한다는 것을 시사함.

(2) Patterns (패턴) 조작

- 문제 해결 방식(예: 수식 순서)을 변경하여 패턴의 중요성을 분석

- 패턴을 없애거나, 잘못된 패턴을 포함했을 때 성능 변화를 측정

예제:

✅ 원본 COT 프롬프트

Q: "Leah had 32 chocolates, and her sister had 42. If they ate 35, how many pieces do they have left in total?"

T: "Originally, Leah had 32 chocolates. Her sister had 42. So in total, they had 32 + 42 = 74. After eating 35, they had 74 - 35 = 39."

A: "The answer is 39."

🔄 반사실적 프롬프트 (패턴 제거 - 수식 없이 서술만 포함)

Q: "Leah had 32 chocolates, and her sister had 42. If they ate 35, how many pieces do they have left in total?"

T: "Leah started with some chocolates. Then she ate some chocolates."

A: "The answer is 74."

✅ 결과:

- 패턴이 사라지면 모델의 성능이 급격히 하락 (성공률 27.37% → 10.01%)

➡️ 즉, LLM은 수학 문제 해결에서 "수식 형태"의 패턴을 활용하고 있으며, 단순한 언어 서술만으로는 reasoning을 수행하기 어렵다.

(3) Surface-Level Features (문장 스타일) 조작

- 문장 스타일을 변경하여 성능 변화를 분석

- 수동태 변환, Yoda 스타일 문장 사용 등

- 문장의 어순을 바꾸었을 때 모델의 성능이 어떻게 변하는지 평가

예제:

✅ 원본 COT 프롬프트 (SPORTS reasoning)

Q: "Jamal Murray was perfect from the line."

T: "Jamal Murray is a basketball player. Being perfect from the line is part of basketball."

A: "Yes."

🔄 반사실적 프롬프트 (Yoda 스타일 문장으로 변형)

Q: "Perfect from the line, Jamal Murray was."

T: "A basketball player, Jamal Murray is. Perfect from the line, part of basketball it is."

A: "Yes."

✅ 결과:

- 문장 스타일이 변경되었을 때 성능이 저하됨 (SPORTS reasoning 성능: 93.67% → 68.26%)

➡️ 즉, 모델은 단어의 의미보다는 학습된 문장 구조를 따르는 경향이 있음.

3. 실험 결과 분석 및 핵심 발견

(1) COT는 문제 해결 방식(task understanding)을 전달하는 역할

- LLM은 reasoning을 수행하는 것이 아니라, COT 프롬프트를 통해 "이 문제는 이렇게 푸는 것이다"라는 방식을 학습한다.

- 즉, COT는 모델이 학습한 reasoning 방식과 맞아떨어질 때 효과적으로 작용한다.

(2) COT는 상식적 정보를 보완하는 역할

- 모델이 학습하지 않은 희귀 개념도, COT 프롬프트를 통해 reasoning할 수 있다.

- 예제: 스포츠 reasoning에서, "드문 스포츠 용어"도 문맥을 통해 학습 가능.

(3) COT는 어려운 문제와 희귀한 개념에서 더 효과적

- 복잡한 문제일수록 COT의 효과가 두드러짐.

- 단순한 계산보다는 논리적 사고가 필요한 문제에서 COT가 더 큰 영향을 미친다.

결론 및 시사점

- COT의 효과는 기호(symbols)보다는 패턴(patterns)과 문장 구조의 일관성에 의해 결정된다.

- 향후 연구에서는 더 효율적인 COT 프롬프트 설계 및 모델의 reasoning 능력을 강화하는 방법이 필요하다.

- LLM의 reasoning 능력을 진정으로 강화하기 위해서는 COT를 넘어서는 새로운 접근법이 필요하다. 🚀

본 논문에서는 Chain-of-Thought Prompting (COT)의 효과를 설명하기 위해 반사실적(Counterfactual) 프롬프트 기법을 활용하였다. 이 연구가 기존 연구들과 차별화되는 지점을 명확히 이해하기 위해, 먼저 관련 연구를 정리한 후, 본 연구의 차별점을 분석한다.

1. 관련 연구 정리

COT 및 인컨텍스트 러닝(In-Context Learning, ICL)에 대한 연구는 다양한 방향에서 진행되었다. 본 논문과 관련된 주요 연구를 정리하면 다음과 같다.

(1) COT의 등장과 발전

1-1. Chain-of-Thought Prompting (Wei et al., 2022)

- 핵심 내용:

- COT를 처음으로 제안한 논문.

- LLM이 reasoning 성능을 향상시키기 위해 단계별로 문제를 해결하도록 유도하는 기법을 소개.

- 수학 문제, 논리 추론, 상식 추론 등 다양한 태스크에서 COT가 효과적임을 입증.

- 한계점:

- COT가 효과적인 이유를 깊이 탐구하지 않았으며, 단순히 인간의 사고 과정과 유사하다는 점만 제시.

1-2. Least-to-Most Prompting (Zhou et al., 2022)

- 핵심 내용:

- COT의 변형 기법으로, 문제를 여러 개의 하위 문제로 나누고 점진적으로 해결하는 방식.

- 복잡한 문제를 단계별로 풀도록 유도하여 reasoning 능력을 더욱 강화.

- 한계점:

- 문제를 적절히 분할하는 것이 어려우며, 일부 문제에서는 오히려 성능이 저하됨.

(2) In-Context Learning과 Few-Shot Learning 연구

2-1. In-Context Learning: Few-shot Learning의 근본적 원인 분석 (Min et al., 2022)

- 핵심 내용:

- LLM이 few-shot learning을 할 때, 실제로 프롬프트의 정답을 학습하는 것이 아니라, 프롬프트에서 문제 유형과 형식을 인식하는 것이 더 중요함을 입증.

- 심지어 few-shot 예제의 정답이 틀려도 모델의 성능에 큰 영향을 주지 않는 경우가 많음.

- 한계점:

- LLM이 실제 reasoning을 수행하는지, 단순한 패턴 매칭을 수행하는지에 대한 명확한 검증이 부족.

2-2. Few-shot prompting은 학습이 아니라 "리마인드" 기능을 한다 (Reynolds & McDonell, 2021)

- 핵심 내용:

- LLM이 few-shot learning을 통해 새로운 정보를 "학습"하는 것이 아니라, 이미 알고 있는 정보를 "리마인드"하는 역할을 한다는 것을 주장.

- 프롬프트를 변경해도 모델의 성능이 크게 변하지 않는 경우가 많음.

- 한계점:

- 이론적인 검증이 부족하며, 실험이 한정된 데이터셋에서만 수행됨.

(3) COT의 효과에 대한 추가 연구

3-1. COT가 무조건 옳아야 할 필요는 없다 (Ye et al., 2022)

- 핵심 내용:

- COT 프롬프트가 틀린 reasoning을 포함하더라도, 모델의 성능이 크게 저하되지 않음을 보임.

- 즉, LLM은 reasoning 자체를 학습하는 것이 아니라, COT의 형식적인 구조를 따라가는 경향이 강함.

- 한계점:

- 틀린 COT 프롬프트가 언제 성능을 향상시키고 언제 성능을 저하시킬지에 대한 명확한 설명이 부족.

3-2. COT는 reasoning을 촉진하는 것이 아니라, "패턴 매칭"을 한다 (Wang et al., 2022)

- 핵심 내용:

- COT가 reasoning을 도와주는 것이 아니라, 모델이 기존에 학습한 문장 패턴을 강화하는 역할을 한다고 주장.

- 단순히 단어 순서를 바꾸거나 문장 스타일을 변경하는 것만으로도 성능이 급격히 저하됨을 실험적으로 입증.

- 한계점:

- COT의 정확한 메커니즘을 설명하는 추가적인 실험이 필요함.

2. 본 연구의 기존 연구와의 차이점

본 연구는 기존 연구들과 다음과 같은 차별점을 가진다.

(1) COT의 효과를 기호(Symbols)와 패턴(Patterns)으로 분해하여 분석

- 기존 연구들은 COT의 효과를 단순히 "human-like reasoning" 때문이라고 설명했으나, 본 연구는 이를 구체적인 요소(기호, 패턴, 문장 스타일)로 나누어 분석하였다.

- 주요 실험 결과:

- 숫자(symbols)를 변경해도 성능에 거의 영향이 없으나, 패턴이 변경되면 성능이 급격히 저하됨을 입증.

- 문장 스타일(Yoda 스타일, 수동태 등)이 변할 경우, reasoning 성능이 크게 떨어짐.

➡️ 즉, COT의 핵심은 reasoning이 아니라, "패턴을 학습하는 능력"에 있음을 실험적으로 입증.

(2) 반사실적(Counterfactual) 프롬프트를 통한 실험적 검증

- 본 연구는 단순한 성능 비교를 넘어서, 반사실적 프롬프트(Counterfactual Prompting) 기법을 활용하여 COT의 메커니즘을 검증.

- 반사실적 프롬프트 기법이란?

- COT 프롬프트에서 특정 요소(기호, 패턴, 스타일)만 변경하고 나머지는 그대로 유지한 상태에서 모델 성능을 비교.

- 예를 들어, 숫자 대신 그리스 문자(α, β, γ)를 사용해도 성능이 유지되지만, 문장 패턴이 바뀌면 성능이 급격히 저하됨을 입증.

➡️ 기존 연구들은 COT의 효과를 단순한 직관적 설명에 의존했으나, 본 연구는 실험적으로 이를 정량화하였다.

(3) COT는 reasoning이 아니라, "리마인드(Reminding)" 역할

- 기존 연구들은 COT를 reasoning을 강화하는 도구로 보았지만, 본 연구는 COT가 reasoning을 수행하는 것이 아니라, 모델이 task를 기억하는 역할을 한다고 주장.

- 즉, COT는 "문제 해결 방식을 알려주는 방식"이지, 모델이 reasoning을 실제로 수행하는 것은 아니라는 것.

➡️ 이는 기존 연구(예: Min et al., 2022)와 비슷한 결론을 도출하지만, 더욱 체계적으로 분석하여 COT의 한계를 명확히 지적한다.

3. 결론

기존 연구와 비교한 본 연구의 핵심 기여

✅ COT의 효과를 단순히 설명하는 것이 아니라, 기호(Symbols)와 패턴(Patterns)의 역할을 실험적으로 분석

✅ 기존 연구들은 단순한 성능 비교에 머물렀지만, 반사실적 프롬프트(Counterfactual Prompting) 기법을 도입하여 실험적 검증 수행

✅ COT는 reasoning을 수행하는 것이 아니라, 모델이 문제 해결 방식을 "리마인드(Remind)"하는 역할을 한다는 점을 명확히 입증.

🚀 즉, 본 연구는 COT의 본질을 한층 더 명확히 밝히며, 향후 LLM의 reasoning 연구 방향을 설정하는 데 중요한 역할을 할 것으로 기대된다.

본 논문에서는 Chain-of-Thought Prompting (COT)의 효과를 분석하기 위해 반사실적(Counterfactual) 프롬프트 기법을 활용하였다. 이를 통해 COT의 효과가 발생하는 근본적인 원인이 무엇인지 규명하고자 했다.

1. 주요 실험 결과 (Results)

(1) Symbols(기호)의 영향 분석

✅ 숫자, 날짜, 인물 등의 기호(symbols)를 변경해도 성능에 거의 영향이 없었음.

- 예제: 프롬프트의 숫자를 그리스 문자(α, β, γ)로 변경해도 성능 유지

- 반면, 패턴이 유지되지 않으면 성능이 급격히 저하됨.

- → 즉, LLM은 숫자 자체보다는 문제의 구조(패턴)를 더 중요하게 사용함.

📌 핵심 발견:

➡️ 기호는 reasoning 성능에 크게 영향을 주지 않으며, 중요한 것은 패턴을 따르는 능력임.

(2) Patterns(패턴)의 중요성

✅ 프롬프트에서 논리적 패턴(예: 수식, 문제 해결 방식)이 사라지면 성능이 급격히 저하됨.

- COT 프롬프트에 수식을 제거하면 모델이 정답을 맞추지 못함.

- 예제: "5 + 2 = 7" 형태가 포함되지 않은 경우, 모델이 엉뚱한 답을 생성하는 경향.

- → 즉, 모델은 reasoning을 하는 것이 아니라, 특정 패턴을 따라 답을 생성하는 경향이 강함.

📌 핵심 발견:

➡️ LLM은 reasoning을 수행하는 것이 아니라, 문제 해결 방식(패턴)을 학습하고 이를 따름.

(3) 잘못된 정보가 포함된 경우

✅ Few-shot 예제에서 일부 정보를 고의적으로 틀리게 주었을 때, 모델 성능 변화 관찰

- 수학 문제에서는 예제의 수식이 틀려도 성능에 큰 영향을 주지 않음.

- 그러나 스포츠 reasoning 문제에서는 잘못된 정보가 포함되었을 때 성능이 크게 저하됨.

- 일부 경우, 틀린 정보가 성능을 오히려 향상시키는 경우도 발견됨.

- 예제: "SORTING" 문제에서 일부 잘못된 예제가 포함되었을 때, 모델이 이를 무시하고 올바른 답을 생성.

📌 핵심 발견:

➡️ 수학적 문제에서는 개별 수식이 틀려도 reasoning이 유지되지만, 논리적 reasoning이 필요한 경우(스포츠 문제)에서는 정답률이 하락함.

➡️ 즉, COT는 reasoning을 수행하는 것이 아니라, 단순한 패턴 매칭을 하고 있을 가능성이 큼.

(4) Surface-Level Manipulations (문장 스타일 변경)

✅ 프롬프트의 문장 스타일을 변경했을 때 성능이 저하됨.

- 문장을 Yoda 스타일로 변환 → 성능 저하

- 문장을 수동태로 변환 → 성능 저하

- 문장의 단어 순서를 바꾸었을 때 → 성능이 크게 떨어짐

📌 핵심 발견:

➡️ 모델은 reasoning을 수행하는 것이 아니라, 패턴과 문장 구조를 기반으로 답을 생성하는 경향이 있음.

➡️ 즉, LLM은 단어의 의미보다는 학습된 문장 구조를 따르는 경향이 있음.

(5) Concise Chain-of-Thought (CCOT) 기법

✅ CCOT (간결한 COT) 프롬프트를 활용하면 COT보다 짧은 프롬프트로도 성능 유지 가능.

- 기존 COT 프롬프트보다 20~30% 짧은 CCOT를 사용했을 때 성능이 비슷하거나 더 우수함.

- CCOT 예제:

- 기존 COT: "Shawn started with 5 toys. He got 2 more toys. 5 + 2 = 7."

- CCOT: "Shawn: 5 + 2 = 7."

📌 핵심 발견:

➡️ COT 프롬프트는 reasoning을 유도하는 것이 아니라, 특정 패턴을 전달하는 역할을 함.

➡️ 즉, LLM이 reasoning을 수행하는 것이 아니라, 적절한 패턴을 학습하여 답을 생성하는 것에 가까움.

2. 연구 결론 (Conclusions)

(1) Chain-of-Thought(COT)는 문제 해결 방식(task understanding)을 전달하는 역할

- LLM은 reasoning을 수행하는 것이 아니라, COT 프롬프트를 통해 "이 문제는 이렇게 푸는 것이다"라는 방식을 학습함.

- 즉, COT는 reasoning을 도와주는 것이 아니라, "프롬프트의 패턴을 따르는 역할"을 한다는 것을 입증.

(2) COT는 상식적 정보를 보완하는 역할

- COT는 모델이 학습하지 않은 개념(예: 특정 스포츠 용어)도 reasoning을 가능하게 함.

- 그러나 이는 reasoning 능력이 뛰어나서가 아니라, 주어진 패턴을 확장하는 방식으로 답을 생성하기 때문임.

(3) COT는 reasoning이 아니라, "리마인드(Reminding)" 역할

- 모델이 새로운 정보를 학습하는 것이 아니라, 이미 알고 있는 정보를 리마인드(remind) 하는 역할을 수행.

- 즉, COT는 단순한 학습이 아니라, 특정 패턴을 강화하는 역할을 한다.

3. 연구의 한계 및 향후 연구 방향 (Limitations & Future Work)

(1) 연구의 한계

✅ COT의 효과가 특정 모델(GPT-3, PaLM-62B)에 한정됨.

- 실험 결과가 특정 LLM에서만 검증되었기 때문에, 다른 모델에서도 동일한 효과가 발생하는지 추가 연구 필요.

✅ LLM이 실제 reasoning을 수행하는지에 대한 검증 부족

- 본 연구에서는 LLM의 reasoning 능력이 아닌, COT 패턴의 역할만 분석함.

- 실제로 LLM이 reasoning을 수행하는지에 대한 심층적인 연구가 필요함.

✅ COT가 reasoning을 촉진하는 것이 아니라, 패턴 매칭을 한다는 점이 주요 결과

- 그러나 LLM이 reasoning을 수행하도록 유도하는 방법론은 추가적으로 연구되어야 함.

(2) 향후 연구 방향

✅ 더 효과적인 COT 프롬프트 개발

- CCOT를 기반으로 한 최적의 COT 프롬프트 설계 연구 필요

- "Concise COT"를 확장하여 더 적은 예제로도 효과적인 reasoning을 유도하는 방법 연구

✅ LLM의 reasoning 능력을 강화하는 연구 필요

- 단순히 패턴을 따라가는 것이 아닌, 실제 reasoning 능력을 강화할 수 있는 프롬프트 기법 연구

- "Pattern-Only COT" vs. "Generalizable COT" 비교 연구 진행 필요

✅ COT를 이용한 강건한 프롬프트 설계 연구

- 문장 구조 변경(Yoda 스타일, 수동태 등)에 강인한 COT 프롬프트 설계

- 모델이 단순한 패턴이 아닌 논리적 reasoning을 수행하도록 유도하는 방법론 연구 필요

4. 최종 요약

✅ COT의 효과는 기호(symbols)보다는 패턴(patterns)과 문장 구조의 일관성에 의해 결정됨.

✅ COT는 학습이 아니라 "문제 해결 방식을 리마인드(Remind)" 시키는 역할을 수행.

✅ 향후 연구에서는 LLM이 실제로 reasoning을 수행할 수 있도록 강화하는 연구가 필요.

🚀 즉, 본 연구는 COT의 본질을 한층 더 명확히 밝히며, 향후 LLM의 reasoning 연구 방향을 설정하는 데 중요한 역할을 할 것으로 기대된다.

이 그림은 Chain-of-Thought Prompting (COT)의 효과를 분석하기 위해 반사실적(Counterfactual) 프롬프트 기법을 활용한 실험을 시각적으로 보여준다. 그림은 기본 프롬프트(Base Prompt)를 중심으로 다양한 요소를 수정한 반사실적 프롬프트와 그에 따른 모델 응답 변화를 비교한 결과를 담고 있다.

1. 기본 프롬프트 (Base Prompt)

구성:

- Question (Q): "If there are 3 cars in the parking lot and 2 more cars arrive, how many cars are in the parking lot?"

- Thought (T): "There are originally 3 cars. 2 more cars arrive. 3 + 2 = 5."

- Answer (A): "The answer is 5 cars."

역할:

- 기본적으로 모델이 COT 방식으로 문제를 풀 때 사용하는 표준 프롬프트.

- 이 프롬프트는 LLM이 단계별 reasoning 과정을 따르도록 설계되었다.

2. 반사실적 프롬프트 (Counterfactual Prompts)

기본 프롬프트의 특정 요소를 변경하여 COT의 효과를 분석하기 위한 실험.

(1) What if we don’t have actual numbers?

- 변경 내용:

- 숫자(3, 2)를 기호(α, β)로 대체.

- 예: "If there are α cars and β more arrive, how many cars are in the parking lot?"

- Thought (T): "There are originally α cars. β more cars arrive. α + β = λ."

- Answer (A): "The answer is λ cars."

- 목적:

- 숫자와 같은 구체적 기호가 reasoning에 얼마나 중요한지 분석.

- 모델이 reasoning을 수행할 때 기호보다는 패턴에 의존하는지 확인.

(2) What if the prompt is misleading?

- 변경 내용:

- Thought(T)의 계산을 의도적으로 잘못 기재.

- 예: "3 + 2 = 7" (잘못된 reasoning).

- Answer (A): "The answer is 7 cars."

- 목적:

- 프롬프트에 틀린 정보가 포함되었을 때, 모델이 이를 무시하고 올바른 reasoning을 수행할 수 있는지 확인.

(3) What if the syntax of thought is less frequent?

- 변경 내용:

- Thought(T)의 문장 구조를 변경.

- 예: "Originally 3 cars, there are. 2 more cars arrive. 3 + 2 = 5."

- Yoda 스타일의 비주류 문장 구조 적용.

- Answer (A): "The answer is 5 cars."

- 목적:

- LLM이 reasoning을 수행할 때 문장 구조의 빈도(frequency)에 얼마나 의존하는지 분석.

- 비정형적 문장이 포함되었을 때 성능 저하가 발생하는지 확인.

3. 결과 분석의 핵심

이 실험을 통해 연구진은 다음을 확인하였다:

- Symbols (기호)의 중요성:

- 숫자를 기호로 대체해도 성능에는 큰 영향을 미치지 않음.

- 이는 모델이 숫자 자체보다는 패턴과 문장 구조를 더 중시함을 시사.

- Misleading Prompts:

- Thought(T)에 잘못된 reasoning이 포함되면, 모델이 그대로 답을 생성하는 경향을 보임.

- 이는 LLM이 실제로 reasoning을 수행하지 않고, 패턴을 따라가는 경향이 강하다는 점을 보여줌.

- Syntax Variation:

- 문장 구조가 비정형적인 경우 성능이 저하됨.

- 즉, 모델은 reasoning을 수행할 때 패턴의 정형성(frequency)에 의존.

4. 결론

이 그림은 COT가 reasoning을 강화하는 방식을 시각적으로 잘 보여준다. 특히, 반사실적 프롬프트를 활용하여 COT의 핵심 메커니즘을 다음과 같이 요약할 수 있다:

- COT의 효과는 숫자(기호)가 아닌, 패턴과 문장 구조의 일관성에 크게 의존.

- 모델은 reasoning을 수행하는 것처럼 보이지만, 실제로는 학습된 패턴을 따라가는 경향이 강함.

- 프롬프트 설계의 중요성을 강조하며, 비정형적인 문장 구조나 틀린 정보를 포함했을 때 모델의 성능이 크게 저하될 수 있음을 입증.

이 실험은 LLM의 한계와 개선 방향을 탐구하는 데 중요한 기반을 제공한다.

Table 1: COT가 다양한 태스크에서 기호와 패턴을 어떻게 사용하는지 분석

이 표는 Chain-of-Thought Prompting (COT)이 다양한 태스크에서 어떻게 기호(Symbols)와 패턴(Patterns)을 사용하는지 구체적으로 설명한다. 각각의 태스크별로 질문(Question), 사고 과정(Thought), 기호(Symbols), 패턴(Patterns)이 정리되어 있다.

(1) Mathematical (수학적 문제 해결)

- Question: Shawn은 5개의 장난감을 가지고 있고, 부모님이 각각 2개의 장난감을 추가로 주었다. 총 장난감은 몇 개인가?

- Thought: "Shawn은 원래 5개의 장난감을 가지고 있었고, 추가로 4개의 장난감을 받았다. 5 + 4 = 9."

- Symbols: 숫자 5, 4, 9

- Patterns: 수학적 수식 형태 (예: "5 + 4 = 9")가 사고 과정의 마지막에 포함됨.

- 의의: COT는 계산식과 같은 명확한 패턴을 따라야 높은 성능을 보임.

(2) Commonsense (스포츠 상식 검증)

- Question: "Jamal Murray는 자유투에서 완벽했다."라는 문장이 타당한가?

- Thought: "Jamal Murray는 농구 선수이다. 자유투는 농구의 일부이다."

- Symbols: "Jamal Murray" (인물), "Being perfect from the line" (활동)

- Patterns: 인물(Person)과 스포츠(Sport)를 연결하는 일관된 문장 구조 (예: "Person belongs to Sport").

- 의의: 스포츠 상식 문제에서는 일관된 문장 구조가 중요한 패턴으로 작용.

(3) Commonsense (날짜 계산)

- Question: 1969년 4월 19일에서 24시간 후의 날짜는 무엇인가?

- Thought: "오늘은 1969년 4월 19일이다. 24시간 후는 하루 뒤인 1969년 4월 20일이다."

- Symbols: 날짜(04/19/1969, 04/20/1969)

- Patterns: 사고 과정이 두 단계로 진행됨 (1. 초기 계산, 2. 최종 출력 생성).

- 의의: 날짜 관련 reasoning에서 초기 계산과 결과 생성의 패턴이 중요하다.

(4) Symbolic (숫자 정렬 문제)

- Question: 3, 1, 2, 7, 8, 5, 6, 9, 4를 오름차순으로 정렬하라.

- Thought: "작은 숫자 < 큰 숫자 (예: 1 < 2)."

- Symbols: 숫자(2, 4, 9 등)

- Patterns: 숫자가 작은 것에서 큰 것으로 정렬되는 논리적 순서 (예: "1 < 2 < ... < 9").

- 의의: 숫자 정렬 문제에서는 숫자의 관계성과 정렬 패턴이 중요하다.

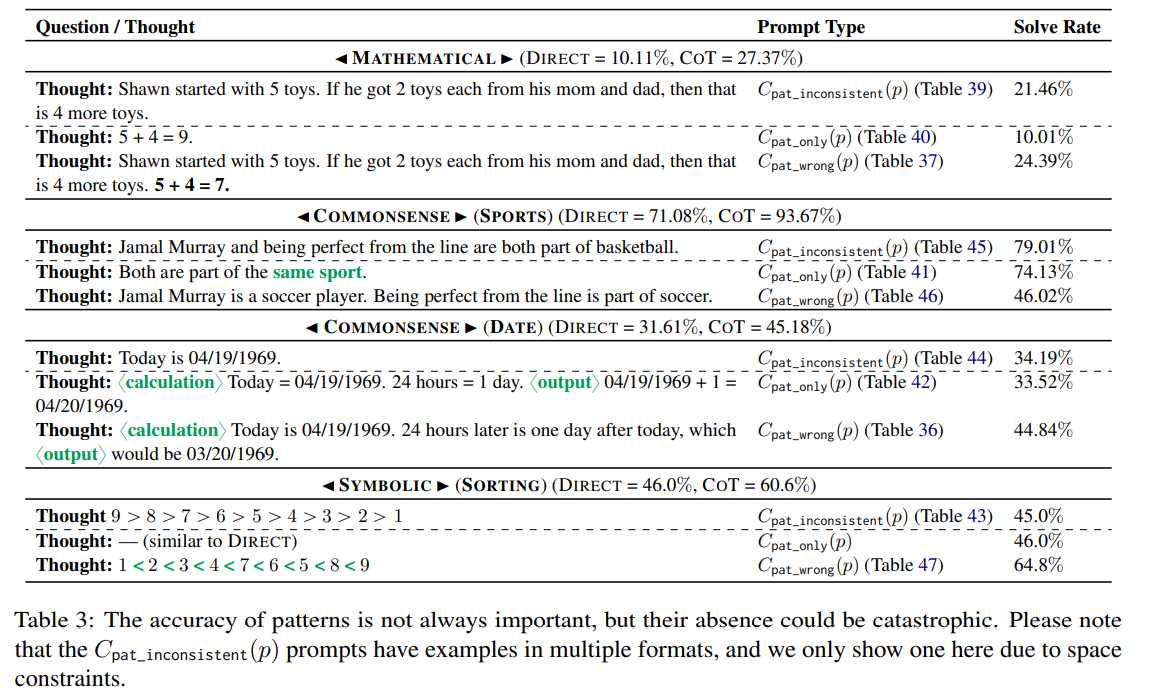

Table 2: 반사실적 프롬프트(Counterfactual Prompts)와 성능 비교

이 표는 반사실적 프롬프트를 활용해 COT와 Direct Prompting (Few-shot Prompting)의 성능을 비교한 결과를 보여준다. 각 태스크에서 표준 프롬프트와 기호(Symbols) 및 패턴(Patterns)의 수정이 모델의 성능에 미치는 영향을 분석한다.

(1) Mathematical (수학적 문제 해결)

- Direct Prompting 성능: 10.11%

- COT 성능: 27.37%

- Counterfactual Prompting:

- 기호를 추상 기호(α, β)로 대체한 경우: 25.70%

- OOD(Out-of-Distribution) 값(5.5, 2.5)을 삽입한 경우: 28.20%

- 분석:

- Direct Prompting보다 COT가 더 높은 성능을 보이며, 기호의 구체적 값보다는 패턴의 일관성이 중요한 요소임.

(2) Commonsense (스포츠)

- Direct Prompting 성능: 71.08%

- COT 성능: 93.67%

- Counterfactual Prompting:

- 기호를 추상화한 경우: 92.11%

- 비정상적 활동(Juggling the paper cups)을 포함한 경우: 79.72%

- 분석:

- 스포츠 상식 문제에서 COT의 성능이 Direct보다 우수하며, 패턴과 문장 구조가 중요한 역할을 함.

- 비정상적 활동은 성능 저하를 초래함.

(3) Commonsense (날짜 계산)

- Direct Prompting 성능: 31.61%

- COT 성능: 45.18%

- Counterfactual Prompting:

- 날짜를 추상 기호로 대체한 경우: 37.41%

- 날짜를 비현실적 값(04/30/3069)으로 변경한 경우: 44.50%

- 분석:

- 날짜 계산 문제에서 COT가 Direct보다 성능이 우수하며, 초기 계산과 결과 생성 패턴이 중요.

- 비현실적 날짜를 사용할 경우에도 모델이 높은 성능을 보임.

(4) Symbolic (숫자 정렬 문제)

- Direct Prompting 성능: 46.00%

- COT 성능: 60.60%

- Counterfactual Prompting:

- 기호를 추상화한 경우: 61.8%

- 비현실적 순서(기호 배열)를 포함한 경우: 80.0%

- 분석:

- 숫자 정렬 문제에서 COT가 Direct보다 높은 성능을 보이며, 숫자의 정렬 패턴이 중요.

- 기호의 세부적인 형태보다 논리적 순서가 더 큰 영향을 미침.

결론

- Table 1:

- 각 태스크에서 기호(Symbols)와 패턴(Patterns)이 LLM의 reasoning 성능에 미치는 주요 요소를 정리.

- 모든 태스크에서 패턴이 핵심적인 역할을 하며, COT의 성공은 reasoning이 아닌 패턴 인식 능력에 기반함.

- Table 2:

- 반사실적 프롬프트를 통해 COT의 패턴 의존성을 실험적으로 입증.

- 기호나 값의 세부적인 변화보다, 문장 구조와 패턴의 일관성이 더 중요한 요소임.

- COT가 Direct보다 consistently 높은 성능을 보이며, reasoning 태스크에서의 중요성을 확인.

이 실험은 COT가 reasoning을 강화하는 것이 아니라 패턴 기반 사고 과정을 강화한다는 점을 명확히 보여준다. 🚀

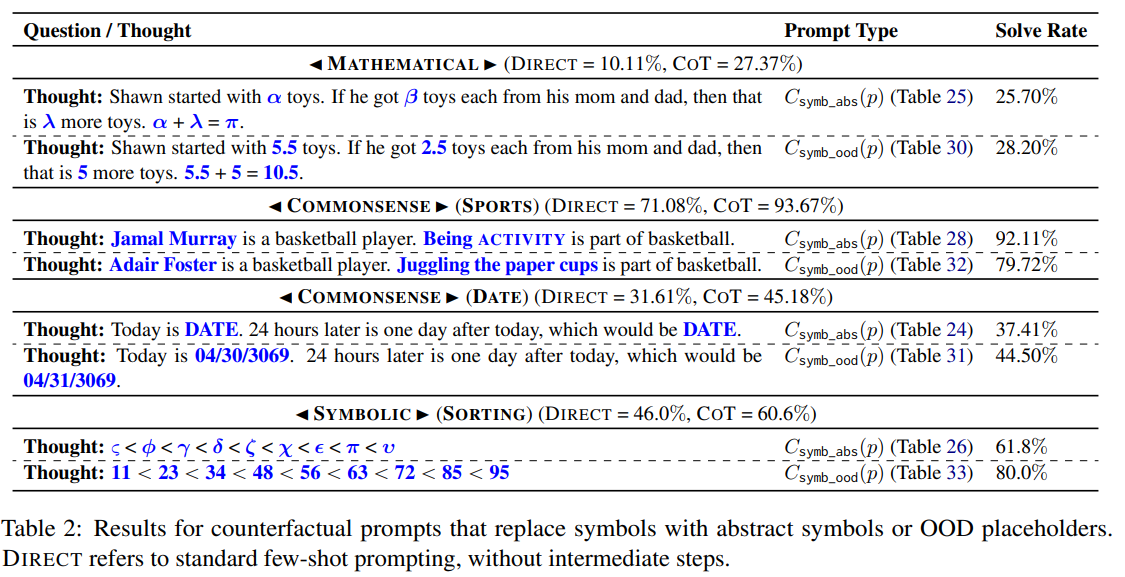

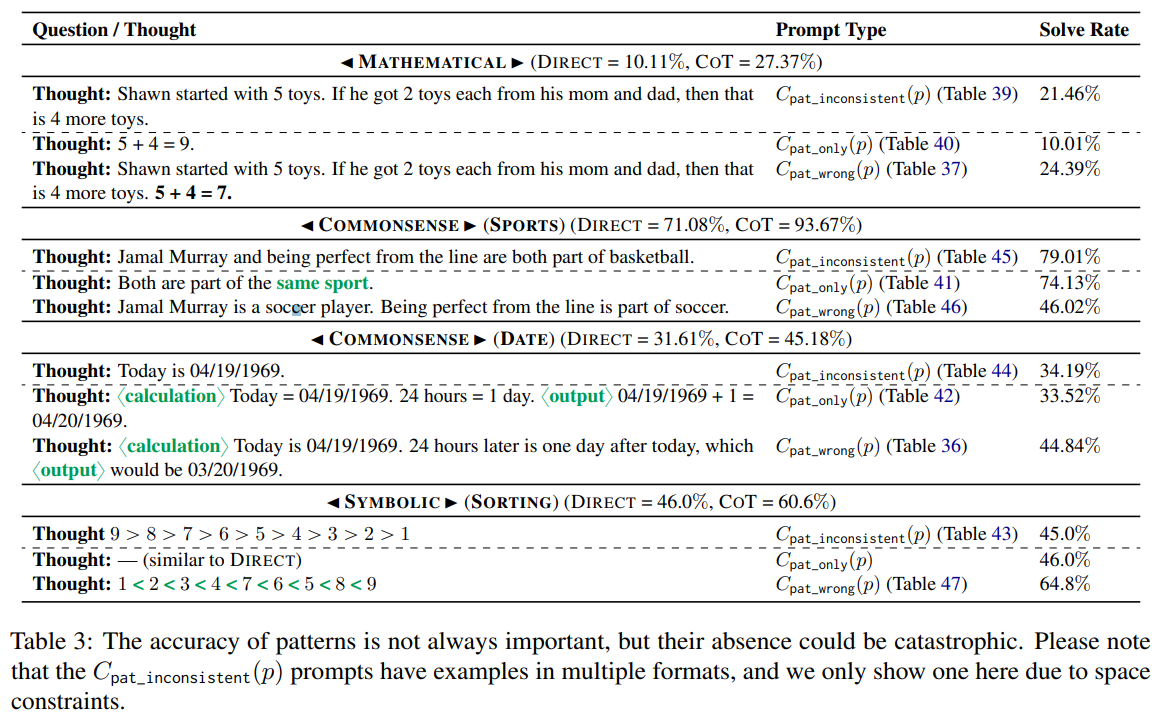

Table 3: 패턴의 중요성과 일관성 분석

이 표는 다양한 태스크에서 패턴의 중요성과 패턴 일관성의 부재가 성능에 미치는 영향을 보여준다. 특히, 패턴이 일치하지 않거나 잘못된 경우 성능이 어떻게 변화하는지 분석하고 있다.

(1) Mathematical (수학 문제 해결)

- COT Solve Rate (기본): 27.37%

- 패턴 일관성 부재 (C_pat_inconsistent): 21.46%

- 패턴만 제공 (C_pat_only): 10.01%

- 패턴이 잘못된 경우 (C_pat_wrong): 24.39%

- 분석:

- 패턴이 일치하지 않을 경우 성능이 감소.

- 하지만 패턴이 일부 잘못된 경우에도 모델이 일정 부분 reasoning을 수행함.

(2) Commonsense (스포츠)

- COT Solve Rate (기본): 93.67%

- 패턴 일관성 부재 (C_pat_inconsistent): 79.01%

- 패턴만 제공 (C_pat_only): 74.13%

- 패턴이 잘못된 경우 (C_pat_wrong): 46.02%

- 분석:

- 스포츠 문제에서 패턴 일관성이 중요하며, 패턴이 잘못되면 성능이 크게 하락함.

(3) Commonsense (날짜 계산)

- COT Solve Rate (기본): 45.18%

- 패턴 일관성 부재 (C_pat_inconsistent): 34.19%

- 패턴만 제공 (C_pat_only): 33.52%

- 패턴이 잘못된 경우 (C_pat_wrong): 44.84%

- 분석:

- 날짜 계산 문제에서도 패턴 일관성이 중요하며, 잘못된 패턴이 포함된 경우 성능이 유지되는 경우도 있음.

(4) Symbolic (숫자 정렬 문제)

- COT Solve Rate (기본): 60.60%

- 패턴 일관성 부재 (C_pat_inconsistent): 45.00%

- 패턴만 제공 (C_pat_only): 46.00%

- 패턴이 잘못된 경우 (C_pat_wrong): 64.80%

- 분석:

- 숫자 정렬 문제에서는 패턴이 잘못되더라도 성능이 크게 영향을 받지 않음.

Table 4: Yoda 스타일 텍스트 변경이 성능에 미치는 영향

이 표는 프롬프트의 텍스트 스타일을 Yoda 방식으로 변경했을 때, 태스크별 성능 변화를 분석한 결과를 보여준다.

(1) Mathematical (수학 문제 해결)

- COT Solve Rate: 27.37%

- Yoda 스타일 Solve Rate: 23.22%

- 분석:

- 텍스트 스타일이 변경되었을 때 성능이 소폭 감소하였음.

- 이는 LLM이 수학 문제에서 패턴보다는 텍스트 구조에 일부 의존한다는 것을 보여줌.

(2) Commonsense (스포츠)

- COT Solve Rate: 93.67%

- Yoda 스타일 Solve Rate: 68.26%

- 분석:

- 텍스트 스타일 변경이 스포츠 상식 문제에서 성능에 큰 영향을 미쳤음.

- 모델이 텍스트의 전통적인 문장 구조에 강하게 의존하고 있음.

(3) Commonsense (날짜 계산)

- COT Solve Rate: 45.18%

- Yoda 스타일 Solve Rate: 30.75%

- 분석:

- 날짜 계산 문제에서도 텍스트 스타일 변경이 성능을 크게 저하시킴.

- 이는 모델이 reasoning을 수행하기보다 텍스트의 패턴에 의존함을 의미.

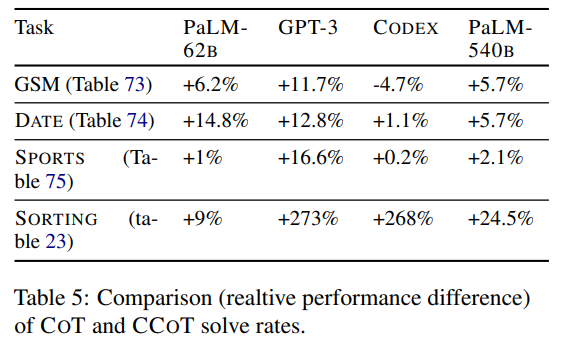

Table 5: 다양한 모델에서 COT와 CCOT의 성능 비교

이 표는 네 가지 태스크(GSM, DATE, SPORTS, SORTING)에서 다양한 모델(PaLM-62B, GPT-3, Codex, PaLM-540B)에 대해 COT와 CCOT의 상대적 성능 차이를 비교한 결과를 보여준다.

(1) GSM (수학 문제 해결)

- PaLM-62B: +6.2%

- GPT-3: +11.7%

- Codex: -4.7%

- PaLM-540B: +5.7%

- 분석:

- 대부분의 모델에서 COT가 CCOT보다 우수하지만, Codex에서는 CCOT가 더 나은 결과를 보임.

(2) DATE (날짜 계산)

- PaLM-62B: +14.8%

- GPT-3: +12.8%

- Codex: +1.1%

- PaLM-540B: +5.7%

- 분석:

- DATE 태스크에서는 모든 모델에서 COT가 CCOT보다 우수함.

- 특히 PaLM-62B와 GPT-3에서 큰 성능 차이가 나타남.

(3) SPORTS (스포츠)

- PaLM-62B: +1%

- GPT-3: +16.6%

- Codex: +0.2%

- PaLM-540B: +2.1%

- 분석:

- 스포츠 상식 문제에서는 상대적으로 적은 성능 차이를 보임.

- GPT-3에서 COT가 CCOT보다 더 큰 성능 향상을 보여줌.

(4) SORTING (숫자 정렬)

- PaLM-62B: +9%

- GPT-3: +273%

- Codex: +268%

- PaLM-540B: +24.5%

- 분석:

- 숫자 정렬 문제에서는 CCOT가 Direct Prompting보다 훨씬 더 우수하며, 특히 GPT-3와 Codex에서 큰 성능 차이를 보임.

종합 분석

- Table 3: 패턴 일관성의 부재는 성능 저하를 초래하며, 특히 reasoning 태스크에서 패턴의 역할이 매우 중요함.

- Table 4: 텍스트 스타일의 변화(Yoda 스타일)는 태스크별로 성능에 차별적 영향을 미치며, 전통적 문장 구조에 대한 의존성이 드러남.

- Table 5: 다양한 모델에서 COT가 CCOT보다 상대적으로 우수하지만, 태스크와 모델에 따라 성능 차이가 다름.

➡️ 결론:

COT의 효과는 패턴과 문장 구조에 강하게 의존하며, 다양한 태스크와 모델에서 COT와 CCOT의 효율성을 구체적으로 이해하려면 추가적인 실험과 분석이 필요하다.

Role of Symbols: 심볼이 모델의 이해와 성능에 미치는 역할 분석

3.1 Method: 심볼 정의 및 실험 설계

(1) Symbols의 정의

- 심볼(Symbol)은 모델이 태스크를 이해하고 해결책을 도출하는 데 사용하는 토큰 시퀀스를 의미.

- 각 태스크에 적합한 심볼의 정의:

- GSM-8K (수학 문제): 숫자(예: 5, 4).

- SORTING (정렬 문제): 정렬에 사용되는 숫자(예: 2, 9).

- DATE (날짜 계산): 날짜(예: 01/01/2021).

- SPORTS (스포츠 관련 상식): 인물(예: Michael Jordan)과 활동(예: dunked the ball).

(2) Counterfactual Prompts: 심볼 변형 실험

심볼이 모델의 태스크 이해와 성능에 미치는 영향을 분석하기 위해 반사실적 프롬프트를 설계함. 두 가지 주요 변형을 실험:

- Abstract Symbols (추상 심볼):

- 심볼을 추상적인 플레이스홀더(Placeholder)로 대체.

- 예: SPORTS에서 "scoring a three-pointer"를 ACTIVITY로 대체.

- Out-of-Distribution (OOD) Symbols (분포 밖 심볼):

- 학습 데이터에 존재하지 않는 심볼로 대체.

- 예:

- GSM-8K: 정수를 분수로 대체(예: 5 → 5.5).

- SPORTS: 실제 인물 이름을 임의의 이름으로 변경(예: Jamal Murray → Adair Foster).

- DATE: 3000년 이후의 날짜로 변경(예: 04/19/1969 → 04/30/3069).

(3) 실험 설계

- Few-shot 예제에서만 심볼을 조작하고, 질문 자체는 변경하지 않음.

- 목표: 조작된 심볼로 학습한 예제를 기반으로, 모델이 원래 질문의 심볼을 일반화하여 답할 수 있는지 평가.

3.2 Results: 실험 결과 분석

(1) Abstract Symbols (추상 심볼)

- 심볼을 추상 플레이스홀더로 대체한 경우, 대부분의 태스크에서 성능에 거의 영향을 미치지 않음.

- 결과:

- GSM-8K의 경우, 출력 응답에 추상 심볼(예: 그리스 문자)이 포함된 비율은 12.91%.

- SPORTS에서는 출력 응답에 추상 심볼이 거의 포함되지 않음.

- 모델이 추상 심볼을 사용할 때도 약 **36.5%**의 사례에서 정답을 도출.

- 결론:

- 심볼 자체가 아닌, 문장 구조와 패턴이 모델 성능에 더 중요한 역할을 함.

(2) OOD Symbols (분포 밖 심볼)

- 분포 밖 심볼을 도입했을 때 태스크별로 상이한 성능 결과를 보임:

- GSM-8K (수학 문제):

- 정수를 분수로 대체했을 때, 성능에 큰 변화가 없었음.

- DATE (날짜 계산):

- 3000년 이후 날짜를 사용해도 성능에 큰 영향을 미치지 않음.

- SPORTS (스포츠 상식):

- 인물 이름을 임의의 이름으로 대체하거나, 스포츠 활동을 무관한 활동(예: "Juggling the paper cups")으로 변경했을 때, 성능이 크게 저하됨.

- 정확도 하락: Jamal Murray → Adair Foster, 활동 변경으로 성능 저하(Table 2 참고).

- SORTING (숫자 정렬):

- 큰 숫자를 사용했을 때, 성능이 크게 향상(60.6% → 80.0%).

- GSM-8K (수학 문제):

- 결론:

- OOD 심볼이 태스크 이해에 미치는 영향은 태스크의 특성에 따라 다르며, SPORTS처럼 심볼과 활동 간의 관계성이 중요한 경우 성능이 민감하게 반응.

추가 분석: Attention Analysis (주의 메커니즘 분석)

- 심볼이 변경된 프롬프트와 원래 프롬프트에서의 Attention Pattern을 비교.

- 결과:

- GSM-8K에서 심볼이 추상 심볼로 대체된 경우에도, Attention Pattern은 거의 동일.

- 이는 모델이 reasoning 과정에서 심볼 자체보다는 일관된 패턴에 의존하고 있음을 시사.

결론 및 시사점

- 심볼 자체의 중요성은 제한적:

- 추상적 심볼로 대체하거나 OOD 심볼을 사용해도 대부분의 태스크에서 큰 성능 저하가 없었음.

- 이는 모델이 reasoning 과정에서 심볼보다는 문장 패턴과 구조에 더 의존함을 보여줌.

- SPORTS와 같은 특정 태스크에서는 심볼이 중요:

- 스포츠 문제에서는 심볼(인물과 활동)이 명확히 정의되어야 높은 성능을 발휘.

- OOD 심볼로 변경 시, 태스크 이해에 혼란을 주어 성능이 저하됨.

- 추론 과정에서 패턴 의존성 확인:

- Attention 분석 결과, 모델은 심볼이 변해도 동일한 Attention 패턴을 보이며, 이는 reasoning이 아니라 패턴 매칭에 의존하고 있음을 시사.

- 향후 연구 방향:

- 심볼과 패턴의 상호작용에 대한 심층적인 연구 필요.

- OOD 심볼 상황에서도 강건한 reasoning을 수행하는 모델 개발 필요.

이 연구는 심볼과 패턴이 모델 reasoning 성능에 미치는 영향을 심층적으로 분석하며, 향후 COT 프롬프트 설계 및 심볼 중심 태스크 최적화를 위한 중요한 기반을 제공한다.