https://link.springer.com/article/10.1007/s10489-020-02144-x

청킹에 대해 찾아보다가 이 논문을 보게 되었습니다.

문서에 대한 청킹을 찾으려고 했는데 여긴 문장 단위 청킹이 들어가서 좀 다른 내용이긴 하지만 그래도 뭔가 새로운 내용을 배운 것 같습니다.

이러한 방법을 문서 단위 청킹으로 들어가기엔 컴퓨팅 자원이 너무 들어가서 사용 불가능할 것 같지만 그래도 문장을 작은 의미 단위로 나눠 청크를 비교하고, 유사도를 계산하며 쌍 분류를 통해 직관적인 해석을 보여줘 높은 점수를 받았습니다.

논문의 발표 년도가 좀 오래 되기도 했고, 지금과 같은 초 거대 LLM시대엔 좀 다를 것 같긴 합니다...?

| 연구 목표 | 문장 간 유사성(semantic textual similarity, STS)을 정량화하고, 해석 가능성을 추가하여 왜 두 문장이 유사하거나 다른지 설명 가능하도록 모델 개발. |

| 핵심 기여 | - STS 문제에 해석 가능성(interpretable layer)을 추가. - 5단계 모듈(Chunking, Alignment, Scoring, Classification, Interpretability) 기반 프레임워크 제안. |

| 주요 기술 및 방법 | 1. Chunking: 문장을 작은 단위로 분할 (MaxEntropy 분류기 사용). 2. Alignment: 1:1 및 1:M 정렬 기법 적용. 3. Scoring: 문자열, 의미적, 문법적 유사성을 활용해 점수화. 4. Classification: 정렬 유형(EQUI, SIMI 등)을 SVM 기반으로 분류. 5. Interpretability Layer: 정렬 결과와 점수를 종합해 해석 가능한 설명 생성. |

| 주요 데이터셋 | - 뉴스 헤드라인 데이터셋 (1,131 쌍) - 이미지 캡션 데이터셋 (1,125 쌍) - 학생 답변 데이터셋 (674 쌍) |

| 결과 요약 | 1. Chunking 성능: IOB 정확도 90.4%(뉴스), 98.5%(이미지). 2. Alignment 성능: F1 점수 95.2%(뉴스), 93.4%(이미지). 3. Classification 성능: SVM 분류 기반 F1 점수 82%(뉴스). 4. Scoring 성능: 회귀 모델 평균 절대 오차(MAE) 0.42 기록. |

| 결론 | - 기존 STS 모델보다 높은 성능과 해석 가능성 제공. - 다양한 NLP 응용 분야(대화형 AI, 정보 검색, 교육)에서 활용 가능성 입증. |

| 한계 및 개선 방향 | - 다중 언어 지원 부족: 현재 영어에 한정된 모델. - 데이터 불균형 문제: 특정 유형(EQUI, SIMI 등)에 데이터 집중. - 복잡한 문장 구조에 대한 추가 검증 필요. |

| 향후 연구 방향 | 1. 다중 언어 환경에서 적용 가능한 모델 확장. 2. 긴 텍스트나 비정형 데이터에 대한 테스트. 3. Textual Entailment(TE), 대화형 AI 등으로의 응용 확장. |

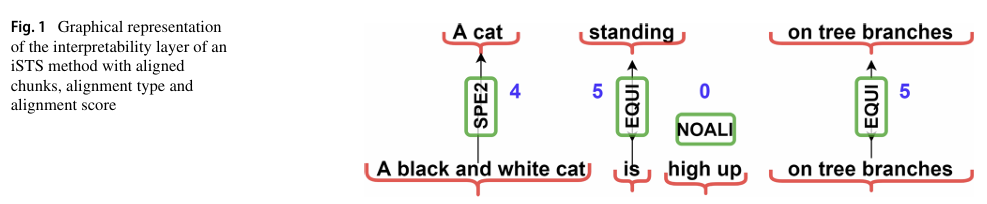

이 Figure는 iSTS (Interpretable Semantic Textual Similarity) 방법의 Interpretability Layer를 시각적으로 나타낸 것으로, 문장 간 청크(chunk) 단위 정렬, 정렬 유형(alignment type), 유사성 점수(alignment score)를 설명하고 있습니다.

Figure의 구성

- 문장 간 Chunk 정렬:

- 두 문장이 각각 청크 단위로 분리되어 서로 비교됩니다.

- 위 문장: "A cat standing on tree branches."

- 아래 문장: "A black and white cat is high up on tree branches."

- 각 청크는 붉은 중괄호로 표시되어, 비교 대상이 명확히 구분됩니다.

- 두 문장이 각각 청크 단위로 분리되어 서로 비교됩니다.

- 정렬 유형 (Alignment Type):

- 각 청크 쌍 간의 관계를 나타냅니다. 정렬 유형은 녹색 상자로 표시되며, 다음 유형을 포함합니다:

- SPE2: 아래 문장의 청크가 위 문장의 청크보다 더 구체적(Specific)인 경우.

- EQUI: 두 청크가 동등(Equivalent)한 경우.

- NOALI: 정렬되지 않은 청크 (유사성이 없거나 대응 관계가 없음).

- 각 청크 쌍 간의 관계를 나타냅니다. 정렬 유형은 녹색 상자로 표시되며, 다음 유형을 포함합니다:

- 유사성 점수 (Alignment Score):

- 각 청크 쌍 간의 유사성을 0~5의 점수로 정량화합니다. 점수는 파란색 숫자로 표시됩니다.

- 5: 높은 유사성.

- 0: 유사성이 없음.

- 각 청크 쌍 간의 유사성을 0~5의 점수로 정량화합니다. 점수는 파란색 숫자로 표시됩니다.

Figure의 세부 설명

- 첫 번째 청크 비교:

- 위 문장: "A cat" ↔ 아래 문장: "A black and white cat".

- 정렬 유형: SPE2 (아래 문장이 위 문장보다 더 구체적임).

- 점수: 4 (의미적으로 유사하지만 약간의 차이 존재).

- 두 번째 청크 비교:

- 위 문장: "standing" ↔ 아래 문장: "is".

- 정렬 유형: EQUI (두 단위가 동등한 의미를 가짐).

- 점수: 5 (완벽히 동등한 의미).

- 세 번째 청크 비교:

- 위 문장: (빈 청크) ↔ 아래 문장: "high up".

- 정렬 유형: NOALI (위 문장에는 해당 의미가 존재하지 않음).

- 점수: 0 (유사성이 없음).

- 네 번째 청크 비교:

- 위 문장: "on tree branches" ↔ 아래 문장: "on tree branches".

- 정렬 유형: EQUI (완전히 동일한 의미).

- 점수: 5 (최대 유사성).

Figure의 의미

- 이 Figure는 iSTS 방법이 문장 간의 유사성을 단순히 점수로 표현하는 것을 넘어서, 각 청크의 관계를 상세히 분석하고 해석 가능한 방식으로 시각화한다는 점을 보여줍니다.

- 실용성:

- 이와 같은 해석 계층은 결과를 인간이 직관적으로 이해하기 쉽게 하며, 대화형 AI, 정보 검색, 교육 튜터링과 같은 응용 분야에 유용합니다.

- 정렬 유형 및 점수는 두 문장의 차이점과 유사성을 더 깊이 이해할 수 있도록 도와줍니다.

추가적인 설명이 필요하면 언제든지 요청해주세요!

이 Figure와 Table은 iSTS(Interpretable Semantic Textual Similarity) 방법의 전체 구조와 예제를 보여줍니다.

Figure 2: iSTS 방법의 주요 구성 요소

Figure 2는 iSTS 시스템의 워크플로우를 시각적으로 설명하며, 각 단계가 텍스트 데이터를 처리하는 과정을 나타냅니다.

1. Input Handling and Chunking (입력 처리 및 청킹)

- 목적: 문장을 청크(chunk)라는 작은 의미 단위로 분리.

- 입력 문장에서 의미적으로 독립적인 단위(예: 주어, 동사구, 목적어 등)를 생성.

- 이 단계는 이후 정렬 및 유사성 평가의 기본이 됩니다.

- 예: "George W Bush weighs into immigration debate" → [George W Bush], [weighs into], [immigration debate].

2. Alignment (정렬)

- 1:1 Aligner:

- 두 문장의 청크를 1:1로 정렬하여 가장 유사한 쌍을 우선 연결.

- 1:M Aligner:

- 남아 있는 청크를 처리하기 위해 1:M 정렬 수행 (하나의 청크를 여러 청크와 연결 가능).

- 이 과정에서 청크 간의 유사성을 점수화하고 정렬 관계를 결정.

3. Measuring Similarity and Relatedness Score (유사성 및 관련 점수 계산)

- 각 청크 쌍의 유사성을 0~5 사이 점수로 계산.

- 유사성 점수는 문자열 유사도(Jaccard, Cosine), 의미적 유사도(Word2Vec, GloVe), 문법적 유사도(WordNet)를 결합하여 산출.

4. Classification (정렬 유형 분류)

- 각 청크 쌍의 관계를 다음 유형으로 분류:

- EQUI: 동등한 의미.

- SPE1/SPE2: 한쪽이 더 구체적.

- REL: 관련성 있음.

- NOALI: 정렬되지 않음.

5. Interpretability Layer (해석 가능 계층)

- 최종적으로 정렬된 청크, 유사성 점수, 정렬 유형을 종합하여 해석 가능한 결과를 생성.

- 이 계층은 사용자가 결과를 직관적으로 이해할 수 있도록 시각화하거나 설명을 제공합니다.

Table 1: 뉴스 헤드라인 데이터셋에서의 Gold Standard 청크

Table 1은 Figure 2에서 설명된 iSTS 프로세스를 예제로 보여줍니다.

문장 쌍

- 문장 1: George W Bush weighs into immigration debate.

- 문장 2: George W. Bush warns against bitter immigration debate.

Gold Standard Chunks

- 각 문장이 청크 단위로 분리됩니다.

- 문장 1:

- [George W Bush], [weighs into], [immigration debate].

- 문장 2:

- [George W. Bush], [warns against], [bitter immigration debate].

- 문장 1:

해석

- 이 예제는 문장 간의 청크 정렬 및 관계를 보여줍니다.

- [George W Bush] ↔ [George W. Bush]: 동등한 의미 (EQUI).

- [weighs into] ↔ [warns against]: 유사하지만 다른 뉘앙스 (SIMI 또는 REL).

- [immigration debate] ↔ [bitter immigration debate]: 아래 문장이 더 구체적 (SPE2).

Figure와 Table의 연결성

- Figure 2는 iSTS 시스템의 전체적인 구조와 프로세스를 설명.

- Table 1은 해당 시스템의 실제 데이터셋에서의 동작을 예제로 보여줌.

- 특히, 청크 생성, 정렬 및 유사성 평가가 어떻게 이루어지는지에 대한 구체적인 사례를 제공합니다.

이 구조는 iSTS가 단순히 문장 간 유사성을 점수화하는 것을 넘어서, 청크 간의 정밀한 관계와 해석 가능한 결과를 제공한다는 점을 잘 나타냅니다.

추가적으로 궁금한 점이 있으면 말씀해주세요!

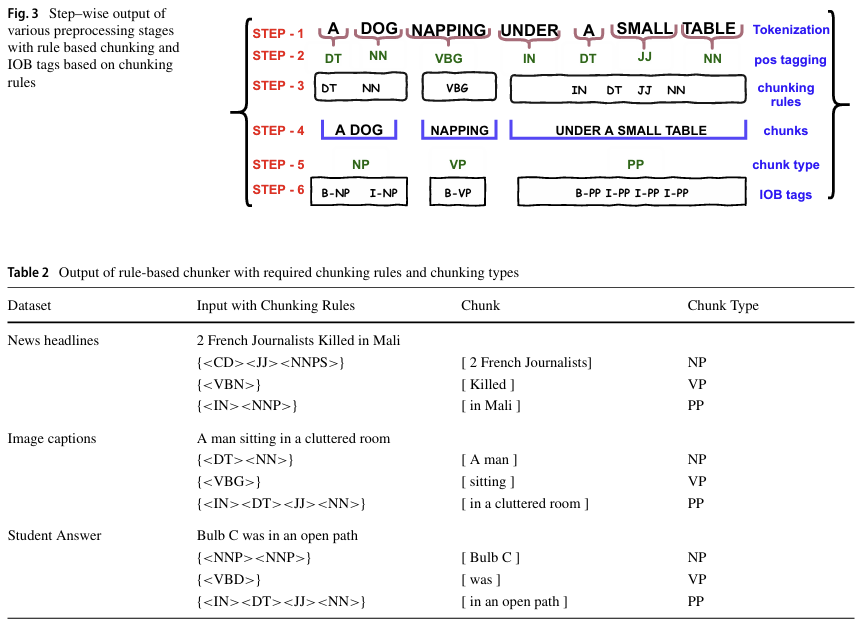

Fig. 3: 단계별 청킹 과정

Fig. 3은 Rule-based Chunking의 단계별 과정을 시각적으로 설명합니다. 각 단계는 문장을 처리하여 청크(chunk)를 생성하고 이를 태깅(IOB Tagging)하는 전체 과정을 나타냅니다.

단계별 설명

- Step 1: Tokenization (토큰화)

- 문장을 단어 단위로 분리합니다.

- 예: "A dog napping under a small table" → A, dog, napping, [under], a, [small], [table].

- 문장을 단어 단위로 분리합니다.

- Step 2: POS Tagging (품사 태깅)

- 각 단어에 품사 태그를 할당합니다.

- Step 3: Chunking Rules 적용

- 사전 정의된 청킹 규칙에 따라 품사 태그를 기반으로 청크를 그룹화합니다.

- 예: DT + NN → 명사구(Noun Phrase, NP)

- VBG → 동사구(Verb Phrase, VP)

- IN + DT + JJ + NN → 전치사구(Prepositional Phrase, PP)

- 사전 정의된 청킹 규칙에 따라 품사 태그를 기반으로 청크를 그룹화합니다.

- Step 4: 청크 생성

- 품사 태그를 그룹화한 결과로 청크를 생성합니다.

- 예: A dog, napping, under a small table.

- 품사 태그를 그룹화한 결과로 청크를 생성합니다.

- Step 5: 청크 유형 할당

- 각 청크에 청크 유형(NP, VP, PP 등)을 할당합니다.

- Step 6: IOB Tagging

- 청크의 시작과 내부를 구분하기 위해 IOB 태그를 사용합니다.

- B-: 청크의 시작 (Begin)

- I-: 청크의 내부 (Inside)

- 예: A dog → [B-NP], [I-NP]

napping → [B-VP]

under a small table → [B-PP], [I-PP], [I-PP], [I-PP].

- 청크의 시작과 내부를 구분하기 위해 IOB 태그를 사용합니다.

Table 2: Rule-based Chunker 결과

Table 2는 서로 다른 데이터셋에서 Rule-based Chunker가 적용된 결과를 보여줍니다.

구성 요소

- Input with Chunking Rules:

- 입력 문장에서 사전 정의된 청킹 규칙을 적용한 부분.

- 규칙은 품사 태그 패턴(예: <DT><NN> 또는 <IN><DT><JJ><NN>)으로 표현됩니다.

- Chunk:

- 청킹 규칙에 의해 생성된 청크 결과.

- 예: "2 French Journalists Killed in Mali" →

- 2 French Journalists, Killed, in Mali.

- Chunk Type:

- 생성된 청크의 유형:

- NP: 명사구

- VP: 동사구

- PP: 전치사구

- 생성된 청크의 유형:

데이터셋별 결과

- News Headlines:

- 예문: "2 French Journalists Killed in Mali".

- 청크 결과:

- Image Captions:

- 예문: "A man sitting in a cluttered room".

- 청크 결과:

- Student Answer:

- 예문: "Bulb C was in an open path".

- 청크 결과:

Fig. 3와 Table 2의 연결성

- Fig. 3:

- Rule-based Chunker의 세부 처리 과정을 시각적으로 보여줍니다.

- 문장을 처리하는 단계별 과정 (토큰화 → 품사 태깅 → 청크 생성 → 태깅)을 명확히 설명.

- Table 2:

- 실제 데이터셋에 적용한 Rule-based Chunker의 결과를 사례로 제시.

- 청킹 규칙에 따른 청크 생성 결과와 청크 유형을 구체적으로 설명.

의의

- Fig. 3:

- 청킹 과정의 구조적 이해를 돕는 시각적 자료로, Rule-based Chunker의 처리 단계를 명확히 설명.

- Table 2:

- Rule-based Chunker가 실제 데이터셋에서 동작하는 방식을 구체적으로 보여줌.

- 뉴스, 이미지 캡션, 학생 답변 등 다양한 텍스트 유형에서 적용 가능한 방법론임을 입증.

추가 질문이 있다면 언제든지 말씀해주세요! 😊

1. 문제 정의

- Semantic Textual Similarity (STS)는 두 문장의 의미적 유사성을 측정하는 NLP 문제로, 의미적으로 유사하거나 차이가 있는 문장을 평가합니다.

- 본 논문은 기존 STS 기법에 해석 가능성을 추가하여, 문장 간 유사성 점수뿐만 아니라 왜 유사하거나 다른지에 대한 설명을 제공하는 Interpretable STS (iSTS) 방법론을 제안합니다.

2. 연구 방법론

- 주요 목표: 문장을 chunk(문장의 작은 단위) 단위로 나누고, 이를 정렬하여 유사성 점수와 정렬 유형을 해석 가능한 방식으로 제공.

- 전체 모델은 다음 5단계 모듈로 구성:

- Preprocessing and Chunking: 문장을 전처리 후 chunk로 분리.

- Rule-based와 MaxEntropy 기반 분류기를 비교하여 더 정확한 chunk를 생성.

- Alignment: 두 문장의 chunk를 정렬.

- 1:1 정렬 후, One-to-Multi (1:M) 방식으로 추가 정렬.

- Scoring: 정렬된 chunk 간의 유사성을 0~5 사이 점수로 평가.

- 다양한 문자열 유사도, 임베딩 기반 유사도, WordNet 기반 유사도 활용.

- Classification: 정렬 유형을 EQUI, SIMI, SPE1 등으로 분류.

- Gaussian Naive Bayes, k-NN, SVM 분류기 사용.

- Interpretability Layer: 정렬된 chunk, 유사성 점수, 유형을 종합하여 해석 가능한 출력 제공.

- Preprocessing and Chunking: 문장을 전처리 후 chunk로 분리.

3. 데이터 및 실험

- 데이터셋: 뉴스 헤드라인, 이미지 캡션, 학생 답변 세 가지 도메인에서 수집된 문장 쌍.

- 총 데이터: 1,131쌍(뉴스), 1,125쌍(이미지 캡션), 674쌍(학생 답변).

- 평가 메트릭:

- Chunk 분할 정확도(IOB Accuracy), Alignment 정확도(F1), Classification 결과(Precision, Recall).

- 평가 지표:

- 유사성 점수와 정렬 유형 정확도.

주요 결과:

- Chunking: MaxEntropy 기반 chunking이 Rule-based 방식보다 정확.

- 예: 뉴스 데이터에서 IOB 정확도 90.4% 기록.

- Alignment: 1:M 정렬 기법으로 F1 점수가 기존 방식 대비 평균 5~10% 개선.

- 이미지 캡션에서 F1 점수: 93.4%.

- Classification: SVM 분류기가 최고 성능을 기록.

- 전체 데이터셋 평균 F1: 82%.

- Scoring: 선형 회귀를 통한 점수 예측에서 평균 오차(MAE)가 0.42로 낮음.

4. 주요 기여

- 해석 가능성: 단순 점수화가 아닌, chunk별 구체적 차이와 유사성 설명.

- 성능 향상: 기존 state-of-the-art 방법론 대비 chunk 분할, 정렬, 점수화 모두에서 높은 정확도 달성.

- 응용: 제안된 iSTS 모듈을 Textual Entailment 문제로 확장해, 추가적인 성능 향상을 확인.

5. 결론 및 의의

- 제안된 iSTS 방법은 NLP에서 중요한 STS 문제를 인간의 직관과 유사한 방식으로 해결 가능.

- 활용 가능성: 자동 튜터링 시스템, 대화형 AI, 정보 검색 등 여러 도메인에서 유용하게 적용 가능.

- 향후 연구: 더 복잡한 문장 구조 및 다중 언어 데이터셋으로 확장 가능.

방법론: Interpretable STS (iSTS)

본 논문에서 제안한 iSTS 방법론은 두 문장의 의미적 유사성을 해석 가능한 방식으로 평가하기 위해 5단계의 모듈형 구조를 제안합니다. 각 모듈은 입력 문장을 처리, 비교, 분석하여 최종적으로 유사성 점수와 해석 가능한 출력(정렬 유형 및 점수)을 생성합니다.

1단계: Preprocessing 및 Chunking

- 목적: 문장을 작은 의미 단위(chunk)로 나누어 분석의 기본 단위로 활용.

- 작동 방식:

- 전처리: 문장에서 특수 문자 제거, 대소문자 통일, 불용어(stop words) 제거.

- 예: 문장 "The quick brown fox jumps over the lazy dog!" → "quick brown fox jumps lazy dog".

- Chunking: 문법 규칙(rule-based) 또는 MaxEntropy 분류기를 사용해 chunk 생성.

- Rule-based: 품사 태그(POS tag)를 기반으로 사전 정의된 규칙 적용.

- MaxEntropy: 문맥 정보를 반영하여 동적 chunking 수행.

- 전처리: 문장에서 특수 문자 제거, 대소문자 통일, 불용어(stop words) 제거.

- 예시: 문장: "A quick brown fox jumps over a lazy dog."

- Rule-based: [A quick brown fox], [jumps], [over a lazy dog]

- MaxEntropy: [A quick], [brown fox], [jumps], [over], [a lazy dog]

MaxEntropy 방식은 문맥적 정보(예: "quick"과 "brown"의 연관성)를 더 잘 반영해 세부적으로 chunk를 분리합니다.

2단계: Alignment (정렬)

- 목적: 두 문장의 chunk를 비교하여 일대일(1:1) 또는 일대다(1:M) 방식으로 정렬.

- 작동 방식:

- 1:1 정렬: 동일하거나 유사한 단어를 기준으로 가장 강력한 연관성을 가진 chunk 쌍을 우선 정렬.

- 예: "A brown fox" ↔ "The brown fox" (동일 정보로 정렬).

- 1:M 정렬: 남은 chunk를 문맥적 유사도에 따라 다중 정렬.

- 예: "over a lazy dog" ↔ "above the dog" + "with laziness".

- 1:1 정렬: 동일하거나 유사한 단어를 기준으로 가장 강력한 연관성을 가진 chunk 쌍을 우선 정렬.

- 정렬 기준:

- 문자열 유사도(Jaccard, Cosine): 단어 간 유사도를 수치로 표현.

- 의미적 유사도: Word2Vec, GloVe 임베딩을 활용해 문맥적 의미 평가.

- 문법적 유사도: WordNet을 활용해 동의어, 상위어(hypernym), 반의어 관계 파악.

3단계: Scoring (유사성 점수 계산)

- 목적: 정렬된 chunk 쌍의 유사도를 0에서 5까지 점수로 표현.

- 0점: 관련 없음, 5점: 의미적 동등.

- 작동 방식:

- 문자열 유사도: Jaccard, Cosine 유사도로 단어 구성 비교.

- Jaccard 예시: "brown fox"와 "fox" → 공통 단어 비율 = 1/2 = 0.5.

- 의미적 유사도: GloVe나 Word2Vec 벡터 간 코사인 유사도 계산.

- 문법적 유사도: WordNet 기반으로 동의어, 상위어 여부 평가.

- 회귀 모델: 위에서 얻은 모든 특성을 결합하여 선형 회귀를 사용해 유사성 점수 예측.

- 문자열 유사도: Jaccard, Cosine 유사도로 단어 구성 비교.

- 예시:

- Chunk: "A quick brown fox" ↔ "The brown fox".

- Jaccard: 0.75 (단어 중 3/4이 유사).

- GloVe: 0.8 (의미적으로 높은 유사성).

- 최종 점수: 4.5 (문맥과 구성 모두 높은 유사성으로 평가).

4단계: Classification (정렬 유형 분류)

- 목적: 각 chunk 쌍의 관계를 정렬 유형으로 분류 (예: EQUI, SIMI, REL 등).

- 정렬 유형:

- EQUI: 완전히 동등 (예: "A cat" ↔ "A feline").

- SIMI: 유사하나 완전히 동등하지 않음 (예: "A quick fox" ↔ "A fast fox").

- REL: 관련은 있지만 직접적으로 연결되지 않음 (예: "The fox" ↔ "The animal").

- SPE1/SPE2: 특정 쪽이 더 구체적임 (예: "A cat" ↔ "A black cat").

- OPPO: 의미가 반대 (예: "The fox jumped up" ↔ "The fox jumped down").

- 예시:

- Chunk: "A quick fox" ↔ "A fox".

- 유형: SPE1 (첫 번째 chunk가 더 구체적).

- Chunk: "The fox is running" ↔ "The fox stopped".

- 유형: OPPO (의미 반대).

5단계: Interpretability Layer (해석 가능 계층)

- 목적: 정렬된 chunk, 유형, 점수를 종합하여 사용자에게 직관적 설명 제공.

- 출력 형태:

- 입력 문장: "A quick brown fox jumps over a lazy dog." ↔ "The brown fox leaps above the dog."

- 해석 계층:

- [Chunk 1: "A quick brown fox"] ↔ [Chunk 2: "The brown fox"], 유형: SIMI, 점수: 4.5.

- [Chunk 1: "jumps over"] ↔ [Chunk 2: "leaps above"], 유형: EQUI, 점수: 5.

- [Chunk 1: "a lazy dog"] ↔ [Chunk 2: "the dog"], 유형: SPE1, 점수: 4.

이러한 출력은 유사성과 차이를 직관적으로 표현하며, 시스템 결과를 더 잘 이해하도록 돕습니다.

예시 기반의 이해를 높인 방법론의 장점

- 세분화된 분석: 단어 수준에서 문장 수준까지 유사성을 평가 가능.

- 해석 가능성: 왜 특정 문장이 유사한지 또는 다른지를 명확히 설명.

- 응용 가능성: 대화형 AI, 텍스트 검색, 교육 튜터링 등에서의 활용 가능성.

논문의 결과, 결론 및 마무리

1. 결과

- iSTS 시스템의 성능

- Chunking:

- MaxEntropy 기반 chunking은 rule-based 방식보다 높은 정확도와 세부적인 문장 분해 결과를 제공.

- 뉴스 헤드라인 데이터셋에서 IOB 정확도는 90.4%, 이미지 캡션에서는 98.5%로 기록.

- Alignment:

- 제안된 1:M 정렬 기법은 기존 1:1 정렬보다 정밀도가 높아, 정렬 정확도가 평균적으로 5~10% 향상.

- 이미지 캡션 데이터셋의 정렬 F1 점수: 93.4% (gold standard chunk 기준).

- Scoring:

- 다중 선형 회귀 기반 점수 계산은 평균 절대 오차(MAE)가 0.42로 낮아, 정밀한 유사성 점수 계산 가능.

- Classification:

- SVM 기반 정렬 유형 분류기가 가장 높은 정확도를 기록.

- 뉴스 데이터셋에서 정렬 유형 F1 점수: 82%.

- 통합 평가:

- 전체 모듈 성능(F1): 뉴스 헤드라인 95.2%, 이미지 캡션 93.4%, 학생 답변 89.4%.

- Chunking:

- iSTS의 비교 우위

- 기존 state-of-the-art 방법들과의 비교에서 chunk 분할, 정렬, 점수화, 정렬 유형 분류 모든 면에서 우수한 성능을 달성.

- 특히 2015~2016년 SemEval iSTS 과제의 상위 모델들보다 높은 정확도와 해석 가능성을 제공.

- Textual Entailment(T.E.) 응용 결과

- iSTS 기반 T.E. 시스템은 chunk-level, sentence-level, alignment 정보를 결합하여 성능을 개선.

- Pascal RTE-1 데이터셋에서 정확도 65.4% (개발 세트)와 60.3% (테스트 세트)를 기록하며, alignment 정보의 중요성을 입증.

2. 결론

- 핵심 기여

- 제안된 iSTS 방법은 기존의 단순 유사성 점수 제공 시스템을 넘어, 유사성과 차이점의 해석 가능성을 제공.

- 유사성을 점수화하고, chunk 단위에서 정렬 유형과 차이점을 명확히 설명하여 인간의 직관과 유사한 분석 결과를 생성.

- NLP 분야에서 STS 문제를 보다 정밀하게 해결할 수 있는 체계적인 프레임워크를 제시.

- 효용성

- iSTS는 대화형 AI, 지능형 튜터링 시스템, 정보 검색 등 다양한 도메인에서 실질적인 유용성을 가지며, 데이터의 의미적 분석 및 활용 가능성을 크게 확장.

- 기술적 우위

- 다중 모듈(Chunking, Alignment, Scoring, Classification)의 통합으로, 기존 방식 대비 해석성과 정확성을 모두 개선.

- 특히, MaxEntropy 기반 chunking 및 1:M 정렬 기법은 실질적인 성능 향상에 크게 기여.

3. 마무리 및 향후 연구 방향

- 연구 요약

- 본 논문은 해석 가능한 STS 방법론을 통해 문장 간 유사성과 차이점을 체계적으로 분석하고, 이를 다양한 도메인에 활용할 수 있음을 실험적으로 입증.

- Textual Entailment 문제에도 응용하여 iSTS의 범용성과 성능 향상을 확인.

- 한계점

- 현재 연구는 영어 데이터셋에 초점을 맞추고 있어, 다중 언어 지원 및 언어적 다양성에 대한 추가 검증이 필요.

- 특정 정렬 유형(OPPO, REL 등)에 대한 데이터 불균형이 성능에 영향을 미칠 수 있음.

- 향후 연구 방향

- 다중 언어 환경: 다양한 언어에서 적용 가능한 범용 iSTS 시스템 구축.

- 복잡한 문장 구조: 더 긴 문장 및 복잡한 구조를 가진 문장 쌍에 대한 평가와 개선.

- 응용 확장: 지능형 정보 검색, 대화형 AI, 지능형 교육 시스템 등에서 iSTS 모듈의 실용화 연구.

본 연구는 NLP의 STS 문제를 해결하는 데 있어 단순 점수 계산 이상의 해석 가능한 모델의 가능성을 열어주었으며, 향후 다양한 응용으로 확장될 잠재력을 입증했습니다.

논문과 관련된 연구 및 관련 논문 정리

본 논문은 Interpretable Semantic Textual Similarity (iSTS)의 새로운 접근법을 제안하며, 유사한 문제를 해결하거나 보완적 접근을 취한 기존 연구와 비교 분석을 진행합니다. 아래는 논문에서 직접 참조하거나 연관된 주요 연구들을 정리한 내용입니다.

1. iSTS의 배경이 되는 연구

- Semantic Textual Similarity (STS) 연구 흐름

- 초기 STS 연구:

- 2006년: Mihalcea et al.은 텍스트의 의미적 유사성을 측정하기 위해 코퍼스 기반 및 지식 기반 방법론을 제안 .

- STS의 주요 목표는 문서 간 또는 문장 간의 의미적 유사성을 정량화하여 정보 검색, 요약, 의미적 검색 등에 적용.

- SemEval STS 과제:

- 2012년~현재: SemEval 워크샵을 통해 STS 문제에 대해 여러 팀이 다양한 기법을 제안 .

- 유사성 점수화뿐 아니라, 해석 가능한 STS (iSTS) 과제를 도입하여 유사성과 차이점을 설명 가능하도록 요구.

- 초기 STS 연구:

- 유사성 점수화 기법의 발전

- 문자열 기반 유사성: Jaccard, Cosine, Levenshtein 거리 등.

- 분산 표현 기반:

- Mikolov et al.의 Word2Vec , GloVe , FastText 등의 임베딩 기술로 단어 간의 의미적 유사성 평가가 가능해짐.

- 문맥적 유사성:

- BERT와 같은 컨텍스트 기반 모델은 텍스트의 문맥적 의미를 더 깊이 이해하는 데 기여.

2. 관련된 주요 연구

- 기존 iSTS 모델

- NeRoSim 모델:

- Banjade et al.은 1:1 정렬 기반으로 chunk 간 유사성을 평가하고 Mikolov의 Word2Vec을 활용하여 의미적 유사성을 계산 .

- DTSim:

- Banjade et al.의 다른 연구로, chunk 정렬을 개선하기 위해 자동화된 분할 및 정렬 기법을 적용 .

- Inspire:

- Kazmi et al.은 논리 프로그래밍(Answer Set Programming)을 사용하여 정렬 및 유사성 평가를 수행 .

- Lopez et al.:

- 문장 간 차이를 설명하는 방법론을 도입. 주요 정렬 과정에 Mono-Lingual Word Aligner를 사용하고, 정렬 유형 및 점수를 추가적으로 계산 .

- NeRoSim 모델:

- Textual Entailment와의 연계

- Textual Entailment(TE) 문제는 한 텍스트(T)가 다른 텍스트(H)를 의미적으로 포함하는지 여부를 판단.

- Nielsen et al.:

- TE와 STS를 결합하여 학생 답변의 품질 평가에 활용 .

- PASCAL RTE 과제:

- TE 과제는 iSTS 연구와 결합 가능성을 보이며, T와 H 간의 의미적 관계를 세분화하는 데 도움 .

3. 본 논문과의 차별점

- Chunk 기반 접근:

- 본 논문은 문장을 의미 단위로 분해하여 chunk 단위에서 유사성을 계산.

- 1:1 정렬을 넘어 1:M 정렬 기법을 통해 더 복잡한 문장 구조를 처리.

- 해석 가능성 강조:

- 기존 모델은 유사성 점수에만 초점을 맞춘 반면, 본 논문은 유사성 유형과 차이점을 해석적으로 제공.

- 예: EQUI, SIMI, REL 등 세분화된 정렬 유형과 함께 점수를 제공.

4. 비교 분석

| 연구 | 주요 특징 | 한계 |

| NeRoSim | Word2Vec 기반 정렬, 유사성 점수 계산 | 다중 정렬(1:M)에 대한 지원 부족 |

| DTSim | 자동화된 chunk 정렬 기법 | 데이터의 복잡성을 다루는 성능 개선 필요 |

| Inspire | 논리 프로그래밍 기반으로 정렬, 유사성 평가 수행 | 일반화된 방법론 부족, 논리 기반의 유연성 제한 |

| Lopez et al. | 정렬 및 점수화를 위한 Mono-Lingual Word Aligner 사용 | 문장 분할(chunking) 기법의 미흡 |

| 본 논문 | MaxEntropy 기반 chunking, 1:M 정렬, 해석 가능성 제공 | 다중 언어 지원 및 데이터 불균형 문제 개선 필요 |

5. 향후 연구 방향

- 다중 언어 지원:

- 본 논문은 영어 중심으로 진행되었으나, 다중 언어 환경에서도 유사성과 해석 가능성을 제공할 수 있는 모델 연구 필요.

- 더 복잡한 데이터셋:

- 뉴스, 이미지 캡션, 학생 답변 외에도 긴 텍스트(논문, 보고서)나 비정형 데이터에 대한 확장 필요.

- 응용 연구:

- 교육(Tutoring Systems), 정보 검색, 대화형 AI에서 iSTS의 실질적 적용 연구.

이 논문은 STS와 TE 문제를 연결하며 해석 가능성이라는 중요한 요소를 더한 혁신적인 연구로, 관련 연구와의 차별성을 통해 NLP 응용에서의 발전 가능성을 제시합니다. 추가적인 논의가 필요하다면 말씀해주세요!

사용자가 작성한 요약에 대해 잘못되거나 부족한 부분을 판단하고, 이를 수정 및 보완해드리겠습니다.

사용자가 작성한 요약의 검토 및 피드백

- "문장 단위 청킹"과 관련된 표현:

- "문장 단위 청킹이 들어가서 좀 다른 내용"이라는 표현은 다소 모호하게 들립니다.

- 본 논문의 청킹은 문장을 구성하는 작은 단위(chunk)를 분할하여 정렬 및 유사성 계산에 사용하는 방식입니다. "문장 단위 청킹"보다는 "문장을 청킹하여 작은 의미 단위로 분해"라는 표현이 더 적합할 것 같습니다.

- "문서 단위 청킹"에 대한 언급:

- 문서 단위에서 청킹을 구현하기 어려운 점에 대한 언급은 적절하지만, 문장 단위 청킹이 컴퓨팅 자원이 부족해서 문서 단위로 확장할 수 없다는 설명은 정확하지 않을 수 있습니다. 실제로 문서 전체를 처리하기 위한 효율적인 방법론(예: 문서를 문장 단위로 나눈 후 병렬 처리)이 존재할 수 있습니다.

- "LLM 시대에 적합하지 않음"이라는 부분:

- 본 논문은 2021년에 발표되었으며, 초거대 LLM이 주류로 자리 잡기 시작한 이후의 연구입니다. 따라서 LLM 시대와의 괴리가 있다기보다는, LLM과 보완적으로 사용 가능한 방법론으로 볼 수 있습니다.

- 특히 iSTS는 해석 가능성을 강조하며, 거대 언어 모델(LLM)의 블랙박스 성격을 보완할 수 있다는 점에서 여전히 유의미한 연구로 간주됩니다.

수정 및 보완된 요약

청킹에 대해 알아보던 중, 문장 간 의미적 유사성을 해석 가능한 방식으로 평가하는 이 논문을 접하게 되었습니다.

문서 단위 청킹을 찾으려고 했으나, 이 논문은 문장을 작은 의미 단위로 나눠 chunk로 분리한 후, 이 chunk 간 유사성을 비교하여 점수화하고 정렬 유형을 분류하는 방법론을 제안했습니다. 이는 단순히 점수를 계산하는 것을 넘어 **직관적이고 해석 가능한 설명**을 제공하는 데 중점을 둔 방식입니다.

문서 단위 청킹에 적용하려면 컴퓨팅 자원 문제로 인해 어려움이 있을 수 있지만, 문장을 의미 단위로 나누고 비교하는 접근법은 문서 단위 문제를 해결하기 위한 기초적인 단계로 매우 유용할 수 있습니다.

논문이 발표된 시기가 2021년으로 초거대 LLM이 주목받기 시작한 이후의 연구이긴 하지만, 여전히 유의미한 점은 존재합니다. 특히 iSTS는 LLM의 결과를 해석 가능하게 만들거나, 문장 간 유사성을 세부적으로 평가하는 데 사용할 수 있어 보완적인 역할을 할 수 있을 것 같습니다.

주요 수정 내용

- 청킹에 대한 설명 강화:

- "문장을 작은 의미 단위로 나눠 chunk로 분리"라는 표현을 사용해 iSTS의 핵심 작업을 더 명확히 설명했습니다.

- 청킹이 문장 내의 작은 단위로 세분화된다는 점을 명확히 하여 "문장 단위 청킹"이라는 모호한 표현을 정정했습니다.

- 컴퓨팅 자원 문제 관련 보완:

- 문서 단위 청킹이 자원 문제로 어려움을 겪는 점을 언급하면서도, 문장 단위 접근법이 문서 분석의 기초가 될 수 있다는 긍정적인 가능성을 추가했습니다.

- LLM 시대와의 관계 재정립:

- iSTS가 LLM의 대안이 아니라 보완적인 역할을 할 수 있다는 점을 강조했습니다.

- LLM의 해석 가능성 부족을 보완하는 데 iSTS의 유용성을 언급했습니다.

추가적인 논의가 필요하면 말씀해주세요! 😊