https://arxiv.org/abs/2402.05131

Financial Report Chunking for Effective Retrieval Augmented Generation

Chunking information is a key step in Retrieval Augmented Generation (RAG). Current research primarily centers on paragraph-level chunking. This approach treats all texts as equal and neglects the information contained in the structure of documents. We pro

arxiv.org

일단 제가 찾던 논문 중 하나입니다!

Chunking을 토큰 단위로, 단어 수 단위로 진행하는 것이 아닌 구조적, 표와 그래프로 나눠 진행하는 것에 큰 의미가 있었네요

이 방법이 효과가 있었고, 높은 정답률을 보이기도 했고요!

내용을 확인한 것이 아니라 그 부분은 아쉽지만 그래도 내용까지 추가하면 더 좋은 결과가 나오지 않을 까 싶습니다.

| 문제 정의 | - RAG 시스템에서 기존의 단순 chunking(토큰 또는 문단 기반)은 문서의 구조적 정보를 반영하지 못함. - 금융 보고서와 같은 복잡한 문서에서는 문맥 보존과 정확한 정보 검색에 한계가 있음. |

| 연구 목적 | - 문서의 구조적 요소(제목, 본문, 표 등)를 기반으로 한 효과적인 chunking 전략 개발. - RAG 기반 시스템의 정보 검색 정확도와 질의응답(Q&A) 성능 향상. - 금융 도메인에서 최적의 문서 전처리 방식 탐구. |

| 방법론 | - Chipper 기반 구조적 chunking: 1. 문서의 제목, 본문, 표 등의 구조적 요소를 식별. 2. 요소별로 chunk 생성 규칙 적용(예: 표는 독립적으로 유지, 제목은 새로운 chunk 시작). 3. 메타데이터(키워드, 요약, 프리픽스) 추가로 검색 효율 향상. |

| 사용 데이터 | - FinanceBench: 금융 보고서 기반 Q&A 평가 데이터셋. 80개 문서, 141개 질문으로 구성. 평균 문서 길이: 약 147페이지(최대 549페이지). |

| 평가 방법 | - 정보 검색 정확도: 페이지 단위 및 문단 단위에서 ROUGE, BLEU 점수 계산. - 질의응답(Q&A) 정확도: 수작업 평가 및 GPT-4 자동 평가 사용. - 효율성: chunk 수와 인덱싱 비용 측면 평가. |

| 결과 | 1. 정보 검색 정확도: - 구조 기반 chunking(Chipper): 페이지 정확도 67.38%, 문단 수준 ROUGE 0.514, BLEU 0.400. - 여러 전략 결합 시 페이지 정확도 84.40%, ROUGE 0.568, BLEU 0.452. 2. Q&A 정확도: - Chipper: 수작업 평가 기준 53.19%로 가장 높은 성능. |

| 장점 | - 문서의 구조적 정보 보존: 문맥 왜곡 최소화. - 하이퍼파라미터 튜닝 불필요: 다양한 문서에 적용 가능. - 효율적 검색: 메타데이터를 활용해 검색 정확도와 속도 향상. - 비용 절감: chunk 수가 절반으로 줄어 인덱싱 비용과 검색 지연 감소. |

| 한계 | - 금융 도메인에 국한된 평가. - 추가적인 요소 간 관계(예: 본문과 표의 연관성)를 고려하지 못함. - RAG 구성 요소(예: 벡터 인코더, 검색 알고리즘)에 따른 성능 변화 분석 부족. |

| 미래 연구 방향 | - 금융 이외의 도메인(생의학, 법률 등)으로 확장. - 문서 요소 간 관계 분석(예: 표와 본문 연결성). - RAG 구성 최적화 및 다른 모델과의 성능 비교. - 복잡한 문서에서 추가 요소(이미지, 수식 등) 활용 방안 탐구. |

| 결론 | - 구조 기반 chunking은 RAG 시스템의 성능을 크게 향상시키며, 금융 보고서와 같은 복잡한 문서에서 유의미한 결과를 도출. - 정보 검색과 Q&A의 정확성 및 효율성을 동시에 개선하는 최적의 chunking 전략 제안. - 범용성과 비용 효율성이 높아 다른 도메인에도 적용 가능. |

이 Figure 1은 RAG (Retrieval-Augmented Generation) 시스템에서 문서를 기반으로 사용자의 질문에 답변을 생성하는 과정을 단계적으로 설명하는 흐름도입니다. 아래에 각 구성 요소와 단계에 대한 설명을 드리겠습니다.

1. Question (질문 입력)

- 사용자가 질문을 입력합니다. 예를 들어, "2021년 매출은 얼마입니까?"와 같은 질의가 입력됩니다.

2. Encoder (질문 벡터화)

- 입력된 질문은 벡터(수치 표현)로 변환됩니다.

- 여기서 사용되는 모델은 일반적으로 문장 임베딩 모델(예: Sentence Transformers)입니다.

- 질문을 벡터로 변환하는 이유는 질문과 문서의 각 chunk 간 유사성을 계산하기 위함입니다.

3. VectorDB (벡터 데이터베이스 검색)

- VectorDB는 문서의 chunk(분리된 텍스트 단위)가 벡터로 저장된 데이터베이스입니다.

- 질문 벡터와 데이터베이스에 저장된 chunk 벡터 간의 유사도를 계산하여, 가장 관련성이 높은 상위 k개의 chunk(top-k chunks)를 검색합니다.

4. Top-k Chunks (관련 chunk 검색)

- 질문과 가장 유사한 상위 k개의 chunk가 선택됩니다.

- 예: "2021년 매출"이라는 질문이 주어지면, "표: 2021년 매출: $10M"과 같은 관련된 chunk가 반환됩니다.

5. Question to Prompt (질문을 프롬프트로 변환)

- 사용자의 질문을 LLM(대규모 언어 모델)이 이해할 수 있도록 프롬프트 형식으로 변환합니다.

- 변환된 프롬프트는 질문과 관련된 chunk를 포함하며, 예시는 다음과 같습니다:

Question: "2021년 매출은 얼마입니까?" Sources: 1. "표: 2021년 매출: $10M" 2. "표: 2020년 매출: $8M"

- 변환된 프롬프트는 질문과 관련된 chunk를 포함하며, 예시는 다음과 같습니다:

6. Prompt + Generator (응답 생성)

- Generator(생성기):

- 변환된 프롬프트는 LLM(예: GPT-4)에 입력됩니다.

- LLM은 프롬프트를 기반으로 질문에 대한 답변을 생성합니다.

- 예: "2021년 매출은 $10M입니다."

7. Answer (최종 응답)

- 생성된 답변이 사용자에게 반환됩니다.

- 최종 출력은 간단한 응답일 수도 있고, 세부 정보가 포함된 서술적 응답일 수도 있습니다.

전체 과정의 요약

- 질문 입력 → 질문을 벡터화.

- VectorDB에서 유사도 계산 → 관련 chunk 검색.

- 검색된 chunk와 질문으로 프롬프트 생성 → LLM으로 응답 생성.

- 최종 응답 반환.

이 Figure의 의의

- 이 흐름도는 RAG 시스템의 기본 동작 방식을 체계적으로 설명합니다.

- 특히, RAG 시스템이 검색과 생성을 결합하여 정보를 정확하게 제공하는 메커니즘을 시각적으로 보여줍니다.

- 중요한 점은, chunking 전략이 이 프로세스의 핵심 요소로, 검색 및 생성 성능에 직접적으로 영향을 미친다는 것입니다.

추가적으로 궁금한 점이 있으면 말씀해 주세요!

Figure 2는 RAG 시스템에서 문서를 chunk(분리)하고, 이를 벡터 데이터베이스(VectorDB)에 인덱싱하는 과정을 시각적으로 설명한 흐름도입니다. 아래에서 각 단계에 대해 자세히 설명하겠습니다.

1. Document (문서)

- 입력된 문서입니다.

- 예를 들어, 10-K와 같은 기업의 연례 재무 보고서가 여기에 해당됩니다.

- 문서는 텍스트와 구조적 요소(예: 제목, 본문, 표 등)를 포함하고 있을 수 있습니다.

2. Chunker (chunk 생성기)

- 문서를 여러 chunk로 분리하는 단계입니다.

- Chunker의 역할:

- 문서의 구조적 요소(제목, 본문, 표 등)를 분석.

- 특정 규칙에 따라 문서를 분리(예: 제목이 나오면 새로운 chunk 생성, 표는 독립적인 chunk로 유지).

- 문맥과 의미를 유지하며, 적절한 길이(예: 512~2048 토큰)로 chunk를 생성.

예제:

문서:

제목: 회사 재무 보고서

본문: 이 문서는 2021년의 재무 상태를 설명합니다. 회사의 매출은 $10M입니다.

표: 매출: $10M, 비용: $8M

생성된 chunks:

[Chunk 1]: "제목: 회사 재무 보고서"

[Chunk 2]: "이 문서는 2021년의 재무 상태를 설명합니다. 회사의 매출은 $10M입니다."

[Chunk 3]: "표: 매출: $10M, 비용: $8M"

3. Chunks

- Chunker에 의해 생성된 텍스트 단위(chunk)입니다.

- 각각의 chunk는 문서 내에서 의미를 보존하는 작은 단위입니다.

- 이 단계에서 각 chunk는 문서의 전체 정보를 나눠 가진 상태입니다.

4. Encoder (벡터화)

- 각 chunk를 벡터(수치 표현)로 변환합니다.

- Encoder의 역할:

- NLP 모델(예: Sentence Transformers)을 사용하여 각 chunk의 의미를 수치적으로 표현.

- 이러한 벡터는 검색을 위해 유사도를 계산할 수 있는 형식입니다.

예제:

[Chunk 1]: "제목: 회사 재무 보고서" → [Vector 1]

[Chunk 2]: "이 문서는 2021년의 재무 상태를 설명합니다. 회사의 매출은 $10M입니다." → [Vector 2]

[Chunk 3]: "표: 매출: $10M, 비용: $8M" → [Vector 3]

5. Chunk Vectors

- Encoder에 의해 생성된 각 chunk의 벡터입니다.

- 이 벡터들은 문서의 정보를 포함하고 있으며, 추후 검색 단계에서 사용됩니다.

6. VectorDB (벡터 데이터베이스)

- 벡터 데이터베이스는 각 chunk의 벡터를 저장하는 공간입니다.

- VectorDB의 역할:

- 문서의 모든 chunk 벡터를 저장 및 인덱싱.

- 질문(Question)을 벡터로 변환한 후, 이 벡터와 데이터베이스 내 chunk 벡터 간 유사도를 계산하여 관련성이 높은 chunk를 반환.

요약

- 문서를 여러 chunk로 나누고(chunking), 각 chunk를 벡터로 변환(벡터화)합니다.

- 변환된 벡터는 VectorDB(벡터 데이터베이스)에 저장됩니다.

- 이 과정을 통해 문서를 효율적으로 검색할 수 있는 형태로 전처리합니다.

Figure의 의의

- 이 과정은 RAG 시스템에서 문서 전처리 단계의 핵심입니다.

- 문서를 chunk로 분리하고 벡터화하여, 검색 속도와 정확도를 높이는 데 기여합니다.

- 특히, 구조 기반 chunking(예: Chipper)이 효과적이라면, 의미 있는 chunk를 생성하여 더 나은 검색 결과를 제공할 수 있습니다.

추가 질문이 있으면 말씀해주세요!

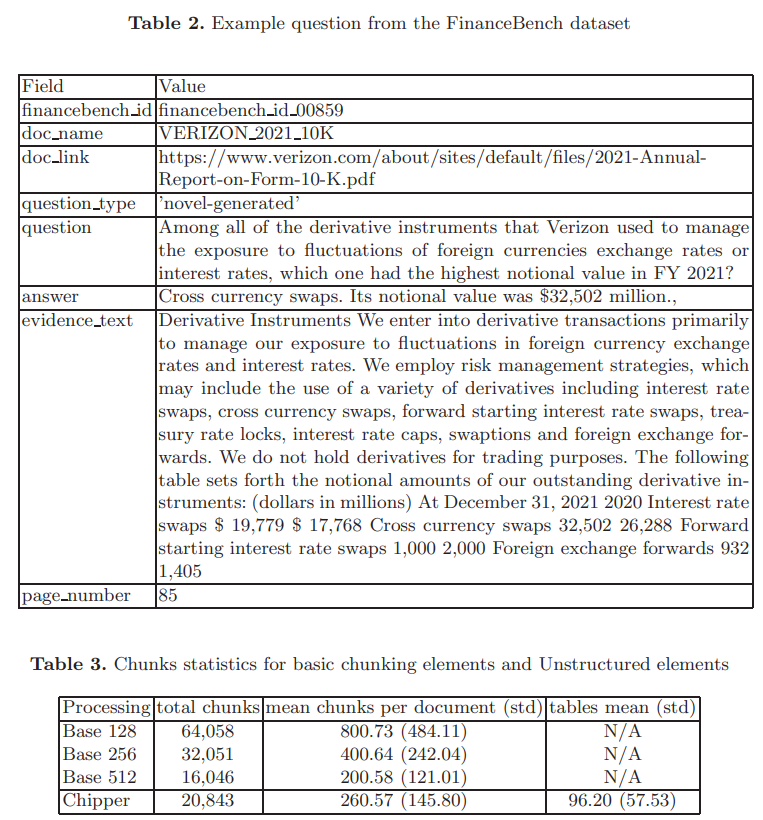

이 표(Table 2와 Table 3)는 FinanceBench 데이터셋과 chunking 전략의 통계를 보여줍니다. 각각에 대해 상세히 설명드리겠습니다.

Table 2: FinanceBench 데이터셋의 예제 질문

이 표는 FinanceBench 데이터셋에서 제공되는 질문-응답 예제를 설명하며, 문서의 세부 정보와 질문/응답에 필요한 주요 증거(evidence)를 포함합니다.

주요 필드 설명

- financebench_id:

- 이 질문-응답 쌍의 고유 ID로, 데이터셋 내에서 참조 가능합니다.

- doc_name:

- 질문과 응답이 추출된 문서의 이름.

- 예: VERIZON_2021_10K (버라이즌의 2021년 연례 보고서).

- doc_link:

- 문서의 URL로, 실제 문서가 공개된 위치를 가리킵니다.

- 예: 버라이즌의 연례 보고서 링크.

- question_type:

- 질문의 유형을 나타냅니다.

- novel-generated: 새롭게 생성된 질문임을 의미.

- question:

- 사용자 질문.

- 예: "Verizon이 외환 및 이자율 변동 관리를 위해 사용한 파생상품 중, 2021년 가장 높은 명목 가치를 가진 것은 무엇인가?"

- answer:

- 질문에 대한 정답.

- 예: "Cross currency swaps" (명목 가치: $32,502 million).

- evidence_text:

- 답변을 뒷받침하는 문서 내의 텍스트 내용.

- 예: 파생상품의 명목 금액과 관련된 정보를 담은 텍스트와 표.

- page_number:

- 증거 텍스트가 포함된 문서 페이지 번호.

- 예: 페이지 85.

Table 3: Chunking 전략 통계

이 표는 기본 토큰 기반 chunking(Base)과 구조 기반 chunking(Chipper)의 통계를 비교합니다.

항목 설명

- Processing:

- 각 chunking 전략의 이름.

- Base 128/256/512: 고정된 토큰 수(128, 256, 512)를 기준으로 chunk 생성.

- Chipper: 문서의 구조적 요소를 기반으로 chunk 생성(예: 제목, 본문, 표).

- 각 chunking 전략의 이름.

- Total chunks:

- 전체 문서에서 생성된 총 chunk 수.

- Base 128: 64,058개로 가장 많음 (짧은 크기로 많이 분리됨).

- Chipper: 20,843개로 가장 적음 (효율적 분할).

- 전체 문서에서 생성된 총 chunk 수.

- Mean chunks per document (std):

- 문서당 평균 chunk 수 및 표준 편차.

- Base 128: 평균 800.73개, 표준 편차 484.11.

- Chipper: 평균 260.57개, 표준 편차 145.80 (chunk 수가 안정적).

- 문서당 평균 chunk 수 및 표준 편차.

- Tables mean (std):

- 문서에서 표를 포함하는 chunk 수의 평균과 표준 편차.

- Base 전략에서는 표에 대한 통계가 제공되지 않음.

- Chipper는 평균 96.20개의 표를 포함하는 chunk를 생성, 표준 편차는 57.53.

- 문서에서 표를 포함하는 chunk 수의 평균과 표준 편차.

Table 2와 Table 3의 연계

- Table 2의 예제 질문은 "Verizon의 2021년 연례 보고서"와 관련된 정보를 검색하는 과정에서 발생합니다.

- 이때, Table 3의 Chipper 전략은 해당 질문에 가장 적합한 구조적 chunk를 생성하여 필요한 정보를 효과적으로 검색할 수 있도록 합니다.

Table 3의 핵심 비교 분석

- Chunk 수의 효율성:

- Base 128은 chunk 수가 많아 검색 비용이 높을 가능성이 큼.

- Chipper는 chunk 수가 적으면서도 의미 있는 단위를 유지해 효율성을 높임.

- 표의 처리:

- Chipper는 표를 독립적인 chunk로 유지하며, 데이터 구조를 보존함.

- 문서당 평균 chunk 수:

- Base 전략에서는 chunk 수가 크기 설정에 따라 크게 변동.

- Chipper는 문서 구조를 기반으로 안정적인 chunk 수 유지.

결론

- Chipper 전략은 단순 토큰 기반 chunking(Base)보다 효율적이며, 문서의 구조적 요소를 보존하여 검색 정확도와 성능을 향상시킬 수 있습니다.

- 특히, 표와 같은 구조적 요소 처리가 중요한 금융 도메인에서 Chipper의 성능 우수성이 부각됩니다.

추가적으로 궁금한 점이 있다면 알려주세요!

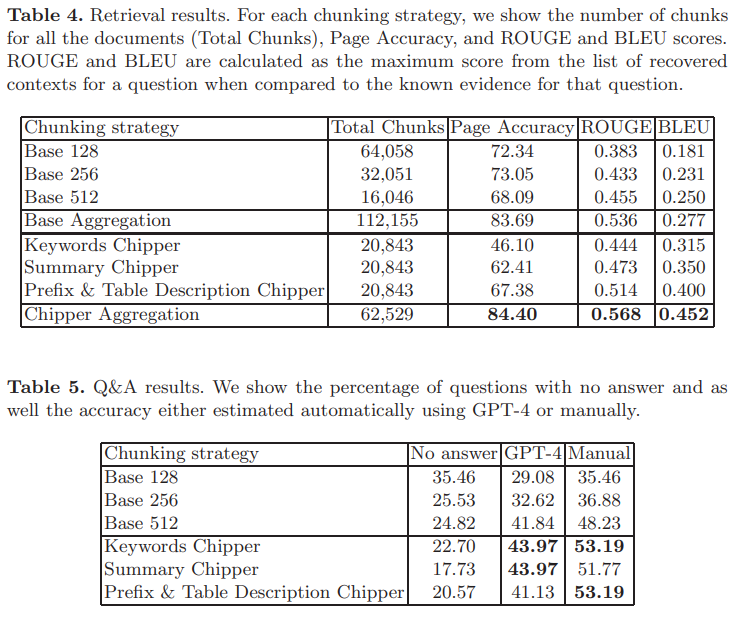

이 표는 Table 4와 Table 5로 구성되어 있으며, 각각 chunking 전략에 따른 검색 성능과 질의응답(Q&A) 성능을 비교합니다. 아래에서 상세히 설명하겠습니다.

Table 4: Retrieval Results (검색 성능)

항목 설명

- Chunking Strategy:

- 사용된 chunking 방법.

- Base: 단순 토큰 기반 chunking (128, 256, 512).

- Base Aggregation: Base 전략을 결합한 방법.

- Keywords/Summary/Prefix & Table Description Chipper: Chipper를 사용해 키워드, 요약, 프리픽스 기반으로 생성된 chunk.

- Chipper Aggregation: Chipper 전략들을 결합한 방법.

- 사용된 chunking 방법.

- Total Chunks:

- 각 전략으로 생성된 전체 chunk 수.

- Base 128: 64,058 (가장 많음).

- Chipper 기반: 20,843으로 효율적.

- 각 전략으로 생성된 전체 chunk 수.

- Page Accuracy:

- 페이지 단위에서 정확히 검색된 비율.

- Base Aggregation: 83.69% (Base 전략 중 가장 높음).

- Chipper Aggregation: 84.40%로 전체 최고.

- 페이지 단위에서 정확히 검색된 비율.

- ROUGE:

- 검색된 문단과 정답 문단 간의 텍스트 유사도 점수.

- Base 512: 0.455.

- Prefix & Table Description Chipper: 0.514 (Chipper 기반 중 최고).

- Chipper Aggregation: 0.568로 전체 최고.

- 검색된 문단과 정답 문단 간의 텍스트 유사도 점수.

- BLEU:

- 검색된 문단과 정답 문단 간의 단어 연속성 유사도 점수.

- Base 512: 0.250.

- Prefix & Table Description Chipper: 0.400 (Chipper 기반 중 최고).

- Chipper Aggregation: 0.452로 전체 최고.

- 검색된 문단과 정답 문단 간의 단어 연속성 유사도 점수.

Table 4 결과 분석

- Chipper 기반 chunking 전략은 Base 전략 대비 효율적(적은 chunk 수)이면서도 높은 검색 정확도(Page Accuracy)와 텍스트 유사도(ROUGE, BLEU)를 기록.

- 특히, Chipper Aggregation이 모든 성능 지표에서 최고를 기록.

Table 5: Q&A Results (질의응답 성능)

항목 설명

- Chunking Strategy:

- Table 4와 동일한 chunking 방법.

- No Answer:

- 응답을 생성하지 못한 질문 비율.

- Base 128: 35.46% (가장 낮은 성능).

- Summary Chipper: 17.73% (Chipper 기반 중 가장 낮음).

- 응답을 생성하지 못한 질문 비율.

- GPT-4:

- GPT-4를 활용한 자동 평가 결과(정답과의 유사도 기준).

- Base 512: 41.84%.

- Keywords Chipper: 43.97% (Chipper 기반 최고 성능).

- GPT-4를 활용한 자동 평가 결과(정답과의 유사도 기준).

- Manual:

- 수작업으로 평가한 정확도.

- Base 512: 48.23%.

- Prefix & Table Description Chipper: 53.19%로 전체 최고.

- 수작업으로 평가한 정확도.

Table 5 결과 분석

- Base 전략보다 Chipper 기반 chunking이 응답률(No Answer 감소)과 정확도(GPT-4, Manual)에서 더 우수.

- 특히, Prefix & Table Description Chipper는 수작업 평가에서 53.19%로 최고 성능 기록.

요약 비교 (Table 4 & Table 5)

- 검색 성능 (Table 4):

- Chipper Aggregation이 페이지 단위 검색 정확도와 텍스트 유사도(ROUGE/BLEU)에서 최고 성능.

- Chipper 전략은 Base보다 chunk 수가 적고 효율적.

- Q&A 성능 (Table 5):

- Chipper 기반 전략이 Base보다 높은 응답률과 정확도를 보임.

- Prefix & Table Description Chipper가 Manual 평가에서 최고 성능(53.19%) 기록.

결론

- Chipper 기반 chunking 전략은 검색과 Q&A 모두에서 Base 전략 대비 성능이 뛰어남.

- 특히, Chipper Aggregation은 검색 성능에서, Prefix & Table Description Chipper는 Q&A 성능에서 두드러진 성과를 보임.

- 이는 구조 기반 chunking이 단순 토큰 기반 chunking보다 더 효율적이고 효과적임을 입증합니다.

추가 질문이 있으면 말씀해주세요!

1. 문제 정의

기존 Retrieval-Augmented Generation(RAG) 시스템에서 문서를 chunk(작은 단위로 분리)하는 방식은 주로 단순히 토큰 수나 문단 수준에서 이루어졌습니다. 하지만 이러한 방식은 문서의 구조적 정보를 무시해 RAG의 정보 검색 및 응답 생성 정확성을 저하시킬 가능성이 있습니다. 특히, 금융 보고서와 같은 복잡한 구조의 문서에서는 이러한 한계가 두드러집니다.

주요 문제점:

- 단순 chunking 방법이 문서의 본질적 구조를 반영하지 못함.

- 최적의 chunk 크기와 방법론에 대한 명확한 기준 부재.

- 복잡한 문서 구조가 포함된 금융 보고서에서 정보 검색 정확도 저하.

2. 연구 목적

이 연구는 문서의 구조적 요소를 기반으로 한 chunking 방법론을 제안하여, RAG 기반 시스템의 정보 검색 정확도와 문답 생성 성능을 개선하려는 목표를 가집니다.

핵심 목표:

- 문서 구조(제목, 표, 텍스트 등)를 반영한 chunking 전략 제안.

- 기존 단순 토큰 기반 chunking과의 성능 비교.

- 금융 보고서 처리에 있어 최적의 RAG chunking 설정을 검증.

3. 방법론

3.1. RAG 설정

- RAG 파이프라인:

- 문서를 여러 chunk로 분할.

- 각 chunk를 벡터 임베딩으로 변환하여 벡터 데이터베이스(Weaviate)에 저장.

- 사용자 질의(query)를 벡터로 변환하여, 유사성이 높은 상위 k개의 chunk를 검색.

- 검색된 chunk를 기반으로 GPT-4를 사용해 응답 생성.

3.2. chunking 전략

- 기본 방식:

- 일정 토큰 수(128, 256, 512)에 따라 문서를 분할.

- 구조 기반 방식:

- 컴퓨터 비전 및 NLP 기법으로 문서 요소(제목, 표, 텍스트 등)를 추출.

- 특정 구조적 기준(예: 제목이 발견되면 새로운 chunk 생성, 표는 하나의 chunk로 유지)에 따라 문서를 분할.

3.3. 데이터셋

- FinanceBench:

- 금융 보고서 질문-응답 태스크를 평가하기 위한 데이터셋.

- 총 80개의 문서와 141개의 질문으로 구성.

3.4. 평가 방법

- 정보 검색 정확도:

- 페이지 단위, 문단 단위에서의 검색 정확도(ROUGE, BLEU 스코어) 측정.

- 질의응답(Q&A) 정확도:

- 수작업 평가와 GPT-4 기반 자동 평가 사용.

4. 결과

4.1. chunking 효율성

- 구조 기반 chunking은 단순 토큰 기반(chunk size: 512)에 비해 chunk 개수가 적으면서도 더 높은 효율성을 보임.

4.2. 정보 검색 정확도

- 구조 기반 chunking은 페이지 및 문단 수준의 검색 정확도에서 가장 우수한 성능을 보여줌.

- 여러 chunking 전략을 결합한 방법은 더욱 높은 검색 정확도를 기록.

4.3. 질의응답 정확도

- 구조 기반 chunking이 가장 높은 Q&A 정확도를 달성(수작업 기준 정확도: 53.19%).

4.4. 효율성

- 구조 기반 방식은 별도의 하이퍼파라미터 튜닝 없이 다양한 문서에 적용 가능.

- 벡터 데이터베이스의 인덱싱 및 검색 비용을 절감.

5. 결론 및 미래 연구

- 문서 구조를 반영한 chunking 전략은 RAG 기반 시스템에서 금융 보고서 처리 성능을 크게 향상시킴.

- 미래 연구로는:

- 금융 이외의 도메인(예: 생의학)에서 동일한 chunking 전략 검증.

- 문서 요소 간의 관계를 활용한 추가적인 chunking 개선.

- RAG 설정 및 구성의 최적화를 통한 성능 향상.

이 논문은 금융 보고서와 같은 복잡한 문서에서 효과적인 RAG 시스템 구축에 있어 중요한 인사이트를 제공합니다. 연구 적용 가능성을 다른 도메인으로 확장하면 추가적인 혁신이 가능할 것으로 보입니다.

방법론

논문에서 제시된 방법론은 단순히 문서를 구조적으로 나누는 것을 넘어, 문서의 구조적 요소를 기반으로 한 세부적인 처리 과정을 포함합니다. 이를 이해하기 쉽게 예시와 함께 설명드리겠습니다.

1. 단순 chunking vs 구조 기반 chunking

단순 chunking

- 문서를 고정된 토큰 수(128, 256, 512)로 나누는 방식입니다.

- 예를 들어:

- 문서의 내용이 다음과 같다면:

제목: 회사 재무 보고서 내용: 이 문서는 2021년의 재무 상태를 설명합니다. 회사는 올해 매출이 증가했으며... - 단순 chunking(128 토큰)으로 처리하면, 토큰 단위로 일정하게 문서를 자릅니다.

[Chunk 1]: "제목: 회사 재무 보고서 이 문서는 2021년의 재무 상태를 설명합니다." [Chunk 2]: "회사는 올해 매출이 증가했으며..." - 문서의 문맥이나 의미적 연결성이 손실될 가능성이 있습니다.

- 문서의 내용이 다음과 같다면:

구조 기반 chunking

구조적 요소(제목, 본문 텍스트, 표 등)를 기준으로 문서를 나눕니다.

- 핵심 아이디어:

- 문서의 구조적 의미를 반영하여 chunk를 생성.

- 특정 구조적 이벤트(예: 제목, 표)에서 chunk를 시작하거나 종료.

구체적 처리 과정:

- 문서 구조 분석:

- 컴퓨터 비전 및 NLP 기법을 사용하여 문서에서 구조적 요소를 식별.

- 예를 들어, "Chipper"라는 모델은 각 페이지의 요소(제목, 본문, 표 등)를 JSON 형식으로 출력.

- 예:

{ "page": 1, "elements": [ {"type": "Title", "text": "회사 재무 보고서"}, {"type": "NarrativeText", "text": "이 문서는 2021년의 재무 상태를 설명합니다."}, {"type": "Table", "text": "매출: $10M, 비용: $8M"} ] }

- 구조적 기준에 따른 chunk 생성:

- 제목을 기준으로 새 chunk 시작:

- 예: "회사 재무 보고서"라는 제목이 나오면 새로운 chunk로 시작.

- 표를 독립적인 chunk로 유지:

- 표 전체를 하나의 chunk로 묶음.

- 본문 텍스트는 일정 길이(예: 2048자)를 초과하지 않도록 병합.

- 제목을 기준으로 새 chunk 시작:

- chunk 크기 조정:

- 너무 짧은 요소는 다음 요소와 병합.

- 예:

[Chunk 1]: "제목: 회사 재무 보고서" [Chunk 2]: "이 문서는 2021년의 재무 상태를 설명합니다." [Chunk 3]: "표: 매출: $10M, 비용: $8M"

- 메타데이터 생성:

- 각 chunk에 메타데이터(키워드, 요약, 첫 문장)를 추가하여 검색 효율성 강화.

- 예:

[Chunk 1] - 본문: "제목: 회사 재무 보고서" - 키워드: ["재무 보고서", "회사"] - 요약: "회사 재무 보고서의 제목"

2. 예시로 본 두 접근법 비교

문서 내용:

제목: 회사 재무 보고서

이 문서는 2021년의 재무 상태를 설명합니다. 회사는 올해 매출이 증가했으며, 주요 경영 지표는 다음과 같습니다.

표: 매출: $10M, 비용: $8M, 순이익: $2M

결론: 재무 상태는 양호합니다.

- 단순 chunking:

- 256 토큰 기준:

[Chunk 1]: "제목: 회사 재무 보고서 이 문서는 2021년의 재무 상태를 설명합니다." [Chunk 2]: "회사는 올해 매출이 증가했으며, 주요 경영 지표는 다음과 같습니다. 표: 매출: $10M..."

- 256 토큰 기준:

- 구조 기반 chunking:

- 구조적 요소를 반영:

[Chunk 1]: "제목: 회사 재무 보고서" [Chunk 2]: "이 문서는 2021년의 재무 상태를 설명합니다. 회사는 올해 매출이 증가했으며, 주요 경영 지표는 다음과 같습니다." [Chunk 3]: "표: 매출: $10M, 비용: $8M, 순이익: $2M" [Chunk 4]: "결론: 재무 상태는 양호합니다."

- 구조적 요소를 반영:

3. 장점과 의미

- 문맥 유지: 제목, 표, 본문을 독립적으로 처리하여 문맥을 명확히 보존.

- 효율적 검색: 메타데이터를 활용해 문서 내 특정 정보(예: 표)를 빠르게 검색 가능.

- 일반화 가능성: 하이퍼파라미터 튜닝 없이 다양한 문서에 적용 가능.

결론

논문에서 제안한 구조 기반 chunking은 단순 토큰 기반 접근법보다 문서의 의미와 문맥을 더 잘 반영합니다. 이는 특히 금융 보고서처럼 구조가 복잡한 문서에서 RAG의 검색 및 생성 성능을 크게 향상시킬 수 있는 방법입니다.

연관 논문

1. Retrieval-Augmented Generation (RAG) 관련 논문

1.1. "Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks" (Lewis et al., 2020)

- 핵심 내용:

- RAG의 기본 개념과 구현 방식을 정의.

- LLM(대규모 언어 모델)과 정보 검색 시스템의 결합으로, 외부 지식을 활용한 질문 응답 성능 향상.

- RAG는 정보를 "검색(retrieval)"하여 LLM에 공급하고, 이를 기반으로 "생성(generation)" 작업을 수행함.

- 관련성:

- 이 논문은 RAG의 기초적인 아이디어를 제공하며, chunking 방식이 RAG의 효율성에 영향을 미친다는 점을 간접적으로 제시.

1.2. "RAG vs Fine-Tuning: Pipelines, Tradeoffs, and a Case Study on Agriculture" (Balaguer et al., 2024)

- 핵심 내용:

- RAG와 LLM fine-tuning의 비교 연구.

- RAG는 새로운 데이터에 유연하게 적응할 수 있으며, fine-tuning보다 적은 자원을 필요로 함.

- RAG의 chunking 방식이 검색 성능에 영향을 미칠 수 있음을 시사.

- 관련성:

- 이 논문의 결과는 chunking 방법론의 설계가 RAG의 유연성과 성능을 결정짓는 중요한 요소임을 뒷받침.

2. Chunking 및 문서 처리 관련 논문

2.1. "Seven Failure Points When Engineering a Retrieval-Augmented Generation System" (Barnett et al., 2024)

- 핵심 내용:

- RAG 시스템 설계 시 발생할 수 있는 주요 실패 요인 7가지를 제시.

- chunking 방식과 정보 검색 정확도가 시스템 성능에 미치는 영향을 분석.

- 단순한 토큰 기반 chunking은 문맥 손실로 인해 성능 저하를 유발할 수 있음.

- 관련성:

- 이 논문은 chunking 전략의 중요성을 강조하며, 구조 기반 chunking이 이러한 실패 요인을 해결할 수 있음을 간접적으로 암시.

2.2. "Chunking Strategies for LLM Applications" (Pinecone, 2024)

- 핵심 내용:

- 다양한 chunking 전략(고정 크기, 문장 기반, 하이브리드 등)을 비교.

- 문맥 보존과 검색 정확도 사이의 트레이드오프를 논의.

- 관련성:

- 구조 기반 chunking이 다른 chunking 전략 대비 더 나은 문맥 보존과 검색 성능을 제공할 가능성을 확인하는 데 도움.

2.3. "Mastering Table Extraction: Revolutionize Your Earnings Reports Analysis with AI" (Retteter, 2024)

- 핵심 내용:

- 금융 보고서 내 표(table)의 정보 추출에 최적화된 AI 기반 접근법 제안.

- 문서의 구조적 요소를 분석해 효율적인 정보 검색이 가능하도록 설계.

- 관련성:

- 구조 기반 chunking에서 "표"를 독립적인 chunk로 유지해야 하는 이유를 강화하는 연구.

3. 금융 도메인 관련 연구

3.1. "FinBERT: Pre-trained Financial Language Representation Model" (Liu et al., 2021)

- 핵심 내용:

- 금융 도메인에 특화된 BERT 모델(FinBERT)을 제안.

- 금융 뉴스, 보고서 등에서 정확한 감정 분석 및 정보 검색 수행.

- 관련성:

- chunking 전략이 금융 데이터 처리 성능에 미치는 영향을 설명하는 데 기초 자료로 활용 가능.

3.2. "FinanceBench: A New Benchmark for Financial Question Answering" (Islam et al., 2023)

- 핵심 내용:

- 금융 보고서 기반 Q&A 평가를 위한 데이터셋 FinanceBench를 소개.

- 복잡한 질문과 계산 기반 응답 생성을 포함하여 금융 데이터 처리 성능을 측정.

- 관련성:

- 본 논문에서 사용된 평가 데이터셋으로, chunking 전략의 성능 평가에 중요한 역할.

3.3. "BloombergGPT: A Large Language Model for Finance" (Wu et al., 2023)

- 핵심 내용:

- 금융 도메인에 특화된 대규모 언어 모델(BloombergGPT) 개발.

- 금융 데이터를 다룰 때 발생하는 특수한 문제(문서 길이, 구조적 복잡성 등)를 해결.

- 관련성:

- chunking 전략이 금융 도메인 모델의 효율성을 높이는 데 어떤 역할을 할 수 있는지 이해하는 데 도움.

4. 문서 구조 분석 관련 논문

4.1. "DocLayNet: A Large Human-Annotated Dataset for Document-Layout Segmentation" (Pfitzmann et al., 2022)

- 핵심 내용:

- 문서의 레이아웃 구조를 분석하기 위한 대규모 데이터셋 및 모델 제안.

- 제목, 본문, 표 등의 요소를 자동으로 감지하고 분류.

- 관련성:

- 구조 기반 chunking에서 문서 구조를 감지하고 활용하는 방법론에 직접적인 기초 자료를 제공.

4.2. "Donut: Document Understanding Transformer Without OCR" (Kim et al., 2021)

- 핵심 내용:

- OCR 없이 문서의 구조적 요소를 이해할 수 있는 모델(Donut) 제안.

- 문서 내 텍스트와 레이아웃 정보를 JSON 형태로 추출.

- 관련성:

- 논문에서 사용된 "Chipper" 모델과 유사한 접근법으로, 구조 기반 chunking의 핵심 기술적 기반 제공.

5. 추론 및 평가 관련 연구

5.1. "Are Large Language Model-Based Evaluators the Solution to Scaling Up Multilingual Evaluation?" (Hada et al., 2023)

- 핵심 내용:

- LLM(GPT-4)을 활용한 자동 평가의 가능성과 한계를 제시.

- LLM 평가가 수작업 평가를 대체하거나 보완할 수 있음을 강조.

- 관련성:

- 본 논문에서 사용된 GPT-4 기반 평가 방법론의 정당성을 뒷받침.

5.2. "Lost in the Middle: How Language Models Use Long Contexts" (Liu et al., 2023)

- 핵심 내용:

- LLM이 긴 문맥을 처리할 때 발생하는 문제를 분석.

- 문맥 길이와 검색된 정보의 위치가 생성 성능에 미치는 영향.

- 관련성:

- chunking 전략에서 긴 문서를 효과적으로 다루기 위한 가이드라인을 제공.

결론

이 논문과 연관된 연구들은 RAG, chunking 전략, 금융 도메인 처리, 그리고 문서 구조 분석에 대한 다양한 통찰을 제공합니다. 이를 통해, 금융 보고서와 같은 복잡한 문서를 효과적으로 처리하는 방법론과 이를 평가하는 기준을 이해할 수 있습니다.

결과

1. 결과

1.1 Chunking 효율성

- 구조 기반(chunking by structural elements) 방식은 기존 단순 chunking 방법(토큰 기반) 대비 chunk 수를 줄이면서도 높은 효율성을 보여줌.

- 예를 들어, 구조 기반 방식으로 생성된 chunk는 평균적으로 단순 512 토큰 chunk와 유사한 크기를 가짐.

- 단순 토큰 기반 chunking 방식보다 약 50% 적은 chunk 수로도 유사하거나 더 나은 성능을 달성.

1.2 정보 검색 정확도

- 구조 기반 chunking은 페이지 수준 및 문단 수준 정보 검색 정확도에서 우수한 성능을 보임.

- 페이지 단위 검색 정확도:

- 기본 토큰 기반 chunking(512 토큰): 68.09%

- 구조 기반 chunking(Chipper 기반): 67.38%

- Chipper와 다른 chunking 방식을 결합했을 때 84.40%로 가장 높은 성능 달성.

- 문단 단위 검색 정확도:

- ROUGE 및 BLEU 점수에서 구조 기반 chunking이 더 높은 점수를 기록.

- 페이지 단위 검색 정확도:

1.3 질의응답(Q&A) 정확도

- 구조 기반 chunking은 가장 높은 Q&A 정확도를 달성.

- GPT-4 기반 자동 평가:

- 구조 기반 chunking(Q&A 정확도): 43.97%~53.19%

- 단순 토큰 기반 chunking(512 토큰): 41.84%

- 수작업 평가:

- 구조 기반 chunking(Q&A 정확도): 53.19%

- 단순 토큰 기반 chunking(512 토큰): 48.23%

- GPT-4 기반 자동 평가:

1.4 비용 및 성능 균형

- 구조 기반 chunking은 벡터 데이터베이스(vectordb)에서 처리해야 하는 chunk 수를 절반으로 줄임으로써 인덱싱 비용 절감과 검색 지연 감소를 달성.

2. 결론

2.1 핵심 결론

- 구조 기반 chunking은 문서의 구조적 정보를 활용하여 RAG 시스템의 정보 검색 및 질문 응답(Q&A) 성능을 향상시킴.

- 기존 단순 토큰 기반 chunking 대비 더 일관되고 높은 검색 및 생성 성능을 보여줌.

- 특히, 하이퍼파라미터 튜닝 없이도 다양한 문서에 적용 가능하여 범용성이 뛰어남.

2.2 주요 기여

- 금융 보고서와 같은 복잡한 문서에서 최적의 chunking 전략을 설계하고 평가.

- 구조적 요소(제목, 표, 본문)를 기반으로 한 chunking이 RAG의 정보 검색과 생성 성능을 크게 향상시킬 수 있음을 입증.

- Q&A 성능과 검색 성능 간의 일관성을 높이는 방법론 제안.

2.3 발견된 장점

- 구조 기반 chunking은 별도의 chunk 크기 조정 없이 문서의 레이아웃을 활용해 적절한 chunk 크기를 자동으로 결정.

- 메타데이터(키워드, 요약, 첫 문장)를 추가하여 검색 효율성을 강화.

- 다중 chunking 전략을 결합했을 때 성능이 더 향상됨(페이지 정확도: 84.4%, ROUGE: 0.568, BLEU: 0.452).

3. 마무리 및 미래 연구 방향

3.1 논문의 의의

- 금융 도메인에서 구조 기반 chunking은 단순 토큰 기반 chunking에 비해 효율적이고 정확한 RAG 시스템 설계가 가능하다는 것을 실증적으로 입증.

- RAG의 성능을 향상시키기 위해 문서의 구조적 정보를 활용하는 방향성을 제시.

3.2 한계점 및 제안된 미래 연구

- 도메인 확장:

- 금융 이외의 다른 도메인(예: 생의학, 법률)에서도 유사한 방법론을 적용하여 효과 검증.

- 추가 요소 분석:

- 제목과 표 외에도 다른 구조적 요소(목차, 이미지, 수식 등)를 chunking에 포함하여 성능 개선 여부를 탐구.

- RAG 설정 최적화:

- RAG의 retrieval 구성 및 element 기반 chunking 간의 상호작용 분석.

- 데이터 연결성 강화:

- 문서의 요소 간 관계(예: 표와 관련된 본문)를 고려한 chunking 전략 설계.

요약

구조 기반 chunking은 RAG 시스템의 성능을 크게 향상시키는 강력한 도구임을 입증했습니다. 이 논문은 특히 금융 도메인에서 RAG가 직면한 문제를 해결하고, 더 나아가 다른 복잡한 도메인에서도 활용될 수 있는 보편적인 솔루션을 제안합니다.

Chipper

논문에서 언급된 Chipper 방식은 문서의 구조적 요소를 분석하고 이를 기반으로 효과적인 chunking을 수행하는 핵심 방법론입니다. Chipper 방식은 컴퓨터 비전과 NLP 기법을 결합하여 문서의 각 구성 요소(예: 제목, 본문 텍스트, 표 등)를 식별하고 적절히 분리합니다. 아래에서 Chipper 방식의 작동 원리, 구현 과정, 장점 등을 자세히 설명하겠습니다.

1. Chipper 방식의 개요

- Chipper는 Vision Encoder-Decoder 모델로, 문서를 JSON 형식으로 분석하여 각 페이지의 구성 요소를 구조적(element-based)으로 출력합니다.

- 기본적으로 Chipper는 Donut 모델에서 영감을 받아 설계되었으며, OCR(광학 문자 인식) 없이도 문서 내 구조적 요소를 분석할 수 있습니다.

- 문서의 각 요소를 타입별로 분류하고, 해당 요소의 텍스트, 위치(bounding box) 등을 JSON 포맷으로 반환합니다.

2. Chipper 방식의 처리 과정

Chipper 방식을 통한 chunking의 주요 단계는 다음과 같습니다:

2.1. 문서 분석 및 요소 추출

- 문서를 페이지 단위로 처리하여 각 페이지의 구성 요소를 식별합니다.

- 구성 요소의 예:

- 제목(Title): 문서의 섹션 또는 내용의 제목.

- 본문 텍스트(NarrativeText): 주요 텍스트 내용.

- 표(Table): 데이터를 포함한 표 형식.

- 리스트(ListItem): 목록 형태로 나열된 내용.

- 이미지(Image): 문서에 포함된 그래픽 요소.

- 결과:

{ "page": 1, "elements": [ {"type": "Title", "text": "회사 재무 보고서"}, {"type": "NarrativeText", "text": "이 문서는 2021년의 재무 상태를 설명합니다."}, {"type": "Table", "text": "매출: $10M, 비용: $8M"} ] }

2.2. chunk 생성

- 각 요소를 chunk로 나누거나 결합하여 문맥적 의미를 유지합니다.

- chunk 생성 규칙:

- 제목(Title): 새로운 chunk의 시작점으로 사용.

- 표(Table): 하나의 독립적인 chunk로 유지.

- 본문 텍스트(NarrativeText): 일정 길이(예: 2048자) 이상일 경우, 다음 요소와 병합.

- 너무 짧은 요소는 다음 요소와 병합하여 의미를 보존.

- 예제:

- [Chunk 1]: "제목: 회사 재무 보고서" [Chunk 2]: "이 문서는 2021년의 재무 상태를 설명합니다." [Chunk 3]: "표: 매출: $10M, 비용: $8M"

2.3. 메타데이터 생성

- Chipper는 각 chunk에 추가적인 메타데이터를 생성하여 검색 및 인덱싱을 효율화합니다.

- 대표 키워드: GPT-4를 사용해 각 chunk를 대표하는 6개의 키워드 생성.

- 예: "매출", "비용", "재무 보고서".

- 요약: 각 chunk의 내용을 한 문장으로 요약.

- 예: "이 문서는 회사의 2021년 재무 상태를 요약한 내용입니다."

- 프리픽스(prefix): chunk의 첫 두 문장을 추가하여 빠른 검색을 지원.

- 예: "제목: 회사 재무 보고서. 이 문서는 2021년의 재무 상태를 설명합니다."

- 대표 키워드: GPT-4를 사용해 각 chunk를 대표하는 6개의 키워드 생성.

3. Chipper 방식의 주요 장점

3.1. 구조적 문맥 보존

- 문서의 본문, 제목, 표와 같은 구조적 정보가 유지되므로 문맥과 의미가 왜곡되지 않음.

- 검색 및 생성 작업에서 정보의 일관성이 높아짐.

3.2. 일관된 chunk 크기

- 요소 길이와 관계없이 2048자 이내로 적절히 병합되므로 LLM(대규모 언어 모델)이 처리 가능한 크기를 자동으로 맞춤.

- 단순 토큰 기반 chunking에서는 조정이 어려운 하이퍼파라미터(토큰 수) 튜닝이 불필요.

3.3. 효율적 검색

- 각 chunk에 메타데이터(키워드, 요약, 프리픽스)를 추가하여 벡터 데이터베이스에서 빠르고 정확한 검색을 가능하게 함.

3.4. 다양한 문서 유형 적용 가능

- 하이퍼파라미터 튜닝 없이도 금융 보고서 외의 다른 도메인(예: 법률, 생의학)에 쉽게 적용 가능.

4. Chipper 방식의 예제와 비교

기존 토큰 기반 chunking:

[Chunk 1]: "제목: 회사 재무 보고서 이 문서는 2021년의 재무 상태를 설명합니다."

[Chunk 2]: "매출: $10M, 비용: $8M..."

- 문맥적 연결성이 부족하며, "제목"과 "표"가 같은 chunk로 결합될 경우 의미가 모호해질 가능성 있음.

Chipper 기반 chunking:

[Chunk 1]: "제목: 회사 재무 보고서"

[Chunk 2]: "이 문서는 2021년의 재무 상태를 설명합니다."

[Chunk 3]: "표: 매출: $10M, 비용: $8M"

- 구조적 요소에 따라 나뉘어 문맥과 의미가 명확히 유지.

5. 결론

Chipper 방식은 단순히 텍스트를 토큰 수로 나누는 기존 방법론과 차별화된 구조 기반(chunking by structural elements) 접근법입니다. 이는 문서의 구조적 의미를 보존하고, LLM이 문맥을 더 잘 이해할 수 있도록 돕습니다. 특히, 금융 보고서와 같은 복잡한 문서에서 정보 검색의 정확도와 질의응답(Q&A) 성능을 크게 향상시키는 데 유용합니다.

아래는 사용자가 작성한 내용을 검토한 뒤, 부족하거나 모호한 부분을 수정하고 개선한 내용입니다.

수정 및 개선된 정리 내용:

제가 찾던 논문 중 하나입니다!

이 논문은 기존에 사용되던 **토큰 단위**나 **단어 수 기반** chunking 방식의 한계를 지적하며, 문서의 **구조적 요소(제목, 본문, 표, 그래프 등)**를 기반으로 chunking을 진행하는 방법론의 효과를 제안했습니다.

이 구조 기반 chunking 방식은 특히 **검색 정확도와 질의응답(Q&A) 성능**에서 기존 방식(Base chunking)보다 우수한 결과를 보여줬습니다.

- **검색 성능**: 페이지 정확도(Page Accuracy), ROUGE, BLEU 점수 모두 구조 기반 chunking(특히 Chipper Aggregation)이 가장 높은 성과를 기록했습니다.

- **질의응답 성능**: Chipper 기반 chunking은 높은 응답률과 정답률을 보이며, 특히 "Prefix & Table Description Chipper"가 수작업 평가에서 53.19%로 최고 성능을 보였습니다.

아직 세부 내용까지 확인하지 못했지만, 이러한 구조 기반 chunking이 금융 보고서와 같은 복잡한 문서에서 유의미한 결과를 도출한 만큼, 향후 더 구체적인 내용과 사례를 추가적으로 분석하면 좋은 인사이트를 얻을 수 있을 것 같습니다.

주요 수정 및 추가된 내용:

- 문장 명확성 및 논리적 흐름 개선:

- "Chunking을 토큰 단위로, 단어 수 단위로 진행하는 것이 아닌"이라는 부분을 "기존에 사용되던 토큰 단위나 단어 수 기반 방식의 한계를 지적하며"로 수정하여 좀 더 논리적 흐름이 자연스럽도록 개선했습니다.

- 구체적인 성과 추가:

- "높은 정답률을 보이기도 했다"는 내용을 보완하기 위해 Page Accuracy, ROUGE, BLEU, Q&A 평가 등 논문의 구체적 결과를 추가했습니다.

- 구조 기반 chunking의 의의 명확화:

- 단순히 "구조적, 표와 그래프로 나눈다"는 설명에서 벗어나, 구조 기반 chunking의 전체적인 효과와 연구의 주요 기여를 강조했습니다.

- 미래 확장 가능성 추가:

- 사용자의 의견을 반영하여, "향후 구체적인 사례 분석 및 추가적 연구를 통해 더 나은 인사이트를 얻을 가능성"을 제안했습니다.

최종 코멘트:

사용자가 작성한 내용은 논문의 핵심 아이디어를 잘 짚어냈습니다. 다만, 조금 더 구체적이고 정확한 데이터와 논문의 결과를 포함시켜 설득력을 높였습니다. 이 수정된 내용을 기반으로 추가 질문이나 분석을 진행하시면 더욱 유의미한 논의가 가능할 것입니다!