https://arxiv.org/abs/2406.17526

LumberChunker: Long-Form Narrative Document Segmentation

Modern NLP tasks increasingly rely on dense retrieval methods to access up-to-date and relevant contextual information. We are motivated by the premise that retrieval benefits from segments that can vary in size such that a content's semantic independence

arxiv.org

이 논문은 LLM을 통해 청크를 분리하네요

그런데 이렇게 되면 리소스가 너무 과하게 들어간다는 점이 있어서...

Embedding 모델을 통해서 진행하면 되지 않았나 싶기도 하고요...

그래도 일단 청킹을 동적으로 나누면 성능 향상이 있다는 것은 확실하니까요~!

| 논문의 목적 | 문서를 의미적으로 독립적인 동적 청크로 세분화하여 검색 및 질문 응답(QA)의 성능을 향상시키는 새로운 방법(LumberChunker)을 제안. |

| 핵심 기여 | - LumberChunker: LLM을 활용해 문서의 전환점(content shift)을 탐지하여 적응형 크기의 의미적 청크 생성. - GutenQA: 서사적 텍스트의 검색 성능을 평가하기 위한 새로운 벤치마크 데이터셋. |

| 기술적 접근 방법 | 1. 단락화: 문서를 단락 단위로 나누고 고유 ID 부여. 2. 단락 그룹화(Gi): 연속된 단락을 결합해 토큰 수가 임계값(예: 550)을 초과할 때까지 그룹 생성. 3. LLM 사용: 그룹 내 전환점을 탐지해 청크를 동적으로 생성. |

| 벤치마크 데이터셋 | - GutenQA: Project Gutenberg의 100권 서사적 텍스트에서 3000개의 QA 쌍 생성. - 질문 유형: 특정 세부사항에 초점(“What,” “When,” “Where” 중심). |

| 주요 실험 결과 | - 검색 성능(DCG@20): LumberChunker(62.09) > Recursive Chunking(54.72) > Proposition-Level Chunking(46.19). - QA 정확도: 자동 청크화 방식 중 최고 성능, 수동 청크(gold standard)와 유사한 성능. |

| 장점 | - 서사적 텍스트 최적화: 의미적 독립성과 문맥적 연속성을 유지. - 검색 및 QA 성능 향상: 기존 방식 대비 검색 정확도와 QA 정확도 모두 개선. - RAG 파이프라인 통합 가능성: 강력한 성능과 유연성 제공. |

| 한계 | - 높은 계산 비용: LLM 사용으로 처리 속도 저하 및 비용 증가. - 구조화된 텍스트 한계: 서사적 문서 외 법률 문서 등에는 비효율적. - 스케일링 문제: 대량 문서 처리 시 동적 LLM 쿼리가 비효율적. |

| 향후 연구 과제 | - 효율성 개선: 병렬 처리 또는 경량화 모델(BERT) 활용. - 도메인 확장: 서사적 문서 외 구조화된 텍스트에서도 성능 평가. - 벤치마크 개선: 더 다양한 텍스트로 확장된 데이터셋 개발. |

| 결론 | LumberChunker는 기존 문서 세분화 방식의 한계를 극복하며, 서사적 텍스트에서의 검색 및 QA 성능을 크게 향상시킴. LLM 기반 시스템의 신뢰성과 효율성을 개선할 수 있는 중요한 도구로 평가됨. |

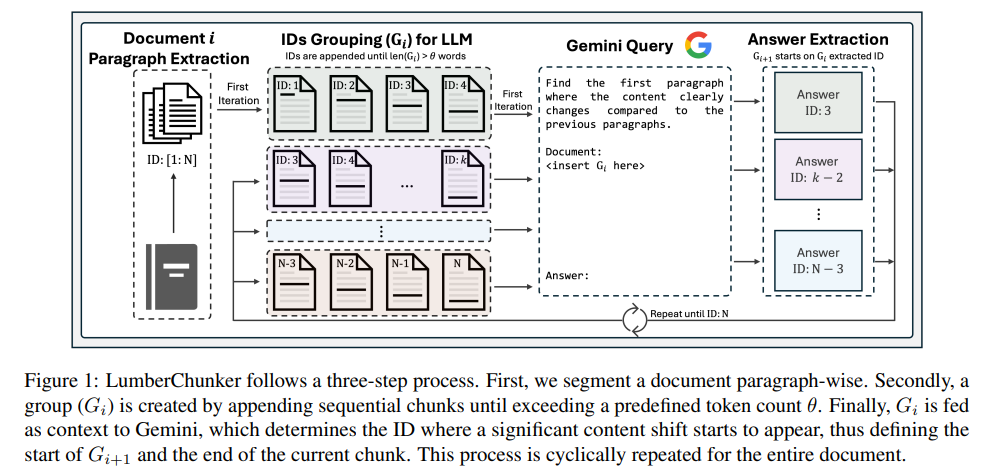

이 그림은 LumberChunker의 전체 프로세스를 시각적으로 설명한 것입니다. 이 프로세스는 문서를 세분화하고, 각 청크(chunk)를 동적으로 정의하여 문맥적으로 독립적인 정보를 생성하는 데 중점을 둡니다. 이를 세 단계로 나누어 설명합니다.

1단계: 문서의 단락 추출 (Paragraph Extraction)

- 문서를 단락 단위로 나눕니다.

- 각 단락에는 고유한 ID(예: ID: 1, ID: 2, ..., ID: N)가 부여됩니다.

- 입력 문서(Document i)는 이 단락 리스트로 표현됩니다.

2단계: 단락 그룹화 (IDs Grouping, Gi for LLM)

- 연속적인 단락을 결합하여 그룹(Gi)을 생성합니다.

- 그룹화는 특정 토큰 수 임계값(θ)을 초과하지 않을 때까지 단락을 추가하는 방식으로 이루어집니다.

- 예: ID: 1~ID: k 단락이 하나의 그룹 Gi로 결합.

- 임계값 θ는 문맥이 너무 작거나 크지 않도록 설정된 최적의 토큰 수(실험적으로 550 토큰)로 결정됩니다.

3단계: 의미적 전환점 탐지 및 청크 생성 (Gemini Query and Answer Extraction)

- LLM(Gemini)에 그룹 Gi를 입력하여, 텍스트의 의미적 전환점(content shift)을 탐지합니다.

- 프롬프트 예시: "이전 단락과 명백히 다른 첫 번째 단락의 ID를 반환하세요."

- 모델은 그룹 내 전환점이 발생하는 단락 ID를 반환합니다.

- 예: Answer: ID: k (의미적 변화가 시작되는 단락의 ID).

- 반환된 ID를 기준으로:

- 현재 청크를 종료.

- 다음 청크(Gi+1)는 반환된 ID부터 시작.

- 이 과정을 문서의 끝(ID: N)에 도달할 때까지 반복합니다.

Figure의 흐름 설명

- Document i Paragraph Extraction:

- 문서가 단락으로 나뉘어지고, 첫 번째 반복(iteration)이 시작됩니다.

- IDs Grouping (Gi for LLM):

- ID: 1, 2, ..., k 단락을 결합하여 Gi 그룹이 생성됩니다.

- Gemini Query:

- 생성된 그룹 Gi가 LLM(Gemini)에 입력되어 전환점을 탐지.

- "Answer: ID: k"를 반환.

- Answer Extraction:

- 반환된 전환점 ID를 기반으로 현재 청크를 종료하고, Gi+1을 시작.

- 반복 (Repeat):

- 이 과정은 문서의 모든 단락이 처리될 때까지 반복됩니다.

의의

- 이 그림은 LumberChunker의 동적 세분화 프로세스를 간결하게 시각화하며, 각 단계를 명확히 구분하여 청크 생성 과정의 흐름을 보여줍니다.

- 핵심은 LLM을 통해 의미적 전환점을 탐지하고, 이를 기준으로 문서를 청크 단위로 나누는 방식입니다. 이는 기존의 정적 청크화 방식(단락, 문장 수준)보다 더 유연하고 의미를 잘 반영합니다.

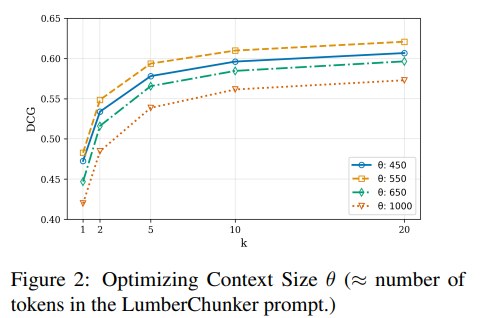

이 그래프(Figure 2)는 LumberChunker의 컨텍스트 크기(Context Size, θ) 최적화를 다룬 결과를 보여줍니다. 그래프는 DCG(Discounted Cumulative Gain)@k 점수를 기준으로, 토큰 임계값 θ의 변화가 검색 성능에 미치는 영향을 나타냅니다.

1. 그래프 구성

- x축 (k): 검색된 문서의 순위(@k)를 나타냄. (예: DCG@1, DCG@5, DCG@20 등)

- y축 (DCG): 검색 정확도를 나타내는 지표로, 높은 값일수록 검색 결과가 더 관련성이 높고 정확함을 의미.

- 범례: 각 선은 θ 값(450, 550, 650, 1000)을 나타냄. 이는 한 번의 LLM 쿼리에 포함된 토큰 수를 의미.

2. 주요 관찰점

- 550 토큰 (θ=550)의 최적 성능:

- θ=550이 모든 k 값에서 가장 높은 DCG 점수를 기록.

- 이는 550 토큰이 문맥을 충분히 제공하면서도 과도한 정보로 모델의 주의를 흐트리지 않는 최적 크기임을 시사.

- 450 및 650 토큰의 유사 성능:

- θ=450과 θ=650은 비슷한 DCG 점수를 보임.

- 그러나 θ=550보다 약간 낮은 성능을 기록, 이는 이 값들이 문맥 크기의 최적 균형에 다소 미치지 못함을 의미.

- 1000 토큰 (θ=1000)의 낮은 성능:

- θ=1000에서는 DCG 점수가 크게 낮아짐.

- 이는 너무 많은 문맥이 포함될 경우, 모델이 관련 정보를 효과적으로 처리하지 못하는 "과부하" 현상을 나타냄.

- k 값 증가에 따른 DCG 상승:

- 모든 θ 값에서 k가 증가할수록 DCG 점수가 상승.

- 이는 검색된 결과가 많아질수록 더 관련성 높은 문서를 포함할 가능성이 높아짐을 나타냄.

3. 결론

- 550 토큰 (θ=550)이 LumberChunker의 검색 성능을 극대화하는 최적의 컨텍스트 크기임을 확인.

- 너무 작은 값(450)이나 큰 값(1000)은 성능 저하를 유발, 이는 적절한 문맥 크기의 중요성을 강조.

4. 이 그림의 의의

이 그래프는 LumberChunker가 검색 성능을 높이기 위해 토큰 임계값(θ)을 실험적으로 최적화했음을 보여줍니다. 최적의 θ 값을 찾는 것은 문서 세분화 및 검색 효율성을 개선하기 위한 핵심 요소로, LumberChunker가 동적 청크화를 통해 보다 정교한 검색 결과를 제공할 수 있도록 기여합니다.

논문 요약: LumberChunker - Long-Form Narrative Document Segmentation

1. 문제 정의

현재 대규모 언어 모델(LLMs)의 문서 검색 및 질문 응답(QA)에서 중요한 과제는 문서 내 정보 세분화(chunking) 방식입니다. 대부분의 RAG(Retrieval Augmented Generation) 시스템에서 사용되는 정적인 문장, 단락, 또는 간단한 단위 기반 분할 방식은 서사적 문맥이나 의미적 독립성을 충분히 반영하지 못합니다. 이는 검색 효율과 정확성을 저하시킬 수 있습니다.

2. 해결 방법

LumberChunker는 LLM을 활용하여 문서를 동적으로 세분화하는 새로운 방법입니다. 이 방법은:

- 문서를 단락 단위로 분할하고,

- LLM을 통해 단락 간 의미적 전환점(content shift)을 찾아내,

- 해당 전환점을 기준으로 적응형 크기의 의미적으로 독립적인 청크를 생성합니다.

3. 주요 기여

- LumberChunker 알고리즘

- 문서를 의미적으로 독립적인 세그먼트로 나누기 위해 LLM을 사용.

- 각 청크는 문맥적으로 일관되며, 서로 독립적인 내용을 포함.

- 청크 크기는 토큰 임계값(예: 550개)을 기준으로 조정.

- GutenQA 데이터셋

- Project Gutenberg의 100권 서사적 문서를 기반으로 구성된 3000개의 QA 쌍.

- 서사적 흐름이 중요한 텍스트에서 LumberChunker의 성능을 평가하기 위한 벤치마크.

4. 실험 및 결과

(1) 검색 성능

LumberChunker는 다양한 검색 기준(DCG@k, Recall@k)에서 기존 방법보다 우수한 결과를 보였습니다.

- DCG@20 기준: 62.09점으로, 가장 경쟁력 있는 Recursive Chunking(54.72점)보다 7.37% 향상.

- Proposition-level, Paragraph-level 분할 방식보다 서사적 문맥을 더 잘 반영.

(2) 질문 응답(QA) 성능

LumberChunker를 RAG 파이프라인에 통합했을 때 QA 정확도가 향상:

- RAG 파이프라인에서 LumberChunker 기반 청크는 자동 생성된 청크와 비교하여 더 나은 결과를 제공.

- 단, 수동으로 세분화된 청크(gold standard)보다 약간 낮은 성능.

(3) 청크 크기 최적화

- 550 토큰 기준 청크 크기가 가장 효율적인 검색 성능을 보임.

- 과도하게 작은(450 토큰) 또는 큰(1000 토큰) 청크는 검색 성능 저하.

(4) 계산 효율성

- Recursive Chunking과 비교할 때 LumberChunker는 더 많은 계산 비용이 소요되며, 특히 대용량 문서에서 처리 시간이 증가.

- 그러나 동적 LLM 쿼리를 사용하기에 의미적 독립성을 잘 반영.

5. 한계 및 향후 과제

- 비용 및 속도: LLM 기반으로 작동하기에 처리 속도와 비용이 기존 정적 분할 방식보다 높음.

- 구조화된 텍스트 한계: 서사적 텍스트에 최적화되어 있으며, 법률 문서 등 고도로 구조화된 텍스트에는 부적합.

- 스케일링 문제: 대규모 문서 처리 시 반복적인 LLM 쿼리가 비효율적일 수 있음.

6. 결론

LumberChunker는 서사적 텍스트에서 정보 검색과 QA 정확도를 향상시키는 데 매우 효과적인 방법입니다. 특히 LLM을 활용한 동적 세분화는 기존 방식보다 더 높은 의미적 독립성을 보장하며, RAG 기반 응용 프로그램에 적합합니다.

활용 방안:

- 이 방법은 질문 응답 시스템 또는 정보 검색 엔진에서 서사적 문서 처리를 위한 새로운 기준점을 제공할 수 있습니다.

- 향후 비효율성을 해결하기 위한 병렬 처리 및 최적화 연구가 필요합니다.

관련 논문

LumberChunker 논문에 연관된 주제를 다루는 연구는 Retrieval-Augmented Generation (RAG), 문서 세분화(chunking), 그리고 대규모 언어 모델(LLM) 기반 정보 검색과 관련이 깊습니다.

1. RAG (Retrieval-Augmented Generation)

Lewis et al., 2020 - Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks

- 문제: LLM은 종종 자체적으로 없는 정보를 생성하며, 이는 잘못된 "환각(hallucination)" 문제로 이어질 수 있음.

- 해결: RAG는 외부 검색 시스템을 통해 관련 문서를 모델에 입력으로 제공하여 정보 기반 생성을 가능하게 함.

- 방법:

- 입력 질문에 대해 가장 관련 있는 문서를 검색.

- 검색된 정보를 기반으로 모델이 답변을 생성.

- 결과: 정보의 정확성과 신뢰성을 향상, 특히 지식 기반 질문 응답에서 강력한 성능을 보임.

- 연관성: LumberChunker도 RAG 시스템에 통합되어 정보를 세분화하고, 검색 성능을 향상시키는 방식으로 기여.

2. 문서 세분화 및 Granularity

Shi et al., 2023 - Large Language Models Can Be Easily Distracted by Irrelevant Context

- 문제: LLM이 지나치게 큰 문맥에서 중요한 정보를 간과하거나 산만해지는 현상.

- 기여:

- 적절한 문맥 크기를 유지하면서 정보의 핵심을 포착하는 문서 세분화 방법이 필요함을 강조.

- Granularity가 Retrieval 효율과 직접적으로 연관됨.

- 연관성: LumberChunker의 550 토큰 기반 청크 크기 설정은 이러한 연구 결과를 기반으로 함.

Chen et al., 2023 - Dense x Retrieval: What Retrieval Granularity Should We Use?

- 내용: Retrieval 효율성을 높이기 위한 다양한 granularity 수준(문장, 단락, proposition 등)을 비교.

- 결론:

- Proposition-level 세분화는 위키피디아와 같은 정보 중심 문서에 적합.

- 서사적 문서에는 단락 수준 이상의 문맥 유지가 필요함.

- 연관성: LumberChunker는 서사적 문서에서 proposition-level 접근의 한계를 극복하기 위한 방법으로 설계됨.

Langchain, 2023 - Recursive Character Splitting

- 방법: 텍스트를 계층적으로 구분(단락, 줄바꿈, 공백, 개별 문자).

- 한계: 구조는 유지되지만 의미적 연결성을 간과할 수 있음.

- 연관성: LumberChunker는 이러한 한계를 극복하기 위해 LLM을 사용하여 의미적 독립성을 유지.

3. LLM 기반 Retrieval 및 Generation

Gao et al., 2022 - Precise Zero-Shot Dense Retrieval Without Relevance Labels

- 문제: 무관한 문서가 검색되는 문제를 해결하기 위해 Dense Retrieval 기법 제안.

- 방법:

- 질문(query)을 잠재적 답변(document)으로 변환하는 HyDE(Hypothetical Document Embeddings) 기법.

- 결론: Dense Embedding을 사용하면 더 높은 정확도와 효율성을 달성.

- 연관성: LumberChunker는 Dense Embedding을 기반으로 세분화와 검색 결과를 최적화.

Reid et al., 2024 - Gemini 1.5M Pro

- 내용: Gemini 모델은 최대 150만 토큰을 처리할 수 있는 멀티모달 모델로, 장문의 문서에서도 우수한 성능을 보임.

- 연관성: LumberChunker는 Gemini 모델과 통합되어 문서 세분화와 검색 성능 향상을 시연.

Zhang et al., 2023 - Hallucination in Large Language Models

- 내용: LLM의 환각 문제에 대한 포괄적 조사.

- 결론: RAG와 같은 외부 문서 기반 접근법이 환각을 줄이는 데 효과적.

- 연관성: LumberChunker는 RAG를 강화하는 세분화 방법으로 환각 문제 완화를 목표로 함.

4. Benchmark 및 데이터셋

Kočiský et al., 2017 - NarrativeQA

- 내용: 서사적 문서를 대상으로 한 QA 벤치마크.

- 특징:

- 문맥적 연결성과 서사 흐름이 중요한 질문 응답 환경 제공.

- 대화형 질문과 긴 문맥을 요구하는 응답 생성.

- 연관성: LumberChunker는 NarrativeQA와 유사한 GutenQA 벤치마크를 새롭게 정의하여 서사적 텍스트 검색 성능을 평가.

5. 결론

LumberChunker는 RAG, 문서 세분화, LLM 검색과 관련된 기존 연구를 기반으로 발전된 세분화 방법을 제안합니다. 특히 서사적 텍스트에서 의미적 독립성과 문맥적 연결성을 유지하며 검색 및 질문 응답 성능을 크게 향상시킵니다. 이를 통해 LLM 기반 시스템의 신뢰성과 정확성을 높이고, 서사적 데이터를 처리하는 AI 응용 프로그램에 기여할 수 있습니다.

방법론

LumberChunker의 핵심은 문서를 의미적으로 독립적이고 동적으로 세분화하여 정보 검색의 효율성과 정확성을 높이는 것입니다. 이는 기존의 정적인 문서 세분화 방식(단락, 문장 수준 등)과 달리 LLM을 활용하여 텍스트의 의미적 전환점을 식별함으로써 이루어집니다.

1. 핵심 아이디어

- 목표: 각 청크(chunk)가 문맥적으로 독립적이면서 의미적으로 완결된 정보를 포함하도록 세분화.

- 왜 중요한가?

- 검색 시스템에서 적절한 청크 크기는 정보를 완전하게 포함하면서도 불필요한 문맥 노이즈를 제거함.

- 서사적 텍스트는 단순히 문장이나 단락 단위로 나누는 방식이 의미를 충분히 반영하지 못할 수 있음.

- LumberChunker는 LLM의 강력한 언어 처리 능력을 활용하여 이러한 문제를 해결.

2. 방법론의 단계

(1) 문서 단락화

- 입력 문서를 단락 단위로 나눕니다.

- 각 단락에는 고유한 ID가 부여됩니다. 예를 들어:

- ID 0001: Edward Bear는 계단을 뒤로 내려가고 있었다. ID 0002: 그는 더 나은 방법이 있을지도 모른다고 생각했다. ID 0003: 그러나 그는 항상 결국 이런 방법이 유일하다고 결론지었다.

(2) 단락 그룹 생성

- 연속된 단락을 결합하여 그룹(Gi)를 만듭니다.

- 그룹의 총 토큰 수가 임계값 θ(예: 550 토큰)를 초과할 때까지 단락을 추가합니다.

- 예를 들어, ID 0001에서 ID 0005까지의 단락이 결합되어 Gi 그룹이 생성됩니다.

(3) LLM을 통한 전환점 식별

- LLM(Gemini 1.5 Pro 등)에 Gi 그룹을 입력하고, 콘텐츠 전환점(content shift)을 감지하도록 프롬프트를 작성합니다.

- 프롬프트 예시:

- Task: 다음 단락들(ID 0001~ID 0005)에서 내용이 명백히 달라지기 시작하는 단락의 ID를 찾아주세요. Output: 'Answer: ID XXXX'

- 모델은 Gi 내에서 의미적으로 중요한 변화가 시작되는 단락(ID XXXX)을 반환합니다.

- 예: Answer: ID 0004

(4) 청크 생성 및 반복

- 반환된 전환점(ID XXXX)을 기준으로 현재 청크를 마무리하고, 다음 청크(Gi+1)를 시작합니다.

- 이 과정을 문서의 끝까지 반복하여 전체 문서를 청크 단위로 분할합니다.

3. 동작 예시

(예제 문서: Winnie-the-Pooh)

문서 초기 단락:

ID 0001: Edward Bear는 계단을 뒤로 내려가고 있었다.

ID 0002: 그는 더 나은 방법이 있을지도 모른다고 생각했다.

ID 0003: 그러나 그는 항상 결국 이런 방법이 유일하다고 결론지었다.

ID 0004: 오래전 금요일, Winnie-the-Pooh는 Sanders라는 이름으로 숲에서 살았다.

ID 0005: Christopher Robin이 “그게 무슨 뜻이야?”라고 물었다.

- ID 0001부터 ID 0005까지 결합하여 Gi 그룹을 생성.

- LLM에게 전환점을 찾도록 요청:

- 모델의 출력: Answer: ID 0004

- 청크 생성:

- 첫 번째 청크: ID 0001 ~ ID 0003

- 두 번째 청크는 ID 0004부터 시작.

4. 청크 크기 설정 (Context Size θ)

- 임계값 θ는 청크 크기를 결정하는 주요 변수로, 적절한 균형을 유지해야 함.

- 작은 θ: 문맥이 너무 잘려 검색 성능 저하.

- 큰 θ: 문맥이 과도하게 포함되어 정보가 산만해짐.

- 실험 결과, θ = 550 토큰이 최적의 검색 성능을 보임.

5. 장점

- 의미적 독립성 유지: LLM이 전환점을 식별함으로써 각 청크가 완전한 문맥과 독립적인 의미를 가짐.

- 서사적 텍스트에 최적화: 서사적 흐름을 방해하지 않고 검색 성능을 향상.

- RAG 통합 가능: 생성 모델과 검색 시스템에서 유리한 성능을 보임.

6. 주요 적용 분야

- 서사적 질문 응답 시스템(QA).

- 대규모 문서 검색 시스템.

- 복잡한 서사 구조가 포함된 문서 처리(예: 역사적 문서, 소설).

결론

LumberChunker는 동적이고 의미 중심적인 문서 세분화를 통해 RAG 시스템의 검색 및 QA 성능을 크게 향상시킬 수 있습니다. 특히 LLM의 의미 해석 능력을 활용하여 기존 방식의 한계를 극복하며, 서사적 텍스트 처리에 강력한 도구로 자리 잡을 가능성이 높습니다.

그럼 이건 너무 LLM을 활용한거 아니야...?BERT 모델로 좀 학습해서 할 순 없나...?

LumberChunker가 LLM에 강하게 의존한다는 점은 분명한 한계 중 하나입니다. 하지만 BERT와 같은 사전 학습된 트랜스포머 모델을 활용하면 LLM의 과도한 계산 비용과 속도를 줄이면서 비슷한 방식으로 문서 세분화를 구현할 수 있습니다. 이를 위해 다음과 같은 접근 방식을 고려할 수 있습니다.

1. BERT 기반 문서 세분화 접근

(1) 문장/단락 임베딩 생성

- 문서를 단락 단위로 분할한 후, 각 단락을 BERT 모델에 입력하여 임베딩 벡터를 생성합니다.

- 예: BERT([CLS] + 단락 텍스트 + [SEP]) → 단락 벡터

- [CLS] 토큰 임베딩은 단락의 전체적 의미를 대표하는 벡터로 사용됩니다.

(2) 의미적 전환점 탐지

- 단락 간 유사도 측정:

- 연속된 단락 벡터 간 코사인 유사도를 계산합니다.

- 유사도가 특정 임계값(예: 0.8) 이하로 떨어지면 의미적 전환점으로 간주합니다.

- 예:

- Sim(벡터1, 벡터2) = 0.95 → 같은 맥락

- Sim(벡터2, 벡터3) = 0.75 → 의미적 전환점 발생.

(3) 청크 생성

- 전환점을 기준으로 청크를 나눕니다.

- 단락을 연결해 청크를 생성하되, 청크 내 단락 수나 토큰 수가 과도하지 않도록 제어합니다.

- 예: 전환점 발생 시 → 새로운 청크 시작

2. 장점과 한계

장점

- LLM 사용 감소:

- BERT는 LLM보다 경량화되어 있고 계산 비용이 낮아 대규모 데이터 처리에 적합.

- 효율성 향상:

- LLM의 동적 프롬프트 처리 없이 임베딩 계산으로 빠르게 처리 가능.

- 유사도 계산의 명확성:

- 단순한 코사인 유사도 계산만으로 전환점 탐지가 가능.

한계

- BERT의 문맥 크기 제한:

- BERT는 최대 512 토큰까지 처리 가능하므로, 단락이 길면 분할이 필요함.

- 이는 문맥 손실로 이어질 수 있음.

- 정확도 저하 가능성:

- BERT는 사전 학습된 모델로 특정 도메인에 최적화되지 않아 의미적 전환점 탐지에서 LLM만큼의 정밀도를 보장하지 못할 수 있음.

- 서사적 텍스트 한계:

- 서사적 흐름이 강한 문서에서 의미적 전환점의 미묘한 차이를 포착하는 데 제한적일 수 있음.

3. 개선 방안

(1) BERT의 도메인 적응

- 파인 튜닝(fine-tuning):

- 서사적 문서(GutenQA, NarrativeQA)로 BERT를 파인 튜닝하여 서사적 흐름과 전환점 탐지 능력을 강화.

- 도메인 특화 모델:

- BioBERT, LegalBERT처럼 서사적 문서에 특화된 BERT 변형 모델을 개발.

(2) 클러스터링 활용

- 단락 간 유사도 계산 후, K-means 또는 Hierarchical Clustering을 사용하여 문서를 동적으로 분할.

- 방법: 단락 벡터를 클러스터링하고, 각 클러스터를 하나의 청크로 정의.

- 장점: 유사도를 바탕으로 전환점을 자동 탐지.

(3) 하이브리드 접근

- BERT로 초기 전환점을 탐지한 후, 주요 전환점에서만 LLM을 활용해 최종 청크를 보정.

4. 예시

문서 샘플

ID 0001: Edward Bear는 계단을 뒤로 내려가고 있었다.

ID 0002: 그는 더 나은 방법이 있을지도 모른다고 생각했다.

ID 0003: 그러나 그는 항상 결국 이런 방법이 유일하다고 결론지었다.

ID 0004: 오래전 금요일, Winnie-the-Pooh는 Sanders라는 이름으로 숲에서 살았다.

ID 0005: Christopher Robin이 “그게 무슨 뜻이야?”라고 물었다.

단계

- BERT를 사용해 각 단락의 [CLS] 벡터를 생성.

- 연속된 단락 간 코사인 유사도 계산:

- Sim(ID 0001, ID 0002) = 0.95

- Sim(ID 0002, ID 0003) = 0.90

- Sim(ID 0003, ID 0004) = 0.70 (전환점 탐지)

- 전환점(ID 0004) 기준으로 청크 생성:

- 청크1: ID 0001~ID 0003

- 청크2: ID 0004~ID 0005

5. 결론

BERT 기반 접근은 LLM의 높은 비용과 속도 문제를 해결할 수 있는 현실적 대안입니다. 특히 파인 튜닝과 클러스터링을 결합한 방법은 의미적 전환점 탐지와 문맥 유지 측면에서 효과적일 수 있습니다. 다만, 복잡한 서사적 흐름이 포함된 텍스트에서는 여전히 LLM 보조가 필요할 가능성이 있습니다. BERT와 LLM의 하이브리드 접근이 최적의 성능을 제공할 수 있을 것입니다.

결과, 결론 및 마무리

1. 결과 (Results)

(1) 검색 성능

- LumberChunker는 다양한 검색 지표(DCG@k, Recall@k)에서 기존 방식보다 우수한 성능을 기록.

- DCG@20 기준:

- LumberChunker: 62.09

- 가장 가까운 경쟁 방식(Recursive Chunking): 54.72

- Recall@20에서도 유사한 성능 격차 확인(77.92 vs. 74.35).

- DCG@20 기준:

- 이는 의미적으로 독립적인 청크를 생성함으로써 검색 정확도가 향상되었음을 보여줌.

(2) QA 정확도

- LumberChunker 기반 RAG 파이프라인은 서사적 QA 작업에서 높은 정확도를 달성.

- 특히 자동 생성된 청크나 Recursive Chunking 기반 방법보다 우수한 성능.

- 그러나 수동으로 생성된 청크(gold standard)에는 약간 미치지 못함.

- 이는 LumberChunker가 자동화된 방식 중 가장 신뢰도가 높은 방법임을 입증.

(3) 청크 크기 최적화

- 최적의 청크 크기를 설정하기 위한 실험 결과, 550 토큰 기준이 가장 효율적.

- 너무 큰 청크(1000 토큰)는 모델 성능 저하.

- 너무 작은 청크(450 토큰)는 문맥 단절 문제를 야기.

(4) 계산 효율성

- LumberChunker는 LLM을 활용하기 때문에 기존 방식보다 더 많은 계산 자원이 필요.

- 예: "A Christmas Carol" 처리 시간

- Recursive Chunking: 0.1초

- LumberChunker: 95초

- 이는 동적 LLM 호출에 따른 시간 증가로 분석됨.

- 예: "A Christmas Carol" 처리 시간

2. 결론 (Conclusions)

(1) 기여

- LumberChunker는 기존 문서 세분화 방식의 한계를 극복한 동적 의미 기반 세분화 방식을 제안.

- 서사적 문서에 적합한 방식으로, 각 청크가 문맥적으로 독립적이고 의미적으로 완결된 내용을 보장.

- RAG 시스템에 통합 시 높은 검색 및 QA 성능을 제공.

- 새롭게 제안된 GutenQA 벤치마크는 서사적 텍스트의 검색 성능을 평가할 수 있는 새로운 기준점을 제공.

(2) 우수한 성능

- LumberChunker는 검색 효율성과 QA 정확도에서 기존의 모든 자동화된 방법을 능가.

- 서사적 텍스트에서 Recursive Chunking이나 Proposition-Level Chunking 방식이 가지는 한계를 극복.

(3) 실용성 및 확장성

- LumberChunker는 서사적 QA, 정보 검색, 문서 요약 등 다양한 NLP 응용 프로그램에 활용 가능.

- 특히, 서사적 텍스트에서 정보의 흐름과 의미적 전환을 정확히 반영할 수 있음.

3. 한계 및 향후 과제

(1) 한계

- 계산 비용:

- LLM 활용으로 인해 속도와 비용이 높음.

- 대규모 문서 처리에는 비효율적일 수 있음.

- 구조화된 텍스트 한계:

- 서사적 텍스트에 최적화된 방식으로, 법률 문서나 기술 문서와 같은 고도로 구조화된 텍스트에는 불필요하게 복잡한 방법이 될 수 있음.

- 스케일링 문제:

- LLM의 동적 쿼리 특성상, 대량의 문서를 처리할 때 비효율적.

(2) 향후 과제

- 효율성 개선:

- LLM 호출을 줄이거나 병렬 처리를 통해 처리 속도를 최적화.

- BERT와 같은 경량 모델을 결합하여 계산 비용 절감 가능성 탐색.

- 도메인 확장:

- 서사적 문서 외에 구조화된 문서나 다양한 도메인 텍스트에도 적용 가능하도록 방법론 확장.

- 벤치마크 개선:

- 더 다양한 서사적 문서를 포함한 확장된 벤치마크 데이터셋 개발.

- NarrativeQA와 같은 기존 데이터셋과의 통합 평가를 통해 일반화 성능 테스트.

4. 마무리 (Closing Thoughts)

LumberChunker는 NLP 응용 프로그램에서 문서 검색과 QA 성능을 혁신적으로 향상시킬 수 있는 가능성을 입증했습니다. 특히 LLM의 강력한 언어 이해 능력을 활용하여 서사적 문서의 의미적 독립성과 문맥적 연속성을 유지하면서 세분화하는 방식을 제안한 것은 큰 기여로 평가됩니다.

향후 연구에서는 계산 비용을 줄이고 다양한 도메인에 확장 가능하도록 최적화를 진행해야 하며, 이를 통해 RAG 파이프라인과 같은 최신 NLP 시스템의 필수 구성 요소로 자리 잡을 수 있을 것입니다.

아래는 작성하신 글을 검토하고 부족한 부분을 보완하며, 조금 더 정확하고 체계적으로 정리한 수정본입니다.

수정된 글:

"이 논문은 LLM을 활용하여 문서의 청크를 동적으로 분리하는 방법을 제안하고 있습니다. LLM을 통해 의미적 전환점을 탐지하여 적응형 청크를 생성함으로써 검색 성능과 QA 정확도를 높이는 것을 목표로 하고 있습니다.

다만, LLM을 사용하는 방식은 높은 계산 비용과 리소스 소모 문제가 있다는 점에서 한계가 명확합니다. 이를 해결하기 위해, BERT나 다른 임베딩 모델을 활용하여 의미적 전환점을 탐지하고 청크를 생성하는 방식도 가능했을 것 같습니다.

그럼에도 불구하고, 논문에서 제안한 동적 청킹 방식은 기존의 정적 청크 방식보다 성능 향상에 크게 기여한다는 것을 실험적으로 증명하고 있습니다. 따라서, 성능 최적화와 효율성 측면에서 의미 있는 기여를 한 것으로 평가할 수 있습니다."

보완 및 수정 사항:

- 구조적 개선:

- 기존 작성 내용이 조금 단편적으로 보일 수 있어 문장의 흐름을 명확히 다듬었습니다.

- 논문의 주요 기여와 한계를 함께 설명해 전체적인 맥락을 더 풍부하게 전달.

- 구체적 근거 추가:

- "Embedding 모델"에 대한 가능성을 언급하셨지만, BERT와 같은 대안적 접근을 구체적으로 제안하여 논의의 깊이를 더했습니다.

- 긍정적 평가 추가:

- 동적 청킹 방식의 장점을 강조하여 논문의 기여도를 명확히 표현.

이 수정된 글은 원래 작성하신 내용의 핵심을 유지하면서도, 논문의 기여와 한계를 더 체계적으로 정리하고 구체적 논의점을 보완했습니다. 이렇게 다듬으면 논문에 대한 평가와 대안 제안이 좀 더 명확하게 전달될 것입니다! 😊