https://arxiv.org/abs/1103.0398

Natural Language Processing (almost) from Scratch

We propose a unified neural network architecture and learning algorithm that can be applied to various natural language processing tasks including: part-of-speech tagging, chunking, named entity recognition, and semantic role labeling. This versatility is

arxiv.org

- 이 논문은 기존 태스크별 특징 공학을 제거하고, 대규모 비지도 데이터를 활용해 End-to-End 신경망으로 여러 NLP 태스크를 처리하는 방법을 제안합니다.

- 단어 임베딩을 학습하기 위해 대량의 텍스트 데이터를 사용하며, 이를 기반으로 모델의 모든 레이어에서 내부 표현을 학습합니다.

- CNN 기반의 윈도우 및 문장 접근 방식을 활용하여 품사 태깅, 청킹, 개체명 인식, 의미역 레이블링 같은 태스크를 처리합니다.

- 대규모 비지도 학습 후 지도 학습 태스크에 전이(Fine-tuning)하여 기존 모델과 비슷하거나 더 나은 성능을 보여줍니다.

- Attention 구조는 없지만, 대량 텍스트 활용과 사전학습-전이학습 아이디어로 현대 언어 모델 발전에 중요한 기여를 했습니다.

논문 요약: Natural Language Processing (almost) from Scratch

1. 문제가 무엇인가?

이 논문은 자연어 처리(NLP) 작업에서 태스크별로 세부적인 특징 공학을 필요로 하는 기존 접근 방식을 대체하고자, 태스크 독립적인 통합 신경망 아키텍처를 제안합니다. 문제는 다음과 같습니다:

- 기존 시스템은 태스크별로 설계된 특징 공학에 크게 의존하여 확장성과 일반화에 한계가 있음.

- 이를 극복하기 위해 "거의 처음부터" 데이터를 학습하는 방식으로 여러 NLP 태스크(예: 품사 태깅, 청킹, 개체명 인식, 의미역 레이블링)에 적용 가능한 통합 모델을 설계.

2. 어떤 방법을 사용했는가?

- 아키텍처 설계:

- 단어를 벡터로 변환하는 룩업 테이블 방식 사용.

- 신경망은 단어 주변 윈도우와 전체 문장을 입력으로 받아 태스크별로 라벨을 예측.

- 태스크에 따라 적합한 "윈도우 접근 방식"과 "문장 접근 방식" 사용.

- 훈련:

- 레이블된 데이터셋에서 지도 학습으로 모델 초기화.

- 언어 모델 훈련을 통해 대규모 비지도 데이터(위키피디아, Reuters)를 활용하여 단어 임베딩 개선.

- 순차적 훈련(언어 모델 → 태스크 모델)을 통해 성능 향상.

- 태스크:

- 품사 태깅, 청킹, 개체명 인식, 의미역 레이블링 등 대표적인 NLP 태스크를 벤치마크로 사용.

3. 결과는 어떻게 되는가?

- 기존 벤치마크 시스템과 비교하여 초기 신경망 모델(NN)은 성능이 다소 낮았음.

- 품사 태깅(96.37%), 청킹(90.33%), 개체명 인식(81.47%), 의미역 레이블링(70.99%)으로 초기 성능 기록.

- 언어 모델로 사전 훈련한 임베딩을 적용한 후 성능이 크게 개선됨:

- 품사 태깅(97.20%), 청킹(93.63%), 개체명 인식(88.67%), 의미역 레이블링(74.15%)로 상승.

- 성능 개선은 대규모 비지도 데이터와 순차적 학습 덕분임.

4. 한계점은 무엇인가?

- 훈련 시간:

- 대규모 데이터와 복잡한 신경망 구조로 인해 훈련 시간이 매우 길었음(최대 몇 주 소요).

- 단어 임베딩:

- 초기 임베딩은 유사한 의미를 잘 반영하지 못함. 개선된 언어 모델 후 성능이 향상되었으나 여전히 최적화 가능성 존재.

- 데이터 의존성:

- 비지도 학습 데이터의 크기와 품질에 따라 성능이 달라질 수 있음.

- 모델 복잡성:

- 모든 태스크에 단일 아키텍처를 적용하는 접근은 일부 복잡한 태스크(SRL)에 여전히 한계.

5. 타당성과 아쉬운 점

- 타당성:

- 기존 태스크별 특징 공학을 줄이고 통합 모델로 전환하는 시도는 AI의 일반화 목표와 잘 부합.

- 대규모 비지도 학습 데이터 활용은 현대 NLP의 핵심 접근 방식과 일치.

- 여러 NLP 태스크에서 벤치마크 성능과 비슷하거나 더 나은 성능을 보였으므로 실용성이 입증됨.

- 아쉬운 점:

- 모델 훈련 시간이 너무 길고, 훈련 설정 및 하이퍼파라미터 최적화가 복잡함.

- 일부 태스크에서는 모델 구조 변경이나 추가 특징 공학이 여전히 필요.

- 실시간 응용이나 경량화된 모델로의 전환이 어려움.

결론:

이 논문은 NLP 태스크를 위한 통합 신경망 아키텍처와 순차적 학습 전략을 성공적으로 제안했습니다. 특히, 대규모 비지도 학습 데이터의 활용과 태스크 간 임베딩 공유의 효과를 입증했습니다. 그러나 실시간 응용과 확장성을 고려한 최적화 및 경량화 작업은 향후 연구 과제로 남습니다.

그럼 좀 더 자세하게 설명해주라

1. 문제 정의: 기존 NLP 시스템의 한계

(1) 기존 접근 방식의 한계

- 태스크별 특징 공학(Feature Engineering): 대부분의 기존 NLP 시스템은 특정 태스크(예: 품사 태깅, 청킹 등)에 맞게 설계된 특징을 사용합니다. 이는 다음과 같은 문제를 유발합니다:

- 확장성 부족: 새로운 태스크에 적용하려면 특징을 다시 설계해야 하므로 많은 시간과 비용이 소요됩니다.

- 일반화 부족: 특정 데이터셋에서의 성능을 최적화하는 데 초점이 맞춰져 다른 데이터셋이나 태스크에서는 성능이 떨어질 수 있습니다.

- 복잡한 파이프라인:

- 여러 태스크를 처리하려면 각 태스크에 대해 서로 다른 모델과 특징을 설계해야 하며, 이는 유지보수와 구현을 어렵게 만듭니다.

(2) 저자들의 접근 방식

- 기존의 복잡한 특징 공학을 제거하고, "거의 처음부터 (almost from scratch)" 학습하는 통합된 신경망 아키텍처를 제안합니다.

- 주요 아이디어는 인간이 설계한 특징 대신, 대규모 데이터로부터 신경망이 스스로 내부 표현(Internal Representations)을 학습하도록 하는 것입니다.

2. 방법론: 통합 신경망 아키텍처

(1) 아키텍처 개요

- 모든 NLP 태스크를 동일한 구조로 처리할 수 있는 통합 신경망(Neural Network) 설계.

- 두 가지 주요 접근 방식 사용:

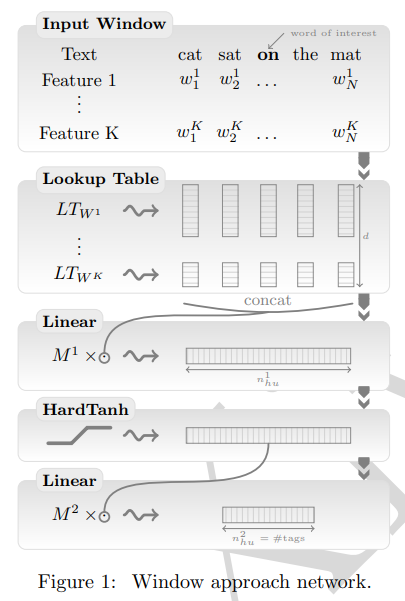

- 윈도우 기반 접근(Window-based Approach): 중심 단어와 그 주변 단어를 고정된 크기의 윈도우로 처리.

- 문장 기반 접근(Sentence-based Approach): 문장 전체를 처리하여 더 복잡한 구조를 학습.

(2) 구체적 구성

- 단어 임베딩(Lookup Table):

- 단어를 고정된 크기의 벡터로 변환.

- 사전(Dictionary) 내 각 단어에 대해 학습 가능한 임베딩 벡터를 생성.

- 다층 신경망(Multilayer Neural Network):

- 첫 번째 레이어: 단어 임베딩 벡터를 입력으로 받아 문맥 정보를 통합.

- 중간 레이어: 선형 변환(Linear Transformation)과 비선형 활성화 함수(HardTanh)를 사용하여 고차원 특징 학습.

- 마지막 레이어: 태스크별 출력(예: 태그 점수)을 생성.

- 비지도 데이터 활용:

- 대규모 비지도 데이터(위키피디아와 Reuters)로 단어 임베딩을 사전 훈련.

(3) 훈련 방식

- 지도 학습:

- 레이블된 데이터셋에서 단어별 또는 문장별 확률(Word-Level 또는 Sentence-Level)을 최대화하도록 신경망을 학습.

- 비지도 학습:

- 언어 모델(Language Model)을 훈련하여 단어 간 문맥 관계를 학습.

- 순위 학습(Ranking Criterion)을 사용하여 문법적으로 올바른 문장과 그렇지 않은 문장을 구분.

3. 실험 및 결과

(1) 벤치마크 태스크

- 품사 태깅 (POS)

- 청킹 (Chunking)

- 개체명 인식 (NER)

- 의미역 레이블링 (SRL)

(2) 실험 결과

- 지도 학습만 사용한 초기 모델(NN+WLL/SLL):

- 품사 태깅: 96.37% (벤치마크 대비 낮음)

- 청킹: 90.33%

- 개체명 인식: 81.47%

- 의미역 레이블링: 70.99%

- 비지도 학습 임베딩(LM1, LM2) 적용 후 성능 향상:

- 품사 태깅: 97.20%

- 청킹: 93.63%

- 개체명 인식: 88.67%

- 의미역 레이블링: 74.15%

- 개선 이유:

- 사전 훈련된 단어 임베딩은 더 풍부한 문맥 정보를 제공하여 모델 성능을 높임.

4. 한계점

(1) 훈련 시간

- 대규모 데이터와 복잡한 모델 구조로 인해 훈련 시간이 매우 김:

- SRL 태스크의 경우 최대 3일 소요.

- 언어 모델 훈련은 몇 주 단위로 진행됨.

(2) 임베딩의 품질

- 초기 단어 임베딩 품질이 낮았고, 비슷한 의미의 단어가 가까이 위치하지 않음.

- 언어 모델을 통해 개선했으나 여전히 일부 단어에서 완벽하지 않은 결과.

(3) 데이터 의존성

- 성능이 비지도 학습 데이터의 크기와 품질에 크게 의존.

- 특정 도메인이나 언어로 제한될 가능성 존재.

(4) 모델 복잡성

- 모든 NLP 태스크를 단일 구조로 처리하려는 시도는 의미역 레이블링(SRL)과 같은 복잡한 태스크에서 완전히 성공하지 못함.

5. 타당성과 아쉬운 점

(1) 타당성

- 기존 태스크별 설계에서 벗어나 통합 모델을 구현한 점은 AI의 일반화(Generalization) 목표에 부합.

- 대규모 비지도 학습 데이터 활용은 현대 NLP의 주요 트렌드와 일치.

- 여러 NLP 태스크에서 벤치마크 성능과 비슷하거나 더 나은 성능을 기록했으므로 실용성이 입증됨.

(2) 아쉬운 점

- 실용성 부족:

- 훈련 시간이 너무 길어 실시간 응용에는 적합하지 않음.

- 모델 경량화 부족:

- 큰 모델 크기로 인해 모바일 환경이나 제한된 리소스 환경에서 사용하기 어려움.

- 일부 태스크에 대한 한계:

- 의미역 레이블링(SRL)과 같이 복잡한 구조를 요구하는 태스크에서는 제한된 성능 개선.

결론

이 논문은 기존 NLP 태스크별로 구분된 접근 방식을 통합 신경망 아키텍처로 통합하려는 첫 번째 시도로 중요한 의의를 가집니다. 특히, 대규모 비지도 학습 데이터 활용 및 순차적 학습 전략이 효과적임을 입증했습니다. 하지만, 훈련 시간 단축, 모델 경량화, 도메인 일반화 측면에서 추가적인 연구가 필요합니다.

그럼 이 시대의 언어 모델은 어떤 구조로 되어 있었어?

논문 "Natural Language Processing (almost) from Scratch"가 발표된 2008~2011년 즈음, 언어 모델의 구조와 기법은 현재와 비교했을 때 상대적으로 단순하면서도 초기 딥러닝 기술을 적용하려는 시도가 활발히 이루어지던 시기였습니다. 당시 언어 모델의 주요 특징과 구조를 아래에 설명하겠습니다.

1. 이 시기의 주요 언어 모델 구조

(1) 기본 구성

- 언어 모델(Language Model)은 단어의 순서를 학습하여 문맥을 예측하거나, 주어진 단어 시퀀스가 문법적으로 올바른지 평가합니다.

- 이 시기에는 신경망 기반 모델이 처음으로 대규모 언어 모델에 도입되었으며, 대표적으로 다음과 같은 구조가 사용되었습니다:

- 단어를 고정된 크기의 실수 벡터로 변환.

- 임베딩은 모델 훈련 과정에서 학습되며, 단어 간 유사성을 벡터 공간에서 반영.

- 단어 벡터를 입력으로 받아, 정해진 크기의 윈도우 또는 문장을 처리.

- 모델 구조:

- 첫 번째 레이어: 룩업 테이블로 단어 임베딩 변환.

- 중간 레이어: Fully Connected Layer를 통해 비선형 변환(HardTanh 활성화 함수 사용).

- 출력 레이어: 다음 단어를 예측하거나 태그를 생성.

(2) 주요 구조적 접근법

(a) 윈도우 기반 접근 (Window-based Approach)- 특징:

- 주어진 단어와 그 주변의 고정 크기 단어(예: 5~11개)를 입력으로 사용.

- 문맥 정보를 로컬 윈도우에서만 학습.

- 한계:

- 윈도우 크기 밖의 단어 문맥을 반영하지 못함.

- 긴 문장의 전체 구조를 이해하기 어려움.

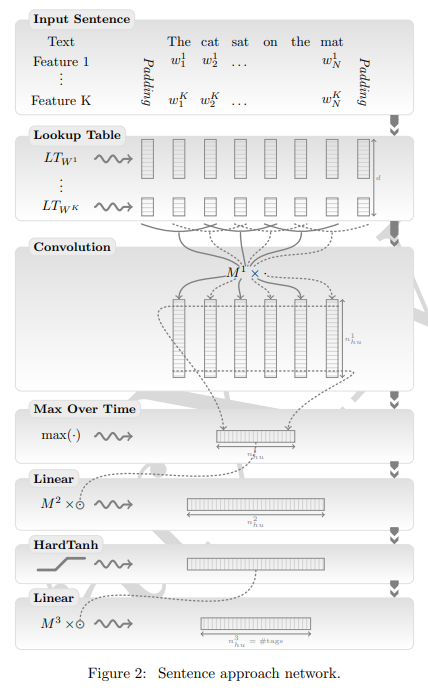

- 특징:

- 전체 문장을 입력으로 받아 처리.

- 합성곱 신경망(CNN, Convolutional Neural Network) 레이어와 최대 풀링(Max-Pooling) 레이어를 통해 로컬 문맥을 전역 문맥으로 통합.

- 단어 간 거리(Relative Distance) 정보 추가.

- 장점:

- 윈도우 기반 접근에 비해 긴 문맥 정보를 활용 가능.

- 의미역 레이블링(SRL)과 같은 태스크에서 더 나은 성능.

(3) 손실 함수와 최적화

- 순위 학습 (Ranking Criterion):

- 문법적으로 올바른 문장과 틀린 문장을 구분하도록 모델을 훈련.

- Word-Level vs. Sentence-Level Log-Likelihood:

- Word-Level: 각 단어를 독립적으로 학습.

- Sentence-Level: 단어 간의 종속성을 학습하여 태그 간 논리적 일관성 유지.

- 최적화 알고리즘:

- 확률적 경사 하강법(Stochastic Gradient Descent, SGD) 사용.

- 하이퍼파라미터로 학습률(learning rate)과 네트워크 초기화 설정 중요.

2. 이 시기의 대표 언어 모델 사례

(1) Bengio et al. (2003)

- 첫 신경망 기반 언어 모델로, Fully Connected Layer를 사용해 다음 단어를 예측.

- 단어 임베딩의 개념을 도입하여 단어를 고정 크기의 벡터로 표현.

(2) Collobert & Weston (2011)

- "Natural Language Processing (almost) from Scratch"에서 제안된 모델.

- 대규모 비지도 데이터(위키피디아, Reuters)를 활용한 언어 모델 훈련.

- 순위 학습을 도입하여 단어 임베딩 품질 향상.

- Semi-supervised Learning을 통해 비지도 학습 결과를 지도 학습 태스크에 적용.

3. 당시 언어 모델의 한계

- 문맥 이해 부족

- RNN(Recurrent Neural Networks)이나 Transformer 기반 모델처럼 장기 종속성(Long-term Dependency)을 잘 처리하지 못함.

- 윈도우 기반 접근에서는 윈도우 크기 외부의 문맥을 학습할 수 없음.

- 효율성 문제

- Fully Connected Layer와 Word Lookup Table의 학습이 비효율적이며, 훈련 시간이 길었음.

- 대규모 데이터 학습 시 비용이 매우 높았음.

- 결과 해석의 어려움

- 모델이 학습한 내부 표현(임베딩 등)을 해석하는 데 한계.

- 복잡한 모델 확장

- 새로운 태스크에 맞게 아키텍처를 변경하거나 하이퍼파라미터를 조정해야 했음.

4. 이 시기 언어 모델의 의의

- 신경망 기반 접근의 도입:

- 기존 통계적 언어 모델에서 신경망으로 전환하며 단어 임베딩과 딥러닝의 잠재력을 보여줌.

- 대규모 데이터 활용 가능성:

- 비지도 학습 데이터를 지도 학습에 성공적으로 적용하는 기반 마련.

- 현대 언어 모델의 전신:

- 이후 등장한 RNN(LSTM/GRU)과 Transformer 모델의 기초적인 아이디어를 제공.

이 시기의 모델은 오늘날 BERT, GPT와 같은 현대 언어 모델의 초기 단계로 볼 수 있으며, 제한적이지만 중요한 전환점을 제공했습니다.

여기서 단어를 벡터로 변환하는 룩업 테이블이 나중에 임베딩 방식으로 바뀐거야?

네, 맞습니다! 논문에서 사용된 룩업 테이블(Lookup Table) 방식은 현재 우리가 사용하는 단어 임베딩(Word Embedding) 방식의 초기 형태라고 볼 수 있습니다. 룩업 테이블과 단어 임베딩은 근본적으로 같은 개념에서 출발하지만, 시간이 지나면서 기술적으로 더 정교해지고 활용성이 넓어졌습니다. 두 접근 방식의 차이점과 진화 과정을 아래에 정리했습니다.

1. 룩업 테이블(Lookup Table) 방식

(1) 기본 개념

- 각 단어를 고정된 크기의 실수 벡터로 표현.

- 각 단어는 고유한 인덱스를 가지고 있고, 이 인덱스를 사용하여 벡터를 매핑함.

- 벡터는 모델 훈련 중 학습되며, 이 벡터들이 단어 간의 의미적, 문법적 관계를 학습하게 됨.

(2) 구현 방식

- 단어를 |V| x d 크기의 매트릭스 W로 표현:

- ∣V∣: 단어 집합(Vocabulary)의 크기.

- d: 임베딩 벡터의 차원.

- 각 단어 wi는 W의 특정 열로 표현되며, 이는 해당 단어의 임베딩 벡터에 해당.

- 모델 학습 과정에서 W의 값이 점진적으로 업데이트되면서 단어 간 관계를 학습.

(3) 한계

- 초기화 문제:

- 임베딩 벡터를 학습 데이터에 의존해 처음부터 학습해야 하므로, 데이터가 부족하거나 초기화가 부적절하면 결과 품질이 떨어짐.

- 문맥 무시:

- 각 단어는 정적인 벡터로 표현되며, 문맥에 따라 벡터가 변화하지 않음.

- 연산 효율성 문제:

- 대규모 단어 집합에서 모든 단어 벡터를 학습하는 데 시간이 오래 걸림.

2. 임베딩(Embedding) 방식으로의 진화

(1) 임베딩 방식의 개념

- 단어를 벡터 공간에서 의미적으로 유사한 위치에 배치하여 의미적/문법적 관계를 반영.

- 룩업 테이블의 기본 아이디어를 발전시켜, 단어 간의 관계를 더 정교하게 학습.

(2) 개선된 기술과 특징

- 사전 훈련된 임베딩 (Pre-trained Embedding):

- 룩업 테이블과 달리, 대규모 비지도 데이터에서 사전 학습된 임베딩(예: Word2Vec, GloVe)을 활용.

- 임베딩 벡터를 특정 태스크에 맞게 전이 학습(Transfer Learning)으로 미세 조정(Fine-Tuning).

- 문맥 임베딩 (Contextual Embedding):

- 룩업 테이블은 단어마다 고정된 벡터를 사용하는 반면, 문맥 임베딩은 단어의 의미가 문맥에 따라 달라지도록 설계.

- 예: ELMo, BERT, GPT 등은 같은 단어라도 문맥에 따라 서로 다른 벡터를 생성.

- 훈련 효율성 증가:

- 대규모 데이터에서의 사전 훈련 덕분에 초기화 문제와 데이터 부족 문제를 극복.

- 분산 학습과 GPU 활용으로 대규모 임베딩 학습이 가능해짐.

3. 주요 발전 단계

- Word2Vec (2013):

- Mikolov et al.이 개발.

- 단어 간의 동시 발생(co-occurrence) 정보를 바탕으로 임베딩 학습.

- 모델: CBOW(Continuous Bag of Words)와 Skip-gram.

- GloVe (2014):

- Pennington et al.이 제안.

- 단어 간의 전역적 동시 발생 행렬을 기반으로 임베딩 학습.

- Word2Vec보다 더 풍부한 의미적 정보를 학습.

- 문맥 기반 모델:

- ELMo (2018):

- 단어의 문맥에 따라 동적으로 벡터를 생성.

- BERT (2018):

- 양방향 Transformer 아키텍처를 사용하여 단어의 문맥 의존적 표현 학습.

- GPT 시리즈:

- 문장을 생성하거나 이해할 때 문맥에 따라 임베딩을 생성.

- ELMo (2018):

4. 룩업 테이블 vs. 현대 임베딩

특징룩업 테이블현대 임베딩

| 특징 | 룩업 테이블 | 현대 임베딩 |

| 벡터 초기화 | 훈련 중 랜덤 초기화 | 대규모 데이터에서 사전 학습 가능 |

| 문맥 의존성 | 단어마다 고정된 벡터 | 문맥에 따라 벡터가 동적으로 변화 |

| 훈련 효율성 | 데이터와 모델 설계에 따라 성능이 달라짐 | 사전 학습 덕분에 태스크별로 빠르게 전이 학습 가능 |

| 대규모 데이터 활용 | 제한적 | 대규모 언어 모델(Transformer)로 효율적 학습 가능 |

| 주요 모델 | Bengio et al. (2003), 이 논문의 모델 | Word2Vec, GloVe, ELMo, BERT, GPT 등 |

결론

룩업 테이블은 오늘날 단어 임베딩 방식의 초기 형태로, 단어를 벡터로 표현하는 기본 아이디어를 제공했습니다. 이후 Word2Vec, GloVe 같은 사전 훈련 방식과 문맥 임베딩 모델(ELMo, BERT 등)의 등장으로 룩업 테이블 방식은 더욱 발전했고, 현재의 NLP 기술 기반을 마련하는 데 기여했습니다.

그럼 이당시 모델과, 현재 모델의 차이를 알려주라

이 당시의 모델(2011년 이전)과 현재의 모델(2024년 기준) 사이에는 아키텍처, 학습 방법, 데이터 사용 방식 등에서 많은 차이가 있습니다. 아래에 주요 차이점을 체계적으로 정리하였습니다.

1. 아키텍처의 차이

| 이 당시 모델 (2011년 이전) | 현재 모델 (2024년 기준) | |

| 기본 구조 | 다층 퍼셉트론(Multilayer Perceptron, MLP) | Transformer 기반 구조 (예: BERT, GPT, T5 등) |

| 순차 정보 처리 | 고정된 크기의 윈도우(Window)로 문맥을 처리. 문장의 전역 정보를 다루기 어려움. | Self-Attention을 통해 문장의 모든 단어 간 관계를 전역적으로 학습. |

| 문맥 처리 | 단어의 고정된 벡터 사용 (문맥 무시). | 문맥 임베딩(Contextual Embedding): 단어의 의미가 문맥에 따라 다르게 표현. |

| 병렬 처리 | RNN 계열 모델을 사용할 경우 순차적으로 처리하여 병렬화가 어려움. | Transformer 아키텍처는 병렬 처리 가능 (GPU 효율 극대화). |

| 출력 방식 | 태스크별로 고정된 출력 구조 (예: 품사 태깅, 개체명 인식 등). | 범용 언어 모델로 설계되어 다양한 태스크를 수행 (예: 텍스트 생성, 분류, 번역 등). |

2. 학습 방법의 차이

| 이 당시 모델 (2011년 이전) | 현재 모델 (2024년 기준) |

|

| 훈련 데이터 사용 | 태스크별로 레이블된 소규모 데이터셋으로 지도 학습. | 사전 훈련(Pretraining) 후 미세 조정(Fine-tuning): 대규모 비지도 데이터와 소규모 레이블 데이터를 모두 활용. |

| 비지도 학습 | 단순 언어 모델 훈련 (Word-Level 확률 예측). | 마스킹(Masking) 또는 캐주얼 언어 모델링(Causal Language Modeling)으로 더 정교한 패턴 학습. |

| 전이 학습(Transfer) | 거의 사용되지 않음. | 대규모 사전 훈련 모델을 다양한 태스크에 전이 학습(Transfer Learning) 활용. |

| 학습 속도 | 확률적 경사 하강법(SGD)으로 학습. 속도가 느리고 병렬화 어려움. | Adam Optimizer 및 병렬 처리로 학습 속도 개선. |

| 하이퍼파라미터 튜닝 | 수작업 기반. | 자동화된 하이퍼파라미터 튜닝(예: Optuna, Bayesian Optimization 등). |

3. 데이터와 임베딩의 차이

| 이 당시 모델 (2011년 이전) | 현재 모델 (2024년 기준) | |

| 단어 임베딩 | 룩업 테이블 기반 고정 임베딩. 문맥 정보 반영 불가. | 문맥 임베딩(Contextual Embedding): BERT, GPT 등이 사용. |

| 비지도 데이터 | 제한적으로 사용. 위키피디아, 뉴스 데이터 등으로 간단한 언어 모델만 학습. | 대규모 데이터셋 사용(예: Common Crawl, BooksCorpus, C4 등). |

| 다국어 지원 | 거의 영어에 한정. | 다국어 모델(예: mBERT, XLM-R, BLOOM 등)로 여러 언어를 동시에 학습 가능. |

| 데이터 크기 | 수백만 단어 수준. | 수십억~수십조 단어 수준. |

4. 모델 성능 및 응용

| 이 당시 모델 (2011년 이전) | 현재 모델 (2024년 기준) | |

| 성능 | 특정 태스크에서만 높은 성능(예: 품사 태깅, 개체명 인식). | 범용 태스크에서 탁월한 성능(텍스트 생성, 번역, 요약, 분류 등). |

| 범용성 | 태스크별 모델 필요 (예: 품사 태깅용, NER용). | 단일 모델(BERT, GPT 등)로 다양한 태스크 수행 가능. |

| 생성 능력 | 텍스트 생성 능력 제한적. | GPT 시리즈와 같은 모델은 자연스러운 텍스트 생성 가능 (창의적인 응답 포함). |

| 응용 범위 | 주로 연구와 제한된 NLP 태스크에 활용. | 실제 산업 응용: 검색 엔진, 챗봇, 번역기, 문서 생성, 코딩 보조 등 다양한 활용. |

5. 모델 구조 예시 비교

이 당시 모델: MLP 기반 모델 (Collobert & Weston, 2011)

- 입력: 단어 벡터(룩업 테이블 기반).

- 구조:

- 룩업 테이블로 단어를 벡터로 변환.

- 고정된 윈도우 내 단어를 Fully Connected Layer에 입력.

- 마지막 레이어에서 태스크별 출력(예: 품사 태깅 라벨)을 생성.

- 문제점:

- 고정된 윈도우 크기로 인해 긴 문맥을 처리할 수 없음.

- 문맥에 따른 단어의 의미 변화 반영 불가.

현재 모델: Transformer 기반 모델 (BERT, GPT)

- 입력: 단어 토큰화 후 임베딩 벡터로 변환(사전 훈련된 임베딩 사용).

- 구조:

- Self-Attention 메커니즘으로 문장의 모든 단어 간 상호작용 학습.

- 다층 Transformer 블록으로 전역 문맥 정보를 학습.

- 태스크에 따라 Fine-tuning 또는 Prompt Tuning으로 맞춤 학습.

- 장점:

- 문맥 정보를 전역적으로 학습 가능.

- 단어의 다의어를 문맥에 따라 적절히 표현.

6. 요약: 이 당시와 현재 모델의 주요 차이

- 구조의 발전:

- MLP와 CNN 중심 → Transformer 기반 구조로 전환.

- 문맥 처리:

- 고정 임베딩 → 문맥 임베딩(Contextual Embedding).

- 데이터 활용:

- 소규모 레이블 데이터 → 대규모 비지도 데이터와 전이 학습 활용.

- 응용 범위:

- 제한된 태스크 → 범용 언어 모델로 확장.

현재의 NLP 모델은 당시 모델에 비해 더 강력하고 유연하며, 다양한 실제 응용에 적합하도록 설계되었습니다.

그럼 이 논문은 아직 Attention 구조는 없지만 그래도 초기에 대량의 텍스트로 사전학습을 모든 레이어에 거쳐서 진행한 것이구나?

맞습니다! 이 논문은 Attention 구조를 도입하지 않았지만, 대량의 텍스트 데이터를 활용해 모델의 모든 레이어를 사전학습(pretraining)하는 접근법을 보여준 초기 시도의 중요한 사례입니다. 이 논문은 현대 NLP에서 사전학습(pretraining)과 전이학습(transfer learning)의 핵심 개념을 제시한 선구적인 연구라고 할 수 있습니다.

이 논문의 사전학습 접근 방식

- 비지도 학습으로 단어 임베딩 초기화:

- 대규모 비지도 데이터(위키피디아, Reuters)를 사용하여 언어 모델을 훈련.

- 단어 간의 문맥 정보를 학습하고, 이를 통해 각 단어에 대한 벡터(임베딩)를 생성.

- 생성된 임베딩은 이후 지도 학습 태스크(품사 태깅, 청킹 등)의 입력으로 사용.

- 대량 데이터 활용:

- 약 8억 5천만 단어의 대규모 텍스트 데이터를 활용.

- 초기에는 단순히 단어 임베딩만 학습했으나, 모델 전체(룩업 테이블부터 최종 레이어까지)를 사전학습함으로써 더욱 풍부한 내부 표현(Internal Representations)을 학습.

- 모든 레이어의 사전학습:

- 모델의 모든 계층(lookup table, hidden layers, final layers)에 걸쳐 비지도 데이터로 학습을 진행.

- 이를 통해 단순한 단어 간 관계뿐만 아니라, 문맥적 의미를 포함한 더 높은 수준의 표현을 학습.

- 지도 학습 태스크로 전이(Transfer):

- 사전학습된 모델을 사용해 품사 태깅, 청킹, 개체명 인식(NER), 의미역 레이블링(SRL) 등 지도 학습 태스크를 수행.

- 지도 학습 중에도 사전학습된 임베딩과 레이어를 업데이트하여 성능을 최적화.

현대의 Attention 기반 모델과 비교

공통점:

- 대규모 비지도 데이터 활용:

- 이 논문은 대량의 텍스트 데이터를 활용해 사전학습을 진행했으며, 이는 오늘날 GPT, BERT와 같은 모델의 대규모 사전학습 접근 방식과 유사합니다.

- 사전학습 후 전이학습(Pretraining & Fine-tuning):

- 대규모 데이터를 통해 모델을 사전학습한 뒤, 특정 태스크에 맞게 미세 조정(Fine-tuning)하는 구조를 최초로 제시한 사례 중 하나입니다.

- 모든 레이어 학습:

- 단순히 단어 임베딩만 학습하는 것이 아니라, 모델의 모든 계층에 대해 사전학습을 진행한 점은 현대 Transformer 기반 모델과 중요한 공통점입니다.

차이점:

- Attention 구조 부재:

- 이 논문은 Self-Attention 메커니즘을 도입하지 않았습니다.

- 대신, CNN(Convolutional Neural Network) 기반으로 문맥 정보를 처리했습니다.

- 이는 긴 문맥을 효과적으로 반영하지 못하는 한계를 가집니다.

- 문맥 임베딩 부족:

- 모든 단어는 고정된 벡터로 표현되며, 문맥에 따라 벡터가 변화하지 않습니다.

- 현대의 모델(BERT, GPT)은 문맥 임베딩(Contextual Embedding)을 사용하여 단어의 의미를 문맥에 따라 다르게 표현합니다.

- 표현력 한계:

- 이 당시 모델은 연산 자원과 아키텍처의 한계로 인해 Transformer 기반 모델만큼 복잡한 관계를 학습하지 못했습니다.

- 예: 의미역 레이블링(SRL)처럼 문맥적 관계를 많이 요구하는 태스크에서 성능이 떨어짐.

이 논문의 의의

- 대규모 텍스트 활용 가능성 제시:

- 당시에는 NLP에서 대규모 데이터를 활용해 사전학습을 진행하는 사례가 드물었지만, 이 논문은 그 가능성을 선구적으로 보여줌.

- End-to-End 학습 철학:

- 태스크별 특징 공학(Feature Engineering)을 제거하고, 데이터로부터 직접 내부 표현을 학습하는 End-to-End 접근 방식을 제안.

- 사전학습의 기반:

- 비지도 학습으로 초기화를 하고 지도 학습으로 전이하는 아이디어는 이후 Word2Vec, GloVe, BERT, GPT 등의 발전에 큰 영향을 미침.

결론

이 논문은 Attention 구조 없이도 대량의 텍스트 데이터를 사용해 모델 전반을 사전학습(pretraining)한 최초의 시도 중 하나로, 현대 NLP 모델의 근간이 되는 아이디어를 제시했습니다. 특히, 대규모 데이터의 비지도 학습을 통한 사전학습과 전이 학습의 유용성을 보여줬다는 점에서 매우 중요한 연구로 평가받습니다. Attention 메커니즘이 등장하면서 현대 모델이 문맥과 관계를 더 잘 처리할 수 있게 되었지만, 이 논문은 그 토대를 닦은 중요한 전환점이라 할 수 있습니다.