https://arxiv.org/abs/2406.04341

Interpreting the Second-Order Effects of Neurons in CLIP

We interpret the function of individual neurons in CLIP by automatically describing them using text. Analyzing the direct effects (i.e. the flow from a neuron through the residual stream to the output) or the indirect effects (overall contribution) fails t

arxiv.org

1차적으로 뉴런의 활성화 정도만을 확인하면 뉴런의 특성을 제대로 표현할 수 없다.

이 뉴런이 또 어떤 영향을 미치는 지, 다른 레이어를 거쳐 출력에 미치는 효과를 확인해야 그 뉴런의 특징을 제대로 표현할 수 있다.

그리하여 이 논문에서는 스파스 분해 기법을 통해서 뉴런의 2차 효과를 텍스트 표현으로 분해하여 설명하려고 한다.

VIT모델은 사용해본적이 없어서 많은 부분에서 이해한 것은 아니나 그래도 다양한 예시를 통해서 뉴런을 설명할 수 있도록 만들고, 적대적 예제를 생성하거나, 이미지 내부에 숨겨진 개념을 찾고, 이미지 객체 분할이 가능하도록 만드는 논문이다.

1. 문제 제기

논문은 CLIP 모델의 뉴런을 해석하는 데 어려움이 있다는 문제를 제기합니다. 기존 연구는 CLIP의 주의(head) 구조에 대한 해석에 중점을 두었으나, 뉴런의 역할과 기능에 대한 해석은 이루어지지 않았습니다. 뉴런은 정보가 중복 저장되어 있어서 일부 뉴런을 비활성화해도 큰 변화가 없고, 직접적인 출력 효과는 미미합니다. 이를 해결하기 위해 뉴런의 2차 효과를 분석하는 새로운 렌즈를 제안했습니다.

2. 제안된 방법

제안된 방법은 뉴런의 2차 효과를 통해 뉴런의 역할을 이해하는 것입니다. 뉴런의 활성화가 이후 여러 주의 레이어를 거쳐 출력에 영향을 미치는 방식을 분석하고, 이 2차 효과를 통해 뉴런의 역할을 보다 명확하게 해석하고자 했습니다. 이를 통해 뉴런이 다양한 개념에 걸쳐 활성화되는 다의적(polysemantic) 행동을 보인다는 점을 확인했습니다.

3. 사용된 방법

- CLIP-ViT 아키텍처 분석: CLIP의 이미지와 텍스트 임베딩을 사용하는 아키텍처를 바탕으로, 뉴런이 1차(직접) 및 2차(간접) 효과를 통해 출력에 영향을 미치는 과정을 분석했습니다.

- 2차 효과 렌즈: 뉴런 활성화가 주의 레이어를 통해 출력에 도달하는 과정을 수학적으로 모델링하여 2차 효과를 정의했습니다. 뉴런의 2차 효과는 주로 후반 레이어에서 나타났으며, 각 뉴런의 2차 효과는 특정 이미지 세트(<2%)에만 강하게 나타났습니다.

- 스파스 분해 기법: 뉴런의 2차 효과를 텍스트로 분해하여, 각 뉴런이 다양한 개념에 걸쳐 어떤 의미를 가지는지 파악했습니다.

4. 결과 및 발견

- 다의성: 뉴런은 다의적으로 여러 개념을 동시에 나타내며, 예를 들어 동일한 뉴런이 '차량'과 '배'와 같은 상이한 개념에 대해 활성화될 수 있음을 확인했습니다.

- 적용 사례:

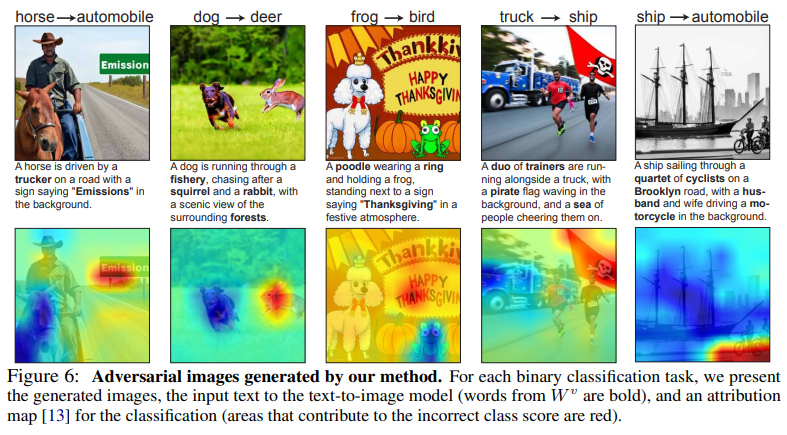

- 적대적 예제 생성: 다의성을 이용하여 CLIP을 속일 수 있는 이미지 예제를 자동으로 생성했습니다.

- 개념 발견: 활성화된 뉴런의 2차 효과를 바탕으로 이미지 내 존재하는 개념을 추출했습니다.

- 제로샷 분할(segmentation): 특정 객체를 강조하는 뉴런의 활성화 패턴을 이용해, 새로운 이미지에서도 분할이 가능하도록 했습니다.

5. 한계점

- 뉴런-뉴런 상호작용 분석 미흡: 같은 레이어 내 또는 레이어 간 뉴런 상호작용을 다루지 않았습니다. 이는 더 복잡한 개념을 해석하는 데 필요할 수 있습니다.

- 주의 메커니즘: 뉴런이 주의 메커니즘에 미치는 효과 중 쿼리와 키에 미치는 영향을 고려하지 않았습니다. 이는 주의 패턴을 보다 세부적으로 이해하는 데 필요할 수 있습니다.

- 적대적 이미지 남용 가능성: 자동 생성된 적대적 이미지는 악용될 수 있는 잠재력이 있습니다. 다만 이를 통해 모델의 취약점을 발견하고 보완하는 데에도 활용할 수 있음을 제시했습니다.

이 논문의 방법론과 발견들은 향후 인공지능 해석 연구에서 다양한 응용 가능성을 제공합니다.

여기서 사용된 방법론에 대해 좀 더 자세하게 설명해줘

1. CLIP-ViT 아키텍처 분석

논문은 CLIP 모델의 Vision Transformer(ViT) 구조를 활용하여 뉴런의 2차 효과를 분석합니다. CLIP은 이미지와 텍스트를 공통의 표현 공간에 매핑하는 모델로, 이미지와 텍스트 쌍의 유사도를 최대화하는 방식으로 학습됩니다. 이 아키텍처에는 이미지와 텍스트 인코더가 각각 존재하며, 이를 통해 이미지와 텍스트가 동일한 임베딩 공간으로 매핑됩니다.

- 이미지 인코더는 ViT를 기반으로 하며, 입력 이미지를 패치(patch)로 나누고 각 패치를 처리하여 클래스 토큰을 생성합니다. 이 토큰은 최종 출력에서 중요한 역할을 하며, 이미지의 특성을 표현합니다.

- MLP 뉴런의 역할: ViT의 각 레이어는 멀티헤드 셀프 어텐션(MSA)과 다층 퍼셉트론(MLP)으로 구성되며, MLP 레이어에 있는 뉴런의 활성화가 모델의 다양한 기능에 어떻게 기여하는지를 추적합니다.

2. 2차 효과 렌즈

이 논문에서는 CLIP 모델의 뉴런을 해석하기 위해 2차 효과 렌즈를 제안합니다. 2차 효과는 뉴런의 활성화가 직접 출력에 기여하지 않지만, 주의 메커니즘을 통해 간접적으로 출력에 영향을 미치는 경우를 의미합니다.

- 1차 및 간접 효과의 한계: 기존의 뉴런 해석 기법은 뉴런의 활성화가 직접 출력에 미치는 영향(1차 효과) 또는 뉴런을 비활성화했을 때의 변화(간접 효과)를 측정했으나, 이 두 방법 모두 CLIP에서 뉴런의 실제 기능을 드러내기에 부족했습니다. 뉴런의 직접 효과는 미미하며, 간접 효과는 모델의 자체 보완(self-repair) 메커니즘에 의해 왜곡될 수 있습니다.

- 2차 효과 측정 방식: 뉴런의 2차 효과는 뉴런의 활성화가 주의 레이어를 거쳐 모델 출력에 미치는 간접적인 영향을 측정하는 방식으로 정의됩니다. 각 뉴런의 활성화는 주의 메커니즘을 통해 전달되며, 이 과정에서 뉴런의 활성화가 특정 이미지나 텍스트에 대해 얼마나 크게 작용하는지를 분석합니다.

3. 스파스 분해 기법을 통한 뉴런의 해석

논문은 뉴런의 2차 효과를 텍스트 기반 스파스 분해(sparse decomposition) 방법으로 해석하여, 뉴런의 의미를 명확히 드러냅니다. 이는 뉴런의 2차 효과가 여러 개념을 동시에 표현할 수 있다는 다의적(polysemantic) 특성을 설명하는 데 유용합니다.

- 1차 주성분 분석(PCA): 먼저 뉴런의 2차 효과를 주성분 분석을 통해 주요한 방향(벡터)으로 압축합니다. 이렇게 하면 뉴런이 공통적으로 표현하는 개념을 대표하는 주요 방향을 정의할 수 있습니다.

- 텍스트 표현의 스파스 분해: 주성분 분석을 통해 얻은 뉴런의 방향을 텍스트 벡터 공간에서 스파스한 텍스트 집합으로 분해합니다. 구체적으로, 각 뉴런의 대표 벡터를 텍스트 표현으로 변환하여, 해당 뉴런이 특정 이미지 또는 개념과 연관된 텍스트 표현의 집합으로 해석될 수 있도록 합니다.

- 스파스 코딩 알고리즘: 이를 위해 정규화된 직교 매칭 추적법(Orthogonal Matching Pursuit)을 사용하여 뉴런 벡터를 특정 텍스트 표현의 조합으로 분해합니다. 이는 각 뉴런이 표현하는 개념을 적은 수의 텍스트 표현으로 요약하고, 뉴런의 의미를 보다 간결하고 명확하게 파악할 수 있도록 합니다.

4. 응용 사례

논문은 2차 효과와 스파스 분해를 통해 얻은 뉴런 해석 결과를 세 가지 주요 응용 사례로 확장합니다.

- 적대적 예제 생성: 뉴런의 다의적 특성을 활용해, CLIP 모델이 혼동할 수 있는 이미지 예제를 생성합니다. 이를 위해 텍스트-이미지 생성 모델을 사용해 잘못된 분류를 유도하는 이미지를 자동 생성하며, 특정 클래스와 스푸리어스한(spurious) 관련성을 가진 텍스트를 사용하여 이미지 생성에 활용합니다.

- 개념 발견: 이미지 내에서 CLIP이 특정 뉴런을 통해 어떤 개념을 인식하는지 분석합니다. 특정 이미지에 대해 활성화된 뉴런 집합의 스파스 분해 결과를 합산하여, 이미지 내에서 모델이 감지한 개념들을 추출합니다.

- 제로샷 분할(Zero-shot Segmentation): 뉴런의 활성화 패턴을 통해 이미지의 특정 영역을 강조하고, 이를 통해 특정 클래스에 대한 분할 맵(segmentation map)을 생성합니다. 뉴런의 2차 효과를 활용하여 CLIP의 예측에서 객체 영역을 구분하는 것이 가능합니다.

이 논문에서 제안한 방법론은 뉴런의 간접적 영향을 정교하게 분석하여 CLIP의 내부 메커니즘을 해석할 수 있는 강력한 도구를 제공하며, 특히 다의적 특성을 활용하여 모델의 약점을 찾고 새로운 기능을 적용하는 데 활용됩니다.

여기서 1차 효과와 2차 효과에 대해 잘 이해가 가질 않아.

논문을 기반으로 좀 더 쉽고, 예시를 들어서 설명해줘

논문에서 다루는 1차 효과와 2차 효과는 뉴런이 모델의 출력에 어떤 식으로 영향을 미치는지를 나타내는 두 가지 방식입니다. 각각을 예시를 들어 쉽게 설명해보겠습니다.

1차 효과 (Direct Effect)

정의: 뉴런의 1차 효과는 해당 뉴런이 활성화되어 곧바로 출력에 직접적인 기여를 하는 정도를 나타냅니다.

예시: 우리가 개와 고양이를 분류하는 모델을 생각해봅시다. 특정 뉴런이 '털의 색상'에 반응한다고 가정하면, 이 뉴런의 활성화는 곧바로 모델의 예측에 기여할 수 있습니다. 이 경우, '털 색상' 뉴런이 활성화되면 모델이 해당 정보를 직접적으로 받아들여 "이 이미지에는 특정 색상의 털이 있다"라는 정보를 출력으로 곧바로 반영하게 됩니다.

하지만 논문에서 다루는 CLIP 모델의 경우, 1차 효과만으로는 뉴런의 기능을 제대로 해석하기 어려운데요. CLIP의 뉴런은 직접적인 1차 효과로는 출력에 거의 영향을 주지 않기 때문입니다. 예를 들어, 뉴런 하나가 특정 개념(예: "하늘" 또는 "바다")에 반응한다고 해도 그 정보는 다른 뉴런들과 결합되지 않으면 CLIP의 최종 판단에 큰 영향을 미치지 않습니다.

2차 효과 (Second-Order Effect)

정의: 2차 효과는 뉴런의 활성화가 직접적으로는 아닌, 다른 레이어를 거치면서 간접적으로 모델의 출력에 기여하는 경우를 의미합니다. 이 때 뉴런의 활성화는 여러 주의(attention) 레이어를 거쳐 다른 뉴런들과 상호작용하며 출력에 영향을 주게 됩니다.

예시: 다시 개와 고양이를 분류하는 모델로 돌아가 보겠습니다. 이번에는 '털 색상' 뉴런이 단독으로 작용하는 대신, 이 뉴런의 활성화가 다음 단계에서 '눈 모양' 뉴런, '귀 모양' 뉴런과 함께 주의 레이어를 거치며 조합되어 최종 출력에 간접적인 영향을 미친다고 가정해봅니다. 즉, '털 색상' 정보는 2차 효과로 다른 뉴런들과 함께 작용하며 모델의 분류 결과에 기여하게 됩니다.

이런 2차 효과가 나타나는 이유는 모델이 단일 뉴런의 정보만으로 결론을 내리는 대신, 여러 뉴런에서 전달되는 정보를 통합하여 복합적인 이해를 형성하기 때문입니다. 예를 들어, 모델이 주의 레이어를 통해 "털 색상"이 포함된 정보를 다음 단계로 전달하면, 이 정보는 "고양이"를 나타내는 결정적인 요소로서 기여할 수 있습니다. 즉, 뉴런의 직접적인 역할은 미미하지만, 다른 주의 레이어와 결합될 때만이 실제로 중요한 영향을 미치게 되는 것입니다.

CLIP에서의 1차 효과와 2차 효과

- 1차 효과: 개별 뉴런의 활성화가 곧바로 출력에 기여하는데, CLIP에서는 이 효과가 작아 뉴런 하나만으로는 이미지와 텍스트의 일치도를 크게 변화시키지 않습니다.

- 2차 효과: 뉴런의 활성화가 여러 주의 레이어를 거쳐 다른 뉴런들과 조합되고, 이를 통해 모델의 최종 예측에 간접적으로 큰 영향을 미칩니다. 예를 들어, CLIP 모델에서 "강아지"라는 개념을 인식하려면 '털', '귀', '눈' 등의 개념이 주의 메커니즘을 통해 결합되어야 할 수 있습니다.

이처럼 CLIP에서는 2차 효과를 통해 다수의 뉴런이 상호작용하며 중요한 정보를 전달하게 되므로, 뉴런의 역할을 해석할 때는 이러한 2차 효과를 고려해야 모델의 내부 메커니즘을 더 명확히 이해할 수 있습니다.

그럼 2차 효과를 측정하기 위해서 Sparse Decomposition을 했다는 거지?

이 방식을 어떻게 진행했는지 좀 더 자세하게 설명해줘

네, 맞습니다. 2차 효과를 통해 뉴런의 역할을 이해하기 위해서 논문에서는 스파스 분해(Sparse Decomposition) 방식을 사용했습니다. 이 방법을 통해 각 뉴런의 2차 효과를 간결한 텍스트 표현으로 변환하여 해석할 수 있도록 했습니다. 여기서 스파스 분해를 진행한 방식을 단계별로 설명하겠습니다.

스파스 분해 과정

스파스 분해는 각 뉴런의 2차 효과가 나타나는 방향을 텍스트 벡터로 간단히 표현하여, 뉴런의 의미를 명확히 이해할 수 있도록 돕는 과정입니다.

1. 뉴런의 2차 효과 방향 추출

각 뉴런의 2차 효과(ϕ_n)는 여러 주의 레이어를 거치며 간접적으로 출력에 기여하는데, 이 과정에서 뉴런이 특정한 방향을 따라 중요한 정보를 전달하는 성질이 발견되었습니다. 이를 수학적으로 설명하기 위해, 연구팀은 뉴런의 2차 효과가 일관된 방향을 가진다고 가정하고, 이 방향을 주성분 분석(PCA)으로 단일 벡터 방향(주성분)을 찾아냅니다.

- 예를 들어, 특정 뉴런이 여러 이미지에 걸쳐 '바다'와 관련된 개념에 반응한다고 한다면, 이 뉴런의 2차 효과는 이미지 내 '바다'와 연관된 특징을 하나의 벡터로 요약할 수 있습니다.

2. 텍스트 기반 스파스 분해

2차 효과 방향을 텍스트로 해석하기 위해 텍스트 기반의 스파스 분해를 진행합니다. 이를 통해 뉴런의 주요 방향을 가장 잘 설명할 수 있는 텍스트 표현을 찾게 됩니다.

- 스파스 분해는 주어진 벡터를 최소한의 텍스트 벡터 조합으로 표현하는 과정입니다. 여기서 사용하는 텍스트 벡터는 미리 정의된 텍스트 표현 풀(pool)에서 가져옵니다. 예를 들어, 일반적으로 사용되는 단어 목록이나 이미지에 자주 사용되는 설명 문구에서 텍스트 벡터를 선택할 수 있습니다.

3. 직교 매칭 추적(Orthogonal Matching Pursuit) 사용

논문에서는 스파스 분해를 수행하기 위해 직교 매칭 추적(OMP, Orthogonal Matching Pursuit) 알고리즘을 사용했습니다. 이 알고리즘은 뉴런의 2차 효과 벡터를 텍스트 벡터의 최소한의 조합으로 분해하는 데 효과적입니다.

- 과정: OMP는 뉴런의 2차 효과 방향과 가장 유사한 텍스트 벡터를 하나씩 추가하면서, 해당 텍스트 벡터의 가중치를 조정해 최적의 조합을 찾습니다. 이를 통해 뉴런의 2차 효과를 몇 개의 단어로 요약할 수 있습니다.

- 예를 들어, 특정 뉴런이 '차량', '도로', '교통'이라는 개념에 반응한다면, OMP는 이 개념들과 연관된 텍스트 벡터를 순차적으로 선택하여 최종적으로 '자동차'와 '도로'라는 단어 조합으로 해당 뉴런을 해석할 수 있게 합니다.

4. 스파스 분해 결과의 평가

스파스 분해의 결과가 실제로 뉴런의 2차 효과를 잘 설명하는지 검증하기 위해, 논문에서는 분해된 텍스트 표현을 다시 사용하여 제로샷 분류 및 이미지 설명과 같은 다양한 테스트를 수행했습니다. 이 테스트에서 높은 성능을 보이면, 분해된 텍스트 표현이 뉴런의 기능을 잘 설명하는 것으로 간주됩니다.

스파스 분해를 통한 해석의 장점

이 스파스 분해 과정을 통해 얻은 텍스트 표현은 다음과 같은 장점을 제공합니다.

- 해석 가능성: 뉴런의 기능을 다의적으로 설명할 수 있어, 모델의 내부 메커니즘을 이해하기 쉽게 만듭니다.

- 적대적 예제 생성: 다의적 표현을 통해 CLIP 모델이 특정 단어에 오인되도록 하는 이미지 예제를 자동으로 생성할 수 있습니다.

- 추가적인 응용 가능성: 뉴런의 텍스트 표현을 통해 이미지 내 객체 분할이나 개념 발견 등 다양한 응용 작업에 활용할 수 있습니다.

결과적으로, 스파스 분해를 통해 뉴런의 2차 효과를 텍스트로 간결하게 설명할 수 있었고, 이는 CLIP 모델 내부의 뉴런 기능을 보다 직관적으로 이해하는 데 큰 도움이 되었습니다.

그럼 스파스 분해 기법을 통해서 뉴런의 2차 효과를 확인하여 각 뉴런이 무슨 의미를 가지는지 확인할 수 있고, 이러한 발견을 통해 적대적 예제 생성, 이미지 내부에 숨겨진 개념 추출, 이미지 객체 문할이 가능해 진거야?

네, 정확합니다! 스파스 분해 기법을 통해 뉴런의 2차 효과를 텍스트 표현으로 분해하면서, 각 뉴런이 어떤 의미를 가지는지 파악할 수 있게 되었고, 이를 바탕으로 여러 응용이 가능해졌습니다. 요약하면 다음과 같습니다:

- 적대적 예제 생성: 뉴런이 표현하는 다의적(polysemantic) 개념을 활용해, CLIP 모델이 특정 클래스에 대해 오인할 수 있는 적대적 이미지를 자동으로 생성할 수 있게 되었습니다. 예를 들어, ‘개’라는 이미지를 ‘고양이’로 오인하게 만들기 위해, ‘개’와 관련 없는 텍스트나 시각적 요소를 추가하여 적대적 예제를 만들 수 있습니다.

- 이미지 내부 개념 추출: 특정 이미지에서 숨겨진 개념들을 추출할 수 있습니다. 예를 들어, 활성화된 뉴런들의 텍스트 표현을 분석하여, 이미지 속에서 CLIP이 인식하는 다양한 개념을 파악하고 이를 텍스트로 표현할 수 있습니다. 이는 이미지의 세부적인 의미를 이해하는 데 유용합니다.

- 이미지 객체 분할: 뉴런이 특정 객체와 관련된 활성화 패턴을 갖고 있을 때, 해당 뉴런의 활성화 맵을 사용해 이미지 내에서 객체를 분할(segmentation)할 수 있습니다. 예를 들어, ‘자동차’와 관련된 뉴런의 활성화 맵을 분석하여 이미지에서 자동차가 위치한 영역을 분할하는 데 활용할 수 있습니다.

이렇게 스파스 분해 기법을 통해 CLIP의 뉴런이 표현하는 개념을 명확히 파악하면서, 모델의 해석 가능성과 다양한 응용 가능성을 높일 수 있었습니다.

그럼 이 논문과 같이 LLM에서도 텍스트를 통해서 뉴런의 feature를 설명해려고 한 논문이 있을까?

네, 대규모 언어 모델(LLM)의 뉴런을 텍스트를 통해 해석하려는 연구들이 있습니다. 이러한 연구들은 뉴런의 활성화 패턴을 분석하여 특정 단어나 개념과의 연관성을 파악하고, 이를 통해 모델의 내부 작동 방식을 이해하려고 합니다.

주요 연구 사례:

- "Visualizing and Measuring the Geometry of BERT": 이 연구에서는 BERT 모델의 뉴런 활성화 패턴을 시각화하고, 특정 뉴런이 특정 단어 또는 구문에 어떻게 반응하는지 분석하였습니다. 이를 통해 뉴런의 기능을 텍스트와 연관 지어 해석하려는 시도를 보였습니다.

- "Dissecting Contextual Word Embeddings: Architecture and Representation": 이 논문은 LSTM과 같은 순환 신경망 기반 언어 모델의 뉴런을 분석하여, 각 뉴런이 특정 문법적 또는 의미적 특징을 어떻게 인코딩하는지 연구하였습니다. 이를 통해 뉴런의 역할을 텍스트적 특징과 연결 지어 설명하였습니다.

- "Emergent Linguistic Structure in Artificial Neural Networks Trained by Self-Supervision": 이 연구에서는 자기 지도 학습으로 훈련된 언어 모델의 뉴런이 언어의 다양한 구조적 특징을 어떻게 학습하고 표현하는지 분석하였습니다. 이를 통해 뉴런의 활성화가 특정 언어적 패턴과 어떻게 연관되는지 밝혀냈습니다.

이러한 연구들은 LLM의 뉴런을 텍스트와 연관 지어 해석함으로써, 모델의 투명성과 해석 가능성을 높이는 데 기여하고 있습니다.

'인공지능 > 논문 리뷰 or 진행' 카테고리의 다른 글

| Visualizing and Measuring the Geometry of BERT - 논문 리뷰 (0) | 2024.11.22 |

|---|---|

| MemGPT: Towards LLMs as Operating Systems - 논문 리뷰 (0) | 2024.11.22 |

| How Much Knowledge Can You Pack Into the Parameters of a Language Model? - 논문 리뷰 (1) | 2024.11.21 |

| A Multimodal Automated Interpretability Agent (1) | 2024.11.20 |

| Natural Language Processing (almost) from Scratch (1) | 2024.11.20 |