https://arxiv.org/abs/2401.12874

From Understanding to Utilization: A Survey on Explainability for Large Language Models

Explainability for Large Language Models (LLMs) is a critical yet challenging aspect of natural language processing. As LLMs are increasingly integral to diverse applications, their "black-box" nature sparks significant concerns regarding transparency and

arxiv.org

1. 문제 정의:

대형 언어 모델(LLMs)은 다양한 자연어 처리 작업에서 뛰어난 성능을 보여주지만, 이러한 모델들은 종종 "블랙박스"로 인식되어 그 내부 동작이 명확하지 않습니다. 특히, 모델이 비윤리적이거나 해로운 내용을 생성할 가능성, 편향된 결과를 유발할 위험성 등이 문제가 됩니다. 따라서, 이 논문은 LLM의 투명성 및 설명 가능성을 향상시키기 위한 방법론들을 제안하고, 이를 활용해 모델의 신뢰성 및 윤리적 사용을 개선하는 것이 목표입니다.

2. 시도한 방법:

논문에서는 LLMs의 설명 가능성을 높이기 위해 로컬 분석과 글로벌 분석이라는 두 가지 주요 방법론을 제시합니다. 각 방법은 모델 내부의 작동 원리를 설명하고자 하는 목적에 맞춰 구체화되었습니다.

- 로컬 분석: 개별 입력에 대해 모델이 어떻게 예측을 수행하는지 설명하는 방식입니다. 여기에는 특성 귀속 분석과 트랜스포머 블록 분석이 포함됩니다.

- 글로벌 분석: 모델 전체의 지식이나 언어적 특성을 이해하는 데 초점을 맞추며, 탐색 기반 방법과 기계적 해석 가능성을 포함합니다.

3. 사용한 방법:

- 특성 귀속 설명: 입력 토큰들이 예측 결과에 얼마나 기여했는지 점수를 부여하는 방법입니다. 이 방법은 퍼트베이션 기반 방법(입력 변형 후 결과를 비교)과 그래디언트 기반 방법(모델 출력에 대한 각 토큰의 기여도를 그래디언트를 통해 계산), 그리고 벡터 기반 방법으로 나눌 수 있습니다.

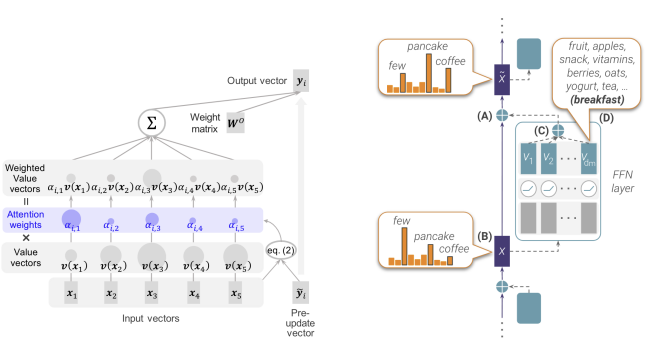

- 트랜스포머 블록 분석: 트랜스포머 블록의 내부 처리를 추적해 모델이 예측을 생성하는 메커니즘을 분석하는 방식입니다. 각 레이어의 멀티 헤드 자기 주의(MHSA) 및 MLP 서브레이어의 역할을 분석합니다.

4. 연구 결과:

- 로컬 분석: 로컬 설명 방법들은 특정 입력에 대한 모델의 예측이 어떻게 이루어지는지 명확하게 설명할 수 있었습니다. 특히, 그래디언트 기반 방법은 모델의 특정 상태에서 발생하는 변화에 대한 유용한 정보를 제공합니다.

- 글로벌 분석: 글로벌 분석에서는 모델이 학습한 지식과 내부 표현을 조사해 모델의 일반적인 동작 방식을 이해할 수 있었습니다. 예를 들어, 탐색 기반 방법은 모델이 가지고 있는 배경 지식을 추출하는 데 유용하며, 기계적 해석 가능성은 모델 내부 회로를 역설계하여 학습 알고리즘을 분석하는 데 사용되었습니다.

5. 한계점:

- 복잡성 문제: 매우 큰 모델의 경우 설명 가능성을 높이기 위한 기존의 방법들이 효율성이 떨어질 수 있으며, 정확한 설명을 도출하는 데 한계가 있었습니다.

- 계산 비용: 설명을 위한 분석은 대부분의 경우 상당한 계산 비용을 요구하며, 이는 대규모 LLMs에 적용할 때 비효율적일 수 있습니다.

- 편향성 문제 해결: 모델이 보유한 편향성이나 비윤리적인 내용을 해결하는 방법은 여전히 한정적이며, 추가적인 연구가 필요합니다.

주요 계산식:

- 벡터 기반 특성 귀속:이는 각 입력 토큰 xli에 대한 기여도를 나타내며, 이를 통해 특정 예측에 대한 기여를 분석할 수 있습니다.

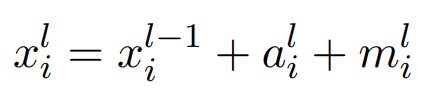

- 트랜스포머 블록에서의 처리 과정:

여기서 ali는 주의 메커니즘의 출력, mli는 MLP 서브레이어의 출력을 나타냅니다.

이 논문은 대형 언어 모델의 설명 가능성을 다각도로 탐구하며, 모델 성능 향상과 윤리적 문제 해결에 중요한 시사점을 제공합니다.

여기서 무슨 방법을 한건지, 무엇을 의도한 것인지, 결과가 어떤 것인지 명확하게 이해가 안가네

좀 더 자세하게 설명해줘

논문의 주요 목표는 대형 언어 모델(LLM)의 설명 가능성을 높이는 것이며, 이를 통해 모델의 투명성을 확보하고 신뢰성을 개선하는 것입니다. 이를 달성하기 위해 두 가지 주요 방법론이 제시되었으며, 각각의 방법론과 의도된 목적, 결과에 대해 더 자세히 설명하겠습니다.

1. 문제 해결을 위한 의도

대형 언어 모델은 성능은 뛰어나지만, 내부가 복잡하여 "블랙박스"처럼 작동하는 경향이 있습니다. 이는 왜 특정한 예측을 내렸는지, 또는 어떻게 학습된 지식이 내재되어 있는지 이해하는 데 한계를 주며, 이러한 투명성 부족은 신뢰성 문제를 야기할 수 있습니다. 특히, 이러한 모델이 생성하는 내용이 때로는 편향적이거나 비윤리적일 가능성도 있기 때문에 설명 가능성은 매우 중요한 연구 주제입니다. 이 논문은 모델이 내리는 결정을 더 잘 이해하고 제어할 수 있도록 하기 위해 LLM의 내부 구조를 설명하는 방법론을 탐구하는 것을 목적으로 합니다.

2. 사용된 방법론

논문에서는 로컬 분석(Local Analysis)과 글로벌 분석(Global Analysis)라는 두 가지 설명 방법론을 제시했습니다. 각 방법은 모델의 특정 측면을 더 잘 이해하기 위한 도구로 활용됩니다.

2.1. 로컬 분석

로컬 분석은 모델이 개별 입력에 대해 어떻게 예측을 수행하는지 설명하는 방법입니다. 즉, 특정 입력에 대해 모델이 어떤 결정을 내렸는지 그 과정에 대한 설명을 제공합니다. 이를 통해 모델의 각각의 입력 토큰이 예측에 얼마나 기여했는지를 분석할 수 있습니다. 여기에는 몇 가지 방법이 포함됩니다:

- 특성 귀속 설명 (Feature Attribution Explanation):

- 퍼트베이션 기반 방법(Perturbation-based methods): 입력 데이터를 일부 변형시켜 결과의 변화를 관찰하는 방식입니다. 예를 들어, LIME과 SHAP 같은 기법이 이에 해당합니다. 이 방법들은 모델 출력이 특정 입력 피처에 의해 얼마나 영향을 받는지 계산합니다.

- 그래디언트 기반 방법(Gradient-based methods): 각 입력 토큰이 모델의 출력에 미친 영향을 그래디언트를 통해 계산합니다. 예를 들어, 통합 그래디언트(Integrated Gradients, IG)는 모델의 예측 과정에서 각 입력 토큰이 얼마나 중요한지 파악할 수 있습니다.

- 벡터 기반 방법(Vector-based methods): 입력 벡터가 각 레이어에서 어떻게 변형되고, 예측에 어떤 기여를 했는지 분석합니다.

- 트랜스포머 블록 분석(Transformer Block Analysis):

- 멀티 헤드 자기 주의(MHSA)와 MLP 서브레이어의 작동 과정을 분석하여 모델이 어떻게 정보를 처리하는지 파악합니다. 예를 들어, MHSA는 입력 데이터 간의 상호작용을 학습하고, MLP 서브레이어는 이를 더 복잡한 형태로 변형해 최종 예측에 기여합니다. 이러한 과정을 통해, 모델이 어떻게 예측을 생성하는지 이해할 수 있습니다.

2.2. 글로벌 분석

글로벌 분석은 모델이 전체적으로 어떤 지식이나 언어적 특성을 학습했는지에 대해 설명합니다. 이는 모델의 내부 표현이나 학습된 지식을 조사하는 데 중점을 둡니다.

- 탐색 기반 방법(Probing-based methods):

- 이 방법은 모델이 어떤 종류의 지식을 학습했는지를 파악하기 위해 사용됩니다. 예를 들어, 모델의 중간 상태에서 의미나 문법적 지식을 탐색하는 프로브를 이용해 모델의 지식 표현을 분석합니다.

- 기계적 해석 가능성(Mechanistic Interpretability):

- 모델의 개별 뉴런이나 연결을 분석하여 모델의 동작 원리를 역설계하는 방법입니다. 이를 통해 모델이 어떤 회로를 사용해 특정 작업을 처리하는지 파악할 수 있습니다. 예를 들어, GPT-2 모델에서 간접 객체 식별(Indirect Object Identification)을 수행하는 회로를 발견한 연구가 대표적입니다. 이러한 회로 분석은 모델의 예측을 더 깊이 이해하는 데 중요한 역할을 합니다.

3. 결과

- 로컬 분석의 결과: 로컬 설명 방법은 특정 입력에 대해 모델이 어떻게 예측을 수행했는지 명확하게 설명할 수 있었습니다. 특히, 그래디언트 기반 방법은 모델의 특정 상태에서 발생하는 변화에 대한 유용한 정보를 제공했습니다. 이는 입력 토큰들이 예측에 어떻게 기여하는지를 이해하는 데 도움이 됩니다.

- 글로벌 분석의 결과: 글로벌 분석을 통해 모델이 학습한 지식이나 언어적 특성을 파악할 수 있었습니다. 특히, 탐색 기반 방법을 통해 모델이 문법적 지식이나 의미적 정보를 어떻게 처리하는지에 대한 중요한 통찰을 제공했습니다. 또한, 기계적 해석 가능성을 이용한 회로 발견은 모델의 내부 동작을 명확히 이해하는 데 기여했습니다.

4. 한계점

- 모델의 복잡성: 매우 큰 모델의 경우, 이러한 설명 방법을 적용하는 데 있어 계산 비용이 많이 들며, 모델의 복잡한 구조로 인해 일부 설명 방법들이 제한적일 수 있습니다.

- 편향 해결의 한계: 모델이 내재한 편향이나 윤리적 문제를 완전히 해결하는 데는 여전히 한계가 있으며, 이를 위한 더 많은 연구가 필요합니다.

이 논문은 LLM의 설명 가능성을 높이기 위한 다양한 방법론을 제시하며, 이를 통해 모델의 투명성과 신뢰성을 개선하는 데 기여하고자 합니다.

그럼 여기서 사용한 방법론의 타당성과 그 방법에 대한 결과를 자세하게 설명해줘

논문에서 사용한 방법론은 대형 언어 모델(LLM)의 설명 가능성을 높이고자 하는 여러 연구에서 제안된 기법들을 기반으로 하고 있습니다. 이 방법론들은 모델의 예측 과정과 내부 구조를 보다 잘 이해할 수 있도록 돕기 위해 설계되었으며, 여기서 논문에서 제시된 방법들의 타당성과 그 결과에 대해 더욱 자세히 설명하겠습니다.

1. 로컬 분석(Local Analysis)

로컬 분석은 모델이 특정 입력에 대해 어떻게 예측을 수행하는지를 분석하는 방법으로, 모델의 내부 예측 과정이 복잡한 LLM에서 매우 유용합니다. 이 방법의 타당성과 결과는 각각 다음과 같습니다.

1.1 특성 귀속 설명(Feature Attribution Explanation)

- 타당성: 특성 귀속 분석은 입력 데이터의 각 요소(예: 토큰, 단어)가 모델 예측에 얼마나 기여하는지 평가하는 데 유용합니다. 이를 통해 모델이 어떤 입력 정보에 주목하고 있는지 확인할 수 있습니다. 이는 특히 언어 모델의 해석 가능성을 높이는 데 매우 중요합니다. 예를 들어, 텍스트 분류나 감정 분석과 같은 작업에서 특정 단어가 예측에 얼마나 중요한지 확인하는 데 적합합니다.

- 결과:

- 퍼트베이션 기반 방법: 입력 데이터를 약간 변형(제거 또는 변경)한 후 결과가 어떻게 변하는지를 분석하여 모델이 중요하다고 생각하는 입력 요소를 추정할 수 있습니다. 하지만, 이 방법은 입력 요소 간의 상관관계를 무시하고 독립적인 가정하에 작동하기 때문에 실제 상황에서 복잡한 입력 데이터 구조를 충분히 반영하지 못할 수 있습니다.

- 그래디언트 기반 방법: 각 입력 토큰이 모델 출력에 미친 영향을 그래디언트로 측정하는 방식입니다. 이 방법은 계산 효율성이 뛰어나고, 모델이 어떻게 예측을 하는지 보다 직관적으로 설명할 수 있습니다. 그러나 그래디언트 기반 기법은 모델의 비선형성이나 층 간 상호작용을 모두 고려하지 못하는 경우가 있어, 모든 상황에서 완벽한 설명을 제공하지 못할 수 있습니다.

- 벡터 기반 방법: 각 레이어의 벡터 표현이 어떻게 형성되고 변형되는지에 대한 자세한 분석을 통해, 예측에 어떤 기여를 했는지 확인할 수 있습니다. 이는 모델의 각 층이 정보를 처리하는 방식에 대한 보다 세밀한 통찰을 제공할 수 있는 강력한 방법입니다. 특히, L1 노름 등의 수학적 지표를 활용해 입력 토큰이 특정 레이어에서 예측에 얼마나 기여했는지를 정량적으로 평가할 수 있습니다.

1.2 트랜스포머 블록 분석(Transformer Block Analysis)

- 타당성: 트랜스포머는 멀티 헤드 자기 주의(MHSA)와 MLP 계층으로 구성된 블록을 사용하여 입력 데이터를 처리합니다. 이를 분석하는 것은 모델의 정보 처리 방식을 깊이 이해하는 데 매우 유용합니다. 특히, 모델이 어떤 단계에서 어떤 종류의 정보를 어떻게 처리하는지 설명할 수 있기 때문에, 트랜스포머의 복잡한 구조를 설명하는 데 중요한 역할을 합니다.

- 결과:

- MHSA 서브레이어 분석: MHSA는 입력 토큰 간의 관계를 학습하는 역할을 하며, 이를 시각화하거나 그래디언트를 분석함으로써 각 토큰이 얼마나 중요한지 파악할 수 있습니다. 주의 가중치(Attention Weights)를 시각화한 연구들은 모델이 특정 단어에 집중하는 방식과 모델이 학습한 언어적 구조를 이해하는 데 도움을 줍니다. 특히, 특정 토큰 간의 상관관계를 이해하는 데 유용했습니다.

- MLP 서브레이어 분석: MLP는 비선형 변환을 통해 입력 데이터를 처리하며, 특히 키-값 메모리 구조로 작동하여 각 단어에 대한 개념을 생성하고 이를 예측에 반영합니다. MLP 서브레이어는 주로 텍스트의 내부 의미적 표현을 학습하는 데 기여하며, 이를 해석함으로써 모델이 어떻게 지식을 학습하고 활용하는지 더 명확히 이해할 수 있었습니다.

2. 글로벌 분석(Global Analysis)

글로벌 분석은 모델 전체의 동작 방식을 이해하고자 하며, 모델이 지식이나 언어적 특성을 어떻게 학습하고 있는지 파악하려는 목적을 가지고 있습니다.

2.1 탐색 기반 방법(Probing-based methods)

- 타당성: 탐색 기반 방법은 모델 내부의 표현을 해석하고, 이를 통해 모델이 어떤 지식을 학습하고 있는지 파악할 수 있습니다. 예를 들어, 특정 문법적 규칙이나 사실에 대한 모델의 지식을 조사하는 데 사용할 수 있습니다.

- 결과: 이 방법을 통해 모델이 단어 간의 의미적 관계나 문법적 규칙 등을 어떻게 학습하는지를 분석할 수 있었습니다. 특히, 탐색 기법을 사용하면 모델이 특정 언어적 구조를 학습하고 있음을 확인할 수 있으며, 이를 통해 모델의 내부 표현을 보다 명확하게 파악할 수 있습니다. 예를 들어, 모델의 특정 헤드가 사실적인 정보를 저장하고, 다른 헤드는 문법적 구조를 더 많이 처리하는 식으로 각 역할이 분리되는 경향이 있음을 발견했습니다.

2.2 기계적 해석 가능성(Mechanistic Interpretability)

- 타당성: 기계적 해석 가능성은 뉴런 간의 상호작용과 모델의 내부 회로를 조사하여 모델의 동작 원리를 역설계하는 것을 목표로 합니다. 이를 통해 모델의 예측 과정을 이해하고, 특정 작업을 수행하는 메커니즘을 명확히 할 수 있습니다.

- 결과: 예를 들어, GPT-2 모델의 간접 객체 식별(Indirect Object Identification, IOI) 작업을 수행하는 데 중요한 26개의 주의 헤드를 발견한 연구가 있었습니다. 이는 전체 모델의 약 1.1%에 해당하는 중요한 요소들이 특정 작업을 담당하고 있음을 보여주었으며, 모델의 복잡한 내부 동작을 해석하는 데 중요한 역할을 했습니다. 이러한 분석은 모델의 학습된 회로가 어떻게 동작하는지 명확히 하여, 더 복잡한 작업에서도 모델을 이해하고 개선할 수 있는 방향성을 제시했습니다.

3. 결론 및 타당성 평가

이 논문에서 사용된 방법론들은 대형 언어 모델의 투명성을 높이고, 모델의 예측 과정과 내부 구조를 이해하는 데 매우 유효한 방법들입니다. 로컬 분석과 글로벌 분석 모두 모델의 복잡한 동작 방식을 해석하는 데 기여하였으며, 특히 트랜스포머 블록의 내부 처리 과정을 이해하고 설명 가능성을 높이는 데 큰 도움이 되었습니다.

타당성 평가:

- 로컬 분석은 개별 예측에 대한 설명 가능성을 제공함으로써 사용자가 특정 예측이 왜 나왔는지 이해할 수 있게 도와줍니다. 이는 모델의 신뢰성을 높이는 데 큰 기여를 합니다.

- 글로벌 분석은 모델이 학습한 지식이나 구조적 정보를 조사하여 모델의 전반적인 동작 방식을 이해하는 데 유효했습니다. 이는 모델 개선과 디버깅에도 중요한 역할을 했습니다.

따라서, 이 논문에서 제시된 방법론들은 대형 언어 모델의 투명성과 해석 가능성을 높이는 데 매우 타당하며, 특히 LLM의 복잡한 내부 메커니즘을 이해하고 활용하는 데 중요한 역할을 했다고 평가할 수 있습니다.