https://arxiv.org/abs/2012.09838

Transformer Interpretability Beyond Attention Visualization

Self-attention techniques, and specifically Transformers, are dominating the field of text processing and are becoming increasingly popular in computer vision classification tasks. In order to visualize the parts of the image that led to a certain classifi

arxiv.org

이건 Visual LM인가 보네요

특정 토큰마다 중요도를 구해서 별 의미없는 토큰인데 중요도가 높게 나오거나 중요한 토큰인데 중요도가 낮게 나오는 것을 막아 성능을 증가시켰다고 하네요

Sparse Autoencoder는 학습이 필요하지만 이 모델은 학습이 필요하지 않다는 것이 좀 중요해 보입니다.

1. 해결하려는 문제

Transformer 모델은 NLP와 컴퓨터 비전에서 점점 더 중요한 역할을 하고 있지만, 이러한 모델의 결정 과정을 해석하는 방법은 여전히 미흡합니다. 기존의 방법들은 주로 attention 맵에 의존하거나, attention 그래프를 단순히 추론하는 방식으로 설명을 시도하지만, 이는 모델의 전체적인 결정 과정을 충분히 설명하지 못하고 불완전한 정보를 제공합니다. 또한, 이러한 기존 방법들은 종종 클래스에 특화되지 않거나, 많은 경우 관심 없는 토큰들을 강조하는 문제점이 있습니다.

2. 시도된 방법

기존 연구들은 attention 맵을 통해 Transformer의 해석 가능성을 시도했지만, 본 연구에서는 Deep Taylor Decomposition(DTD) 원칙을 기반으로 relevancy(중요도)를 계산하고 이를 Transformer 네트워크의 각 레이어에 걸쳐 전파하는 새로운 방법론을 제안했습니다. 이 방법은 attention 레이어뿐만 아니라 skip connection과 같은 구조적 문제들을 해결하고, 모델의 총 relevancy를 유지하면서도 클래스에 특화된 시각화를 제공하도록 설계되었습니다.

3. 사용한 방법

본 연구에서는 다음과 같은 절차를 따릅니다:

- DTD 기반 Relevance Propagation: 각 레이어에 대해 relevance 점수를 계산하고, 이는 Transformer의 attention 레이어뿐만 아니라 다른 레이어에도 적용됩니다.

- Relevance 전파: skip connection과 같은 비선형적 레이어에도 relevance를 정확하게 전파하기 위해, 새로운 normalization 규칙을 적용하여 relevance가 소멸하거나 불안정해지는 문제를 해결합니다.

- Gradient 정보 통합: attention 레이어에서 계산된 relevance와 gradient 정보를 통합하여 모델의 해석 가능성을 향상시킵니다.

4. 결과

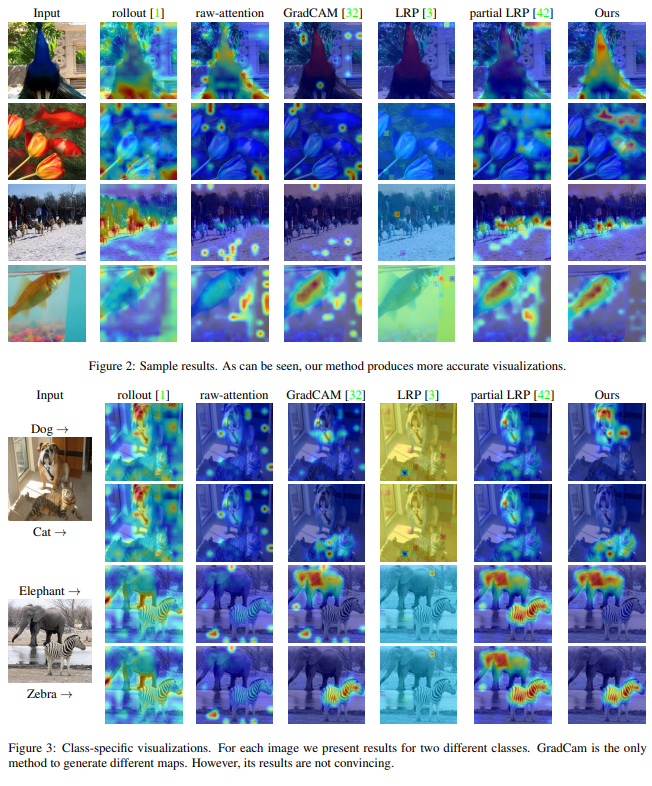

실험 결과, 제안된 방법은 컴퓨터 비전 및 NLP 작업에서 기존의 해석 가능성 방법보다 우수한 성능을 보였습니다. 특히, 이미지 분할 실험에서는 정확도와 평균 IoU, mAP 측면에서 기존 방법보다 높은 성과를 달성했으며, NLP 작업에서는 "Movie Reviews" 데이터셋에서 더 높은 F1 점수를 기록했습니다. 또한, 제안된 방법은 클래스별로 특정한 설명을 제공하여 다중 객체가 포함된 이미지에서도 더 정확한 해석을 가능하게 했습니다.

5. 한계점

이 방법은 다양한 Transformer 모델에서 효과적이었지만, 추가적인 계산 비용이 발생할 수 있으며, 특히 큰 모델이나 긴 시퀀스를 처리할 때 계산 복잡도가 증가하는 문제가 있습니다. 또한, 일부 테스트에서는 매우 복잡한 시나리오에서 기존 방법과의 차이가 크지 않을 수 있음을 보여줍니다. 추후 연구에서 더 많은 데이터셋과 작업에 대해 확장성을 테스트할 필요가 있습니다.

이 논문은 Transformer 해석 가능성 연구의 중요한 진전을 보여주며, 이를 통해 LLM 해석 연구에서도 관련성을 지닌 방법론을 탐색할 수 있습니다.

여기서 사용한 방법에 대해 자세하게 설명해줘

그리고 이 방법이 어떤 장점과 단점을 가지고 있는지도

논문에서 사용된 방법에 대한 자세한 설명

- DTD 기반 Relevance Propagation (Deep Taylor Decomposition):

- Deep Taylor Decomposition(DTD)는 네트워크가 내린 결정의 각 부분이 모델의 입력에서 얼마나 중요한지를 분해하는 방법입니다. 이 논문에서는 Transformer 모델의 각 레이어에 대해 relevancy(중요도)를 계산하기 위해 DTD를 사용합니다. 구체적으로, DTD를 통해 각 토큰이 모델의 출력에 미치는 영향을 추적하고, 이 relevancy 점수를 모델의 여러 레이어에 걸쳐 전파합니다.

- 이 방법은 Transformer의 self-attention 레이어뿐만 아니라 다른 레이어들에도 적용되며, relevancy의 총합을 각 레이어에서 유지하는 방식으로 진행됩니다. 이를 통해 모델의 내부 구조를 더 정밀하게 분석할 수 있습니다.

- Relevance 전파 (Propagation):

- Transformer 모델에는 skip connection이나 비선형적인 레이어들이 많이 존재합니다. 이러한 구조들은 relevance를 정확하게 전파하는데 어려움을 줄 수 있는데, 이 논문에서는 이를 해결하기 위해 새로운 normalization 규칙을 도입했습니다.

- 예를 들어, skip connection에서 발생하는 relevance 값의 불안정성을 해결하고, 모델 전반에서 relevancy가 제대로 유지되도록 normalization을 적용합니다. 이렇게 하면 self-attention 레이어뿐만 아니라, 다른 비선형적 레이어들에서도 relevance가 유효하게 전달될 수 있습니다.

- Gradient 정보 통합 (Integration of Gradient Information):

- 본 연구에서는 attention 레이어에서 계산된 relevancy 정보와 gradient 정보를 함께 통합하여, 모델의 결정 과정에서 양성 및 음성 기여를 구별하고 시각화를 강화합니다. gradient는 각 레이어의 중요도를 나타내는 추가적인 신호로 활용되어, 최종적으로 Transformer 모델에서 각 토큰이 어떻게 상호작용하여 특정한 출력을 생성했는지에 대한 명확한 해석을 제공합니다.

- 이를 통해 클래스에 특화된 시각화가 가능해지며, 기존의 attention만 사용하는 방법보다 더 정교하고 정확한 설명을 제공합니다.

장점

- 클래스 특화 시각화: 제안된 방법은 클래스별로 특정한 설명을 제공할 수 있어, 다중 클래스 또는 다중 객체가 포함된 입력에서 각 클래스나 객체의 기여도를 명확하게 시각화할 수 있습니다.

- 더 나은 해석 가능성: 기존의 단순한 attention 맵 기반의 시각화보다, DTD 기반으로 relevance를 계산하고 이를 전파함으로써, 모델의 결정 과정에서 중요하게 작용한 부분을 더 정확하게 포착할 수 있습니다.

- 비선형 구조 지원: skip connection이나 비선형적인 레이어에서도 relevance를 효과적으로 전파할 수 있어, Transformer 모델의 복잡한 구조에서도 적용이 가능합니다.

- 양성/음성 기여 구분: gradient 정보를 통합하여 양성(positive)과 음성(negative) 기여도를 구별할 수 있으므로, 더 정교한 해석이 가능합니다.

단점

- 계산 복잡도: relevance 전파와 gradient 정보를 통합하는 과정에서 추가적인 계산 비용이 발생할 수 있습니다. 특히, 매우 큰 Transformer 모델이나 긴 시퀀스를 처리할 때 이 계산 복잡도는 더 커질 수 있습니다.

- 적용성 제한: 이 방법은 특정한 유형의 모델이나 작업에 최적화되어 있으며, 다른 유형의 모델에서 동일한 성능을 발휘하지 않을 수 있습니다. 특히, 본 연구에서 다루지 않은 더 복잡한 시나리오에서는 기존 방법과의 성능 차이가 크지 않을 가능성도 있습니다.

- 다양한 작업에 대한 확장성: 연구에서 제시된 실험이 이미지 분류와 NLP 작업에 한정되어 있기 때문에, 더 다양한 데이터셋이나 과업에 적용할 때 이 방법이 얼마나 효과적인지 추가적인 연구가 필요합니다.

이 방법은 Transformer 모델의 결정 과정을 보다 정교하게 해석하는데 도움을 주며, 특히 NLP와 컴퓨터 비전에서의 모델 해석 연구에 유용한 방법론이 될 수 있습니다.

그럼 여기서 DTD는 어떻게 구하는거야??

그리고 DTD를 통해서 어떤 토큰이 출력에 가장 큰 영향을 끼쳤나 확인하는 거야?

DTD (Deep Taylor Decomposition)의 구체적 과정

DTD는 Deep Taylor Decomposition의 약자로, 각 토큰이 출력에 기여하는 정도를 수학적으로 분해하는 방식입니다. 이를 통해 모델이 내린 결정의 중요도를 계산합니다. Transformer 모델에서 DTD를 통해 relevancy를 계산하는 방법은 다음과 같습니다:

- Relevance 초기화:

- DTD는 먼저 네트워크의 출력 레이어에서 시작하여 relevance를 역전파합니다. 예를 들어, 모델이 특정 클래스에 대한 예측을 할 때, 그 클래스에 대한 relevance를 1로 설정하고, 다른 클래스는 0으로 설정하여 역전파를 시작합니다.

- 이 relevance는 모델의 모든 레이어를 통과하며, 마지막에는 입력 토큰 각각에 대한 relevance 점수를 얻게 됩니다.

- Relevance 전파:

- 각 레이어에서 relevance를 전파할 때, 각 입력 토큰이 다음 레이어에서 출력에 미친 영향을 계산합니다. 구체적으로는, 각 레이어에서 입력 토큰과 출력 사이의 기여도를 Taylor Series(테일러 급수)를 이용해 수학적으로 분해합니다.

- 이 과정에서 기울기(gradient)와 같은 정보를 활용해, 각 토큰의 relevance가 어떻게 변하는지 추적합니다. 즉, 모델이 예측한 클래스에 가장 큰 영향을 미친 입력 토큰을 찾아냅니다.

- ReLU 기반 비선형 처리:

- Transformer 모델은 비선형 활성화 함수(ReLU, GELU 등)를 사용하기 때문에, 이를 처리하기 위한 방법도 DTD에서 다룹니다. 예를 들어, ReLU는 음수 값을 모두 0으로 만들기 때문에, relevance가 음수일 경우 그 값을 전파하지 않고, 양수 부분만 남기면서 relevance를 계산합니다.

- 이를 통해 각 레이어에서 relevance의 총합을 유지하며 전파하게 됩니다.

- Self-Attention에서의 Relevance 분해:

- Transformer의 Self-Attention 메커니즘에서는 각 토큰이 다른 모든 토큰과 상호작용하며 attention 값을 계산합니다. DTD는 이 과정에서 각 토큰의 relevance가 self-attention 레이어를 통해 어떻게 전달되고 변하는지를 계산합니다. 여기서 각 토큰의 쿼리(Query), 키(Key), 값(Value) 벡터 간의 내적을 기반으로 relevancy를 분해하고 전파합니다.

- 이를 통해 각 토큰이 최종 예측에 미친 영향을 추적할 수 있습니다.

DTD로 출력에 영향을 미친 토큰 확인 방법

DTD의 최종 목표는 각 입력 토큰이 모델의 출력에 얼마나 큰 영향을 미쳤는지, 즉 relevancy score를 계산하는 것입니다. 이 relevancy score를 사용하여 다음과 같은 방식으로 특정 토큰이 출력에 얼마나 기여했는지 확인할 수 있습니다:

- Relevance Score 기반 영향도 분석:

- 모델이 예측을 완료한 후, 각 입력 토큰에 대해 relevancy score가 계산됩니다. 이 점수는 해당 토큰이 예측 결과에 얼마나 중요한 역할을 했는지를 나타냅니다.

- 예를 들어, 한 문장에서 "긍정적인" 감정 분석을 할 때, 긍정적인 의미를 가진 단어들(예: "좋다", "행복하다")이 높은 relevance score를 가지게 됩니다. 이는 해당 단어들이 최종 예측에 큰 영향을 미쳤음을 나타냅니다.

- Relevance Score 시각화:

- DTD를 통해 얻은 relevancy score를 기반으로 시각화할 수 있습니다. 예를 들어, 이미지 분류 작업에서는 이미지의 특정 부분이 모델의 예측에 얼마나 기여했는지 시각적으로 표현할 수 있고, 텍스트 분류 작업에서는 텍스트 내 특정 단어가 예측에 얼마나 기여했는지를 시각화할 수 있습니다.

- 이를 통해 모델이 예측할 때 어떤 정보에 의존했는지를 쉽게 확인할 수 있습니다.

장점과 단점

장점:

- 정밀한 분석: DTD는 모델의 모든 레이어를 고려하여 relevance를 전파하기 때문에, 어떤 토큰이 출력에 가장 큰 영향을 미쳤는지에 대해 정확한 정보를 제공합니다.

- Self-Attention 메커니즘의 분석: DTD는 self-attention 레이어에서 각 토큰 간의 상호작용을 분석할 수 있어, Transformer 모델의 복잡한 구조도 해석 가능합니다.

- 클래스 특화 분석: DTD는 특정 클래스에 대해 relevance를 계산할 수 있어, 다중 클래스 작업에서도 각 클래스별로 중요한 토큰을 명확하게 구분할 수 있습니다.

단점:

- 계산 복잡도: relevance 전파 과정에서 추가적인 계산이 필요하기 때문에, 특히 큰 모델이나 긴 입력 시퀀스에 대해 적용할 때 계산 비용이 큽니다.

- 특정 모델에 최적화: DTD는 Transformer 모델에 최적화된 방법이기 때문에, 다른 유형의 모델이나 구조에서는 직접적인 적용이 어려울 수 있습니다.

결론적으로, DTD는 Transformer 모델의 출력에 영향을 미친 주요 토큰을 찾아내는 데 매우 유용한 방법이며, 이를 통해 모델의 해석 가능성을 크게 향상시킬 수 있습니다.

그런데 이런 해석 방법을 통해 LLM의 평가 데이터셋에서 어떻게 성능을 높인거야?

DTD 기반 해석 방법을 통해 LLM(Large Language Models)의 평가 데이터셋에서 성능을 높인 과정은 모델의 해석 가능성을 바탕으로 모델의 학습 및 예측 성능을 개선한 데 있습니다. 구체적으로, 해석 방법을 통해 LLM의 성능을 높이는 과정은 다음과 같이 이루어집니다.

1. 모델의 신뢰성 및 투명성 향상

DTD와 같은 해석 방법을 통해 LLM의 각 예측이 왜 이루어졌는지를 명확히 설명할 수 있습니다. 이는 모델이 어떤 패턴에 의존해서 답변을 생성하는지, 혹은 어떤 부분이 잘못된 예측으로 이어졌는지를 이해하는 데 큰 도움이 됩니다. 해석 가능한 모델을 통해 다음과 같은 장점이 성능 향상으로 이어집니다:

- 잘못된 학습 패턴 파악: LLM이 특정 잘못된 패턴에 너무 의존하여 학습되었을 때, DTD를 통해 그 원인을 밝혀내고, 불필요하거나 왜곡된 패턴을 수정할 수 있습니다. 예를 들어, 불필요한 토큰들이 너무 많은 relevance를 갖는다면, 이를 통해 모델이 불필요한 정보에 의존하지 않도록 개선할 수 있습니다.

- 바이어스(편향) 제거: LLM이 특정 바이어스(예: 인종, 성별, 지역)에 의해 영향을 받는 경우, 해석 방법을 통해 그러한 바이어스가 발생한 이유를 파악할 수 있습니다. 바이어스가 확인되면, 이를 수정함으로써 더 공정하고 성능이 높은 모델을 만들 수 있습니다.

2. 클래스별 중요 요소 파악

DTD 기반 해석을 통해, 각 클래스에 따라 중요한 토큰이 무엇인지, 또는 어떤 특징이 결과에 큰 영향을 미치는지 확인할 수 있습니다. 이렇게 하면 다음과 같은 성능 향상 요소가 발생합니다:

- 중요 토큰에 기반한 피드백 제공: 예를 들어, 감정 분석에서 LLM이 긍정적인 리뷰와 부정적인 리뷰를 분류할 때, 각 클래스에서 중요한 단어들이 무엇인지 DTD로 확인할 수 있습니다. 만약 모델이 부적절한 단어들에 지나치게 의존하고 있다면, 그 부분을 조정하거나 추가적인 학습 데이터로 보완할 수 있습니다.

- 데이터셋 정제 및 추가 학습: 모델이 특정한 예측에서 잘못된 토큰이나 특징에 의존하는 경우, 해당 부분을 식별하여 학습 데이터셋을 정제할 수 있습니다. 더 나아가, 특정 클래스에서 부정확한 예측이 반복된다면 그 부분을 보강할 수 있는 추가 데이터를 수집하거나 학습시키는 방법도 사용됩니다.

3. 성능 개선을 위한 Fine-tuning 및 학습 조정

해석 방법을 통해 모델이 잘못된 부분을 파악하고 수정하면, 이를 기반으로 모델을 더욱 효과적으로 fine-tuning할 수 있습니다. 이를 통해 LLM의 성능을 평가 데이터셋에서 향상시키는 구체적인 방법은 다음과 같습니다:

- Fine-tuning: DTD를 통해 잘못된 예측에 대한 이유를 분석한 후, 그에 맞게 모델을 재조정하거나 특정 레이어에서 잘못된 특성에 의존하는 경향을 줄일 수 있도록 fine-tuning합니다. 예를 들어, 불필요한 토큰이나 특징을 과도하게 강조하는 레이어를 수정할 수 있습니다.

- Gradient 정보 활용: DTD에서 사용하는 gradient 정보를 통해 각 토큰이 얼마나 기여했는지를 분석한 후, 양성과 음성 기여도를 바탕으로 gradient를 조정하여 모델이 올바른 방향으로 학습되도록 도울 수 있습니다.

4. 모델 검증 및 평가

- 평가 데이터셋에서의 성능 향상: DTD로 설명 가능한 방식으로 각 예측을 시각화하고 분석함으로써, LLM의 평가 지표(정확도, F1 스코어 등)를 개선할 수 있습니다. 특히, 평가 데이터셋에서 모델이 어떤 부분에서 실수를 하고 있는지 시각적으로 명확히 볼 수 있기 때문에, 해당 오류를 수정하는 방향으로 학습 및 모델 아키텍처를 조정할 수 있습니다.

- Fine-tuning 전략 강화: LLM의 평가 데이터셋에서 반복적으로 발생하는 문제들을 발견하고, 이를 해결하기 위한 fine-tuning 전략을 강화할 수 있습니다. 예를 들어, 특정 데이터셋에서 잘못된 추론이 반복될 경우, 그 원인을 파악하고 추가적인 fine-tuning 데이터나 학습 전략을 설계할 수 있습니다.

5. 모델의 Robustness 향상

DTD와 같은 해석 방법을 통해, 모델이 잘못된 입력에 대해 어떻게 반응하는지도 확인할 수 있습니다. 이러한 과정을 통해 모델의 robustness를 향상시킬 수 있습니다:

- 공격이나 왜곡된 입력에 대한 대응력 향상: DTD는 모델이 왜곡된 입력이나 공격적인 데이터를 만났을 때 어떻게 반응하는지를 분석하는 데 유용합니다. 예를 들어, 입력 데이터를 조금만 바꿨을 때 모델이 잘못된 예측을 한다면, 그 이유를 해석하고 모델을 보강하여 더 강건한 예측을 하도록 만들 수 있습니다.

결론

DTD 기반 해석 방법은 LLM의 평가 데이터셋에서 성능을 높이기 위한 중요한 도구로 작용합니다. 이를 통해 모델이 잘못된 학습 패턴이나 바이어스에 의존하는 경우를 식별하고 수정할 수 있으며, 클래스별로 중요한 특징들을 파악하여 더 나은 fine-tuning 전략을 세울 수 있습니다. 또한, 모델의 robustness를 향상시키는 데 도움을 주어, 왜곡된 입력이나 공격적인 데이터에 대한 대응력을 강화할 수 있습니다.

그럼 이 것은 특정 단어마다 DTD를 통해 Relevance를 구해서 만약 너무 심하게 반응이 크거나 작으면 그 토큰을 조금 더 학습시키는 방향으로 진행할 수 있는 것이네?

네, 정확합니다! DTD(Deep Taylor Decomposition)를 통해 각 토큰에 대해 구체적인 Relevance 값을 계산할 수 있기 때문에, 이를 바탕으로 과도하게 반응하는 토큰이나 너무 적게 반응하는 토큰을 찾아낼 수 있습니다. 이러한 토큰에 대한 정보는 모델의 성능을 개선하기 위한 fine-tuning 또는 추가 학습 전략을 설계하는 데 유용하게 활용될 수 있습니다.

이 과정을 좀 더 구체적으로 설명하자면:

- Relevance 계산:

- DTD를 통해 각 입력 토큰이 모델의 출력에 얼마나 기여했는지를 나타내는 relevance score를 계산합니다. 이 relevance score는 각 토큰의 중요도를 의미하며, 모델이 해당 토큰에 대해 얼마나 강하게 반응했는지를 수치적으로 보여줍니다.

- 비정상적인 Relevance 탐지:

- 만약 특정 토큰이 과도하게 높은 relevance를 가지고 있거나, 반대로 너무 낮은 relevance를 가진다면, 이는 모델이 해당 토큰에 대해 과잉 반응하거나 과소 반응하고 있음을 의미합니다.

- 예를 들어, 텍스트 분류 작업에서 "the"와 같은 일반적인 단어가 매우 높은 relevance를 가진다면, 모델이 해당 토큰에 과잉 반응하고 있을 가능성이 큽니다.

- 반대로, "행복하다"나 "기쁘다" 같은 중요한 감정 관련 단어가 relevance가 너무 낮다면, 모델이 중요한 신호를 충분히 활용하지 못하고 있음을 나타냅니다.

- 만약 특정 토큰이 과도하게 높은 relevance를 가지고 있거나, 반대로 너무 낮은 relevance를 가진다면, 이는 모델이 해당 토큰에 대해 과잉 반응하거나 과소 반응하고 있음을 의미합니다.

- Fine-tuning 및 추가 학습:

- 과잉 반응 토큰 조정: relevance가 너무 높은 토큰의 경우, 해당 토큰에 대한 학습을 조정하여 모델이 해당 토큰에 과도하게 의존하지 않도록 할 수 있습니다. 학습 데이터에서 해당 토큰의 기여도를 줄이거나, 특정 레이어에서 이 토큰에 대한 가중치를 조정할 수 있습니다.

- 과소 반응 토큰 강화: relevance가 너무 낮은 중요한 토큰에 대해서는 해당 토큰이 더 중요한 역할을 할 수 있도록 추가 학습을 통해 강화할 수 있습니다. 추가 데이터를 통해 해당 토큰의 패턴을 더욱 학습하거나, 특정 레이어에서 그 토큰에 대한 가중치를 높이는 방식으로 학습을 강화할 수 있습니다.

- 다양한 학습 전략 적용:

- 데이터 확장: relevance 분석을 통해 발견된 특정 패턴에 대해 추가 데이터를 제공함으로써 모델이 더 잘 학습할 수 있도록 도울 수 있습니다. 예를 들어, 특정 감정 단어에 대한 반응이 낮다면, 감정 표현을 포함한 문장들을 더 많이 학습시켜 해당 패턴에 대한 민감도를 높일 수 있습니다.

- 가중치 조정 및 Regularization: 특정 토큰에 대해 relevance가 과도하게 높을 경우, 가중치를 조정하거나 regularization 기법을 사용하여 과잉 반응을 줄일 수 있습니다.

예시 시나리오

- 감정 분석 작업: 감정 분석에서 모델이 "좋다", "사랑스럽다"와 같은 긍정적인 단어에 대해 relevance가 낮다면, 해당 단어가 긍정적인 감정을 나타내는 데 중요한 역할을 하는 만큼, 추가 학습을 통해 모델이 이를 더 민감하게 처리하도록 조정할 수 있습니다. 반대로, "is", "the" 같은 일반적인 단어에 relevance가 지나치게 높다면, 모델이 불필요한 부분에 과도하게 반응하는 것이므로 그에 대한 의존도를 줄이는 fine-tuning이 필요할 수 있습니다.

- 독성 언어 탐지: 독성 언어 탐지 모델에서 특정 비속어나 공격적인 단어에 relevance가 낮게 나오는 경우, 이를 보완하기 위한 추가 학습을 진행하여 해당 단어들이 더 정확히 탐지될 수 있도록 할 수 있습니다.

결론

DTD를 통해 계산된 Relevance Score는 모델이 특정 입력 토큰에 대해 어떻게 반응하는지를 명확히 보여줍니다. 이를 통해 과잉 반응하는 토큰과 과소 반응하는 토큰을 발견하고, 이러한 문제를 해결하기 위한 fine-tuning 또는 추가 학습을 적용하여 모델의 성능을 개선할 수 있습니다.

그럼 이 방식은 Sparse Autoencoder와는 다르게 추가적인 학습이 필요 없는 것이네?

네, 정확합니다! DTD(Deep Taylor Decomposition) 방식은 추가적인 학습을 요구하지 않고, 이미 학습된 모델을 해석하는 방법입니다. 즉, 모델을 재학습하거나 fine-tuning 없이도, 현재 모델이 특정 입력에 대해 어떻게 반응하는지를 분석할 수 있는 방식입니다.

이를 Sparse Autoencoder와 비교하면 다음과 같은 차이점이 있습니다:

DTD 방식의 특징

- 추가 학습 불필요:

- DTD는 해석을 위한 방법이므로, 이미 학습된 모델에서 각 입력이 출력에 얼마나 기여했는지 relevance를 계산하는 데 사용됩니다.

- 이는 모델의 설명 가능성을 높이는 데 중점을 두고 있기 때문에, 추가적인 학습을 요구하지 않습니다.

- 따라서 DTD는 모델의 결정 과정을 분석하고 이해하는 도구로 사용되며, 새로운 데이터를 학습시키지 않고도 모델이 어떤 패턴에 의존하고 있는지 파악할 수 있습니다.

- 모델 성능에 직접적인 영향 없음:

- DTD는 모델의 해석 가능성을 높여주는 도구로서, 모델의 성능(예측 정확도 등)에 직접적인 변화를 주지 않습니다. 대신, 모델이 잘못된 판단을 할 때 그 이유를 파악하고, 이를 통해 간접적으로 성능 개선에 활용할 수 있습니다.

- 모델 구조에 대한 변화 없음:

- DTD는 기존 모델의 구조를 수정하지 않으며, 모델의 학습된 파라미터를 그대로 유지한 상태에서 relevance를 계산합니다. 즉, 모델을 해석하는 데 있어서 기존의 구조를 그대로 사용합니다.

Sparse Autoencoder와의 차이점

- Sparse Autoencoder는 추가 학습 필요:

- Sparse Autoencoder는 입력 데이터의 잠재적 표현을 학습하는 방식으로, 모델이 새로운 학습 데이터를 통해 더 효율적인 표현을 찾도록 설계되었습니다. 즉, 새로운 데이터를 입력으로 학습시키고, 이를 통해 보다 중요한 특징을 학습하도록 만드는 과정이 필요합니다.

- Sparse Autoencoder는 주로 특징 추출 및 차원 축소를 목적으로 사용되며, 추가적인 학습을 통해 모델을 개선하는 데 중점을 둡니다.

- Sparse Autoencoder는 학습을 통한 성능 개선:

- Sparse Autoencoder는 추가 학습을 통해 모델의 성능을 개선할 수 있습니다. 예를 들어, 모델이 중요한 특징에만 집중하도록 유도하여 과적합을 방지하거나, 입력 데이터에서 불필요한 정보를 제거하는 효과를 볼 수 있습니다.

- 이 방식은 LLM과 같은 대형 모델을 해석하는 데 초점을 맞추기보다는, 모델의 학습 효율성을 높이고 중요한 특징을 학습하는 데 중점을 둡니다.

결론적으로:

- DTD는 추가 학습 없이 이미 학습된 모델을 해석하여 모델의 동작 방식을 분석하는 방식입니다. 모델의 결정 과정을 이해하고, 그에 맞는 조정을 통해 성능을 간접적으로 개선할 수 있습니다.

- Sparse Autoencoder는 추가 학습이 필요하며, 이를 통해 새로운 특징 표현을 학습하여 모델 성능을 직접적으로 향상시키는 데 사용됩니다.

따라서 DTD 방식은 모델의 설명 가능성을 높이고, Sparse Autoencoder는 모델의 표현 학습과 성능 향상에 초점을 맞추고 있다고 볼 수 있습니다.

DTD도 그럼 Sparse Autoencoder처럼 모델의 출력을 조정할 수 있어?

아니면 무조건 fine-tuning을 통해 중요도를 살짝 조정하는거야?

DTD(Deep Taylor Decomposition)는 모델의 출력을 직접 조정하는 방식은 아닙니다. DTD는 해석을 위한 도구로서, 모델의 내부에서 각 입력 토큰이 모델의 예측에 얼마나 기여하는지를 분석하고 시각화하는 데 중점을 둡니다. 즉, DTD는 모델의 가중치나 출력을 직접 수정하거나 조정하는 기능은 없습니다.

DTD와 모델 출력 조정의 관계

DTD는 이미 학습된 모델에서 결과를 분석하는 것이 목표입니다. 이를 통해:

- 모델이 예측을 내릴 때 어떤 입력 요소에 더 집중하는지를 파악하고,

- 과도하게 높은 relevance를 가지는 입력이나 과소하게 평가된 입력을 찾아낼 수 있습니다.

하지만, DTD 자체는 모델의 가중치나 출력을 변경하지 않고, 추가적인 학습 없이도 모델을 해석하고 분석하는 데 사용됩니다. 따라서, DTD는 모델의 해석에 초점을 맞추고 있으며, 모델의 성능 개선을 위한 직접적인 조정 도구는 아닙니다.

중요도 조정: Fine-Tuning의 필요성

만약 DTD를 사용하여 발견된 중요도가 너무 높은 토큰 또는 중요도가 너무 낮은 토큰을 조정하고 싶다면, 그때는 fine-tuning이나 추가 학습이 필요합니다. 즉, DTD를 통해 문제를 발견한 후, 해당 문제를 해결하려면 모델을 다시 학습시키는 과정이 필요할 수 있습니다. 이를 위한 몇 가지 방법은 다음과 같습니다:

- Fine-Tuning:

- 과도하게 높은 relevance를 가진 토큰: 해당 토큰에 모델이 과도하게 반응하고 있다면, 이를 줄이기 위해 특정 레이어나 파라미터를 조정하여 모델이 불필요한 정보에 의존하지 않도록 합니다.

- 과소하게 평가된 토큰: 중요한 의미를 가지지만 relevance가 너무 낮은 토큰의 경우, 추가적인 학습 데이터를 사용하여 해당 패턴을 더 잘 학습할 수 있도록 조정할 수 있습니다.

- 이 과정은 모델을 다시 학습시키는 것으로, 모델의 출력 조정과 관련된 부분은 fine-tuning을 통해 이루어집니다.

- Regularization 및 가중치 조정:

- relevance가 비정상적으로 높은 특정 입력에 대해 가중치를 낮추거나 regularization 기법을 사용하여 과도한 반응을 억제할 수 있습니다.

- 이는 fine-tuning이나 추가 학습 과정에서 적용될 수 있습니다.

- Feature Importance 조정:

- 모델이 학습하는 과정에서 DTD를 통해 발견된 중요한 특징을 반영할 수 있도록 학습 과정을 재설계할 수 있습니다. 예를 들어, 특정 토큰이나 패턴이 적절한 중요도로 반영되지 않는다면, 그에 맞는 데이터 보강 또는 학습 알고리즘 조정이 필요할 수 있습니다.

결론적으로:

- DTD는 모델의 출력을 직접적으로 조정할 수 없습니다. DTD는 모델의 동작을 분석하고, 각 입력이 어떻게 모델 예측에 기여했는지를 해석하는 데 중점을 둡니다.

- 만약 DTD를 통해 발견된 중요도를 조정하고 싶다면, fine-tuning이나 추가 학습이 필요합니다. 이를 통해 모델이 특정 입력에 대해 과도하게 반응하거나 적절하게 반응하지 않는 문제를 해결할 수 있습니다.

따라서, DTD는 Sparse Autoencoder처럼 학습 과정에서 직접적으로 모델의 출력을 조정하는 기능을 하지 않지만, 해석을 통해 문제를 발견하고 이를 해결하기 위한 fine-tuning 전략을 수립하는 데 중요한 역할을 할 수 있습니다.