이건 퀴즈에 있었던 내용이네요

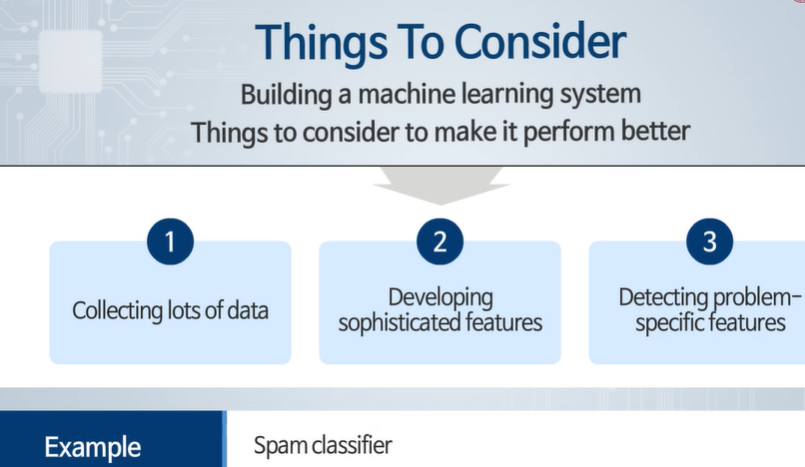

접근 방식 선택하기

머신러닝 시스템을 설계할 때 가장 먼저 고려하여야 할 사항은 "접근방식 선택하기 (지도학습 / 비지도학습)"입니다. 따라서 정답은 3번입니다.

이유:

머신러닝 시스템을 설계할 때 첫 번째 단계는 문제를 정의하고 그에 맞는 접근 방식을 선택하는 것입니다. 이 결정은 전체 시스템 설계의 방향을 결정짓기 때문에 가장 중요합니다. 지도학습(Supervised Learning)과 비지도학습(Unsupervised Learning) 중 어느 접근 방식을 사용할지 결정하는 것이 시스템의 기본 구조와 데이터 수집, 알고리즘 선택 등 이후 모든 단계에 영향을 미칩니다.

선택지 분석:

- 샘플 데이터 수집하기:

- 데이터 수집은 매우 중요한 단계이지만, 어떤 접근 방식을 사용할지 결정한 후에 수집하는 것이 효율적입니다. 데이터의 종류와 형식은 접근 방식에 따라 다를 수 있습니다.

- 학습 알고리즘 개발하기:

- 학습 알고리즘은 문제 정의와 접근 방식 선택 후에 결정해야 합니다. 먼저 어떤 유형의 문제를 해결할 것인지, 어떤 데이터를 사용할 것인지 결정한 후에 적절한 알고리즘을 선택하고 개발합니다.

- 접근방식 선택하기 (지도학습 / 비지도학습):

- 머신러닝 시스템 설계의 첫 단계는 문제의 성격에 맞는 접근 방식을 선택하는 것입니다. 지도학습은 레이블이 있는 데이터를 사용하여 모델을 학습시키는 방법이고, 비지도학습은 레이블이 없는 데이터를 사용하여 데이터의 구조를 학습합니다. 이 결정은 이후 모든 설계 단계를 결정짓습니다.

- 특징 추출하기:

- 특징 추출은 데이터가 준비된 후에 수행하는 단계입니다. 데이터를 어떻게 처리하고 어떤 특징을 추출할지는 접근 방식과 알고리즘에 따라 다를 수 있습니다.

따라서, 머신러닝 시스템을 설계할 때 가장 먼저 고려해야 할 사항은 "접근방식 선택하기 (지도학습 / 비지도학습)"입니다.

2024.05.09 - [인공지능/공부] - 모두를 위한 머신러닝 10주차 퀴즈

모두를 위한 머신러닝 10주차 퀴즈

다음 설명 중 머신러닝 시스템을 설계할 때 가장 먼저 고려하여야 할 사항은 무엇인가?하나를 선택하세요.샘플 데이터 수집하기학습 알고리즘 개발하기접근방식 선택하기 (지도학습 / 비지도학

yoonschallenge.tistory.com

아 산술평균이 아니었는디

뭘 하든 1에 가까워야 성능이 우수합니다.

다음 설명 중 올바른 것을 모두 고르시오:

- F1 점수는 정밀도와 재현율을 절충하기 위한 좋은 수치 평가척도이다

- 올바른 설명입니다. F1 점수는 정밀도(Precision)와 재현율(Recall)을 절충하여 조화평균을 계산하는 척도입니다. 정밀도와 재현율 사이에 균형을 맞추기 때문에 한쪽으로 치우치지 않는 성능 평가에 유용합니다.

- F1 점수는 정밀도와 재현율의 산술평균으로 계산한다

- 잘못된 설명입니다. F1 점수는 정밀도와 재현율의 산술평균이 아니라 조화평균(Harmonic Mean)으로 계산됩니다. 조화평균은 ((2 \times \text{정밀도} \times \text{재현율}) / (\text{정밀도} + \text{재현율}))로 정의됩니다. 조화평균은 두 값 중 하나가 매우 낮을 때 전체 값을 낮추기 때문에, 두 값을 모두 고려한 균형 있는 평가를 제공합니다.

- 정밀도는 1값에 가까울수록 성능이 우수하다는 것을 나타낸다

- 올바른 설명입니다. 정밀도는 예측한 양성 중 실제로 양성인 비율을 나타내며, 1에 가까울수록 잘못된 양성 예측이 적다는 것을 의미합니다. 따라서 정밀도가 1에 가까울수록 성능이 우수하다고 할 수 있습니다.

- 재현율은 0값에 가까울수록 성능이 우수하다는 것을 나타낸다

- 잘못된 설명입니다. 재현율은 실제 양성 중에서 모델이 정확하게 예측한 양성의 비율을 나타내며, 값이 1에 가까울수록 모든 실제 양성을 정확히 예측했다는 의미입니다. 따라서 재현율은 1에 가까울수록 성능이 우수합니다. 재현율이 0에 가까울수록 성능이 나쁘다고 할 수 있습니다.

따라서 올바른 설명은 첫 번째와 세 번째입니다.

추가 설명

F1 점수 (F1 Score):

- F1 점수는 정밀도와 재현율을 절충한 지표로, 두 값의 조화평균을 사용합니다. 이 지표는 두 값 중 하나가 매우 낮을 때 전체 성능 평가가 낮아지는 특징이 있어, 모델의 균형된 성능을 평가하는 데 유용합니다.

정밀도 (Precision):

- 정밀도는 모델이 예측한 양성 중에서 실제 양성의 비율을 측정합니다. (\text{정밀도} = \frac{\text{진짜 양성}}{\text{진짜 양성} + \text{가짜 양성}}). 정밀도가 높다는 것은 모델이 불필요한 양성 예측을 적게 한다는 것을 의미합니다.

재현율 (Recall):

- 재현율은 실제 양성 중에서 모델이 올바르게 예측한 비율을 측정합니다. (\text{재현율} = \frac{\text{진짜 양성}}{\text{진짜 양성} + \text{가짜 음성}}). 재현율이 높다는 것은 모델이 실제 양성을 잘 놓치지 않는다는 것을 의미합니다.

정확한 성능 평가를 위해서는 이 세 가지 지표를 모두 고려하는 것이 중요하며, 특히 F1 점수는 정밀도와 재현율 간의 균형을 중요하게 생각할 때 유용한 지표입니다.

F1 점수는 정밀도와 재현율을 절충하기 위한 좋은 평가 척도이며, 정밀도와 재현율의 조화평균(harmonic average)로 계산함.

정밀도와 재현율의 값이 서로 큰 차이를 가지고 있을 때 산술평균은 좋은 평가 척도가 되기 어려움.

정밀도와 재현율은 둘다 1값에 가까울수록 성능이 우수하다는 것을 나타냄.

다른 국소 최적 값에서 멈출 수 있고, 랜덤하게 하면 다른 국소 최소값 빠지는거 발생할 수 있고, 랜덤 여러번 하면 도움을 줄 수 있는 것도 맞는디?

다음 설명 중 올바른 것을 모두 고르시오:

- K-means는 다른 국소 최적 값에서 멈출 수 있다

- 올바른 설명입니다. K-means 알고리즘은 초기 중심값(centroid)의 선택에 따라 서로 다른 국소 최적 값(local optimum)에서 멈출 수 있습니다. 이는 알고리즘이 전역 최적 값(global optimum)을 찾지 못하고, 초기화에 따라 다르게 수렴할 수 있음을 의미합니다.

- 랜덤하게 초기화 하였을 때 국소 최적 값에 빠지게 되는 경우도 발생할 수 있다

- 올바른 설명입니다. K-means 알고리즘을 랜덤하게 초기화하면, 특정한 초기 중심값에 따라 국소 최적 값에 빠질 수 있습니다. 이는 알고리즘의 본질적인 특성 때문에 발생합니다.

- 랜덤 초기화를 여러 번 실행하면 K-means가 국소 최적 값에 빠지는 것을 방지하는 데 도움이 될 수 있다

- 올바른 설명입니다. K-means 알고리즘을 여러 번 실행하고 가장 낮은 비용 함수 값을 가지는 결과를 선택하면, 국소 최적 값에 빠지는 것을 방지하는 데 도움이 될 수 있습니다. 이 방법을 통해 더 나은 클러스터링 결과를 얻을 수 있습니다.

따라서 올바른 설명은 첫 번째, 두 번째, 세 번째입니다.

K-means 알고리즘은 실행할 때 마다 다른 국소 최적 값에서 멈출 수 있음

랜덤하게 초기화 하였을 때, 국소 최적 값에 빠지게 되는 경우가 발생할 수 있음

랜덤 초기화를 여러 번 실행하면 K-means가 국소 최적 값에 빠지는 것을 방지할 수 있음

과적합 방지에는 사용하지 말라고 했었습니당 ㅎ

PCA(Principal Component Analysis)를 사용하는 이유에 대한 설명이 아닌 것을 선택해야 합니다. 주어진 설명들을 하나씩 검토해 보겠습니다.

- 학습 알고리즘의 실행 시간을 단축시킨다

- 맞는 설명입니다. PCA는 차원 축소를 통해 데이터의 특징 수를 줄이기 때문에 학습 알고리즘의 실행 시간을 단축시킬 수 있습니다.

- 데이터의 저장에 필요한 메모리/디스크 공간을 감소시킨다

- 맞는 설명입니다. PCA를 사용하면 데이터의 차원을 줄여서 저장 공간을 절약할 수 있습니다. 이는 데이터의 크기를 줄이기 때문에 메모리와 디스크 공간의 사용량을 감소시킵니다.

- 특징값의 수를 줄여 과적합을 방지할 수 있다

- 맞는 설명입니다. PCA는 특징값의 수를 줄여 모델이 복잡해지는 것을 막아 과적합을 방지하는 데 도움이 됩니다.

답변:

모든 설명이 PCA를 사용하는 이유에 해당합니다. 따라서 이 선택지들 중에서 PCA를 사용하는 이유가 아닌 설명이 없습니다.

주어진 설명에서 PCA의 사용 이유가 아닌 것이 포함되어 있지 않은 것으로 보입니다. 주어진 설명 모두 PCA를 사용하는 이유에 해당합니다.

GPT랑은 다르네요 ㅎㅎ....

1. PCA를 이용하여 특징값의 수를 줄이면 학습 알고리즘의 실행 시간을 단축시킬 수 있음

2. PCA를 이용하여 특징값의 수를 줄이면 데이터 저장에 필요한 메모리/디스크 공간을 감소시킬 수 있음

3. PCA는 과적합을 방지하는 데 사용할 수 없음

1번 맞고,3번 맞고 나머지는...?

PCA는 특징 수를 줄이니까 아닌듯...?

이상 데이터 검출의 정확도를 높일 수 있는 방법을 모두 고르시오:

- 이상 데이터 발생 시 비정상적으로 크거나 작은 값을 가지는 특징들을 선택한다

- 올바른 설명입니다. 이상 데이터는 일반적으로 비정상적으로 크거나 작은 값을 가지는 특징을 통해 식별될 수 있습니다. 이러한 특징들을 선택하면 이상 데이터 검출의 정확도를 높일 수 있습니다.

- 특징의 수를 줄인다

- 잘못된 설명입니다. 특징의 수를 줄이는 것이 항상 이상 데이터 검출의 정확도를 높이는 것은 아닙니다. 오히려 중요한 특징을 놓칠 수 있기 때문에, 특징을 선택할 때 신중하게 선택해야 합니다.

- 특징들을 가우시안 분포에 더욱 가깝도록 변환한다

- 올바른 설명입니다. 이상 데이터 검출에서는 데이터가 가우시안 분포를 따를 때 더 효과적으로 수행될 수 있습니다. 따라서, 특징들을 가우시안 분포에 가깝도록 변환하면 이상 데이터 검출의 성능을 향상시킬 수 있습니다.

- 특징에 주성분 분석(PCA)을 적용한다

- 올바른 설명입니다. PCA를 적용하면 데이터의 차원을 축소하여 중요한 특징을 추출할 수 있습니다. 이는 이상 데이터를 더 쉽게 식별할 수 있게 도와줍니다. PCA를 통해 데이터를 변환하면 이상 데이터와 정상 데이터 간의 차이를 더욱 명확히 할 수 있습니다.

결론:

이상 데이터 검출의 정확도를 높일 수 있는 방법은 다음과 같습니다:

- 이상 데이터 발생 시 비정상적으로 크거나 작은 값을 가지는 특징들을 선택한다

- 특징들을 가우시안 분포에 더욱 가깝도록 변환한다

- 특징에 주성분 분석(PCA)을 적용한다

따라서 올바른 선택지는 첫 번째, 세 번째, 네 번째입니다.

1. 이상 데이터 발생 시 비정상적으로 크거나 작은 값을 가지는 특징들을 선택하면 검출의 정확도를 높일 수 있음

2. 특징의 수를 줄여도 이상 데이터 검출의 정확도를 높일 수 없음

3. 특징들을 가우시안 분포에 가깝도록 변환하면 이상 데이터 검출의 정확도를 높일 수 있음

4. PCA를 적용하면 특징의 수는 줄일 수 있으나 이상 데이터 검출의 정확도를 높일 수 없음

'인공지능 > 공부' 카테고리의 다른 글

| 생성형 인공지능 입문 6~7, 9 ~10 주 차 정리, 중간 고사, 퀴즈 (1) | 2024.06.13 |

|---|---|

| 생성형 인공지능 입문 1~5주 차 정리, 퀴즈 (2) | 2024.06.11 |

| 모두를 위한 머신러닝 9 ~ 14주차 정리 (0) | 2024.06.10 |

| 모두를 위한 머신러닝 1 ~ 7주차 정리 (0) | 2024.06.09 |

| 모두를 위한 머신러닝 기말 문제 풀기 (0) | 2024.06.09 |