QA 모델에서는 의도파악, NER, 문서 검색, 정보 추출, 정답 생성 등 다양한 기능이 필요하고, 질문의 의도 파악이 중요하다.

CHAT GPT도 하나의 QA챗봇으로 지금 시대의 검색이다.

QA SOTA 모델은 대부분 pre trained된 BERT 모델이다.

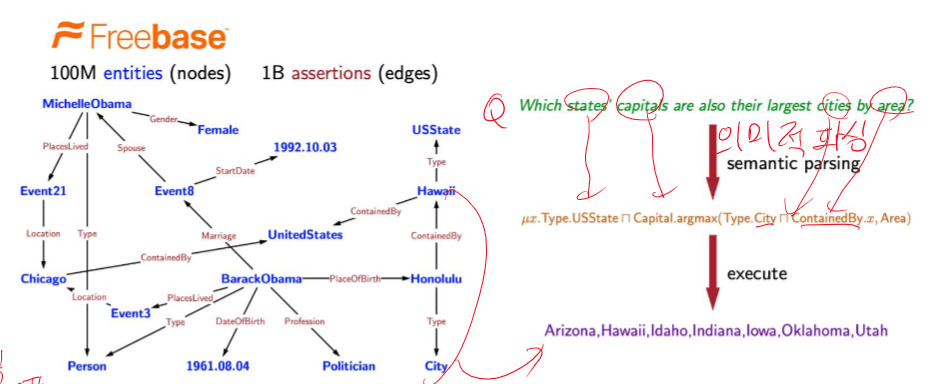

BERT 기반 질문 응답 시스템(QA)은 주어진 문맥에서 질문에 대한 답변을 찾아내는 작업에 주로 사용됩니다. 그러나 Knowledge-Based QA에서는 외부 지식 그래프나 데이터베이스와 같은 지식을 활용하여 질문에 답변을 제공합니다. 아래는 BERT를 활용한 Knowledge-Based QA 시스템의 일반적인 접근 방식을 설명합니다.

BERT를 활용한 Knowledge-Based QA 시스템의 구성 요소

- 질문 이해 (Question Understanding):

- 입력된 질문을 이해하고, 그에 따라 필요한 정보를 추출합니다.

- BERT를 사용하여 질문의 의미를 파악하고, 중요한 엔티티와 관계를 추출할 수 있습니다.

- 지식 그래프 쿼리 (Knowledge Graph Query):

- 질문에서 추출한 엔티티와 관계를 바탕으로 지식 그래프에 쿼리를 수행합니다.

- SPARQL 또는 다른 쿼리 언어를 사용하여 지식 그래프에서 관련 정보를 검색합니다.

- 답변 생성 (Answer Generation):

- 지식 그래프에서 검색한 정보를 바탕으로 질문에 대한 답변을 생성합니다.

- BERT를 사용하여 검색된 정보를 문맥에 맞게 조합하고, 자연어 형태의 답변을 생성할 수 있습니다.

Knowledge-Based QA 시스템의 상세 과정

1. 질문 이해

BERT를 사용하여 질문을 토큰화하고, 질문의 의미를 파악합니다. 이 과정에서는 질문에서 중요한 엔티티와 관계를 추출합니다.

from transformers import BertTokenizer, BertForQuestionAnswering

import torch

# 질문과 문맥 정의

question = "Who is the president of the United States?"

context = "Joe Biden is the current president of the United States."

# BERT 토크나이저와 모델 로드

tokenizer = BertTokenizer.from_pretrained('bert-base-uncased')

model = BertForQuestionAnswering.from_pretrained('bert-base-uncased')

# 입력 텍스트 토큰화

inputs = tokenizer(question, context, return_tensors='pt')

# 모델을 통해 출력 계산

outputs = model(**inputs)

# 답변 추출

answer_start_scores = outputs.start_logits

answer_end_scores = outputs.end_logits

start_index = torch.argmax(answer_start_scores)

end_index = torch.argmax(answer_end_scores) + 1

answer = tokenizer.convert_tokens_to_string(tokenizer.convert_ids_to_tokens(inputs['input_ids'][0][start_index:end_index]))

print("Answer:", answer)2. 지식 그래프 쿼리

질문에서 추출한 엔티티와 관계를 사용하여 지식 그래프를 쿼리합니다. 예를 들어, SPARQL을 사용하여 Wikidata에서 정보를 검색할 수 있습니다.

from SPARQLWrapper import SPARQLWrapper, JSON

def query_wikidata(entity, relation):

sparql = SPARQLWrapper("https://query.wikidata.org/sparql")

query = f"""

SELECT ?answerLabel WHERE {{

wd:{entity} wdt:{relation} ?answer .

SERVICE wikibase:label {{ bd:serviceParam wikibase:language "[AUTO_LANGUAGE],en". }}

}}

"""

sparql.setQuery(query)

sparql.setReturnFormat(JSON)

results = sparql.query().convert()

for result in results["results"]["bindings"]:

print(result["answerLabel"]["value"])

# 예제 엔티티와 관계

entity = "Q30" # United States

relation = "P35" # head of state

query_wikidata(entity, relation)3. 답변 생성

지식 그래프에서 검색한 정보를 바탕으로 답변을 생성합니다. 검색된 정보를 BERT를 사용하여 문맥에 맞게 조합하고, 자연어 형태의 답변을 생성합니다.

# 지식 그래프에서 검색된 정보를 바탕으로 답변 생성

context = "Joe Biden is the current president of the United States."

answer = "Joe Biden"

print("Final Answer:", answer)요약

- 질문 이해: BERT를 사용하여 질문을 이해하고, 중요한 엔티티와 관계를 추출합니다.

- 지식 그래프 쿼리: 추출한 정보를 사용하여 지식 그래프에서 관련 정보를 검색합니다.

- 답변 생성: 검색한 정보를 바탕으로 BERT를 사용하여 자연어 형태의 답변을 생성합니다.

이 과정은 BERT를 통해 질문의 의미를 파악하고, 지식 그래프와 상호작용하며, 검색된 정보를 바탕으로 자연스러운 답변을 생성하는 전반적인 흐름을 설명합니다.

사진의 물체를 탐지하여 테그한 뒤 알려준다 => You tube에서 사용되는 방식이다.

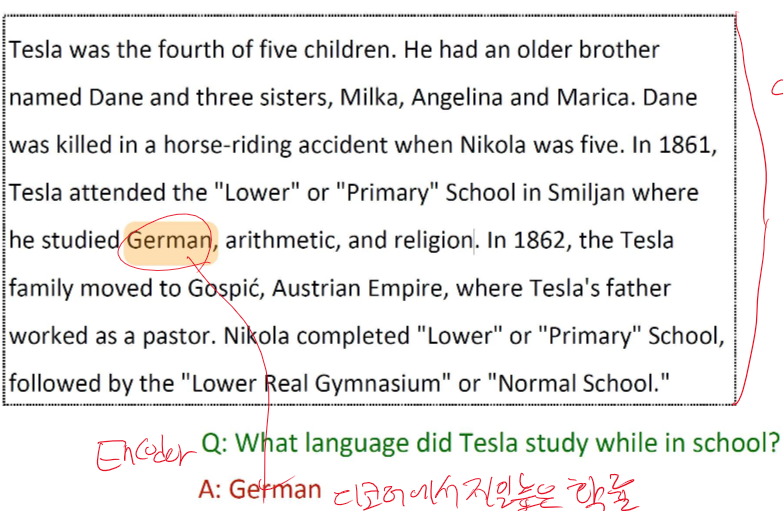

지문을 디코더에 넣어 제일 높은 확률을 가지는 것이 정답이다.

이 과정은 컴퓨터가 인간의 언어를 얼마나 잘 이해하고 있는지 평가하는 척도이다.

SQuAD는 벤치마크 테스트 셋이다.

지문과 Q, A로 구성되어 있고, A는 여러 단어로 되어 있다. -span

평가 지표로는 정확히 매치되었나 확인하는 것과 f1 score가 있다.

BERT에는 다양한 tokenizer가 존재한다.

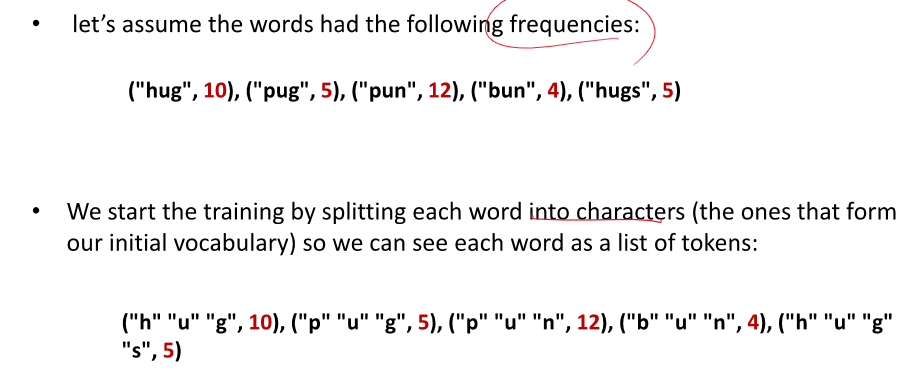

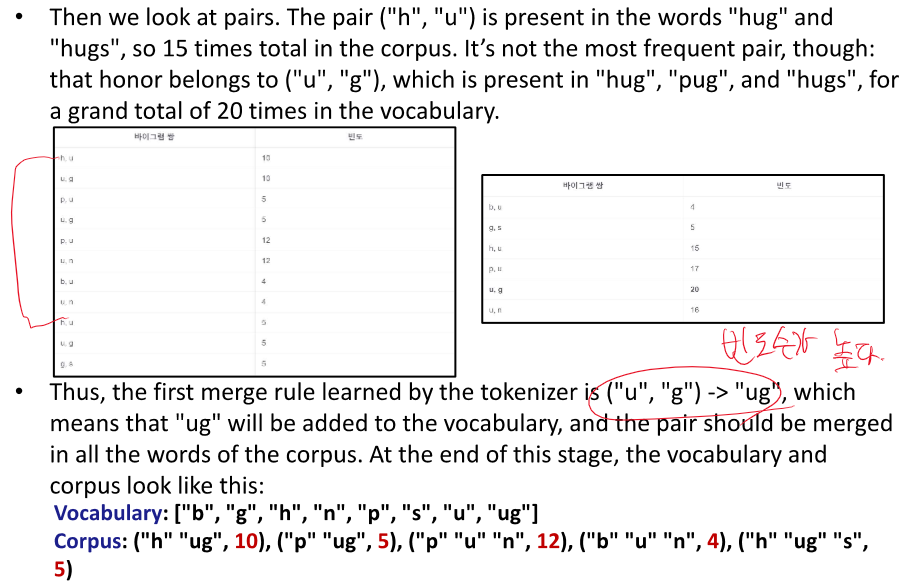

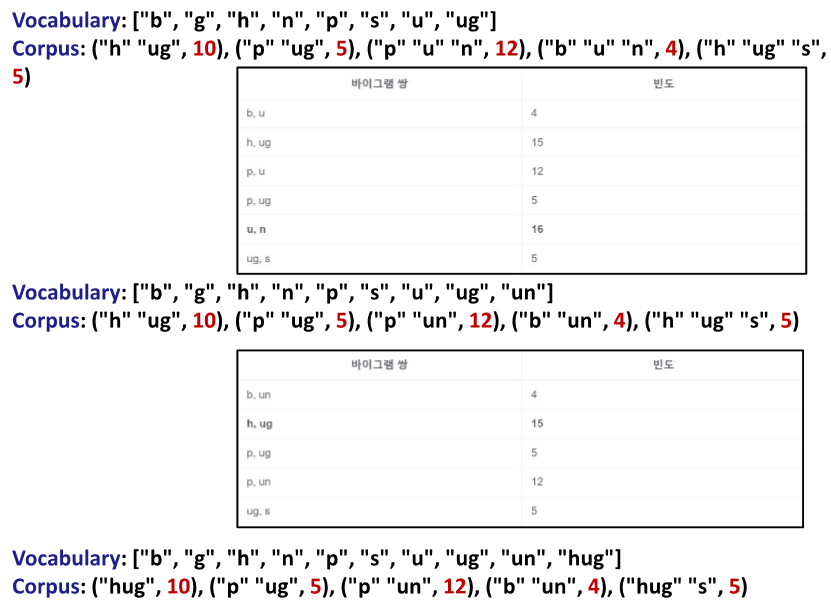

BPE(Byte-Pair Encoding)는 기본적으로 캐릭터 단위로 쪼갠뒤 시작한다.

여기서 빈도수가 가장 높은 캐릭터들을 합쳐준다.

빈도수가 높으면 계속 합쳐진다.

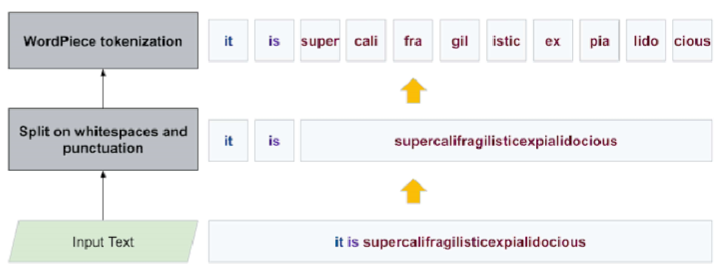

WordPiece Tokenization

subword단위로 쪼개서 보지 못한, 학습하지 못한 단어들에 대해 사용할 수 있게 되었다.

Pretrained된 BERT에 SQuAD로 파인튜닝을 진행하면 QA에 대해 시작과 마지막 위치를 뱉어준다.

2024.05.22 - [인공지능/자연어 처리] - NLP Python - BERT for Question Answering, Tokenizer, Evaluate(f1 score)

NLP Python - BERT for Question Answering, Tokenizer, Evaluate(f1 score)

일단 BERT의 구조부터 한번 상기시키고 가겠습니다.더보기BERT(Bidirectional Encoder Representations from Transformers)는 Google AI에서 개발한 자연어 처리 모델로, 트랜스포머(Transformer) 아키텍처를 기반으로 합

yoonschallenge.tistory.com

여기서 진행했습니다!

Question Answering (QA) 개념

- 질문 응답의 목표: 자연어로 제시된 질문에 대해 자동으로 응답하는 시스템을 구축하는 것.

- 정보 출처: 텍스트 단락, 웹 문서, 지식 기반, 테이블, 이미지 등 다양한 소스에서 정보를 추출할 수 있습니다.

질문 유형 및 응답 유형

- 질문 유형:

- Factoid vs Non-factoid

- Open-domain vs Closed-domain

- Simple vs Compositional

- 응답 유형:

- 짧은 텍스트 세그먼트

- 단락

- 목록

- 예/아니오

실용적인 응용 사례

- 질문 응답 시스템은 챗봇, 고객 지원, 정보 검색 등 다양한 실제 응용 프로그램에 사용됩니다.

딥러닝 시대의 질문 응답

- 최첨단 질문 응답 시스템은 주로 사전 학습된 언어 모델(BERT 등)과 엔드-투-엔드 훈련을 기반으로 구축됩니다.

Reading Comprehension (독해)

- 독해 정의: 텍스트 단락을 이해하고 해당 내용에 대한 질문에 응답하는 것.

- 중요성:

- 독해 능력은 컴퓨터 시스템이 인간의 언어를 얼마나 잘 이해하는지 평가하는 중요한 시험대입니다.

- 다양한 NLP 작업을 독해 문제로 환원할 수 있습니다.

Stanford Question Answering Dataset (SQuAD)

- SQuAD 데이터셋: 약 100,000개의 주석이 달린 (단락, 질문, 답변) 삼중항.

- 데이터 출처: 영어 위키피디아의 단락(주로 100~150 단어).

- 질문 및 답변 생성: 군중 소싱 방식.

- 평가 지표: 정확한 일치(Exact Match)와 F1 점수.

- 한계: 모든 질문이 단락 내에서 답변될 수 있는 것은 아닙니다.

BERT Tokenizer 및 Byte-Pair Encoding (BPE)

- BPE:

- 텍스트 압축 알고리즘으로 개발되었으며, GPT 모델을 사전 학습할 때 사용되었습니다.

- 자주 나타나는 문자 쌍을 병합하여 서브워드를 생성합니다.

- WordPiece Tokenization:

- 단어를 제한된 서브워드로 나타냅니다.

- BERT 모델에서 약 30,000개의 WordPiece 토큰을 사용합니다.

BERT 사전 학습 및 파인 튜닝

- 사전 학습: Book Corpus와 영어 위키피디아를 사용하여 BERT 모델을 사전 학습합니다.

- 파인 튜닝: [CLS] 토큰에 소프트맥스 레이어를 붙여 분류 작업을 수행합니다.

- 질문 응답 작업: [SEP] 토큰 이후의 정답을 찾아 각 토큰을 시작 또는 끝 토큰으로 분류합니다.

실험

- 데이터셋:

- General Language Understanding Evaluation (GLUE) 데이터셋: 텍스트적 함의(MNLI, QNLI, RTE), 의미 유사성(QQP, STS-B, MRPC), 문장 분류(SST-2), 언어 수용성(CoLA)

- Stanford Question Answering Dataset (SQuAD): 질문 응답(SQuAD v1.1/2.0)

- Situations With Adversarial Generations (SWAG) 데이터셋: 기초 상식 추론

이 문서는 질문 응답 시스템과 BERT 모델의 개념, 응용 사례, 주요 데이터셋 및 실험 결과를 다루고 있습니다. BERT의 사전 학습 및 파인 튜닝 과정, 그리고 다양한 질문 응답 데이터셋에 대한 성능 평가 방법을 설명합니다.

O, X 문제 (10문제)

- 질문 응답 시스템은 인간이 제시한 질문에 자연어로 답변하는 시스템을 구축하는 것을 목표로 한다. (O)

- 해설: 질문 응답 시스템의 주요 목표는 자연어 질문에 대한 답변을 자동으로 제공하는 것입니다.

- 질문 응답 시스템은 항상 텍스트를 기반으로 작동한다. (X)

- 해설: 질문 응답 시스템은 텍스트, 웹 문서, 지식 베이스, 이미지 등 다양한 정보 소스를 사용할 수 있습니다.

- BERT 기반의 질문 응답 시스템은 토큰 단위 작업에서 각 토큰이 시작과 끝 토큰인지 분류한다. (O)

- 해설: BERT는 질문 응답 작업에서 각 토큰이 답변의 시작 또는 끝인지 분류합니다.

- SQuAD 데이터셋은 영어 위키피디아에서 발췌한 문단을 기반으로 한다. (O)

- 해설: SQuAD 데이터셋은 영어 위키피디아에서 발췌한 문단을 사용합니다.

- SQuAD 데이터셋에서 모든 질문은 짧은 텍스트 조각이나 문장으로 답변할 수 있다. (X)

- 해설: SQuAD 데이터셋의 제한점 중 하나는 모든 질문에 대해 짧은 텍스트 조각으로 답변할 수 없다는 것입니다.

- 질문 응답 시스템의 평가 지표로 정확한 일치와 F1 점수가 사용된다. (O)

- 해설: 질문 응답 시스템에서는 정확한 일치(Exact Match)와 F1 점수가 주요 평가 지표로 사용됩니다.

- BERT의 WordPiece 토크나이저는 단어를 서브워드 단위로 분할하여 표현한다. (O)

- 해설: BERT의 WordPiece 토크나이저는 단어를 서브워드 단위로 분할하여 표현합니다.

- 질문 응답 시스템에서 모든 질문은 사실 기반 질문이다. (X)

- 해설: 질문 응답 시스템은 사실 기반 질문뿐만 아니라 비사실 기반 질문도 처리할 수 있습니다.

- 그냥 문제를 비사실로 주면 비사실 문제도 푼다는 건가...?

-

더보기

이 문제는 적절한 질문이며, 주어진 문장과 해설은 맞습니다. 문제를 풀기 위해 질문 응답 시스템(Question Answering System, QA System)에 대해 좀 더 자세히 설명드리겠습니다.

질문 응답 시스템 (Question Answering System)

질문 응답 시스템은 사용자가 입력한 질문에 대한 답변을 제공하는 인공지능 시스템입니다. 이러한 시스템은 다양한 종류의 질문을 처리할 수 있으며, 질문의 유형에 따라 여러 방식으로 동작할 수 있습니다.

질문의 유형

- 사실 기반 질문 (Fact-based Questions):

- 특정한 사실을 묻는 질문입니다.

- 예: "2024년 올림픽은 어디에서 개최되나요?"

- 이러한 질문들은 주로 고정된 정보나 데이터를 기반으로 답변됩니다.

- 비사실 기반 질문 (Non-fact-based Questions):

- 사실에 기반하지 않는 질문으로, 의견, 설명, 분석 등이 포함될 수 있습니다.

- 예: "기후 변화의 주요 원인은 무엇인가요?", "행복의 정의는 무엇인가요?"

- 이러한 질문들은 주관적인 답변을 포함할 수 있으며, 종종 설명이나 의견이 필요합니다.

문제와 해설

질문 응답 시스템에서 모든 질문은 사실 기반 질문이다. (X) 해설: 질문 응답 시스템은 사실 기반 질문뿐만 아니라 비사실 기반 질문도 처리할 수 있습니다.문제의 진술:

- "질문 응답 시스템에서 모든 질문은 사실 기반 질문이다."는 틀린 진술입니다.

해설:

- 질문 응답 시스템은 사실 기반 질문뿐만 아니라 비사실 기반 질문도 처리할 수 있습니다. 사실 기반 질문은 구체적이고 정량적인 답변을 필요로 하지만, 비사실 기반 질문은 주관적이고 정성적인 답변을 필요로 합니다.

예시

사실 기반 질문:

- 질문: "미국의 첫 번째 대통령은 누구인가요?"

- 답변: "조지 워싱턴입니다."

비사실 기반 질문:

- 질문: "좋은 리더의 자질은 무엇인가요?"

- 답변: "좋은 리더는 결단력, 소통 능력, 공감 능력, 비전 제시 등의 자질을 가져야 합니다."

따라서, 문제는 적절하며 해설도 정확합니다. 질문 응답 시스템은 다양한 종류의 질문을 처리할 수 있으며, 사실 기반 질문뿐만 아니라 비사실 기반 질문도 처리할 수 있습니다.

- 사실 기반 질문 (Fact-based Questions):

- BERT는 트랜스포머 디코더를 사용하여 질문 응답 시스템을 구축한다. (X)

- 해설: BERT는 트랜스포머 인코더를 사용합니다.

- SQuAD 데이터셋은 개발 및 테스트 세트에서 여러 개의 정답을 가지고 있다. (O)

- 해설: SQuAD 데이터셋은 개발 및 테스트 세트에서 다수의 정답을 가지고 있습니다.

빈칸 문제 (10문제)

- 질문 응답 시스템의 목표는 __를 사용하여 인간의 질문에 답변하는 것이다. (자연어)

- 해설: 질문 응답 시스템은 자연어를 사용하여 질문에 답변합니다.

- 질문 응답 시스템은 __, 웹 문서, 지식 베이스, 테이블, 이미지 등을 정보 소스로 사용할 수 있다. (텍스트)

- 해설: 질문 응답 시스템은 다양한 정보 소스를 사용할 수 있습니다.

- 질문 응답 시스템에서 질문 유형과 답변 유형은 __와 비사실 기반 질문으로 나눌 수 있다. (사실 기반 질문)

- 해설: 질문 유형과 답변 유형은 사실 기반 질문과 비사실 기반 질문으로 나뉩니다.

- SQuAD 데이터셋은 __에서 발췌한 문단을 포함한다. (영어 위키피디아)

- 해설: SQuAD 데이터셋은 영어 위키피디아에서 발췌한 문단을 포함합니다.

- SQuAD 데이터셋의 주요 평가 지표는 정확한 일치와 __ 점수이다. (F1)

- 해설: SQuAD 데이터셋은 정확한 일치(Exact Match)와 F1 점수를 주요 평가 지표로 사용합니다.

- BERT 기반 질문 응답 시스템에서 각 토큰은 답변의 __ 또는 끝 토큰으로 분류된다. (시작)

- 해설: 각 토큰은 답변의 시작 또는 끝 토큰으로 분류됩니다.

- BERT의 __ 토크나이저는 단어를 서브워드 단위로 분할하여 표현한다. (WordPiece)

- 해설: BERT의 WordPiece 토크나이저는 단어를 서브워드 단위로 분할하여 표현합니다.

- SQuAD 데이터셋은 __와 F1 점수로 평가된다. (정확한 일치)

- 해설: SQuAD 데이터셋은 정확한 일치(Exact Match)와 F1 점수로 평가됩니다.

- BERT는 트랜스포머 __를 사용하여 질문 응답 시스템을 구축한다. (인코더)

- 해설: BERT는 트랜스포머 인코더를 사용합니다.

- SQuAD 데이터셋은 개발 및 테스트 세트에서 __ 개의 정답을 가지고 있다. (3)

- 해설: SQuAD 데이터셋은 개발 및 테스트 세트에서 3개의 정답을 가지고 있습니다.

서술형 문제 (10문제)

- 질문 응답 시스템이 중요한 이유를 설명하시오.

- 정답: 질문 응답 시스템은 정보 검색, 고객 지원, 교육 등 다양한 분야에서 효율적이고 정확한 답변을 제공하여 사용자 경험을 개선하는 데 중요한 역할을 합니다.

- 해설: 질문 응답 시스템은 사용자가 필요한 정보를 빠르고 정확하게 얻을 수 있도록 도와줍니다.

- BERT 기반 질문 응답 시스템의 작동 원리를 설명하시오.

- 정답: BERT는 입력된 질문과 문맥을 처리하여 각 토큰의 벡터 표현을 생성하고, 이를 기반으로 각 토큰이 답변의 시작과 끝인지 예측합니다.

- 해설: BERT는 입력된 질문과 문맥을 벡터로 변환하고, 이를 통해 답변의 위치를 예측합니다.

- SQuAD 데이터셋의 특징과 그 중요성을 설명하시오.

- 정답: SQuAD 데이터셋은 영어 위키피디아에서 발췌한 문단과 군중 소싱을 통해 생성된 질문 및 답변 쌍을 포함하며, 이는 대규모 지도 학습 데이터셋으로서 효과적인 신경망 모델 훈련에 중요합니다.

- 해설: SQuAD 데이터셋은 다양한 질문 유형을 포함하여 모델의 학습과 평가에 중요한 역할을 합니다.

- BERT의 WordPiece 토크나이저가 어떻게 동작하는지 설명하시오.

- 정답: WordPiece 토크나이저는 단어를 서브워드 단위로 분할하여 표현함으로써 복잡한 형태소와 희귀 단어를 효과적으로 처리합니다.

- 해설: WordPiece 토크나이저는 단어를 작은 단위로 분할하여 더 나은 단어 표현을 제공합니다.

- 질문 응답 시스템의 평가 지표로서 정확한 일치와 F1 점수가 중요한 이유를 설명하시오.

- 정답: 정확한 일치는 모델의 예측이 정답과 정확히 일치하는지를 평가하며, F1 점수는 정밀도와 재현율의 조화 평균으로 모델의 전반적인 성능을 평가합니다.

- 해설: 두 지표는 모델의 예측 정확성과 완전성을 평가하는 데 중요한 역할을 합니다.

- SQuAD 데이터셋의 개발 및 테스트 세트에서 다수의 정답을 사용하는 이유를 설명하시오.

- 정답: 여러 정답을 사용함으로써 다양한 표현 방식과 가능한 정답을 모두 평가하여 모델의 유연성과 정확성을 높일 수 있습니다.

- 해설: 다양한 정답을 통해 모델의 예측 성능을 더 정확하게 평가할 수 있습니다.

- BERT의 사전 훈련과 질문 응답 작업에 대한 미세 조정 절차를 설명하시오.

- 정답: BERT는 대규모 텍스트 데이터로 사전 훈련을 수행한 후, 질문 응답 작업에 맞게 미세 조정을 통해 최적화됩니다. 미세 조정 단계에서는 질문과 문맥을 입력으로 받아 각 토큰의 시작과 끝 위치를 예측합니다.

- 해설: 사전 훈련 단계에서 언어 모델을 학습하고, 미세 조정 단계에서 특정 작업에 맞게 모델을 조정합니다.

SQuAD 데이터셋 외에 다른 질문 응답 데이터셋의 예시와 그 특징을 설명하시오.정답: TriviaQA는 퀴즈 애호가들이 만든 질문과 답변을 포함하며, HotpotQA는 여러 문서를 참조하여 답변을 도출하는 다단계 질문을 포함합니다.해설: 다양한 질문 응답 데이터셋은 각기 다른 질문 유형과 답변 형식을 포함하여 모델의 학습에 유용합니다.

- BERT의 Byte-Pair Encoding(BPE)와 WordPiece 토크나이저의 차이점을 설명하시오.

- 정답: BPE는 텍스트 압축 알고리즘에서 유래하여 자주 나타나는 문자 쌍을 병합하여 단어를 분할하고, WordPiece는 단어를 서브워드 단위로 분할하여 더 유연한 단어 표현을 제공합니다.

- 해설: 두 토크나이저는 단어를 분할하는 방식에서 차이가 있습니다.

- 질문 응답 시스템이 실제 응용에서 어떻게 사용될 수 있는지 설명하시오.

- 정답: 질문 응답 시스템은 고객 지원, 교육, 검색 엔진, 가상 비서 등 다양한 응용 분야에서 사용되어 사용자에게 효율적이고 정확한 정보를 제공합니다.

- 해설: 질문 응답 시스템은 다양한 분야에서 사용자 경험을 개선하는 데 중요한 역할을 합니다.

단답형 문제 (10문제)

- 질문 응답 시스템의 목표는?

- 정답: 자연어로 질문에 답변하는 것

- 해설: 질문 응답 시스템은 자연어 질문에 대한 답변을 자동으로 제공합니다.

- 질문 응답 시스템의 정보 소스는?

- 정답: 텍스트, 웹 문서, 지식 베이스, 이미지 등

- 해설: 다양한 정보 소스를 사용할 수 있습니다.

- 질문 응답 시스템에서 질문 유형은?

- 정답: 사실 기반 질문, 비사실 기반 질문

- 해설: 질문 유형은 사실 기반 질문과 비사실 기반 질문으로 나뉩니다.

- SQuAD 데이터셋은 어디에서 발췌한 문단을 사용하는가?

- 정답: 영어 위키피디아

- 해설: 영어 위키피디아에서 발췌한 문단을 사용합니다.

- SQuAD 데이터셋의 주요 평가 지표는?

- 정답: 정확한 일치, F1 점수

- 해설: 정확한 일치와 F1 점수를 주요 평가 지표로 사용합니다.

BERT 기반 질문 응답 시스템에서 각 토큰은 어떤 역할을 하는가?정답: 답변의 시작 또는 끝 토큰해설: 각 토큰은 답변의 시작 또는 끝 토큰으로 분류됩니다.- 문제가 너무 이상...

-

더보기

네, 맞습니다. 제시된 문제는 다소 혼동을 줄 수 있습니다. BERT 기반 질문 응답 시스템에서 각 토큰의 역할을 묻는 질문은 모호할 수 있습니다. 대신, 질문 응답 시스템에서 토큰의 역할이 무엇인지 구체적으로 묻거나, BERT의 출력에 대해 묻는 것이 더 명확할 것입니다.

개선된 문제와 정답 예시

문제:

BERT 기반 질문 응답 시스템에서 출력 벡터는 어떤 역할을 하는가? 정답: 출력 벡터는 각 토큰이 답변의 시작 또는 끝인지 여부를 예측하는 데 사용됩니다. 해설: BERT 기반 질문 응답 시스템에서는 각 토큰에 대해 시작 토큰과 끝 토큰에 대한 확률을 출력합니다.설명:

- 질문: BERT 기반 질문 응답 시스템에서 출력 벡터의 역할에 대해 묻습니다.

- 정답: 출력 벡터는 각 토큰이 답변의 시작 토큰인지 끝 토큰인지 여부를 예측하는 데 사용됩니다.

- 해설: BERT 기반 질문 응답 시스템에서는 각 토큰에 대해 시작 토큰과 끝 토큰에 대한 확률을 계산합니다. 모델의 출력은 각 토큰에 대한 두 개의 확률 분포를 포함합니다: 하나는 시작 위치, 다른 하나는 끝 위치에 대한 것입니다.

BERT 기반 질문 응답 시스템의 동작 원리

- 입력 처리:

- 입력으로 질문과 문서(또는 문맥)가 주어집니다. 두 입력은 [CLS]와 [SEP] 토큰으로 구분됩니다.

- 예: [CLS] 질문 [SEP] 문서 [SEP]

- 출력 벡터:

- BERT 모델은 각 토큰에 대해 출력 벡터를 생성합니다.

- 출력 벡터는 각 토큰이 답변의 시작 위치인지 끝 위치인지를 예측하는 두 개의 확률 분포를 포함합니다.

- 예측:

- 모델은 각 토큰에 대해 시작 위치 확률과 끝 위치 확률을 예측합니다.

- 가장 높은 확률을 가진 시작 토큰과 끝 토큰을 선택하여 답변을 생성합니다.

예시

입력:

질문: "조지 워싱턴은 언제 태어났나요?" 문서: "조지 워싱턴은 1732년 2월 22일에 태어났습니다."BERT의 출력:

- 각 토큰에 대한 시작 확률과 끝 확률을 계산합니다.

- 예를 들어, "1732년" 토큰의 시작 확률이 가장 높고, "2월 22일" 토큰의 끝 확률이 가장 높다면, 모델은 "1732년 2월 22일"을 답변으로 선택합니다.

결론

제시된 문제는 더 명확하게 작성될 필요가 있습니다. "BERT 기반 질문 응답 시스템에서 각 토큰은 어떤 역할을 하는가?" 대신 "BERT 기반 질문 응답 시스템에서 출력 벡터는 어떤 역할을 하는가?" 또는 "BERT 기반 질문 응답 시스템에서 스페셜 토큰은 어떤 역할을 하는가?"와 같이 구체적으로 물어보는 것이 좋습니다.

- BERT의 토크나이저는?

- 정답: WordPiece

- 해설: WordPiece 토크나이저를 사용합니다.

- 질문 응답 시스템의 정확성을 평가하는 지표는?

- 정답: 정확한 일치

- 해설: 정확한 일치 지표를 사용합니다.

- f1 score도 ㅎㅎ..

- BERT는 어떤 구조를 사용하는가?

- 정답: 트랜스포머 인코더

- 해설: 트랜스포머 인코더를 사용합니다.

- SQuAD 데이터셋은 개발 및 테스트 세트에서 몇 개의 정답을 가지는가?

- 정답: 3개

- 해설: 3개의 정답을 가지고 있습니다.

'인공지능 > 자연어 처리' 카테고리의 다른 글

| 자연어 처리 14강 - Self supervised Learning 2 (0) | 2024.06.05 |

|---|---|

| 자연어 처리 13강 - Self Supervised Learning 1 (1) | 2024.06.04 |

| 자연어 처리 11강 - Named Entity Recognition (NER) + BERT (2) | 2024.06.03 |

| 자연어 처리 10강 - Language Modeling with GPT (0) | 2024.06.03 |

| NLP Python - BERT for Question Answering, Tokenizer, Evaluate(f1 score) (32) | 2024.05.22 |