728x90

728x90

기하학적으로 2차원 벡터 평면로 표현할 수 있다.

그럼 이 둘의 내적은 어떻게 될까?

백터의 크기는 스칼라 값이다.

p의 길이는 v의 그림자 길이와 같다.

부호가 있어서 +도 -도 가질 수 있다.

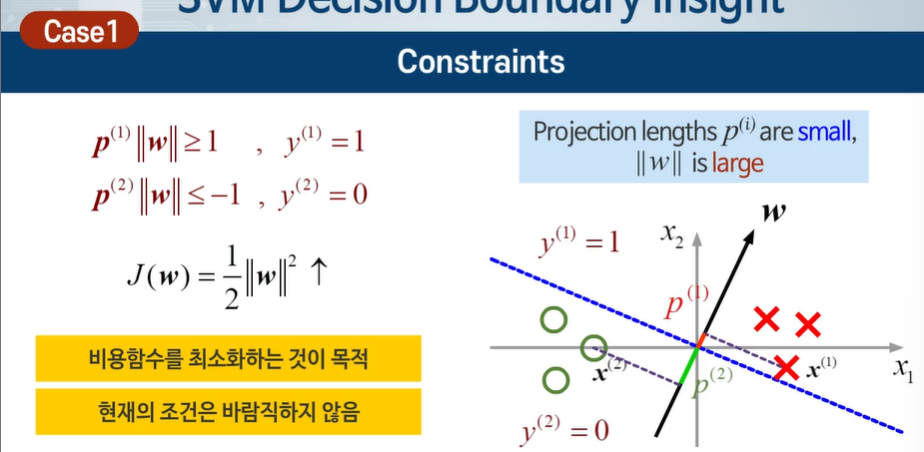

1보다 크다는 것의 의미가 뭘까?

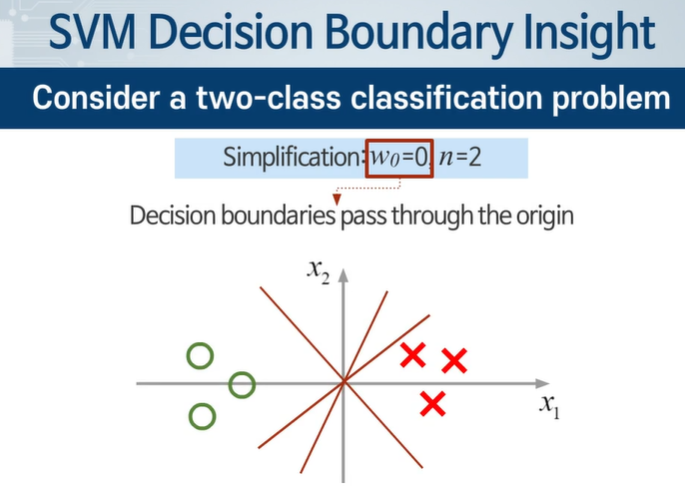

이렇게 되면 원점을 지날 수 밖에 없다.

n = 2라는 것은 2차원 공간이라는 것이다.

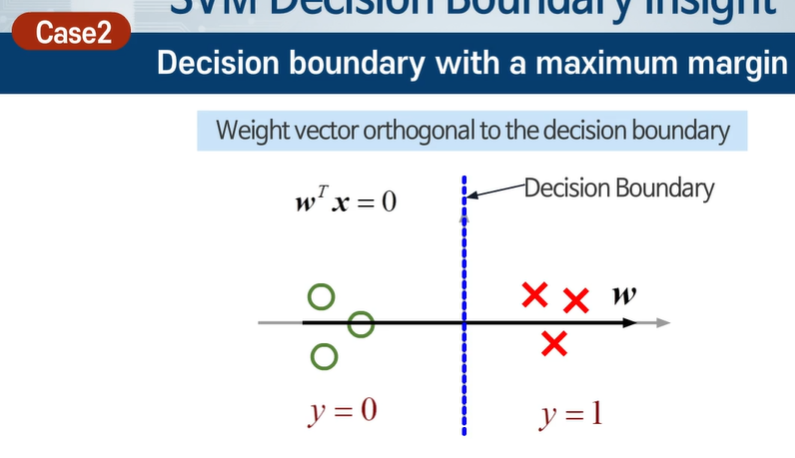

decision 바운더리와 weight는 항상 직교한다.

p와 w는 반비례한다.

w가 커진다면 비용함수가 증가한다!

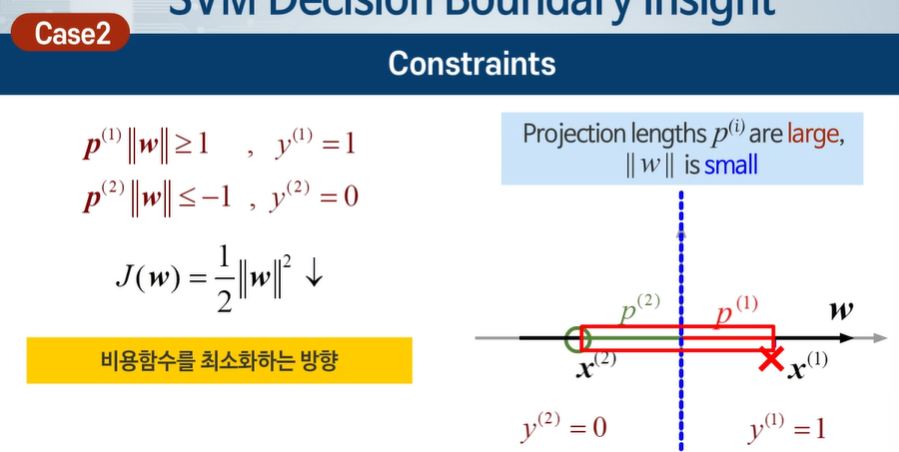

-> p가 커야한다.

이렇게 p가 크다면 w가 작아서 비용함수가 작아진다.

최대 마진 분류 선을 만들어서 일반화 성능이 높다 ! -> 이상적이다.

728x90

'인공지능 > 공부' 카테고리의 다른 글

| 모두를 위한 머신러닝 11주차 5차시 - SVM 적용하기 (0) | 2024.05.18 |

|---|---|

| 모두를 위한 머신러닝 11주차 4차시 - 커널의 개념 (0) | 2024.05.18 |

| 모두를 위한 머신러닝 11주차 2차시 - 최대 마진 개념 (0) | 2024.05.17 |

| 모두를 위한 머신러닝 11주차 1차시 - SVM의 최적화 목적 함수 (0) | 2024.05.17 |

| 인공지능과 빅데이터 15주차 - 딥러닝, 정형데이터 다중 분류 (0) | 2024.05.14 |