마르코프 프로세스 MP = s + P

마르코프 리워드 프로세스 MRP = MP + R + 감쇠인자

리턴 : 에피소드가 끝날때 까지의 보상과 각각의 감쇠 인자를 곱한 것

상태 가치 함수 : 현재 상태의 가치 리턴으로 표현될 수 있다.

마르코프 결정 프로세스 MDP = MRP + a

정책 함수 : 현재 상태에서 어떤 액션을 취해야 할지 정해져 있다.

상태 가치 함수 : 현재 상태의 가치로 리턴으로 표현할 수 있고, 다음 액션을 통해 갈 수 있는 상태의 가시함수의 기대값으로 표현 가능하다.

액션 가치 함수 : 현재 상태에서 액션을 취했을 때의 가치이다. 액션을 통해 갈 수 있는 곳의 상태 가치의 기대값으로 작성할 수 있다.

여러분이 작성하신 내용의 기본적인 아이디어는 올바르나, 조금 더 명확하고 정확하게 표현할 필요가 있습니다. 아래는 몇 가지 수정 제안입니다:

- 마르코프 프로세스 (Markov Process, MP): MP는 상태(state) 집합 ( S )와 전이 확률 ( P )로 정의됩니다. 이 때 ( P )는 현재 상태에서 다음 상태로 전이될 확률을 나타냅니다. 따라서, 정확한 표현은 "마르코프 프로세스 ( MP = (S, P) )"입니다.

- 마르코프 리워드 프로세스 (Markov Reward Process, MRP): MRP는 MP에 보상 함수 ( R )과 감쇠 인자(할인율) ( \gamma )를 추가한 것입니다. 보상 함수 ( R )는 특정 상태, 혹은 상태 전이에 따른 즉각적인 보상을 정의하며, 감쇠 인자는 미래 보상의 현재 가치를 결정합니다. 따라서, 정확한 표현은 "마르코프 리워드 프로세스 ( MRP = (S, P, R, \gamma) )"입니다.

벨만 기대 방정식 : v와 q의 관계 및 정의 식

v로 q 구하기 : 액션을 통해 갈 수 있는 곳의 v의 기대값이다.

q로 v 구하기 : 상태에서 취할 수 있는 액션을 모두 q를 사용해서 기대값 하면 v이다.

v로 v 구하기 : 정책의 모든 액션마다 q가 있을 것이므로 그 큐에 v를 대입한다.

q로 q 구하기 : 액션을 통해 갈수있는 곳의 v의 기대값이므로 그 v에 대한 q식을 넣는다.

여러분이 제공하신 내용에 대한 정리는 강화학습에서 중요한 벨만 방정식의 관계를 설명하려는 시도로 보입니다만, 몇 가지 부분이 명확하지 않거나 혼동을 줄 수 있는 표현이 포함되어 있습니다. 아래에서 이를 개선하여 더 명확하게 표현하겠습니다:

- 벨만 기대 방정식:

벨만 기대 방정식은 현재 상태의 가치 함수 (v)와 액션 가치 함수 (q)의 관계를 설명합니다. 이 방정식은 다음과 같이 정의됩니다:

벨만 최적 방정식 : 최적 정책을 찾기 위한 방정식

v* : v의 최대값으로 최적 정책이면 v가 최대값이 된다.

q* : q의 최대값으로 최대 값으로 가는 액션이면 최대값이 된다..

q* 이용해 v* 계산하기 : 최대값이 되는 액션을 선택한 q

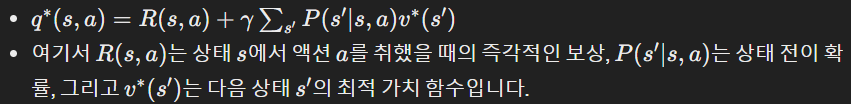

v* 이용해 q* 계산하기 : 액션에 대한 보상을 더하고, 액션에 대한 다음 상태의 v*의 기대값에 감쇠인자 곱하기

v*로 v* 구하기 : v*은 max q이므로 q를 v로 바꾼 식 대입한다.

q*로 q* 구하기 : 여기도 동일하게 대입한다.

여러분이 제공한 정리는 벨만 최적 방정식과 최적 가치 함수 (v^)와 최적 액션 가치 함수 (q^)에 대한 개념을 설명하려는 것 같습니다. 그러나 몇 가지 부분에서 표현이 모호하거나 오해의 소지가 있어 명확한 설명을 추가하겠습니다:

- 벨만 최적 방정식 (Bellman Optimality Equation):

- 벨만 최적 방정식은 최적 정책을 찾기 위한 방정식으로, 이 방정식은 각 상태에서 가능한 최대의 기대 리턴을 계산합니다. 이를 통해 최적 정책을 결정할 수 있습니다.

- v*와 q* 정의:

- v*(s)는 모든 가능한 정책 중 최적의 정책 하에서 상태 (s)의 최대 가치를 나타냅니다.

- q*(s, a)는 상태 (s)에서 액션 (a)를 취했을 때, 모든 가능한 정책 중 최적의 정책 하에서 얻을 수 있는 최대 가치를 나타냅니다.

- q* 이용해 v* 계산하기:

- v*(s) = max_a q*(s, a)

- 이는 상태 (s)에서 취할 수 있는 모든 액션 (a) 중 최대의 q* 값을 선택하는 것입니다.

- v* 이용해 q* 계산하기:

5. v*로 v* 구하기:

- 이 표현은 일반적으로 사용되지 않습니다. 상태 가치 함수 v*_의 계산은 위에서 언급한 벨만 최적 방정식을 통해 q*_를 이용하여 진행됩니다.

6. q*로 q* 구하기:

- q*의 계산 또한 벨만 최적 방정식을 사용하여 갱신됩니다. 이는 위의 q*(s, a) 계산 방식과 동일합니다.

이러한 설명을 통해 각 함수와 방정식이 어떻게 서로 연관되어 있는지를 더 명확하게 이해할 수 있습니다. 벨만 최적 방정식은 강화학습에서 가장 핵심적인 방정식 중 하나로, 최적 정책을 찾는 데 필수적입니다.

반복적 정책 평가 : 일정 정책을 정해두고 v를 계속해서 업데이트 하는 과정

정책 이터레이션 : 일정 정책이 있을 때 v를 수렴하고, 그 v를 통해 최대값이 되는 방향으로 정책을 구하고, 다시 v를 수렴하고 정책 구하는 과정의 반복

벨류 이터레이션 : v의 최대값으로 진행하는 a를 반복하여 단순한 문제를 푼다.

여러분이 작성한 강화학습의 핵심 알고리즘들에 대한 정리는 기본적인 개념은 올바르게 포함하고 있습니다만, 약간 더 명확하고 정확한 설명을 추가하면 도움이 될 것 같습니다. 아래에 각 알고리즘에 대해 수정 및 보완된 설명을 제공합니다:

- 반복적 정책 평가 (Iterative Policy Evaluation):

- 반복적 정책 평가는 주어진 정책 (\pi)에 대해 해당 정책의 상태 가치 함수 (V^\pi)를 추정하는 과정입니다. 이 과정에서 상태 가치 함수는 벨만 기대 방정식을 이용하여 반복적으로 업데이트 됩니다. 이는 주어진 정책의 효율성을 평가하기 위한 단계입니다.

- 수식적으로는 다음과 같이 표현됩니다:

2. 정책 이터레이션 (Policy Iteration):

- 정책 이터레이션은 반복적 정책 평가와 정책 개선 단계를 교대로 반복하는 과정입니다. 먼저, 주어진 정책에 대해 상태 가치 함수를 수렴시킨 후, 이를 기반으로 새로운 정책을 생성합니다. 새로운 정책은 각 상태에서 가치를 최대화하는 액션을 선택하는 것입니다.

- 정책 개선 단계에서는 다음과 같이 새로운 정책을 도출합니다:

3. 벨류 이터레이션 (Value Iteration):

- 벨류 이터레이션은 상태 가치 함수의 수렴을 통해 바로 최적 정책을 도출하는 과정입니다. 이 방법에서는 각 반복에서 상태 가치 함수를 업데이트하면서 바로 최대 가치를 제공하는 액션을 선택합니다. 벨류 이터레이션은 정책 개선과 평가 단계를 명시적으로 분리하지 않고, 하나의 단계에서 수행합니다.

- 수식적으로는 다음과 같이 표현됩니다:

이러한 방법들은 강화학습에서 정책의 최적화를 위한 기본적인 접근 방식들을 나타내며, 각각의 방법은 특정 상황에 따라 더 유용할 수 있습니다. 강화학습 문제의 구조와 특성에 맞게 적절한 방법을 선택하는 것이 중요합니다.

몬테카를로 학습 : 에피소드가 끝날 때 까지 에이전트의 행동을 기억해 놨다가 에피소드가 끝나면 뒤에서부터 v,N을 기록하여 평균내서 사용하거나, 학습률을 두어 일정 부분만 업데이트하는 방식을 사용한다.

TD : 에피소드가 끝나지 않거나 너무 길 때 사용하여 현재 s의 v를 다음 s'의 v를 더하여 업데이트 한다. 이것도 학습률을 통해 일정 부분만 업데이트 한다.

분산 : TD는 잘 못 갈수 있다.MC가 적다.

편향 : MC는 에피소드가 끝나야 되므로 범위가 크다. TD 가 적다.

n스탭 리턴 : 람다만큼 곱해서 더한다.

TD람다 : 일정 스탭을 평균내서 사용하므로 안정적인 TD 사용이 가능하다.

여러분이 제공한 강화학습의 몬테카를로 학습, 시간차 학습(TD), 그리고 TD 람다에 관한 설명은 기본적인 개념을 담고 있지만, 좀 더 명확하고 정확한 설명을 제공하기 위해 수정 및 보완이 필요해 보입니다. 아래에서 각 기술에 대해 자세히 설명하겠습니다:

- 몬테카를로 학습 (Monte Carlo Learning):

- 몬테카를로 학습은 각 에피소드가 완전히 끝난 후에 가치 함수를 업데이트합니다. 에피소드 내의 각 상태에 대해, 에피소드가 제공하는 리턴(반환값)을 기반으로 상태 가치를 추정합니다.

- 업데이트 방식은 보통 누적 보상의 평균을 계산하거나, 각 상태의 방문 횟수 (N)을 기록하여 평균을 내는 방식입니다. 또한, 일정한 학습률 (\alpha)을 사용하여 이전의 가치 추정치를 부분적으로 업데이트할 수도 있습니다.

- 시간차 학습 (Temporal Difference Learning, TD Learning):

- TD 학습은 에피소드가 완전히 끝나지 않아도 현재 상태의 가치를 다음 상태의 가치를 이용하여 업데이트할 수 있는 방법입니다. 이는 몬테카를로 방식과 다르게, 각 스텝마다 가치 함수를 업데이트하며 학습합니다.

- TD(0) 업데이트 공식은 다음과 같습니다:

- 분산과 편향:

- 분산: 몬테카를로 방법은 전체 에피소드의 결과를 사용하기 때문에 분산이 높을 수 있습니다. 반면, TD 학습은 각 스텝마다의 리워드와 추정된 다음 상태의 가치를 사용하기 때문에 상대적으로 분산이 낮을 수 있습니다.

- 편향: TD 학습은 현재의 가치 추정에 의존하기 때문에 초기 추정이 잘못되었다면 편향될 수 있습니다. 몬테카를로 방법은 에피소드가 완전히 끝나야만 업데이트를 수행하기 때문에 시작부터의 추정이 더 안정적이나, 에피소드가 길어질수록 업데이트가 지연됩니다.

- TD(lambda)와 n-스텝 리턴:

- TD(lambda)는 TD(0)과 몬테카를로 사이의 일반화된 방법으로, 여러 스텝에 걸쳐 가중치를 두어 가치를 업데이트합니다. 이는 lambda 매개변수를 사용하여 n-스텝 리턴을 결합하고, 이러한 리턴들을 평균내어 안정적인 학습을 진행합니다.

이와 같은 방식으로 각 기술의 기능과 차이점을 더 명확하게 설명할 수 있으며, 각기 다른 상황에서의 적합한 강화학습 방법을 선택하는 데 도움이 됩니다.

MDP를 모를 때 정책 이터레이션을 사용할 수 없는 이유: P를 모르기 때문에 v를 계산할 수 없기 때문이다.

해결 방법 3가지: 1. MC를 이용하여 v를 구한다. 2. q를 계산한다. 3. 입실론 그리디를 사용하여 최적 정책을 그린다.

몬테카를로 컨트롤 : MC와 비슷하다. 끝까지 경험 후에 업데이트하는 방식

SARSA : 정책에 따른 액션을 가지고, 한스텝마다 q를 업데이트 한다. 이 후에 최대 q를 가지는 a를 통해 정책을 개선한다.

Q 러닝 : 최대 q를 가지는 a을 선택해서 움직인다.

여러분이 제공한 설명은 강화학습의 주요 개념과 방법들에 대해 언급하고 있지만, 일부 명확하지 않거나 부정확한 부분이 있습니다. 각 방법에 대해 보다 명확하고 정확한 설명을 제공하겠습니다:

- MDP를 모를 때 정책 이터레이션을 사용할 수 없는 이유:

- 정책 이터레이션은 주어진 정책 하에서의 상태 가치 함수 ( V^\pi(s) )를 계산하고, 이를 기반으로 정책을 개선하는 과정입니다. 상태 전이 확률 ( P )를 알아야 벨만 기대 방정식을 사용하여 ( V^\pi(s) )를 계산할 수 있습니다. 만약 ( P )를 모른다면, 상태 가치 함수를 계산할 수 없어 정책 이터레이션을 직접적으로 적용하기 어렵습니다.

- 해결 방법 3가지:

- 몬테카를로 방법을 이용하여 V(s) 구하기: 몬테카를로 방법을 사용하여 각 상태의 가치를 에피소드가 끝날 때까지의 반환값으로 추정할 수 있습니다. 이는 전이 확률을 필요로 하지 않습니다.

- Q(s, a) 계산하기: Q-값 기반의 학습 방법들(예: Q-러닝, SARSA)을 사용하여 직접 Q-함수를 추정할 수 있으며, 이는 각 상태-행동 쌍의 가치를 나타냅니다.

- 입실론-그리디 알고리즘을 사용하여 정책 탐색하기: 탐색과 이용 사이의 균형을 맞추기 위해 입실론-그리디 알고리즘을 사용하여 정책을 실행하면서 데이터를 수집하고 최적화할 수 있습니다.

- 몬테카를로 컨트롤:

- 몬테카를로 컨트롤은 에피소드가 완전히 끝난 후에 상태-행동 쌍의 Q-값을 업데이트합니다. 이 방법은 각 에피소드를 통해 얻은 경험을 기반으로 최적 정책을 점진적으로 개선합니다.

- SARSA:

- SARSA는 온-폴리시(on-policy) 학습 알고리즘으로, 현재 정책에 따라 행동을 선택하고, 선택된 행동에 기반해 Q-값을 업데이트합니다. 이후 Q -값을 기반으로 정책을 개선할 수 있습니다. SARSA의 업데이트 공식은 다음과 같습니다:

- SARSA는 온-폴리시(on-policy) 학습 알고리즘으로, 현재 정책에 따라 행동을 선택하고, 선택된 행동에 기반해 Q-값을 업데이트합니다. 이후 Q -값을 기반으로 정책을 개선할 수 있습니다. SARSA의 업데이트 공식은 다음과 같습니다:

- Q-러닝:

- Q-러닝은 오프-폴리시(off-policy) 학습 알고리즘으로, 실제로 선택한 행동과 관계없이 가능한 최대 Q-값을 기반으로 Q-값을 업데이트합니다. 이는 최적의 행동을 찾기 위해 최대 Q-값을 가진 행동을 선택하여 움직입니다. Q-러닝의 업데이트 공식은 다음과 같습니다:

- Q-러닝은 오프-폴리시(off-policy) 학습 알고리즘으로, 실제로 선택한 행동과 관계없이 가능한 최대 Q-값을 기반으로 Q-값을 업데이트합니다. 이는 최적의 행동을 찾기 위해 최대 Q-값을 가진 행동을 선택하여 움직입니다. Q-러닝의 업데이트 공식은 다음과 같습니다:

이러한 설명을 통해 각 학습 방법의 목적과 작동 방식을 보다 명확하게 이해할 수 있습니다. 각각의 방법은 특정 상황과 요구에 따라 선택적으로 사용될 수 있습니다.

'인공지능 > 공부' 카테고리의 다른 글

| 강화학습 - TD에서 s'을 언제 업데이트 해야 할까? (0) | 2024.04.23 |

|---|---|

| 강화학습 암기할 내용들 (0) | 2024.04.23 |

| 벨만 방정식, Q러닝, 반복적 정책 평가, SARSA, TD, MC 대략적 개념 (0) | 2024.04.23 |

| 강화학습 퀴즈 - MDP, 벨만 방정식, 플래닝, 정책 평가, 정책 개선... with ChatGpt (0) | 2024.04.22 |

| 딥러닝개론 정리 2 - Convolution, CNN, 합성곱 (0) | 2024.04.22 |