728x90

728x90

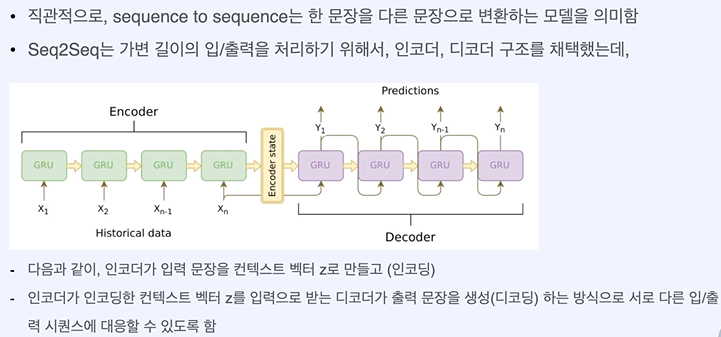

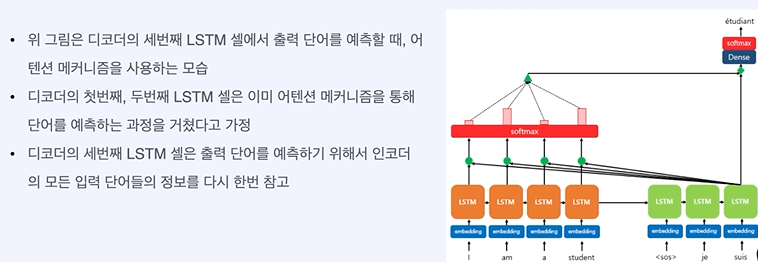

seq2seq - RNN기반 모델 = vanishing gradient problem, 고정된 벡터에 모든 정보 압축하다 보니 정보 손실 발생

이 구조는 입력 문장이 길면 품질이 떨어지게 된다! -> attention 등장

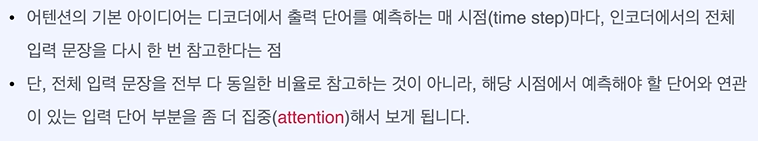

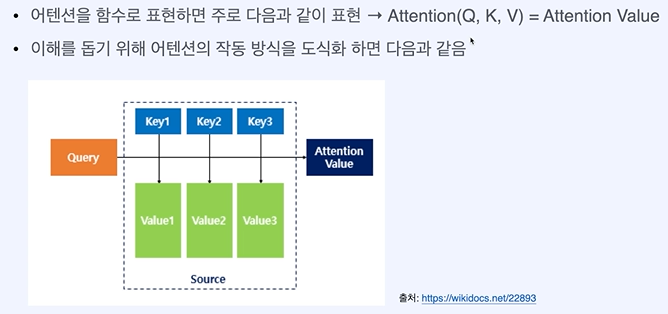

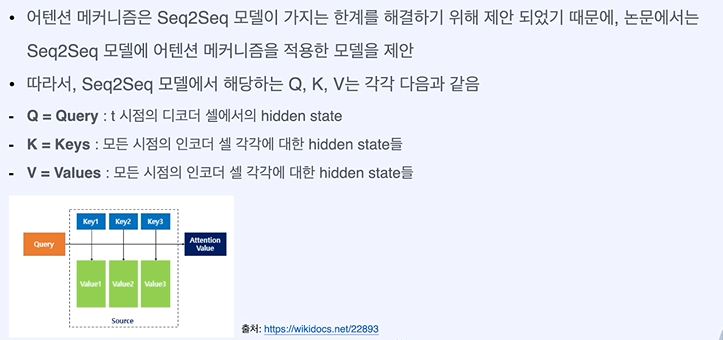

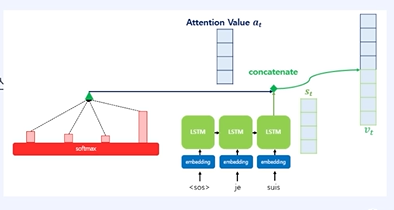

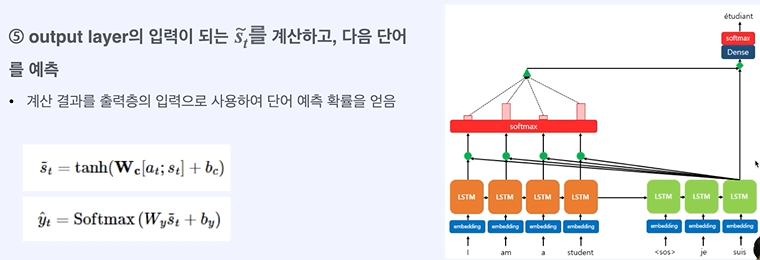

attention value - 단어가 얼마나 중요하냐

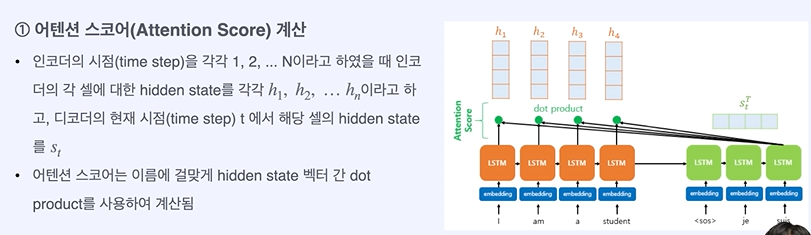

query - 입력

key - 모든 말 뭉치들

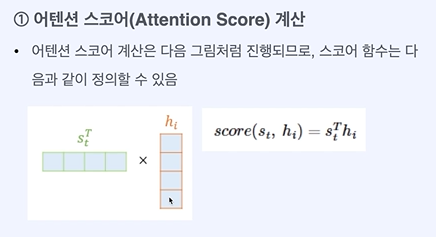

저거 각각 내적하면 유사도가 나온다.

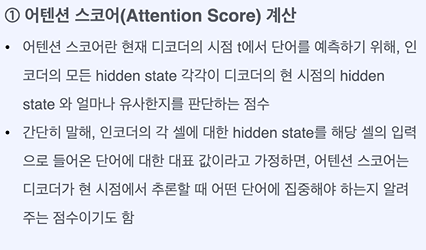

스코어 = 유사도 - 유사하면 가중치를 크게 주겠다.

스칼라 점수가 튀어나온다. == 어텐션 스코어

합을 1로 만들어 주는 과정이다.

단어 각각을 어느정도 볼 것이냐

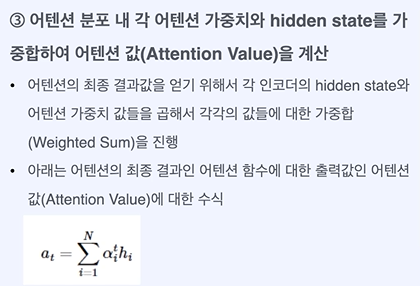

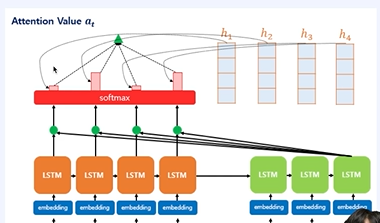

여기서 h1은 인코더의 hidden state이다.

임베딩 차원 만큼의 결과가 나온다.

가중치를 곱하여 입력 차원을 맞춰준다.

attention의 등장 BUT RNN을 기반으로 사용한 모델은 입력을 순차적으로 처리하기 때문에 병렬화가 안된다는 문제 발생

attention만으로 모델을 만들어보자 ->

728x90

'인공지능 > 공부' 카테고리의 다른 글

| 고급 인공지능 활용 hw 1 - 단순 파이썬, numpy (0) | 2024.04.13 |

|---|---|

| transformer, attention 정리 3 (0) | 2024.04.11 |

| attention, Transformer 정리 1 (0) | 2024.04.11 |

| 생성형 인공지능 입문 6주차 퀴즈 (1) | 2024.04.10 |

| 생성형 인공지능 입문 6주차 5차시 - 휴먼 피드백 학습 (0) | 2024.04.10 |