728x90

728x90

경사 하강법!

최솟값에 도달할 때까지 진행하게 된다.

이와 같이 최솟값을 구하고 있다.

경사 하강법 = Gradient Descent Algorithm

코드로 바꾸기 위해 수도 코드로 작성해보자

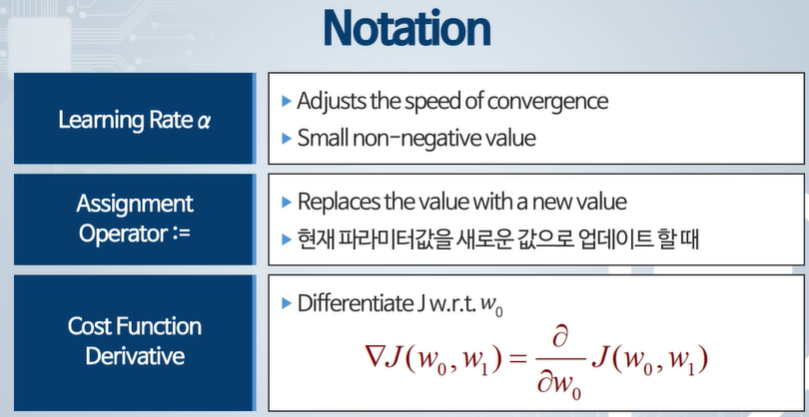

Learning rate == 학습률 - 적당한 값이 필요하다.

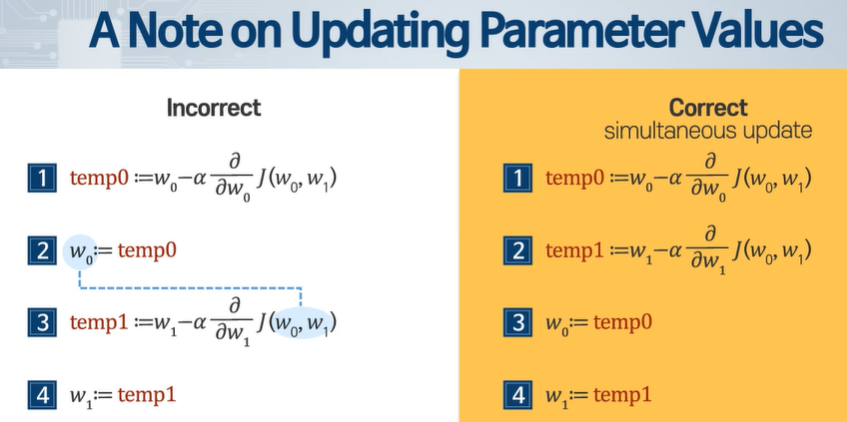

:= 업데이트 기호이다!

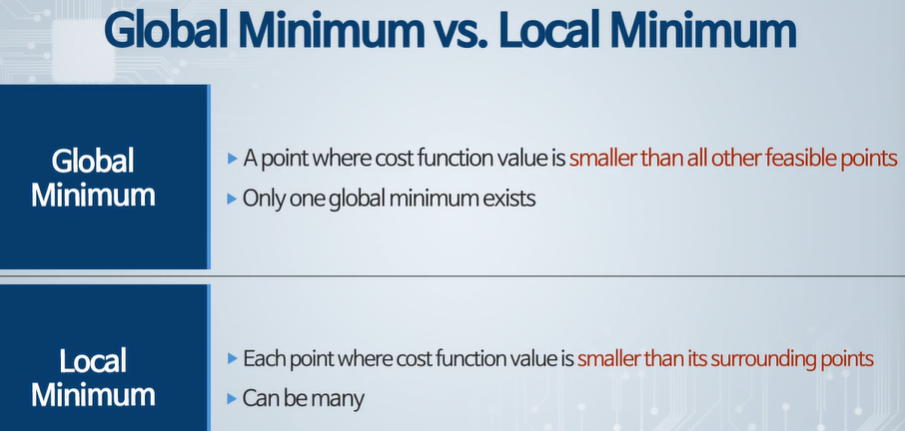

전역 최소 - 제일 작은 값

국소 최소 - 주변에서 작은 값

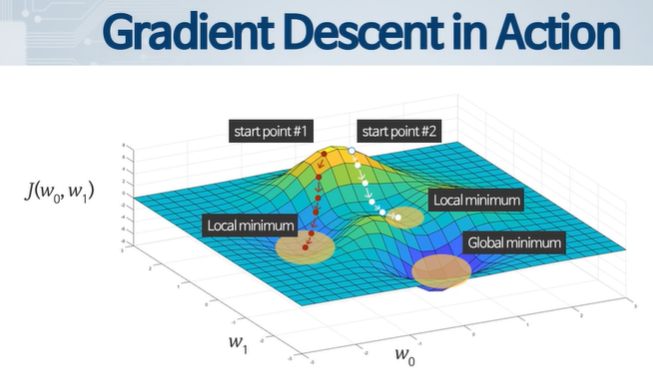

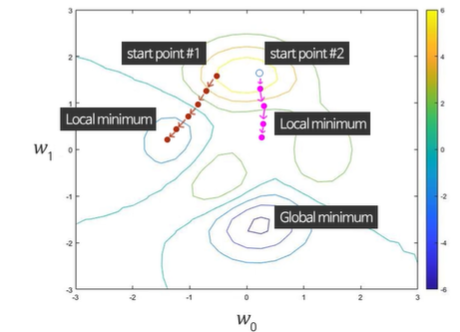

두 경우 모두 전역 최솟값으로 도달하지 못하였고, 초기 값에 의해 영향받는 다는 것을 알 수 있다.

이건 optimizer를 통해 조금 극복할 수 있다.

이상하게 업데이트 되는 경우가 생길 수 있다.

728x90

'인공지능 > 공부' 카테고리의 다른 글

| 머신러닝 2주차 5 - 경사 하강과 선형 회귀 (0) | 2024.03.12 |

|---|---|

| 머신러닝 2주차 4 - 경사 하강 개념 (0) | 2024.03.12 |

| 머신러닝 2주차 2 - 비용함수 Cost Function (0) | 2024.03.12 |

| 머신러닝 2주차 1 - 선형회귀 (0) | 2024.03.12 |

| 생성형 인공지능 퀴즈 2 (0) | 2024.03.11 |