728x90

728x90

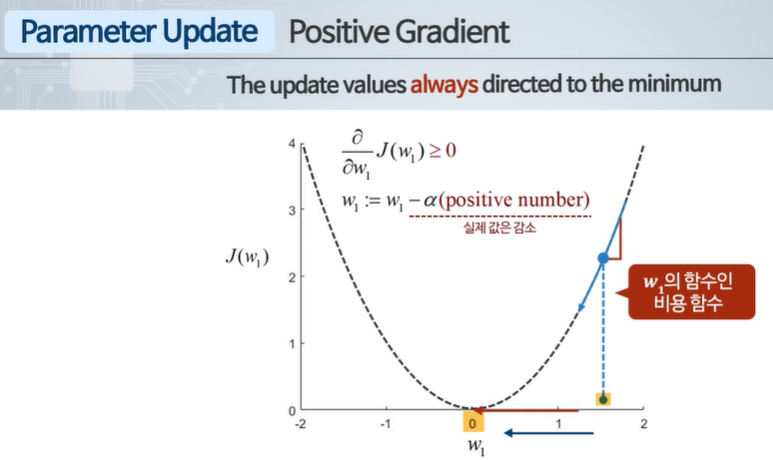

경사 하강법 - 단계적으로 최솟값에 다가가기 위해 기울기 미분값을 빼는 방식으로 업데이트

Learning Rate!

너무 작으면 학습하는데 너무 오래걸린다.

너무 크면 오버슈팅이 발생하여 발산할 수 있다.

local optimum에 도달하면 도함수 값이 0이 되며 업데이트가 멈추게 된다.

728x90

'인공지능 > 공부' 카테고리의 다른 글

| 머신러닝 퀴즈 1 (0) | 2024.03.12 |

|---|---|

| 머신러닝 2주차 5 - 경사 하강과 선형 회귀 (0) | 2024.03.12 |

| 머신러닝 2주차 3 - 경사 하강 Gradient descent (0) | 2024.03.12 |

| 머신러닝 2주차 2 - 비용함수 Cost Function (0) | 2024.03.12 |

| 머신러닝 2주차 1 - 선형회귀 (0) | 2024.03.12 |