objective = 모델이 학습하려고 하는 바

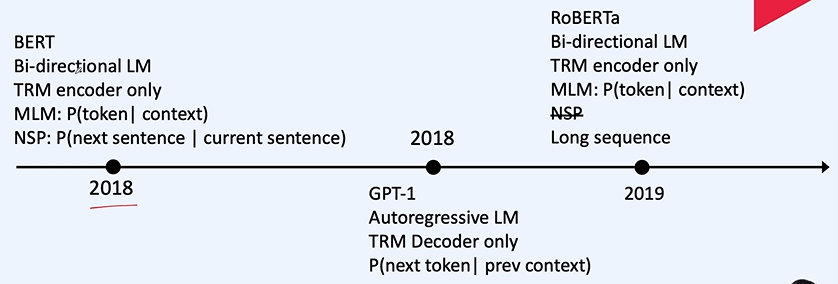

MLM = 컨텍스트들이 마스킹 되어 있다. 마스킹 된 것을 예측한다! 한 단어를 예측할 때 주변을 다 보고 예측한다.

NSP = 이전문장과 다음 문장이 이어지면 1, 아니면 0으로 풀게 된다.

BERT = MLM + NSP 문장에 대한 특징을 잘 추출, 언어를 잘 이해하게 되어 파인튜닝시 잘 이해한다.

실무적으로 아직 잘 사용되고 있다.

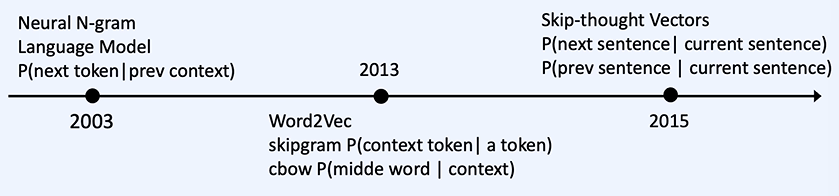

GPT - 1 = 단방향! 미래는 볼 수 없다. 고전적인 학습 방법을 이용한다.

RoBERTa : Long sequence!!

GPT - 2: 1버전 보다 더 커졌다.

T5 - 입력에 대해 토큰들로 치환하여 디코더에서 치환된 영역이 다시 생성된다! 모든 일을 자연어로 풀게한다-> 요즘의 트렌드

MTDNN - MS

ELECTRA

TRM enc처럼 생겼다.학습에 사용!

입력의 토큰을 대체하여 토큰의 위치를 예측하도록 학습된다.

REALM

Retriever 문서에 마스크를 씌우고 이 것을 사용 -> Retriever을 맞춰라!

ExT5 - google

PaLM - Google

MOE - 모델의 스케일링을 굉장히 키웠다.

강화학습도 활용!

제일 처음에 분류를 해준다!

질문과 정답에 대한 위치를 찾아서 출력

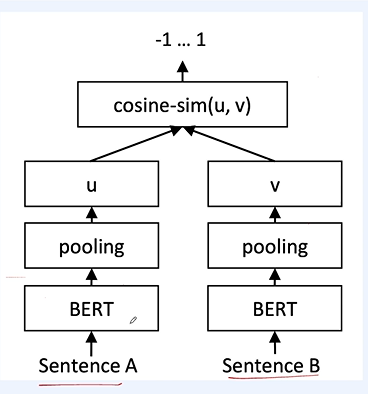

이 것으론 문장의 유사도 검증 X

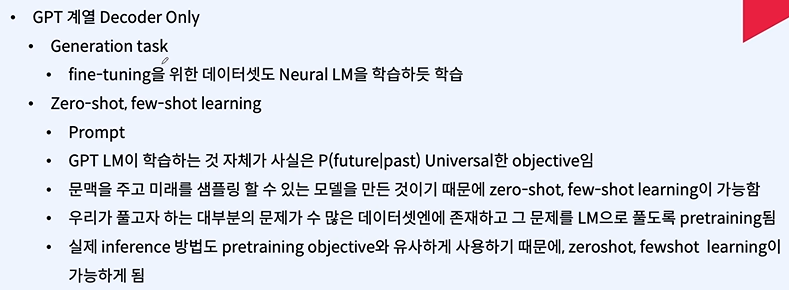

Prompt - 모델의 지시사항

Zero shot- 지시사항만 두고 풀기

few-shot learning - 지시사항과 샘플을 주고 풀기

'인공지능 > 자연어 처리' 카테고리의 다른 글

| 자연어 처리 python 실습 - Neural Language model 구현 (3) | 2024.03.01 |

|---|---|

| 자연어 처리 python 실습 - N gram language model (0) | 2024.03.01 |

| 자연어 처리 python - skip thought vector (0) | 2024.03.01 |

| 자연어 처리 - Neural language modeling 2 (0) | 2024.02.21 |

| 자연어 처리 - Neural language modeling 1 (0) | 2024.02.20 |