좀 더 넓은 범위를 보게 된다. 그러나 연산량은 동일하다.

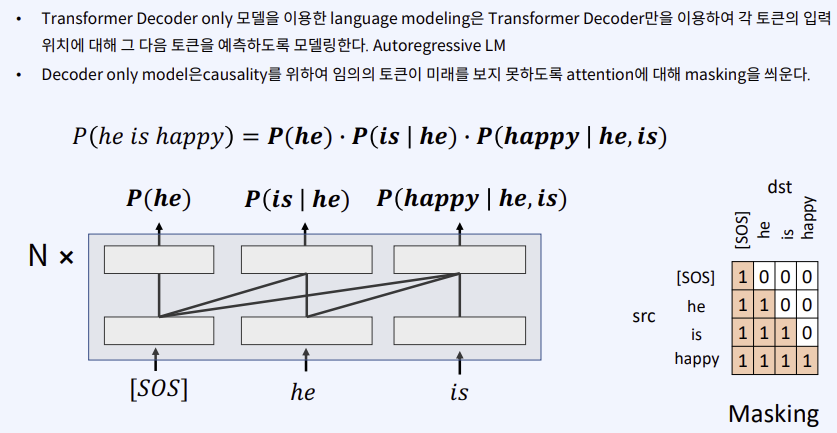

미래값은 포함하지 않는다!

순서를 가지고 오기 때문에 RNN이 가장 좋아 보이긴 한다.

2024.01.17 - [인공지능/자연어 처리] - 자연어 처리 - RNN, LSTM

자연어 처리 - RNN, LSTM

RNN 우린 이 점선으로 된 부분을 예측해야 한다. 그냥 MLP를 사용하면 현재 데이터나 과거 데이터나 신경쓰지 않는다. CNN은 패턴을 잡는 모델이라 순서를 신경쓰지 않아 문제가 생긴다. 시간의 순

yoonschallenge.tistory.com

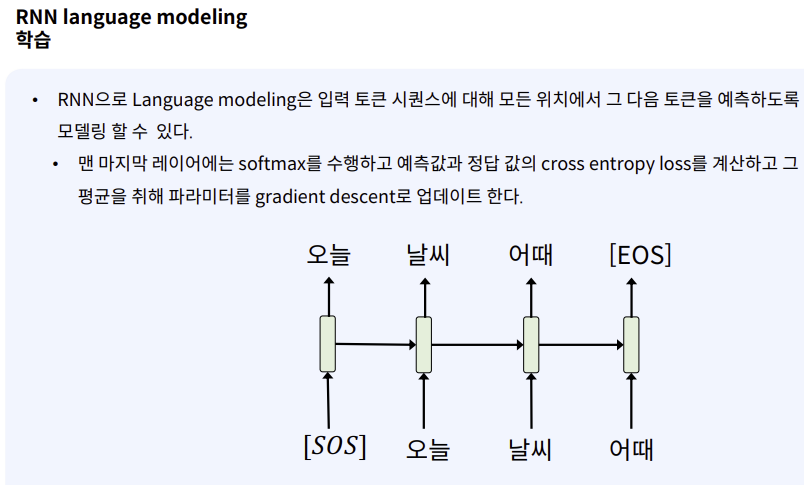

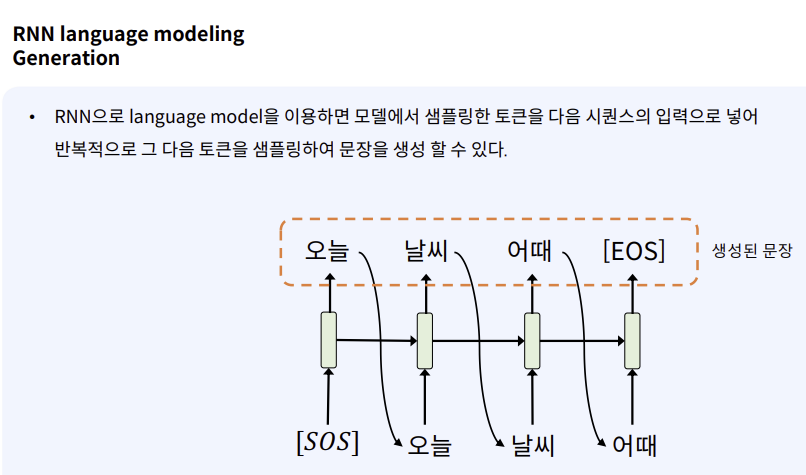

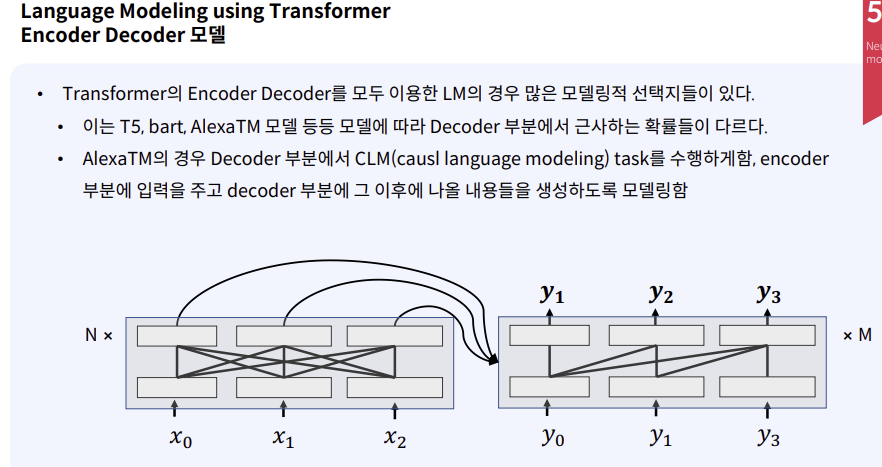

SOS? : start of santence 문장의 시작

EOS : end of santence 문장의 끝

오늘보다 더 높은 확률이 있지만 오늘이 선택되기 때문에 '오늘'의 확률을 보게 된다.

sos를 넣었을 때 가장 확률 높은 토큰이 오늘인 것이다!

그리고 계속 입력으로 집어넣고, 확률 높은 것을 계속 고르게 된다.

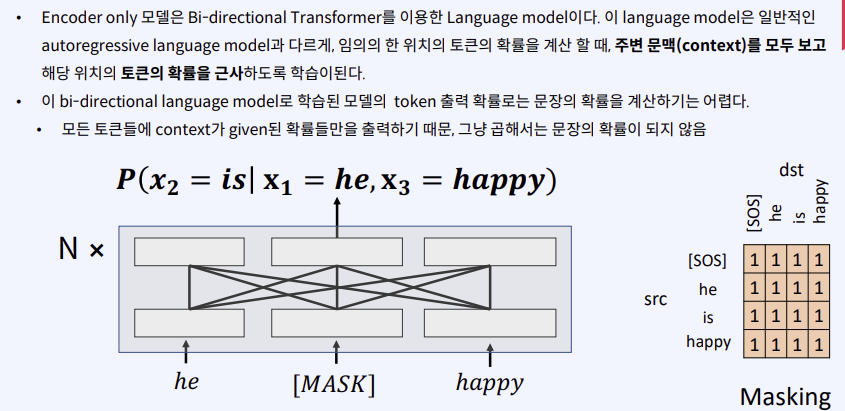

마스킹을 이용해 미래의 단어는 확인하지 못한다! 과거의 정보만 확인할 수 있다.

학습시에는 모든 정보를 다 가지고 정답이 나올 확률을 통해 경사하강법을 진행하게 된다.

p(x1),P(x2|x1)이 없기 때문에 문장의 확률이 아니다.

'인공지능 > 자연어 처리' 카테고리의 다른 글

| 자연어 처리 python - 최신 Language model들과 활용법 (0) | 2024.03.01 |

|---|---|

| 자연어 처리 python - skip thought vector (0) | 2024.03.01 |

| 자연어 처리 - Neural language modeling 1 (0) | 2024.02.20 |

| 자연어 처리 - N Gram language modeling (0) | 2024.02.16 |

| 자연어 처리 - Autoregressive language modeling (0) | 2024.02.15 |