728x90

728x90

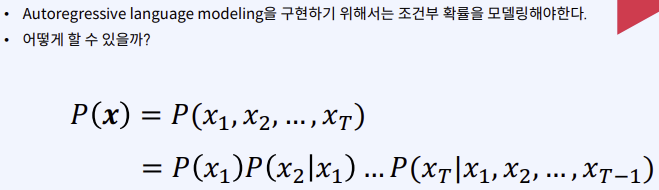

2024.02.15 - [인공지능/자연어 처리] - 자연어 처리 - Autoregressive language modeling

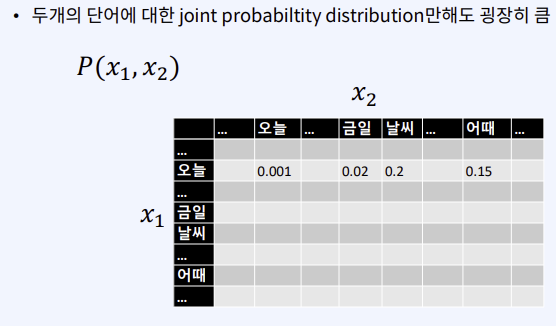

제곱 크기 만큼의 숫자가 생긴다.

공간, 용량이 과하게 필요하게 된다. == 비용!!!!

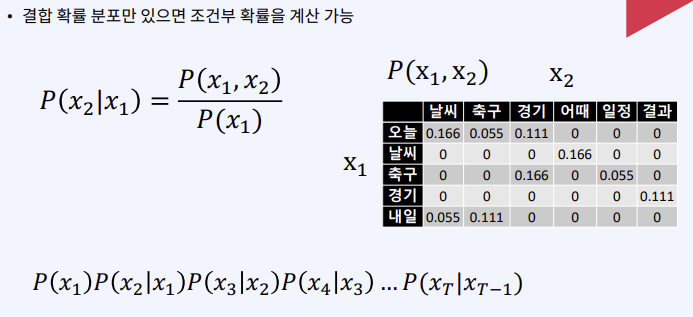

가정을 주어서 토큰을 완화시킨다.

(원래는 같지 않지만)이전타임을 다 쓰지 않아도 직전만 사용해도 유사할 것이라고 가정하는 것이다.

확률과 카운트는 비례하기 때문에 하나만 알아도 됨!

P(날씨|오늘) = 0.166/0.333 = 0.166/(0.166 + 0.111 + 0.055)

P(날씨|오늘) = 3/(3+1+2)

하나가 0이라면 전체가 0이 되는 문제가 생긴다.

adam optimizer에서도 본 경우다!

2023.12.16 - [인공지능/공부] - 인공지능 backpropagation, optimization- 개념

인공지능 backpropagation, optimization- 개념

backpropagation backpropagation은 대부분의 인공지능의 파라미터 업데이트 방식이다. 우린 경사하강법을 통해 loss를 최소화 시키는 방향으로 학습한다. 기본적인 gradient 계산 방법이다. 이제 activation fun

yoonschallenge.tistory.com

728x90

'인공지능 > 자연어 처리' 카테고리의 다른 글

| 자연어 처리 - Neural language modeling 2 (0) | 2024.02.21 |

|---|---|

| 자연어 처리 - Neural language modeling 1 (0) | 2024.02.20 |

| 자연어 처리 - Autoregressive language modeling (0) | 2024.02.15 |

| 자연어 처리 - 문장의 그럴듯함을 측정하는 방법 (0) | 2024.02.15 |

| 자연어 처리 -CNN을 사용한 실습, self- attention 실습 (1) | 2024.02.15 |