728x90

728x90

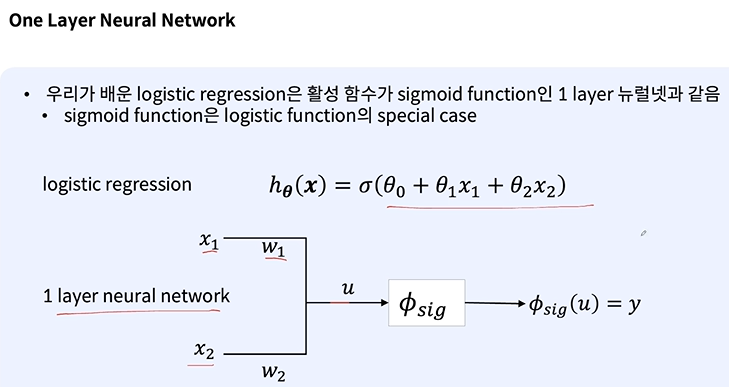

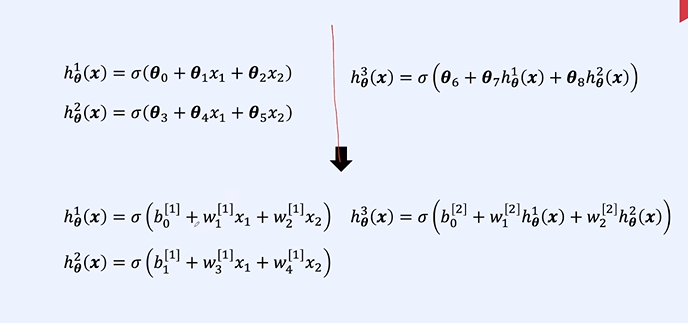

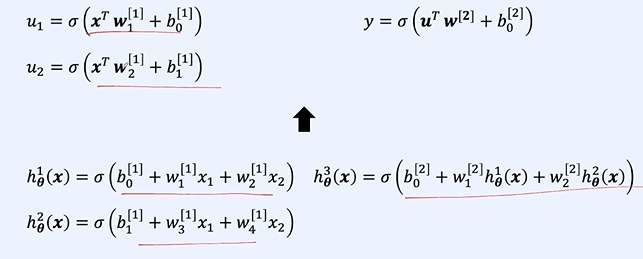

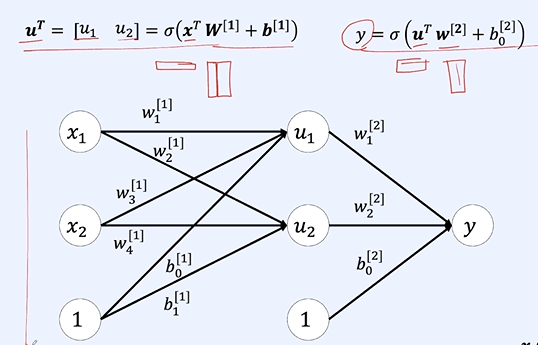

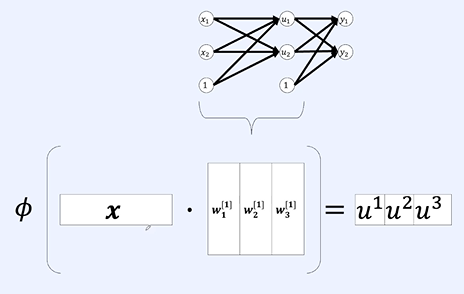

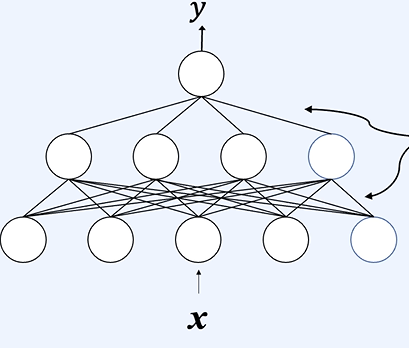

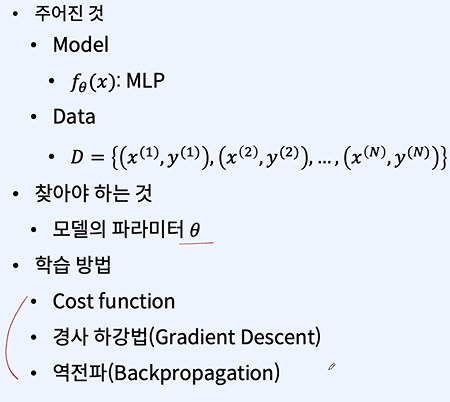

MLP

이것도 블로그 내에 엄청 자주 나오던 내용이다.

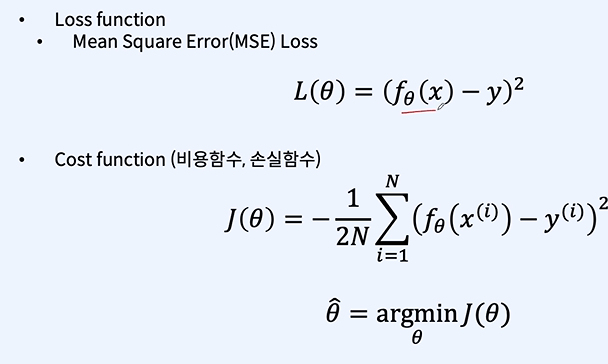

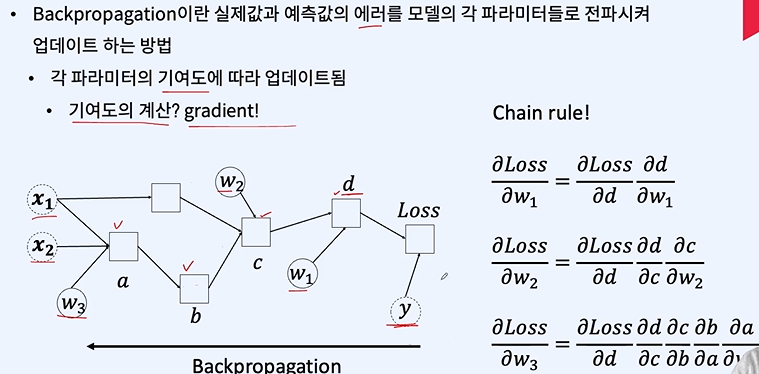

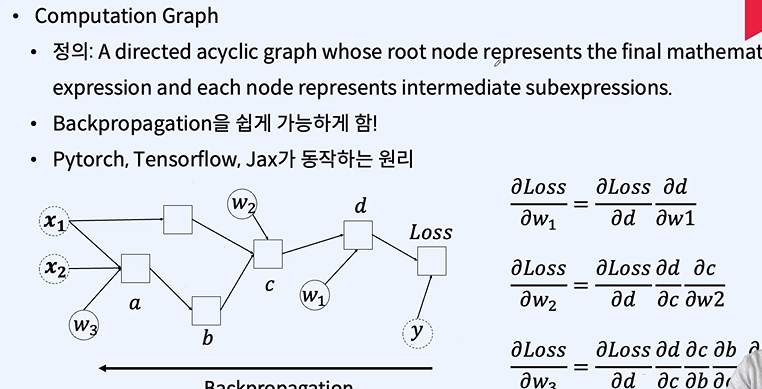

모델 최적화

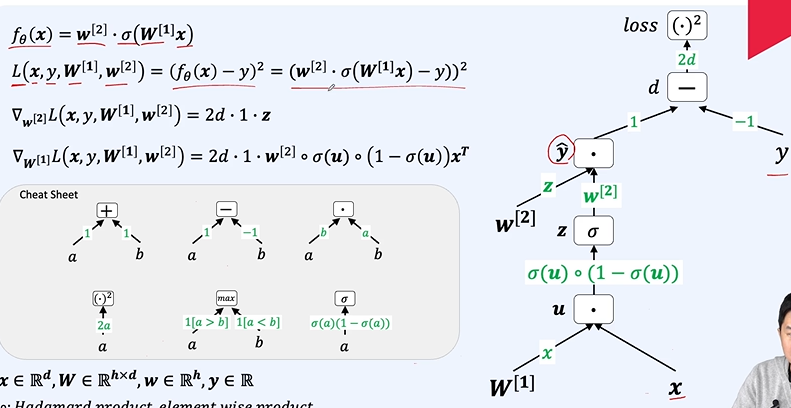

각각의 미분값들을 계산해 놓아서 저장된 값을 빠르게 사용하여 중복 계산을 막는다.

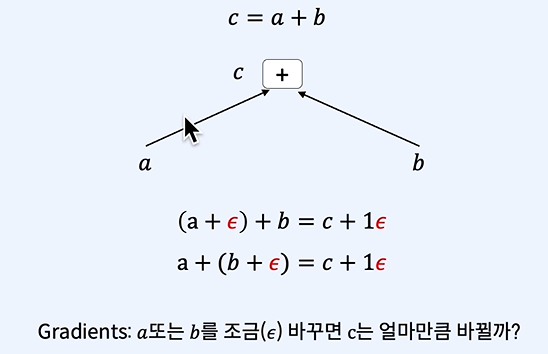

여기선 다 1이다. ( 변하는 만큼 변한다.)

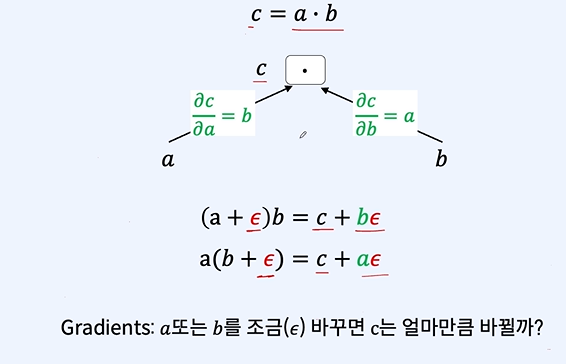

곱하기에선 비율만큼 움직인다.

b는 a의 제곱이니까 넣으면 알 수 있다.

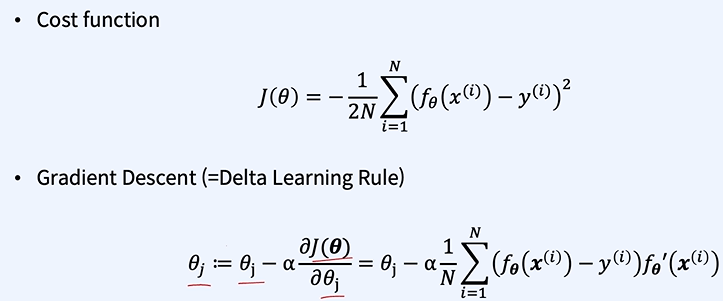

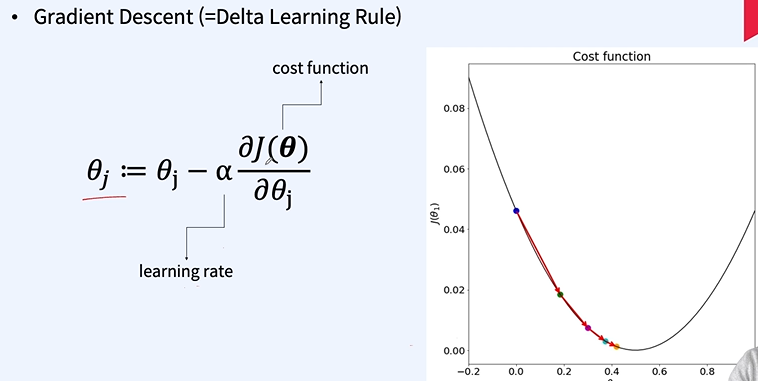

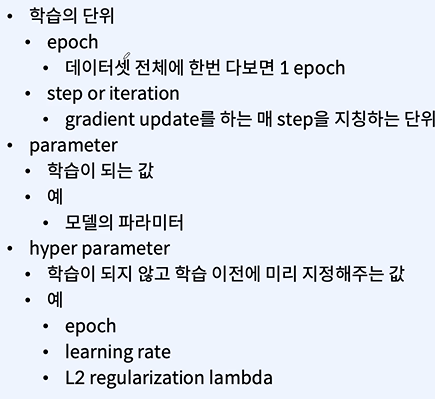

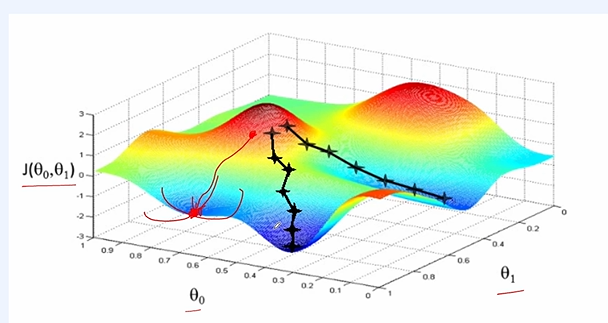

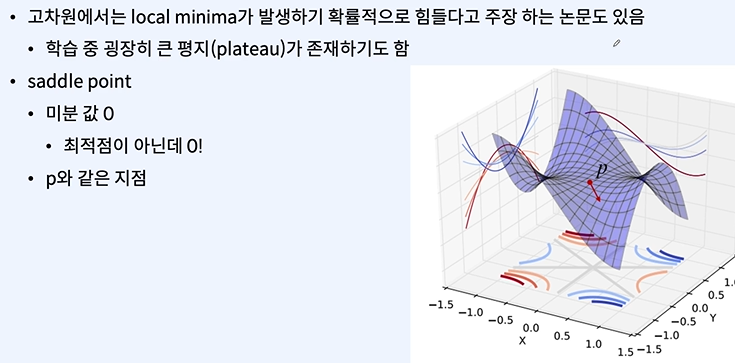

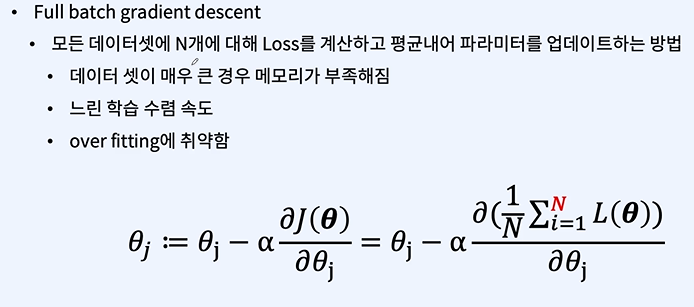

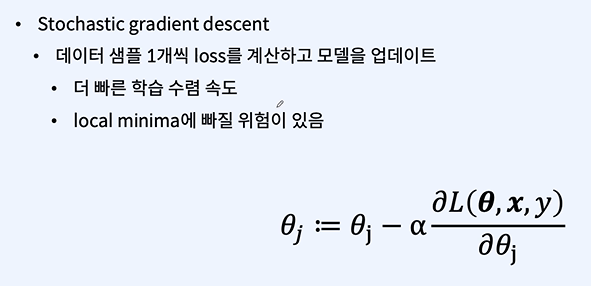

Gradient Descent

728x90

'인공지능 > 자연어 처리' 카테고리의 다른 글

| 자연어 처리 - 과적합 방지 (0) | 2024.01.17 |

|---|---|

| 자연어 처리 - multi classification, soft max (0) | 2024.01.17 |

| 자연어 처리 - 인공지능 선형대수, 인공 신경망 (0) | 2024.01.15 |

| 자연어 처리 - 비용 함수 이해하기 (2) | 2024.01.09 |

| 자연어 처리 - Linear Regression 선형 회귀, Cost function 비용함수 실습 (1) | 2024.01.09 |