https://aclanthology.org/2025.emnlp-main.36/

CODI: Compressing Chain-of-Thought into Continuous Space via Self-Distillation

Zhenyi Shen, Hanqi Yan, Linhai Zhang, Zhanghao Hu, Yali Du, Yulan He. Proceedings of the 2025 Conference on Empirical Methods in Natural Language Processing. 2025.

aclanthology.org

emnlp 2025 main에 붙었네요

기존 CoT는 토큰 사용량이 너무 많았고, Coconut는 단계적 치환을 통해 latent로 바꾸는데 stage간 망각 가능성을 제시함

추론 능력을 연속 공간으로 압축해도 학습 신호를 주면 explicit CoT 성능에 도달할 수 있음!

Teacher는 Explicit CoT를 진행하며 CoT 토큰과 정답 토큰을 학습하고, Student는 Implicit CoT를 진행하여 언어 토큰 생성 없이 hidden state를 생성하고, eot를 통해 답을 말하게 됨

이게 되는건 CoT가 답 생성 직전 토큰인 ':'의 hidden state을 특정 방향으로 shift 시킨다고 보고 여기에 CoT 정보가 담겼다고 봄

그래서 이 ':' 를 맞추도록 KD 학습

여기도 n개가 고정되긴 하네요...

CoT Path는 gpt 4o mini로 했다고 하네요

왜 CoT SFT 보다 높은가 싶기는 한데....

KD를 제거한 실험에서 성능 급락을 통해 KD가 필수임을 보여줌

teacher와 student를 분리한 것도 성능 하락함

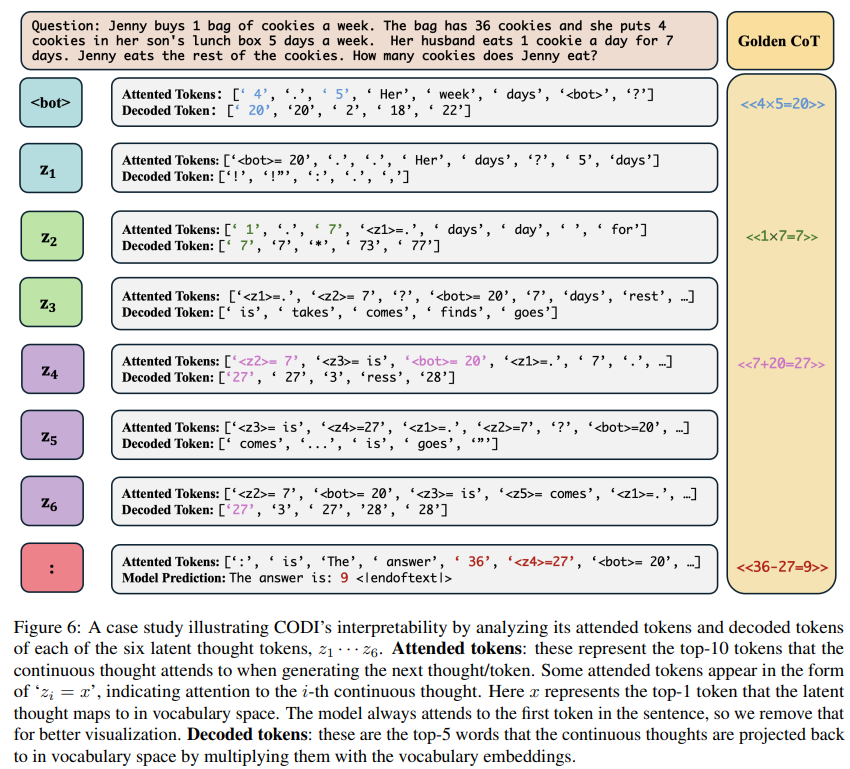

lm head를 통해 중간 결과를 확인했을 때 연산하는 과정 토큰이 섞여있음

| 한 줄 결론 | 자연어 CoT(Explicit)를 연속(latent) 공간의 짧은 thought로 “압축”하되, self-distillation(teacher↔student hidden state 정렬)로 추론 능력을 전이해 implicit CoT가 explicit CoT 성능에 도달하게 만든다. |

| 문제의식 | CoT는 성능을 올리지만 토큰 비용이 크고(비효율), 언어적 모사로 과적합 가능. 기존 implicit CoT는 언어를 우회하려 했으나 CoT-SFT 대비 성능 격차가 큼 (특히 curriculum 기반 Coconut은 stage 간 forgetting 가능). |

| 핵심 아이디어 | 동일 LLM에서 (1) Teacher: explicit CoT 생성(CE) + (2) Student: continuous thought 후 답 생성(CE)을 공동 학습하고, 답 직전 특정 토큰(기본 ‘:’)의 hidden activation을 층별로 L1 정렬하여 reasoning을 latent로 distill. |

| 모델/학습 설계 | 목적함수 L = α·L_student + β·L_KD + γ·L_teacher. Student는 <bot>에서 시작해 n개의 continuous thought를 hidden-state propagation으로 만들고 <eot>로 답 생성 모드로 전환. continuous thought에는 2-layer MLP+LN projection을 적용. Distillation은 stop-grad teacher로 one-way 전이. |

| Distillation 근거 | CoT가 “답 직전 토큰(예: ‘The answer is:’의 ‘:’)” hidden을 shift시키며, 그 shift에 reasoning 정보가 담긴다는 관점(“CoT shift” 정당화). 그래서 해당 토큰 hidden만 정렬해도 효과적이라고 주장. |

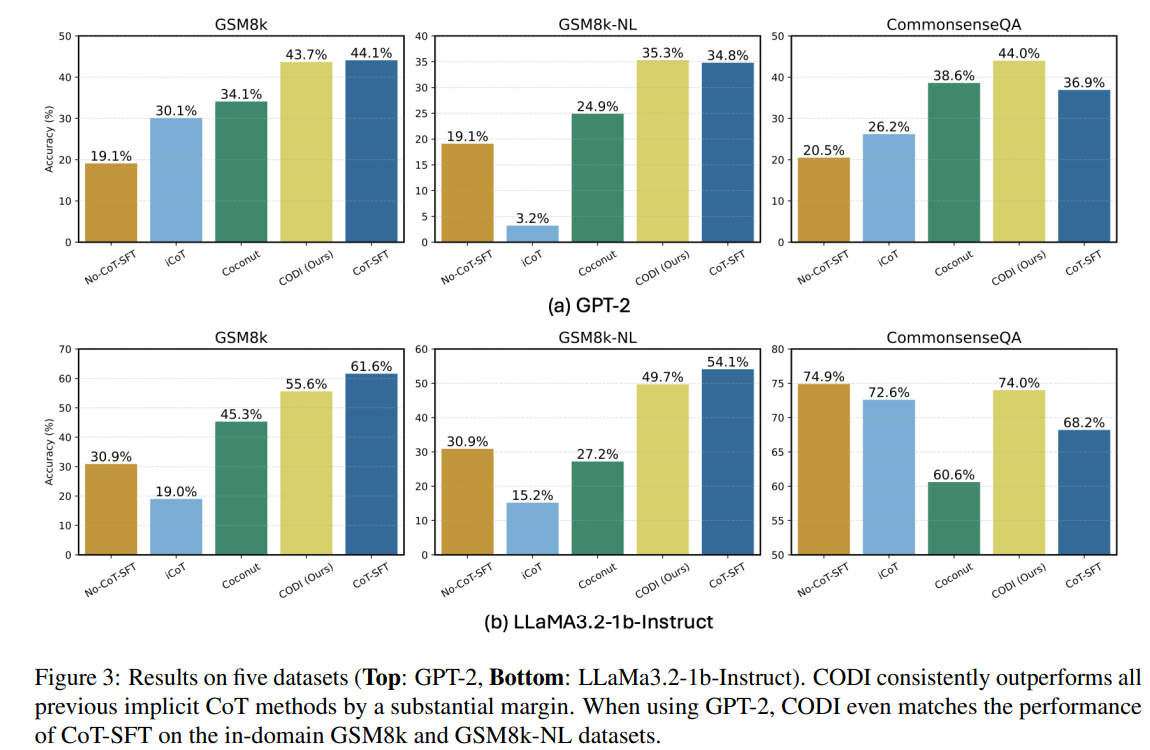

| 데이터/비교 | 학습: GSM8k-Aug / GSM8k-Aug-NL / CommonsenseQA-CoT(자체 생성). 비교: No-CoT-SFT, CoT-SFT, iCoT, Coconut, CODI. |

| 메인 성과(성능) | GPT-2 스케일에서 GSM8k에서 CoT-SFT 성능에 “매칭(99%)”했다고 보고. Coconut 등 기존 implicit CoT 대비 큰 폭 향상(본문 요약). |

| 메인 성과(효율) | 6개 continuous thought(+bot/eot=총 8 토큰)로 reasoning 길이를 고정해, GSM8k-Aug에서 ~3.1× 압축/~2.7× 속도, GSM8k-Aug-NL에서 ~8.2× 압축/~5.9× 속도를 보고(A100, bs=1). |

| 견고성(OOD) | GSM8k-Aug로 학습 후 SVAMP/GSM-Hard/MultiArith에서 implicit CoT 중 최고, GPT-2에서는 CoT-SFT도 일부 상회. 해석: token-level CoT 모사가 없어 과적합 감소. |

| Ablation 핵심 | L1(KD) 제거 시 급락, 분리된 static teacher도 성능 하락(reference learning 중요). CoT 마지막 step 포함 시 성능 악화(answer-copy shortcut). projection 제거는 소폭 하락. |

| 해석가능성 | continuous thought를 vocab에 투영(probing)하면 중간 계산 결과가 관찰되고, attention이 operand 토큰을 잡는 사례 제시. 다만 token-level probing 한계 존재. |

| 한계/향후 | implicit CoT는 본질적으로 해석성 trade-off. distill token(‘:’) 선택/프롬프트 영향, 긴 reasoning에서 credit assignment/최적화 난이도 가능. 대규모 스케일링은 제한적. |

https://arxiv.org/abs/2508.03440

LLMs are Single-threaded Reasoners: Demystifying the Working Mechanism of Soft Thinking

Human cognition naturally engages with abstract and fluid concepts, whereas existing reasoning models often rely on generating discrete tokens, potentially constraining their expressive capabilities. Recent advancements aim to address this limitation by en

arxiv.org

ICLR 2026 포스터에 붙은 논문이네요

요즘 soft thinking은 토큰 하나 대신 여러 토큰을 통해 다음 스텝에 더 많은 정보를 넣어준다.

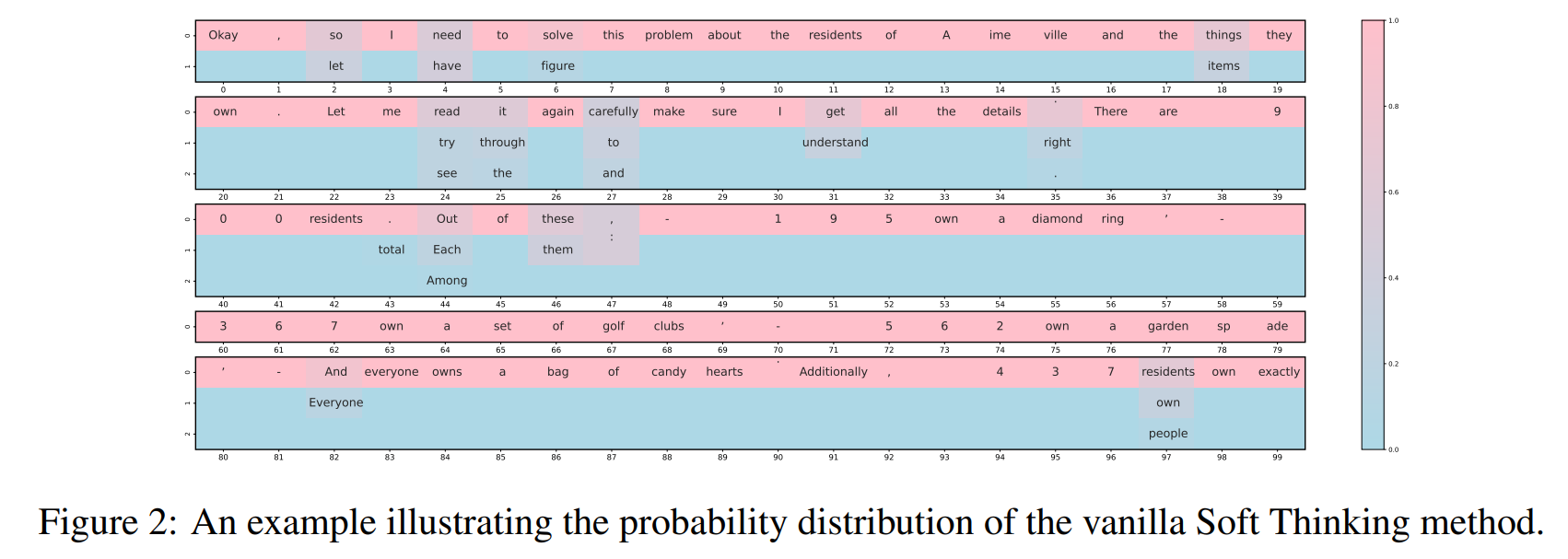

BUT 실제로는 성능이 잘 나오지 않음 == 소프트 입력이 병렬 탐색을 실젣로 유도하지 못함

soft 토큰에 여러 후보가 섞여 있어도 다음 스텝은 항상 top-1 토큰 성분에 의해 지배되어 나머지 성분은 무시됨

바닐라와 거의 유사한 것을 볼 수 있음

1top token과 2top token, soft input을 비교해봤을 때 soft의 예측 분포는 top-1과 거의 비슷함

두 토큰을 섞어서 넣어봐도 top -1 경로에 수렴함을 볼 수 있음

단순 sampling보다 soft thinking이 greedy trace에 가까움

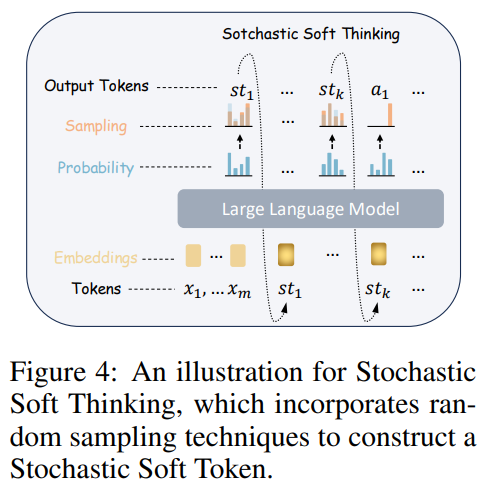

sampling을 통해서 확률을 조정함 => 바닐라 대비에서 개선됨

| 연구 질문 | Soft Thinking(= 확률분포/연속 표현을 “soft token”으로 다음 스텝 입력에 넣는 latent/continuous CoT)이 병렬적 추론 경로 탐색을 실제로 수행하는가? 그리고 왜 training-free vanilla Soft Thinking이 기대만큼 성능이 안 나오는가? |

| 배경/가정 | Soft token은 단일 토큰 선택 대신 어휘분포 전체를 다음 입력으로 전달해 정보량을 늘리고, 이론적으로는 다중 추론 경로를 잠재적으로 유지할 수 있다는 기대가 있었다. |

| 핵심 발견 | LLM은 Soft Thinking에서도 single-threaded reasoner처럼 동작: soft input이 여러 후보를 포함해도 다음 스텝 예측은 top-1 토큰 성분에 의해 거의 지배되고, 비-top1 경로는 빠르게 약화/종료된다(“가지치기”). |

| 원인 개념화 | Greedy Pitfall: top-1 성분 지배 → 다음 스텝도 top-1을 강화하는 양의 피드백 루프가 생겨 탐색이 억제되고, 결과적으로 vanilla Soft Thinking은 greedy decoding과 유사한 궤적으로 수렴한다. |

| 분석/증거 | (1) Soft 입력 vs top-1 입력의 다음 분포가 JS divergence≈0, 반면 top-2 입력과는 크게 다름(soft가 사실상 top-1처럼 작동). (2) Logit Lens로 레이어 진행 시 top-1 경로 점유율이 1.0으로 수렴(forward가 pruning처럼 작동). (3) soft trace(top-1 연결)와 greedy trace의 ROUGE-L 유사도↑로 greedy화 확인. |

| 베이스라인 결과 | 8개 벤치마크(수학/지식/코드)에서 vanilla Soft Thinking은 Token CoT(sampling)보다 대체로 낮고, 평균적으로 greedy와 비슷한 수준에 머무는 경향(Table 1). |

| 제안 방법 | Stochastic Soft Thinking: soft token을 그대로 쓰지 말고, 원 분포를 기반으로 제어된 확률성을 주입해 greedy pitfall을 깨는 “stochastic soft token”을 생성. 요구 조건: Validness(분포), Randomness(탐색), Softness(원-핫 붕괴 방지). |

| 구현(2가지) | (1) Dirichlet sampling: Dir(γ·p)에서 샘플(γ로 농도 조절). (2) Gumbel-Softmax: gumbel noise + temperature τ로 soft 샘플링(연속적 argmax 근사). |

| 성능 결과 | 두 방법 모두 vanilla 대비 개선. 특히 Gumbel-Softmax는 Token CoT(sampling)까지도 넘어서는 개선을 3개 LLM×8벤치에서 비교적 일관되게 보임(Table 2). |

| 왜 Gumbel이 유리한가 | Randomness–Softness trade-off에서 Gumbel은 τ로 softness를 조절하면서도 충분한 randomness(JS divergence)를 유지하기 쉬운 반면, Dirichlet은 γ에 따라 한쪽을 얻으면 다른 쪽이 깨지는 경향(Fig.5). |

| 추가 의의 | Gumbel-Softmax 샘플은 잘 정의된 PDF/정책비를 제공해, Latent/Soft Thinking에 policy-gradient RL(PPO/GRPO류) 연결을 더 정합적으로 만들 수 있다고 논의(“foundation for RL training”). 또한 Pass@k에서 soft rollouts가 더 강한 탐색 잠재력을 보임(Fig.6). |

| 한 줄 결론 | “Soft token을 넣는다고 LLM이 자동으로 병렬 추론을 하지는 않는다(단일 스레드로 수렴). 따라서 Soft Thinking의 잠재력을 쓰려면 stochasticity를 설계적으로 주입해야 하며, 그 실용적 해법으로 Gumbel-Softmax 기반 Stochastic Soft Thinking이 가장 효과적이다.” |

'인공지능 > 논문 리뷰 or 진행' 카테고리의 다른 글

| Latent Reasoning, Soft Thinking 논문 정리 3 (0) | 2026.02.21 |

|---|---|

| Multi-turn, Long-context Benchmark 논문 5 (0) | 2026.02.20 |

| Latent Reasoning, Soft Thinking 논문 정리 1 (1) | 2026.02.19 |

| Multi-turn, Long-context Benchmark 논문 4 (0) | 2026.02.04 |

| Privacy AI 관련 조사 13 (0) | 2026.02.03 |