https://arxiv.org/abs/2412.06769

Training Large Language Models to Reason in a Continuous Latent Space

Large language models (LLMs) are typically constrained to reason in the language space, where they express the reasoning process through a chain-of-thought (CoT) to solve complex problems. However, the language space may not always be optimal for reasoning

arxiv.org

COLM 2025 에 붙었습니다.

기존 LLM의 추론은 언어 공간에서 진행되어서 자연어 토큰으로 생성하게 된다.

그러나 추론에 불필요한 토큰이 너무 많이 들어가고, 대부분 자연스러움과 유창성을 위한 것으로 실제 정보량은 적다.

또한 핵심 토큰을 가지는 것이 아니라 모든 토큰 예측에 도잉ㄹ한 리소스를 할당하고, 그리디한 경로를 진행하기에 틀리면 되돌아가기 어렵고, 환각에 빠지기 쉬움

=> 추론을 자연어 토큰으로 뱉지 말고 마지막 hidden state를 그대로 입력하여 연속 공간에서 진행하도록 함

bot = Latent mode 시작

eot = Latent mode 끝

여기선 loss를 걸지 않고 진행하는 방식으로 continous thought가 정답 토큰, 뒷 토큰 예측을 더 잘하도록 도와주게 학습됩니다.

=> 이 부분은 Soft thinking의 학습 방법이 좀 더 나은 것 같네요

그리고 정답으로 넘어가는 부분도 고정 길이를 사용해서 진행합니다.

binary classifier 를 학습해도 된다고 하지만... 이 부분은 음 학습 방법 상 어쩔 수 없는 것 같네요

애초에 bot의 마지막 hidden state를 한번 더 넣고, eot를 넣는거라 언제 끝낼지 신호 자체가 없으니...

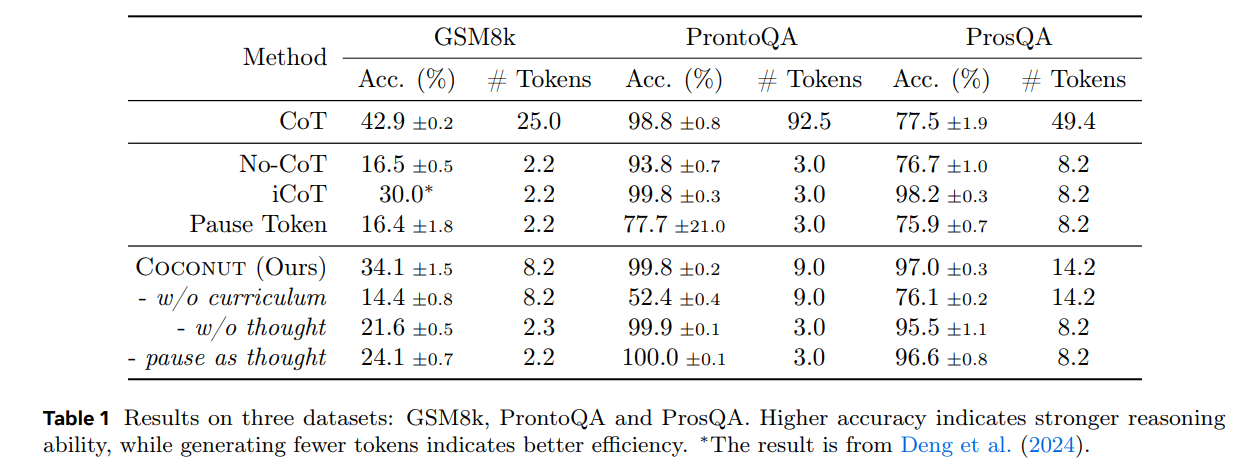

최대 reasoning step을 6으로 두고 실험을 진행했다.

https://neurips.cc/virtual/2025/loc/san-diego/poster/118535

NeurIPS Poster Hybrid Latent Reasoning via Reinforcement Learning

Recent advances in large language models (LLMs) have introduced latent reasoning as a promising alternative to autoregressive reasoning. By performing internal computation with hidden states from previous steps, latent reasoning benefit from more informati

neurips.cc

뉴립스에 붙은 논문입니다.

'인공지능 > 논문 리뷰 or 진행' 카테고리의 다른 글

| Multi-turn, Long-context Benchmark 논문 4 (0) | 2026.02.04 |

|---|---|

| Privacy AI 관련 조사 13 (0) | 2026.02.03 |

| Privacy AI 관련 조사 12 (0) | 2026.02.02 |

| Multi-turn, Long-context Benchmark 논문 3 (0) | 2026.01.31 |

| ALIENLM: ALIENIZATION OF LANGUAGE FORPRIVACY-PRESERVING API INTERACTION WITHLLMS (0) | 2026.01.28 |