https://arxiv.org/abs/2505.10413

Hierarchical Document Refinement for Long-context Retrieval-augmented Generation

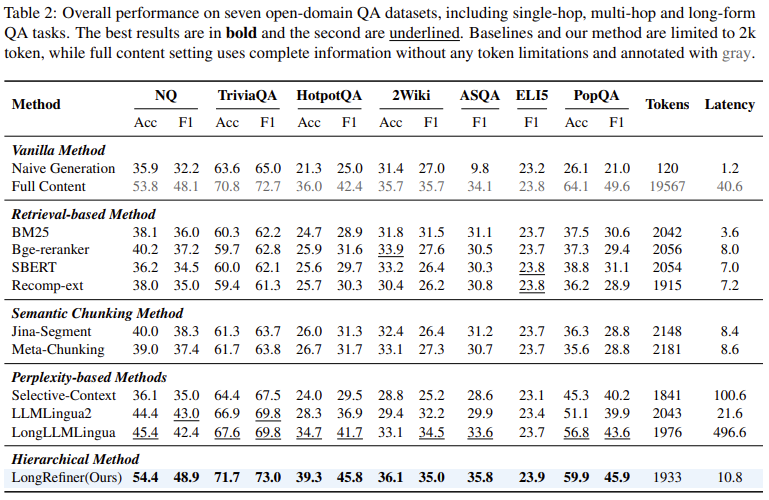

Real-world RAG applications often encounter long-context input scenarios, where redundant information and noise results in higher inference costs and reduced performance. To address these challenges, we propose LongRefiner, an efficient plug-and-play refin

arxiv.org

긴 문서에는 노이즈가 많아 RAG 성능과 추론 시간이 악화

Perplexity 기반 선택이나 Chunking 방식은 문서 구조를 고려하지 않거나 성능과 효율성을 저하한다.

1. 질문의 정보 요구 범위 분석 (짧고 명확한 정보 혹은 문서 전반적 이해)

2. 긴 문서 구조화 하여 계층적 분석이 가능하게 만든다.

3. 계층 구조를 기반으로 정보를 정제 (중요한 정보만 가져욤)

=> 토큰은 10%만 사용하고, Latency 25%로 감소

새로운 방식을 통해 Latency를 줄이면서 성능을 올림

Multi-hop QA에도 강한 모습을 보임

Latency에서 강한 모습을 보인다.

| 🧩 문제 상황 | 🔹 긴 문서에는 불필요한 정보와 노이즈가 많아 RAG 시스템 성능 저하 및 추론 비용 증가 🔹 기존 정제 방식은 문서 구조 미반영 or 간단한 score(PPL 등)에 의존 |

| 🧠 방법론 | 1. Dual-Level Query Analysis: 쿼리가 Local/Global 정보를 요구하는지 분석 (Soft token) 2. Hierarchical Document Structuring: 문서를 XML-like 구조로 트리화 (section/subsection/paragraph) 3. Adaptive Refinement: Local/Global score 결합하여 중요한 노드만 선택 (token budget 내에서 구조 유지) |

| ⚙️ 구현 방식 | 🔹 Wikipedia에서 구조 정보를 자동 수집하여 학습 데이터 생성 🔹 Multi-task LoRA 방식으로 query 분석, 구조화, 정제 모델을 통합 학습 🔹 추론 시 구조화는 오프라인, 정제는 온라인 처리로 latency 절감 |

| 📊 결과 | 🔸 평균 F1: 48.9 (Full-content보다 높음) 🔸 Token 수: 1/10 수준 (1933 tokens) 🔸 Latency: 4배 이상 개선 (10.8초) 🔸 모든 QA 유형(Single-hop, Multi-hop, Long-form)에서 일관된 성능 향상 |

| ✨ 기여 | ✅ 구조 기반 문서 정제 프레임워크 최초 제안 ✅ query 정보 요구 수준을 정량적으로 반영 ✅ XML 기반 압축 표현으로 정보 손실 최소화 ✅ Multi-task LoRA + 모듈화로 실용성 확보 |

| ⚠️ 한계 | ❌ 비텍스트 정보 (표, 이미지 등) 미지원 ❌ 위키 기반 학습이라 도메인 일반화 어려움 ❌ <skip>으로 인한 구조 복원 시 정보 손실 가능성 ❌ Teacher LLM 기반 라벨링의 자동화 정확도 한계 |

https://arxiv.org/abs/2408.05829

Supporting Software Maintenance with Dynamically Generated Document Hierarchies

Software documentation supports a broad set of software maintenance tasks; however, creating and maintaining high-quality, multi-level software documentation can be incredibly time-consuming and therefore many code bases suffer from a lack of adequate docu

arxiv.org

| 📌 문제 상황 | - 유지보수 시 필수적인 문서화 작업은 시간 소모가 커 자주 소홀히 다뤄짐 - 많은 코드베이스가 문서 부족으로 인해 변경 분석, 요구 추적 등에 어려움을 겪음 - 기존 자동화 기법은 API 수준에 그쳐 시스템 전반을 다층적으로 설명하는 데 한계 |

| ⚙️ 제안 방법 (HGEN) | - LLM 기반 문서 계층 자동 생성 파이프라인 HGEN 제안 - 소스코드 → 요약 → 클러스터링 → 문서 생성 → 중복 제거 및 추적 링크 생성의 6단계 구성 - Sentence-BERT로 문서 임베딩, 다중 클러스터링 (OPTICS, Spectral 등), Claude 2.0 기반 생성 - 문서 계층 간 의미 기반 추적 링크(trace link) 자동 연결 |

| 🧪 실험 구성 | - 3개 프로젝트(Dronology, SAFA, Jack of Clubs)에서 수작업 문서 vs HGEN vs Baseline LLM 비교 - 9개 산업 프로젝트에서 HGEN 단독 파일럿 실행 및 전문가 인터뷰 |

| 📈 주요 결과 | ✅ 문서 품질: Readability, Appropriateness, Usefulness 등에서 HGEN이 수작업보다 우수 ✅ 개념 커버리지: 기존 문서 대비 HGEN이 80~100% 수준으로 핵심 개념 포착 ✅ 문서 계층 간 관계(Trace): 높은 Recall 및 Precision, 오프한(Orphan) 문서 수 현저히 감소 ✅ 산업 피드백: 이해도 향상, 신규 인력 온보딩, 레거시 분석 및 규제 대응 등에 실용성 인정 |

| 🌟 기여 | - 계층적 문서화 자동화의 실질적 구현 사례 제시 - 단순 요약을 넘어 구조화된 문서 계층 및 추적 연결 생성 - 산업 적용 가능성 검증 및 실사용 시나리오 제시 (e.g., onboarding, safety review) - Sentence-BERT + LLM + 다중 클러스터링 기반 traceable 문서화 파이프라인 설계 |

| ⚠️ 한계 | - 총 3개 프로젝트 기반의 품질 평가: 일반화에 제한 - 복잡한 파이프라인 구조로 재현 및 유지보수 어려움 - LLM 사용이지만 다양한 모델 성능 비교 실험은 미진 - 현업 적용은 프로토타입 수준이며 장기 사용 사례는 부족 |

https://arxiv.org/abs/2410.03761v2

Taxonomy Tree Generation from Citation Graph

Constructing taxonomies from citation graphs is essential for organizing scientific knowledge, facilitating literature reviews, and identifying emerging research trends. However, manual taxonomy construction is labor-intensive, time-consuming, and prone to

arxiv.org

| 🔍 문제 상황 | - 문헌 리뷰나 연구 동향 파악을 위한 분류 체계(taxonomy) 생성이 중요하지만, 현재 대부분 수작업으로 진행됨. - 이는 시간이 많이 소요되고, 주관적 편향이 개입될 수 있으며, 인용 수가 적은 중요 논문이 누락되기도 함. - 기존 방법은 텍스트 기반(semantic only)이라 그래프 구조(인용 관계)를 고려하지 못함. |

| 🧠 제안 방법 (HiGTL) | HiGTL: Hierarchical Graph Taxonomy Learning → End-to-End 방식으로 인용 그래프에서 자동으로 taxonomy 생성하는 모델 |

| ⚙️ 주요 구성 요소 | ① Hierarchical Citation Graph Clustering (구조적 분할) ② Taxonomy Node Verbalization (토픽 요약 생성) ③ Joint Optimization (두 모듈의 공동 학습) |

| 📌 방법론 세부 설명 | 1. 계층적 그래프 클러스터링 (g): - 인용 그래프를 다단계로 클러스터링하여 논문들을 주제별로 그룹화 - 처음엔 soft clustering → 점차 hard clustering으로 - 각 클러스터의 대표 노드 밀도(density)를 기반으로 특징 벡터 생성 2. 노드 개념 요약 (h): - 각 클러스터의 중심 개념(주제 label)을 LLM(GPT or fine-tuned LLaMA)을 활용하여 생성 - 논문 텍스트, 클러스터 임베딩, 사용자 주제 쿼리로 구성된 입력을 바탕으로 계층적 개념 생성 3. 최적화 (f = h ∘ g): - 클러스터링과 개념 생성을 joint training으로 학습 - 초기에는 GNN 클러스터링만 pre-train, 이후 LLM과 함께 fine-tune |

| 🧪 실험 설정 | - 총 518개 arXiv 리뷰 논문에서 1~3 hop 인용 그래프 구축 - 학습용: 200개 / 테스트용: 118개 / 리뷰 생성용: 318개 - 비교 대상: TaxoGen, NetTaxo, HiExpan, GPT-4o, Claude-3.5 등 |

| 🧾 결과 | 1. Taxonomy Generation (표 1) - HiGTL이 모든 평가 지표에서 가장 우수 (LLMScore, Human Eval, BertScore) - 특히 구조적 일관성(Structure)과 Adequacy/Validity에서 가장 높은 점수 기록 2. Literature Review Generation (표 2) - HiGTL 기반 HiReview 모델이 기존 AutoSurvey, RAG, LLM보다 가장 일관적이고 구조화된 리뷰 생성 - 구조 점수: 0.9484 (AutoSurvey: 0.9122) 3. Ablation Study - Retrieval, Clustering, Taxonomy 제거 시 모두 성능 감소 - 특히 구조 점수 및 주제 정합성에서 큰 차이 발생 |

| 🎯 기여 | - 인용 그래프 기반 자동 분류체계 생성 방법 최초 제안 - 그래프 구조 + 논문 텍스트를 통합하여 클러스터링 - LLM을 활용한 클러스터 주제 생성 및 일관된 계층적 개념 유지 - 리뷰 생성 모델로 확장 가능성 증명 (HiReview) |

| ⚠️ 한계 | - 초기 클러스터링 성능이 낮으면 LLM 개념 생성이 어려워짐 - Fine-tuning 데이터 수 제한 → 확장성에 제약 - 사람 수준의 도메인 세분화(예: 법/의료/소셜 미디어 분야 구분)는 어려움 |

https://arxiv.org/abs/2309.08872

PDFTriage: Question Answering over Long, Structured Documents

Large Language Models (LLMs) have issues with document question answering (QA) in situations where the document is unable to fit in the small context length of an LLM. To overcome this issue, most existing works focus on retrieving the relevant context fro

arxiv.org

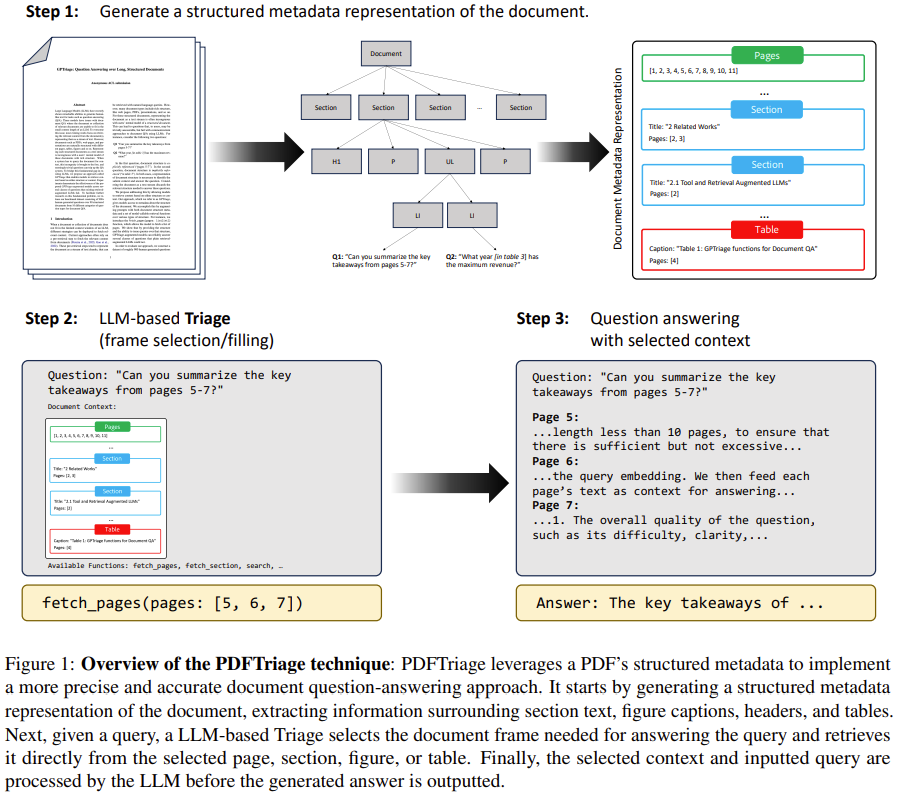

긴 문서에서 Context length 문제 때문에 청킹해야 해서 성능 저하가 일어남

표나 그림과 같은 메타데이터를 질문에 맞게 필요한 부분만 LLM에 제공

PDF를 일단 LLM이 이해할 수 있도록 Adobe API를 활용해서 트리 구조를 JSON 메타 데이터로 변환합니다.

이제 질문에 맞는 문서의 일부분을 함수 호출 기반으로 불러와서 Context로 LLM에 제공합니다.

여기서 함수 호출에선 텍스트 추출, 내용 추출, 테이블 텍스트나 캡션 추출, 그림 설명이나 관련 텍스트 추출, 관련 문서 조각 검색 등이 있다.

이제 위 정보를 통해 최종 응답을 생성하는 것이다.

논문에서 제안한 방식이 제일 높은 선호도를 가지는 것을 볼 수 있다.

그런데 여러가지 방법을 사용했으니 높은 것이 당연하지 않나 싶기도 하고...

| 문제 상황 | 🔹 기존 LLM 기반 Document QA는 긴 문서가 context window를 초과하면 전체 문서를 처리하지 못함 🔹 대부분의 접근이 문서를 평면 텍스트 chunk로 변환하여 검색 → 문서의 구조(Page, Section, Table 등) 정보가 손실됨 🔹 사용자는 "5~7페이지 요약해줘", "표 3에서 최대 매출은?"처럼 구조를 기반으로 질문함 |

| 제안 방법 (PDFTriage) | 📌 문서 구조 인식 기반 QA 시스템으로, 다음 세 단계로 구성됨: 1. 문서 메타데이터 생성: Adobe Extract API로 PDF → 트리형 JSON 메타데이터 변환 (페이지, 섹션, 표 등) 2. LLM 기반 Triage: 질문을 기반으로 fetch_pages, fetch_section, fetch_table 등의 함수 호출로 필요한 context만 선택 3. 질의응답: 선택된 context를 기반으로 GPT-3.5-turbo가 응답 생성 |

| 실험 결과 | ✅ 908개의 질문, 82개의 문서 기반 QA 평가 ✅ PDFTriage가 전체 질문 중 50.8%에서 가장 선호되는 응답 생성 ✅ 특히 구조 기반 질문에서 압도적 성능 (예: Structure Questions 75.0%, Table Reasoning 62.5%) ✅ Accuracy, Informativeness, Readability, Overall Quality 항목 모두 기존 방식보다 우수 |

| 주요 기여 | 🏆 구조화 문서를 효과적으로 처리하는 LLM-augmented QA 프레임워크 제안 🏆 10가지 질문 유형(요약, 추출, 테이블 추론 등)을 포함하는 대형 QA 벤치마크 데이터셋 구축 🏆 함수 기반 질의 시스템 + 메타데이터 기반 prompting 전략 구현 및 실증 |

| 한계 및 향후 방향 | ⚠ 구조 외 시각 정보(도표 해석 등)는 활용하지 못함 ⚠ Clarity 평가 점수는 일부 유형에서 낮게 나타남 ⚠ 자동 평가(GPT 기반)와 사람 평가 사이 정합도 낮음 (Cohen’s κ = 0.067) ➕ 향후 GPT-4 기반 멀티모달 QA 확장, 질문 유형 분류기 도입 예정 |

'인공지능 > 논문 리뷰 or 진행' 카테고리의 다른 글

| DoGe 관련 논문 조사 6 - Synthetic QA Data, SELF-ROUTE (0) | 2025.07.08 |

|---|---|

| DoGe 관련 논문 조사 5 - LayoutLLM, DocLLM (6) | 2025.07.08 |

| DoGe 관련 논문 조사 3 - STRUC-BENCH, TABLELLM, LLM table Gen task Evaluation (2) | 2025.07.07 |

| Blinded by Generated Contexts: How Language Models Merge Generated and Retrieved Contexts When Knowledge Conflicts? (2) | 2025.07.07 |

| DoGe 관련 논문 조사 2 - SKR, Self-Prompting (0) | 2025.07.06 |