https://arxiv.org/abs/1908.10084

Sentence-BERT: Sentence Embeddings using Siamese BERT-Networks

BERT (Devlin et al., 2018) and RoBERTa (Liu et al., 2019) has set a new state-of-the-art performance on sentence-pair regression tasks like semantic textual similarity (STS). However, it requires that both sentences are fed into the network, which causes a

arxiv.org

RAG가 상용화 될 수 있었던 논문인 것 같습니다.

기존 엄청나게 오래 걸리던 검색 작업을 단일 벡터로만 진행할 수 있도록 BERT 구조를 변경했습니다.

단순 벡터 하나가 나오니 이를 통해 COS Sim을 통해 빠른 문서 검색이 가능합니다.

기존 방식에 비해 효율적으로 시간을 단축했다는 것이 이 논문의 핵심이네요

| 문제 정의 | 기존 BERT는 문장 간 유사도 계산 시 모든 조합을 입력으로 처리해야 해 계산 비용이 기하급수적으로 증가하며, 대규모 데이터셋에서 비효율적임. |

| 제안 방법 | BERT를 기반으로 한 Siamese 및 Triplet 네트워크 구조를 통해 문장을 고정된 크기의 벡터로 변환하여 계산 효율성과 정확도를 높임. |

| 핵심 아이디어 | - 문장을 의미적으로 가까운 벡터 공간으로 매핑. - Cosine Similarity 등 간단한 계산으로 유사도를 효율적으로 측정. - Siamese 구조를 통해 독립적인 문장 벡터 생성으로 계산량 감소. |

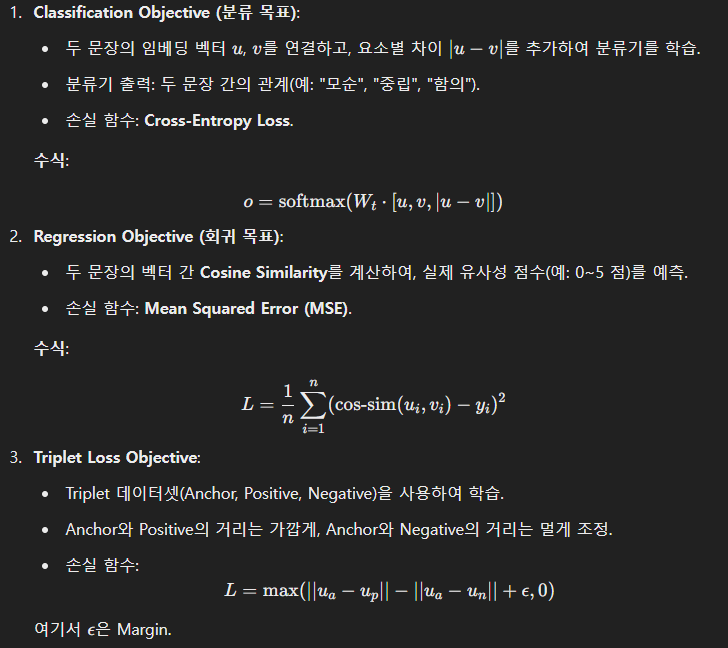

| 모델 구조 | 1. Pooling 전략: [CLS] 토큰, MEAN(평균), MAX(최댓값) 중 MEAN이 가장 우수. 2. Fine-Tuning 목표: Classification, Regression, Triplet Loss를 사용해 학습. |

| 결과 | - STS 태스크에서 InferSent 대비 11.7 포인트, Universal Sentence Encoder 대비 5.5 포인트 높은 성능. - GPU에서 Universal Sentence Encoder 대비 55% 더 빠른 속도. - 다양한 전이 학습 태스크에서 최고 성능 기록. |

| 적용 가능성 | - 정보 검색: 효율적인 검색 및 문장 유사도 계산. - 문서 클러스터링: 대규모 데이터 처리 및 요약. - 질의 응답 시스템: 의미적 검색 최적화. - 다국어 작업: 언어 간 의미 비교 및 다국어 태스크 지원. |

| 기여 | - 문맥적 의미를 보존하며 효율적인 계산을 가능케 하는 문장 임베딩 생성. - 대규모 데이터 작업에서 기존 BERT 대비 실질적 개선. |

| 한계 | - Argument Facet Similarity(AFS) 크로스 토픽 태스크에서 일반화 성능이 다소 저하됨. - 훈련 데이터 다양성과 양을 확장하면 해결 가능. |

| 결론 | SBERT는 문장 임베딩 품질과 계산 효율성을 모두 갖추어, 대규모 데이터 작업 및 실시간 검색에서 혁신적 도구로 자리 잡을 가능성이 큼. |

| 연구 확장 방향 | - 더 다양한 데이터셋에서의 활용 가능성 검토. - 다국어 환경에서 SBERT 확장. - 클러스터링 및 정보 검색 시스템에의 실질적 적용. |

이 Figure는 SBERT의 아키텍처를 나타내며, SBERT가 문장 임베딩을 생성하고 문장 간 유사도를 계산하는 방식을 시각적으로 설명합니다. 두 가지 주요 구성 요소를 다루고 있습니다: 학습 과정 (Figure 1)과 추론 과정 (Figure 2)입니다.

Figure 1: 학습 아키텍처

이 그림은 SBERT의 학습(fine-tuning) 과정에서 사용되는 아키텍처를 나타냅니다.

구조 설명:

- 입력 (Sentence A, Sentence B):

- 두 개의 문장(예: A와 B)이 입력으로 주어집니다.

- BERT 네트워크:

- 각 문장은 독립적으로 동일한 가중치를 공유하는 BERT 네트워크에 입력됩니다.

- 이 구조는 Siamese Network로 불리며, 두 문장 간의 관계를 학습하기 위해 동일한 임베딩 모델을 사용합니다.

- Pooling:

- 각 BERT 네트워크의 출력(토큰별 벡터)을 고정된 크기의 벡터로 변환하기 위해 Pooling 전략([CLS], 평균, 최대값 중 선택)을 사용합니다.

- 이로 인해 각 문장은 고정된 크기의 임베딩 u와 v로 변환됩니다.

- 벡터 결합:

- 두 문장 벡터 u와 v를 연결(concatenate)하고, 각 차원의 차이 |u - v|를 계산하여 하나의 입력으로 병합합니다.

- Softmax 분류기:

- 결합된 벡터는 Softmax 분류기를 통해 학습됩니다.

- 예를 들어, SNLI 데이터셋을 활용해 두 문장이 "모순(Contradiction)", "중립(Neutral)", "함의(Entailment)"인지 분류하는 작업을 수행합니다.

Figure 2: 추론(Inference) 아키텍처

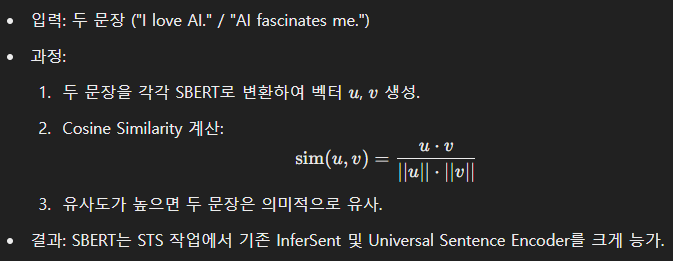

이 그림은 SBERT의 추론 과정에서 문장 간 유사도를 계산하는 방식을 나타냅니다.

구조 설명:

- 입력 (Sentence A, Sentence B):

- 학습된 SBERT에 두 문장(A와 B)을 입력합니다.

- BERT 네트워크와 Pooling:

- 학습 때와 동일하게 각 문장은 독립적으로 BERT 네트워크를 통과하고, Pooling을 통해 고정된 크기의 임베딩 u와 v로 변환됩니다.

- Cosine Similarity 계산:

- 생성된 두 문장 벡터 u와 v의 유사도를 Cosine Similarity로 계산합니다:

- 이 계산 결과는 -1에서 1 사이의 값으로 나타나며, 두 문장이 의미적으로 유사할수록 값이 1에 가까워집니다.

Figure 간 차이와 역할

- Figure 1 (학습):

- SBERT는 학습 단계에서 SNLI 등 지도 학습 데이터셋을 활용하여 문장 간 의미적 관계를 학습합니다.

- Softmax 분류기를 통해 각 문장 벡터가 특정 태스크(예: STS, NLI)에 최적화됩니다.

- Figure 2 (추론):

- 학습된 SBERT를 사용하여 새로운 문장 쌍의 의미적 유사도를 계산합니다.

- Cosine Similarity와 같은 단순 계산으로 빠르게 유사도를 평가합니다.

SBERT 아키텍처의 특징

- 효율성:

- 두 문장을 독립적으로 처리하므로, 모든 문장 조합을 입력으로 넣어야 했던 기존 BERT 대비 계산 비용이 크게 감소.

- 학습 이후 고정된 크기의 벡터를 재사용할 수 있으므로, 대규모 데이터에서 빠른 검색 및 유사도 계산 가능.

- 확장성:

- 다양한 지도 학습 태스크(NLI, STS 등)로 학습 가능하며, 학습된 모델은 추론 단계에서 유사도 계산, 검색, 클러스터링 등에 활용.

- 정확성:

- Cosine Similarity와 같은 단순 계산으로도 높은 성능을 달성.

요약

- Figure 1: 학습 단계에서 문장 벡터를 생성하고 Softmax 분류기로 학습.

- Figure 2: 추론 단계에서 학습된 모델로 문장 벡터를 생성하고, Cosine Similarity로 유사도 계산.

이 Table은 SBERT 및 기타 문장 임베딩 모델이 Semantic Textual Similarity (STS) 태스크에서 성능을 비교한 결과를 나타냅니다. Spearman 상관 계수(ρ)를 기준으로 모델 간 문장 유사도 측정 정확도를 평가한 것입니다.

Table의 주요 구성 요소

- 컬럼 설명:

- Model: 평가된 모델 이름.

- Avg. GloVe embeddings: GloVe 단어 임베딩의 평균을 사용.

- Avg. BERT embeddings: BERT의 출력 벡터를 평균.

- BERT CLS-vector: BERT의 [CLS] 토큰 벡터를 사용.

- InferSent - GloVe: InferSent 모델을 GloVe로 학습.

- Universal Sentence Encoder: Google의 Transformer 기반 문장 임베딩 모델.

- SBERT, SRoBERTa: SBERT와 RoBERTa 기반 Sentence-BERT 모델.

- STS12~STS16, STSb, SICK-R: 다양한 STS 데이터셋에서의 평가 결과.

- STS12 ~ STS16: SemEval 2012 ~ 2016에서의 STS 태스크.

- STSb: STS Benchmark 데이터셋.

- SICK-R: SICK(Relatedness) 데이터셋.

- Avg.: 모든 데이터셋에서의 평균 성능.

- Model: 평가된 모델 이름.

- 평가지표:

- Spearman Rank Correlation (ρ): 두 문장 간 유사도를 측정한 모델의 출력(임베딩 기반 Cosine Similarity)과 정답(레이블 간 유사도) 간의 순위 상관 계수를 나타냄.

- 점수가 높을수록 모델이 문장의 의미적 유사도를 잘 반영.

Table에서 확인할 수 있는 주요 내용

- 기존 모델의 성능:

- Avg. GloVe embeddings:

- 단어 임베딩 평균화 방식은 61.32로 가장 낮은 성능.

- 단어 수준 의미는 보존하지만 문장 수준 문맥 정보 부족.

- Avg. BERT embeddings & BERT CLS-vector:

- BERT 출력 벡터 평균(54.81)이나 [CLS] 토큰 벡터(29.19)는 기존 방식보다 성능이 저하됨.

- 이는 BERT의 문장 임베딩이 문맥 정보를 효과적으로 함축하지 못한다는 점을 시사.

- Avg. GloVe embeddings:

- SBERT의 성능:

- SBERT-NLI-base:

- 평균 점수 74.89로, 기존 방법(InferSent, USE)보다 높은 성능.

- SBERT-NLI-large:

- SBERT의 large 모델은 76.55로 가장 높은 성능을 기록.

- 특히 STS15, STSb, SICK-R에서 매우 우수한 성능을 보임.

- 이는 BERT를 Fine-Tuning하여 문장 간 유사도를 잘 학습했음을 보여줌.

- SBERT-NLI-base:

- SRoBERTa의 성능:

- SRoBERTa-NLI-base & SRoBERTa-NLI-large:

- SBERT와 유사한 구조로 RoBERTa를 기반으로 학습.

- 평균 성능 74.21(SRoBERTa-base) 및 76.68(SRoBERTa-large)로, SBERT와 비슷하거나 약간 더 높은 성능.

- SRoBERTa-NLI-base & SRoBERTa-NLI-large:

- SBERT vs. 기존 방법 비교:

- SBERT 및 SRoBERTa는 기존 방법(InferSent, Universal Sentence Encoder)보다 전반적으로 높은 점수를 기록.

- 특히 STSb 데이터셋에서 Universal Sentence Encoder(74.92)보다 SBERT-NLI-large(79.23)가 더 나은 성능을 보임.

Table의 주요 메시지

- SBERT의 성능 우수성:

- 기존 GloVe 기반 방법이나 BERT의 단순 임베딩 평균 방식은 STS 태스크에서 성능이 낮음.

- SBERT는 Fine-Tuning을 통해 문맥 정보를 잘 학습하여 STS 태스크에서 기존 모델을 능가.

- RoBERTa 기반 SBERT의 확장 가능성:

- SBERT의 구조를 RoBERTa에 적용한 SRoBERTa는 SBERT와 비슷하거나 약간 더 높은 성능을 보임.

- 이는 다양한 사전 학습 모델을 기반으로 SBERT 구조를 확장할 가능성을 시사.

- STS 태스크에서의 효율성:

- SBERT는 계산 비용을 크게 줄이면서도 문장 간 유사도를 효과적으로 반영하는 모델임.

요약

이 Table은 SBERT와 다른 모델들의 STS 태스크 성능을 비교하며, SBERT가 문장 임베딩 품질에서 기존 방법보다 우수하다는 점을 강조합니다. 특히, BERT의 단점을 극복하고 학습된 문장 임베딩의 정확도와 효율성을 동시에 달성한 점이 두드러집니다.

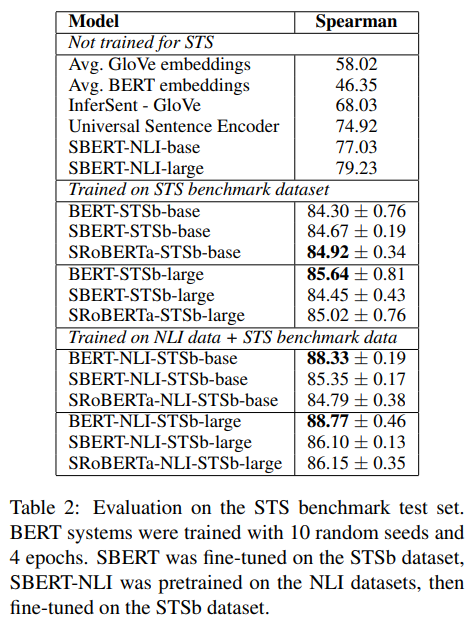

이 Table은 STS Benchmark 데이터셋에서 SBERT와 다른 모델들의 성능 비교를 나타낸 결과입니다. Spearman 상관 계수를 기준으로 문장 간 유사도를 측정한 성능을 비교하고, 학습 조건(훈련 데이터와 Fine-Tuning 여부)에 따른 성능 변화를 보여줍니다.

Table의 주요 구성 요소

- 컬럼 설명:

- Model: 평가된 모델 이름.

- "Not trained for STS" 섹션: STS 데이터셋에 대해 학습되지 않은 모델.

- "Trained on STS benchmark dataset" 섹션: STS 데이터셋으로 Fine-Tuning된 모델.

- "Trained on NLI data + STS benchmark dataset" 섹션: NLI 데이터로 사전 학습 후 STS 데이터셋으로 Fine-Tuning된 모델.

- Spearman: 각 모델의 출력 유사도와 정답 간 순위 상관 계수를 나타냄. 높을수록 문장 간 유사도를 잘 반영.

- Model: 평가된 모델 이름.

Table의 주요 내용

1. Not Trained for STS

- STS 데이터셋으로 학습되지 않은 모델들의 성능:

- Avg. GloVe embeddings: Spearman 58.02로 가장 낮은 성능. 단어 수준의 의미만 반영하며 문맥적 정보를 충분히 반영하지 못함.

- Avg. BERT embeddings (46.35), BERT CLS-vector (20.16):

- BERT 기반 단순 평균이나 [CLS] 토큰을 사용한 임베딩은 GloVe보다 낮은 성능.

- 이는 BERT의 임베딩이 STS와 같은 태스크에 특화되지 않았음을 의미.

- InferSent - GloVe (68.03): BiLSTM과 NLI 데이터로 학습되어 상대적으로 높은 성능을 보임.

- Universal Sentence Encoder (74.92): 비지도 학습으로 다양한 문맥적 정보를 반영해 높은 성능.

- SBERT-NLI-base (77.03), SBERT-NLI-large (79.23):

- NLI 데이터로 학습된 SBERT는 기존 모델보다 높은 성능을 기록. 이는 SBERT가 문장 간 관계를 학습했기 때문.

2. Trained on STS Benchmark Dataset

- STS 데이터셋으로 Fine-Tuning된 모델들의 성능:

- BERT-STSb-base (84.30 ± 0.76), BERT-STSb-large (85.64 ± 0.81):

- BERT를 STS 데이터로 Fine-Tuning하면 성능이 크게 향상됨.

- SBERT-STSb-base (84.67 ± 0.19), SBERT-STSb-large (84.45 ± 0.43):

- BERT와 비슷한 성능을 보임.

- SRoBERTa-STSb-base (84.92 ± 0.34), SRoBERTa-STSb-large (85.02 ± 0.76):

- RoBERTa 기반 모델은 BERT 및 SBERT와 유사한 성능을 기록.

- BERT-STSb-base (84.30 ± 0.76), BERT-STSb-large (85.64 ± 0.81):

3. Trained on NLI Data + STS Benchmark Dataset

- NLI 데이터로 사전 학습 후, STS 데이터셋으로 Fine-Tuning된 모델들의 성능:

- BERT-NLI-STSb-base (88.33 ± 0.19), BERT-NLI-STSb-large (88.77 ± 0.46):

- NLI 데이터로 사전 학습된 BERT는 매우 높은 성능을 기록. 이는 NLI 데이터가 문장 간 관계 학습에 효과적임을 의미.

- SBERT-NLI-STSb-base (85.35 ± 0.17), SBERT-NLI-STSb-large (86.10 ± 0.13):

- SBERT는 이 경우에도 높은 성능을 유지하며, BERT와의 차이는 미미함.

- SRoBERTa-NLI-STSb-base (84.79 ± 0.38), SRoBERTa-NLI-STSb-large (86.15 ± 0.35):

- SRoBERTa 역시 BERT 및 SBERT와 유사한 성능을 보임.

- BERT-NLI-STSb-base (88.33 ± 0.19), BERT-NLI-STSb-large (88.77 ± 0.46):

Table에서 확인할 수 있는 주요 메시지

- Fine-Tuning의 효과:

- STS 데이터셋으로 Fine-Tuning하면 성능이 크게 향상됨.

- 특히 BERT 및 SBERT 모델은 Fine-Tuning 전보다 성능이 5~10포인트 이상 상승.

- NLI 데이터 사전 학습의 중요성:

- NLI 데이터로 사전 학습하면 STS 태스크에서 추가적인 성능 향상이 가능.

- BERT-NLI-STSb 모델이 가장 높은 Spearman 값을 기록(88.77).

- SBERT의 성능:

- SBERT는 기존 모델 대비 더 높은 효율성과 함께 STS 태스크에서 매우 경쟁력 있는 성능을 보임.

- 특히 NLI 데이터 사전 학습 후 Fine-Tuning하면 성능이 BERT와 근접.

- SRoBERTa의 가능성:

- RoBERTa를 기반으로 한 SRoBERTa는 SBERT와 유사하거나 약간 더 높은 성능을 기록.

결론

- SBERT의 경쟁력:

- SBERT는 STS 태스크에서 InferSent와 USE를 능가하며, BERT와 비슷한 수준의 성능을 기록.

- 특히, 효율성이 뛰어나면서도 높은 품질의 문장 임베딩을 제공.

- NLI 데이터의 중요성:

- NLI 데이터를 활용한 사전 학습은 문장 간 관계 학습에 매우 효과적이며, STS와 같은 유사도 태스크에서 성능을 크게 향상시킴.

- Fine-Tuning 전략:

- STS 데이터셋에서의 Fine-Tuning과 NLI 데이터로 사전 학습을 결합하면 최고 성능을 달성.

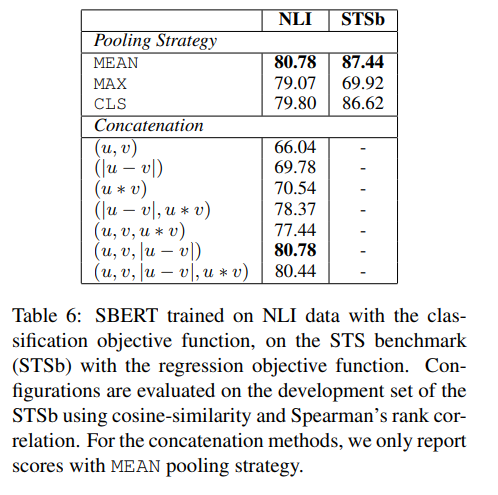

이 Table은 SBERT가 NLI 데이터로 학습되고, STS benchmark (STSb)에서 성능을 평가한 결과를 나타냅니다. 특히, Pooling 전략과 벡터 결합(Concatenation) 방식에 따른 성능 차이를 비교하고 있습니다.

Table의 주요 구성 요소

- Pooling Strategy (위쪽 표):

- SBERT에서 BERT의 출력(hidden states)을 고정된 크기의 벡터로 변환하기 위한 Pooling 전략을 비교.

- 평가 데이터셋:

- NLI: SBERT가 NLI 데이터로 학습된 결과.

- STSb: NLI 데이터로 학습 후 STS benchmark 데이터에서 평가된 결과.

- Pooling 전략:

- MEAN: 모든 토큰의 벡터 값을 평균.

- MAX: 각 차원에서 가장 큰 값을 선택.

- CLS: BERT 출력의 [CLS] 토큰 벡터를 사용.

- Concatenation (아래쪽 표):

- 두 문장 벡터 u와 v를 결합하는 방식에 따라 성능을 비교.

- 결합 방식:

- (u, v): 벡터를 단순히 연결.

- (|u - v|): 벡터 간 절댓값 차이.

- (u + v): 벡터를 더한 값.

- (|u - v|, u * v): 절댓값 차이와 요소별 곱을 결합.

- (u, v, |u - v|, u * v): 모든 정보를 결합.

Table에서 확인할 수 있는 주요 내용

1. Pooling Strategy 결과:

- MEAN:

- NLI (80.78) 및 STSb (87.44)에서 가장 높은 성능을 기록.

- 모든 토큰 벡터를 평균하는 방식이 문장 전체 정보를 가장 잘 함축한다는 점을 시사.

- MAX:

- NLI (79.07), STSb (69.92)로 성능이 낮음.

- 특정 차원의 최대값만 선택하므로 정보 손실이 발생.

- CLS:

- NLI (79.80), STSb (86.62)로 MEAN보다 성능이 낮음.

- [CLS] 토큰이 문장 전체 정보를 완전히 반영하지 못함.

결론:

- MEAN Pooling이 가장 효과적이며, 이는 SBERT에서 기본적으로 사용하는 방식임.

2. Concatenation 결과:

Table의 주요 메시지

- Pooling 전략:

- MEAN Pooling이 문장 전체 정보를 가장 잘 반영하며, 다른 Pooling 방법에 비해 높은 성능을 보임.

- SBERT에서는 MEAN Pooling을 기본적으로 사용.

- 벡터 결합 방식:

- 두 벡터 간 관계를 반영하기 위해 (u, v, |u - v|, u * v)처럼 다양한 정보를 결합할수록 성능이 향상.

- 단순한 연결이나 더하기 방식은 충분한 정보를 반영하지 못함.

- SBERT의 설계 최적화:

- MEAN Pooling과 (u, v, |u - v|, u * v) 결합 방식이 최적의 조합으로 나타남.

- 이는 SBERT가 문장 간 관계를 학습하는 데 최적화된 구조임을 보여줌.

결론

이 Table은 SBERT의 성능이 Pooling 전략과 벡터 결합 방식에 따라 크게 달라질 수 있음을 보여줍니다. MEAN Pooling과 복합 결합 방식(u, v, |u - v|, u * v)을 사용하면 NLI 및 STSb 데이터셋에서 최고 성능을 달성할 수 있습니다. 이는 SBERT의 문맥적 정보를 효과적으로 함축하고 문장 간 관계를 잘 학습할 수 있도록 설계되었음을 시사합니다.

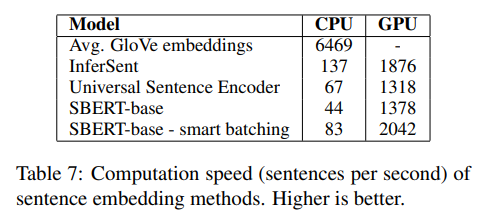

이 Table은 문장 임베딩 생성 속도를 비교한 결과를 나타냅니다. CPU와 GPU 환경에서 초당 처리 가능한 문장 수를 기준으로 각 모델의 계산 효율성을 평가합니다. 숫자가 높을수록 더 빠르게 문장 임베딩을 생성할 수 있음을 의미합니다.

Table의 주요 구성 요소

- Model:

- Avg. GloVe embeddings:

- GloVe 임베딩의 평균값을 계산하여 문장 임베딩을 생성.

- 가장 빠른 속도를 보이지만 문맥 정보를 반영하지 못함.

- InferSent:

- BiLSTM 기반 모델로, 문장의 문맥 정보를 반영하는 고품질 임베딩 생성.

- 하지만 CPU와 GPU 환경에서 속도가 상대적으로 느림.

- Universal Sentence Encoder (USE):

- Google의 Transformer 기반 모델로, InferSent보다 빠른 속도를 제공.

- SBERT-base:

- BERT 기반 Sentence-BERT 모델.

- GPU 환경에서 빠르지만, CPU에서는 다소 느림.

- SBERT-base - smart batching:

- SBERT에 스마트 배치(Smart Batching)를 적용하여 효율을 향상시킨 버전.

- CPU와 GPU 환경 모두에서 속도가 크게 개선됨.

- Avg. GloVe embeddings:

- CPU / GPU:

- CPU:

- GPU가 없는 환경에서 모델이 초당 처리할 수 있는 문장의 수를 나타냄.

- CPU 환경에서는 경량화된 모델이 상대적으로 유리.

- GPU:

- 병렬 처리가 가능한 환경에서 초당 처리 가능한 문장 수.

- Transformer 기반 모델에서 GPU의 성능이 특히 두드러짐.

- CPU:

Table의 주요 메시지

1. CPU 환경에서의 성능

- Avg. GloVe embeddings:

- 초당 6469 문장을 처리하며 압도적으로 빠름.

- 하지만 단순 평균 방식이기 때문에 문맥 정보를 효과적으로 반영하지 못함.

- InferSent:

- 초당 137 문장을 처리하며 GloVe 대비 속도가 느림.

- 이는 BiLSTM 구조로 인해 계산량이 많기 때문.

- Universal Sentence Encoder (67):

- InferSent보다도 느리며, Transformer 기반 모델의 계산 비용이 높은 것을 보여줌.

- SBERT-base (44):

- 기존 모델들에 비해 다소 느리지만, 이는 Transformer 구조의 높은 계산 비용 때문.

- SBERT-base - smart batching (83):

- 스마트 배치를 통해 CPU 환경에서 성능이 크게 향상되며, USE와 비슷한 속도를 기록.

2. GPU 환경에서의 성능

- InferSent (1876):

- BiLSTM 기반 모델로 GPU를 활용한 경우 속도가 크게 향상됨.

- Universal Sentence Encoder (1318):

- GPU 환경에서 InferSent보다 약간 느리지만 여전히 좋은 성능을 보여줌.

- SBERT-base (1378):

- USE와 거의 동일한 속도를 기록하며, Transformer 기반임에도 효율적인 처리 속도를 달성.

- SBERT-base - smart batching (2042):

- 스마트 배치 기법 덕분에 GPU 환경에서 가장 빠른 속도를 기록.

스마트 배칭(Smart Batching)이란?

- 문장의 길이에 따라 배치(batch)를 구성하여 패딩(padding) 양을 최소화하는 기술.

- SBERT에서 스마트 배칭을 도입하면 불필요한 계산을 줄여 효율성을 대폭 향상할 수 있음.

Table의 주요 메시지 요약

- GloVe의 속도:

- GloVe 기반 단어 평균화 방식이 가장 빠르지만, 문맥 정보를 효과적으로 반영하지 못하므로 품질에서는 한계가 있음.

- InferSent와 USE:

- BiLSTM 기반 InferSent는 GPU에서 높은 효율성을 보여주지만, CPU에서는 상대적으로 느림.

- USE는 Transformer 기반으로 CPU와 GPU 환경 모두에서 균형 잡힌 성능을 제공.

- SBERT의 효율성:

- SBERT는 Transformer 기반으로 높은 품질의 문장 임베딩을 생성하면서도 GPU 환경에서 빠른 속도를 유지.

- 특히 스마트 배칭을 적용하면 CPU와 GPU 환경 모두에서 속도가 크게 개선됨.

결론

SBERT는 기존 모델에 비해 품질과 효율성을 동시에 제공하며, 스마트 배칭을 통해 계산 속도를 더욱 향상시킬 수 있습니다. 이는 SBERT가 대규모 데이터셋 처리 및 실시간 검색 시스템에서 특히 유리하다는 점을 보여줍니다. 추가적인 질문이나 상세 설명이 필요하면 말씀해주세요! 😊

Sentence-BERT: Sentence Embeddings Using Siamese BERT-Networks

1. 문제 정의

기존 BERT와 RoBERTa는 문장 쌍 회귀 작업(예: Semantic Textual Similarity, STS)에서 뛰어난 성능을 보여주지만, 모든 문장을 네트워크에 개별적으로 입력해야 하므로 계산 비용이 매우 큽니다. 예를 들어, 10,000개의 문장에서 가장 유사한 쌍을 찾으려면 약 50억 번의 추론이 필요하며, 이는 약 65시간의 계산 시간을 요구합니다. 이러한 계산량은 BERT 구조가 대규모 유사성 검색 및 클러스터링 같은 작업에 비효율적임을 보여줍니다.

2. 제안 방법

논문은 Sentence-BERT (SBERT)를 제안합니다. 이는 기존 BERT를 변형하여 Siamese Network와 Triplet Network 구조를 사용해 문장의 의미를 유지하면서 계산 비용을 크게 줄이는 문장 임베딩을 생성합니다. 주요 특징은 다음과 같습니다:

- SBERT는 문장을 벡터 공간으로 매핑하여 의미적으로 유사한 문장은 가까운 벡터로 표현.

- Cosine 유사도 등의 간단한 거리 계산으로 문장 간 유사성을 효율적으로 측정 가능.

3. 모델 구조

- Pooling 전략: SBERT는 문장의 [CLS] 토큰, 모든 토큰의 평균(MEAN), 또는 최대값(MAX)을 사용해 고정 크기의 문장 벡터를 생성.

- Fine-tuning:

- Classification Objective: 문장 벡터 u, v와 |u - v|를 연결해 softmax 분류기를 학습.

- Regression Objective: 두 문장 벡터 간 Cosine 유사도를 계산해 Mean Squared Error (MSE)로 학습.

- Triplet Objective: Anchor 문장, Positive 문장, Negative 문장의 임베딩 간 거리 차이를 최소화.

4. 학습 데이터

- SNLI(570,000 쌍)와 MultiNLI(430,000 쌍) 데이터셋을 사용해 SBERT를 학습.

- 문장 간 논리적 관계(모순, 함의, 중립)를 활용하여 유의미한 임베딩을 생성.

5. 결과 분석

- Semantic Textual Similarity (STS):

- STS 2012~2016, STS Benchmark(STSb), SICK-R 데이터에서 SBERT는 기존 방법보다 높은 Spearman 상관 계수를 기록.

- 평균적으로 Universal Sentence Encoder보다 5.5 포인트, InferSent보다 11.7 포인트 성능 우수.

- 효율성:

- GPU 기반 SBERT는 기존 InferSent 대비 9%, Universal Sentence Encoder 대비 55% 더 빠름.

- 10,000개의 문장을 클러스터링하는 데 소요 시간: 기존 BERT는 65시간, SBERT는 약 5초.

- 전이 학습 (SentEval):

- SBERT는 SentEval의 7가지 전이 학습 태스크 중 5개에서 최고 성능을 기록.

- 특히 감정 분석 관련 태스크(MR, CR, SST)에서 Universal Sentence Encoder 및 InferSent보다 높은 정확도.

- Ablation Study:

- Pooling 전략 중 MEAN이 가장 우수.

- Classification 목표에서는 |u - v| 차원의 추가가 가장 중요한 요소로 확인.

6. 의의와 한계

- 의의: SBERT는 문장 임베딩 생성에서 정확성과 효율성을 동시에 달성하며, 대규모 유사성 검색, 클러스터링, 정보 검색 등 다양한 태스크에서 활용 가능.

- 한계: 특정 태스크(예: Argument Facet Similarity)에서 SBERT는 일반화 성능이 떨어질 수 있음.

7. 결론

SBERT는 기존 BERT의 한계를 극복하기 위해 개발된 강력한 방법으로, 문장 임베딩의 품질과 계산 효율성을 모두 향상시켰습니다. 이는 BERT 구조의 활용 범위를 크게 확장시키며, 특히 실시간 검색 및 대규모 데이터 처리 태스크에 유용합니다.

Sentence-BERT 방법론

1. 문제 설정

기존의 BERT는 문장 간 유사도를 계산할 때 두 문장을 입력으로 받아 처리하는 Cross-Encoder 방식을 사용합니다. 이 방식은 정확도는 높지만, 대규모 데이터셋에서는 비효율적입니다. 예를 들어, 10,000개의 문장에서 가장 유사한 문장 쌍을 찾으려면 약 50억 번의 계산이 필요합니다. 이를 해결하기 위해 SBERT는 문장을 고정된 크기의 벡터로 변환하여 계산 비용을 획기적으로 줄이고 효율성을 개선합니다.

2. SBERT의 핵심 방법론

(1) Siamese Network 구조

SBERT는 Siamese Network 구조를 채택하여 두 문장을 독립적으로 BERT에 입력합니다. 두 네트워크는 동일한 가중치를 공유하며, 각 문장에서 고정된 크기의 벡터를 생성합니다. 이 구조를 통해 두 문장의 의미적 유사성을 측정할 수 있습니다.

구조 예시:

- 문장 A와 문장 B를 각각 BERT에 입력.

- 각 출력 벡터 u, v를 별도로 생성.

- 두 벡터 간 유사성을 Cosine Similarity로 계산.

(2) Pooling 기법

BERT는 입력 문장의 각 단어에 대한 컨텍스트 벡터를 생성하지만, 이를 문장 단위로 축약해야 합니다. SBERT는 다음 세 가지 Pooling 전략을 실험적으로 사용합니다:

- [CLS] 토큰: BERT의 출력 중 [CLS] 벡터를 사용.

- MEAN (평균): 모든 단어의 벡터 평균값을 계산.

- MAX (최댓값): 각 차원에서 최대값을 선택.

결론: 실험 결과 MEAN 전략이 가장 우수한 성능을 보였습니다.

(3) Fine-Tuning 기법

SBERT는 기존의 BERT를 Pretrained 모델로 활용하고, 추가 학습(fine-tuning)을 통해 문장 임베딩의 품질을 개선합니다. Fine-tuning 과정에서 사용된 학습 목표는 아래와 같습니다:

3. SBERT의 활용 예시

예시 1: Semantic Textual Similarity (STS)

예시 2: 문장 클러스터링

- 입력: 10,000개의 문장.

- 과정:

- 각 문장을 SBERT로 벡터화.

- 각 벡터 간 유사도를 계산하여 클러스터링 알고리즘(Hierarchical Clustering) 적용.

- 결과: BERT를 사용한 클러스터링(65시간 소요) 대비 SBERT는 5초 내외로 완료.

예시 3: 정보 검색

- 입력: 쿼리 문장("What is the capital of France?")과 문서 집합.

- 과정:

- 쿼리 문장과 문서 집합을 SBERT로 벡터화.

- 쿼리 벡터와 각 문서 벡터 간 유사도 계산.

- 가장 유사한 문서를 반환.

- 결과: 질의 응답 태스크에서 효율성 증대.

4. SBERT의 성능 분석

- 문장 임베딩 품질:

- SBERT는 Semantic Textual Similarity 및 SentEval에서 기존 모델보다 높은 성능을 기록.

- 계산 효율성:

- SBERT는 GPU에서 InferSent 대비 9%, Universal Sentence Encoder 대비 55% 빠름.

- 적용성:

- 대규모 데이터셋에서의 검색, 클러스터링, 의미적 문장 비교에 적합.

5. 결론

SBERT는 Siamese Network 구조와 효과적인 Fine-Tuning 기법을 통해 문장 임베딩의 품질을 크게 향상시키고, 계산 비용을 최소화했습니다. 이는 AI 연구에서 대규모 텍스트 데이터 처리와 관련된 다양한 응용 분야(예: 정보 검색, 문서 요약, 대화 시스템 구축)에 활용될 수 있습니다.

오 그럼 이 논문은 여러 토큰으로 이루어진 문장을 고정된 크기의 벡터로 변환하여 문맥을 함축하고 있고, 검색에도 뛰어난 성능을 가지도록 언어 모델을 만든거네?

네, 맞습니다! 이 논문은 문맥을 잘 함축한 고정된 크기의 벡터로 문장을 변환하는 데 초점을 맞췄고, 이를 통해 검색, 클러스터링, 정보 검색 등 다양한 태스크에서 뛰어난 성능을 발휘하도록 언어 모델을 설계한 것입니다.

SBERT는 BERT의 기본 구조를 활용하면서도 다음과 같은 특징으로 기존의 한계를 극복했습니다:

핵심 아이디어

- 고정 크기 벡터로 변환:

- SBERT는 문장을 벡터 공간으로 매핑하여 문맥 정보를 포함하는 고정된 크기의 임베딩을 생성합니다.

- 이 벡터는 문장의 의미를 함축하므로, 단순한 계산(Cosine Similarity)만으로도 문장 간의 의미적 유사성을 측정할 수 있습니다.

- 효율성 강화:

- 기존 BERT는 문장 쌍 간 비교 시 모든 조합을 입력으로 처리해야 하므로 계산량이 기하급수적으로 늘어났습니다.

- SBERT는 Siamese 구조를 통해 한 번의 전파로 각각의 문장을 독립적으로 처리하여 계산 비용을 획기적으로 줄였습니다.

- 검색과 클러스터링에 최적화:

- 생성된 벡터는 고유한 의미 공간에 위치하므로, 대규모 문서 데이터셋에서도 빠르게 유사성을 검색하거나 클러스터링할 수 있습니다.

- 예를 들어, Quora의 4천만 개 질문 중 가장 유사한 질문을 검색하는 데 기존 BERT는 50시간 이상 걸렸지만, SBERT는 몇 밀리초 내에 완료할 수 있습니다.

SBERT의 응용 가능성

- 정보 검색:

- 예: "파리의 수도는 무엇인가?"라는 질문을 입력하면, 파리와 관련된 정보를 포함하는 문서를 빠르게 검색.

- 검색 시스템의 백엔드에서 문장을 벡터로 변환해 효율적인 유사도 계산 수행.

- 의미적 문장 비교:

- 두 문장이 의미적으로 유사한지 판단.

- 예: "나는 커피를 좋아한다."와 "커피를 마시는 것이 좋다."가 같은 벡터 공간에서 가까운 거리를 가지도록 학습.

- 대규모 클러스터링:

- 비슷한 문장들을 그룹화하여 뉴스 요약, 주제 분류 등에서 활용.

- 다국어 처리:

- 동일한 아키텍처를 다국어 데이터셋에 학습시켜, 언어 간 의미적 비교를 지원.

SBERT의 의의

이 논문은 단순히 문장을 임베딩하는 것에 그치지 않고, 문맥적 의미를 보존하며 효율성을 극대화한 점에서 매우 큰 연구적 가치를 지닙니다. 특히 대규모 데이터 처리와 실시간 검색 태스크에서 BERT의 한계를 극복한 혁신적인 접근 방식으로 평가받고 있습니다.

😊

논문의 결과, 결론, 그리고 마무리

1. 결과

SBERT는 기존 BERT 및 다른 문장 임베딩 모델에 비해 다음과 같은 주요 결과를 도출했습니다.

(1) Semantic Textual Similarity (STS) 태스크

- SBERT는 STS 2012~2016, STS Benchmark(STSb), SICK-R 등 데이터셋에서 기존의 InferSent 및 Universal Sentence Encoder를 크게 상회하는 성능을 기록했습니다.

- STS 태스크에서 평균적으로 InferSent보다 11.7 포인트, Universal Sentence Encoder보다 5.5 포인트 높은 Spearman 상관 계수를 달성했습니다.

(2) 전이 학습 성능 (SentEval)

- SBERT는 SentEval 전이 학습 태스크 7가지 중 5개에서 최고 성능을 기록했습니다.

- 특히 감정 분석(MR, CR, SST) 관련 태스크에서 큰 성능 향상을 보였으며, 이는 SBERT 임베딩이 문장의 맥락적 의미를 잘 포착했음을 시사합니다.

(3) 계산 효율성

- SBERT는 계산 비용 측면에서도 기존 모델을 크게 능가했습니다:

- GPU 환경에서 SBERT는 InferSent보다 9%, Universal Sentence Encoder보다 55% 빠른 속도를 기록.

- SBERT의 효율적인 벡터 생성은 검색, 클러스터링, 정보 검색과 같은 대규모 데이터 처리 작업에서 특히 유용.

- 예를 들어, 10,000개의 문장을 클러스터링하는 데 기존 BERT는 65시간이 소요되지만, SBERT는 약 5초 만에 처리.

(4) 다양한 태스크 적용 가능성

- Argument Facet Similarity (AFS)와 Wikipedia Section Distinction과 같은 고급 태스크에서도 기존 모델 대비 높은 성능을 기록.

- AFS의 크로스 토픽 평가에서 성능이 다소 하락했지만, 이는 훈련 데이터의 다양성과 양을 확장함으로써 개선 가능.

2. 결론

SBERT는 BERT의 한계를 극복하고 다음과 같은 결론을 제시했습니다.

- 문장 임베딩 품질의 개선:

- SBERT는 기존 BERT가 생성하는 문장 벡터가 의미적 유사성 검색에 부적합하다는 점을 극복하여, 유의미한 임베딩을 생성.

- 이는 다양한 NLP 태스크에서 성능을 향상시키는 데 기여했습니다.

- 효율적인 유사도 계산:

- SBERT는 Siamese 네트워크 구조를 활용해 문장 쌍을 독립적으로 처리하고, Cosine Similarity 등의 간단한 방법으로 유사도를 측정.

- 이를 통해 대규모 문서 검색, 클러스터링 등 실용적인 응용이 가능.

- 다양한 응용 가능성:

- SBERT는 STS뿐만 아니라 전이 학습, 정보 검색, 대화형 AI 등에 적용 가능성을 제시.

- 특히, 효율적이고 정확한 문장 간 비교가 필요한 분야에 적합.

- BERT의 확장성 증대:

- SBERT는 BERT를 fine-tuning하여 문장 임베딩 품질을 대폭 향상시키면서도 계산 효율성을 유지.

- 이는 BERT의 활용 범위를 대폭 확장시켰습니다.

3. 마무리

논문은 SBERT가 문장 임베딩 품질과 계산 효율성을 모두 갖춘 모델임을 입증했습니다. 특히, 대규모 데이터 처리와 실시간 검색 환경에서 기존 BERT의 한계를 극복한 점은 중요한 공헌으로 평가됩니다. 연구팀은 SBERT가 문장 유사도 측정 및 검색 태스크에 혁신적인 도구로 자리 잡을 수 있음을 강조하며, 다음과 같은 메시지를 전달합니다:

- SBERT는 대규모 데이터 작업에서 필수적인 도구로 사용할 수 있습니다.

- SBERT는 단순히 새로운 모델이 아니라, 기존 BERT의 실질적인 활용성을 개선한 혁신적인 접근 방식입니다.

- 향후 연구 방향으로 더 많은 데이터셋과 태스크에 대해 SBERT를 확장하는 연구가 필요합니다.

연구 및 응용에의 제언

이 논문은 다양한 인공지능 응용에서 SBERT를 활용할 가능성을 열어줍니다. 특히:

- 정보 검색 시스템: 효율적이고 정확한 검색 엔진 개발.

- 문서 클러스터링 및 요약: 대규모 텍스트 데이터의 요약 및 군집화.

- 다국어 자연어 처리: 언어 간 의미 비교 및 다국어 텍스트 작업.

😊

관련 연구 및 논문

1. SBERT의 기초가 된 연구들

SBERT는 BERT를 기반으로 하고 있으며, 이를 개선하기 위해 다음과 같은 기존 연구를 활용했습니다:

| 연구/논문 | 핵심 아이디어 | SBERT와의 관계 |

| BERT (Devlin et al., 2018) | Transformer를 기반으로 한 사전 학습 언어 모델로, 문맥을 양방향으로 처리하여 다양한 NLP 태스크에서 SOTA 달성. | SBERT의 기본 구조로 사용되었으며, 문장 임베딩 품질을 개선하기 위해 fine-tuning 및 Siamese 네트워크 적용. |

| InferSent (Conneau et al., 2017) | BiLSTM 기반 문장 임베딩 모델로, NLI 데이터로 학습하여 높은 품질의 문장 임베딩 제공. | SBERT는 InferSent보다 정확도와 효율성을 모두 향상시킨 모델로, 동일한 NLI 데이터를 활용하여 성능을 비교. |

| Universal Sentence Encoder (Cer et al., 2018) | Transformer를 사용해 문장을 벡터로 변환하며, 질의 응답 및 문장 유사도 검색에 최적화. | SBERT는 Universal Sentence Encoder보다 더 효율적이고 정확한 문장 임베딩을 생성하여 STS 및 검색에서 성능을 초과. |

| Triplet Networks (Schroff et al., 2015) | Triplet Loss를 사용해 Anchor, Positive, Negative의 벡터 거리를 학습하여 임베딩 품질을 개선. | SBERT는 Triplet Loss를 문장 임베딩 학습 과정에 통합하여 벡터 간 유사도 계산을 개선. |

| RoBERTa (Liu et al., 2019) | BERT의 사전 학습 과정 개선(더 많은 데이터와 긴 학습 시간 사용)으로 성능을 향상시킨 모델. | SBERT는 RoBERTa를 활용한 변형 모델(SRoBERTa)을 실험적으로 평가하여 BERT와 성능 비교 수행. |

2. SBERT와 유사하거나 확장된 연구들

SBERT와 유사한 목표를 가진 연구 및 SBERT를 확장한 연구를 다음과 같이 정리할 수 있습니다:

| 연구/논문 | 핵심 아이디어 | SBERT와의 차별점 및 연계성 |

| MiniLM (Wang et al., 2020) | BERT의 경량화 버전으로, 더 적은 계산량으로 효율적인 문장 임베딩 생성. | SBERT는 문장 비교와 검색에 초점, MiniLM은 소규모 모델에서의 효율성을 강조. |

| SimCSE (Gao et al., 2021) | 문장 간 유사도를 학습하기 위해 Contrastive Learning을 사용. | SBERT는 NLI 데이터와 Triplet Loss를 활용, SimCSE는 대규모 비지도 학습 데이터와 대조 학습 전략 활용. |

| Sentence-T5 (Ni et al., 2021) | T5 모델을 기반으로 문장 임베딩 품질을 개선. | SBERT는 BERT와 RoBERTa 기반, Sentence-T5는 T5 기반으로 더 큰 사전 학습 모델을 사용하여 성능 강화. |

| Dense Passage Retrieval (DPR, 2020) | 효율적인 정보 검색을 위해 문장 벡터를 기반으로 한 쿼리-문서 매칭 모델. | DPR과 마찬가지로 SBERT도 검색에 적합하지만, SBERT는 보다 다양한 태스크(STS, 클러스터링)에도 활용 가능. |

| LaBSE (Feng et al., 2020) | 다국어 문장 임베딩 생성에 특화된 모델로, 다국어 문장 간 의미적 비교를 지원. | SBERT는 영어 중심, LaBSE는 다국어 태스크에 초점. SBERT도 다국어 데이터로 확장 가능성 있음. |

3. SBERT 활용 연구 및 응용

SBERT를 기반으로 한 응용 및 실질적 활용이 증가하면서 관련 연구가 활발히 진행되고 있습니다:

| 연구/논문 | 설명 | 연계성 |

| Semantic Search Systems | SBERT를 활용하여 의미적 검색 엔진 구축(예: Quora 질문 검색, FAQ 시스템). | SBERT는 검색 시스템에서 계산 효율성과 정확도를 대폭 향상. |

| Dialogue Systems (Chatbots) | SBERT 임베딩을 대화 시스템의 응답 생성 및 대화 흐름 유지를 위한 유사도 계산에 활용. | 자연어 이해가 필요한 대화 시스템에서 문맥적 이해를 강화. |

| Text Clustering & Summarization | 문서의 의미적 그룹화를 통해 요약 및 클러스터링 수행. | SBERT의 효율적인 임베딩이 대규모 데이터 요약에 적합. |

| Multilingual Applications | SBERT를 다국어 데이터셋으로 확장하여 언어 간 유사성 검색 및 다국어 NLP 태스크에 활용. | 다국어 처리가 필요한 응용에서 기존 LaBSE와 협업 가능. |

| Bias Detection in Text | SBERT 임베딩을 사용해 문장 내 편향성을 감지하고, 공정성을 향상시키는 연구. | 임베딩 공간에서 편향적 표현을 정량화하고 수정하는 데 SBERT가 활용됨. |

4. SBERT 이후 발전 가능성

- 확장 가능성:

- SBERT를 다른 사전 학습 언어 모델(T5, GPT 계열 등)과 결합하여 임베딩 품질을 강화.

- 다국어 모델과의 통합을 통해 언어 간 문맥 비교 및 검색 효율성 증대.

- 응용 가능성:

- 검색 엔진, 대화 시스템, 문서 요약, 질문 생성, 대규모 데이터 클러스터링 등에 폭넓게 활용 가능.

- 편향성 감지 및 수정과 같은 사회적 책임을 고려한 AI 시스템 개발에도 적용 가능.

SBERT는 단순히 하나의 모델에 그치지 않고, 다양한 연구 및 응용에서 중심적인 역할을 할 수 있는 기술적 기반을 제공합니다.

그럼 기존 InterSent와 Universal Sentence Encoder 방식은 어떻게 임베딩을 진행했는데 SBERT보다 연산 시간, 성능이 안 좋은 거야?

기존 InferSent와 Universal Sentence Encoder (USE)는 SBERT 이전의 문장 임베딩 모델로 널리 사용되었지만, 연산 시간과 성능에서 SBERT에 비해 뒤처졌습니다. 이를 이해하기 위해 각 모델의 방식과 SBERT와의 차이를 비교하겠습니다.

1. InferSent

- 방식:

- BiLSTM(Bidirectional LSTM) 네트워크를 사용하여 문장 임베딩 생성.

- Stanford NLI(SNLI)와 Multi-Genre NLI(MultiNLI) 데이터로 학습.

- BiLSTM의 출력 벡터에 Max Pooling을 적용하여 고정 크기의 벡터 생성.

- 특징:

- SNLI 데이터에 특화된 학습으로 비교적 높은 성능을 보여줌.

- 문장의 구조적 특징을 잘 반영하나, BiLSTM의 계산량이 많고 병렬화가 어려움.

- InferSent의 한계:

- 계산 시간: BiLSTM은 입력 문장의 길이에 따라 순차적으로 계산해야 하므로 병렬화가 제한됨. 이는 대규모 데이터셋에서 속도가 느린 주요 원인.

- 확장성 부족: NLI 데이터에 초점이 맞춰져 있어, 다른 도메인에서는 성능이 저하될 가능성이 큼.

- 임베딩 품질: SBERT처럼 Transformer의 강력한 문맥적 표현력을 활용하지 못해 의미적 비교에 한계가 있음.

2. Universal Sentence Encoder (USE)

- 방식:

- Transformer 또는 Deep Averaging Network(DAN)를 사용해 문장 임베딩 생성.

- 대규모 비지도 학습 데이터와 지도 학습 데이터(SNLI 등)를 결합하여 학습.

- 문장의 각 단어 벡터를 평균(Deep Averaging)하거나 Transformer 구조를 통해 문장 벡터 생성.

- 특징:

- Google에서 개발하여 웹 검색, FAQ 시스템 등 다양한 태스크에 사용.

- 비지도 학습 데이터(뉴스, 포럼 등)로 학습되어 도메인 일반화에 강점.

- TensorFlow 기반으로 구현되어 효율적인 계산 가능.

- USE의 한계:

- 연산 비용: Transformer 기반 USE는 SBERT보다 계산 효율이 떨어짐. SBERT는 문장 벡터를 미리 생성해 비교하는 반면, USE는 쿼리 시점에 모델 추론이 필요.

- 임베딩 품질: USE는 비지도 학습 데이터의 영향을 많이 받아 특정 태스크(NLI 기반 STS 등)에서는 SBERT보다 성능이 낮음.

- Fine-Tuning 부족: USE는 일반적 학습에 초점이 맞춰져 있으며, SBERT처럼 특정 태스크(STS, NLI)에 최적화되지 않음.

3. SBERT와의 차이

| 모델 | 임베딩 방식 | 연산 시간 | 성능 |

| InferSent | BiLSTM + Max Pooling | 느림: BiLSTM의 순차적 계산으로 병렬화 어려움. | SBERT보다 성능 낮음: Transformer 기반 모델 미사용. |

| USE | Transformer 또는 Deep Averaging | 중간: Transformer 기반, 다소 비효율적. | 도메인 일반화 강점: 비지도 학습 데이터 사용. |

| SBERT | Siamese BERT 구조 + Cosine Similarity | 빠름: 문장 벡터를 사전 계산 후 효율적 비교 가능. | STS, NLI 등 특정 태스크에서 최고 성능. |

4. SBERT의 우위

- 연산 시간 효율성:

- SBERT는 Siamese 구조를 사용하여 문장 벡터를 독립적으로 계산.

- 한 번 계산한 벡터는 재사용 가능하므로 검색, 클러스터링, 유사성 비교에서 매우 효율적.

- 예: 10,000개 문장의 모든 조합 유사도 계산 시, 기존 BERT는 65시간 소요되지만 SBERT는 5초 만에 완료.

- 성능 개선:

- BERT의 사전 학습된 언어 표현력을 활용하고, NLI 데이터로 Fine-Tuning하여 문장 간 의미적 유사성을 잘 반영.

- 기존 InferSent, USE보다 STS와 같은 지도 학습 태스크에서 높은 정확도.

- 태스크 적응성:

- SBERT는 다양한 목적에 맞게 Fine-Tuning 가능.

- InferSent와 USE는 고정된 모델 구조와 데이터로 인해 특정 도메인에 최적화하기 어려움.

5. 결론

SBERT는 효율성과 성능 모두를 개선한 문장 임베딩 모델로, 기존의 InferSent와 USE의 한계를 극복했습니다. 이는 SBERT가 기존 방식에 비해 다음과 같은 강점을 가지기 때문입니다:

- Siamese 구조로 계산 효율성을 극대화.

- BERT 기반 Fine-Tuning으로 문맥적 의미를 잘 포착.

- 다양한 태스크에서 적용 가능하며, 특히 STS와 검색 태스크에서 뛰어난 성능.

이로 인해 SBERT는 문장 비교와 검색 작업에 있어 사실상 새로운 표준을 제시했다고 볼 수 있습니다. 추가적인 세부 사항이 궁금하면 말씀해주세요! 😊

당신이 작성한 요약은 논문의 핵심을 간단하게 잘 잡아냈지만, 약간의 오해와 부정확한 표현이 있습니다. 이를 수정하고 보완한 내용을 아래에 제시합니다:

수정 및 보완된 요약:

- RAG와의 관계:

- SBERT는 RAG(Retrieval-Augmented Generation)와 직접적인 연관이 있는 논문은 아닙니다. 다만, RAG와 같은 검색 기반 시스템에서 SBERT의 효율적인 문장 임베딩 기술을 활용할 수 있습니다. SBERT는 검색 태스크를 위한 핵심 기술로 활용되기 때문에 RAG와 간접적으로 유용한 역할을 할 수 있습니다.

- 기술적 개선 사항:

- SBERT는 BERT 구조를 변경한 것이 아니라, BERT를 활용하여 Siamese 네트워크 구조로 확장하고 문장을 고정된 크기의 벡터로 변환하는 방식을 도입했습니다.

- 단순히 "단일 벡터 하나를 생성한다"는 표현은 SBERT의 역할을 축소할 수 있으므로, 고정 크기 벡터를 생성하여 문맥적 의미를 함축한다는 점을 강조해야 합니다.

- 빠른 검색 구현:

- SBERT는 생성된 고정 크기의 벡터를 활용하여 Cosine Similarity와 같은 간단한 계산만으로도 문장 간 의미적 유사도를 빠르게 계산할 수 있습니다.

- 기존 BERT가 문장 간 비교를 위해 모든 쌍을 입력으로 받아야 했던 것과 달리, SBERT는 각 문장의 벡터를 독립적으로 계산하므로 계산 비용이 획기적으로 절감됩니다.

- 효율성의 핵심:

- 단순히 "시간을 단축했다"가 아닌, 기존 BERT 구조에서 계산량이 기하급수적으로 증가하던 문제를 해결했다는 점을 명확히 해야 합니다.

- 예를 들어, 10,000개의 문장에서 가장 유사한 문장을 찾는 데 기존 BERT는 65시간이 소요되지만, SBERT는 5초 내외로 처리 가능합니다.

개선된 요약:

SBERT는 기존 BERT를 활용한 검색 및 문장 유사도 계산에서 발생하던 대규모 계산 비용 문제를 해결한 혁신적인 논문입니다. 기존 BERT는 모든 문장 쌍을 네트워크에 입력해야 했지만, SBERT는 Siamese 네트워크 구조를 도입하여 각 문장을 독립적으로 고정 크기 벡터로 변환합니다. 이를 통해 Cosine Similarity로 문장 간 유사도를 빠르고 효율적으로 계산할 수 있습니다.

결과적으로, SBERT는 기존 방식 대비 효율성을 극대화하여 대규모 데이터 검색(예: FAQ 검색, 클러스터링)과 같은 작업에서 시간을 획기적으로 단축하는 데 성공했습니다. 예를 들어, 10,000개의 문장에서 유사도를 계산하는 작업은 기존 65시간에서 5초 내외로 단축되었습니다.

추가적으로 궁금하거나 수정이 필요한 부분이 있으면 알려주세요! 😊