https://arxiv.org/abs/2404.13627

NegotiationToM: A Benchmark for Stress-testing Machine Theory of Mind on Negotiation Surrounding

Large Language Models (LLMs) have sparked substantial interest and debate concerning their potential emergence of Theory of Mind (ToM) ability. Theory of mind evaluations currently focuses on testing models using machine-generated data or game settings pro

arxiv.org

여기서도 생성 능력보단 일단 부수적으로 무슨 생각을 하면서 이런 말을 했는지 예측하는 것에 먼저 관심을 가졌네요

수동으로 하나하나 데이터 작업을 했다는 것, 다양한 모델 시험을 통해 Zero-shot, CoT, Few-shot 사용하여 최고의 결과를 가져오려 했다는 것이 좋긴 한데 사실 저는 이 ToM이 그렇게 중요한지 아직도 잘 모르겠어서...

아직 인간을 잘 이해하지 못한다는 것에 대한 증거가 되나 싶기도 하고여

| 연구 목표 | LLM의 Theory of Mind(ToM) 능력을 현실적인 협상 시나리오에서 평가하고, 인간과의 성능 격차를 분석. |

| 배경 및 문제 | - 기존 ToM 평가 방식은 합성 데이터 또는 게임 기반으로 실제 사회적 맥락을 반영하지 못함. - LLM이 타인의 욕구, 믿음, 의도를 정확히 추론하지 못하는 한계 존재. |

| 데이터셋 | - CaSiNo 데이터셋 활용 및 수정. - 캠핑 협상을 주제로 음식, 물, 장작에 대한 대화를 포함. - 욕구(Desire), 믿음(Belief), 의도(Intention) 주석 추가. |

| 방법론 | - Belief-Desire-Intention(BDI) 모델 기반으로 다차원적 정신 상태를 평가. - 욕구(선호도), 믿음(상대방의 추론), 의도(협상 전략)를 각각 추적 및 분석. |

| 평가 메트릭 | 1. 정확도(Accuracy): 욕구, 믿음, 의도 예측의 정확도. 2. 일관성(Consistency): 대화 전체에서 정신 상태 변화를 추적. 3. "All" 스코어: 욕구, 믿음, 의도를 모두 정확히 맞춘 경우. |

| 모델 성능 결과 | - GPT-4(CoT): 욕구와 믿음에서 가장 우수한 성능. - Claude-v2.1(CoT): 의도(Intention)에서 가장 높은 성능. - 인간 대비 성능 격차: 욕구 27.85%, 믿음 32.96%, 의도 43.82%. |

| 오류 분석 | - 욕구/믿음: 정보 부족 시 무작위 선택 경향. - 의도: 잘못된 의도를 포함하거나 올바른 의도를 누락. |

| 결론 | - LLM은 현실적 맥락에서 인간 수준의 ToM 능력을 달성하지 못함. - 복잡한 대화 맥락에서의 일관성 유지와 추론 능력이 부족. |

| 기여 | 1. ToM 평가를 위한 첫 번째 현실적 협상 대화 벤치마크 제공. 2. LLM의 ToM 한계를 정량적으로 분석하여 향후 개선 방향 제시. |

| 향후 연구 방향 | - 능동적 ToM 평가: 모델이 직접 상호작용하며 협상 전략 학습. - 멀티모달 접근: 언어 외에 표정, 제스처 등 통합. - 윤리적 고려: 공정성과 편향 방지. |

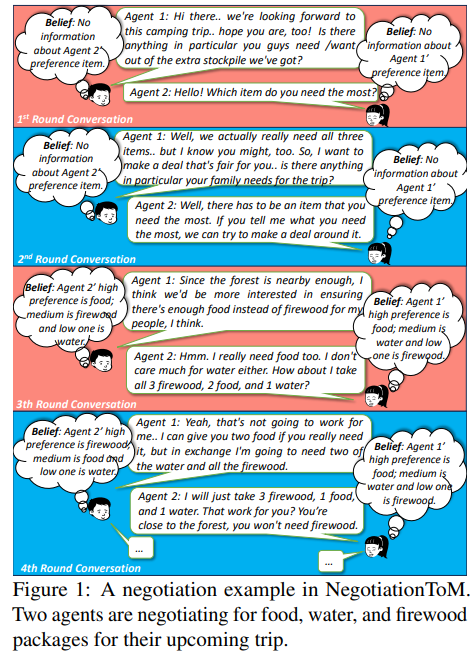

이 Figure는 NegotiationToM에서 사용된 협상 과정의 예제를 시각적으로 보여줍니다. 두 명의 에이전트가 음식(Food), 물(Water), 장작(Firewood)이라는 세 가지 항목을 협상 대상으로 하여 캠핑을 준비하는 상황을 묘사하고 있습니다. 각 라운드의 대화와 함께 에이전트들이 서로의 욕구(Desire)와 믿음(Belief)을 추론하는 과정을 설명하고 있습니다.

Figure 내용 설명

1st Round Conversation (첫 번째 라운드)

- 대화 내용:

- Agent 1: "우리는 캠핑을 준비 중이고, 추가 물품에서 당신이 가장 필요로 하는 것이 무엇인지 궁금합니다."

- Agent 2: "어떤 항목이 가장 필요한가요?"

- Belief(믿음):

- 양쪽 모두 상대방의 우선순위에 대한 정보가 없습니다(초기 상태).

- 이 라운드는 서로의 필요를 탐색하기 위한 질문과 응답으로 시작됩니다.

2nd Round Conversation (두 번째 라운드)

- 대화 내용:

- Agent 1: "우리는 세 가지 항목 모두 필요하지만, 당신도 필요할 거라는 걸 알아요. 공정한 협상을 하고 싶습니다. 가족이 가장 필요로 하는 것이 무엇인가요?"

- Agent 2: "당신이 가장 필요로 하는 항목을 알려주면, 저희가 협상을 진행할 수 있을 것 같아요."

- Belief(믿음):

- 여전히 서로의 우선순위에 대한 명확한 정보는 없습니다.

- 양쪽 모두 상대방의 필요를 더 구체적으로 탐색하려고 노력합니다.

3rd Round Conversation (세 번째 라운드)

- 대화 내용:

- Agent 1: "우리는 숲 근처라서 장작이 부족하지 않습니다. 음식이 더 중요합니다."

- Agent 2: "저희는 음식이 정말 필요해요. 이렇게 하죠: 장작 3개, 음식 2개, 물 1개를 제가 가져가면 어떨까요?"

- Belief(믿음):

- Agent 1: "Agent 2의 우선순위는 음식이 가장 높고, 중간은 물, 낮음은 장작."

- Agent 2: "Agent 1의 우선순위는 음식이 높고, 중간은 물, 낮음은 장작."

- 양쪽 모두 협상 과정에서 상대방의 우선순위에 대한 믿음을 형성하고, 자신의 필요에 맞는 제안을 시작.

4th Round Conversation (네 번째 라운드)

- 대화 내용:

- Agent 1: "그건 좀 안 될 것 같아요. 제가 물 2개를 드릴 테니 장작은 전부 저에게 주세요."

- Agent 2: "알겠어요. 장작 3개, 음식 1개, 물 1개를 제가 가져갈게요. 숲 근처에 계시니 장작이 필요 없으시죠?"

- Belief(믿음):

- Agent 1: "Agent 2는 장작을 가장 선호하고, 중간은 음식, 낮음은 물."

- Agent 2: "Agent 1은 음식이 가장 중요하고, 중간은 물, 낮음은 장작."

- 이 라운드에서 최종적으로 거래가 성사되며, 협상 종료.

Figure의 목적

이 Figure는 협상 대화 중 각 에이전트가 서로의 욕구(Desire)와 믿음(Belief)을 어떻게 추론하고 변화시키는지를 보여줍니다. 이를 통해:

- 협상 맥락에서 LLM이 추론해야 할 다차원적 정신 상태(욕구, 믿음, 의도)를 시각적으로 명확히 설명.

- 협상 과정이 어떻게 진행되며, 각 라운드에서 추론이 어떻게 발전하는지 단계적으로 이해할 수 있음.

Figure의 중요성

- 이 시각화는 NegotiationToM이 인간의 협상 대화를 얼마나 현실적으로 모방했는지 보여주며, LLM이 해결해야 할 주요 과제를 명확히 합니다.

- LLM은 단순히 문맥을 이해하는 것을 넘어, 대화 상대의 우선순위를 정확히 추론하고 협상 전략을 형성해야 하는 복잡한 작업에 도전합니다.

이 Table은 NegotiationToM에서 제시된 협상 대화 예제를 통해 LLM이 평가해야 하는 세 가지 정신 상태(욕구, 믿음, 의도)를 구체적으로 설명하고 있습니다.

Table의 구성

1. 상단: 평가 질문 (NegotiationToM Questions)

- Table 상단에는 세 가지 질문 유형이 명시되어 있습니다. 이는 협상 대화에서 LLM이 예측해야 할 정신 상태를 나타냅니다:

- Desire Question:

- "Agent 1/Agent 2가 특정 항목(음식, 물, 장작)에 대해 <높음/중간/낮음> 우선순위를 가지는가?"

- 대화 히스토리를 기반으로 에이전트의 욕구(Desire)를 추론.

- Belief Question:

- "Agent 1/Agent 2가 상대방의 우선순위를 어떻게 생각하는가?"

- 믿음(Belief)을 평가하며, 한 에이전트가 상대방의 욕구를 어떻게 이해하고 있는지 추론.

- Intention Question:

- "특정 발화(Utterance)의 의도는 무엇인가?"

- 협상 중 발화의 의도(Intention)를 분석.

- Desire Question:

2. 하단: 대화 예제와 정신 상태 주석

Table 하단에는 4개의 협상 라운드를 예시로 들며, 각 라운드에서 발화 내용과 세 가지 정신 상태(욕구, 믿음, 의도)를 구체적으로 주석으로 보여줍니다.

1st Round Conversation (첫 번째 라운드):

- 대화:

- P1: "우리는 캠핑을 준비 중입니다. 추가 물품 중 당신이 가장 필요로 하는 것은 무엇인가요?"

- P2: "어떤 항목이 가장 필요한가요?"

- Intention (의도):

- P1: 관계 구축(Build-Rapport), 필요 탐색(Discover-Preference).

- P2: 필요 탐색(Discover-Preference).

- Belief (믿음):

- 양쪽 모두 상대방의 우선순위에 대한 정보가 없음(Not Given).

- Desire (욕구):

- 양쪽 모두 자신의 우선순위에 대한 정보를 제공하지 않음(Not Given).

2nd Round Conversation (두 번째 라운드):

- 대화:

- P1: "우리 모두 3가지 항목이 필요하지만, 공정한 거래를 하고 싶습니다. 당신의 가족이 가장 필요로 하는 것이 무엇인가요?"

- P2: "당신이 가장 필요로 하는 항목을 알려주면, 협상할 수 있을 것 같아요."

- Intention (의도):

- P1: 필요 설명(Describe-Need), 공정성 요구(Callout-Fairness).

- P2: 필요 탐색(Discover-Preference).

- Belief (믿음):

- 여전히 상대방의 우선순위에 대한 정보가 없음.

- Desire (욕구):

- 여전히 자신의 우선순위를 명시하지 않음.

3rd Round Conversation (세 번째 라운드):

- 대화:

- P1: "우리는 숲 근처라 장작이 충분합니다. 음식이 더 필요합니다."

- P2: "음식이 정말 필요해요. 제가 장작 3개, 음식 2개, 물 1개를 가져가도 될까요?"

- Intention (의도):

- P1: 필요 설명(Describe-Need).

- P2: 필요 설명(Describe-Need), 협상 제안(No-Need).

- Belief (믿음):

- P1: 상대방은 음식 > 물 > 장작 순으로 선호.

- P2: 상대방은 음식 > 물 > 장작 순으로 선호.

- Desire (욕구):

- P1: 음식 > 물 > 장작.

- P2: 음식 > 물 > 장작.

4th Round Conversation (네 번째 라운드):

- 대화:

- P1: "제가 물 2개를 드릴 테니, 장작은 전부 저에게 주세요."

- P2: "장작 3개, 음식 1개, 물 1개를 가져갈게요."

- Intention (의도):

- P1: 협력 촉진(Promote-Coordination).

- P2: 의도 없음(No-Intention).

- Belief (믿음):

- P1: 상대방은 장작 > 음식 > 물 순으로 선호.

- P2: 상대방은 음식 > 물 > 장작 순으로 선호.

- Desire (욕구):

- P1: 음식 > 물 > 장작.

- P2: 장작 > 음식 > 물.

Table의 목적

- 세 가지 정신 상태의 평가 명확화:

- LLM이 협상 대화에서 욕구, 믿음, 의도를 각각 어떻게 예측해야 하는지를 구체적으로 제시.

- 대화의 점진적 진행과 추론 변화 설명:

- 라운드별로 에이전트의 발화와 그로 인한 믿음과 욕구의 변화를 체계적으로 보여줌.

- 협상 대화의 복잡성 시각화:

- 대화 속에서 상대방의 정신 상태를 추론하는 작업이 단순하지 않음을 강조.

Table의 중요성

이 표는 LLM이 해결해야 할 ToM 문제를 명확히 정의하며, 평가를 위한 구체적인 기준(욕구, 믿음, 의도)을 제공하여 연구의 체계성을 강조합니다. 이는 LLM이 단순한 텍스트 이해를 넘어 대화의 맥락과 인간의 복잡한 심리 상태를 추론할 수 있는 능력을 요구한다는 점을 시사합니다.

이 두 테이블은 각각 협상 의도와 전략 분류(Table 2)와 Belief(믿음) 및 Desire(욕구)에 대한 평가자 일치도(Table 3)를 나타내며, 연구의 방법론 및 데이터 품질을 설명하는 데 사용됩니다.

Table 2: 협상 전략과 의도 매핑

이 테이블은 협상 대화에서 발화의 의도를 다양한 협상 전략과 매핑한 것입니다. 협상 대화에서 나타나는 의도를 분류하여, LLM이 발화의 맥락과 의도를 이해하고 추론하는 기준을 제공합니다.

구성

- Strategies (전략): 협상 대화에서 사용된 전략을 나타냅니다.

- Intentions (의도): 각 전략이 발화에서 나타내는 의도를 정의합니다.

전략 및 의도의 예시

- Small-Talk (Build-Rapport):

- 전략: 상대방과 친밀감을 쌓기 위한 대화.

- 의도: 상대방과의 관계를 형성(Build Rapport).

- Empathy (Show-Empathy):

- 전략: 상대방의 상황에 공감.

- 의도: 공감을 표현(Show Empathy).

- Coordination (Promote-Coordination):

- 전략: 협력을 촉진.

- 의도: 협력 촉진(Promote Coordination).

- Elicit-Pref (Discover-Preference):

- 전략: 상대방의 우선순위를 탐색.

- 의도: 우선순위 탐색(Discover Preference).

- Vouch-Fairness (Callout-Fairness):

- 전략: 공정성에 호소.

- 의도: 공정성을 요구(Callout Fairness).

- No-Need (No-Need):

- 전략: 자신이 특정 물품을 필요로 하지 않음을 강조.

- 의도: 필요 없음(No Need).

- Non-strategic (No-Intention):

- 전략: 발화에서 명확한 의도가 없음.

- 의도: 의도 없음(No Intention).

Table 2의 목적

- 협상 발화의 의도 분류:

- 협상 대화에서 의도를 다양한 전략으로 체계적으로 분류하여 LLM이 이를 예측하고 학습할 수 있도록 설계.

- LLM 평가 기준 제공:

- LLM이 단순히 문맥을 이해하는 것을 넘어 발화의 전략적 의도를 정확히 추론해야 함을 강조.

Table 3: Belief 및 Desire 상태에 대한 평가자 일치도

이 테이블은 협상 대화 데이터에서 Belief(믿음)와 Desire(욕구)의 우선순위(high/medium/low)에 대해 주석을 달 때, 평가자 간 일치도를 Fleiss’s Kappa(κ)로 측정한 결과를 보여줍니다.

구성

- Task (작업): Belief와 Desire 상태를 각각 high, medium, low로 구분하여 평가.

- Fleiss’s Kappa (%): 평가자 간의 주석 일치도를 백분율로 표시. 높은 값일수록 평가자 간 합의가 높음을 의미.

결과

- Desire:

- High: 83.02%

- Medium: 72.23%

- Low: 79.32%

- Medium 상태에서 일치도가 상대적으로 낮지만, 전반적으로 높은 합의도를 보임.

- Belief:

- High: 85.25%

- Medium: 74.03%

- Low: 78.81%

- Desire와 마찬가지로 Medium 상태에서 일치도가 다소 낮음.

Table 3의 목적

- 데이터 주석의 신뢰성 검증:

- 평가자 간 높은 일치도를 통해 데이터 주석의 신뢰성과 품질이 보장되었음을 증명.

- 데이터 품질 향상:

- Medium 상태에서 상대적으로 낮은 일치도를 통해 데이터 주석 프로세스 개선 가능성을 시사.

두 테이블의 연구 기여

- Table 2는 협상 대화에서 의도와 전략의 관계를 정의하여 LLM이 협상 대화의 맥락과 의도를 학습할 수 있는 기초를 제공합니다.

- Table 3은 데이터의 신뢰성을 Fleiss’s Kappa로 측정하여 주석 품질이 높은 수준임을 보장하며, LLM의 학습과 평가가 신뢰할 수 있는 데이터에서 이루어짐을 확인합니다.

이 두 테이블은 협상 대화 데이터를 분석하고 LLM의 ToM 능력을 평가하는 데 있어 중요한 기반 자료를 제공합니다.

Figure 2와 Figure 3 설명

이 두 Figure는 LLM이 욕구(Desire)와 믿음(Belief) 상태를 추론할 때 발생한 모델 오류의 유형과 빈도를 시각적으로 보여줍니다. 각각의 Figure는 다양한 모델(GPT-4, Claude, ChatGPT, LLaMA 등)의 성능을 비교하며, 오류 유형별로 구분하여 모델의 약점을 명확히 나타냅니다.

Figure 2: 욕구 상태(Desire State)에 대한 모델 오류

구성

- 가로축: 오류의 총 빈도.

- 세로축: 평가된 모델(LLM) 종류.

- 오류 유형:

- Irrelevant Response (녹색):

- 대화와 관련 없는 응답을 생성.

- Incorrect Preference Order (주황색):

- 항목(음식, 물, 장작)의 우선순위를 잘못 추론.

- Incorrect Items Selection (파란색):

- 잘못된 항목을 선택.

- Irrelevant Response (녹색):

주요 관찰

- Irrelevant Response:

- 모든 모델에서 빈도가 낮음(녹색 막대가 짧음).

- 대체로 대화와 관련된 응답은 제공하지만, 세부 추론에서 실수가 많음.

- Incorrect Preference Order:

- LLM이 항목 간 우선순위를 잘못 추론하는 경우가 많음.

- Claude-v1.3과 LLaMA2(특히 13B 모델)가 이 오류의 비율이 높음.

- Incorrect Items Selection:

- GPT-4(CoT)가 이 오류를 가장 적게 발생시킴.

- LLaMA2-Chat(70B)은 대체로 많은 항목 선택 오류를 보임.

- Chain-of-Thought(CoT) 효과:

- CoT를 적용하면 대부분의 모델에서 오류가 줄어드는 경향을 보임.

- 특히 GPT-4(CoT)는 오류 빈도가 가장 적음.

Figure 3: 믿음 상태(Belief State)에 대한 모델 오류

구성

- 구성 방식은 Figure 2와 동일하며, 믿음 상태의 추론 오류를 분석.

주요 관찰

- Irrelevant Response:

- 믿음 상태에서도 관련 없는 응답은 거의 없으며, 대부분의 모델이 대화와 연관된 내용을 제공.

- Incorrect Preference Order:

- 믿음 상태 추론에서도 Claude와 LLaMA2-Chat 모델이 높은 오류율을 보임.

- GPT-4(CoT)는 비교적 낮은 오류율을 보임.

- Incorrect Items Selection:

- Claude-v1.3(CoT) 및 LLaMA2(70B)의 오류 비율이 높음.

- 믿음 상태 추론에서는 아이템 선택 오류가 욕구 상태에 비해 더 두드러짐.

- CoT의 효과:

- CoT를 적용한 GPT-4(CoT)는 믿음 상태에서도 가장 낮은 오류를 보임.

- LLaMA2(CoT) 모델은 일부 개선되었지만 여전히 오류 비율이 높음.

Figure의 목적

- 모델의 약점 파악:

- 욕구(Desire)와 믿음(Belief)를 추론할 때 주로 발생하는 오류의 유형과 빈도를 시각화하여 모델의 약점을 명확히 분석.

- Incorrect Preference Order와 Incorrect Items Selection이 주요 오류 유형임을 강조.

- 모델 성능 비교:

- 다양한 모델(GPT-4, Claude, ChatGPT, LLaMA 등)의 오류 비율을 비교함으로써 각각의 강점과 약점을 식별.

- 특히 GPT-4(CoT)가 다른 모델보다 정확도가 높음을 보여줌.

- CoT의 효과 평가:

- Chain-of-Thought(CoT) 방법이 대부분의 모델에서 오류를 줄이고 성능을 향상시킴을 확인.

- CoT 적용이 LLM의 ToM 추론 능력 향상에 효과적임을 뒷받침.

Figure의 중요성

이 두 Figure는 욕구와 믿음 상태를 추론할 때 모델이 자주 발생시키는 오류와 그 분포를 시각적으로 보여줍니다. 이를 통해:

- 모델의 성능 한계를 파악하고, 특정 유형의 오류를 개선할 방향성을 제시.

- CoT 방법론의 유효성을 확인하여, 복잡한 맥락 추론에서 모델 성능을 높이는 방안을 제공.

- LLM이 인간의 정신 상태를 추론하는 ToM(Task of Mind) 과제에서 여전히 인간 수준에 도달하지 못했음을 입증.

이 정보는 향후 LLM 개선과 ToM 연구 방향 설정에 중요한 기여를 합니다.

Figure 4와 Figure 5 설명

Figure 4: Intention State의 모델 오류

이 Figure는 LLM이 협상 대화에서 의도(Intention)를 추론할 때 발생한 오류를 분석한 결과를 보여줍니다. 모델별로 주요 오류 유형의 빈도를 비교합니다.

구성

- 가로축: 모델 오류의 총 빈도.

- 세로축: 평가된 모델(LLaMA2, Claude, ChatGPT, GPT-4 등).

- 오류 유형:

- Irrelevant Response (녹색):

- 대화 맥락과 관련 없는 응답을 생성.

- Did Both (파란색):

- 올바른 의도와 잘못된 의도를 동시에 포함.

- Excluded Correct Intentions (주황색):

- 올바른 의도를 누락.

- Include Incorrect Intentions (분홍색):

- 잘못된 의도를 포함.

- Irrelevant Response (녹색):

주요 관찰

- Irrelevant Response:

- 대부분의 모델에서 발생 빈도가 낮음(녹색 막대가 짧음).

- 대화 맥락에 맞는 응답은 대체로 생성하지만, 의도 추론에서 세부적인 오류 발생.

- Excluded Correct Intentions:

- Claude 시리즈와 LLaMA2 시리즈(특히 70B 모델)에서 빈도가 높음.

- 모델이 대화 의도 중 일부를 인식하지 못하는 경우.

- Include Incorrect Intentions:

- 모든 모델에서 가장 높은 빈도를 차지.

- 특히 LLaMA2(13B, 70B) 모델과 Claude-v1.3(CoT)이 이 오류를 자주 발생시킴.

- CoT의 효과:

- CoT 적용 시 Claude 및 GPT-4 모델에서 오류 빈도가 감소.

- 특히 GPT-4(CoT)가 모든 오류 유형에서 가장 낮은 빈도를 보임.

Figure 5: Intention State의 라벨별 F1 점수

이 Figure는 각 의도(Intention) 라벨에 대해 LLM의 F1 점수를 시각화한 결과를 나타냅니다. 각 모델이 특정 의도를 얼마나 잘 추론했는지 비교합니다.

구성

- 가로축: 의도 라벨(Build-Rapport, Show-Empathy, 등).

- 세로축: F1 점수(정확도와 재현율의 조화 평균).

- 막대: 모델별 성능(LLaMA2, Claude, ChatGPT, GPT-4 등).

주요 관찰

- 전반적인 성능:

- GPT-4(CoT)가 대부분의 의도에서 가장 높은 F1 점수를 기록.

- Claude 시리즈(CoT 적용 시)는 중간 수준의 성능을 보임.

- LLaMA2 모델은 전반적으로 낮은 성능을 보이며, 특히 복잡한 의도에서 오류가 많음.

- 의도별 성능 차이:

- Build-Rapport (관계 형성):

- 대부분의 모델에서 성능이 높음.

- 간단한 의도 추론에는 LLM이 강점을 보임.

- Show-Empathy (공감 표현):

- LLaMA2와 Claude에서 낮은 성능을 보임.

- GPT-4(CoT)는 비교적 높은 성능을 기록.

- Promote-Coordination (협력 촉진):

- 모든 모델에서 성능이 낮음.

- 이 의도는 상대적으로 복잡하여 LLM이 정확히 추론하기 어려움.

- No-Intention (의도 없음):

- Claude-v1.3(CoT)와 GPT-4(CoT)가 높은 점수를 보임.

- Build-Rapport (관계 형성):

- Undermine-Requirements (요구 조건 약화):

- 대부분의 모델에서 낮은 성능을 보임.

- 이 의도는 추론이 어렵고 맥락적 이해를 많이 요구.

두 Figure의 목적

- 모델의 약점 파악 (Figure 4):

- Intention 추론 시 발생하는 오류의 구체적인 유형과 빈도를 분석하여 모델의 약점을 체계적으로 이해.

- 특정 모델(Claude-v1.3, LLaMA2)의 주요 오류 원인을 확인.

- 의도별 성능 분석 (Figure 5):

- 특정 의도(Build-Rapport, Undermine 등)에 대해 LLM의 성능을 비교하여 모델 간의 강점과 약점을 식별.

- 의도별로 복잡성과 성능의 상관관계를 확인.

Figure의 중요성

- 의도 추론에서 모델의 한계 확인:

- Intention 추론에서 LLM이 맥락을 완전히 이해하지 못하고 오류를 범하는 이유를 명확히 설명.

- 특히 협력 촉진(Promote-Coordination)과 요구 약화(Undermine-Requirements) 같은 복잡한 의도에서 어려움을 겪음.

- CoT의 유효성 입증:

- Chain-of-Thought(CoT) 방식이 Intention 추론에서 모델의 성능을 향상시킴을 강조.

- 미래 연구 방향 제시:

- 특정 의도(특히 복잡한 의도)에서 LLM의 성능을 개선하기 위한 데이터 증강 및 훈련 방법 필요.

- 대화 맥락의 더 깊은 이해를 위한 모델 구조 개선의 필요성을 시사.

이 Figure는 LLM이 협상 대화의 의도를 추론하는 데 있어 여전히 인간 수준에 미치지 못함을 보여주며, 연구 개선 방향을 구체적으로 제시합니다.

논문 요약: NegotiationToM: A Benchmark for Stress-testing Machine Theory of Mind on Negotiation Surrounding

1. 연구 배경 및 문제 정의

- 이론적 배경: Theory of Mind(ToM)은 타인의 정신 상태(욕구, 믿음, 의도)를 추론하는 능력을 의미하며, 이는 인간의 사회적 상호작용 및 의사소통의 핵심 요소입니다.

- 현 상황 문제점:

- 현재 LLM(Large Language Models)에 대한 ToM 평가 대부분이 기계 생성 데이터나 게임 기반으로 이루어져 있어 현실적 맥락에서의 ToM 능력을 반영하지 못함.

- 기존 평가 방식은 단축(shortcuts)과 스퓨리어스(spurious) 상관관계에 의존하며, 실질적인 인간 상호작용을 반영하지 못함.

- 연구 목표:

- 다차원적 정신 상태(욕구, 믿음, 의도)를 포괄하는 현실적 협상 시나리오를 기반으로 LLM의 ToM 능력을 평가하기 위해 새로운 벤치마크 데이터셋 "NegotiationToM"을 개발.

2. 연구 방법

- Belief-Desire-Intention(BDI) 모델:

- BDI 이론을 기반으로 각 에이전트의 정신 상태를 평가하도록 설계.

- 욕구(Desire), 믿음(Belief), 의도(Intention)를 추적하며 협상 과정을 모델링.

- 데이터 구축:

- 현실적인 협상 시나리오를 반영하기 위해 CaSiNo 데이터셋(캠핑 관련 협상 대화)을 수정하여 사용.

- 협상 대화의 각 라운드마다 에이전트의 욕구와 믿음, 의도를 수작업으로 주석.

- 평가 메트릭:

- 정확도: 욕구와 믿음에서 각각 고/중/저 우선 순위 항목 예측의 정확도를 측정.

- 일관성(Consistency): 대화 전반에서 에이전트의 정신 상태 변화를 정확히 추적하는 능력을 평가.

- "All" 스코어: 동일 정보 내에서 욕구, 믿음, 의도를 모두 정확히 예측한 경우를 평가.

3. 주요 실험 결과

- 모델 성능:

- 인간 대비 성능 차이가 큼: 욕구(27.85%), 믿음(32.96%), 의도(43.82%)에서 인간보다 낮은 정확도를 보임.

- GPT-4(CoT)와 Claude-v2.1(CoT)가 각기 다른 영역에서 최고의 성능을 보였으나, 인간 성능에는 크게 미치지 못함.

- 체인-오브-띵킹(CoT) 방법 적용 시 대부분의 모델이 약간의 성능 향상을 보임.

- 일관성 문제:

- GPT-4(CoT)가 비교적 높은 일관성을 보였으나, 인간의 75.44%에 비해 현저히 낮은 17.72%에 불과.

- 특히 의도(Intention) 평가에서는 모든 모델이 일관성 점수가 0에 가까운 결과를 나타냄.

- 질문 형식 효과:

- "Ranking"과 "Individual" 형식보다 "Combined" 형식이 더 높은 성능을 유도.

- 오류 분석:

- 욕구 및 믿음: 정보 부족 시 무작위 응답 경향.

- 의도: 부정확한 의도를 포함하거나 적절한 의도를 누락하는 경향.

4. 결론 및 미래 연구 방향

- 결론:

- LLM은 협상 시나리오에서 인간 수준의 ToM 능력을 보여주지 못함.

- 현실적이고 복잡한 대화에서의 정신 상태 추론은 여전히 도전 과제로 남아 있음.

- 미래 연구:

- 능동적 ToM 평가: 모델이 단순히 대화 기록을 분석하는 것이 아니라, 다른 에이전트와 상호작용하며 협상 전략을 학습 및 실행하도록 설계.

- 모델 강화: LLM이 ToM 추론 능력을 더욱 발전시키기 위한 학습 데이터와 방법론 탐색.

연구 기여

- 현실적인 협상 시나리오에서 LLM의 ToM 능력을 평가하는 최초의 자연 대화 기반 벤치마크 데이터셋 제공.

- 다차원적 정신 상태(욕구, 믿음, 의도)를 포괄하는 평가 프레임워크 설계.

- 인간과 LLM 간 ToM 능력 격차를 체계적으로 분석하여 향후 연구 방향 제시.

관련 연구

NegotiationToM 논문과 관련된 연구 정리

1. Theory of Mind(ToM)와 AI

관련 연구 영역

- ToM은 인간의 사회적 상호작용과 의사소통에서 핵심적인 역할을 하며, AI가 인간 수준의 추론 및 상호작용 능력을 달성하기 위해 필수적인 개념으로 간주됩니다.

- ToM 연구는 크게 두 가지로 나뉩니다:

- 이론적 접근: 기계가 ToM 능력을 갖추었는지 실험 및 벤치마크를 통해 평가.

- 실용적 접근: 현실적인 맥락에서 AI가 ToM 추론 능력을 활용하도록 설계.

주요 연구

- Sally-Anne False Belief Test:

- ToM 테스트의 전형적인 예시로, 모델이 타인의 믿음을 이해하고 예측할 수 있는지를 평가.

- 이 테스트는 모델이 표면적 데이터를 넘어 타인의 정신 상태를 추론하는 능력을 확인합니다.

- Faux Pas Test:

- 모델이 대화 속 실수나 의도치 않은 상황을 탐지하고 그 의미를 이해할 수 있는지 평가.

2. AI에서 협상 대화 연구

협상 대화 시스템 개발

- Lewis et al. (2017):

- 협상 대화의 자연스러운 언어 생성을 위해 RNN 기반 모델 사용.

- 대화의 연속성을 유지하면서 설득과 거래를 수행할 수 있는 모델 개발.

- He et al. (2018):

- 협상 대화에서 대화 행위를 기반으로 한 모듈형 생성 모델 제안.

- 숫자 기반 협상보다는 인간 중심의 설득과 논리를 포함한 대화 방식을 모방.

현실적 협상 대화 데이터

- CaSiNo 데이터셋:

- 캠핑을 주제로 한 협상 대화로, 현실적이고 다양한 언어적 특징을 포함.

- 소규모 대화부터 복잡한 설득 전략까지 다양한 시나리오를 포괄.

3. 대규모 언어 모델(LLM)과 ToM

LLM의 ToM 능력 평가

- BigToM Benchmark (Gandhi et al., 2023):

- LLM이 타인의 욕구 및 믿음을 얼마나 잘 추론하는지 평가하기 위해 설계된 벤치마크.

- 그러나 이 연구는 대부분 합성 데이터를 사용하였으며, 현실 세계와의 연결성이 부족하다는 한계를 가짐.

- FANTOM (Kim et al., 2023):

- 대화 중 LLM의 사회적 추론 능력을 테스트하기 위해 설계된 벤치마크.

- 협상, 설득, 감정 표현 등 다양한 요소를 포함하여 LLM의 ToM 한계를 드러냄.

모델 성능 및 한계

- GPT-4 및 Claude-v2.1:

- 인간과 유사한 수준의 ToM 추론 능력을 보이는 것으로 평가되었으나, 현실적 시나리오에서는 부족함.

- 특히 복잡한 대화 맥락에서 의도와 믿음을 정확히 추론하는 데 어려움을 겪음.

4. 협상 전략과 AI

전략 모델링

- 협상 전략을 추론하는 데 있어 ToM 능력은 핵심 요소로 간주됩니다.

- Yang et al. (2021):

- 협상에서 상대방의 성격 유형을 확률적으로 모델링하여 ToM 능력을 활용.

- 협상 전략을 결정하고 학습하는 데 ToM 추론이 유용하다는 점을 보여줌.

ToM이 협상에서 미치는 영향

- 협상은 인간 상호작용에서 복잡성과 다양성을 포함하며, 타인의 욕구와 믿음을 이해하는 것이 필수적입니다.

- LLM이 상대방의 정신 상태를 정확히 추론하면 더 합리적이고 공정한 협상 전략을 설계할 수 있음.

5. 향후 연구 방향

- 능동적 ToM 모델링:

- 모델이 수동적으로 데이터만 분석하는 것이 아니라, 다른 에이전트와 상호작용하고 적응적인 협상 전략을 생성하도록 설계.

- 강화 학습과 ToM:

- 강화 학습을 통해 협상 과정에서 ToM 기반 추론과 전략 개발을 더욱 효과적으로 학습.

- 멀티모달 접근:

- 언어, 표정, 제스처 등의 다양한 입력을 통합하여 모델의 ToM 능력을 현실적으로 확장.

- 공정성과 윤리적 고려:

- 협상 대화에서 편향과 불공정을 방지하기 위해 ToM 기반 알고리즘에 윤리적 기준을 도입.

결론

NegotiationToM은 AI의 ToM 능력을 현실적인 협상 시나리오에서 평가하는 데 있어 중요한 기여를 하였으며, 이를 바탕으로 LLM의 한계를 보완하고 인간 수준의 추론 능력을 개발하기 위한 새로운 연구 방향을 제시합니다.

방법론

1. 논문의 주요 목표

이 논문은 LLM(Large Language Models)의 Theory of Mind(ToM) 능력을 현실적인 맥락에서 평가하고자 합니다. 단순히 합성 데이터나 이론적 평가에 그치지 않고, 현실적인 협상 시나리오에서 타인의 욕구(Desire), 믿음(Belief), 의도(Intention)를 추론하고 추적하는 능력을 평가하는 것을 목표로 합니다.

- 문제 인식:

- 기존 ToM 평가 시스템은 LLM의 성능을 과대평가하거나 현실적인 사회적 맥락을 반영하지 못함.

- ToM은 현실 세계에서 대화와 의사결정을 이해하고 수행하는 데 필수적이므로, 현실적인 대화 데이터를 활용한 평가가 필요.

- 논문의 최종 목표:

- 다차원적인 정신 상태(Desire, Belief, Intention)에 대한 LLM의 추론 능력과 일관성을 평가.

- LLM과 인간 간 ToM 능력의 격차를 정량적으로 분석.

2. 연구 방법론

NegotiationToM의 방법론은 크게 데이터셋 설계, 평가 메트릭, 실험 구성으로 나뉩니다.

(1) 데이터셋 설계

- 데이터셋 출처:

- 현실적인 협상 데이터를 기반으로 한 CaSiNo 데이터셋을 수정하여 사용.

- 캠핑 여행 준비와 관련된 음식, 물, 장작에 대한 협상 시나리오 포함.

- 다양한 협상 전략(설득, 감정 표현, 선호 탐색 등)을 반영.

- 다차원적 정신 상태 주석:

- 각 대화 라운드에서 참여자의 욕구, 믿음, 의도를 추론할 수 있도록 수작업으로 주석 추가.

- 욕구(Desire): 각 에이전트의 물품 우선순위(높음/중간/낮음) 추정.

- 믿음(Belief): 에이전트가 상대방의 우선순위를 어떻게 추론하는지 평가.

- 의도(Intention): 각 발화가 협상 전략(예: 공감, 공정성 호소, 필요 설명) 중 무엇을 목표로 하는지 분석.

- 각 대화 라운드에서 참여자의 욕구, 믿음, 의도를 추론할 수 있도록 수작업으로 주석 추가.

(2) 평가 메트릭

LLM의 성능은 다음 메트릭으로 평가됩니다.

- 정확도(Accuracy):

- 욕구와 믿음에서 높은/중간/낮은 우선순위 예측의 정확도를 측정.

- 일관성(Consistency):

- 대화의 전체 맥락에서 에이전트의 정신 상태 변화를 정확히 추적하는지 평가.

- "All" 스코어:

- 동일한 정보 내에서 욕구, 믿음, 의도를 모두 정확히 예측했는지 측정.

- 의도 분류(F1 스코어):

- 각 발화의 협상 전략(의도)을 얼마나 정확히 분류하는지 평가.

(3) 실험 설계

- 모델 및 설정:

- GPT-4, ChatGPT, Claude-v2.1, Llama2 Chat 등 최신 LLM 평가.

- Zero-shot, Chain-of-Thought(CoT), Few-shot 설정으로 테스트.

- Zero-shot: 사전 학습된 지식만으로 작업 수행.

- Chain-of-Thought(CoT): 단계별 추론을 유도하여 복잡한 맥락에서 모델의 추론 능력 향상.

- Few-shot: 모델에게 학습 예제를 제공하여 추가적인 작업 이해 유도.

- 대화 질문 형식:

- 욕구 및 믿음 질문을 Ranking, Individual, Combined 형식으로 변형하여 모델의 응답 품질 비교.

- 인간 평가 비교:

- 인간의 ToM 성능을 기준으로 LLM의 성능과의 격차를 정량적으로 분석.

3. 논문이 달성하려는 바

NegotiationToM은 단순히 LLM의 ToM 능력을 평가하는 데 그치지 않고, 다음과 같은 새로운 연구 방향을 제시하고자 합니다.

- 현실적인 ToM 평가 프레임워크 제공:

- 기계 생성 데이터나 단순한 게임 설정을 넘어, 현실적인 인간 대화에서 LLM의 추론 능력을 검증.

- 데이터가 합성되지 않은 자연스러운 협상 대화를 포함하여 실제 응용 가능성 확대.

- LLM의 ToM 능력의 한계 식별:

- LLM이 인간보다 욕구와 믿음을 덜 정확히 예측하고, 대화 맥락에서의 의도 추론에 어려움을 겪는 문제를 분석.

- 특히 일관성 부족과 불완전한 맥락 이해를 중요한 한계로 식별.

- 능동적 ToM 연구로의 확장 가능성 제시:

- 현재는 수동적 평가(단순 관찰)를 수행했으나, LLM이 직접 상대와 협상하며 ToM 능력을 학습하고 적응할 수 있는 능동적 ToM 평가로의 확장 가능성을 제안.

4. 핵심 기여

- 벤치마크 개발: ToM 연구를 위한 최초의 자연스러운 협상 대화 기반 벤치마크 데이터셋 설계.

- 다차원 평가 프레임워크: 욕구, 믿음, 의도를 포괄하는 평가 체계 확립.

- LLM과 인간 성능 비교: ToM 능력에서 LLM과 인간 간 격차를 체계적으로 정량화.

NegotiationToM은 LLM의 현실적인 ToM 능력을 평가하고, 더 나아가 인간 수준의 사회적 추론을 달성하기 위한 기초 연구로 자리 잡을 가능성을 보여줍니다.

그럼 이 것은 협상 과정에서 사람이 어떤 생각을 하며 저런 말을 한 것인지 예측하는 모델을 만든것이네?

네, 정확합니다. NegotiationToM은 협상 과정에서 사람이 어떤 생각(욕구, 믿음, 의도)을 기반으로 말을 했는지 예측하는 모델을 평가하기 위한 벤치마크를 제시한 연구입니다. 이 연구는 다음과 같은 특징을 가지고 있습니다:

1. 사람이 협상 중에 어떤 생각을 하고 있는지 추론하는 것

- 욕구(Desire):

- 사람마다 협상 과정에서 특정 물품(예: 음식, 물, 장작)에 대한 선호 순위(높음/중간/낮음)가 있습니다.

- 예를 들어, "우리는 물이 많아서 필요하지 않아요."라는 말은 상대적으로 물에 대한 욕구가 낮음을 나타냅니다.

- 믿음(Belief):

- 협상자는 상대방의 욕구를 추론하려고 합니다.

- 예를 들어, "당신이 말한 걸 보니, 음식이 가장 필요해 보이네요."라는 말은 상대방의 욕구를 기반으로 형성된 믿음을 나타냅니다.

- 의도(Intention):

- 특정 발언은 협상 전략에 기반하여 이루어집니다. 이는 상대방과의 협력을 촉진하거나, 상대의 요구를 낮추기 위해 설계된 발언일 수 있습니다.

- 예를 들어, "저는 공정한 거래를 원해요."는 공정성을 호소하는 전략적 의도를 나타냅니다.

2. LLM이 사람의 정신 상태를 어떻게 추론하는지 평가

NegotiationToM은 사람이 협상 중에 어떤 정신 상태를 기반으로 말을 했는지를 LLM이 얼마나 정확히 추론할 수 있는지 평가합니다.

- 목표:

- LLM이 단순히 대화의 문맥적 의미를 이해하는 것을 넘어, 발언의 이면에 있는 정신 상태를 추론할 수 있는지를 측정.

- 예를 들어, "우리 가족이 캠핑에서 더 많은 음식을 필요로 해요."라는 발언 뒤에는 다음과 같은 정신 상태가 숨겨져 있습니다:

- 욕구(Desire): 음식 > 물 > 장작.

- 믿음(Belief): 상대방도 음식이 필요하지만 우선순위는 다를 수 있음.

- 의도(Intention): 상대방에게 자신의 필요를 설득하려는 의도.

3. 협상 대화의 복잡성과 다양성을 고려한 접근

NegotiationToM의 데이터셋과 평가 방법은 협상 과정에서 인간의 복잡한 심리를 반영하려고 설계되었습니다.

- 협상 대화 데이터:

- 단순히 "숫자 교환"만 하는 협상이 아니라, 감정 표현, 설득, 공정성 호소 등 인간적인 요소가 포함된 대화를 사용.

- 예를 들어, "우리 아이들이 많아서 더 많은 음식을 필요로 해요." 같은 발언은 감정적인 설득과 논리적 설명을 포함.

- 다차원적 정신 상태 추론:

- 욕구, 믿음, 의도를 독립적이면서도 상호작용적인 방식으로 추론.

- 예를 들어, 상대방이 "우리는 물이 충분합니다."라고 말하면, LLM은 이 발언에서:

- 욕구: 물에 대한 욕구가 낮음.

- 믿음: 이 정보로 상대방이 다른 물품(예: 음식, 장작)을 더 원할 가능성이 높다고 추론.

- 의도: 협상을 더 유리하게 이끌기 위해 자신에게 필요 없는 물품을 줄 가능성이 있음.

4. LLM이 실제로 무엇을 학습했는지 평가

- 기존 LLM은 단순히 패턴 인식으로 문장을 생성하거나 해석합니다. 하지만 NegotiationToM은 이를 넘어 상대방의 숨겨진 정신 상태를 예측할 수 있는지를 측정합니다.

- 예시: "장작을 더 원한다고 하셨죠? 저는 공정하게 나누고 싶어요."

- 여기서 LLM은 단순히 문맥적 의미만이 아니라, 발언의 숨겨진 의도(공정성을 기반으로 협상을 이끌고자 하는)를 추론해야 함.

- 예시: "장작을 더 원한다고 하셨죠? 저는 공정하게 나누고 싶어요."

결론

NegotiationToM은 단순히 협상 대화를 이해하는 것을 넘어, 인간이 어떤 정신 상태로 말을 하고 행동했는지를 예측하는 모델 평가를 목표로 합니다. 이 논문은:

- 인간과 LLM의 ToM 추론 능력을 비교.

- 협상과 같은 현실적인 상황에서 LLM의 한계를 밝히고 개선 가능성을 탐구.

- 향후 능동적이고 협력적인 AI 시스템 개발의 기반을 제공.

이를 통해 궁극적으로 AI가 인간과 더 자연스럽고 심층적으로 상호작용할 수 있는 방향으로 나아가고자 합니다.

결과

논문의 결과, 결론, 마무리

1. 주요 결과

(1) LLM의 성능

NegotiationToM 데이터셋에서 평가된 최신 LLM(GPT-4, Claude-v2.1 등)의 성능은 다음과 같은 결과를 보여줍니다:

- 인간 대비 성능 격차:

- 욕구(Desire) 예측: 인간 대비 27.85% 낮은 정확도.

- 믿음(Belief) 예측: 인간 대비 32.96% 낮은 정확도.

- 의도(Intention) 예측: Micro-F1에서 43.82%, Macro-F1에서 48.98% 낮음.

- 최고 성능 모델:

- GPT-4(CoT)는 욕구와 믿음 예측에서 가장 우수한 성능을 보임.

- Claude-v2.1(CoT)는 의도(Intention) 예측에서 최상의 결과를 보임.

- 일관성 부족:

- 대화 전반의 맥락에서 정신 상태 추적(Consistency) 성능이 낮음.

- 인간이 75.44% 일관성을 보인 반면, GPT-4(CoT)는 17.72%에 그침.

(2) ToM 질문 형식과 LLM 성능

- 질문 형식의 영향:

- "Combined Format"(질문을 한 번에 묶어 제시)이 다른 형식("Ranking" 또는 "Individual")보다 더 높은 정확도를 유도.

- 모델이 독립적인 질문보다 전체 맥락에서 추론하도록 설계된 형식이 효과적임.

(3) 오류 분석

- 욕구(Desire) 및 믿음(Belief) 오류:

- 정보가 충분하지 않을 때 모델은 무작위로 항목을 선택하는 경향.

- 예를 들어, "Not Given"으로 답해야 할 상황에서 임의로 물(Water)을 선택.

- 의도(Intention) 오류:

- 의도를 잘못 포함하거나, 올바른 의도를 누락하는 경우가 많음.

- 특히 LLaMA2 시리즈는 "의도가 없는 발화"에 대해 높은 오류율을 보임.

2. 논문의 결론

(1) LLM의 ToM 한계

NegotiationToM 데이터셋은 LLM이 협상 대화에서 인간 수준의 ToM 추론 능력을 가지지 못했음을 명확히 보여줍니다:

- 현실적 맥락에서의 부족함:

- 기존의 LLM은 단순한 게임 기반 테스트에서는 높은 성능을 보일 수 있지만, 현실적인 협상 대화에서는 실패하는 경향.

- 복잡한 맥락 추론의 어려움:

- 발화의 의도(Intention) 추론이나 맥락에서의 믿음(Belief) 변화 추적에서 일관성이 부족.

(2) LLM의 개선 가능성

논문은 LLM이 단순한 텍스트 이해를 넘어 인간 수준의 사회적 추론 능력으로 발전하기 위해 필요한 방향을 제시합니다:

- 능동적 학습 필요성:

- 모델이 단순히 대화를 분석하는 데 그치지 않고, 실제 협상에 참여하며 자신의 ToM 능력을 학습할 수 있어야 함.

- 다차원적 평가:

- 욕구, 믿음, 의도를 통합적으로 평가할 수 있는 새로운 벤치마크의 필요성.

3. 마무리

(1) 논문의 기여

- 새로운 벤치마크 제시:

- NegotiationToM은 현실적인 협상 시나리오를 기반으로 인간과 LLM 간 ToM 성능을 비교할 수 있는 첫 번째 데이터셋.

- LLM의 ToM 한계 명확화:

- 현실적인 사회적 상호작용에서 LLM의 취약점을 체계적으로 분석.

(2) 향후 연구 방향

- 능동적 ToM 평가:

- LLM이 실제 협상 상황에서 상대방과 상호작용하며 협상 전략을 학습하고 개선하도록 설계.

- 멀티모달 통합:

- 언어 외에 표정, 제스처, 목소리 톤 등 다양한 입력을 통합하여 모델의 ToM 능력 확장.

- 공정성 및 윤리 고려:

- 협상 중 발생할 수 있는 윤리적 문제(예: 편향된 협상 전략, 불공정한 합의)를 방지하기 위한 알고리즘 개선.

결론 요약

NegotiationToM은 인간과 LLM 간 ToM 성능의 격차를 명확히 보여주었으며, AI가 인간과의 복잡한 상호작용에서 효과적으로 대응하기 위해 어떤 방향으로 발전해야 하는지 실질적인 기준을 제시합니다. 이는 미래의 AI 연구에서 인간-기계 상호작용을 개선하기 위한 중요한 기초 자료로 활용될 수 있습니다.

수정 및 보완된 정리 내용

수정된 내용:

NegotiationToM에서는 LLM의 생성 능력보다 사람이 어떤 생각(욕구, 믿음, 의도)을 기반으로 말을 했는지 예측하는 데 초점을 맞추고 있습니다.

데이터 작업은 연구팀이 직접 수동으로 주석을 추가하여 고품질의 현실적 협상 데이터를 구성한 점이 인상적이며, 다양한 최신 모델(GPT-4, Claude-v2.1 등)을 Zero-shot, Chain-of-Thought(CoT), Few-shot 방식으로 시험하여 최적의 결과를 도출하려 했다는 점은 연구의 철저함을 보여줍니다.

다만, ToM(Theory of Mind)이 LLM 연구에서 실제로 얼마나 중요한 역할을 하는지에 대해서는 여전히 의문이 있습니다. 이 연구가 인간을 더 잘 이해하지 못하는 LLM의 한계를 증명하려는 시도처럼 보이기도 하며, 실제 응용 가능성 측면에서는 약간 모호하게 느껴질 수 있습니다.

보완된 이유 및 부족했던 점:

- ToM의 의의와 목표 명확화:

- ToM의 역할(인간의 정신 상태를 추론하고 상호작용을 이해하는 능력)이 LLM 연구의 중요한 부분임을 간략히 설명.

- 연구의 목표가 단순한 성능 비교가 아니라, 현실적 맥락에서의 LLM의 한계를 체계적으로 분석하는 데 있다는 점 강조.

- 연구의 기여 평가 추가:

- 연구가 ToM을 통해 인간-기계 상호작용을 개선하려는 장기적인 비전을 담고 있음을 언급.

- ToM의 실질적인 응용 가능성에 대한 의문을 제기하는 부분은 유지하되, 연구의 가능성을 부정하지 않도록 보완.

- 감정적 표현의 명료화:

- "ToM이 중요한지 모르겠다"는 의견은 "응용 가능성과 학문적 중요성 간의 괴리"로 재구성하여 객관성을 부여.

- 간결성과 체계화:

- 문장을 더 간결하고 체계적으로 재구성하여 논문 내용을 더 명확히 전달.

수정된 정리 내용은 논문의 핵심을 더 잘 반영하며, ToM의 학문적 맥락과 응용 가능성에 대한 균형 잡힌 비판을 제공합니다.