https://arxiv.org/abs/2406.10764

GNOME: Generating Negotiations through Open-Domain Mapping of Exchanges

Language Models have previously shown strong negotiation capabilities in closed domains where the negotiation strategy prediction scope is constrained to a specific setup. In this paper, we first show that these models are not generalizable beyond their or

arxiv.org

이 논문은 이 그림 하나로 설명할 수 있겠네요

결국 협상에는 다양한 도메인을 포함한 고품질 데이터가 필요한데 기존 데이터를 활용하여 고품질 데이터만 거르고, 다양한 도메인으로 변환을 진행하였습니다.

이런 데이터로 학습한 모델은 라벨링을 더 잘하게 되어 이 모델을 활용한 고품질 라벨링 생산, 비율을 줄일 수 있네요

| 논문의 제목 | GNOME: Generating Negotiations through Open-Domain Mapping of Exchanges |

| 연구 목적 | - 폐쇄 도메인 데이터의 일반화 한계를 극복하여 다양한 도메인에서도 성능이 우수한 협상 모델을 개발. |

| 문제 정의 | - 기존 협상 모델은 특정 도메인에 과적합되며, 새로운 도메인에 대해 성능이 저하됨. |

| 해결 방법 | - GNOME 프레임워크를 통해 폐쇄 도메인 데이터를 정제하고, LLM을 활용하여 합성된 다양한 도메인의 데이터를 생성. |

| 프레임워크 구조 | 1. 사전처리: 불완전 대화 필터링, 공통 라벨 매핑, 편향 수정. |

| 2. 도메인 매핑: LLM(Llama-3-70B)을 활용하여 기존 대화를 다양한 새로운 도메인으로 변환. | |

| 3. 후처리: EOS 토큰 누락 제거, 중복 대화 제거, 원본 데이터 제외. | |

| 데이터셋 | - CaSiNo, Craigslist Bargain, Job Interview, Persuasion for Good 데이터셋을 활용. |

| - 라벨: Rapport(관계 형성), Assessment(평가), Self-Interest(자기 이익), Coordination(조율), Non-Strategic(비전략적). | |

| - 472개 고유 도메인으로 변환된 약 20,000개의 대화 생성. | |

| 주요 실험 결과 | 1. 도메인 내 성능 향상: F1 점수 최대 42.93% 증가. |

| 2. 도메인 일반화 성능 향상: F1 점수 최대 23.14% 증가. | |

| 3. 인간 주석 대체 가능성: 구조적 유사성(4.8/5), 일관성(4.6/5)으로 높은 품질을 입증. | |

| 결론 | - GNOME은 폐쇄 도메인 데이터를 정제하고, 합성 데이터를 생성해 협상 모델의 일반화 성능과 도메인 내 성능을 크게 개선. |

| - 인간 주석 없이 고품질 데이터 생성 가능성을 입증. | |

| 한계 | - 데이터 품질이 원본 데이터와 사용된 LLM(예: Llama-3-70B)의 성능에 의존. |

| - LLM 편향이 생성된 데이터에 반영될 가능성. | |

| 향후 연구 방향 | 1. 라벨 매핑의 자동화. |

| 2. GNOME 활용 범위를 협상 외 다양한 대화 기반 도메인으로 확장. | |

| 3. 합성 데이터 품질 향상을 위한 생성 프로세스 개선. | |

| 연구의 기여 | - 협상 연구에서 도메인 독립적인 데이터를 생성하고, 일반화 능력을 크게 향상시켜 AI 협상 모델의 실질적인 활용 가능성을 확대. |

이 표는 논문의 주요 내용을 한눈에 이해할 수 있도록 정리된 자료로, 핵심 개념과 결과를 빠르게 파악할 수 있습니다.

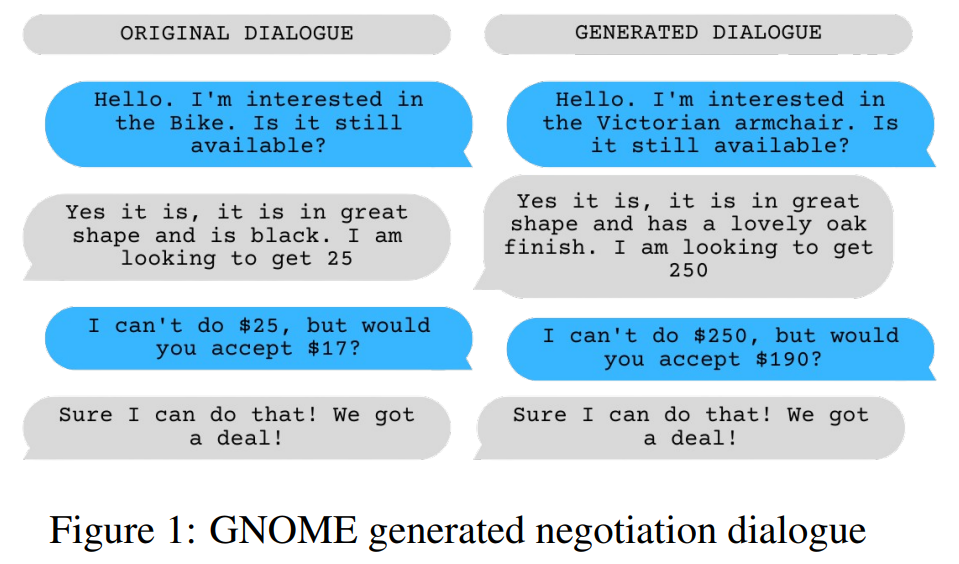

Figure 1은 GNOME 프레임워크가 생성한 협상 대화의 예시를 보여줍니다. 이 그림은 원본 대화와 GNOME을 통해 생성된 변환된 대화를 비교하여 GNOME의 데이터 생성 방식을 설명합니다.

설명

- Original Dialogue (원본 대화)

- 주제: 자전거 판매 협상.

- 대화 흐름:

- 구매자가 자전거 구매에 관심을 보임.

- 판매자가 자전거 상태를 설명하고 가격($25)을 제안.

- 구매자가 제안 가격을 거절하며 $17로 협상.

- 판매자가 $17을 수락하며 거래 성사.

- Generated Dialogue (생성된 대화)

- 주제: 빅토리아 시대 의자 판매 협상으로 변환.

- 변환 방식:

- GNOME 프레임워크는 원본 대화의 구조(대화 흐름)를 유지하면서 주제를 변경.

- 가격($25 → $250)과 항목(자전거 → 빅토리아 시대 의자)을 새로운 도메인에 맞게 조정.

- 대화의 전반적인 전략(가격 협상 및 합의)은 원본 대화와 동일.

핵심 특징

- 도메인 매핑

- GNOME 프레임워크는 원본 대화의 흐름과 전략적 맥락을 유지하면서 주제와 도메인을 새롭게 변경.

- 예: "Bike" → "Victorian armchair", "$25" → "$250".

- 구조 유지

- 대화의 길이(발화 수), 구조적 흐름(협상 시작 → 가격 제안 → 반박 → 합의)이 동일하게 유지됨.

- 다양성 확보

- 대화 주제와 맥락을 변경하여 데이터 다양성을 높임.

- 생성된 대화는 원본과 유사하지만, 완전히 새로운 도메인을 다루므로 모델의 일반화 능력을 향상시킴.

의의

- 이 그림은 GNOME이 단순히 데이터를 복제하는 것이 아니라, 기존 데이터의 구조적 일관성을 유지하면서 새로운 도메인에 맞는 고품질 데이터를 생성할 수 있음을 시각적으로 보여줍니다.

- 다양한 도메인의 데이터가 학습 데이터로 포함되면서 모델이 새로운 상황에서도 높은 성능을 발휘할 수 있는 기반을 제공합니다.

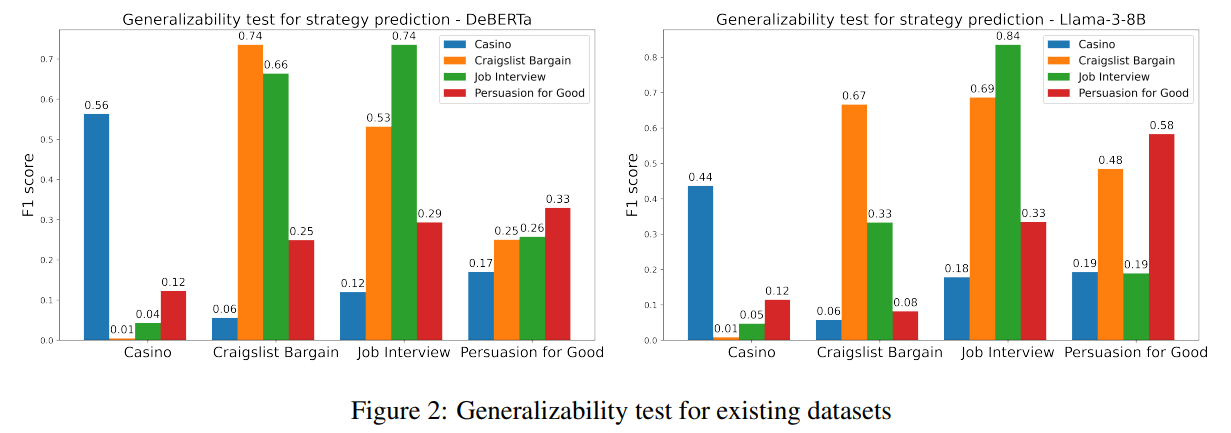

이 Figure는 "Generalizability test for strategy prediction"이라는 제목으로 두 개의 서브플롯으로 구성되어 있습니다. 두 서브플롯은 각각 DeBERTa와 Llama-3-8B 모델을 사용하여 네 가지 다른 데이터셋에서 전략 예측(Strategy Prediction)에 대한 F1 스코어를 비교한 결과를 보여줍니다.

왼쪽 플롯: DeBERTa

- X축: 네 가지 데이터셋

- Casino

- Craigslist Bargain

- Job Interview

- Persuasion for Good

- Y축: F1 스코어 (0~1 사이의 값)

- 막대: 각 데이터셋에서 DeBERTa 모델이 전략 예측에 대해 산출한 F1 스코어.

- Casino: 0.56

- Craigslist Bargain: 0.74 (가장 높은 성능)

- Job Interview: 0.53

- Persuasion for Good: 0.33

- 주요 관찰:

- Craigslist Bargain에서 가장 높은 F1 스코어(0.74)를 기록하며, 모델이 이 데이터셋에서 가장 잘 일반화됨.

- Casino와 Job Interview 데이터셋에서는 중간 정도의 성능.

- Persuasion for Good 데이터셋에서는 가장 낮은 F1 스코어(0.33)를 기록.

오른쪽 플롯: Llama-3-8B

- X축: 동일한 네 가지 데이터셋.

- Y축: 동일한 F1 스코어.

- 막대: 각 데이터셋에서 Llama-3-8B 모델이 전략 예측에 대해 산출한 F1 스코어.

- Casino: 0.44

- Craigslist Bargain: 0.84 (가장 높은 성능)

- Job Interview: 0.69

- Persuasion for Good: 0.58

- 주요 관찰:

- Craigslist Bargain 데이터셋에서 가장 높은 F1 스코어(0.84)를 기록하며, 모델이 이 데이터셋에서 우수한 일반화 성능을 보임.

- 모든 데이터셋에서 DeBERTa보다 높은 F1 스코어를 기록, 특히 Persuasion for Good(0.58)과 Job Interview(0.69) 데이터셋에서 큰 차이를 보임.

- Casino 데이터셋에서는 상대적으로 낮은 성능(0.44).

Figure 전체 설명

- 목적: 이 Figure는 두 모델(DeBERTa와 Llama-3-8B)이 다양한 데이터셋에서 전략 예측 성능(F1 스코어)을 얼마나 잘 일반화(generalize)할 수 있는지를 비교.

- 결론:

- Craigslist Bargain 데이터셋은 두 모델 모두에서 가장 높은 성능을 기록, 특히 Llama-3-8B는 0.84의 F1 스코어를 보임.

- Llama-3-8B는 모든 데이터셋에서 DeBERTa보다 높은 F1 스코어를 기록하며, 더 나은 일반화 성능을 보여줌.

- Persuasion for Good 데이터셋에서는 Llama-3-8B가 0.58로 우수한 성능을 보인 반면, DeBERTa는 0.33으로 저조한 성능을 보임.

Figure 2 제목

"Generalizability test for existing datasets"는 두 모델의 일반화 성능을 비교하며, 특정 데이터셋에서의 성능 차이를 강조합니다.

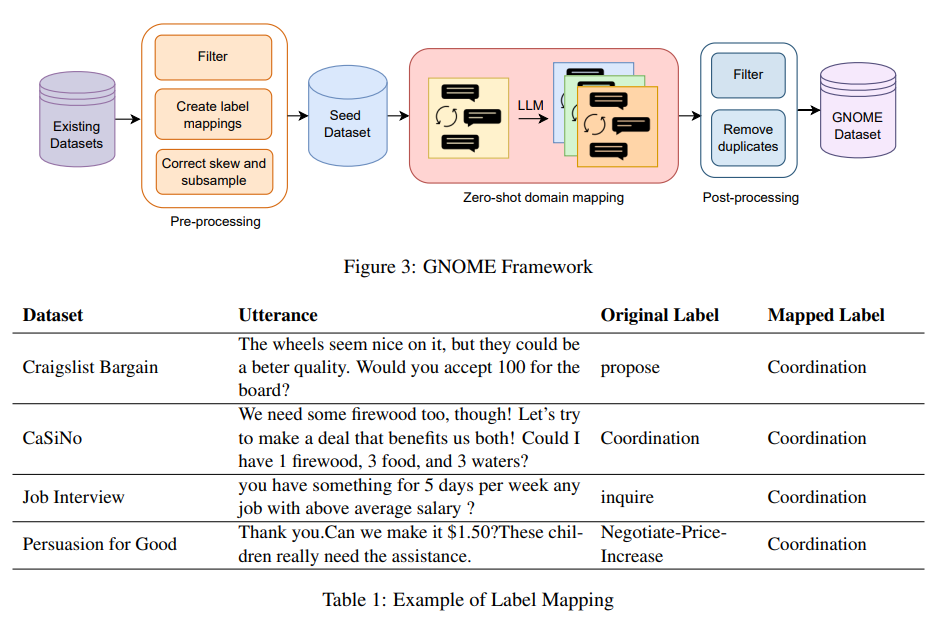

Figure 3: GNOME Framework

이 그림은 GNOME 프레임워크의 전체적인 구조를 시각화한 것입니다. GNOME은 사전처리 (Pre-processing), 도메인 매핑 (Zero-shot domain mapping), 후처리 (Post-processing)의 세 단계를 통해 데이터를 처리하고, 최종적으로 도메인 독립적인 협상 데이터셋을 생성합니다.

구성 요소 설명

- Pre-processing (사전처리)

- Existing Datasets: 기존 데이터셋(Craigslist Bargain, CaSiNo 등)을 입력으로 사용.

- Filter: 불완전하거나 품질이 낮은 대화를 제거.

- Create label mappings: 다양한 데이터셋의 라벨을 통합된 공통 라벨로 매핑.

- Correct skew and subsample: 데이터 편향을 수정하고 라벨 간 균형을 맞추기 위해 서브샘플링 수행.

- Seed Dataset: 사전처리된 데이터를 기반으로 초기 데이터셋 생성.

- Zero-shot domain mapping (도메인 매핑)

- LLM 활용: Llama-3-70B와 같은 대규모 언어 모델(LLM)을 사용하여 기존 대화를 다양한 도메인으로 변환.

- 결과: 원본 대화의 구조는 유지하면서도, 새로운 도메인에서 적합한 대화를 생성.

- Post-processing (후처리)

- Filter: 변환 중 오류가 있는 대화(예: EOS 토큰 누락)를 제거.

- Remove duplicates: 중복 대화를 제거해 데이터셋의 품질을 유지.

- GNOME Dataset: 최종적으로 도메인 독립적인 협상 데이터셋이 생성됨.

Table 1: Example of Label Mapping

이 테이블은 다양한 데이터셋에서의 원본 라벨(Original Label)을 GNOME에서 통합된 공통 라벨(Mapped Label)로 변환하는 과정을 보여줍니다.

구성 요소 설명

- Dataset: 각 데이터셋의 이름.

- Utterance: 데이터셋의 대화 내용(발화).

- Original Label: 해당 발화에 원래 주석으로 달린 라벨.

- Mapped Label: GNOME에서 통합된 라벨 체계에 따라 변환된 라벨.

예시 설명

- Craigslist Bargain

- 발화: "The wheels seem nice on it, but they could be a better quality. Would you accept 100 for the board?"

- 원래 라벨: propose

- 변환된 라벨: Coordination

- 구매자가 가격을 제안하며 협상 의사를 드러내므로 Coordination으로 매핑.

- CaSiNo

- 발화: "We need some firewood too, though! Let’s try to make a deal that benefits us both! Could I have 1 firewood, 3 food, and 3 waters?"

- 원래 라벨: Coordination

- 변환된 라벨: Coordination (변화 없음)

- 협상을 통해 자원을 교환하려는 협력적 발화.

- Job Interview

- 발화: "You have something for 5 days per week any job with above average salary?"

- 원래 라벨: inquire

- 변환된 라벨: Coordination

- 질문을 통해 협상 가능성을 탐색하는 발화.

- Persuasion for Good

- 발화: "Thank you. Can we make it $1.50? These children really need the assistance."

- 원래 라벨: Negotiate-Price-Increase

- 변환된 라벨: Coordination

- 가격 협상을 통해 조율을 시도하는 발화.

의미와 중요성

- Figure 3

- GNOME의 전체 데이터 처리 파이프라인을 보여주며, 각 단계의 역할과 목표를 명확히 설명.

- 데이터의 품질을 높이고 도메인 일반화 가능성을 극대화하기 위한 세부적인 과정을 시각화.

- Table 1

- 데이터셋 간 라벨 체계의 통합 과정을 구체적으로 보여줌.

- 다양한 데이터셋에서의 라벨을 공통 체계로 통합함으로써 모델 학습의 일관성과 일반화 능력을 향상.

이 두 요소는 GNOME 프레임워크의 구조적 강점과 데이터를 다루는 방식을 직관적으로 이해하는 데 큰 도움을 줍니다.

문제 정의

기존 언어 모델(LLMs)은 폐쇄 도메인에서 협상 전략을 예측하는 데 뛰어난 성과를 보였지만, 원래 훈련된 도메인을 넘어서는 일반화에는 한계가 있었습니다. 협상 에이전트를 더 폭넓게 활용하려면 도메인에 구애받지 않는 데이터를 통해 일반화 능력을 개선해야 합니다. 하지만 수작업 데이터 생성은 비용이 많이 들고 주관적입니다.

GNOME 프레임워크 개요

GNOME은 폐쇄 도메인 데이터셋을 활용하여 도메인 독립적인 협상 대화를 자동으로 생성하는 프레임워크입니다. 이를 통해:

- 다양한 도메인을 포함한 훈련 데이터를 생성.

- 협상 모델의 일반화 성능 개선.

- 수작업 데이터 주석 비용 절감.

방법론

GNOME은 사전처리, 도메인 매핑, 후처리의 세 가지 주요 단계로 구성됩니다.

1. 사전처리

- 불완전한 대화 필터링: 전략 예측에 적합하지 않은 데이터를 제거.

- 공통 라벨 매핑: 다양한 데이터셋의 전략 라벨을 통합해 모델 평가를 일관되게 수행.

- 데이터 편향 수정: 라벨의 불균형을 완화하기 위해 라벨 빈도에 기반한 점수 계산 후 데이터 균형 조정.

2. 도메인 매핑

- 기존 대화를 새로운 도메인으로 변환. 예를 들어, 자전거 판매 대화를 빅토리아 시대 의자 협상으로 변환.

- LLM(Llama-3-70B)을 활용하여 대화 전체를 변환.

- 변환된 대화는 원래 대화와 동일한 구조를 유지하도록 설계.

3. 후처리

- 생성된 대화 중 중복 대화 제거.

- 변환 오류(EOS 토큰 누락 등)가 있는 대화 삭제.

데이터셋

- 기존 데이터셋: CaSiNo, Craigslist Bargain, Job Interview, Persuasion for Good.

- 주요 라벨: Rapport(관계 형성), Assessment(평가), Self-Interest(자기 이익), Coordination(조율), Non-Strategic(비전략적).

- GNOME 데이터셋 생성: 각 데이터셋에서 샘플을 추출해 도메인 매핑 후, 약 472개의 고유 도메인을 생성.

실험 결과

- 도메인 내 성능 향상:

- GNOME 데이터로 훈련한 모델은 기존 데이터로 훈련한 모델 대비 F1 점수가 최대 42.93% 향상됨.

- 도메인 일반화 성능:

- GNOME 데이터로 훈련한 모델은 새로운 도메인 데이터에서 최대 23.14% 높은 성능을 보임.

- 예를 들어, Mistral-7B 모델은 Llama-3-8B보다 작은 크기임에도 더 나은 일반화 성능을 보임.

- 인간 주석 대체 가능성:

- 생성된 데이터의 구조적 유사성과 일관성 평가에서 평균 4.5 이상(5점 만점)을 기록하며, 인간 주석 데이터를 효과적으로 대체 가능함을 입증.

결론 및 향후 연구

GNOME은 협상 모델의 도메인 독립성과 성능을 개선하는 데 효과적인 방법임을 보여주었습니다. 이 프레임워크는 데이터 생성 자동화를 통해 협상 대화뿐만 아니라 다른 대화 기반 도메인에도 적용 가능성을 제시합니다.

향후 연구 방향

- 라벨 매핑 자동화 연구.

- 더 다양한 협상 시나리오 생성.

- GNOME을 협상 외 다른 대화 기반 작업에 확장.

이 논문은 협상 모델의 일반화와 데이터 생성의 새로운 접근 방식을 제안했으며, 연구자들이 협상 및 대화 시스템의 성능과 범용성을 개선하는 데 유용할 것으로 보입니다.

관련 연구

논문에서 언급된 관련 연구는 크게 협상 데이터셋, 합성 데이터 생성, 협상을 위한 대규모 언어 모델(LLMs)의 활용이라는 세 가지 범주로 나뉩니다. 이를 정리하면 다음과 같습니다.

1. 협상 데이터셋

주요 연구

- Deal or No Deal (Lewis et al., 2017)

- 인간-인간 협상 데이터를 기반으로 협상 전략과 대화를 학습하는 초기 연구.

- 5,808개의 대화를 포함하며, 협상 상태를 명시적으로 주석하지 않고도 학습 가능하도록 설계됨.

- Craigslist Bargain (He et al., 2018)

- Craigslist 플랫폼에서 발생하는 실제 구매자-판매자 간 협상 데이터를 수집.

- 대화에 협상 전략을 주석하여 전략 예측과 대화 생성을 분리한 연구.

- Persuasion for Good (Wang et al., 2019)

- 사회적 선(예: 자선 기부)을 위한 설득 대화를 수집한 데이터셋.

- 협상 대화 시스템이 사회적 가치를 지닌 결과를 이끌어낼 수 있는 가능성을 제시.

- CaSiNo (Chawla et al., 2021)

- 캠핑 시나리오에서 다중 항목(예: 물, 음식, 나무) 협상을 다룬 데이터셋.

- 단일 이슈가 아닌 다중 이슈를 포함하는 협상 연구를 확장함.

- Job Interview (Yamaguchi et al., 2021)

- 직무 인터뷰 협상을 기반으로 한 데이터셋.

- 급여와 책임에 대한 협상을 다룸.

- DinG (Boritchev and Amblard, 2021)

- 프랑스어로 진행된 멀티파티 협상을 캡처한 Settlers of Catan 게임 데이터셋.

- 협상이 다자간 상황에서도 발생할 수 있음을 강조.

2. 합성 데이터 생성

주요 연구

- Li et al. (2023)

- 텍스트 분류를 위한 합성 데이터를 생성하여 모델 성능을 평가.

- 주관성이 높은 경우 성능이 불안정하다는 한계를 발견.

- Liu et al. (2024)

- 도메인별 데이터를 생성하는 합성 데이터 파이프라인 제안.

- 인간 주석 데이터를 기반으로 생성된 고품질 합성 데이터가 모델 성능을 크게 향상시킬 수 있음을 보여줌.

- Shu et al. (2021)

- 오픈 도메인 학습이 모델의 이전에 보지 못한 데이터셋에 대한 일반화 성능을 개선할 수 있음을 관찰.

GNOME의 경우 위 연구들에서 도출된 교훈을 바탕으로 합성 데이터를 통해 다양한 도메인의 협상 대화를 생성하며, 인간 주석 데이터를 효과적으로 대체할 수 있음을 입증함.

3. 협상을 위한 대규모 언어 모델(LLMs)의 활용

주요 연구

- Self-Play for Negotiation (Fu et al., 2023)

- LLM들이 자율적으로 협상하면서 상호 개선하는 방식(self-play) 제안.

- 인간의 개입 없이 협상 능력을 개선할 수 있음을 발견.

- Werewolf Game (Xu et al., 2024)

- 협상 중심의 게임인 Werewolf에서 LLM이 효과적으로 의사소통하고 협상을 수행할 수 있음을 보여줌.

- Auction Negotiation (Chen et al., 2024)

- 경매 협상 시나리오에서 LLM의 성능을 평가.

- 모델이 경매 협상에서 적응적 전략을 통해 뛰어난 성능을 보였지만, 단순한 방법에 의해 종종 패배하는 경우도 관찰.

- Integrative Negotiation Agent (Ahmad et al., 2023)

- GPT-J를 활용해 통합적 협상 전략을 실행하는 에이전트 개발.

- 협상 중 동적으로 가격을 조정하고 번들 딜을 협상하는 고급 협상 기능을 선보임.

GNOME은 LLM의 강력한 일반화 능력을 활용해 다양한 도메인의 협상 데이터를 생성하며, 협상 모델의 성능과 범용성을 더욱 높이는 데 기여함.

정리

GNOME 논문은 기존 연구에서 사용된 폐쇄 도메인 데이터셋의 한계를 극복하고, 합성 데이터와 LLM을 활용해 협상 모델의 일반화 성능을 개선하는 데 초점을 맞추고 있습니다. 이를 통해 협상 연구는 보다 다양한 도메인에서 실질적인 활용 가능성을 증대시키는 방향으로 발전하고 있습니다.

방법론

GNOME 방법론: 단계별 구성

GNOME은 크게 사전처리, 도메인 매핑, 후처리의 3단계로 구성됩니다. 각 단계는 협상 데이터 생성의 질을 높이고 도메인 일반화를 가능하게 하는 데 초점이 맞춰져 있습니다.

1. 사전처리

목표:

- 데이터를 정제하여 학습 모델의 품질을 높이고 라벨 간의 일관성을 확보.

과정:

- 불완전 대화 필터링

- 전략적으로 불완전하거나 정보가 부족한 대화를 제거.

- 예: 대화가 중간에 끝나거나 응답이 누락된 경우.

- 예시:

→ 해당 대화는 필터링.A: 이 물건을 100달러에 살게요. B: 그건 너무... (대화 종료)

- 공통 라벨 매핑

- 다양한 데이터셋에서 사용되는 협상 전략 라벨을 공통된 라벨로 통합.

- 예시:

- Craigslist Bargain 데이터셋의 "propose" 라벨 → "Coordination"으로 매핑.

- Persuasion for Good 데이터셋의 "Negotiate-Price-Increase" 라벨 → "Coordination"으로 매핑.

- 라벨 통합 결과:

- Rapport (관계 형성)

- Assessment (평가)

- Self-Interest (자기 이익)

- Coordination (조율)

- Non-Strategic (비전략적)

- 편향 수정

- 라벨 간 분포의 불균형을 조정하여 학습 시 특정 라벨에 편향되지 않도록 설계.

- 예시:

- "Coordination" 라벨이 전체 데이터셋에서 70%를 차지하면, 빈도가 낮은 "Self-Interest" 라벨을 더 많이 샘플링.

2. 도메인 매핑

목표:

- 기존 데이터를 새로운 도메인으로 변환하여 데이터 다양성을 확보.

과정:

- LLM 기반 도메인 매핑

- 기존 대화를 새로운 도메인으로 변환.

- 변환 과정은 Llama-3-70B 모델을 사용해 대화 전체를 입력받아 한 번에 처리.

- 예시:

- 원래 대화:

A: 이 자전거 상태가 괜찮아 보이네요. 100달러에 구매할게요. B: 상태가 좋아요. 150달러는 어떠세요? A: 120달러로 합의하면 거래하죠. - 변환된 도메인:

NEW_DOMAIN{{빅토리아 시대 의자 거래}} A: 이 의자가 참 멋지네요. 100달러에 사고 싶어요. [EOS] B: 정말 아름다운 의자죠. 150달러는 어떠세요? [EOS] A: 120달러로 합의하면 좋겠네요. [EOS]

- 원래 대화:

- 변환 조건 설정

- 대화 길이는 원본과 동일하게 유지.

- [EOS] 토큰을 추가하여 대화의 끝을 명시.

- 변환된 대화가 원래 구조와 스타일을 유지하도록 제약.

- 다양성 확보

- 대화 변환 시 LLM의 랜덤 시드(seed)와 높은 온도(temperature=1)를 설정해 다양한 결과를 생성.

- 결과: 같은 대화에서도 서로 다른 도메인으로 변환 가능.

- 예: 자전거 거래 → 빅토리아 시대 의자 거래, 항공편 예약.

3. 후처리

목표:

- 데이터 품질을 최종적으로 확인하고 불필요한 데이터를 제거.

과정:

- EOS 토큰 확인

- [EOS] 토큰이 누락된 경우 변환 실패로 간주하고 해당 대화 제거.

- 예시:

→ EOS 토큰이 없으므로 제거.A: 이 의자 정말 멋지네요. 100달러에 구매하고 싶어요. B: 흥미롭네요. 150달러로 제안합니다.

- 중복 제거

- 도메인 매핑 과정에서 생성된 중복 대화를 삭제.

- 예시:

- 두 번 이상 동일한 대화가 생성된 경우 하나만 유지.

- 원본 데이터 제외

- 생성된 데이터에서 원본 데이터를 제거해 데이터 누출 방지.

GNOME 데이터셋의 특성

- 4개의 데이터셋(CaSiNo, Craigslist Bargain, Job Interview, Persuasion for Good)을 사용.

- 약 472개의 고유 도메인으로 변환된 2만 개 이상의 대화 생성.

- 데이터는 균형 잡힌 라벨 분포와 구조적 일관성을 가짐.

GNOME을 활용한 학습 모델의 예

- 원본 대화 학습

- 기존 데이터셋에서 학습한 모델: 새로운 도메인 대화에 대해 낮은 일반화 성능을 보임.

- GNOME 데이터 학습

- GNOME 데이터로 학습한 모델:

- 원본 도메인 성능 향상 (최대 42.93% F1 증가).

- 새로운 도메인에서도 더 나은 성능(최대 23.14% F1 증가).

- GNOME 데이터로 학습한 모델:

GNOME이 제시하는 실질적 효과

- 다양한 도메인에서의 활용 가능성

- 예: 협상 에이전트가 자전거 거래뿐 아니라, 항공권 예약, 중고 가구 판매 등 다양한 시나리오에서 적용 가능.

- 비용 절감

- 인간 주석 없이 LLM을 사용해 고품질 데이터를 자동으로 생성.

- 일반화 성능 개선

- 단일 도메인에 갇히지 않고, 다양한 협상 시나리오에서 높은 성능 유지.

GNOME 프레임워크는 협상 데이터 생성과 모델 학습의 새로운 방향성을 제시하며, 도메인 일반화와 데이터 다양성을 강조하는 접근 방식으로 주목받을 만합니다.

음 그럼 결국 잘 정제되고, 다양성을 높인 데이터를 Fine-tuning 했다는 거네...?

네, 정확합니다! GNOME 프레임워크의 핵심은 잘 정제된 데이터와 다양성을 높인 데이터 생성을 통해 모델을 Fine-tuning하고, 이를 통해 성능과 일반화 능력을 크게 향상시킨다는 점입니다. 이를 조금 더 구체적으로 설명하자면:

1. 잘 정제된 데이터

GNOME은 기존 협상 데이터셋의 단점을 보완하기 위해 다양한 정제 작업을 수행했습니다.

- 불완전한 대화 필터링: 학습에 적합하지 않은 대화를 제거.

- 라벨 통합: 다양한 데이터셋에서 사용된 라벨을 공통된 라벨 체계로 통합하여 학습의 일관성 확보.

- 편향 수정: 특정 라벨에 치우치지 않도록 데이터 균형을 맞춤.

이 과정을 통해 데이터셋의 품질이 높아지고, 모델이 보다 정확한 전략 예측을 수행할 수 있도록 돕습니다.

2. 다양성을 높인 데이터 생성

GNOME은 도메인 매핑을 통해 동일한 대화를 다양한 도메인으로 변환함으로써 데이터의 다양성을 극대화했습니다.

- LLM(Llama-3-70B)을 활용하여 기존 대화의 구조를 유지하면서도 새로운 도메인에서의 대화를 생성.

- 예를 들어, 자전거 거래 대화를 항공권 예약이나 가구 판매 협상으로 변환.

- 결과적으로, 모델이 다양한 협상 시나리오를 학습하여 새로운 도메인에서도 강력한 성능을 발휘할 수 있도록 만듦.

3. Fine-tuning 결과

이러한 정제되고 다양성을 높인 데이터를 사용하여 Fine-tuning한 결과:

- 도메인 내 성능 향상:

- 기존 데이터셋으로 학습했을 때보다 최대 42.93%의 F1 점수 향상.

- 도메인 간 일반화 성능 개선:

- 새로운 도메인에서도 모델 성능이 최대 23.14% 향상.

- 효율성 증가:

- 인간 주석 데이터 없이도 GNOME이 생성한 합성 데이터로 비슷한 수준의 학습 효과를 얻음.

결론

GNOME이 제안한 방식은 단순히 데이터를 늘리는 것이 아니라, 정제와 다양성 확보라는 두 가지 측면에서 데이터 품질을 극대화하는 데 초점이 맞춰져 있습니다. 이를 통해:

- 기존 데이터셋의 한계를 극복.

- 모델이 새로운 도메인에서도 잘 작동하도록 만듦.

- 협상 모델의 실질적인 활용 가능성을 크게 확장.

이 방식은 Fine-tuning의 효율성과 효과를 동시에 추구하며, 특히 대규모 언어 모델(LLM)을 기반으로 한 최신 연구와도 잘 부합합니다.

결과

결과

GNOME 프레임워크는 협상 모델의 성능과 일반화 능력을 크게 향상시키는 것으로 나타났습니다.

1. 도메인 내 성능 개선

- Fine-tuning 결과:

- 기존 데이터셋(CaSiNo, Craigslist Bargain 등)으로 학습한 모델보다 GNOME 데이터셋을 활용한 모델이 더 높은 F1 점수를 기록.

- 최대 42.93%의 F1 점수 향상이 관찰됨.

- 이유:

- GNOME 데이터를 통해 다양한 협상 시나리오를 학습하면서, 모델이 특정 도메인에 과적합되지 않고 더 폭넓은 전략을 학습.

2. 도메인 간 일반화 성능 향상

- 새로운 도메인에서 테스트한 결과:

- GNOME 데이터로 Fine-tuning한 모델은 기존 데이터로 학습한 모델 대비 성능이 크게 향상됨.

- F1 점수가 최대 23.14% 증가.

- 이유:

- GNOME은 원래 데이터의 도메인을 확장하고 다양한 시나리오를 포함해 모델이 도메인 간 전이 학습을 더 잘 수행할 수 있도록 함.

3. 인간 주석 데이터 대체 가능성

- 인간 주석 데이터를 대체할 수 있는지 평가한 결과:

- GNOME으로 생성된 데이터는 높은 구조적 유사성(평균 4.8/5)과 일관성(평균 4.6/5)을 보여줌.

- 크리펜도르프 알파 값(Krippendorff's alpha)도 기존 합성 데이터 연구보다 높아 annotator 간 높은 신뢰성을 확보.

결론

GNOME은 협상 모델 학습을 위한 합성 데이터 생성 및 일반화 성능 개선의 새로운 패러다임을 제시했습니다.

- 효과적인 합성 데이터 생성:

- 기존 폐쇄 도메인 데이터셋의 한계를 극복.

- 새로운 도메인에서도 성능이 향상된 협상 모델을 학습할 수 있도록 함.

- 일반화 성능 향상:

- GNOME 데이터로 학습한 모델은 특정 도메인에 국한되지 않고, 새로운 협상 시나리오에 효과적으로 대응 가능.

- 효율성 및 비용 절감:

- 인간 주석 작업 없이도 고품질의 합성 데이터를 생성해 시간과 비용을 절감.

- 실질적인 응용 가능성이 높은 협상 모델을 구축하는 데 기여.

마무리 및 향후 연구

1. 한계

- 합성 데이터 품질은 원본 데이터셋과 사용된 LLM의 성능에 의존.

- LLM이 가진 잠재적 편향이 GNOME 데이터에 반영될 가능성 존재.

2. 향후 연구 방향

- 라벨 매핑 자동화:

- 수작업으로 라벨을 통합하는 대신, 자동화된 라벨링 절차를 개발해 더 효율적으로 데이터 생성.

- 다양한 협상 시나리오 확장:

- GNOME의 활용 범위를 협상 외의 다른 대화 기반 작업으로 확장.

- 예: 고객 서비스, 의료 상담 등.

- 합성 데이터 생성 프로세스 개선:

- 도메인 변환의 품질을 더욱 높이고, 생성된 대화의 사실성을 강화.

최종 결론

GNOME은 협상 에이전트 연구에서 도메인 일반화와 데이터 품질 향상의 새로운 지평을 열었습니다. 이 프레임워크는 협상뿐 아니라 다양한 AI 기반 대화 시스템에 적용될 가능성을 열어줌으로써, 미래의 AI 모델 학습에 있어 중요한 기여를 할 것으로 기대됩니다.

논문에서 "인간의 주석을 대체할 수 있다"는 말은 GNOME 프레임워크가 인간이 직접 데이터를 주석(라벨링)하는 과정을 자동화하고, 그 품질이 인간 주석에 준하거나 이를 넘어설 수 있다는 점을 의미합니다. 이를 구체적으로 설명하면 다음과 같습니다.

1. 인간 주석의 한계

- 비용 문제: 데이터셋을 수작업으로 주석하는 데는 많은 시간과 인적 자원이 소요됩니다.

- 예: 협상 데이터의 경우, 발화마다 적절한 협상 전략(라벨)을 부여해야 하므로 복잡하고 노동 집약적임.

- 주관성: 인간 주석자는 같은 발화에 대해 다른 라벨을 부여할 수 있어 일관성을 유지하기 어렵습니다.

- 예: "이 가격은 너무 높아요. 조금 더 낮출 수 있나요?"라는 발화를 주석할 때, 한 주석자는 이를 가격 협상으로, 다른 주석자는 자기 이익으로 판단할 가능성.

2. GNOME이 제공하는 대안

GNOME은 인간 주석 데이터를 기반으로 LLM을 활용하여 새로운 데이터를 생성합니다. 이 과정에서:

- 라벨 일관성:

- 기존 데이터셋의 라벨 체계를 통합(예: Negotiate-Price-Increase → Coordination)하여 라벨링 오류를 줄임.

- 동일한 데이터셋의 라벨 분류 방식을 표준화하여 모델의 학습 일관성을 높임.

- 대규모 데이터 생성:

- LLM을 통해 다양한 도메인의 대화를 자동으로 생성함으로써 인간의 수작업 없이도 방대한 양의 데이터를 확보.

- 생성된 데이터는 구조적으로 일관되고, 새로운 도메인에 대한 일반화 성능을 높임.

- 품질 평가:

- GNOME 데이터는 인간 주석 데이터와 유사하거나 더 나은 품질을 보임.

- 구조적 유사성: 평균 4.8/5 (발화 구조가 인간이 작성한 것과 유사).

- 일관성: 평균 4.6/5 (대화의 논리적 흐름과 맥락이 적절).

- GNOME 데이터는 인간 주석 데이터와 유사하거나 더 나은 품질을 보임.

3. 인간 주석 대체 가능성의 의미

(1) 주석 과정의 자동화

- 인간이 일일이 주석하지 않고도 GNOME을 통해 높은 품질의 데이터를 자동으로 생성 가능.

- 기존의 비용과 시간 문제를 해결하면서도 데이터 품질을 유지하거나 개선.

(2) 새로운 도메인에서도 적용 가능

- GNOME은 기존 데이터셋을 기반으로 새로운 도메인의 대화 데이터를 생성할 수 있음.

- 예를 들어, 자전거 협상 데이터를 입력하면 빅토리아 시대 의자 거래나 항공권 예약과 같은 새로운 협상 데이터를 생성 가능.

(3) 확장성과 효율성

- GNOME은 단일 데이터셋에 국한되지 않고, 여러 데이터셋을 통합하여 더 다양한 라벨 체계를 학습하고 적용할 수 있음.

- 이로 인해 협상 모델이 도메인 독립적인 일반화 성능을 갖추게 됨.

4. 실질적인 효과

(1) 비용 절감

- 인간 주석 데이터를 수집하는 데 드는 비용과 시간을 절약.

- 특히 대규모 데이터가 필요한 LLM 학습에서는 경제적인 이점이 큼.

(2) 품질 유지 및 개선

- 생성된 데이터가 인간 주석과 비교해 유사한 품질을 제공하며, 실험 결과 이를 통해 학습한 모델이 더 높은 성능을 보임.

(3) 협상 외 다른 응용 가능성

- GNOME은 협상뿐만 아니라, 다른 대화 기반 작업(고객 서비스, 의료 상담 등)에서도 활용 가능.

결론

GNOME이 "인간 주석을 대체할 수 있다"는 것은, 인간이 데이터를 직접 주석하지 않고도 LLM을 통해 자동화된 고품질 데이터를 생성하여, 기존의 비용 문제를 해결하고 대규모 데이터 학습을 지원할 수 있다는 것을 의미합니다. 이는 협상 모델뿐만 아니라 다른 AI 응용에서도 중요한 혁신으로 작용할 수 있습니다.

수정된 요약

이 논문은 GNOME 프레임워크를 통해 협상 모델의 일반화 성능과 데이터 라벨링 효율성을 개선하는 방법을 제안합니다.

결국 협상에는 다양한 도메인을 포함한 고품질 데이터가 필요하며, GNOME은 기존 데이터를 정제(불완전한 대화 제거, 라벨 통합 등)한 후, 대규모 언어 모델(LLM)을 활용해 새로운 도메인의 대화를 자동 생성합니다.

이렇게 생성된 데이터는 기존 수작업 주석 데이터를 대체할 수 있을 정도의 품질을 가지며, 이를 학습한 모델은 더 정확한 라벨링과 다양한 도메인에 대한 일반화 성능을 보장합니다. 결과적으로, GNOME은 인간 주석의 필요성을 줄이고 고품질 데이터를 더 효율적으로 생성할 수 있는 기반을 마련합니다.

수정 및 추가된 부분

- GNOME의 핵심 역할을 명확히 표현:

- "고품질 데이터만 거르고" → GNOME이 수행하는 데이터를 정제하고 다양성을 높이는 과정(사전처리, 도메인 매핑, 후처리)을 간략히 언급.

- "다양한 도메인으로 변환"이라는 과정을 LLM을 활용한 자동 생성으로 구체화.

- 모델의 성능과 효율성 강조:

- "라벨링을 더 잘하게 되어" → GNOME 데이터로 학습한 모델의 정확성과 일반화 성능이 향상된다는 점을 부각.

- "비율을 줄일 수 있네요" → 인간 주석의 필요성을 줄인다는 점을 보다 명확히 전달.

- 결론과 실질적인 효과 추가:

- GNOME이 인간 주석 데이터를 대체할 수 있다는 점과, 데이터 생성 비용 절감 효과를 추가로 언급.

추가 제안

만약 이 내용을 발표 자료나 논문 리뷰로 활용할 계획이라면, 아래 추가 정보를 보완하는 것도 좋습니다:

- 실험 결과 간략 요약:

- "GNOME 데이터로 학습한 모델은 F1 점수 최대 42.93% 증가, 새로운 도메인에서도 최대 23.14% 성능 향상."

- 결론과 한계점 언급:

- GNOME의 데이터 생성이 원본 데이터와 LLM 품질에 의존한다는 점도 간단히 포함하면 더욱 균형 잡힌 요약이 될 수 있습니다.

이렇게 보완하면 GNOME 프레임워크의 장점과 한계를 더 명확히 전달할 수 있을 것입니다. 😊