https://arxiv.org/abs/2308.11432

A Survey on Large Language Model based Autonomous Agents

Autonomous agents have long been a prominent research focus in both academic and industry communities. Previous research in this field often focuses on training agents with limited knowledge within isolated environments, which diverges significantly from h

arxiv.org

교수님의 추천으로 읽어 본 논문입니다.

방법론적인 논문이라기 보다는 AI Agent가 어떻게 발전해 왔는지, 얼마나 관심이 있는지, 어디에 사용되고 있는지 등 조사해서 정리해 놓은 논문입니다.

제가 AI Agent 세미나 준비를 진행해야 하는데 그 자료에 초석이 될 것 같습니다.

AI Agent의 종류에서 시작해서 다양한 분야가 있었네요

| 논문 제목 | A Survey on Large Language Model based Autonomous Agents |

| 목적 | LLM(대규모 언어 모델)을 기반으로 한 자율 에이전트의 현재 상태, 구조, 응용, 평가 방법, 및 미래 연구 방향을 종합적으로 정리. |

| 연구 동기 | - 전통적 자율 에이전트와 달리, LLM은 광범위한 지식을 활용해 인간 수준의 지능과 적응성을 보여줌. - LLM 기반 자율 에이전트 연구는 빠르게 증가하고 있으며, 이를 포괄적으로 정리. |

| 주요 내용 | 1. 구성 요소 - 프로파일링 모듈: 역할 정의 및 목표 설정. - 메모리 모듈: 단기/장기 기억을 통해 학습. - 계획 모듈: 단계적 추론 및 피드백 활용. - 액션 모듈: 작업 수행 및 환경 탐색. 2. 응용 분야 - 사회 과학: 심리학, 정치학, 법학. - 자연 과학: 실험 설계, 데이터 분석. - 공학: 코드 생성, 로봇 제어, 산업 자동화. 3. 평가 방식 - 주관적 평가: 인간 평가자에 의한 품질 평가. - 객관적 평가: 작업 성공률, 효율성, 데이터셋 기반 평가. |

| 주요 결과 | - LLM 기반 에이전트의 연구 논문은 2021년부터 2023년까지 급격히 증가. - 초기에는 WebGPT와 같은 단순한 시스템에서 시작해, AutoGPT, Voyager 등으로 확장. - LLM 에이전트는 다양한 분야에서 복잡한 문제 해결 능력을 입증. |

| 기술적 한계 | 1. 환각(Hallucination): 잘못된 정보 생성 문제. 2. 프롬프트 안정성: 복잡한 작업에서 성능 저하. 3. 효율성 문제: 높은 계산 비용과 느린 처리 속도. |

| 미래 과제 | - 인간 정렬(Human Alignment): 인간의 가치와 목표에 맞는 에이전트 설계. - 지속적 학습: 새로운 데이터와 환경에 적응. - 협업 능력 강화: 인간 및 다른 에이전트와 효과적인 상호작용. |

| 결론 | - LLM 기반 자율 에이전트는 차세대 지능형 시스템으로 발전 가능성 보유. - 복잡한 문제를 해결하고 인간과 협업하는 다목적 도구로서 다양한 응용 가능성. |

| 연구 의의 | - 연구자들에게 자율 에이전트의 트렌드와 방향성을 제공. - LLM 에이전트 개발 및 평가를 위한 참고 자료로 활용 가능. |

이 Figure 1은 LLM 기반 자율 에이전트(Large Language Model-based Autonomous Agents) 분야의 성장 추세를 시각적으로 나타낸 그래프입니다. 아래는 이 그림의 각 요소와 데이터를 기반으로 체계적으로 정리한 설명입니다:

1. X축 (Time: Year-Month)

- 시간에 따라 LLM 기반 자율 에이전트 관련 논문이 출판된 누적 수를 보여줍니다.

- 범위는 2021년 1월부터 2023년 8월까지입니다.

2. Y축 (Number of Papers: Cumulative)

- 출판된 논문의 누적 수를 나타냅니다.

- 시간이 지남에 따라 LLM 기반 에이전트 연구가 급속도로 성장했음을 보여줍니다.

3. 색상별 에이전트 유형

- 각 색상은 다양한 유형의 에이전트를 나타냅니다:

- General Agent (일반 에이전트): 검은색 점선 테두리

- Tool Agent (도구 활용 에이전트): 주황색

- Simulation Agent (시뮬레이션 에이전트): 파란색

- Embodied Agent (구체화된 에이전트): 보라색

- Game Agent (게임 에이전트): 연두색

- Web Agent (웹 탐색 에이전트): 청록색

- Assistant Agent (보조 에이전트): 노란색

4. 주요 연구 발전 시점 및 시스템

- 2021년: 초기 단계

- WebGPT (2021-12): 초기 LLM 에이전트로서, 웹 탐색과 정보 제공을 목적으로 함.

- 2022년: 다양한 에이전트 유형 등장

- DEPS (2022-2), WebShop (2022-7) 등은 도구 사용과 시뮬레이션에 초점을 맞춤.

- 2023년: 급격한 연구 확산

- AutoGPT (2023-3), AgentGPT (2023-4): LLM 기반의 일반 에이전트 시스템으로 발전.

- Generative Agent (2023-4): 생성 기반 에이전트 등장.

- Voyager (2023-5): 시뮬레이션 환경에서의 학습과 탐색에 특화.

- MIND2WEB (2023-6): 웹 탐색 에이전트로서 정교한 검색 및 작업 수행.

- ToolBench (2023-7), Tool LLaMA (2023-7): 도구 중심 에이전트로의 연구 확장.

- AgentSims (2023-8): 복잡한 시뮬레이션 환경을 위한 에이전트.

5. 연구 추세와 주요 발견

- 연구 논문 수는 2021년부터 2023년까지 기하급수적으로 증가했습니다.

- 2023년 이후: 다양한 유형의 에이전트(예: Tool Agent, Web Agent) 연구가 활발해졌으며, 도구 사용 및 복합 작업 환경에서의 성과가 강조됨.

- 에이전트 유형은 초기의 단순한 웹 탐색 및 작업에서 생성, 도구 사용, 시뮬레이션, 게임 환경으로 점차 세분화되고 있습니다.

6. 결론

이 그림은 LLM 기반 자율 에이전트 연구가 빠르게 확장되고 있으며, 특히 2023년에 폭발적으로 증가했음을 보여줍니다. 연구 초점은 초기의 일반 에이전트에서 특정 작업(도구 사용, 웹 탐색, 시뮬레이션 등)에 특화된 에이전트로 이동하고 있습니다.

이 데이터는 연구자가 특정 에이전트 유형(예: 도구 활용 또는 웹 탐색)을 선택하거나, 새로운 융합 연구를 진행할 때 유용한 정보를 제공합니다. 추가적인 심화 분석이 필요하면 요청해주세요!

이 Figure 2는 LLM 기반 자율 에이전트(Large Language Model-based Autonomous Agents)의 아키텍처 설계를 위한 통합 프레임워크를 나타냅니다. 에이전트의 주요 구성 요소인 프로파일(Profile), 메모리(Memory), 계획(Planning), 행동(Action)의 상호작용을 체계적으로 설명합니다.

1. Profile (프로파일)

- 역할: 에이전트의 정체성(identity)과 행동의 방향성을 결정하는 초기 설정.

- 구성 요소:

- 프로파일 내용(Profile Contents):

- Demographic Information: 인구통계학적 정보 (예: 연령, 지역).

- Personality Information: 성격 및 성향.

- Social Information: 사회적 배경 정보.

- 생성 전략(Generation Strategy):

- Handcrafting Method: 수작업으로 설정된 프로파일.

- LLM-Generation Method: LLM을 활용하여 자동 생성.

- Dataset Alignment Method: 데이터셋에 기반한 정렬된 프로파일 생성.

- 프로파일 내용(Profile Contents):

2. Memory (메모리)

- 역할: 에이전트가 학습한 내용, 과거 경험, 그리고 현재 상태를 저장하고 활용.

- 구성 요소:

- 메모리 구조(Memory Structure):

- Unified Memory: 단일 메모리 구조.

- Hybrid Memory: 다양한 형식의 메모리를 결합한 구조.

- 메모리 형식(Memory Formats):

- Languages: 자연어 기반 메모리.

- Databases: 데이터베이스 형태.

- Embeddings: 임베딩 벡터.

- Lists: 리스트 구조.

- 메모리 작업(Memory Operation):

- Memory Reading: 저장된 메모리를 읽기.

- Memory Writing: 새로운 정보를 메모리에 쓰기.

- Memory Reflection: 메모리를 되돌아보고 분석.

- 메모리 구조(Memory Structure):

3. Planning (계획)

- 역할: 목표를 달성하기 위한 행동 전략 및 단계를 결정.

- 구성 요소:

- 피드백 없는 계획(Planning w/o Feedback):

- Single-path Reasoning: 단일 경로로 문제를 해결.

- Multi-path Reasoning: 여러 경로를 탐색하며 최적의 결과 도출.

- External Planner: 외부 계획 도구와 협력.

- 피드백을 활용한 계획(Planning w/ Feedback):

- Environment Feedback: 환경에서 제공된 피드백 활용.

- Human Feedback: 인간으로부터 받은 피드백 반영.

- Model Feedback: 모델 자체의 피드백 활용.

- 피드백 없는 계획(Planning w/o Feedback):

4. Action (행동)

- 역할: 계획된 행동을 실행하고, 환경과 상호작용.

- 구성 요소:

- 행동 목표(Action Target):

- Task Completion: 작업 완료.

- Exploration: 환경 탐색.

- Communication: 의사소통.

- 행동 생성(Action Production):

- Memory Recollection: 메모리를 기반으로 행동 생성.

- Plan Following: 계획된 단계를 따른 행동.

- 행동 범위(Action Space):

- Tools: 도구 활용.

- Self-Knowledge: 자기 인식.

- 행동 영향(Action Impact):

- Environments: 환경에 미치는 영향.

- New Actions: 새로운 행동 유발.

- Internal States: 에이전트 내부 상태에 미치는 영향.

- 행동 목표(Action Target):

결론

이 Figure는 LLM 기반 자율 에이전트의 핵심 모듈과 작동 방식을 체계적으로 보여줍니다. 각 모듈이 독립적으로 작동할 뿐만 아니라, 상호작용을 통해 에이전트가 목표를 달성하고 환경과 적응적으로 상호작용할 수 있도록 설계되었습니다.

세미나 자료로 활용 시, 이 프레임워크를 기반으로 에이전트 설계의 전체 구조를 설명하거나, 각 모듈의 세부 구현을 사례와 함께 제시할 수 있을 것입니다. 추가적인 설명이나 자료가 필요하다면 말씀해주세요!

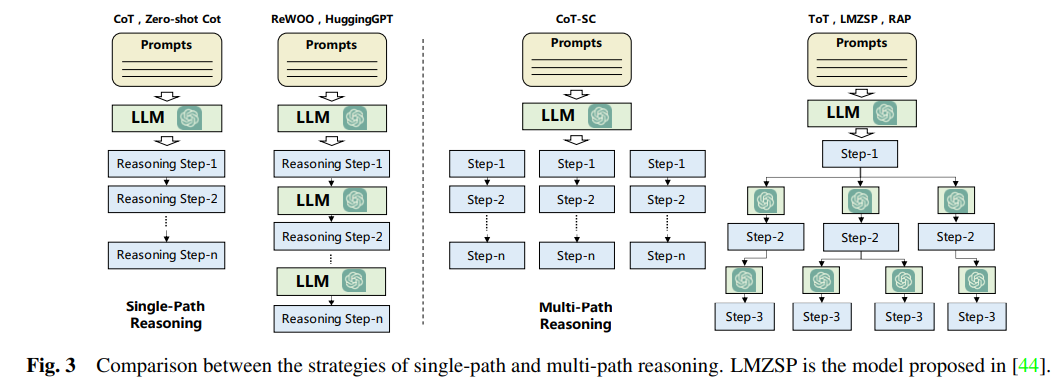

이 Figure 3는 Single-Path Reasoning(단일 경로 추론)과 Multi-Path Reasoning(다중 경로 추론)의 전략을 비교하고, LLM 기반 자율 에이전트가 문제를 해결하는 방식의 차이를 설명합니다. 이는 에이전트가 작업 계획(Planning) 단계에서 사용하는 추론 구조를 시각적으로 보여줍니다.

1. Single-Path Reasoning (단일 경로 추론)

- 특징:

- 단일 경로로 작업을 수행하며, 각 단계에서 이전 결과를 기반으로 다음 단계로 진행.

- CoT (Chain-of-Thought) 및 Zero-shot CoT와 같은 프롬프트 기반 방법이 사용됨.

- 모든 추론 과정은 선형적으로 이루어지며, 중간 단계에서 분기가 발생하지 않음.

- 구조:

- 프롬프트가 LLM에 입력되며, 각 추론 단계(Reasoning Step-1, Step-2, ..., Step-n)가 순차적으로 진행됨.

- 장점:

- 구현이 간단하며, 모델이 일관된 단일 경로로 작업을 수행.

- 적은 계산 비용으로 빠르게 추론 가능.

- 단점:

- 복잡한 문제에서 다양한 가능성을 탐색하지 못함.

- 초기 단계에서 발생한 오류가 이후 단계까지 영향을 미칠 가능성이 높음.

2. Multi-Path Reasoning (다중 경로 추론)

- 특징:

- 여러 경로를 동시에 탐색하며, 각 경로에서 병렬적으로 작업 수행.

- CoT-SC, ToT(Tree-of-Thought), LMZSP, RAP와 같은 모델에서 활용.

- 각 단계에서 생성된 결과를 기반으로 다음 단계에서 다양한 경로를 생성.

- 구조:

- 프롬프트가 LLM에 입력되며, 초기 단계에서 여러 가지 가능성을 탐색.

- 각 경로는 독립적으로 진행되며, 최종적으로 가장 적합한 결과를 선택하거나 통합.

- 장점:

- 복잡한 문제를 해결할 때 다양한 가능성을 탐구하여 최적의 결과를 도출.

- 초기 오류가 다른 경로에서 보완될 가능성이 있음.

- 단점:

- 계산 비용이 높고, 병렬 처리를 위해 추가적인 리소스가 필요.

- 모든 경로를 관리하고 평가하는 데 시간이 소요.

Figure의 세부 구성

- Single-Path Reasoning:

- CoT, Zero-shot CoT: 단일 경로를 따라 순차적으로 추론.

- 예를 들어, 한 번에 한 단계씩 진행하면서 이전 단계의 결과를 반영.

- Multi-Path Reasoning:

- CoT-SC: 여러 경로를 생성한 후 병렬적으로 각 경로를 탐색.

- ToT, LMZSP, RAP:

- 트리 구조를 활용하여 각 단계에서 분기가 발생.

- 다음 단계로 갈수록 다양한 가능성을 고려하여 문제를 해결.

결론

이 Figure는 단일 경로 추론과 다중 경로 추론의 차이를 명확히 보여줍니다.

- Single-Path Reasoning은 효율적이지만 단순한 문제에 적합하며,

- Multi-Path Reasoning은 복잡한 문제를 해결하기 위한 강력한 도구로 사용됩니다.

따라서, LLM 기반 자율 에이전트는 작업의 성격에 따라 두 가지 전략을 선택적으로 사용하며, 특히 복잡한 문제에서 Multi-Path Reasoning이 더 효과적일 수 있습니다. 세미나 준비 시, 이 두 접근법의 특징과 응용 사례를 설명하면 유용할 것입니다. 추가로 궁금한 점이 있으면 말씀해주세요!

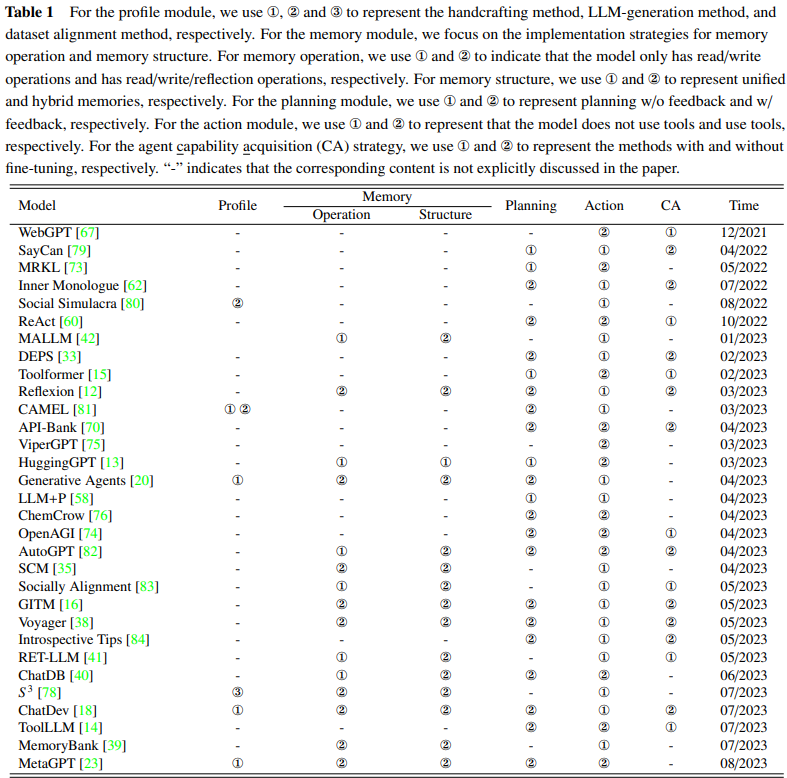

이 Table 1은 다양한 LLM 기반 자율 에이전트 모델의 주요 특징과 구현 방식을 정리한 표입니다. 각각의 모델이 프로파일(Profile), 메모리(Memory), 계획(Planning), 행동(Action), 능력 획득 전략(CA, Capability Acquisition)에서 어떤 구현 전략을 사용했는지 나타내며, 출시 시점(Time)도 함께 제공합니다.

표 구성 요소 설명

- Profile (프로파일):

- ①: Handcrafting Method (수작업 프로파일 생성).

- ②: LLM-Generation Method (LLM 기반 자동 생성).

- ③: Dataset Alignment Method (데이터셋 정렬 기반 프로파일 생성).

- Memory (메모리):

- Operation (작업):

- ①: 읽기/쓰기(Read/Write)만 수행.

- ②: 읽기/쓰기와 Reflection(반성)을 함께 수행.

- Structure (구조):

- ①: Unified Memory (단일 메모리 구조).

- ②: Hybrid Memory (혼합 메모리 구조).

- Operation (작업):

- Planning (계획):

- ①: Planning w/o Feedback (피드백 없는 계획).

- ②: Planning w/ Feedback (피드백 기반 계획).

- Action (행동):

- ①: 도구를 사용하지 않음.

- ②: 도구를 사용하여 작업 수행.

- CA (능력 획득 전략):

- ①: 파인튜닝 없이 활용.

- ②: 파인튜닝을 통해 능력 획득.

- Time (출시 시점):

- 각 모델이 발표된 연월.

주요 모델 분석

- WebGPT (12/2021):

- 초기 모델로, 피드백 없는 계획(①)을 사용하며, 행동에서 도구를 활용하지 않음(①).

- 메모리 구조 및 프로파일 생성과 관련된 세부 내용은 논문에서 다루지 않음.

- HuggingGPT (03/2023):

- LLM-Generation 기반 프로파일(②) 사용.

- Reflection을 포함한 메모리 작업(②), 하이브리드 메모리 구조(②) 활용.

- 피드백 기반 계획(②)과 도구 사용(②)을 지원.

- 파인튜닝 없이 활용(①).

- AutoGPT (04/2023):

- 피드백 없는 계획(①)과 도구 사용(②)을 활용.

- 메모리와 프로파일 생성 방법은 명시되어 있지 않음.

- Generative Agents (04/2023):

- LLM-Generation 기반 프로파일(②) 사용.

- Reflection을 포함한 메모리 작업(②)과 하이브리드 메모리 구조(②) 활용.

- 피드백 기반 계획(②)과 도구 사용(②)을 지원.

- 파인튜닝 없이 사용(①).

- Toolformer (02/2023):

- 메모리 작업(①) 및 구조(①)는 기본적인 수준으로 구현.

- 도구를 활용(②)하며, 계획 및 프로파일 생성에 대한 내용은 논문에서 다루지 않음.

- ToolBench (07/2023):

- 도구 사용(②)을 중점으로 설계된 모델.

- 메모리와 프로파일 생성, 계획과 관련된 세부 사항은 논문에서 다루지 않음.

결론

이 표는 다양한 LLM 기반 자율 에이전트 모델이 각 모듈을 어떻게 구현했는지를 비교합니다. 이를 통해 다음과 같은 점을 이해할 수 있습니다:

- 모델마다 특화된 구현 전략이 있으며, 목적과 응용 사례에 따라 구성 요소의 설계가 달라짐.

- 피드백 기반 계획(Planning w/ Feedback)과 도구 활용(Action w/ Tools)이 최근 모델에서 점점 더 중요한 역할을 차지하고 있음.

- Generative Agents, HuggingGPT 등 최신 모델은 메모리 작업 및 계획, 도구 사용에서 더 높은 수준의 복잡성을 갖춤.

이 표는 세미나나 연구 발표 자료로 활용하기에 적합하며, 각 모델의 발전 방향 및 기술적 차별성을 비교하는 데 유용합니다. 추가 설명이나 특정 모델에 대한 심화 정보가 필요하다면 말씀해주세요!

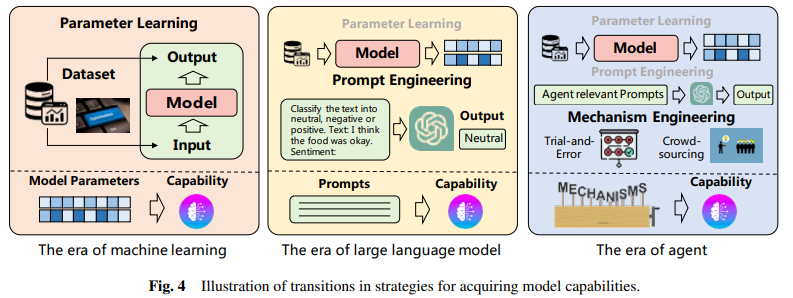

이 Figure 4는 모델 역량(Capability)을 확보하기 위한 전략의 변화를 나타냅니다. 이는 기계 학습(Machine Learning)의 초기 시대부터 대규모 언어 모델(Large Language Model, LLM)의 시대를 거쳐 에이전트의 시대(The Era of Agent)로의 발전을 설명합니다.

1. The Era of Machine Learning (기계 학습의 시대)

특징:

- Parameter Learning(파라미터 학습):

- 데이터셋(Dataset)을 기반으로 모델의 파라미터를 학습하여 특정 작업을 수행.

- 입력(Input)을 모델에 전달하면, 훈련된 파라미터를 통해 출력(Output)이 생성.

- 구성 요소:

- 데이터셋: 모델 학습을 위해 수집된 정형화된 데이터.

- 모델: 특정 작업(예: 이미지 분류, 회귀 분석)을 해결하기 위해 설계된 ML 알고리즘.

- 출력: 학습된 파라미터를 사용하여 생성된 결과.

- 역량 확보:

- 모델 파라미터에 의존하여 기능을 구현.

- 작업이 고도로 정형화되어 있고, 모델은 한 가지 작업에 최적화됨.

- 한계:

- 다목적(Multi-purpose) 문제를 해결하는 데 적합하지 않음.

- 새로운 작업을 위해서는 모델을 다시 학습해야 함.

2. The Era of Large Language Models (대규모 언어 모델의 시대)

특징:

- Prompt Engineering(프롬프트 엔지니어링):

- 대규모 언어 모델(LLM)의 파라미터를 재학습하지 않고도, 적절한 프롬프트를 설계하여 작업을 수행.

- 예: 텍스트를 입력하고, 모델이 이를 긍정, 부정, 중립으로 분류하는 작업 수행.

- 구성 요소:

- 데이터셋: 대규모로 학습된 LLM.

- 프롬프트: 특정 작업을 유도하기 위해 사용자가 입력하는 명령.

- 출력: 프롬프트를 기반으로 모델이 생성하는 결과.

- 역량 확보:

- 파라미터 학습을 보완하거나 대체하는 프롬프트 설계.

- 새로운 작업을 위해 모델 재학습 없이도 활용 가능.

- 장점:

- 모델이 다목적 작업을 처리할 수 있는 유연성을 제공.

- 한계:

- 프롬프트의 설계 품질에 따라 성능이 크게 좌우됨.

- 복잡한 작업에서는 여전히 제한적.

3. The Era of Agent (에이전트의 시대)

특징:

- Mechanism Engineering(메커니즘 엔지니어링):

- 프롬프트 엔지니어링을 확장하여, 에이전트가 자체적으로 학습 및 문제 해결 메커니즘을 설계.

- 에이전트는 프롬프트를 조합하거나 외부 환경과 상호작용하며 작업 수행.

- 예: Trial-and-Error(시도와 오류), Crowd-sourcing(군중 소싱)을 활용한 학습 및 실행.

- 구성 요소:

- 데이터셋 및 모델: LLM을 포함한 복합 시스템.

- 프롬프트 및 메커니즘: 문제를 해결하기 위해 다양한 작업 간 협력과 상호작용 수행.

- 출력: 에이전트가 실행 결과를 통해 작업을 완성.

- 역량 확보:

- 단순히 모델의 파라미터 또는 프롬프트에 의존하지 않고, 메커니즘 설계와 환경 상호작용을 통해 다목적 문제 해결.

- 자율성과 적응성이 높아짐.

- 장점:

- 복잡한 작업에서도 높은 유연성과 적응력을 제공.

- 다양한 도구와 환경을 통합적으로 활용 가능.

- 한계:

- 메커니즘 설계와 실행의 복잡성이 높아 추가적인 계산 비용이 발생.

결론

이 Figure는 AI 기술이 파라미터 학습 → 프롬프트 엔지니어링 → 메커니즘 엔지니어링으로 진화했음을 보여줍니다.

- 초기에는 단일 작업에 최적화된 기계 학습 모델이 중심이었지만,

- LLM 시대에는 프롬프트를 활용하여 다목적 작업이 가능해졌으며,

- 현재 에이전트의 시대에서는 자율적 메커니즘 설계와 환경 적응을 통해 복잡한 문제를 해결할 수 있게 되었습니다.

세미나 자료로 활용 시, 이 내용을 기반으로 AI 발전의 역사와 미래 방향을 설명하면 효과적일 것입니다. 추가로 궁금한 점이 있다면 알려주세요!

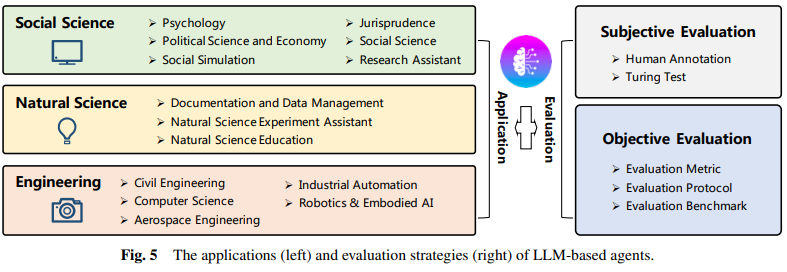

이 Figure 5는 LLM 기반 에이전트의 응용 분야(Application)와 평가 전략(Evaluation Strategies)를 두 축으로 나누어 정리한 그림입니다. 그림은 LLM 기반 에이전트가 어떤 분야에 활용되는지와 어떻게 평가되는지를 체계적으로 보여줍니다.

1. Applications (응용 분야)

LLM 기반 에이전트는 다양한 분야에서 활용되며, 그림은 이를 사회 과학(Social Science), 자연 과학(Natural Science), 공학(Engineering)의 세 영역으로 구분합니다.

(1) Social Science (사회 과학)

- 주요 활용:

- Psychology: 심리학 연구 및 분석 보조.

- Political Science and Economy: 정치학과 경제학에서 데이터 분석 및 정책 평가.

- Social Simulation: 사회적 행동이나 시스템을 시뮬레이션.

- Jurisprudence: 법률 해석과 의사결정 지원.

- Research Assistant: 연구자의 업무 보조.

- 특징:

- 인간 행동, 정책 및 법률 연구에 대한 지원을 통해 사회적 가치 창출.

(2) Natural Science (자연 과학)

- 주요 활용:

- Documentation and Data Management: 과학 데이터 문서화 및 관리.

- Natural Science Experiment Assistant: 실험 설계 및 데이터 분석.

- Natural Science Education: 자연 과학 교육 보조.

- 특징:

- 실험 보조 및 학술 교육에서 LLM의 분석 능력과 데이터 처리 능력을 활용.

(3) Engineering (공학)

- 주요 활용:

- Civil Engineering: 토목 공학 프로젝트 지원.

- Computer Science: 소프트웨어 개발 및 코드 생성.

- Aerospace Engineering: 항공우주 공학 설계 보조.

- Industrial Automation: 산업 자동화 시스템 설계 및 최적화.

- Robotics & Embodied AI: 로봇 공학 및 물리적 AI 시스템 제어.

- 특징:

- 공학 설계, 자동화, 로봇 제어와 같은 기술적 과제 해결에 도움.

2. Evaluation Strategies (평가 전략)

LLM 기반 에이전트의 성능은 주관적 평가(Subjective Evaluation)와 객관적 평가(Objective Evaluation)로 나뉩니다.

(1) Subjective Evaluation (주관적 평가)

- 평가 방법:

- Human Annotation: 인간 평가자가 직접 에이전트의 결과물이나 성능을 평가.

- Turing Test: 에이전트의 성능이 인간과 얼마나 유사한지 평가.

- 특징:

- 사용자의 경험과 품질 만족도를 측정하는 데 중점.

(2) Objective Evaluation (객관적 평가)

- 평가 지표:

- Evaluation Metric: 작업 성공률, 정확도, 효율성과 같은 정량적 지표.

- Evaluation Protocol: 표준화된 평가 절차와 실험 조건.

- Evaluation Benchmark: 특정 작업에 대한 기준 데이터셋.

- 특징:

- 에이전트의 성능을 정량적으로 평가하여 신뢰성과 비교 가능성을 확보.

3. 그림의 의의

- 이 그림은 LLM 기반 에이전트의 다양한 활용 가능성과 평가 방식을 통합적으로 보여줍니다.

- 응용 분야에서는 인간 활동의 보조 및 자동화를 강조하며, 평가 전략은 성능을 정량적/정성적으로 분석하는 다양한 방법을 제시합니다.

- 특히, 사회 과학에서 인간 행동과 관련된 주관적 평가가, 공학 분야에서는 객관적 평가가 상대적으로 더 중요하게 다뤄질 가능성이 있습니다.

결론

이 Figure는 LLM 기반 에이전트의 역할과 성능 평가 방식을 이해하는 데 중요한 틀을 제공합니다.

- 응용 분야에서는 각 분야별 에이전트의 활용 방식과 목표를 보여주고,

- 평가 전략에서는 에이전트의 성능을 종합적으로 측정하기 위한 체계를 제안합니다.

이 정보를 기반으로 세미나나 발표에서 LLM 기반 에이전트의 현황과 발전 방향을 설명하는 데 활용하면 효과적일 것입니다. 추가로 궁금한 점이 있으면 말씀해주세요!

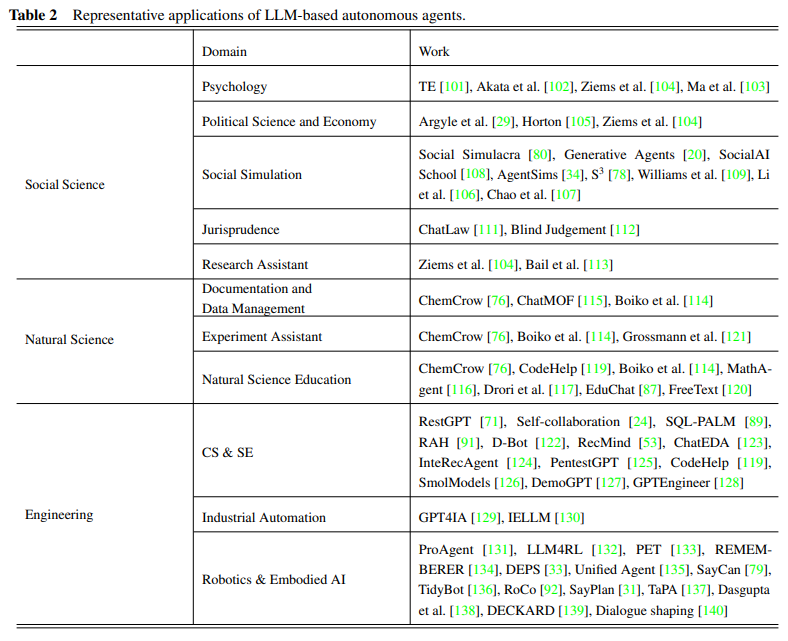

이 Table 2는 LLM 기반 자율 에이전트(Large Language Model-based Autonomous Agents)의 대표적인 응용 사례를 분야별로 정리한 표입니다. 도메인(Domain)별로 에이전트가 어떤 작업(Work)에 사용되었는지를 보여줍니다. 이는 LLM 기반 에이전트가 실제로 어디에 활용되고 있으며, 각 도메인에서 어떤 역할을 수행하는지 이해하는 데 도움을 줍니다.

1. Social Science (사회 과학)

LLM 기반 에이전트가 사회 과학 분야에서 수행하는 대표적인 작업들입니다.

(1) Psychology (심리학)

- 작업(Work): 심리 상태 분석 및 심리학 연구 보조.

- 대표 사례:

- TE: 감정과 관련된 분석.

- Akata et al., Ziems et al.: 심리학 연구 및 데이터 분석 지원.

- Ma et al.: 심리적 상태를 모델링.

(2) Political Science and Economy (정치학 및 경제학)

- 작업(Work): 정책 평가, 정치적 담론 분석, 경제 모델링.

- 대표 사례:

- Argyle et al., Horton, Ziems et al.: 정치 및 경제 행동 시뮬레이션.

(3) Social Simulation (사회 시뮬레이션)

- 작업(Work): 사회적 행동 시뮬레이션 및 연구.

- 대표 사례:

- Social Simulacra, Generative Agents, AgentSims: 사회적 행동 시뮬레이션.

- SocialAI School: 교육 환경에서 사회적 상호작용 연구.

- Williams et al., Li et al., Chao et al.: 복잡한 사회적 시스템 분석.

(4) Jurisprudence (법학)

- 작업(Work): 법적 문서 처리 및 의사결정 지원.

- 대표 사례:

- ChatLaw: 법률 문서 분석 및 지원.

- Blind Judgement: 법적 판단의 지원.

(5) Research Assistant (연구 보조)

- 작업(Work): 연구자의 데이터 분석 및 문서 작업 보조.

- 대표 사례:

- Ziems et al., Bail et al.: 연구 보조를 위한 데이터 처리.

2. Natural Science (자연 과학)

자연 과학 분야에서 LLM 기반 에이전트의 응용 사례입니다.

(1) Documentation and Data Management (문서 및 데이터 관리)

- 작업(Work): 과학 데이터 관리 및 문서화.

- 대표 사례:

- ChemCrow, ChatMOF, Boiko et al.: 과학 실험 데이터 관리.

(2) Experiment Assistant (실험 보조)

- 작업(Work): 실험 설계 및 데이터 분석 지원.

- 대표 사례:

- ChemCrow, Boiko et al., Grossmann et al.: 실험 수행 및 해석.

(3) Natural Science Education (자연 과학 교육)

- 작업(Work): 과학 교육 자료 제공 및 학습 보조.

- 대표 사례:

- ChemCrow, CodeHelp, MathAgent, EduChat, FreeText: 과학 교육 보조 시스템.

3. Engineering (공학)

공학 분야에서의 응용 사례입니다.

(1) CS & SE (컴퓨터 및 소프트웨어 공학)

- 작업(Work): 소프트웨어 개발 및 코드 생성.

- 대표 사례:

- RestGPT, Self-collaboration, SQL-PALM, CodeHelp: 소프트웨어 개발 자동화.

- RecMind, PentestGPT: 코드 리뷰 및 보안 테스트.

(2) Industrial Automation (산업 자동화)

- 작업(Work): 산업 공정 제어 및 자동화.

- 대표 사례:

- GPT4IA, IELLM: 산업 프로세스 최적화.

(3) Robotics & Embodied AI (로봇 및 물리적 AI)

- 작업(Work): 로봇 제어 및 임베디드 AI 시스템 개발.

- 대표 사례:

- ProAgent, LLM4RL, PET, SayCan, TidyBot: 로봇 행동 계획 및 실행.

- Dialogue shaping: 인간-로봇 상호작용 지원.

결론

이 표는 LLM 기반 에이전트의 응용 범위를 구체적으로 보여줍니다.

- 사회 과학에서는 인간 행동 이해 및 정책 분석,

- 자연 과학에서는 데이터 관리와 실험 보조,

- 공학에서는 소프트웨어 개발, 산업 자동화, 로봇 제어 등에서 폭넓게 활용되고 있습니다.

표에 제시된 사례들은 LLM 기반 에이전트의 실질적 활용 가능성을 보여주며, 각 도메인에서 특정 과제를 해결하기 위해 설계된 모델을 강조합니다. 세미나나 연구 발표에서 각 사례를 기반으로 구체적인 응용과 효과를 설명하면 유용할 것입니다. 추가로 더 심층적인 분석이 필요하면 말씀해주세요!

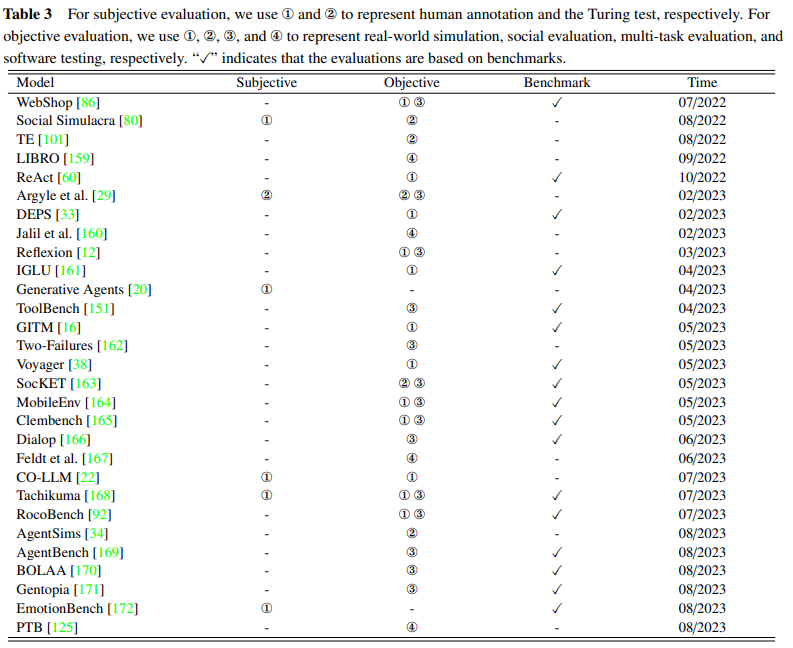

이 Table 3는 LLM 기반 자율 에이전트의 평가 방식과 관련된 정보를 체계적으로 정리한 표입니다. 이 표는 각 모델의 주관적 평가(Subjective Evaluation)와 객관적 평가(Objective Evaluation) 방식, 사용된 벤치마크 데이터(Benchmark) 여부, 그리고 모델이 발표된 시간(Time)을 나타냅니다.

1. 평가 방식 (Evaluation Methods)

(1) Subjective Evaluation (주관적 평가)

- ①: Human Annotation

- 인간 평가자가 모델의 결과물을 직접 평가.

- 예: 모델 출력의 질, 자연스러움, 유사성 등.

- ②: Turing Test

- 모델이 인간과 구별할 수 없을 정도로 자연스러운지를 평가.

- 특징:

- 사용자의 경험과 만족도를 측정하는 데 초점.

(2) Objective Evaluation (객관적 평가)

- ①: Real-world Simulation

- 실제 환경에서의 모델 성능을 시뮬레이션.

- ②: Social Evaluation

- 사회적 맥락에서 모델의 성능을 평가.

- ③: Multi-task Evaluation

- 여러 작업에서 모델의 성능을 종합적으로 평가.

- ④: Software Testing

- 소프트웨어 및 시스템 수준에서 모델의 성능과 안정성을 평가.

- 특징:

- 객관적인 기준과 데이터를 기반으로 모델 성능을 정량적으로 측정.

(3) Benchmark (벤치마크)

- ✓: 해당 모델이 벤치마크 데이터셋을 기반으로 평가되었음을 나타냄.

- 특징:

- 특정 작업에 대한 공통 기준으로, 모델 간 성능 비교 가능.

2. 주요 모델 분석

Social Science (사회 과학)

- Social Simulacra (08/2022):

- 주관적 평가: Human Annotation(①).

- 객관적 평가: Social Evaluation(②).

- 벤치마크 사용.

- Generative Agents (04/2023):

- 주관적 평가: Human Annotation(①).

- 객관적 평가: Multi-task Evaluation(③).

- 벤치마크 사용.

Engineering (공학)

- ToolBench (05/2023):

- 객관적 평가: Multi-task Evaluation(③), Software Testing(④).

- 벤치마크 사용.

- Voyager (05/2023):

- 객관적 평가: Real-world Simulation(①), Social Evaluation(②), Multi-task Evaluation(③).

- 벤치마크 사용.

General Models

- ReAct (10/2022):

- 객관적 평가: Real-world Simulation(①), Multi-task Evaluation(③).

- 벤치마크 사용.

- CO-LLM (06/2023):

- 객관적 평가: Real-world Simulation(①), Multi-task Evaluation(③).

- 벤치마크 사용.

3. 결론

이 표는 LLM 기반 자율 에이전트의 성능 평가 방식과 기준을 한눈에 이해할 수 있도록 구성되었습니다.

- 주관적 평가:

- 인간의 직접 평가(Human Annotation)와 튜링 테스트를 통해 모델의 출력 품질과 자연스러움을 평가.

- 객관적 평가:

- 다양한 맥락에서의 모델 성능(예: 실제 환경, 다중 작업, 소셜 시뮬레이션)을 정량적으로 평가.

- 벤치마크:

- 대부분의 모델이 벤치마크를 사용해 성능을 비교하고 평가.

이 표는 연구 발표나 세미나에서 평가 방식의 비교와 모델별 강점을 설명할 때 유용하며, 각 모델의 특성과 평가 방식의 차이를 논의하는 데 적합합니다. 추가로 궁금한 점이 있으면 알려주세요!

논문 제목: "A Survey on Large Language Model based Autonomous Agents"

이 논문은 LLM(대규모 언어 모델)을 기반으로 한 자율 에이전트의 구조적 구성, 응용, 평가 및 미래 과제에 대해 심층적으로 고찰한 서베이 논문입니다.

1. 문제 정의

- 배경: 자율 에이전트는 인공지능에서 인간 수준의 의사결정을 목표로 하는 중요한 연구 분야입니다. 전통적인 에이전트는 제한된 환경에서 제한적인 지식을 사용해 학습했지만, 이는 인간 학습과 크게 다릅니다.

- LLM 기반 접근: LLM은 광범위한 웹 지식을 활용하여 인간 수준의 지능을 보여주며, 이를 활용해 자율 에이전트를 구성하고 인간처럼 행동하게 하는 연구가 활발히 진행되고 있습니다.

2. 구성 요소 (Agent Construction)

LLM 기반 자율 에이전트는 다음 네 가지 주요 모듈로 구성됩니다:

2.1 프로파일링 모듈 (Profiling Module)

- 역할 정의: 에이전트의 역할(예: 프로그래머, 교사)을 정의하여 행동을 유도합니다.

- 생성 방법:

- 수작업으로 프로파일 작성

- LLM을 이용한 자동 프로파일 생성

- 실제 데이터셋을 활용한 정렬 기반 프로파일 생성

2.2 메모리 모듈 (Memory Module)

- 구조:

- 단기 메모리: 현재 상태나 상황을 기억.

- 장기 메모리: 과거 행동 및 경험 저장.

- 형식:

- 자연어 메모리: 직관적이고 표현력이 좋음.

- 임베딩 메모리: 효율적인 검색이 가능.

- 데이터베이스, 구조적 리스트 등 다양한 형식 활용.

- 작동:

- 메모리 읽기, 쓰기, 반성(reflection)을 통해 환경과 상호작용.

2.3 계획 모듈 (Planning Module)

- 전략:

- 단일 경로 추론 (Single-path reasoning): 문제를 단계별로 해결.

- 다중 경로 추론 (Multi-path reasoning): 나무 구조로 다양한 가능성을 탐색.

- 피드백 활용: 환경, 인간, 또는 모델에서 피드백을 수집해 계획 수정.

2.4 액션 모듈 (Action Module)

- 목적: 작업 수행, 의사소통, 환경 탐색.

- 방법:

- 메모리 기반 행동.

- 사전 계획된 행동.

- 행동 공간:

- 외부 도구(API, 데이터베이스) 사용.

- LLM 내부 지식을 활용.

- 결과:

- 환경 변화, 내적 상태 변화, 새로운 행동 유발.

3. 응용 분야

3.1 사회 과학

- 심리학: LLM을 이용한 인간 심리 연구 및 정신 건강 지원.

- 정치 및 경제학: 정치적 담론 분석 및 경제 행동 시뮬레이션.

- 사회 시뮬레이션: 가상 환경에서 사회적 현상 연구.

- 법학: 법적 의사결정 지원.

3.2 자연 과학

- 문서 및 데이터 관리: 과학 실험 설계 및 정보 관리 지원.

- 실험 보조: 실험 설계, 실행, 데이터 분석 지원.

- 교육: 자연 과학 및 수학 교육 도구로 활용.

3.3 공학

- 컴퓨터 과학: 코드 생성, 테스트, 디버깅 지원.

- 산업 자동화: 생산 프로세스의 지능형 제어.

- 로봇 공학: 강화 학습과 LLM의 결합을 통해 작업 수행.

4. 평가

4.1 주관적 평가

- 방법: 인간 평가자에 의한 직접 평가 또는 튜링 테스트.

4.2 객관적 평가

- 지표:

- 작업 성공률, 인간 유사성, 효율성.

- 프로토콜:

- 시뮬레이션, 사회적 평가, 멀티태스킹 테스트.

- 벤치마크:

- 특정 작업과 환경에 대한 평가 데이터셋.

5. 미래 과제

- 역할 수행 능력 향상: 특정 역할을 정밀히 시뮬레이션하기 위한 모델 및 데이터 개선.

- 일반화된 인간 정렬 (Generalized Human Alignment): 다양한 인간 가치와 조화된 에이전트 설계.

- 프롬프트 안정성: 복잡한 프롬프트의 일관성과 견고성 확보.

- 환각 문제 (Hallucination): 잘못된 정보 생성을 최소화.

- 지식 경계: 시뮬레이션 시 LLM의 과도한 지식 활용 방지.

- 효율성: LLM의 느린 추론 속도를 극복하기 위한 최적화.

6. 결론

이 논문은 LLM 기반 자율 에이전트의 현재 상태를 종합적으로 정리하고, 세부 기술, 주요 응용, 평가 방법, 그리고 해결해야 할 과제를 제시합니다. 이는 미래 연구를 위한 중요한 방향성을 제공합니다.

관련 논문

1. WebGPT (2021)

- 내용: OpenAI에서 개발된 초기 LLM 기반 에이전트로, 웹 탐색을 통해 질문에 답을 제공하는 시스템입니다.

- 특징:

- 웹 검색 결과를 이용해 고품질 답변 생성.

- 평가 과정에서 인간의 피드백(Human Feedback)을 활용해 모델 성능 개선.

- 한계: 정보의 신뢰성과 정확성을 보장하기 어려운 문제를 보여줌.

2. AutoGPT (2023)

- 내용: 멀티태스킹을 목표로 하는 자율 에이전트로, 복잡한 작업을 여러 단계를 통해 수행.

- 특징:

- 작업 완료를 위해 자체 피드백 루프를 형성.

- 사용자가 제공한 간단한 목표를 세부적인 하위 작업으로 나누어 수행.

- 의의:

- LLM의 실행 가능성을 다양한 애플리케이션에서 입증.

- 일반 에이전트로서의 기반 마련.

3. AgentGPT (2023)

- 내용: AutoGPT와 유사하지만, 사용자 친화적인 인터페이스를 제공하여 더 많은 사용자 정의를 지원.

- 특징:

- 사용자 지정 프롬프트를 통해 더욱 구체적인 작업 가능.

- 다양한 외부 도구 및 API와 통합 가능.

- 의의: 개발 및 실험 환경에서 쉽게 활용 가능.

4. Generative Agent (2023)

- 내용: 인간과 유사한 행동 및 의사결정을 시뮬레이션하기 위한 에이전트.

- 특징:

- 장기 기억(Long-term Memory)을 포함한 메모리 시스템.

- 행동과 감정을 반영하는 계획 수립 및 액션 모듈.

- 응용: 사회적 시뮬레이션, 심리학 연구 등.

5. Voyager (2023)

- 내용: Minecraft와 같은 오픈월드 게임 환경에서 학습하고 탐색하는 에이전트.

- 특징:

- 자기지도 학습(Self-supervised Learning)을 통한 지속적 학습.

- 실시간으로 작업 계획 및 자원 활용.

- 의의: 시뮬레이션 환경에서의 성능 검증.

6. ToolBench 및 Tool LLaMA (2023)

- 내용: 도구 사용 능력을 가진 에이전트로, 계산기, 데이터베이스와 같은 도구와의 상호작용을 통해 작업 수행.

- 특징:

- LLM의 도구 활용 능력을 강화.

- 외부 API와 통합된 구조.

- 응용: 계산 작업, 데이터 분석, 웹 검색.

7. MIND2WEB (2023)

- 내용: 웹에서 대규모 지식을 추출하여 문제를 해결하는 에이전트.

- 특징:

- 웹 문서에서 구조적 데이터를 추출하고 이를 분석하여 답변 생성.

- 정보 검색과 분석 능력을 결합.

- 의의: 웹 데이터 활용 가능성을 확대.

8. AgentSims (2023)

- 내용: 복잡한 시뮬레이션 환경에서 상호작용하며 작업을 수행하는 에이전트.

- 특징:

- 멀티에이전트 시뮬레이션.

- 다양한 역할 및 협업 가능.

- 응용: 도시 계획, 로봇 공학, 사회적 행동 연구.

9. WebShop (2022)

- 내용: 온라인 쇼핑 시뮬레이션을 수행하는 에이전트로, 사용자의 요구 사항에 따라 상품 추천 및 구매 과정 시뮬레이션.

- 특징:

- 상품 검색, 비교, 추천 등의 작업 자동화.

- 응용: 전자 상거래 플랫폼 및 사용자 지원.

10. CoT (Chain-of-Thought, 2022)

- 내용: LLM의 단계적 추론 과정을 활용해 문제를 해결하는 프롬프트 엔지니어링 기법.

- 특징:

- 문제를 세부 단계로 나누어 점진적으로 해결.

- 복잡한 문제 해결에서 LLM의 성능을 크게 향상.

- 의의: 자율 에이전트의 계획 모듈에 중요한 기반 기술.

11. DEPS (2022)

- 내용: 외부 환경과 상호작용하며 작업을 수행하는 에이전트.

- 특징:

- 작업 로그와 환경 상태를 지속적으로 업데이트.

- 실시간 피드백 시스템.

- 응용: 산업 자동화 및 생산성 도구.

12. RecAgent (2023)

- 내용: 추천 시스템에 특화된 에이전트로, 사용자 선호도를 학습하여 개인화된 추천 제공.

- 특징:

- 사용자 행동 데이터를 활용.

- 협업 필터링 및 LLM 기반의 콘텐츠 생성.

- 응용: 영화, 음악, 상품 추천 시스템.

13. ToT (Tree of Thoughts, 2023)

- 내용: LLM이 복잡한 문제를 나무(Tree) 형태로 확장하여 여러 경로를 탐색.

- 특징:

- 경로별로 가능한 결과를 생성하고 최적의 경로 선택.

- Multi-path reasoning 기반.

- 의의: 추론 능력을 향상시키고 복잡한 의사결정 문제 해결에 기여.

요약 및 의의

- LLM 기반 자율 에이전트 연구는 다양한 응용 분야(예: 시뮬레이션, 도구 사용, 웹 탐색 등)와 기술적 기반(예: CoT, ToT) 위에서 빠르게 발전하고 있습니다.

- 연구의 핵심은 LLM의 기존 강점을 바탕으로 메모리, 계획, 행동 모듈을 통합해 복잡한 환경에서 자율성과 적응성을 강화하는 것입니다.

그럼 이 논문은 방법론 적인 논문이 아니라 AI Agent가 어디에 사용되고 있고, 어떤 평가 방식으로 진행되며 나중에는 어떤 역할을 할 것이다 이 정도를 작성한 것이네?

네, 정확합니다. 이 논문은 방법론(Methodology)에 중점을 두기보다는, LLM 기반 자율 에이전트의 현재 상태와 트렌드를 포괄적으로 정리한 서베이 논문(Survey Paper)입니다. 논문이 다루는 주요 내용은 다음과 같습니다:

1. AI Agent의 사용 분야

논문은 LLM 기반 자율 에이전트가 다양한 응용 분야에서 어떻게 사용되고 있는지 정리합니다.

- 사회 과학: 인간 심리학, 정치, 경제, 법학, 사회 시뮬레이션 등.

- 자연 과학: 실험 설계, 데이터 분석, 과학 연구 보조.

- 공학 및 산업: 소프트웨어 개발, 산업 자동화, 로봇 공학.

- 일상적인 작업: 웹 탐색, 온라인 쇼핑, 추천 시스템 등.

2. 평가 방식

LLM 기반 에이전트의 성능을 평가하기 위한 다양한 방법론이 제안되었습니다:

- 주관적 평가:

- 인간 평가자를 활용해 에이전트의 성능을 직접 평가.

- 예: 사용자 경험, 답변 품질, 인간 유사성 측정.

- 객관적 평가:

- 작업 성공률, 효율성, 계산 속도와 같은 정량적 지표 사용.

- 시뮬레이션 환경과 특정 벤치마크 데이터셋 활용.

- 벤치마크 데이터셋 및 프로토콜:

- 특정 작업(예: 웹 탐색, 게임 플레이)에 대한 데이터셋.

- 멀티태스킹 능력을 평가하기 위한 프레임워크.

3. 미래 역할 및 연구 과제

논문은 AI 에이전트가 앞으로 수행할 중요한 역할과 해결해야 할 기술적/사회적 과제를 제시합니다:

- 중요한 역할:

- 인간 작업 보조: 정보 검색, 도구 활용, 복잡한 문제 해결.

- 독립적 연구 수행: 자율적인 실험 설계와 분석.

- 인간-에이전트 협업: 다양한 산업과 과학에서 공동 작업 가능.

- 연구 과제:

- 모델 정렬(Human Alignment): 인간의 가치와 목표에 맞는 에이전트 설계.

- 프롬프트 안정성: 복잡한 작업에서도 일관된 성능 유지.

- 환각(Hallucination): 잘못된 정보를 생성하는 문제 해결.

- 효율성: 에이전트의 계산 속도와 자원 사용 최적화.

결론

따라서 이 논문은 방법론을 제안하는 기술적인 논문이 아니라, LLM 기반 AI Agent의 현황과 미래 방향성을 제시하는 전략적 가이드라인 역할을 합니다. 연구자가 LLM 에이전트를 활용한 새로운 방법론을 개발하거나 특정 도메인에 적용할 때 중요한 참고 자료가 될 수 있습니다.

추후 AI Agent 연구를 진행할 때, 이 논문의 정보는 "어떤 문제를 해결할 것인지", "어떤 평가 방식을 활용할 것인지", 그리고 "미래 과제"를 정의하는 데 중요한 통찰을 제공합니다.

결론

결과 (Results)

이 논문은 LLM 기반 자율 에이전트의 연구 현황과 미래 전망을 종합적으로 정리하며, 다음과 같은 주요 결과를 제시합니다:

- LLM 기반 자율 에이전트의 빠른 발전

- 2021년부터 2023년까지 LLM 기반 자율 에이전트 연구가 급격히 증가했습니다.

- 초기에는 간단한 웹 탐색(WebGPT)과 같은 응용에서 시작하여, AutoGPT와 같은 다목적 에이전트, Voyager와 같은 게임 기반 학습 에이전트, ToolBench와 같은 도구 사용 에이전트 등으로 다양화되었습니다.

- 응용 분야의 확장

- LLM 기반 에이전트는 사회 과학, 자연 과학, 공학 등 다양한 분야에서 활용되고 있으며, 인간과의 협업 또는 대체가 가능하도록 발전하고 있습니다.

- 예: 심리학 연구, 데이터 관리, 코드 작성, 산업 자동화 등.

- 에이전트의 주요 구성 요소 정립

- 자율 에이전트는 크게 프로파일링, 메모리, 계획, 행동이라는 4가지 주요 모듈로 구성됨.

- 이들 모듈이 상호작용하여 LLM 에이전트의 유연성과 적응성을 제공함.

- 평가 프레임워크의 발전

- 자율 에이전트 평가를 위한 주관적/객관적 지표 및 벤치마크가 정립되었음.

- 하지만 복잡한 작업에 대한 표준화된 평가 방법은 여전히 부족하다는 점이 강조됨.

결론 (Conclusion)

- LLM 기반 자율 에이전트의 가능성

- LLM은 대규모 지식을 활용하여 인간과 유사한 수준의 작업 수행이 가능하며, 다양한 분야에서 유용한 도구로 자리 잡았습니다.

- 특히, 자율성(Autonomy)과 적응성(Adaptability)을 통해 복잡한 문제 해결에 적합한 시스템으로 발전할 잠재력을 보입니다.

- 기술적 한계와 해결해야 할 문제

- 환각(Hallucination): 에이전트가 잘못된 정보를 생성하는 문제.

- 프롬프트 안정성: 복잡한 프롬프트에서 일관되게 행동하지 못하는 문제.

- 효율성: 계산 비용과 처리 시간의 최적화가 필요함.

- 역할 수행의 한계: 특정 역할에 특화되거나 일반화된 에이전트를 설계하는 데 기술적 어려움 존재.

- 미래 연구의 방향성

- 일반화된 인간 정렬(Generalized Human Alignment): 다양한 인간 가치와 일치하는 에이전트 설계.

- 지속적 학습(Continuous Learning): 새로운 데이터와 환경에 적응할 수 있는 모델 개발.

- 강화된 협업 능력: 인간 및 다른 에이전트와의 효과적인 협업.

마무리 (Closing Remarks)

- 이 논문은 LLM 기반 자율 에이전트 연구가 얼마나 빠르게 발전했는지, 그리고 이 분야가 앞으로 얼마나 큰 잠재력을 가지고 있는지를 강조합니다.

- 논문은 현재 기술의 한계와 이를 극복하기 위한 연구 과제를 정리하여, 향후 연구자들에게 명확한 방향성을 제시합니다.

- LLM 에이전트는 단순한 작업 보조 도구를 넘어, 인간과 협업하며 독립적으로 문제를 해결하는 차세대 지능형 시스템으로 발전할 것으로 기대됩니다.

이 결론과 마무리는 AI Agent 연구를 준비하는 데 중요한 가이드라인을 제공합니다.

교수님의 추천으로 읽어 본 논문입니다.

이 논문은 방법론적인 논문이라기보다는, LLM 기반 AI Agent가 어떻게 발전해 왔는지, 현재 얼마나 많은 관심을 받고 있는지, 그리고 어디에서 활용되고 있는지를 체계적으로 조사하고 정리한 서베이 논문(Survey Paper)입니다.

논문은 AI Agent의 종류부터 시작하여 다양한 응용 분야와 평가 방법, 그리고 미래 연구 과제까지 다루고 있습니다. 특히, 2021년부터 2023년까지의 연구 동향을 분석하며, 각 연구의 발전 방향과 기술적 한계를 구체적으로 설명합니다.

제가 AI Agent 세미나 준비를 진행해야 하는데, 이 논문은 해당 자료의 초석이 될 것으로 보입니다.

AI Agent의 주요 구성 요소와 활용 분야, 그리고 평가 지표는 앞으로 세미나 발표 준비에 유용하게 활용될 수 있을 것 같습니다.

추가적인 내용 보완:

- AI Agent의 종류는 일반 에이전트(General Agent), 도구 에이전트(Tool Agent), 웹 에이전트(Web Agent), 게임 에이전트(Game Agent), 시뮬레이션 에이전트(Simulation Agent) 등으로 구분됩니다.

- 각 에이전트는 특정 목적(예: 도구 활용, 웹 탐색, 시뮬레이션 학습)을 기반으로 설계되며, 다양한 도메인에서 인간과 협력하거나 독립적으로 작업을 수행할 수 있습니다.

- 논문에서는 자율 에이전트의 주요 구성 요소를 다음과 같이 정리하고 있습니다:

- 프로파일링 모듈: 에이전트의 역할과 행동 목표를 정의.

- 메모리 모듈: 단기 및 장기 기억을 통해 학습 및 적응.

- 계획 모듈: 단계적 문제 해결 및 다중 경로 추론.

- 액션 모듈: 작업 수행 및 환경과의 상호작용.

이와 함께, 현재까지의 연구 결과와 기술적 한계(예: 환각, 프롬프트 안정성, 효율성 문제), 그리고 미래 연구 과제(예: 인간 정렬, 지속적 학습, 협업 능력 강화)가 논문에서 명확히 제시되어 있습니다.

이 내용은 세미나에서 AI Agent의 현황 및 발전 가능성을 논의할 때 중요한 참고 자료가 될 것입니다.