2024.12.23 - [인공지능/논문 리뷰 or 진행] - ChatQA: Surpassing GPT-4 on Conversational QA and RAG - 논문 리뷰

ChatQA: Surpassing GPT-4 on Conversational QA and RAG - 논문 리뷰

https://arxiv.org/abs/2401.10225 ChatQA: Surpassing GPT-4 on Conversational QA and RAGIn this work, we introduce ChatQA, a suite of models that outperform GPT-4 on retrieval-augmented generation (RAG) and conversational question answering (QA). To enhance

yoonschallenge.tistory.com

ChatQA 2: Bridging the Gap to Proprietary LLMs in Long Context and RAG Capabilities - 논문 리뷰

https://arxiv.org/abs/2407.14482 ChatQA 2: Bridging the Gap to Proprietary LLMs in Long Context and RAG CapabilitiesIn this work, we introduce ChatQA 2, an Llama 3.0-based model with a 128K context window, designed to bridge the gap between open-source LL

yoonschallenge.tistory.com

여기에 모든 모델에 동일하게 상의 k개의 청크가 주어진다고 작성되어 있네요 ㅎㅎ....

요약 및 설명

이 부분은 논문의 주요 기여와 결과를 체계적으로 요약하고 있습니다. 이를 이해하기 쉽게 단계별로 정리하겠습니다.

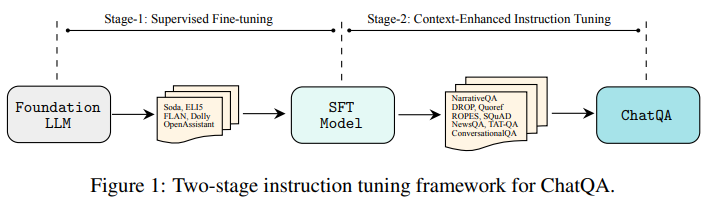

1. Two-Stage Instruction Tuning

- 제안된 방법:

- 두 단계로 이루어진 Instruction Tuning 방법론.

- Stage 1: Supervised Fine-Tuning(SFT)으로 대화형 QA의 기본 능력을 학습.

- Stage 2: Context-Enhanced Instruction Tuning으로 검색된 문맥을 효과적으로 활용하는 능력 추가.

- 두 단계로 이루어진 Instruction Tuning 방법론.

- 성과:

- 이 방법이 기존의 강력한 모델(예: Llama2-Chat, Llama3-Instruct) 및 RLHF 기반 학습 방법을 능가.

- 검색 증강 생성(RAG) 및 대화형 QA에서 높은 성능을 입증.

2. Dense Retriever Fine-Tuning

- 내용:

- Dense Retriever를 단일 질문(single-turn QA) 또는 다중 턴 QA 데이터로 미세 조정(Fine-Tuning)함.

- 인간 주석 데이터(Human Annotated Data)와 합성 데이터(Synthetic Data)를 활용.

- 성과:

- GPT-3.5-Turbo와 같은 최신 쿼리 재작성(Query Rewriting) 모델과 동등한 성능 달성.

- 합성 데이터 생성(synthetic data generation)의 가능성을 보여줌:

- 맞춤형 검색 모델을 학습할 때 유용한 도구로 작동.

3. CHATRAG BENCH 도입

- 내용:

- 10개의 대화형 QA 데이터셋으로 구성된 포괄적인 평가 벤치마크:

- 긴 문서 처리: 5개의 긴 문서 데이터셋에서 검색이 필요한 질문 포함.

- 테이블 및 산술 계산: 3개의 테이블 기반 및 산술 계산 질문 포함.

- 10개의 대화형 QA 데이터셋으로 구성된 포괄적인 평가 벤치마크:

- 성과:

- 다양한 언어 모델에서 ChatQA 학습 방법의 뛰어난 일반화 능력 입증.

- 평균 점수:

- ChatQA-1.0-70B: 54.14 (Llama2 기반).

- GPT-4-0613 (53.90) 및 **GPT-4-Turbo (54.03)**를 초과.

- Llama3-ChatQA-1.5-8B: GPT-4와 유사한 성능 달성.

- Llama3-ChatQA-1.5-70B: GPT-4-Turbo를 초과하는 성능.

- ChatQA-1.0-70B: 54.14 (Llama2 기반).

4. 무응답 처리(Unanswerable Scenario)

- 내용:

- 모델이 답을 알 수 없는 질문에 대해 "답할 수 없음"을 생성하도록 학습.

- 소량의 "무응답 샘플"을 포함하여 모델의 능력을 강화.

- 성과:

- ChatQA-1.0-70B는 GPT-3.5-Turbo보다 우수한 무응답 처리 성능.

- GPT-4-0613과 비교했을 때 약간의 성능 차이(3.5%) 존재:

- ChatQA는 무응답 처리에서 GPT-4에 근접한 성능을 보임.

핵심 요약

- 두 단계 학습법이 기존 모델 학습 방법보다 뛰어난 성능을 발휘.

- Dense Retriever Fine-Tuning을 통해 효율적이고 비용 효과적인 검색 모델 구현.

- CHATRAG BENCH를 통해 ChatQA가 다양한 QA 작업에서 GPT-4 수준 이상의 성능을 입증.

- 무응답 시나리오에서 정확성과 신뢰성을 모두 보장하는 QA 모델의 가능성을 확인.

궁금한 부분이나 추가적으로 알고 싶은 세부 사항이 있다면 말씀해주세요!

최신 커리 재작성??

최신 쿼리 재작성(Query Rewriting)에 대해 쉽게 이해할 수 있도록 체계적으로 설명하겠습니다.

1. 쿼리 재작성(Query Rewriting)이란?

- 쿼리 재작성은 대화형 질문응답 시스템(Conversational QA)에서 사용자의 질문을 더 명확하고 독립적인 형태로 변환하는 기술입니다.

- 사용자의 질문이 대화 문맥에 의존할 경우, 이를 독립된 질문 형태로 변환해 검색 시스템이나 언어 모델이 더 정확하게 처리할 수 있도록 합니다.

예시

- 대화 문맥:

User: 태양의 질량은 얼마인가요? Assistant: 태양의 질량은 약 1.989 × 10^30 kg입니다. User: 지구와 비교하면 얼마나 더 큰가요? - 문제:

- 두 번째 질문은 "지구와 비교하면 얼마나 더 큰가요?"라는 문맥 의존적인 형태입니다.

- 이전 질문과 답변을 모르면 정확히 이해하기 어렵습니다.

- 쿼리 재작성 후:

재작성된 질문: "태양의 질량은 약 1.989 × 10^30 kg인데, 지구의 질량과 비교하면 얼마나 더 큰가요?"- 대화 문맥 없이도 명확히 이해 가능한 독립적인 질문이 됩니다.

2. 최신 쿼리 재작성 기술

- 최신 쿼리 재작성(Query Rewriting) 기술은 대규모 언어 모델(LLM)을 활용해 문맥을 자동으로 분석하고, 독립적인 질문으로 변환하는 방식입니다.

- 예: GPT-3.5-Turbo 같은 언어 모델을 사용하여 질문 재작성.

기술적 특징

- 문맥 분석:

- 모델이 대화의 전체 흐름을 이해하여 사용자의 질문이 참조하는 문맥을 파악.

- 독립적 질문 생성:

- 이전 대화 기록을 반영해 완전하고 독립적인 질문을 생성.

장점

- 대화 기록 전체를 검색 시스템에 넘기지 않아도 되므로 효율적.

- 검색 엔진이 독립된 질문을 처리하므로 정확도가 향상.

예시

- 대화:

User: 브랜디 멜빌은 사람인가요? Assistant: 아니요, 이탈리아 브랜드입니다. User: 광고는 어떻게 하나요? - 쿼리 재작성 후:

재작성된 질문: "브랜디 멜빌은 이탈리아 브랜드인데, 이 브랜드는 광고를 어떻게 하나요?"

3. ChatQA에서의 Dense Retriever와 차이점

- 최신 쿼리 재작성은 질문을 재구성하는 모델을 따로 사용합니다(GPT-3.5-Turbo 같은).

- 이 과정은 추가적인 계산 비용 및 모델 호출(API 사용 비용)을 요구.

- Dense Retriever:

- 별도의 질문 재작성 없이 대화 기록 전체와 현재 질문을 결합해 검색.

- 더 간단하며 효율적.

Dense Retriever의 입력 예시

- 입력:

대화 기록: ["브랜디 멜빌은 사람인가요?", "아니요, 이탈리아 브랜드입니다."] 현재 질문: "광고는 어떻게 하나요?" - 검색된 문맥:

"브랜디 멜빌은 전통 광고를 사용하지 않고, 소셜 미디어에 크게 의존합니다."

4. 결론

- 최신 쿼리 재작성은 대화 문맥을 독립적이고 명확한 질문으로 변환하는 기술.

- ChatQA는 별도의 쿼리 재작성 과정 없이 Dense Retriever를 사용해 문맥을 통합하여 유사한 성능을 달성하면서 더 효율적인 접근을 제공합니다.

추가로 설명이 필요한 부분이 있으면 말씀해주세요!

3.2 Stage-2: Context-Enhanced Instruction Tuning

한글 번역 및 설명

Stage-2는 문맥을 활용한 질문응답(QA) 능력을 강화하기 위해 설계된 두 번째 단계의 Instruction Tuning 과정입니다. 이 단계에서는 문맥 기반 QA 데이터셋을 학습 데이터로 추가하여 모델의 QA 성능을 극대화합니다. 아래는 세부적인 내용입니다.

3.2.1 Human Annotated Data (사람이 주석한 데이터)

데이터 구성

- HumanAnnotatedConvQA 데이터셋:

- 약 7,000개의 문서에서 생성된 고품질 문서 기반 대화형 QA 데이터셋.

- 각 문서는 평균 5개의 사용자-에이전트 대화 턴(turn)으로 구성.

- 문서의 주제는 다양한 인터넷 자료에서 수집되었으며, 궁금한 질문과 답변이 포함된 다중 턴 대화를 포함.

데이터 생성 과정

- 문서 수집:

- 인터넷에서 약 7,000개의 문서를 수집.

- 문서의 주제는 다양하며, 평균 길이는 약 1,000단어.

- 주석 작업:

- 주석자가 문서의 내용을 바탕으로 질문을 생성(질문 및 후속 질문).

- 에이전트는 질문에 적절한 답변을 생성.

- 최종 데이터:

- 문서당 다중 턴 대화(총 7,000개의 대화).

- 평균 5개의 사용자-에이전트 턴으로 구성.

무응답 처리

- 목적:

- 모델이 답변할 수 없는 경우 "답할 수 없음"을 명확히 생성하도록 학습.

- 구현 방식:

- 주석자가 질문과 관련된 문서의 모든 부분을 식별.

- 질문에 관련된 텍스트를 문서에서 삭제.

- 삭제된 텍스트에 대한 답변으로 "죄송합니다. 주어진 문맥에서 답을 찾을 수 없습니다."를 제공.

- 결과:

- 무응답 데이터: 1,500개의 사용자-에이전트 턴 추가 생성.

- 무응답 데이터와 일반 데이터의 균형을 맞춤.

3.2.2 Synthetic Data Generation (합성 데이터 생성)

데이터 생성 목적

- GPT-3.5-Turbo를 활용하여 대화형 QA 데이터를 합성 생성.

- 중간 규모의 고품질 합성 데이터(SyntheticConvQA)를 통해 추가 학습 데이터 확보.

생성 과정

- 입력 데이터 준비:

- 인터넷에서 약 7,000개의 문서(평균 1,000단어) 수집.

- GPT-3.5-Turbo를 활용한 데이터 생성:

- GPT 모델에 세 가지 구성의 명령어를 입력:

- 시스템 역할: "유용한 답변을 제공하는 모델"로 설정.

- 대화형 QA 예시: 데이터 유형의 샘플 제공.

- 문서: 문서를 기반으로 대화형 QA 생성.

- GPT 모델에 세 가지 구성의 명령어를 입력:

- 결과:

- 각 문서를 기반으로 하나의 다중 턴 QA 샘플 생성.

- 총 7,000개의 다중 턴 대화(평균 4.4개의 사용자-에이전트 턴).

무응답 처리

- 합성 데이터에서도 무응답 샘플 생성.

- 구현 방식:

- 문서를 여러 "청크(chunk)"로 나눔.

- 청크와 답변 간의 유사성을 측정(4-gram recall score 사용):

- 높은 유사성 (High Overlap): 0.5 이상.

- 낮은 유사성 (Low Overlap): 0.1 이하.

- "높은 유사성" 청크를 제거한 뒤 무응답 샘플 생성.

- 결과:

- 추가적으로 1,500개의 무응답 샘플 생성.

3.2.3 Training Blends (훈련 데이터 구성)

구성 요소

Stage-2 학습 데이터는 다음으로 구성됩니다:

- 대화형 QA 데이터셋:

- HumanAnnotatedConvQA 또는 SyntheticConvQA.

- 단일 턴 QA 데이터셋:

- DROP, NarrativeQA, Quoref, ROPES, SQuAD 1.1 & 2.0, NewsQA, TAT-QA 등.

- Stage-1 데이터셋:

- Stage-1에서 사용된 모든 Supervised Fine-Tuning(SFT) 데이터셋.

특별 추가 데이터

- Llama3-ChatQA-1.5 학습:

- HybriDial 데이터셋: 테이블 및 대화형 데이터 포함.

- 금융 도메인 QA 데이터: 약 2,000개의 QA 쌍 추가.

훈련 과정

- 단일 턴 및 다중 턴 QA 데이터셋을 통합.

- 질문 유형에 따라 답변 유형(예: 짧은 답변, 긴 답변, 산술 계산) 명시.

- 문맥 기반 질문은 관련 문맥을 추가하여 통합.

최종 요약

- Human Annotated Data와 Synthetic Data를 활용하여 Stage-2 학습을 진행.

- 무응답 처리와 다양한 QA 데이터를 포함해 모델의 범용성과 신뢰성을 강화.

- Llama3-ChatQA-1.5는 금융 도메인과 테이블 기반 QA를 추가 학습하여 더욱 확장된 성능을 보임.

추가적으로 궁금한 점이나 더 자세히 알고 싶은 부분이 있다면 말씀해주세요!

3.2.2 합성 데이터 생성 (Synthetic Data Generation)

HumanAnnotatedConvQA 데이터의 품질을 검증하고 강화하기 위해 GPT-3.5-Turbo를 활용하여 합성 대화형 QA 데이터를 생성했습니다. 이는 GPT-3.5-Turbo의 강력한 명령어 수행 능력과 텍스트 생성 능력을 활용한 결과입니다. 참고로, Dai et al. (2022)에서는 대규모 합성 데이터를 사용한 연구를 진행했으나, 본 연구에서는 중간 규모의 고품질 합성 데이터를 활용해 대규모 언어 모델(LLM)의 파인튜닝에 초점을 맞췄습니다.

GPT-3.5-Turbo로 데이터 생성 과정

GPT-3.5-Turbo에 제공된 명령어는 다음 세 가지 요소로 구성됩니다:

- 시스템 역할 지정: 모델이 "유용한 답변을 제공하는 역할"로 설정됨.

- 대화형 QA 예시 제공: 요구되는 데이터 유형을 보여주는 예시 포함.

- 문서 기반 생성 지시: 문서를 제공하고, 해당 내용을 기반으로 대화형 QA를 생성하도록 지시.

입력 데이터 준비

- 문서 수집:

- 인터넷의 Common Crawl에서 약 7,000개의 문서(문서당 평균 약 1,000단어)를 수집.

- 다양한 도메인을 포함하도록 구성.

- 데이터 생성:

- 각 문서를 바탕으로 하나의 다중 턴 QA 샘플 생성.

- 결과적으로 총 7,000개의 다중 턴 QA 대화를 생성했으며, 대화당 평균 4.4개의 사용자-에이전트 턴 포함.

- 이 데이터셋은 SyntheticConvQA라 명명됨.

무응답 샘플 생성

- HumanAnnotatedConvQA와 유사하게, 이 합성 데이터셋에서도 무응답 샘플을 추가 생성.

- 문맥 정보가 없는 상태에서 무응답 샘플 생성:

- 에이전트 답변의 문맥 위치에 대한 명시적인 주석이 없기 때문에 다른 방법으로 무응답 샘플을 구성.

- 구체적인 생성 과정:

- 각 대화에 사용된 문서를 여러 "청크(chunk)"로 나눔.

- 각 청크와 에이전트 답변 간의 유사성(Overlaps)을 측정:

- 높은 유사성(High Overlap): 청크와 에이전트 답변 간 4-gram recall 점수가 0.5 이상.

- 낮은 유사성(Low Overlap): 4-gram recall 점수가 0.1 이하.

- 높은 유사성을 보이는 청크를 제거한 뒤, 나머지 낮은 유사성 청크만 남겨서 무응답 샘플로 구성.

- 무응답 질문에 대한 답변은 다음과 같이 설정:

- "죄송합니다. 주어진 문맥에서 답을 찾을 수 없습니다."

- 결과:

- 추가적으로 1,500개의 사용자-에이전트 무응답 턴을 생성.

- 이 데이터를 통해 무응답 샘플과 일반 샘플 간의 균형을 유지.

4-gram Recall Metric

- 4-gram recall은 각 청크와 에이전트 답변 간의 유사성을 측정하는 척도입니다.

- 높은 유사성(High Overlap): 답변의 4-그램 구문이 청크 내에서 50% 이상 포함.

- 낮은 유사성(Low Overlap): 답변의 4-그램 구문이 청크 내에서 10% 미만 포함.

- 이 척도를 활용하여 무응답 데이터의 품질을 높임.

요약

합성 데이터 생성 과정은 GPT-3.5-Turbo를 활용하여 다중 턴 QA 데이터와 무응답 샘플을 추가적으로 생성함으로써, HumanAnnotatedConvQA 데이터의 품질을 보완하고 모델 학습을 강화하는 데 기여했습니다. 이로써 중간 규모의 고품질 데이터를 활용한 효율적인 파인튜닝이 가능해졌습니다. 추가적인 질문이 있다면 말씀해주세요!

이 Figure는 ChatQA 모델을 학습시키기 위해 사용된 Two-stage Instruction Tuning Framework를 설명하는 그림입니다. 이를 단계별로 분석해 설명하겠습니다.

1. Stage 1: Supervised Fine-Tuning (SFT)

- 출발점 (Foundation LLM):

- 기본적으로 사전 학습된 언어 모델(Foundation LLM)을 시작점으로 사용합니다.

- 예: Llama2 또는 Llama3와 같은 대규모 언어 모델(LLM).

- 사용 데이터셋:

- Soda, ELI5, FLAN, Dolly, OpenAssistant 등의 데이터셋을 활용하여 모델을 학습.

- Soda: 소셜 대화 데이터셋.

- ELI5: 상세한 설명이 요구되는 질문응답 데이터.

- FLAN: 다양한 명령어 수행 데이터를 포함한 데이터셋.

- Dolly: 오픈소스 명령어 튜닝 데이터셋.

- OpenAssistant: 공개된 대화형 데이터셋.

- Soda, ELI5, FLAN, Dolly, OpenAssistant 등의 데이터셋을 활용하여 모델을 학습.

- 결과:

- 이 단계를 통해 SFT 모델은 기본적인 대화 능력과 명령어 수행 능력을 학습합니다.

2. Stage 2: Context-Enhanced Instruction Tuning

- 출발점 (SFT Model):

- Stage 1에서 생성된 SFT 모델을 기반으로 학습을 이어갑니다.

- 사용 데이터셋:

- 대화 문맥(Context)과 관련된 QA 및 RAG 태스크를 처리하기 위해 데이터셋을 추가적으로 학습.

- NarrativeQA: 긴 문서를 기반으로 질문에 답변.

- DROP, Quoref: 복잡한 추론과 참조를 요구하는 QA 데이터셋.

- ROPES: 문맥 추론 능력을 강화하는 데이터셋.

- SQuAD, NewsQA: 전통적인 질문응답 데이터셋.

- TAQ-QA: 테이블 기반 질문응답 데이터셋.

- ConversationalQA: 다중 턴 대화형 질문응답 데이터셋.

- 대화 문맥(Context)과 관련된 QA 및 RAG 태스크를 처리하기 위해 데이터셋을 추가적으로 학습.

- 결과:

- 모델이 사용자 입력이나 검색된 문맥을 효과적으로 통합하여 대답할 수 있는 능력을 습득.

- 검색 증강 생성(RAG) 및 대화형 QA 태스크에서 우수한 성능을 발휘.

최종 단계: ChatQA

- 최종적으로 ChatQA 모델이 생성됩니다.

- ChatQA는 다음과 같은 특징을 갖습니다:

- 긴 문서, 테이블 기반 데이터, 산술 계산 등을 포함한 다양한 QA 태스크 처리 가능.

- 사용자 제공 문맥 및 검색된 문맥을 효과적으로 통합.

- 무응답 시나리오에서 신뢰성 있는 응답("답할 수 없음") 생성.

Figure의 핵심 요약

- 단계적 학습 과정:

- Stage 1: SFT를 통해 기본적인 대화 및 명령어 수행 능력을 학습.

- Stage 2: 문맥을 강화한 데이터셋으로 모델의 QA 및 RAG 능력 향상.

- 데이터셋 구성:

- 첫 번째 단계에서는 일반적인 명령어 수행 데이터.

- 두 번째 단계에서는 문맥을 포함한 복잡한 QA 데이터.

- ChatQA 모델 결과:

- GPT-4와 비교해 동등하거나 초과하는 성능.

- 검색 증강 생성 및 대화형 QA에서 우수한 성능을 입증.

추가적으로 궁금한 점이나 설명이 필요한 부분이 있다면 말씀해주세요!

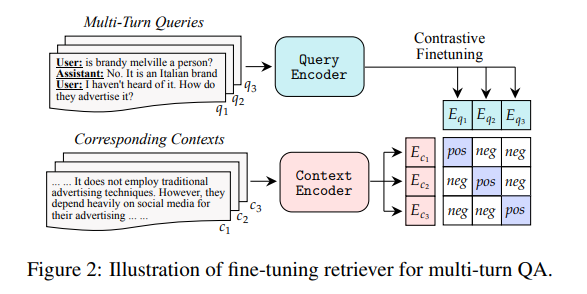

이 Figure는 다중 턴 질문응답(Multi-Turn QA)에서 검색 모델(Retriever)을 파인튜닝하는 과정을 설명합니다. 이를 단계별로 상세히 분석하겠습니다.

1. Multi-Turn Queries (다중 턴 질문)

- 입력: 사용자의 연속적인 질문과 에이전트의 답변으로 구성된 다중 턴 대화 기록.

- 예:

User: Is Brandy Melville a person? Assistant: No, it is an Italian brand. User: I haven’t heard of it. How do they advertise it? - 여기서 q1, q2, q3는 사용자의 질문 시퀀스를 나타냅니다.

- 예:

- 목적:

- 대화의 문맥을 유지하며 적절한 문서를 검색하기 위한 질문 인코딩(Embedding) 생성.

2. Corresponding Contexts (대응하는 문맥)

- 입력: 각 질문(q1, q2, q3)에 해당하는 문서 또는 문맥(c1, c2, c3) 제공.

- 예:

Context: It does not employ traditional advertising techniques. However, they depend heavily on social media for their advertising... - 문맥은 검색 과정에서 질문에 가장 적합한 정보를 포함하는 청크(Chunk)로 나뉩니다.

- 예:

- 목적:

- 각 문맥을 효과적으로 인코딩(Embedding)하여 질문과 매칭되는지 평가.

3. Query Encoder와 Context Encoder

Query Encoder:

- 사용자의 다중 턴 질문(q1, q2, q3)을 벡터 표현으로 변환.

- 모델이 각 질문의 문맥적 의미를 이해하고, 이를 임베딩(Embedding)으로 출력.

Context Encoder:

- 주어진 문맥(c1, c2, c3)을 벡터 표현으로 변환.

- 각 문맥의 내용을 요약하고, 질문과의 적합성을 평가할 수 있도록 임베딩 생성.

4. Contrastive Fine-Tuning (대조 학습)

- 대조 학습(Contrastive Learning)을 사용하여 질문 임베딩과 문맥 임베딩의 매칭 성능을 최적화.

- 작동 방식:

- E_q1: 질문의 임베딩(Encoded Queries).

- E_c1: 문맥의 임베딩(Encoded Contexts).

- 모델은 각 질문에 대해 올바른 문맥(pos)과 잘못된 문맥(neg)을 구분하도록 학습.

- 목표:

- 질문 임베딩(E_q)과 올바른 문맥 임베딩(E_c) 간의 유사성 점수를 높이고, 잘못된 문맥(neg)과의 점수는 낮춤.

구체적 과정:

- Positive Pair (긍정 쌍):

- 질문(q)과 올바른 문맥(c)이 매칭되었을 때의 임베딩.

- 모델은 이를 학습하여 두 임베딩 간의 유사성을 극대화.

- Negative Pair (부정 쌍):

- 질문(q)과 잘못된 문맥(c)이 매칭되었을 때의 임베딩.

- 모델은 이 경우의 유사성을 최소화.

5. Output

- Fine-Tuned Retriever:

- 학습이 완료된 검색 모델은 다중 턴 대화에서 사용자의 질문에 가장 적합한 문맥을 검색하는 데 최적화됨.

- 올바른 문맥과 질문 간의 관계를 효과적으로 이해하여 검색 정확도를 높임.

Figure의 핵심 요약

- 구성 요소:

- 다중 턴 질문(q1, q2, q3)과 대응하는 문맥(c1, c2, c3).

- 질문과 문맥을 각각 인코딩하는 Query Encoder와 Context Encoder.

- Contrastive Fine-Tuning:

- 질문과 올바른 문맥 간의 유사성을 학습하여 검색 정확도를 향상.

- 잘못된 문맥과의 관계는 학습을 통해 최소화.

- 목표:

- 다중 턴 대화에서 적절한 문맥을 검색하는 능력을 최적화.

- 대화의 문맥적 흐름을 반영한 고품질 검색 결과 제공.

추가적으로 궁금한 점이 있거나 더 알고 싶은 내용이 있다면 말씀해주세요!

그럼 이 Figure는 검색 성능을 어떻게 향상시켰는지 보여주는 그림이네?

맞습니다! 이 Figure는 검색 성능(Search Performance)을 어떻게 향상시켰는지 보여주는 구조를 시각화한 것입니다. 특히, 다중 턴 대화(Multi-Turn Dialogue)의 문맥을 효과적으로 활용하여, 질문과 올바른 문맥 간의 관계를 학습함으로써 검색 성능을 최적화하는 과정을 설명합니다.

Figure가 검색 성능 향상을 보여주는 방식

- 다중 턴 질문 활용:

- 사용자의 연속적인 질문(q1, q2, q3)을 Query Encoder로 인코딩하여, 문맥적 흐름(Contextual Flow)을 반영한 임베딩을 생성합니다.

- 이를 통해 단일 질문이 아닌 대화 문맥 전체를 반영한 검색이 가능해집니다.

- 대조 학습(Contrastive Learning):

- 모델이 각 질문에 대해 올바른 문맥(pos)과 잘못된 문맥(neg)을 구별할 수 있도록 학습합니다.

- 긍정 쌍(Positive Pair)과 부정 쌍(Negative Pair)을 사용하여, 질문과 올바른 문맥 간의 유사성은 높이고, 잘못된 문맥과의 유사성은 낮추는 방식으로 검색의 정확도를 향상시킵니다.

- 문맥 적합성 강화:

- Context Encoder를 통해 각 문맥(c1, c2, c3)을 질문과 비교 가능한 형태로 임베딩합니다.

- 질문과 문맥 간의 유사성 계산을 최적화하여, 다중 턴 대화에서도 올바른 문맥을 정확히 검색할 수 있습니다.

- 다중 턴 대화의 문맥 추적:

- Figure는 단순히 개별 질문과 문맥을 매칭하는 것이 아니라, 대화의 문맥적 흐름을 유지하면서 적합한 문맥을 찾는 과정을 보여줍니다.

- 이를 통해 다중 턴 대화에서도 사용자의 의도를 잘 반영한 검색 결과를 제공합니다.

검색 성능 향상 요소 요약

- 다중 턴 문맥 반영: 질문과 대화의 흐름을 결합하여 문맥적인 이해를 기반으로 검색.

- 대조 학습: 긍정 쌍과 부정 쌍을 학습하여 질문과 문맥의 매칭 정확도를 개선.

- 문맥 인코딩 최적화: Context Encoder를 통해 질문과 문맥 간의 관계를 더 효과적으로 표현.

- 올바른 문맥 검색: 올바른 문맥(pos)을 더 잘 검색하고, 잘못된 문맥(neg)은 배제함으로써 최적의 검색 결과를 제공.

따라서 이 Figure는 검색 모델이 다중 턴 대화의 복잡성을 반영하여 검색 성능을 어떻게 향상시켰는지를 잘 보여줍니다. 더 궁금한 점이 있거나 세부적으로 알고 싶은 부분이 있다면 말씀해주세요!

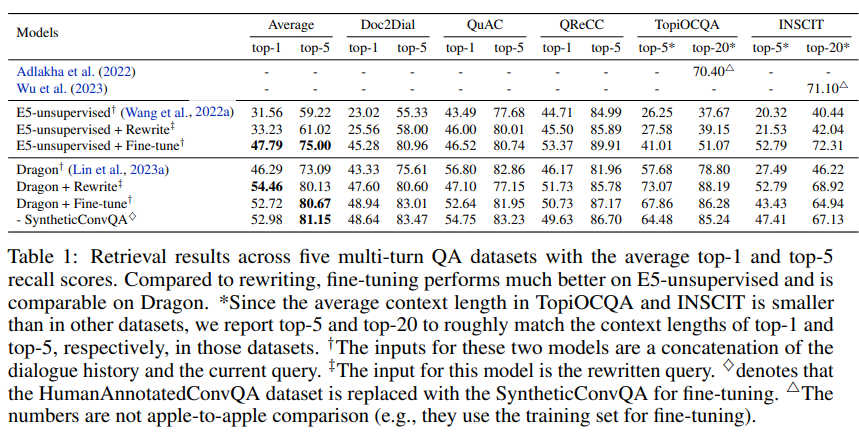

Table 1: Retrieval Results across Five Multi-Turn QA Datasets

이 표는 다중 턴 질문응답(Multi-Turn QA)에서 검색 모델의 Top-1 Recall 및 Top-5 Recall 점수를 비교한 결과를 보여줍니다. 다섯 가지 QA 데이터셋에서의 검색 성능을 분석하며, Fine-Tuning 및 Query Rewriting 방법의 성능을 비교하고 있습니다.

1. 주요 용어

- Top-1 Recall: 검색된 문맥 중 가장 상위에 위치한 문맥이 정답인 경우의 비율.

- Top-5 Recall: 상위 5개의 검색 문맥 중 하나라도 정답인 경우의 비율.

- Top-20: 일부 데이터셋(TopiOCQA, INSCIT)에서는 문맥 길이가 짧아 상위 20개까지 고려한 경우.

- Fine-Tuning: 모델을 특정 데이터셋으로 미세 조정하여 성능을 높이는 방법.

- Query Rewriting: 질문을 문맥 독립적인 형태로 변환한 후 검색하는 방법.

2. 결과 요약

모델 비교

- E5-unsupervised:

- Fine-Tuning 없이 학습된 모델.

- 평균 Top-1 Recall: 31.56%, 평균 Top-5 Recall: 59.22%로 가장 낮은 성능.

- E5-unsupervised + Rewrite:

- 쿼리 재작성(Query Rewriting)을 추가하여 검색 성능이 소폭 향상.

- 평균 Top-1 Recall: 33.23%, 평균 Top-5 Recall: 61.02%.

- E5-unsupervised + Fine-Tune:

- Fine-Tuning을 적용하여 성능이 크게 향상.

- 평균 Top-1 Recall: 47.79%, 평균 Top-5 Recall: 75.00%로 E5 계열 중 가장 높은 성능.

- Dragon 모델 (기본):

- Dragon 모델은 E5-unsupervised보다 성능이 높음.

- 평균 Top-1 Recall: 46.29%, 평균 Top-5 Recall: 73.09%.

- Dragon + Rewrite:

- Query Rewriting을 추가한 Dragon 모델.

- 평균 Top-1 Recall: 54.46%, 평균 Top-5 Recall: 80.13%로 쿼리 재작성이 성능 향상에 기여.

- Dragon + Fine-Tune:

- Fine-Tuning을 적용한 Dragon 모델.

- 평균 Top-1 Recall: 52.72%, 평균 Top-5 Recall: 80.67%로 Query Rewriting과 비슷한 성능.

- Dragon + SyntheticConvQA:

- 합성 데이터를 Fine-Tuning에 사용한 Dragon 모델.

- 평균 Top-1 Recall: 52.98%, 평균 Top-5 Recall: 81.48%로 가장 높은 성능.

데이터셋별 성능

- Doc2Dial:

- 문서 기반 대화형 QA 데이터셋.

- 모든 모델에서 Top-1 및 Top-5 Recall 점수가 비슷하게 나타나며, Dragon + Fine-Tune이 최고 성능.

- QuAC:

- Wikipedia 기반 다중 턴 QA 데이터셋.

- Dragon + Fine-Tune과 Dragon + SyntheticConvQA가 우수한 성능.

- QReCC:

- 열린 도메인 대화 QA 데이터셋.

- Dragon + SyntheticConvQA가 **Top-5 Recall 91.61%**로 가장 높은 성능.

- TopiOCQA:

- 문맥 길이가 짧아 Top-20 Recall로 측정.

- Dragon + SyntheticConvQA가 최고 성능.

- INSCIT:

- 정보 명확화를 요구하는 QA 데이터셋.

- Dragon + SyntheticConvQA가 Top-20 기준으로 가장 높은 성능(71.10%).

3. 주요 해석

- Fine-Tuning의 중요성:

- Fine-Tuning은 Query Rewriting보다 더 일관되게 높은 성능을 보여줌.

- 예: E5-unsupervised + Fine-Tune은 E5-unsupervised + Rewrite보다 평균적으로 높은 성능.

- Dragon 모델의 성능:

- Dragon 모델은 기본적으로 높은 성능을 제공하며, Fine-Tuning 또는 Query Rewriting을 통해 추가적인 성능 향상이 가능.

- SyntheticConvQA 데이터셋의 효과:

- SyntheticConvQA 데이터를 Fine-Tuning에 사용했을 때, 모든 데이터셋에서 검색 성능이 최고치를 기록.

- 이는 고품질 합성 데이터가 검색 성능 향상에 기여할 수 있음을 입증.

- Query Rewriting vs Fine-Tuning:

- Query Rewriting은 Dragon 모델에서 성능을 높이는 데 기여했으나, Fine-Tuning만큼 일관된 성능 향상을 보이지는 않음.

4. 결론

- Dragon + SyntheticConvQA가 가장 높은 성능을 보여주며, 합성 데이터를 활용한 Fine-Tuning의 중요성을 강조.

- Fine-Tuning은 모든 모델에서 검색 성능을 크게 향상시키는 효과적인 접근법.

- 다중 턴 대화의 복잡한 문맥 처리에서 Query Rewriting보다 Fine-Tuning이 더 우수한 결과를 보임.

추가적으로 궁금한 부분이나 더 자세히 알고 싶은 점이 있다면 말씀해주세요!

1. E5 모델

E5란?

- E5(Embedding for Everywhere)는 문맥적 의미를 기반으로 다양한 태스크(예: 검색, 문서 임베딩, 질문응답 등)에 활용 가능한 언어 모델입니다.

- 특히 Dense Retriever로 활용되며, 기본적으로 Unsupervised Learning(비지도 학습)을 통해 문서 및 질문 임베딩을 생성합니다.

- 특징:

- Fine-Tuning 없이도 강력한 기본 성능 제공.

- 검색 및 임베딩 중심의 태스크에서 높은 효율성.

E5-unsupervised:

- 비지도 학습으로만 학습된 모델로, Fine-Tuning 없이 사용됩니다.

- 문서 및 질문의 임베딩을 생성하지만, 특정 태스크에 최적화되지 않아 상대적으로 낮은 성능을 보입니다.

E5-unsupervised + Fine-Tune:

- 다중 턴 대화 QA 데이터셋으로 Fine-Tuning을 적용하여 특정 QA 태스크에 최적화된 성능을 제공합니다.

- HumanAnnotatedConvQA 또는 SyntheticConvQA 데이터셋을 사용하여 Fine-Tuning을 진행.

- Fine-Tuning을 통해 질문과 문맥 간의 매칭 성능이 크게 향상됩니다.

2. Dragon 모델

Dragon이란?

- Dragon은 Dense Retriever 기반 모델로, 다중 턴 대화형 QA 및 검색 태스크에 특화된 모델입니다.

- 주요 설계 목표는 문맥의 흐름(Contextual Flow)을 효과적으로 반영하여 질문과 관련된 문서를 정확히 검색하는 것입니다.

특징:

- Query Encoder와 Context Encoder를 활용하여 질문과 문맥을 독립적으로 인코딩.

- Contrastive Learning (대조 학습):

- 질문과 올바른 문맥(Positive Pair) 간의 유사성을 극대화.

- 질문과 잘못된 문맥(Negative Pair) 간의 유사성을 최소화.

- Dragon 모델은 Fine-Tuning 및 Query Rewriting을 통해 성능을 향상시킬 수 있음.

Dragon + Fine-Tune:

- Dragon 모델에 Fine-Tuning을 적용하여 특정 데이터셋에 맞게 최적화.

- HumanAnnotatedConvQA 또는 SyntheticConvQA를 사용하여 학습.

Dragon + Rewrite:

- Query Rewriting을 추가로 적용하여, 질문을 문맥 독립적인 형태로 변환한 후 검색.

- Dragon 모델에서 추가적인 성능 향상을 가져옴.

Dragon + SyntheticConvQA:

- SyntheticConvQA 데이터셋을 사용하여 Fine-Tuning.

- 고품질 합성 데이터가 모델의 검색 성능 향상에 기여.

3. 각 Fine-Tuning의 학습 방식

Fine-Tuning의 목적:

- 모델이 특정 도메인 또는 태스크에 최적화되도록 학습.

- 질문과 문맥의 관계를 정확히 이해하고, 다중 턴 대화에서도 적절한 문맥을 검색하도록 성능을 강화.

Fine-Tuning 데이터셋:

- HumanAnnotatedConvQA:

- 사람이 주석한 고품질 대화형 QA 데이터.

- 약 7,000개의 문서에서 다중 턴 대화를 생성.

- 무응답(Unanswerable) 시나리오를 포함하여, 모델이 답할 수 없는 질문에 "답할 수 없음"을 명확히 생성하도록 학습.

- SyntheticConvQA:

- GPT-3.5-Turbo를 사용해 생성된 합성 대화형 QA 데이터.

- 약 7,000개의 다중 턴 대화와 1,500개의 무응답 샘플 포함.

- 고품질의 합성 데이터로, HumanAnnotatedConvQA 데이터의 품질을 보완.

4. Query Rewriting이란?

- Query Rewriting은 질문을 문맥 독립적인 형태로 변환하여 검색 성능을 높이는 방법입니다.

- 예:

사용자 질문: "그들은 어떻게 광고하나요?" Query Rewriting: "Brandy Melville은 소셜 미디어를 사용하여 광고를 한다고 들었는데, 그들의 광고 방식은 무엇인가요?" - 질문을 재작성하여 검색 엔진이 문맥 의존성을 배제하고 독립적인 질문으로 정확히 검색할 수 있도록 도와줍니다.

5. E5와 Dragon의 비교

| 특징 | E5 | Dragon |

| 기본 학습 방식 | Unsupervised (비지도 학습) | Dense Retriever 설계 + 대조 학습 |

| Fine-Tuning 적용 | Fine-Tuning 시 높은 성능 | Fine-Tuning 및 Query Rewriting으로 최적화 가능 |

| 질문-문맥 관계 학습 | 문맥 이해는 제한적 | Contrastive Learning으로 질문-문맥 관계 강화 |

| 추가 기술 | Fine-Tuning을 통해 성능 향상 | Query Rewriting으로 추가 성능 향상 가능 |

6. 결론

- E5: 비지도 학습 모델로 시작하지만, Fine-Tuning을 통해 QA 태스크에서 높은 성능을 발휘.

- Dragon: 문맥 흐름과 질문-문맥 관계를 효과적으로 학습하며, Fine-Tuning 및 Query Rewriting으로 추가 성능 향상.

- Fine-Tuning은 HumanAnnotatedConvQA와 SyntheticConvQA 데이터셋을 활용하여 모델 성능을 특정 QA 태스크에 최적화합니다.

궁금한 점이나 더 알고 싶은 부분이 있다면 말씀해주세요!

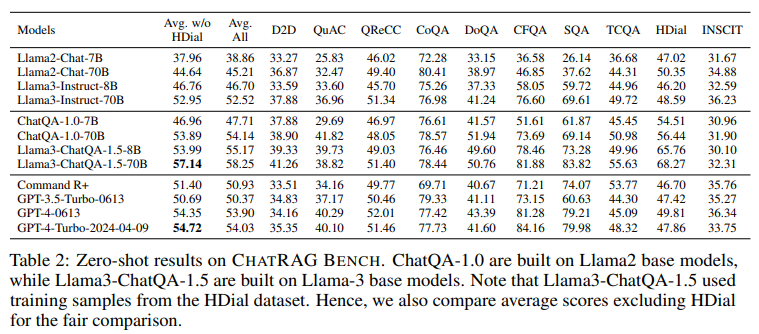

Table 2: Zero-shot Results on CHATRAG BENCH

이 표는 CHATRAG BENCH에서 다양한 모델의 Zero-shot 성능을 비교한 결과를 보여줍니다. CHATRAG BENCH는 다중 QA 데이터셋으로 구성된 평가 벤치마크로, 각 모델의 평균 성능과 세부 데이터셋별 성능을 제공합니다.

1. 주요 정보

평가된 모델

- Llama2 기반 모델:

- Llama2-Chat-7B, 70B, Instruct-8B, 70B 모델.

- ChatQA-1.0-7B, ChatQA-1.0-70B.

- Llama3 기반 모델:

- Llama3-Instruct-8B, 70B 모델.

- Llama3-ChatQA-1.5-8B, 70B.

- Command R+ 모델:

- 상용 Command R+ 모델의 성능 비교.

- GPT 모델:

- GPT-3.5-Turbo-0613, GPT-4-0613, GPT-4-Turbo-2024-04-09.

데이터셋

- CHATRAG BENCH는 다양한 QA 태스크를 평가하기 위해 10개의 데이터셋으로 구성됩니다:

- D2D (Doc2Dial): 문서 기반 QA.

- QuAC: 다중 턴 대화 QA.

- QReCC: 열린 도메인 대화 QA.

- CoQA: 짧은 문서 기반 QA.

- DoQA: FAQ 기반 QA.

- CFQA: 재무 관련 QA.

- SQA: 테이블 기반 QA.

- TCQA: 계산 중심 QA.

- HDial (HybriDial): 텍스트 및 테이블 혼합 QA.

- INSCIT: 정보 명확화 QA.

평균 점수

- Avg. w/o HDial: HybriDial 데이터셋을 제외한 평균 점수.

- Avg. All: 모든 데이터셋을 포함한 평균 점수.

2. 결과 분석

Llama2 기반 모델

- Llama2-Instruct-70B:

- Llama2 계열 중 가장 높은 평균 점수 기록 (Avg. All: 52.95).

- 하지만 ChatQA-1.0-70B보다 성능이 낮음.

- ChatQA-1.0 모델:

- ChatQA-1.0-70B:

- Llama2 기반에서 최고 성능을 기록 (Avg. All: 53.89).

- GPT-3.5-Turbo보다 우수하며 GPT-4에 근접한 성능.

- ChatQA-1.0-7B:

- 소형 모델에서도 강력한 성능 (Avg. All: 46.96).

- ChatQA-1.0-70B:

Llama3 기반 모델

- Llama3-ChatQA-1.5-70B:

- 평균 점수 57.14 (Avg. All)로 GPT-4-Turbo-2024-04-09 (54.72)을 초과.

- CHATRAG BENCH에서 최고 성능.

- Llama3-ChatQA-1.5-8B:

- 소형 모델(8B)에서도 GPT-3.5-Turbo와 유사한 성능 기록.

GPT 계열 모델

- GPT-3.5-Turbo-0613:

- 평균 점수 50.69 (Avg. All)로 ChatQA-1.0-70B와 Llama3-ChatQA-1.5-8B에 비해 낮은 성능.

- GPT-4-0613:

- 평균 점수 54.11 (Avg. All).

- ChatQA-1.0-70B보다 우수하지만 Llama3-ChatQA-1.5-70B에는 미치지 못함.

- GPT-4-Turbo-2024-04-09:

- 평균 점수 54.72 (Avg. All)로 GPT 계열 중 최고 성능.

- 하지만 Llama3-ChatQA-1.5-70B에 약간 뒤처짐.

특이 사항: HybriDial 데이터셋

- Llama3-ChatQA-1.5 모델은 HDial 데이터셋에서 학습 데이터를 사용.

- 공정한 비교를 위해 Avg. w/o HDial 점수를 추가로 제공.

- 결과:

- HDial을 제외한 평균 점수에서도 Llama3-ChatQA-1.5-70B는 여전히 GPT-4-Turbo를 초과.

3. 주요 결과 요약

- ChatQA 모델:

- Llama2-ChatQA-1.0과 Llama3-ChatQA-1.5는 GPT-4 수준의 성능을 달성하거나 이를 초과.

- 특히 Llama3-ChatQA-1.5-70B는 모든 모델 중 최고 성능을 기록.

- 소형 모델의 가능성:

- ChatQA-1.0-7B와 Llama3-ChatQA-1.5-8B는 작은 모델에서도 높은 성능을 발휘.

- GPT-3.5-Turbo와 유사한 수준.

- GPT 모델과의 비교:

- GPT-4-Turbo는 평균 점수에서 높은 성능을 보였으나, Llama3-ChatQA-1.5-70B에 약간 뒤처짐.

- HybriDial 데이터셋:

- HDial 학습 데이터를 포함한 모델(Llama3-ChatQA-1.5)이 HybriDial 관련 태스크에서 높은 성능을 보임.

4. 결론

- ChatQA는 오픈소스 기반으로 상용 GPT 모델과 동등하거나 이를 초과하는 성능을 보여줍니다.

- Llama3-ChatQA-1.5-70B는 특히 GPT-4-Turbo를 능가하며, 소형 모델에서도 경쟁력 있는 성능을 발휘합니다.

- HDial 학습 데이터를 사용한 경우에도 공정한 비교를 위해 별도의 점수를 제공하여 결과의 신뢰성을 높였습니다.

추가로 궁금한 점이나 특정 데이터셋에 대한 세부 분석이 필요하다면 말씀해주세요!

Table 3: Ablation Studies on ChatQA Training

이 표는 ChatQA-1.0-70B 모델의 학습 과정에서 다양한 요소를 제거하거나 대체했을 때의 성능 변화를 분석한 결과를 보여줍니다. 이를 통해 ChatQA 모델의 구성 요소 중 어떤 부분이 성능에 중요한 기여를 했는지 확인할 수 있습니다.

1. 주요 정보

Baseline Model

- ChatQA-1.0-70B:

- ChatQA의 기본 모델로, 모든 구성 요소를 포함하여 학습된 상태.

- 평균 점수(Avg.): 54.14로 가장 높은 성능.

실험 조건

표에서 다양한 구성 요소를 제거하거나 변경하여 모델의 성능에 미치는 영향을 평가했습니다. 각 조건은 다음과 같습니다:

- SyntheticConvQA (◊):

- HumanAnnotatedConvQA 데이터를 SyntheticConvQA로 대체.

- 평균 점수: 39.19 (Baseline 대비 성능 감소).

- w/o stage-1 (†):

- Stage-1 Supervised Fine-Tuning (SFT)을 제거.

- 평균 점수: 52.18 (Baseline 대비 약간 감소).

- w/o stage-2 (‡):

- Stage-2 Context-Enhanced Instruction Tuning을 제거.

- 평균 점수: 43.22 (Baseline 대비 큰 성능 감소).

- w/o single-turn (*):

- Stage-2 학습 데이터에서 단일 턴 QA 데이터셋을 제거.

- 평균 점수: 52.25 (Baseline 대비 약간 감소).

- w/o ConvQAData (‡):

- 대화형 QA 데이터셋(HumanAnnotatedConvQA 또는 SyntheticConvQA)을 제거.

- 평균 점수: 38.97 (Baseline 대비 큰 성능 감소).

2. 데이터셋별 성능 분석

D2D (Doc2Dial):

- 대화형 QA 데이터 제거 시 성능이 크게 감소 (28.19).

- Stage-2를 제거한 경우에도 성능 감소 (32.22).

QReCC:

- 열린 도메인 대화 QA 데이터셋으로, 모든 조건에서 성능 감소.

- 특히 ConvQAData 제거 시 가장 큰 하락 (28.19).

CoQA:

- 짧은 문서 기반 QA로, ConvQAData 제거 시 성능이 가장 큰 폭으로 하락 (41.68).

HDial (HybriDial):

- Stage-2 제거 시 성능이 크게 감소 (55.56 → 38.20).

- 단일 턴 QA 데이터 제거의 영향은 상대적으로 적음.

3. 결과 분석

- 대화형 QA 데이터 (HumanAnnotatedConvQA 또는 SyntheticConvQA)의 중요성:

- ConvQAData를 제거하면 성능이 가장 큰 폭으로 하락 (38.97).

- 이는 다중 턴 대화에서 문맥적 흐름을 이해하고 처리하는 능력에 ConvQAData가 핵심적인 역할을 한다는 것을 보여줍니다.

- Stage-2 Context-Enhanced Instruction Tuning의 중요성:

- Stage-2를 제거한 경우 평균 점수는 43.22로 큰 폭의 성능 감소를 보임.

- 이는 문맥을 강화한 학습 단계가 QA 성능에 중요한 기여를 한다는 것을 입증합니다.

- 단일 턴 QA 데이터의 기여:

- 단일 턴 데이터를 제거한 경우 평균 점수는 52.25로 약간 감소.

- 이는 단일 턴 데이터가 다중 턴 질문응답 성능에도 일부 기여하지만, 주요 영향 요소는 아님을 보여줍니다.

- SyntheticConvQA 대체의 영향:

- SyntheticConvQA는 HumanAnnotatedConvQA를 대체했을 때 성능이 크게 하락 (39.19).

- 이는 HumanAnnotatedConvQA가 더 높은 품질의 데이터를 제공하며, 모델 성능에 중요한 역할을 한다는 것을 시사합니다.

- Stage-1의 상대적 중요성:

- Stage-1을 제거한 경우에도 평균 점수는 52.18으로, Stage-2를 제거했을 때보다 성능 감소가 적음.

- 이는 Stage-2가 QA 태스크에서 더 큰 기여를 한다는 것을 보여줍니다.

4. 결론

- 대화형 QA 데이터셋과 Stage-2 Context-Enhanced Instruction Tuning이 ChatQA 모델 성능의 핵심 요소임.

- 단일 턴 QA 데이터는 보조적인 역할을 하지만, 다중 턴 QA 성능에 큰 영향을 미치지는 않음.

- SyntheticConvQA는 HumanAnnotatedConvQA를 대체할 수 있지만, HumanAnnotatedConvQA의 품질이 더 뛰어남.

- Stage-1과 Stage-2를 함께 사용하면 QA 성능이 최적화되며, 특히 Stage-2의 기여가 더 큼.

추가로 궁금한 점이나 자세히 알고 싶은 부분이 있다면 말씀해주세요!

Table 4: Human Evaluation Comparing ChatQA-1.0-70B to GPT-4-0613

이 표는 ChatQA-1.0-70B와 GPT-4-0613의 Human Evaluation(A/B Testing) 결과를 나타냅니다. 두 모델의 응답을 비교하여 어느 모델이 더 우수한지, 또는 동등한 품질을 보였는지를 평가한 데이터입니다.

1. 주요 정보

평가 기준

- Ours Win: ChatQA-1.0-70B의 응답이 더 나은 경우.

- Tie: 두 모델의 응답 품질이 동등한 경우.

- GPT-4 Win: GPT-4-0613의 응답이 더 나은 경우.

평가 데이터셋

- CHATRAG BENCH의 10개 데이터셋을 기반으로 평가:

- Doc2Dial: 문서 기반 QA.

- QuAC: 다중 턴 대화 QA.

- QReCC: 열린 도메인 대화 QA.

- CoQA: 짧은 문서 기반 QA.

- DoQA: FAQ 기반 QA.

- ConvFinQA: 재무 관련 QA.

- SQA: 테이블 기반 QA.

- TopiOCQA: 주제 중심 대화 QA.

- HybriDial: 텍스트 및 테이블 혼합 QA.

- INSCIT: 정보 명확화 QA.

2. 결과 분석

전체 평균

- ChatQA Win: 13.81%

- Tie: 69.09%

- GPT-4 Win: 17.10%

- 대부분의 경우(69.09%) 두 모델의 응답 품질이 동등하다고 평가됨.

- GPT-4가 ChatQA보다 약간 높은 승률(17.10% vs. 13.81%)을 기록.

데이터셋별 성능

- Doc2Dial:

- ChatQA: 14.29% 승률.

- GPT-4: 17.71% 승률.

- 동등한 품질(Tie)이 68%로 가장 많음.

- QuAC:

- ChatQA: 11.67% 승률.

- GPT-4: 15.00% 승률.

- 대부분 동등(Tie)으로 평가(73.33%).

- QReCC:

- ChatQA: 11.11% 승률.

- GPT-4: 11.67% 승률.

- 두 모델 모두 동등하게 평가되는 경우가 매우 높음(77.22%).

- CoQA:

- ChatQA: 7.78% 승률.

- GPT-4: 12.22% 승률.

- 동등(Tie): 80.00%.

- DoQA:

- ChatQA: 22.78% 승률 (가장 높은 승률 기록).

- GPT-4: 19.44% 승률.

- 이 데이터셋에서 ChatQA가 상대적으로 우수한 성능을 보임.

- ConvFinQA:

- ChatQA: 16.67% 승률.

- GPT-4: 15.55% 승률.

- 동등(Tie)이 67.78%로 가장 많음.

- SQA:

- ChatQA: 11.11% 승률.

- GPT-4: 27.22% 승률.

- GPT-4가 압도적으로 우수.

- TopiOCQA:

- ChatQA: 19.31% 승률.

- GPT-4: 20.00% 승률.

- 동등(Tie)이 60.69%로 가장 많음.

- HybriDial:

- ChatQA: 7.78% 승률.

- GPT-4: 13.89% 승률.

- 대부분 동등(Tie)으로 평가(78.33%).

- INSCIT:

- ChatQA: 15.56% 승률.

- GPT-4: 18.33% 승률.

- 동등(Tie)이 66.11%.

3. 결과 해석

- 동등한 품질:

- 평균적으로 69.09%의 경우에서 두 모델의 응답 품질이 동등(Tie)하다고 평가됨.

- 이는 ChatQA와 GPT-4의 응답 품질이 대체로 비슷하다는 것을 시사.

- GPT-4의 우위:

- GPT-4는 17.10%의 승률로, ChatQA(13.81%)보다 약간 더 우수.

- 특히 SQA(27.22%)와 HybriDial에서 GPT-4가 더 나은 성능을 보임.

- ChatQA의 강점:

- ChatQA는 DoQA 데이터셋에서 22.78%로 GPT-4(19.44%)보다 높은 승률.

- 특정 도메인(FAQ 기반 QA)에서 우수한 성능을 발휘.

- 데이터셋에 따른 변동성:

- 데이터셋에 따라 두 모델의 성능 차이가 다소 상이하며, 일부 데이터셋에서는 ChatQA가 경쟁력을 보임.

4. 결론

- ChatQA-1.0-70B는 GPT-4와 대체로 비슷한 성능을 발휘하며, 일부 데이터셋에서는 우위를 점함.

- GPT-4는 약간 더 높은 평균 승률(17.10%)을 기록했지만, 차이는 크지 않음.

- Human Evaluation 결과는 ChatQA가 상용 GPT 모델과 동등한 수준에서 경쟁할 수 있음을 입증.

추가로 궁금한 점이나 특정 데이터셋에 대한 분석이 필요하면 말씀해주세요!

Table 5: Fine-Grained Studies on Average Scores of Different Dataset Types

이 표는 ChatQA-1.0-70B, Llama3-ChatQA-1.5 모델, 그리고 GPT 모델들이 다양한 데이터셋 유형에서 기록한 평균 점수를 세분화하여 비교한 결과를 보여줍니다. 데이터셋 유형별 성능을 평가하여, 각 모델이 특정 데이터 유형에서 어떤 강점을 가지는지 분석합니다.

1. 주요 용어

데이터셋 유형

- Avg-text:

- 텍스트만 포함된 문서를 사용하는 데이터셋.

- 예: Doc2Dial, QuAC, QReCC, CoQA, DoQA, TopiOCQA, INSCIT.

- Avg-table:

- 문서 내에 테이블이 포함된 데이터셋.

- 예: ConvFinQA, SQA, HybriDial.

- Avg-table w/o HDial:

- HybriDial 데이터셋을 제외한 테이블 기반 데이터셋의 평균 점수.

- 예: ConvFinQA, SQA.

- Avg-ret:

- 긴 문서를 검색(Retrieval)해야 하는 데이터셋.

- 예: Doc2Dial, QuAC, QReCC, TopiOCQA, INSCIT.

- Avg-nonret:

- 검색이 필요 없는 짧은 문서를 사용하는 데이터셋.

- 예: CoQA, DoQA, ConvFinQA, SQA, HybriDial.

2. 모델 비교

ChatQA-1.0-70B

- Avg-text: 48.88

- Avg-table: 66.42

- Avg-table w/o HDial: 71.42

- Avg-ret: 42.33

- Avg-nonret: 65.96

ChatQA-1.0-70B는 텍스트 기반 데이터와 테이블 기반 데이터셋 모두에서 안정적인 성능을 보이지만, 검색이 필요한 데이터셋(Avg-ret)에서는 상대적으로 낮은 점수를 기록합니다.

Llama3-ChatQA-1.5-8B

- Avg-text: 47.74

- Avg-table: 72.50

- Avg-table w/o HDial: 75.87

- Avg-ret: 41.63

- Avg-nonret: 68.71

소형 모델인 Llama3-ChatQA-1.5-8B는 테이블 기반 데이터셋(Avg-table)에서 상대적으로 우수한 성능을 발휘합니다.

Llama3-ChatQA-1.5-70B

- Avg-text: 49.79

- Avg-table: 77.99

- Avg-table w/o HDial: 82.85

- Avg-ret: 43.89

- Avg-nonret: 72.62

Llama3-ChatQA-1.5-70B는 모든 데이터 유형에서 최고의 성능을 기록하며, 특히 테이블 기반 데이터셋(Avg-table)에서 압도적인 성능을 보입니다.

GPT-3.5-Turbo-0613

- Avg-text: 46.07

- Avg-table: 60.40

- Avg-table w/o HDial: 66.40

- Avg-ret: 40.41

- Avg-nonret: 60.33

GPT-3.5-Turbo는 모든 데이터 유형에서 ChatQA 및 Llama3 모델보다 낮은 성능을 보입니다.

GPT-4 계열 모델

- GPT-4-0613:

- Avg-text: 46.96

- Avg-table: 70.10

- Avg-table w/o HDial: 80.25

- Avg-ret: 41.58

- Avg-nonret: 66.22

- GPT-4-Turbo-2024-04-09:

- Avg-text: 46.90

- Avg-table: 70.67

- Avg-table w/o HDial: 82.07

- Avg-ret: 41.80

- Avg-nonret: 66.27

GPT-4 계열은 텍스트 기반 데이터에서 안정적인 성능을 보이지만, 테이블 기반 데이터셋에서만 Llama3-ChatQA-1.5와 유사한 성능을 기록합니다.

3. 주요 해석

1. 텍스트 기반 데이터셋 (Avg-text)

- Llama3-ChatQA-1.5-70B가 최고 성능 (49.79)을 기록.

- GPT 계열 모델은 ChatQA 모델보다 낮은 점수를 기록.

2. 테이블 기반 데이터셋 (Avg-table)

- Llama3-ChatQA-1.5-70B는 77.99로 가장 높은 점수를 기록하며, GPT-4-Turbo를 능가.

- 소형 모델(Llama3-ChatQA-1.5-8B)도 테이블 데이터에서 우수한 성능을 발휘.

3. 검색 기반 데이터셋 (Avg-ret)

- 모든 모델에서 상대적으로 낮은 점수를 기록.

- Llama3-ChatQA-1.5-70B가 검색 기반 데이터에서 최고 성능 (43.89)을 보임.

4. 검색이 필요 없는 데이터셋 (Avg-nonret)

- Llama3-ChatQA-1.5-70B가 최고 성능 (72.62)을 기록.

- ChatQA-1.0-70B와 GPT 계열 모델 간의 성능 차이는 작음.

4. 결론

- Llama3-ChatQA-1.5-70B는 모든 데이터셋 유형에서 최고의 성능을 기록하며, 특히 테이블 기반 데이터와 검색이 필요 없는 데이터셋에서 우수.

- GPT-4 계열 모델은 안정적인 성능을 보이지만, ChatQA 및 Llama3 모델에 비해 전반적으로 낮은 점수.

- ChatQA-1.0-70B는 검색 태스크에서 더 많은 개선 가능성을 보여줌.

추가로 궁금한 점이나 더 자세히 알고 싶은 부분이 있으면 말씀해주세요!

Table 6: Ablation Study on Using “Top-5” Retrieved Chunks

이 표는 ChatQA-1.0-70B 모델의 Stage-2 Instruction Tuning에서 "Top-5 Retrieved Chunks"를 문맥으로 사용했을 때 성능 변화를 분석한 결과를 보여줍니다.

1. 주요 정보

모델 비교

- ChatQA-1.0-70B:

- Stage-2에서 가장 적합한 문맥을 하나만 사용하는 기본 설정.

- 평균 점수:

- ChatRAG: 54.14

- Avg-ret (검색 데이터셋): 42.33

- Avg-nonret (비검색 데이터셋): 65.96

- w/ “Top-5” chunks:

- Top-5로 검색된 문맥(chunks)을 모두 문맥으로 활용.

- 평균 점수:

- ChatRAG: 54.04

- Avg-ret (검색 데이터셋): 42.91

- Avg-nonret (비검색 데이터셋): 65.16

평가 데이터셋

- ChatRAG: CHATRAG BENCH 전체 평균 점수.

- Avg-ret: 검색이 필요한 데이터셋 (예: Doc2Dial, QuAC 등).

- Avg-nonret: 검색이 필요 없는 데이터셋 (예: CoQA, DoQA 등).

2. 결과 분석

1. ChatRAG 전체 성능

- ChatQA-1.0-70B:

- Top-1 문맥만 사용했을 때 평균 점수: 54.14.

- w/ “Top-5” chunks:

- Top-5 문맥을 활용했을 때 평균 점수: 54.04.

- 성능 차이는 미미하며, 약간의 감소를 보임.

2. 검색 데이터셋 (Avg-ret)

- ChatQA-1.0-70B:

- Top-1 문맥 사용: 42.33.

- w/ “Top-5” chunks:

- Top-5 문맥 사용: 42.91.

- 검색 데이터셋에서는 약간의 성능 향상을 보임.

3. 비검색 데이터셋 (Avg-nonret)

- ChatQA-1.0-70B:

- Top-1 문맥 사용: 65.96.

- w/ “Top-5” chunks:

- Top-5 문맥 사용: 65.16.

- 비검색 데이터셋에서는 성능이 약간 감소.

3. 해석

- Top-5 문맥 사용의 효과

- 검색 데이터셋에서는 Top-5 문맥 사용이 약간의 성능 향상을 보임 (42.33 → 42.91).

- 이는 검색에서 추가적인 문맥을 제공함으로써 질문과 더 잘 연결되는 정보를 포함할 가능성을 높였기 때문.

- 비검색 데이터셋에서의 성능 감소

- 비검색 데이터셋에서는 Top-5 문맥 사용이 성능 감소를 초래함 (65.96 → 65.16).

- 불필요한 추가 문맥이 모델의 학습 및 추론 과정에서 혼란을 야기했을 가능성이 있음.

- 전체 평균 성능

- ChatRAG 전체 성능은 Top-1 문맥 사용과 비교했을 때 큰 차이가 없음 (54.14 → 54.04).

- 이는 Top-5 문맥 사용이 모델의 전반적인 학습에 큰 기여를 하지 않았음을 의미.

4. 결론

- 검색 데이터셋(Avg-ret)에서는 Top-5 문맥 사용이 약간의 성능 향상을 보였지만, 비검색 데이터셋(Avg-nonret)에서는 성능 감소를 초래.

- ChatQA-1.0-70B는 Top-1 문맥만 사용했을 때 전반적으로 더 안정적인 성능을 보임.

- Top-5 문맥 사용이 검색 성능을 약간 높이는 데 기여할 수 있지만, 불필요한 문맥이 혼란을 줄 가능성도 존재.

추가로 궁금한 점이 있거나 더 자세히 알고 싶은 부분이 있다면 말씀해주세요!

Table 7: Ablation Studies on Input Context Across Datasets that Require Retrieval

이 표는 문맥(Context)의 수, 순서, 그리고 검색 방식을 변경했을 때 ChatQA-1.0-70B 모델의 성능 변화를 분석한 결과를 나타냅니다. 이는 검색 기반 데이터셋에서 입력 문맥의 구성이 모델 성능에 어떤 영향을 미치는지 보여줍니다.

1. 주요 정보

Baseline Model

- ChatQA-1.0-70B:

- 기본 설정으로 Dragon + Fine-Tune을 사용하여 검색된 Top-5 문맥을 순서대로 정렬하여 입력으로 사용.

- 평균 점수 (Avg.): 42.31.

실험 조건

- # of ctx: top-3:

- Top-5 대신 Top-3 문맥만 입력으로 사용.

- 평균 점수: 41.91 (기본 설정 대비 소폭 감소).

- # of ctx: top-10:

- Top-5 대신 Top-10 문맥을 입력으로 사용.

- 평균 점수: 40.71 (기본 설정 대비 성능 하락).

- 과도한 문맥이 모델의 혼란을 야기한 것으로 추정.

- Context Ordering:

- 문맥의 정렬 방식을 변경:

- Reverse Ordering: 검색된 문맥의 순서를 뒤집음.

- 평균 점수: 42.48 (기본 설정 대비 약간 증가).

- Swing Ordering: 앞뒤를 번갈아 배치.

- 평균 점수: 42.30 (기본 설정과 비슷).

- Random Ordering: 문맥 순서를 무작위로 배치.

- 평균 점수: 42.01 (기본 설정 대비 소폭 감소).

- Reverse Ordering: 검색된 문맥의 순서를 뒤집음.

- 문맥의 정렬 방식을 변경:

- Dragon Retrieval:

- Dragon + Fine-Tune 대신 원본 Dragon Retrieval 방식을 사용.

- 평균 점수: 40.50 (기본 설정 대비 성능 하락).

2. 데이터셋별 성능 분석

- Doc2Dial:

- 기본 설정: 39.19.

- Reverse Ordering이 가장 높은 점수 (39.08)를 기록.

- QuAC:

- 기본 설정: 38.33.

- Random Ordering이 가장 낮은 성능 (38.28)을 기록.

- QReCC:

- 기본 설정: 48.73.

- Top-3 문맥 사용 시 가장 높은 성능 (48.94).

- TopiOCQA:

- 기본 설정: 51.30.

- Reverse Ordering이 가장 높은 성능 (51.16).

- INSCIT:

- 기본 설정: 33.98.

- Random Ordering과 Top-10 문맥 사용 시 가장 낮은 성능 (32.99, 32.53).

3. 주요 해석

1. 문맥의 수 (# of ctx)

- Top-3 문맥 사용:

- 성능이 기본 설정과 비슷하거나 약간 낮음 (41.91).

- 이는 적은 수의 문맥이 오히려 과도한 혼란을 줄이는데 기여할 수 있음을 시사.

- Top-10 문맥 사용:

- 성능이 크게 하락 (40.71).

- 과도한 문맥이 모델의 혼란을 초래하며, 불필요한 정보가 모델의 성능을 저하시킴.

2. 문맥의 순서 (Context Ordering)

- Reverse Ordering:

- 기본 설정보다 약간 높은 성능 (42.48).

- 이는 마지막으로 검색된 문맥이 더 중요한 정보를 포함할 가능성을 나타냄.

- Swing Ordering:

- 성능 변화가 거의 없음 (42.30).

- Random Ordering:

- 성능이 가장 낮음 (42.01).

- 문맥 순서의 일관성이 모델 성능에 중요한 역할을 함.

3. Retrieval 방식

- Dragon Retrieval:

- Fine-Tuning을 적용하지 않은 Dragon Retrieval 방식을 사용했을 때 성능이 크게 감소 (40.50).

- Fine-Tuning이 검색 품질을 향상시키는 데 중요한 역할을 함.

4. 결론

- 문맥의 수:

- 적정한 문맥 수(Top-5)가 모델 성능에 가장 적합.

- 과도한 문맥(Top-10)은 성능을 저하시킴.

- 문맥의 순서:

- Reverse Ordering이 기본 설정보다 약간 더 높은 성능을 기록.

- 문맥 순서를 유지하는 것이 중요한 요인.

- Retrieval 방식:

- Fine-Tuning된 Dragon Retrieval이 성능을 크게 향상.

- Fine-Tuning 없는 Dragon Retrieval은 성능 저하를 초래.

추가로 궁금한 점이 있다면 말씀해주세요!

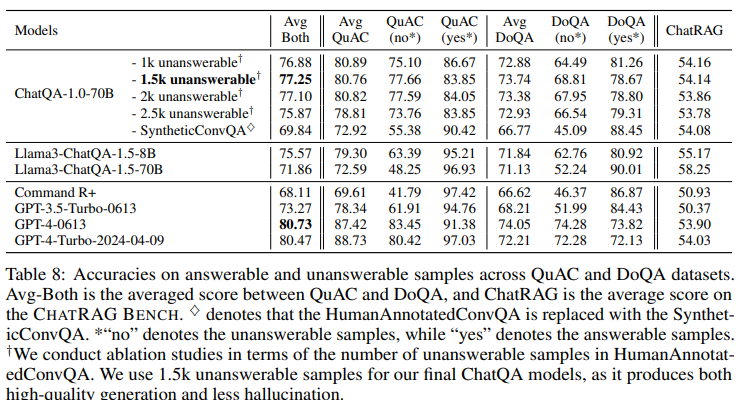

Table 8: Accuracies on Answerable and Unanswerable Samples Across QuAC and DoQA Datasets

이 표는 ChatQA-1.0-70B 모델과 비교 모델들이 QuAC 및 DoQA 데이터셋에서 응답 가능한 샘플(Answerable)과 응답 불가능한 샘플(Unanswerable)에 대해 기록한 정확도를 보여줍니다. 또한, ChatQA 모델에서 Unanswerable 데이터의 수가 모델 성능에 미치는 영향을 분석합니다.

1. 주요 정보

평가된 데이터셋

- QuAC:

- "no*": 응답 불가능(Unanswerable) 샘플.

- "yes*": 응답 가능한(Answerable) 샘플.

- DoQA:

- "no*": 응답 불가능(Unanswerable) 샘플.

- "yes*": 응답 가능한(Answerable) 샘플.

- ChatRAG:

- CHATRAG BENCH의 평균 점수.

평가된 모델

- ChatQA-1.0-70B:

- 응답 불가능 샘플 수를 1k, 1.5k, 2k, 2.5k로 조정하며 성능 변화를 평가.

- Llama3 기반 모델:

- Llama3-ChatQA-1.5-8B, 70B.

- 상용 및 GPT 모델:

- Command R+, GPT-3.5-Turbo-0613, GPT-4-0613, GPT-4-Turbo-2024-04-09.

2. ChatQA-1.0-70B의 성능 분석

Unanswerable 데이터의 수가 성능에 미치는 영향

- 1k Unanswerable 샘플:

- 평균 점수 (Avg Both): 76.88.

- ChatRAG 점수: 54.16.

- 성능이 가장 낮음.

- 1.5k Unanswerable 샘플:

- 평균 점수 (Avg Both): 77.25.

- ChatRAG 점수: 54.14.

- 최적의 성능을 보이며, 응답 가능한 데이터와 불가능한 데이터의 균형을 잘 맞춤.

- 2k Unanswerable 샘플:

- 평균 점수 (Avg Both): 76.78.

- ChatRAG 점수: 54.11.

- 성능이 소폭 감소.

- 2.5k Unanswerable 샘플:

- 평균 점수 (Avg Both): 75.87.

- ChatRAG 점수: 53.85.

- 응답 불가능 샘플 수가 지나치게 많아져 성능이 저하됨.

- SyntheticConvQA 대체:

- 평균 점수 (Avg Both): 69.84.

- ChatRAG 점수: 54.08.

- HumanAnnotatedConvQA를 SyntheticConvQA로 대체하면 성능이 크게 감소.

3. 비교 모델 성능

Llama3 기반 모델

- Llama3-ChatQA-1.5-8B:

- 평균 점수 (Avg Both): 71.86.

- ChatRAG 점수: 52.92.

- Llama3-ChatQA-1.5-70B:

- 평균 점수 (Avg Both): 77.96.

- ChatRAG 점수: 55.57.

- 가장 높은 성능을 기록.

GPT 모델

- GPT-3.5-Turbo-0613:

- 평균 점수 (Avg Both): 73.27.

- ChatRAG 점수: 53.27.

- GPT-4-0613:

- 평균 점수 (Avg Both): 78.11.

- ChatRAG 점수: 54.30.

- GPT-4-Turbo-2024-04-09:

- 평균 점수 (Avg Both): 80.47.

- ChatRAG 점수: 54.03.

4. 데이터셋별 성능 분석

QuAC

- ChatQA-1.0-70B (1.5k Unanswerable 샘플):

- Unanswerable (no*): 80.76.

- Answerable (yes*): 76.85.

- Llama3-ChatQA-1.5-70B:

- Unanswerable (no*): 89.25.

- Answerable (yes*): 96.93.

- Llama3 기반 모델이 가장 높은 성능을 기록.

DoQA

- ChatQA-1.0-70B (1.5k Unanswerable 샘플):

- Unanswerable (no*): 68.81.

- Answerable (yes*): 78.67.

- Llama3-ChatQA-1.5-70B:

- Unanswerable (no*): 71.13.

- Answerable (yes*): 90.01.

- Llama3 기반 모델이 우수한 성능.

5. 주요 해석

- Unanswerable 데이터의 수가 성능에 미치는 영향:

- 응답 불가능(Unanswerable) 샘플의 수를 1.5k로 설정했을 때, ChatQA-1.0-70B 모델이 최적의 성능을 발휘.

- 너무 적거나 많은 Unanswerable 샘플은 모델의 균형을 깨뜨려 성능 저하를 초래.

- Llama3-ChatQA-1.5-70B의 우수성:

- 모든 데이터셋에서 GPT 모델을 포함한 다른 모델들을 초과하는 성능을 보여줌.

- 특히 응답 불가능 샘플 처리에서 탁월한 정확도를 보임.

- SyntheticConvQA 대체의 영향:

- SyntheticConvQA를 사용하면 ChatQA-1.0-70B의 성능이 크게 하락.

- 이는 HumanAnnotatedConvQA의 데이터 품질이 더 높음을 시사.

6. 결론

- ChatQA-1.0-70B는 응답 불가능 샘플의 수를 1.5k로 설정했을 때 가장 높은 성능을 발휘.

- Llama3-ChatQA-1.5-70B는 모든 모델 중 가장 높은 평균 점수와 ChatRAG 점수를 기록하며, 특히 QuAC와 DoQA에서 뛰어난 성능.

- SyntheticConvQA는 HumanAnnotatedConvQA를 대체할 수 있지만, 성능은 다소 떨어짐.

추가로 궁금한 점이나 특정 부분에 대한 추가 설명이 필요하다면 말씀해주세요!

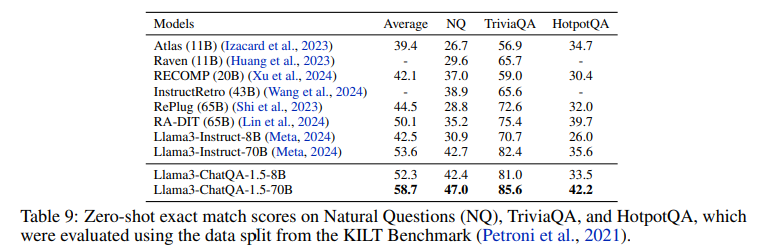

Table 9: Zero-shot Exact Match Scores on NQ, TriviaQA, and HotpotQA

이 표는 Natural Questions (NQ), TriviaQA, 그리고 HotpotQA 데이터셋에서 여러 모델이 기록한 Zero-shot Exact Match Scores를 비교한 결과를 보여줍니다. 각 모델은 KILT Benchmark 데이터 스플릿을 기반으로 평가되었습니다.

1. 주요 정보

평가 지표

- Exact Match (EM): 모델의 출력이 정답과 완전히 일치하는지 평가하는 지표.

- Zero-shot: 사전 학습된 모델에 추가 Fine-Tuning 없이 평가.

평가된 데이터셋

- Natural Questions (NQ):

- 실제 질문 응답(Natural QA) 데이터셋.

- TriviaQA:

- 트리비아 형식의 질문 응답 데이터셋.

- HotpotQA:

- 다단계 추론(Multi-hop Reasoning)을 요구하는 QA 데이터셋.

평가된 모델

- Atlas (11B):

- 11억 파라미터를 가진 Atlas 모델.

- Raven (11B):

- Raven 모델 (결과 일부 누락).

- RECOMP (20B):

- 20억 파라미터를 가진 RECOMP 모델.

- InstructRetro (43B):

- InstructRetro 모델 (43억 파라미터).

- RePlug (65B):

- 65억 파라미터를 가진 RePlug 모델.

- RA-DIT (65B):

- 65억 파라미터를 가진 RA-DIT 모델.

- Llama3-Instruct 시리즈:

- 8B와 70B 모델.

- Llama3-ChatQA-1.5 시리즈:

- 8B와 70B 모델.

2. 결과 분석

평균 점수 (Average)

- Llama3-ChatQA-1.5-70B: 58.7 (최고 성능).

- RA-DIT (65B): 50.1 (2위).

- Llama3-ChatQA-1.5-8B: 52.3 (소형 모델 중 최고 성능).

- 소형 모델인 Atlas (11B)는 39.4로 가장 낮은 점수.

Natural Questions (NQ)

- Llama3-ChatQA-1.5-70B: 47.0 (최고 성능).

- RA-DIT (65B): 35.2.

- 소형 모델인 Atlas (11B)는 26.7로 가장 낮은 점수.

TriviaQA

- Llama3-ChatQA-1.5-70B: 85.6 (최고 성능).

- RA-DIT (65B): 75.4.

- Atlas (11B)는 56.9로 가장 낮은 점수.

HotpotQA

- Llama3-ChatQA-1.5-70B: 42.2 (최고 성능).

- RA-DIT (65B): 39.7.

- Atlas (11B)는 34.7로 가장 낮은 점수.

3. 주요 해석

- Llama3-ChatQA-1.5-70B의 우수성:

- 모든 데이터셋(NQ, TriviaQA, HotpotQA)에서 최고 점수를 기록.

- 평균 점수에서도 58.7로 다른 모델을 크게 초과.

- 소형 모델의 경쟁력:

- Llama3-ChatQA-1.5-8B는 평균 점수 52.3으로, RA-DIT (65B)와 유사한 성능을 기록.

- 이는 소형 모델도 효율적으로 학습될 경우 경쟁력 있는 성능을 발휘할 수 있음을 시사.

- 데이터셋별 특성:

- TriviaQA와 같은 단순 질문 응답에서는 높은 점수를 기록하는 모델이 많음.

- HotpotQA처럼 다단계 추론이 필요한 경우 성능 차이가 더 명확히 드러남.

- RePlug와 RA-DIT의 안정성:

- 두 모델은 높은 성능을 기록했지만, Llama3-ChatQA 모델에는 미치지 못함.

- 이는 Llama3-ChatQA가 문맥 이해와 질문 응답에서 더 강력함을 보여줌.

4. 결론

- Llama3-ChatQA-1.5-70B는 모든 데이터셋에서 최고 성능을 기록하며, 특히 TriviaQA와 HotpotQA에서 뛰어난 결과를 보여줌.

- 소형 모델인 Llama3-ChatQA-1.5-8B도 상위권 성능을 기록하며 효율적인 모델임을 증명.

- 기존 상용 모델(Atlas, RePlug) 대비 Llama3-ChatQA 모델의 성능 우위를 확인할 수 있음.

추가로 궁금한 점이나 더 자세히 알고 싶은 부분이 있다면 말씀해주세요!

Table 10: Case Studies on ChatQA-1.0-70B and GPT-4-0613

이 테이블은 ChatQA-1.0-70B와 GPT-4-0613의 응답 품질을 비교한 사례 연구입니다. 각 사례에서 파란색(blue)은 사용자의 마지막 질문과 관련된 문맥을 강조하며, 초록색(green)과 빨간색(red)은 각각 올바른 응답과 잘못된 응답을 나타냅니다.

1. 테이블 구성

구성 요소

- Context:

- 사용자의 질문과 관련된 문맥.

- 모델이 적절한 답변을 생성하는 데 필요한 정보가 포함됨.

- Conversation:

- 사용자와 모델 간의 대화 기록.

- Assistant Responses:

- ChatQA-1.0-70B와 GPT-4-0613의 응답.

- Ground Truth(정답)와 비교하여 모델의 응답 정확성을 평가.

- Color Coding:

- 파란색: 마지막 질문에 대한 관련 문맥.

- 초록색: 올바른 응답.

- 빨간색: 잘못된 응답.

2. 사례 분석

사례 1: VA Board Hearing 관련 질문

- 문맥:

- VA 결정에 대한 항소 절차와 새로운 프로세스에 대한 정보.

- 사용자 질문:

- "When will I follow the new process for a Board hearing?"

- 응답 비교:

- ChatQA-1.0-70B: 정답을 정확히 제공함.

- GPT-4-0613: 정답을 제공하지만, 문맥에 불필요한 추가 정보를 포함하여 혼란을 줄 수 있음.

- Ground Truth: 간단명료하게 정답을 제시.

사례 2: Game of Thrones 관련 질문

- 문맥:

- Arya의 행동 및 관련 장면에 대한 설명.

- 사용자 질문:

- "How old is the child that they lay on the altar of ice?"

- 응답 비교:

- ChatQA-1.0-70B: 정답과 동일한 응답을 제공함.

- GPT-4-0613: "정보가 제공되지 않는다"고 응답했지만, 이는 문맥에 명확히 나타난 정보를 놓친 사례.

- Ground Truth: "a baby"로 정답.

사례 3: 자연 보호구역 관련 질문

- 문맥:

- Carpathian Biosphere Reserve에 포함된 숲 정보.

- 사용자 질문:

- "Which of the forests is a carpathian biosphere reserve?"

- 응답 비교:

- ChatQA-1.0-70B: 정답("Uholka / Wide Meadow")을 정확히 제공.

- GPT-4-0613: 잘못된 추가 정보를 포함해 혼란을 초래.

- Ground Truth: "Uholka / Wide Meadow".

사례 4: 적 비행기 격추 날짜

- 문맥:

- John B. England가 적 비행기를 격추한 날짜에 대한 데이터.

- 사용자 질문:

- "What were all of the dates in which John B. England destroyed or damaged enemy planes?"

- 응답 비교:

- ChatQA-1.0-70B: 정답에 근접하지만 일부 날짜를 놓침.

- GPT-4-0613: 정답을 더 정확히 제공.

- Ground Truth: GPT-4-0613의 응답과 동일.

3. 주요 분석 및 결과

- ChatQA-1.0-70B의 강점:

- 일부 사례에서 더 간결하고 정확한 응답을 제공.

- 예: VA Board Hearing와 Carpathian Biosphere Reserve 관련 질문.

- GPT-4-0613의 강점:

- 더 많은 정보와 세부사항을 제공하지만, 때로는 불필요하거나 잘못된 정보로 인해 혼란을 초래.

- 예: Game of Thrones 및 Biosphere Reserve 사례.

- Weakness Identification:

- ChatQA는 일부 날짜 기반 질문(예: John B. England 사례)에서 정보를 누락.

- GPT-4는 명확한 문맥 정보가 있음에도 "정보가 없다"고 잘못된 응답을 제공하는 경우가 있음.

4. 결론

- ChatQA-1.0-70B:

- 문맥에 명확히 제공된 정보를 정확히 추출하는 데 강점.

- 불필요한 정보를 추가하지 않아 간결한 응답을 제공.

- GPT-4-0613:

- 복잡한 데이터와 세부사항을 처리하는 데 강점.

- 그러나 불필요하거나 혼란을 줄 수 있는 정보를 포함하는 경우가 있음.

- 개선 가능성:

- ChatQA의 경우 숫자나 날짜 기반 정보의 누락을 줄이기 위한 학습 필요.

- GPT-4는 명확히 주어진 문맥에 더 충실한 응답 생성이 필요.

추가로 궁금한 점이 있거나 특정 사례를 더 깊이 분석하고 싶다면 말씀해주세요!

Chat QA2

다음은 제공된 텍스트의 한글 번역입니다:

"LLM에서 컨텍스트 창 확장의 흐름은 Claude가 100K 토큰 컨텍스트를 지원하면서 시작되었습니다 (Anthropic, 2023)."

독점 모델의 긴 컨텍스트 기술에 대한 구체적인 내용은 불분명하지만, 오픈 LLM 및 연구 커뮤니티는 지속적인 훈련이나 파인튜닝을 통해 LLM의 컨텍스트 창을 확장하는 여러 방법을 개발했습니다. 특히 RoPE(회전 위치 임베딩, Rotary Position Embedding) (Su et al., 2024)을 기반으로 한 오픈 액세스 LLM에서 이러한 기술이 활발히 적용되고 있습니다.

RoPE를 긴 컨텍스트 입력에 적응시키는 데 두 가지 인기 있는 접근 방식이 있습니다:

- 위치 보간(Position Interpolation): Chen et al. (2023a).

- RoPE의 기본 주파수 θ 증가: Xiong et al. (2023), Liu et al. (2023b).

최근에, Yi-34B (01.AI, 2024)는 4K 시퀀스 길이로 사전 훈련되었으며, 지속적인 훈련 중에 RoPE의 θ를 10,000에서 5M으로 증가시켜 컨텍스트 창을 200K까지 확장했습니다.

또한, Qwen2-72B-Instruct (Alibaba-QWen, 2024)는 32K 길이의 컨텍스트로 훈련되었으며, YaRN (Peng et al., 2023)을 사용하여 128K 컨텍스트 길이로 외삽(Extrapolation)되었습니다.

기본 모델의 컨텍스트 창을 확장한 후 명령 조정(Instruction Tuning)을 적용하는 대신, GradientAI (2024)는 NTK-aware 보간법(Peng et al., 2023)과 Liu et al. (2023b)의 공식을 활용해 θ를 스케일 업(scaling up)하는 방식으로 Llama-3-Instruct를 직접 파인튜닝했습니다.

이 연구의 첫 번째 버전이 발표된 후, 128K 컨텍스트 창을 지원하는 Llama-3.1 모델이 도입되었습니다. 우리는 실험에서 ChatQA-2와 Llama-3.1 간의 포괄적인 비교를 추가했습니다.

위 내용은 최신 LLM 연구의 긴 컨텍스트 기술 발전과 관련된 핵심 아이디어를 설명하며, 특히 RoPE와 같은 기술의 발전 방향을 강조합니다. 추가 질문이 있다면 말씀해주세요!

이 문맥에서 "토큰"은 검색기의 청크 크기와 관련이 있습니다. 아래에서 이를 더 자세히 설명하겠습니다:

문맥 분석

- 검색기와 토큰 크기:

- 텍스트는 긴 문서를 처리할 때, 언어 모델의 컨텍스트 창(예: 512, 8K, 32K 등)에 맞지 않을 경우, 검색기가 긴 문서를 작은 청크(Chunk)로 나눕니다.

- 여기서 "토큰"은 이 청크의 단위 크기를 의미하며, 모델의 컨텍스트 창에서 처리 가능한 길이를 기준으로 나뉩니다.

- 예를 들어:

- 512 토큰: 과거의 dense-embedding 기반 검색기에서 주로 사용한 제한된 길이.

- 8K 토큰: Jina Embeddings 2, Nomic Embed에서 지원.

- 32K 토큰: E5-Mistral-7B, NV-Embed에서 지원.

- 청크 크기와 문맥 단절:

- 작은 청크(예: 512 토큰)로 분할할 경우, 문맥 단절(context fragmentation)이 발생할 가능성이 높습니다.

- 이는 검색된 정보가 사용자의 질문과 충분히 연결되지 못하는 결과를 초래할 수 있습니다.

- 이를 해결하기 위해 검색기의 컨텍스트 창을 확장(예: 8K, 32K 토큰 지원)하는 방식이 점점 더 선호되고 있습니다.

- 작은 청크(예: 512 토큰)로 분할할 경우, 문맥 단절(context fragmentation)이 발생할 가능성이 높습니다.

- top-k 청크 검색:

- 검색기는 긴 문서에서 관련성이 높은 상위 k개의 청크를 검색합니다.

- 이 때, 청크의 크기가 크다면 더 많은 문맥 정보를 포함할 수 있어 응답의 정확성을 높일 수 있습니다.

결론

- "토큰"은 검색기의 청크 크기를 나타내며, 이는 모델이 한 번에 처리할 수 있는 문맥 길이와 동일한 단위로 사용됩니다.

- 과거에는 512 토큰처럼 작은 청크를 사용했으나, 이는 문맥 단절의 문제를 야기했습니다.

- 최신 검색기(예: E5-Mistral-7B, NV-Embed)는 32K 토큰까지 지원하며, 더 큰 청크를 통해 문맥 단절 문제를 해결하고 효율성을 향상시킵니다.

이 문맥에서 "토큰"이 검색기의 청크 크기를 나타내는 것은 맞습니다. 추가적인 설명이 필요하다면 말씀해주세요!

여기서 <s> 토큰은 긴 문맥에서 서로 다른 문서를 구분하기 위해 사용됩니다. 이 토큰의 역할과 사용 이유를 자세히 분석하면 다음과 같습니다:

1. <s> 토큰의 역할

- 문서 구분자 역할:

<s>는 긴 컨텍스트 내에서 여러 문서를 구분하는 데 사용됩니다.- 긴 문서나 데이터셋에서 서로 다른 문서가 한 컨텍스트 내에 포함될 경우, 문맥 단절을 방지하고 명확하게 문서 경계를 나타냅니다.

- 모델 학습에 유리:

<s>는 모델이 특정 구간이 새로운 문서의 시작임을 이해하도록 학습할 수 있게 합니다.

2. <BOS>와 <EOS> 토큰이 아닌 <s>를 사용하는 이유

- <BOS> (Beginning of Sequence)와 <EOS> (End of Sequence)의 역할:

- <BOS>와 <EOS>는 일반적으로 모델이 새로운 시퀀스의 시작과 끝을 나타내기 위해 사용합니다.

- 그러나 논문에서는 Llama3 모델이 사전 학습(pretraining) 중에 <BOS>와 <EOS>를 만날 때 이전 문맥을 무시하도록 학습되었다고 가정하고 있습니다.

- <s>의 이점:

- <s>는 <BOS>와 <EOS>와 달리, 모델에게 특정 구간이 새로운 문서의 시작임을 알려주면서도 이전 문맥을 무시하지 않도록 설계됩니다.

- 따라서, 긴 컨텍스트 작업(예: 128K 토큰)에서 이전 문서 정보를 유지한 채, 새로운 문서로의 자연스러운 전환을 가능하게 합니다.

3. 연구자의 가설

- 가설:

<BOS>와 <EOS>는 Llama3 모델에서 이전 청크(문맥)를 무시하도록 학습된 신호로 작용하며, 이는 긴 컨텍스트 작업에는 적합하지 않음.

반면 <s>는 이러한 영향을 받지 않으므로, 긴 컨텍스트 처리 및 적응에서 더 효과적임.

4. 결론

- <s> 토큰은 긴 컨텍스트 내 문서 경계를 명확히 표시하며, 이전 문맥을 유지하면서도 새로운 문서를 시작할 수 있도록 설계된 구분자 역할을 합니다.

- 이는 긴 문맥 작업에서 <BOS>와 <EOS>의 한계를 극복하고, LLM이 더 잘 적응하도록 돕는 중요한 요소입니다.

추가적인 질문이나 이와 관련된 다른 정보가 필요하면 말씀해주세요!

다음은 제공된 텍스트의 한글 번역입니다:

이 섹션에서는 긴 컨텍스트 이해 능력과 RAG 성능을 향상시키기 위해 설계된 명령 조정(Instruction Tuning) 방법을 소개합니다.

특히, 세 가지 단계의 명령 조정을 구현했습니다. 처음 두 단계에서는 ChatQA 1.5 (Liu et al., 2024)의 접근 방식을 따르며, 초기에는 128K 길이의 고품질 명령 수행 데이터셋으로 모델을 훈련하고, 이후 제공된 컨텍스트를 기반으로 한 대화형 QA 데이터를 혼합하여 훈련합니다.

하지만 이 두 단계는 상대적으로 짧은 컨텍스트(최대 4K 토큰 길이)를 포함합니다. 따라서, 모델이 최대 128K 토큰에 이르는 매우 긴 컨텍스트를 처리할 수 있는 능력을 강화하기 위해 긴 SFT(Supervised Fine-Tuning) 데이터셋을 추가로 수집했습니다.

이 데이터셋은 두 가지 범주를 통해 수집되었습니다:

- 32K 토큰 이하의 SFT 데이터 시퀀스:

- LongAlpaca12k, Open Orca 1의 GPT-4 샘플, Long Data Collections 2 등 기존의 긴 컨텍스트 데이터셋을 활용.

- 32K에서 128K 토큰 길이의 시퀀스:

- 이와 같은 SFT 샘플을 수집하는 것은 어려움이 있기 때문에, 합성 데이터셋(synthetic datasets)에 의존.

- NarrativeQA를 활용하며, 해당 데이터셋에는 실제 정답 요약과 의미적으로 관련된 단락들이 포함되어 있습니다.

- 모든 관련 단락을 결합하고, 무작위로 정답 요약을 삽입하여 긴 문서를 시뮬레이션하고, 이를 QA 쌍으로 사용.

이후, 긴 SFT 데이터셋과 첫 두 단계에서 사용된 짧은 SFT 데이터셋을 혼합하여 모델 훈련에 사용했습니다.

학습률은 3e-5, 배치 크기는 32로 설정했습니다.

이 번역은 원문 내용을 정확히 반영하며, 추가 설명이나 질문이 필요하면 말씀해주세요!

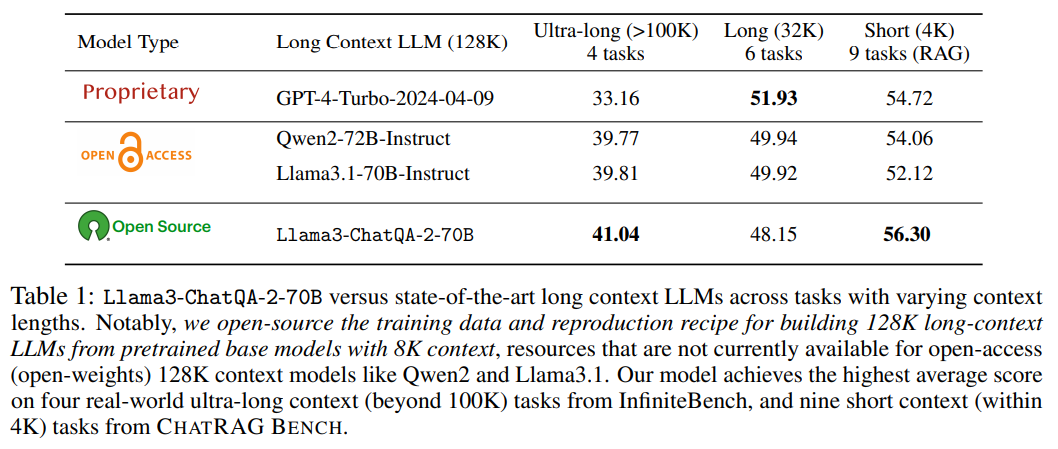

이 표는 Llama3-ChatQA-2-70B 모델과 다른 주요 모델(GPT-4 Turbo, Qwen2-72B-Instruct, Llama3.1-70B-Instruct)을 다양한 컨텍스트 길이에서 성능을 비교한 결과를 보여줍니다. 표의 각 열과 데이터에 대해 자세히 설명하면 다음과 같습니다:

1. 열의 구성

- Model Type: 비교된 모델의 이름과 속성(독점 모델, 오픈소스, 오픈 접근성 여부)을 나타냅니다.

- Proprietary (독점): GPT-4 Turbo (128K 지원).

- Open Access (오픈 접근): Qwen2-72B-Instruct, Llama3.1-70B-Instruct.

- Open Source (오픈소스): Llama3-ChatQA-2-70B.

- Ultra-long Context (>100K) 4 tasks: 초긴 컨텍스트(100K 토큰 이상) 작업에서의 평균 점수.

- InfiniteBench 벤치마크에서 4개의 작업(요약, QA, 다중 선택, 대화) 수행 결과.

- Long Context (32K) 6 tasks: 중간 길이 컨텍스트(32K 토큰 이하) 작업에서의 평균 점수.

- SCROLLS와 LongBench에서 6개의 작업(QMSum, Qasper, QuALITY 등) 수행 결과.

- Short Context (4K) 9 tasks (RAG): 짧은 컨텍스트(4K 토큰 이하) 작업에서의 평균 점수.

- ChatRAG Bench에서 검색 강화 생성(RAG) 기반의 9개 작업 수행 결과.

2. 주요 관찰점

- Ultra-long Context (>100K):

- Llama3-ChatQA-2-70B는 초긴 컨텍스트 작업에서 41.04점으로, 모든 모델 중 최고 성능을 기록.

- GPT-4 Turbo (33.16점)보다 약 24% 더 높은 성능을 보임.

- Qwen2-72B-Instruct (39.77점) 및 Llama3.1-70B-Instruct (39.81점)보다 소폭 우수.

- Long Context (32K):

- GPT-4 Turbo가 51.93점으로 가장 높은 성능을 기록.

- Llama3-ChatQA-2-70B는 48.15점으로 Qwen2-72B-Instruct (49.94점) 및 Llama3.1-70B-Instruct (49.92점)보다 다소 낮은 성능.

- 긴 컨텍스트 작업에서는 GPT-4 Turbo가 여전히 강력한 성능을 유지.

- Short Context (4K, RAG):

- Llama3-ChatQA-2-70B는 56.30점으로 GPT-4 Turbo (54.72점) 및 Qwen2-72B-Instruct (54.06점)을 초과.

- 이는 짧은 컨텍스트 작업에서 RAG를 활용한 ChatQA-2 모델의 강점을 나타냄.

3. 추가 설명

- Llama3-ChatQA-2-70B 모델의 강점:

- 초긴 컨텍스트 작업에서 우수한 성능을 보이며, GPT-4 Turbo를 포함한 독점 모델을 능가.

- 오픈소스 모델로서 성능뿐만 아니라 재현 가능한 학습 및 평가 레시피를 제공하여 연구 커뮤니티에 기여.

- GPT-4 Turbo의 강점:

- 중간 길이 컨텍스트(32K 이하) 작업에서는 여전히 가장 높은 성능을 보임.

- 결론:

- Llama3-ChatQA-2-70B는 초긴 컨텍스트와 짧은 컨텍스트(RAG) 작업에서 우수한 성능을 보이며, 다양한 시나리오에서 활용 가능.

표에서 언급된 모델들의 성능과 각 작업에 대한 구체적인 점수 차이에 대해 더 자세히 알고 싶다면 말씀해주세요!

Figure 설명: "Needle In A Haystack" 테스트

이 Figure는 "Needle In A Haystack" 테스트를 통해 다양한 모델(Llama3 및 ChatQA-2)의 긴 컨텍스트 내에서 특정 정보를 검색하는 성능을 평가한 결과를 보여줍니다. 테스트는 최대 128K 컨텍스트 창에서 수행되었으며, 결과는 "The best thing to do in San Francisco is eat a sandwich and sit in Dolores Park on a sunny day."라는 문장을 동일한 needle(찾고자 하는 정보)로 설정해 각 모델의 검색 능력을 비교합니다.

Figure의 구성

- 모델: 네 가지 모델이 비교되었습니다.

- (a) Llama3.1-Instruct 8B: 8B 매개변수를 가진 모델.

- (b) Llama3.1-Instruct 70B: 70B 매개변수를 가진 모델.

- (c) Llama3-ChatQA-2-8B: ChatQA-2로 확장된 8B 매개변수 모델.

- (d) Llama3-ChatQA-2-70B: ChatQA-2로 확장된 70B 매개변수 모델.

- X축: Token Limit (토큰 제한)

- 입력 컨텍스트의 길이(토큰 수)를 나타내며, 3,282부터 128,000까지 증가합니다.

- 긴 컨텍스트 길이에서 정보 검색 능력을 테스트합니다.

- Y축: Depth Percent (깊이 비율)

- 찾고자 하는 정보(needle)가 텍스트 내 얼마나 깊숙이 위치해 있는지를 나타냅니다.

- 0%는 컨텍스트의 앞부분, 100%는 마지막 부분에 위치.

- 색상 표시: Score (점수)

- 초록색(높은 점수, 1.0): 모델이 정보를 정확히 검색함.

- 빨간색(낮은 점수, 0.0): 모델이 정보를 찾지 못함.

Figure의 주요 결과

- Llama3.1-Instruct 모델 (a, b):

- (a) 8B 모델:

- 짧은 컨텍스트(4K~32K)에서 일부 검색 성공.

- 32K 이상에서는 성능이 급격히 저하됨.

- (b) 70B 모델:

- 70B 모델은 8B보다 더 나은 성능을 보이나, 긴 컨텍스트(100K 이상)에서는 여전히 정보 검색 성능이 낮음.

- (a) 8B 모델:

- ChatQA-2 모델 (c, d):

- (c) ChatQA-2-8B:

- Llama3.1-Instruct 8B보다 긴 컨텍스트에서 더 나은 검색 성능을 보임.

- 그러나 최대 128K 토큰에서는 성능이 일부 제한됨.

- (d) ChatQA-2-70B:

- 모든 컨텍스트 길이에서 가장 높은 검색 성능.

- 128K 컨텍스트에서도 정보를 정확히 검색하며, 특히 긴 문서의 후반부(80% 이상 깊이)에서도 안정적인 성능 유지.

- (c) ChatQA-2-8B:

주요 관찰

- 모델 크기와 검색 성능:

- 동일한 구조에서도 더 큰 매개변수를 가진 모델(70B)이 검색 성능에서 우위를 보임.

- 이는 모델 용량이 증가할수록 긴 컨텍스트 처리 능력이 향상됨을 시사.

- ChatQA-2의 장점:

- Llama3.1-Instruct에 비해 긴 컨텍스트 창(128K)에서 뛰어난 성능을 보임.

- 특히 ChatQA-2-70B는 초긴 문서의 후반부에서도 정보를 정확히 검색하며, 이는 명령 조정(Instruction Tuning)과 데이터 확장이 효과적이었음을 의미.

- 긴 컨텍스트에서의 문제 해결:

- 기존 모델(Llama3.1)은 긴 문서에서 문맥 단절 및 정보 손실이 발생.

- ChatQA-2는 긴 컨텍스트에서도 문맥을 유지하며 정보를 검색하는 데 성공.

결론

- ChatQA-2 모델, 특히 70B 모델은 초긴 컨텍스트 작업에서 가장 높은 성능을 보여줍니다.

- 명령 조정(Instruction Tuning)과 긴 컨텍스트 데이터를 활용한 학습이 긴 문맥에서도 정보 검색 능력을 대폭 향상시켰음을 보여줍니다.

- 이 Figure는 ChatQA-2 모델이 기존 Llama3.1 모델보다 긴 문맥 정보 검색에 있어 더 강력하다는 점을 시각적으로 입증합니다.

추가적인 질문이 있거나 특정 부분에 대해 더 자세히 설명을 원하시면 말씀해주세요!

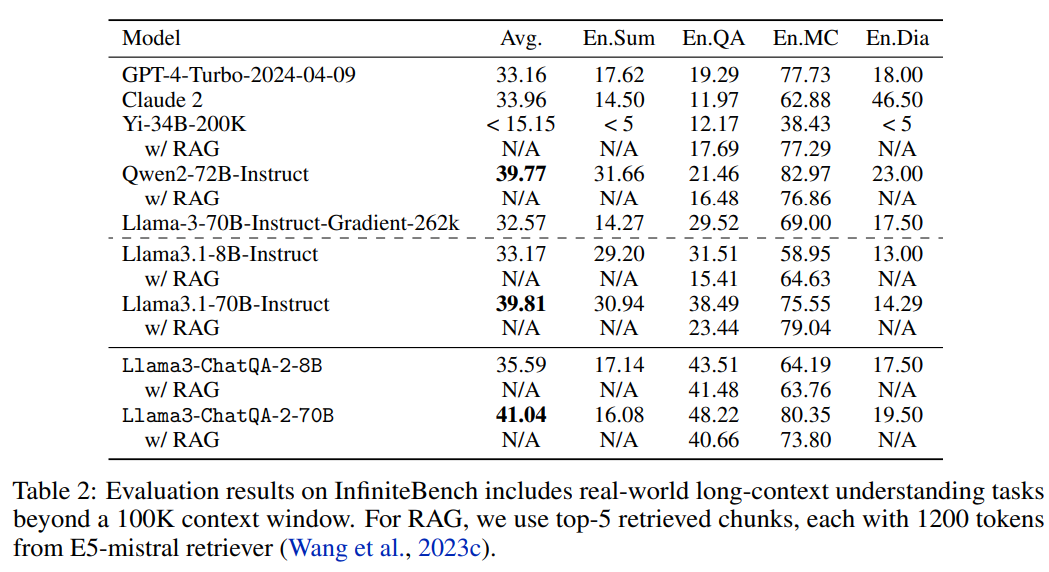

Table 2: InfiniteBench 평가 결과 정리

이 테이블은 InfiniteBench에서 100K 이상의 긴 컨텍스트 작업에 대한 모델 성능을 평가한 결과를 보여줍니다. 여기서는 모델이 긴 문맥에서 주어진 작업을 얼마나 잘 수행하는지 비교하며, 특히 RAG(Retrieval-Augmented Generation)를 사용하는 경우와 사용하지 않는 경우를 구분하여 분석합니다.

1. 주요 열 설명

- Model:

- 평가된 모델의 이름과 버전을 나타냅니다.

- 독점 모델(GPT-4 Turbo, Claude 2)과 오픈소스 모델(Llama3, ChatQA-2)이 포함되어 있습니다.

- Avg. (평균):

- 모든 작업의 평균 점수로 모델의 전반적인 성능을 나타냅니다.

- En.Sum (요약):

- 영어로 된 긴 문서를 요약하는 작업의 점수.

- En.QA (질의응답):

- 영어로 된 긴 문서에서 질문에 답변하는 작업의 점수.

- En.MC (다중 선택):

- 영어 다중 선택 질문(Multiple Choice)을 해결하는 작업의 점수.

- En.Dia (대화):

- 영어 대화 데이터를 처리하는 작업의 점수.

- w/ RAG (with RAG):

- RAG를 활용했을 때의 성능을 별도로 평가합니다.

- E5-mistral 검색기를 사용하며, 각 검색 청크의 크기는 1,200 토큰이고 top-5 청크를 모델 입력으로 제공합니다.

2. 주요 결과

- GPT-4 Turbo (독점 모델):

- 평균 점수(Avg.): 33.16

- 요약(En.Sum): 17.62

- 질의응답(En.QA): 19.29

- 다중 선택(En.MC): 77.73 → 다중 선택 작업에서 뛰어난 성능을 보임.

- 대화(En.Dia): 18.00 → 대화 작업은 상대적으로 약함.

- Claude 2 (독점 모델):

- 평균 점수(Avg.): 33.96 → GPT-4 Turbo보다 평균 점수는 약간 높음.

- 대화(En.Dia): 46.50 → 대화 작업에서 가장 높은 점수를 기록.

- Yi-34B-200K (오픈소스 모델):

- 긴 컨텍스트 작업에서 성능이 낮음.

- 평균 점수(Avg.): 15.15

- 요약(En.Sum): <5

- Qwen2-72B-Instruct (오픈 접근 모델):

- 평균 점수(Avg.): 39.77 → GPT-4 Turbo와 비교해 더 나은 성능을 기록.

- 다중 선택(En.MC): 82.97 → 다중 선택 작업에서 가장 높은 성능.

- Llama3.1-Instruct (오픈소스 모델):

- 8B 모델: 평균 점수 33.17로 상대적으로 낮은 성능.

- 70B 모델: 평균 점수 39.81로 8B 모델보다 월등히 높은 성능.

- RAG를 사용한 경우 긴 문서의 다중 선택과 질의응답 성능이 크게 향상.

- ChatQA-2 모델 (오픈소스):

- 8B 모델: 평균 점수 35.59, RAG 활용 시 성능 증가.

- 70B 모델:

- 평균 점수(Avg.): 41.04 → 가장 높은 점수.

- 다중 선택(En.MC): 80.35 → GPT-4 Turbo와 Qwen2-72B에 근접.

- 요약(En.Sum): 16.08 → 긴 문서 요약에서는 상대적으로 낮은 점수.

- 질의응답(En.QA): 40.66 → 질의응답 작업에서 우수한 성능.

3. 주요 관찰

- 독점 모델과 오픈소스 모델의 비교:

- GPT-4 Turbo와 Claude 2는 전반적으로 안정적이지만, 오픈소스 모델인 ChatQA-2-70B가 평균 점수에서 이를 능가.

- RAG의 효과:

- RAG를 사용하면 긴 문서의 다중 선택과 질의응답 성능이 크게 향상됨.

- 특히, ChatQA-2-70B w/ RAG는 질의응답에서 뛰어난 성능을 보임.

- 오픈소스 생태계의 성장:

- ChatQA-2-70B와 같은 오픈소스 모델은 독점 모델에 근접하거나 뛰어난 성능을 보이며, 긴 컨텍스트 작업에서 유망한 대안을 제시.

4. 결론

- ChatQA-2-70B는 RAG를 활용하여 독점 모델(GPT-4 Turbo, Claude 2)과 동등하거나 더 나은 성능을 보이며, 긴 컨텍스트 이해와 질의응답에서 특히 강력함.

- 오픈소스 생태계에서 RAG와 명령 조정을 통해 긴 문맥 작업의 성능을 대폭 개선할 가능성을 보여줌.

테이블의 특정 항목이나 추가적인 설명이 필요하다면 말씀해주세요!

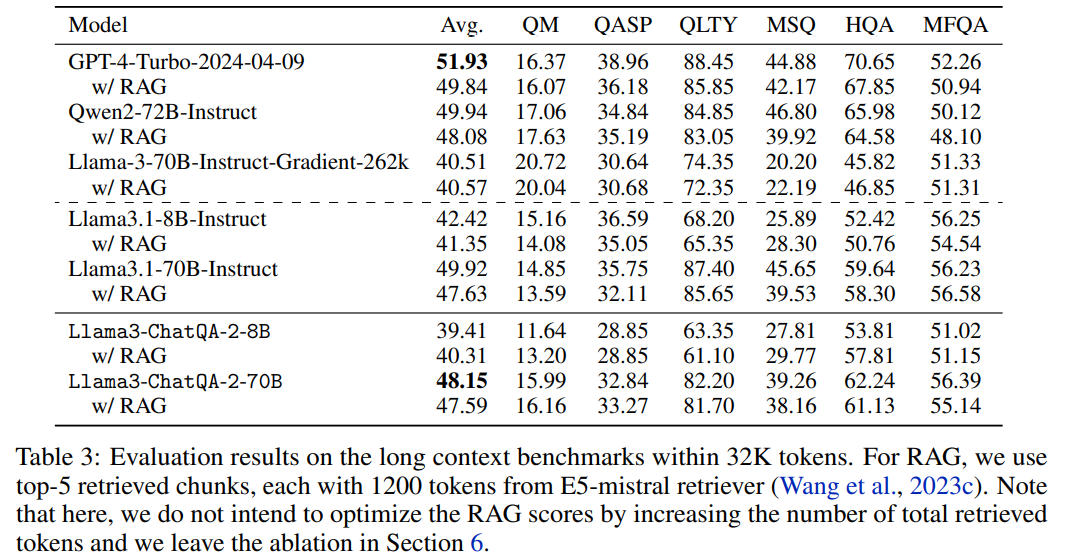

Table 3: 32K 이하 긴 컨텍스트 벤치마크 평가 결과

이 테이블은 32K 토큰 이하의 긴 컨텍스트 작업에 대한 다양한 모델의 성능 평가를 보여줍니다. 벤치마크는 질의응답(QA), 요약, 다중 선택(MCQ) 등 다양한 작업을 포함하며, RAG(Retrieval-Augmented Generation)를 적용한 경우와 그렇지 않은 경우를 비교합니다.

1. 열 구성

- Model:

- 평가된 모델의 이름과 버전.

- 독점 모델(GPT-4 Turbo), 오픈 접근 모델(Qwen2), 오픈소스 모델(Llama3 및 ChatQA-2).

- Avg.:

- 평균 점수. 모든 작업(QM, QASP, QLTY 등)의 평균 성능을 나타냄.

- QM (Question Matching):

- 질문과 문맥이 얼마나 잘 일치하는지를 평가.

- QASP (Qasper):

- 과학 논문 데이터를 기반으로 한 질문 응답 성능.

- QLTY (Quality):

- 긴 문서의 요약 품질 평가.

- MSQ (Multi-Step QA):

- 여러 단계를 거쳐야 답변할 수 있는 복잡한 질의응답 성능.

- HQA (HotpotQA):

- 다중 문서를 참조하는 질의응답 성능.

- MFQA (Multi-Field QA):

- 다양한 주제와 문맥에서의 QA 성능.

2. 주요 결과

(1) GPT-4 Turbo:

- 평균 점수(Avg.): 51.93로 전체 모델 중 가장 높은 성능.

- RAG 미사용: 51.93

- RAG 사용: 49.84 (약간의 성능 저하)

- 주요 강점: 다중 선택(QLTY: 88.45), 다중 필드 QA(MFQA: 52.26)에서 최고 점수.

(2) Qwen2-72B-Instruct:

- 평균 점수(Avg.): 49.94 (GPT-4 Turbo에 근접).

- RAG 사용 시: 48.08 → RAG를 사용한 경우 약간의 성능 저하.

- 강점: QLTY(요약 품질) 및 MSQ(복잡한 QA)에서 안정적인 성능.

(3) Llama3.1-Instruct:

- 8B 모델:

- 평균 점수 42.42로 상대적으로 낮은 성능.

- RAG 사용 시 성능이 소폭 향상(41.35).

- 70B 모델:

- 평균 점수 49.92로 Qwen2와 유사한 성능.

- RAG 사용 시 약간의 성능 저하(47.63).

(4) Llama3-ChatQA-2:

- 8B 모델:

- 평균 점수 39.41로 GPT-4 및 Qwen2 대비 낮은 성능.

- RAG 사용 시 성능이 약간 향상(40.31).

- 70B 모델:

- 평균 점수 48.15 → Qwen2와 비교해 다소 낮지만 준수한 성능.

- RAG 사용 시 성능 소폭 감소(47.59).

- 강점: QLTY(82.20), HQA(62.24)에서 높은 성능을 기록.

3. 주요 관찰

- GPT-4 Turbo의 강점:

- 평균 점수 및 요약(QLTY), 다중 선택 작업에서 최고 성능.

- RAG를 사용해도 성능 저하가 상대적으로 적음.

- RAG의 효과:

- 대부분의 모델에서 RAG 사용 시 성능이 약간 감소하는 경향이 있음.

- 이는 검색된 청크(top-5)가 최적화되지 않았거나, 추가 검색 과정이 모델의 자연스러운 처리 흐름에 영향을 줄 가능성을 시사.

- Llama3-ChatQA-2의 유망성:

- 70B 모델은 GPT-4 Turbo와의 성능 차이를 줄였으며, HQA(HotpotQA)와 요약 품질(QLTY)에서 특히 높은 성능.

- 이는 ChatQA-2의 긴 컨텍스트 이해 및 질의응답 최적화가 효과적임을 보여줌.

- 오픈소스 모델의 성장:

- ChatQA-2와 같은 모델은 독점 모델에 비해 평균 성능이 낮지만, 특정 작업에서는 경쟁력을 가짐.

- 특히 오픈소스 생태계에서 긴 컨텍스트 및 질의응답 작업의 발전 가능성을 입증.

4. 결론

- GPT-4 Turbo는 여전히 전체적인 성능에서 가장 뛰어나지만, Llama3-ChatQA-2(특히 70B 모델)는 오픈소스 모델로서 긴 문맥 작업에서 실질적인 대안이 될 가능성을 보여줌.

- RAG의 사용은 특정 상황에서 성능 향상보다는 오히려 약간의 저하를 초래할 수 있으나, 검색기 최적화와 같은 추가 개선 가능성이 있음.

- 긴 컨텍스트 이해와 요약 품질에서 ChatQA-2의 강점이 두드러짐.

추가 질문이나 특정 작업에 대한 세부적인 설명이 필요하면 말씀해주세요!

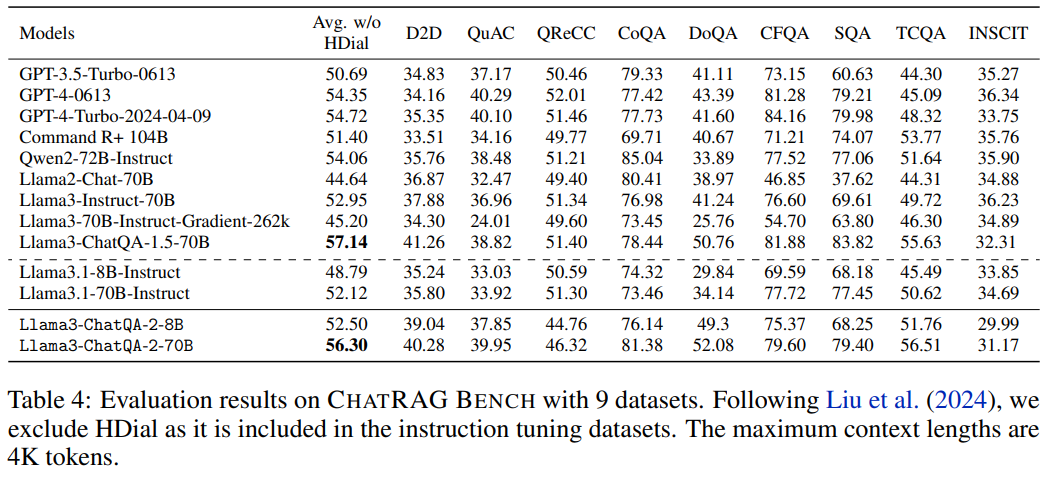

Table 4: CHATRAG BENCH 평가 결과

이 테이블은 CHATRAG BENCH에서 9개의 데이터셋을 활용해 다양한 모델의 성능을 평가한 결과를 나타냅니다. CHATRAG BENCH는 4K 토큰 이하의 짧은 컨텍스트에서 질의응답(QA), 문맥 기반 대화 등의 작업을 수행하며, HDial(Human Dialogue)은 제외된 상태로 평가가 진행되었습니다.

1. 주요 열 설명

- Models:

- 평가된 모델의 이름과 버전.

- GPT-3.5 Turbo, GPT-4 Turbo 등 독점 모델과 Llama3, ChatQA-2 같은 오픈소스 모델이 포함.

- Avg. w/o HDial:

- HDial 작업을 제외한 9개 데이터셋의 평균 점수. 전체 성능을 나타냄.

- D2D, QuAC, QReCC, CoQA 등:

- 각각의 열은 특정 작업에서의 성능 점수를 나타냄.

- 각 작업은 질의응답 및 대화 관련 데이터셋을 기반으로 함.

- D2D: 대화 생성.

- QuAC: 대화형 QA.

- QReCC: 복잡한 질의응답.

- CoQA: 대화 기반 QA.

- DoQA: 도메인 특화 QA.

- CFQA: 추론 기반 QA.

- SQA: 구조화된 데이터에서의 QA.

- TCQA: 표 기반 QA.

- INSCIT: 과학적 텍스트 기반 QA.

2. 주요 결과

(1) GPT 모델:

- GPT-4 Turbo (2024-04-09):

- 평균 점수 54.72로 전체 모델 중 가장 높은 점수.

- CFQA(84.16)와 SQA(79.98) 작업에서 특히 우수.

- QuAC(40.10)과 INSCIT(35.31) 작업에서는 상대적으로 약한 성능.

- GPT-3.5 Turbo:

- 평균 점수 50.69로 GPT-4 Turbo 대비 다소 낮음.

- D2D(34.83)와 QuAC(37.17) 작업에서 중간 수준 성능.

(2) 오픈소스 모델:

- Llama3-ChatQA-2-70B:

- 평균 점수 56.30으로 GPT-4 Turbo와 비슷한 성능을 기록.

- CoQA(81.38), DoQA(52.08), SQA(79.60)에서 높은 점수.

- INSCIT(31.17)은 상대적으로 약함.

- Llama3-ChatQA-2-8B:

- 평균 점수 52.50으로 GPT-3.5 Turbo와 유사한 성능.

- CoQA(76.14), SQA(75.37)에서 준수한 성과를 보임.

- Llama3.1-70B-Instruct:

- 평균 점수 52.12.

- RAG 없이도 QReCC, CFQA, SQA에서 안정적인 성능.

(3) 최고 성능 모델:

- Llama3-ChatQA-1.5-70B:

- 평균 점수 57.14로 가장 높은 성능.

- 대부분의 작업에서 균형 잡힌 우수한 점수.

3. 주요 관찰

- GPT-4 Turbo와 ChatQA-2-70B의 경쟁:

- ChatQA-2-70B는 GPT-4 Turbo와 비슷한 점수를 기록하며, 오픈소스 생태계에서도 독점 모델과 경쟁 가능한 수준임을 보여줌.

- 특히 CoQA, DoQA, SQA와 같은 대화형 및 도메인 특화 QA 작업에서 두드러짐.

- 모델 크기와 성능 관계:

- 같은 모델 구조라도 매개변수가 증가하면 성능이 향상되는 경향이 있음(Llama3-ChatQA-2-8B vs 70B).

- INSCIT 작업의 어려움:

- INSCIT은 과학적 텍스트를 기반으로 한 QA 작업으로, 대부분의 모델에서 낮은 점수를 기록. 이는 과학적 문맥 처리의 난이도를 반영.

- CHATRAG BENCH의 다양한 작업:

- 데이터셋별로 모델의 강점과 약점이 드러나며, 특정 작업에서의 성능 최적화가 중요.

4. 결론

- ChatQA-2-70B는 GPT-4 Turbo와 비교할 때 뛰어난 성능을 보이며, 오픈소스 모델의 가능성을 입증.

- 각 작업에서의 세부 점수는 모델 구조 및 훈련 데이터의 최적화 방향을 설정하는 데 유용한 정보.

- INSCIT과 같은 과학적 텍스트 작업에서는 여전히 개선의 여지가 있음.

추가 질문이나 특정 작업에 대한 심층적인 분석이 필요하다면 말씀해주세요!

Figure 2: RAG에서 다양한 chunk_size와 top-k의 영향

이 그래프는 Llama3-ChatQA-2-70B 모델에서 RAG(Retrieval-Augmented Generation)를 사용해 긴 컨텍스트 벤치마크(32K 이하)에서 chunk_size와 top-k 설정에 따른 성능 변화를 나타냅니다. 그래프의 핵심은 컨텍스트 윈도우 내에서 검색된 총 토큰 수(top-k × chunk_size)가 모델의 정확도에 미치는 영향을 분석하는 것입니다.

1. 축 및 범례 설명

- X축 (Total number of tokens in the context window):

- 검색된 총 토큰 수를 나타냅니다. 이는 top-k와 chunk_size를 곱한 값입니다.

- 예:

- top-k=10, chunk_size=600일 경우, 총 토큰 수는 6,000.

- Y축 (Average score):

- 벤치마크에서의 평균 점수(정확도)를 나타냅니다.

- 높은 점수일수록 더 좋은 성능.

- 범례:

- RAG: chunk_size=300 (빨간색 점): 작은 청크 크기를 사용.

- RAG: chunk_size=600 (녹색 플러스): 중간 크기의 청크.

- RAG: chunk_size=1200 (파란색 X): 큰 청크 크기.

- Full long context (파란색 점선): 전체 긴 컨텍스트를 직접 입력한 경우의 기준선 점수.

2. 주요 관찰

- chunk_size가 클수록 성능이 향상:

- chunk_size=300 (빨간색): 평균 점수가 상대적으로 낮음.

- chunk_size=600 (녹색): 더 많은 토큰을 포함하며 점수가 향상됨.

- chunk_size=1200 (파란색): 가장 높은 평균 점수를 기록.

- 이유: 더 큰 청크 크기는 단일 청크 내에 더 많은 문맥 정보를 포함하므로, 검색된 문맥이 더 풍부해져 모델의 응답 정확도가 높아짐.

- 검색된 총 토큰 수와 성능의 관계:

- 총 토큰 수가 증가할수록 평균 점수가 단조롭게(monotonically) 증가.

- 이는 더 많은 청크(즉, 더 많은 문맥 정보)가 검색될수록 모델이 정확한 응답을 생성할 가능성이 높아짐을 의미.

- Full long context와의 비교:

- 파란색 점선으로 표시된 전체 긴 컨텍스트를 입력한 경우의 점수(48.2)는 RAG를 사용한 경우와 비슷하거나 약간 낮음.

- 결론: RAG를 통해 적절히 검색된 문맥(특히 큰 청크와 높은 top-k 값)이 전체 컨텍스트를 직접 사용하는 것과 동등한 성능을 제공할 수 있음.

3. 중요한 분석

- 작은 chunk_size의 한계:

- 작은 청크 크기(300 토큰)는 문맥 단절(fragmentation)을 초래할 가능성이 높음.

- 검색된 문맥의 정보가 부족하여 평균 점수가 낮음.

- 큰 chunk_size의 장점:

- 큰 청크(600, 1200 토큰)는 문맥 단절을 줄이고, 관련 정보가 포함된 풍부한 데이터를 검색 가능.

- 더 적은 청크로도 동일한 총 토큰 수를 달성하므로 검색 효율성도 높아짐.

- RAG의 효율성:

- 긴 컨텍스트를 직접 입력하지 않고도, RAG를 사용하여 성능을 향상시킬 수 있음.

- 이는 RAG의 검색 정확도와 청크 크기 설정이 모델 성능에 중요한 영향을 미친다는 점을 보여줌.

4. 결론

- chunk_size와 top-k의 적절한 조합이 RAG 기반 모델의 성능 최적화에 중요.

- 큰 chunk_size (1200 토큰)와 높은 총 토큰 수를 활용할수록 평균 점수가 상승.

- 전체 긴 컨텍스트를 입력하는 것과 비슷한 성능을 제공하며, 이는 긴 문서 처리를 위한 RAG의 실용성과 효율성을 입증.

추가로 궁금한 점이나 특정 설정에 대한 심층 분석이 필요하다면 말씀해주세요!

Table 5: RAG vs. Long Context 비교

이 테이블은 RAG(Retrieval-Augmented Generation)과 긴 컨텍스트(Long Context) 입력 방식을 비교한 결과를 보여줍니다.

평가는 Llama3-ChatQA-2-70B 및 Qwen2-72B-Instruct 모델을 대상으로 100K 이상의 긴 컨텍스트 작업(En.QA 및 En.MC)에서 수행되었습니다.

1. 주요 열 설명

- RAG (top-k):

- RAG를 활용해 관련 청크를 검색하여 모델 입력으로 사용했을 때의 성능.

- top-k: 검색된 상위 k개의 청크를 모델에 입력으로 제공.

- Llama3-ChatQA-2-70B에서는 k=30.

- Qwen2-72B-Instruct에서는 k=20.

- Long Context:

- RAG를 사용하지 않고 긴 컨텍스트 전체를 모델에 직접 입력했을 때의 성능.

2. 주요 결과

(1) Llama3-ChatQA-2-70B:

- RAG (top-k=30):

- 평균 점수: 64.55

- 긴 문서에서 RAG를 사용해 관련 문맥만 검색한 경우, 성능이 약간 더 우수.

- Long Context:

- 평균 점수: 64.29

- 긴 컨텍스트 전체를 입력했을 때와 RAG 사용 시 성능 차이는 미미하지만, RAG가 약간 더 높은 점수를 기록.

(2) Qwen2-72B-Instruct:

- RAG (top-k=20):

- 평균 점수: 52.95

- Long Context 방식보다 RAG가 더 높은 성능을 보임.

- Long Context:

- 평균 점수: 52.22

- RAG에 비해 낮은 성능을 기록.

3. 주요 관찰

- RAG의 성능 우위:

- 두 모델 모두에서 RAG를 사용할 경우 긴 컨텍스트를 직접 입력하는 방식보다 더 높은 점수를 기록.

- 특히, Llama3-ChatQA-2-70B는 RAG 사용 시 성능이 64.55로 약간 향상.

- 긴 컨텍스트 처리의 한계:

- 긴 문서를 그대로 입력하면, 문맥 연결성과 효율성이 떨어질 가능성이 있음.

- RAG는 긴 문서에서 관련성이 높은 청크만 선택하여, 효율성과 정확성을 동시에 향상.

- 모델 간 비교:

- Llama3-ChatQA-2-70B는 Qwen2-72B-Instruct에 비해 긴 문서 처리 및 RAG 성능에서 더 우수.

- 이는 ChatQA-2의 명령 조정 및 긴 컨텍스트 학습의 효과를 반영.

4. 결론

- RAG는 긴 컨텍스트를 직접 입력하는 방식보다 우수한 성능을 제공.

- 관련 청크를 선별함으로써 불필요한 정보를 제거하고, 모델의 응답 정확도를 높임.

- Llama3-ChatQA-2-70B는 Qwen2-72B-Instruct보다 높은 성능을 보이며, 긴 컨텍스트 작업에서 독점 모델과 유사한 수준의 성능을 입증.

- RAG와 긴 컨텍스트 방식을 적절히 활용하면 긴 문서 처리에서 더욱 효율적이고 정확한 결과를 도출할 수 있음.

추가 질문이 있거나 더 상세한 분석이 필요하다면 말씀해주세요!

Figure 3: Needle In A Haystack 테스트 (Passkey Retrieval)

이 Figure는 Needle In A Haystack 테스트의 Passkey Retrieval 결과를 시각화한 것으로, 128K 컨텍스트에서 여러 모델의 특정 정보(패스키)를 검색하는 성능을 평가합니다.

패스키는 "The pass key is 385243. Remember it. 385243 is the pass key."로 설정되었으며, 질문은 "What is the pass key?"입니다.

1. 그래프 구성

- X축 (Token Limit):

- 입력된 컨텍스트 길이(토큰 수)를 나타냄.

- 3,282에서 128,000까지 범위를 가짐.

- Y축 (Depth Percent):

- 패스키가 텍스트 내에서 얼마나 깊이 위치해 있는지 나타냄.

- 0%는 컨텍스트의 시작부, 100%는 끝부분에 위치.

- 색상 (Score):

- 정보 검색 성공 여부를 나타냄.

- 초록색(1.0): 정확히 패스키를 검색함.

- 빨간색(0.0): 정보를 검색하지 못함.

2. 모델별 결과

(a) Llama3.1-Instruct 8B:

- 검색 성능이 매우 낮음.

- 깊이에 상관없이 대부분의 경우 패스키를 검색하지 못함(빨간색 영역).

(b) Llama3.1-Instruct 70B:

- 8B 모델보다는 나은 성능을 보이지만, 128K 전체 컨텍스트에서 여전히 패스키 검색이 어려움.

- 일부 얕은 깊이에서만 초록색 영역이 나타남.

(c) Llama3-ChatQA-2-8B:

- 검색 성능이 크게 향상됨.

- 컨텍스트 깊이에 상관없이 안정적으로 패스키를 검색할 가능성이 높음(초록색 비율이 넓음).

- 8B 모델임에도 Llama3.1-Instruct 70B보다 더 우수한 성능.

(d) Llama3-ChatQA-2-70B:

- 최고의 검색 성능을 보임.

- 패스키의 위치에 관계없이 128K 전체에서 패스키를 정확히 검색.

- 초록색 영역이 가장 넓으며, 긴 컨텍스트 처리에서도 안정적인 성능을 입증.

3. 주요 관찰

- 모델 크기와 검색 성능:

- 동일한 구조에서 매개변수가 많을수록 검색 성능이 향상됨(Llama3.1 8B vs 70B).

- ChatQA-2의 강점:

- ChatQA-2 모델(8B, 70B)은 Llama3.1-Instruct보다 뛰어난 검색 성능을 보임.

- 특히, ChatQA-2-70B는 컨텍스트 깊이에 상관없이 패스키를 안정적으로 검색.

- 긴 컨텍스트 처리:

- Llama3.1-Instruct 모델은 긴 컨텍스트(특히 128K)에서 성능이 급격히 저하됨.

- 반면, ChatQA-2 모델은 긴 컨텍스트에서도 성능 저하 없이 안정적으로 검색.

- 패스키 검색의 난이도:

- 패스키가 문서의 끝부분에 위치할수록 검색이 더 어려워짐.

- 하지만 ChatQA-2-70B는 이러한 어려움을 극복하고, 전 범위에서 높은 성능을 유지.

4. 결론

- ChatQA-2-70B는 긴 컨텍스트에서 가장 우수한 패스키 검색 성능을 보임.

- ChatQA-2 모델은 Llama3.1-Instruct 대비 성능 차이를 극복하며, 긴 문맥 정보 검색에서 강력한 도구임을 입증.

- 긴 컨텍스트 작업(예: 128K 토큰)에서 ChatQA-2 모델의 효율성과 안정성을 확인할 수 있음.

추가 질문이나 심층적인 분석이 필요하면 말씀해주세요!

'인공지능 > 자연어 처리' 카테고리의 다른 글

| 토큰 수 확인하기 (2) | 2025.01.13 |

|---|---|

| Chat QA1, Chat QA2 정리하면서 발전 가능성, 개선 점 생각해보기 (0) | 2025.01.03 |

| DEPS와 GITM 비교 (0) | 2024.11.27 |

| MoE란? - Mixture of Experts (2) | 2024.10.29 |

| Hugging face Chat-ui, Vllm으로 챗봇 만들기 (3) | 2024.10.28 |