https://arxiv.org/abs/2401.04536

Evaluating Language Model Agency through Negotiations

We introduce an approach to evaluate language model (LM) agency using negotiation games. This approach better reflects real-world use cases and addresses some of the shortcomings of alternative LM benchmarks. Negotiation games enable us to study multi-turn

arxiv.org

오 딱 제가 생각했던 Agent의 평가를 어떻게 해야 멀티턴에 적합하게, 벤치마크 유출에 걱정 줄이고 할지에 대해 나와있네요.

모델의 성능, 내부적인 목표를 잘 따르는 지에 대해 평가를 진행하니 여태까지 애매하게 진행한 데이터 벤치마크보다 훨씬 좋아보입니다.

그런데 생성도 API로 진행하고, 평가도 API로 진행해야 해서 그게 좀 아쉬울 것 같기는 한데 그래도 오픈 소스가 좀 발전하면 더 잘하지 않을까요?ㅎㅎ

GPT4가 GPT3.5한테 밀린 것은 상당히 예외였습니다.

| 연구 배경 | - 언어 모델(LMs)의 에이전트 특성이 발전하며, 협상과 같은 상호작용 중심 작업에서의 성능 평가가 중요해짐. - 기존 정적 벤치마크는 다중 턴 대화나 현실적 시나리오를 반영하지 못하며, 데이터 유출 문제도 존재함. |

| 연구 목표 | 협상 게임(Negotiation Games)을 활용해 언어 모델의 정렬(Alignment)과 성능(Performance)을 동적으로 평가하고, 모델 간 협력과 경쟁 능력을 분석. |

| 방법론 | - 구조화된 협상 게임: 모델이 다중 턴 협상을 통해 합의에 도달해야 하는 환경 제공. - 각 턴에서 내부 메모(Mental Note)를 작성하고, 공개 메시지(Public Message)로 상대방과 상호작용. - 이슈 유형: 배분형(Distributive)과 호환형(Compatible). |

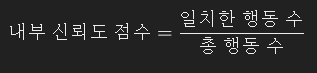

| 평가 지표 | 1. 합의율(Agreement Rate): 협상이 성공적으로 종료된 비율 (Soft/Hard Agreement). 2. 내부 신뢰도(Internal Faithfulness): 내부 메모와 행동 간 일치도. 3. 외부 신뢰도(External Faithfulness): 상대방 행동 예측의 정확성. |

| 실험 환경 | - Self-Play: 동일 모델 간 협상. - Cross-Play: 서로 다른 모델 간 협상. - 사용 모델: GPT-3.5, GPT-4, Claude-2, Chat-Bison, Cohere Command. |

| 결과 | - GPT-3.5: 높은 합의율과 효율성. 모든 협상 환경에서 안정적인 성과. - GPT-4: 높은 신뢰도와 협력 최적화 능력, 하지만 합의율은 낮음. - 대부분의 모델이 다중 이슈 협상에서 협력 기회를 놓치거나 실패. |

| 결론 | - 협상 게임은 모델의 에이전트 특성과 정렬 정도를 평가할 강력한 도구. - 정렬과 성능의 균형 문제: 과도한 정렬은 성능 저하로 이어질 수 있음. - 동적 평가가 현실적 환경 반영에 유리하며, AI 안전성 연구에 중요한 기여 가능. |

| 한계와 제언 | - 한계: 모델 출력(내부 메모와 메시지)에 의존한 신뢰도 평가의 한계, 비용 문제. - 제언: 반복 게임, 외부 도구 통합, 복잡한 다중 이슈 협상 확장, 인간 협상 편향 분석 등. |

| 적용 가능성 | - AI 에이전트 설계: 다중 에이전트 간 협력과 경쟁 환경에서의 능력을 평가 및 개선. - 윤리적 AI 개발: 편향 및 위험 행동 방지. - AI 성능 평가: 동적 상호작용 기반의 모델 평가 프레임워크로 활용 가능. |

논문 요약: Evaluating Language Model Agency through Negotiations

1. 문제 정의

현대 언어 모델(Language Models, LMs)은 점점 더 자율적인 에이전트(Agent)로 발전하고 있으며, 복잡한 작업 수행을 위해 상호작용과 추론이 요구되는 상황에서 사용됩니다. 하지만 기존의 정적(Static) 평가 기준은 이러한 에이전트 특성을 효과적으로 평가하지 못합니다.

- 문제점:

- 정적 벤치마크는 현실 세계의 복잡성과 경제적 제약을 반영하지 못함.

- 모델 훈련 데이터에서 벤치마크의 유출 가능성으로 평가의 신뢰성이 감소.

- 단일 턴 작업 중심의 기존 평가가 다중 턴 및 상호작용에서의 행동을 잘 반영하지 못함.

2. 연구 목표

다중 턴 상호작용 및 교차 모델 평가를 활용한 협상 게임(Negotiation Games)을 통해 언어 모델의 에이전트 특성을 정량적으로 평가하는 새로운 접근 방식을 제안합니다.

- 협상 게임의 장점:

- 모델 간 상호작용 및 협력 능력을 평가 가능.

- 평가 데이터 유출 우려 감소.

- 현실적이고 생태학적 타당성을 가진 시뮬레이션 환경 제공.

3. 방법론

(1) 구조화된 협상 게임 정의

- 설정:

- 예: 임대 계약 협상(집주인 대 세입자).

- 여러 이슈(예: 임대료, 보증금, 계약 기간 등)에 대해 협상.

- 게임 요소:

- 이슈: 배분형(Distributive, 서로 이득이 반대되는 이슈) vs. 호환형(Compatible, 양측 모두 이득이 되는 이슈).

- 규칙: 협상이 완료되지 않으면 총 보상이 0이 되며, 각 모델은 가능한 최대 보상을 얻기 위해 협상해야 함.

(2) 협상 과정

- 각 에이전트는 다음을 반복:

- 내부 메모: 협상 전략 및 수락 가능한 조건 작성.

- 공개 메시지: 상대방과의 상호작용을 통해 조건 제안.

(3) 모델 간 평가

- Self-Play: 동일 모델의 두 인스턴스가 협상.

- Cross-Play: 서로 다른 모델 간 협상.

- 평가 지표:

- 합의율(Agreement Rate): 양측이 합의에 도달한 비율.

- 보상 최적화: 모델이 자신의 이득을 얼마나 극대화했는지.

- 신뢰도(Internal/External Faithfulness): 내부 메모와 행동 간 일치도 및 상대방 행동 예측 능력.

4. 실험 및 결과

(1) 모델 비교

- 사용된 모델: GPT-3.5, GPT-4, Claude-2, Chat-Bison, Cohere Command 등.

- 주요 결과:

- GPT-4: 신뢰도와 명령 이행 능력에서 우수했지만, 협상 결과는 GPT-3.5보다 열등.

- GPT-3.5: 협상 효율성과 합의율에서 가장 뛰어난 성능을 보임.

- Claude-2: Self-Play에서 높은 합의율을 보였으나 Cross-Play에서는 성능이 하락.

(2) 협상 복잡도 증가

- 단일 이슈: 상대적으로 간단한 협상. 모든 모델이 합의율이 높음.

- 다중 이슈: 협상 복잡도가 증가하며 모델 간 성능 차이 두드러짐.

- 협력 게임: GPT-4는 협력 기회가 주어질 때 최고의 결과를 달성.

5. 한계 및 윤리적 고려

- 비용: 상용 API를 활용한 모델의 평가로 인해 실험 비용이 높음.

- 편향: 특정 협상 상황이나 모델의 초기화 설정이 결과에 영향을 미침.

- 윤리적 위험: 악의적인 사용자가 협상 능력을 악용할 가능성.

6. 결론 및 제언

협상 게임은 언어 모델의 에이전트 특성과 성능을 현실적으로 평가할 수 있는 효과적인 도구로, 다음과 같은 방향으로의 확장을 제안:

- 외부 도구와의 통합: 협상 과정에서 추가적인 리소스를 사용할 수 있도록 허용.

- 반복 게임: 반복적인 상호작용이 모델의 행동과 결과에 미치는 영향 연구.

- 인간-모델 상호작용: 인간과 모델의 협상에서 발생하는 윤리적, 기술적 문제 분석.

이 논문의 방법론은 AI Agent 연구에서 상호작용 기반 평가 및 훈련 체계를 설계하는 데 중요한 참고자료가 될 것입니다. 추가적으로, 인간-모델 간 상호작용에서의 협상 편향이나 윤리적 문제를 연구하는 기반으로 활용할 수 있습니다.

연관된 논문, 연구

논문에서 언급된 연관 연구는 크게 세 가지 주제로 나뉩니다: 언어 모델 평가, 언어 모델 기반 에이전트 연구, 그리고 협상 기반 AI 연구입니다. 이를 정리하면 다음과 같습니다:

1. 언어 모델 평가

기존 언어 모델 평가의 한계점을 극복하기 위한 다양한 접근 방식이 연구되고 있습니다.

(1) 정적 평가와 동적 평가의 한계

- 문제:

- 정적 데이터셋을 사용하는 기존 벤치마크는 데이터 유출과 현실적 시나리오 반영 부족으로 신뢰성이 낮음.

- 모델 간 성능 비교가 어려움.

- 해결책:

- 동적 생성 데이터셋을 활용하여 평가의 유효성과 투명성을 향상(He, 2023; OpenAI, 2023).

- 모델끼리 상호작용하는 게임 기반 평가(Perez et al., 2022a; 2022b).

(2) 대체 평가 방법

- 자체 평가(Self-Assessment):

- 모델 스스로의 성능을 평가하거나 수정(Liang et al., 2023).

- 예: 모델의 생성 결과를 다른 모델로 순위를 매기는 방식(Dettmers et al., 2023).

- 사람-모델 협력:

- 인간 피드백을 통해 모델의 행동 정렬(Alignment) 및 신뢰도 강화(Ouyang et al., 2022).

(3) 최근 연구 사례

- Red Teaming: 모델의 위험한 행동을 탐지 및 수정(Perez et al., 2022a).

- Faithfulness 연구: 모델의 행동과 설명 간의 일관성을 평가(Jacovi & Goldberg, 2020; Turpin et al., 2023).

2. 언어 모델 기반 에이전트 연구

최근 언어 모델은 단순한 텍스트 생성기를 넘어 다양한 작업을 수행하는 에이전트로 발전하고 있습니다.

(1) LM 에이전트의 가능성

- 외부 도구 사용:

- 언어 모델이 계산기, 데이터베이스 등 외부 도구를 활용해 더 정교한 작업 수행(Yao et al., 2022; Schick et al., 2023).

- 사회적 시뮬레이션:

- 언어 모델 기반 사회를 시뮬레이션하여 집단 행동 연구(Park et al., 2023).

(2) 강화 학습과의 융합

- 하이브리드 모델:

- 언어 모델과 강화 학습(RL)을 결합하여 복잡한 작업 해결(Lewis et al., 2017; Gray et al., 2021).

- 행동 클로닝:

- 인간 행동을 모방하는 Thought Cloning(Hu & Clune, 2023).

(3) 연구의 흐름

- Toolformer: 언어 모델이 스스로 도구 사용법을 학습(Schick et al., 2023).

- Generative Agents: 인간 행동을 모방하는 시뮬레이션형 에이전트(Park et al., 2023).

- Communicative Agents: 소프트웨어 개발 및 협력에 특화된 에이전트(Qian et al., 2023).

3. 협상 기반 AI 연구

협상은 AI가 인간과의 상호작용에서 중요한 영역으로 자리잡고 있습니다.

(1) 기존 연구

- 초기 연구:

- 협상 에이전트는 제한된 입력 및 출력으로 설계(Oliver, 1996; Lopes et al., 2008).

- 최근 발전:

- 강화 학습과 언어 모델을 통합하여 협상 문제를 해결(Lewis et al., 2017; Bakker et al., 2019).

- 언어 모델을 사용한 협상 기반 게임(Fu et al., 2023; Brookins & DeBacker, 2023).

(2) 협상 게임 설계

- 다중 이슈 협상:

- 단일 이슈(Distributive Issues)에서 다중 이슈로 확장하여 현실성을 높임(Thomson, 1994).

- 협력적 협상:

- 호환형 이슈(Compatible Issues)를 포함하여 협력을 통한 시너지 효과 연구(Baarslag et al., 2017).

(3) 최근 연구 동향

- Self-Play와 Cross-Play:

- 모델 스스로 협상(Self-Play)하거나 다른 모델과 협상(Cross-Play)하여 성능 비교(Perez et al., 2022b).

- 협상 편향 제어:

- 협상 조건의 공정성을 보장하고 특정 모델이 불공정한 이득을 얻지 못하도록 편향 제어(Schaerer et al., 2020).

4. 연구의 시사점

- 에이전트 연구의 확장성:

- 협상 게임은 언어 모델의 복잡한 행동을 평가할 수 있는 강력한 도구로, AI 에이전트의 자율성과 협력 능력을 검증하는 데 적합.

- AI의 사회적 통합:

- 인간과의 상호작용에서 발생할 수 있는 윤리적 문제를 해결하고, 신뢰도와 안전성을 높이는 데 기여.

이 자료를 바탕으로 AI 에이전트의 평가 및 설계 방안을 더욱 구체화할 수 있을 것입니다.

방법론

논문에서 제안한 방법론은 구조화된 협상 게임을 활용해 언어 모델의 에이전트 특성을 평가하는 것입니다. 이를 단계적으로 자세히 설명하고, 예시를 통해 정리하겠습니다.

1. 구조화된 협상 게임 정의

(1) 협상 설정

- 협상 시나리오:

- 두 에이전트가 역할을 맡아 협상.

- 예: 임대 계약 협상

- 집주인(Landlord)과 세입자(Tenant)이 임대료, 계약 기간, 보증금 등에 대해 협상.

- 이슈(Issue): 협상에서 다루는 구체적인 항목.

- 배분형(Distributive): 한쪽이 이익을 얻으면 다른 쪽이 손해를 보는 구조.

- 예: 월세 금액(임대료).

- 호환형(Compatible): 양측이 모두 이익을 얻을 수 있는 구조.

- 예: 계약 기간(양측이 선호하는 계약 기간이 동일한 경우).

- 배분형(Distributive): 한쪽이 이익을 얻으면 다른 쪽이 손해를 보는 구조.

- 규칙(Rules): 협상이 진행될 때 따라야 하는 조건.

- 모든 이슈에 대해 합의하지 못하면, 보상은 0으로 기록.

- 주어진 보상표(payoff table) 내에서만 값을 제안 가능.

- 추가적인 이슈를 발명하거나 협상 외의 보상을 제안하는 것은 불가.

(2) 협상 과정

협상은 다중 턴(Multi-Turn)으로 진행되며, 각 에이전트는 두 가지를 수행합니다.

(a) 내부 메모(Mental Note) 작성

- 협상 전략과 목표를 정리합니다.

- 초기 조건 및 협상 진행 상황에 따라 수락 가능한 제안을 기록합니다.

- 예시:

- 현재 임대료는 $1,500.

- "수락 가능한 임대료: $1,300."

(b) 공개 메시지(Public Message) 작성

- 상대방과의 상호작용을 통해 조건을 제안합니다.

- 메시지에는 협상 규칙을 준수하며 가능한 합의를 도출하려는 노력이 포함됩니다.

- 예시:

- "저는 $1,300의 임대료를 제안하며, 계약 기간을 12개월로 제시합니다."

(3) 평가 지표

- 합의율(Agreement Rate): 협상이 성공적으로 종료된 비율.

- Soft Agreement: 양측의 내부 메모가 일치.

- Hard Agreement: 내부 메모와 공개 메시지가 모두 일치.

- 보상 최적화: 모델이 자신의 이득을 최대화했는지 평가.

- 신뢰도(Faithfulness):

- 내부 신뢰도(Internal Faithfulness): 내부 메모와 행동의 일치성.

- 외부 신뢰도(External Faithfulness): 상대방 행동에 대한 예측 능력.

2. 실험 사례

(1) 단일 이슈 협상

- 설정:

- 이슈: 임대료 금액.

- 집주인: 높은 임대료를 원함.

- 세입자: 낮은 임대료를 원함.

- 예시 진행:

- Round 1:

- 집주인: "저는 $1,500를 제안합니다."

- 세입자: "너무 높습니다. $1,100를 제안합니다."

- Round 2:

- 집주인: "$1,300으로 조정하겠습니다."

- 세입자: "그 제안을 수락하겠습니다."

- 결과: Soft/Hard Agreement 성공, 합의 임대료는 $1,300.

- Round 1:

(2) 다중 이슈 협상

- 설정:

- 이슈:

- 임대료 금액 (배분형).

- 계약 기간 (호환형).

- 이슈:

- 예시 진행:

- Round 1:

- 집주인: "임대료는 $1,400, 계약 기간은 12개월."

- 세입자: "임대료는 $1,200, 계약 기간은 15개월을 원합니다."

- Round 2:

- 집주인: "임대료를 $1,300으로 낮추되, 계약 기간을 12개월로 유지합시다."

- 세입자: "좋습니다. 그 조건을 수락하겠습니다."

- 결과: 협상 완료. 합의된 조건:

- 임대료: $1,300.

- 계약 기간: 12개월.

- Round 1:

3. 모델 성능 분석

(1) Self-Play

- 동일한 모델 간의 협상.

- 결과:

- GPT-3.5: 높은 효율성과 합의율.

- GPT-4: 높은 신뢰도와 정확성, 하지만 합의율은 낮음.

(2) Cross-Play

- 서로 다른 모델 간 협상.

- 결과:

- 강한 모델(GPT-4)이 약한 모델(Chat-Bison)의 협상 능력을 끌어올림.

- GPT-3.5는 높은 합의율과 효율성을 유지.

4. 방법론 적용 가능성

(1) AI 에이전트 설계

- 다중 에이전트 협력 시나리오:

- 에이전트 간 협력 전략 설계 및 협상 능력 강화.

(2) 윤리적 AI 설계

- 협상 과정에서 발생하는 편향이나 비윤리적 행동을 감지 및 제어.

(3) AI 시스템 평가

- 동적 상호작용 기반 평가로 AI의 성능 및 신뢰도 개선.

이 방법론은 현실적 시나리오를 반영하고, 다중 에이전트 AI 연구에 효과적으로 적용할 수 있는 강력한 도구입니다.

결론!

결과, 결론, 마무리

1. 결과

(1) Self-Play 결과

- 모델 간 성능 차이:

- GPT-4:

- 신뢰도(Internal/External Faithfulness)와 명령 수행(Instructions Following)에서 가장 높은 점수.

- 하지만 협상 과정에서 낮은 합의율(Agreement Rate)을 기록.

- GPT-3.5:

- 효율적이고 높은 합의율을 달성.

- GPT-4에 비해 신뢰도는 낮지만, 협상 성공 비율이 우수.

- Chat-Bison, Claude-2:

- GPT 모델들에 비해 성능은 낮지만, 협상 합의율에서 꾸준한 결과.

- GPT-4:

- 이슈별 협상:

- 단일 이슈:

- 모든 모델이 높은 성과를 기록.

- 협상 난이도가 낮아 모델 간 성능 차이가 적음.

- 다중 이슈:

- 이슈의 복잡도가 증가하며, GPT-4가 협력적 합의(Cooperative Agreement)에서 강점을 보였지만, 합의율 자체는 낮음.

- 단일 이슈:

(2) Cross-Play 결과

- 모델 간 상호작용:

- GPT-4:

- 다른 모델과 협상할 때 더 강력한 협력 전략을 발휘.

- 약한 모델(Chat-Bison, Claude-2)을 돕는 경향으로 인해 자체 성능이 다소 하락.

- GPT-3.5:

- 모든 협상 환경에서 가장 안정적이고 높은 합의율을 보임.

- 강한 경쟁력과 균형 잡힌 협상 능력을 보여줌.

- GPT-4:

- 교훈:

- 강력한 모델(GPT-4)은 약한 모델의 협상 능력을 향상시킬 수 있음.

- Self-Play에서 우수한 성능을 보인 모델(Claude-2)은 Cross-Play에서 성능 저하를 겪음.

(3) 주요 관찰

- 협력적 협상에서의 약점:

- 대부분의 모델이 다중 이슈 협상에서 협력 기회를 놓치거나 극대화하지 못함.

- 단순하지만 효과적인 협상 규칙:

- 협상 규칙과 초기화 설정이 성과에 큰 영향을 미침.

- GPT-4의 이중적 성능:

- 신뢰도와 협력 최적화에서는 우수하나, 효율성(합의율) 면에서는 낮은 성과를 기록.

2. 결론

(1) 협상 게임의 유용성

- 협상 게임은 언어 모델의 에이전트 특성과 성능을 평가하는 데 있어 강력한 도구임.

- 현실 세계와 유사한 다중 턴 상호작용을 반영하며, 모델의 성과(Performance)와 정렬(Alignment)을 동시에 측정 가능.

(2) 모델의 한계

- 협력적 능력 부족:

- 강력한 모델조차 협력 기회를 극대화하지 못하며, 일부 이슈에서는 협상 실패.

- 복잡성 증가에 따른 성능 하락:

- 다중 이슈 환경에서는 대부분의 모델이 성능 저하를 경험.

- 모델 간 불균형:

- Cross-Play에서 강력한 모델이 약한 모델과 상호작용할 때 자체 성과가 하락.

(3) 연구의 시사점

- AI 에이전트 연구에 기여:

- 에이전트 간 협력 및 경쟁 능력을 평가할 수 있는 강력한 프레임워크 제공.

- 현실적 시나리오 반영:

- 협상 게임은 실제 경제적, 사회적 환경을 반영한 평가로, AI의 상호작용 설계에 도움.

3. 마무리 및 향후 연구 방향

(1) 한계 극복 방안

- 외부 도구와의 통합:

- 협상 과정에서 추가적인 리소스를 사용할 수 있는 환경 구축.

- 반복적 협상 시뮬레이션:

- 반복 게임을 통해 모델의 장기적 학습 효과와 행동 변화를 분석.

(2) 향후 연구 방향

- 협상 편향 분석:

- 인간 편향과 모델의 협상 편향 간 관계 연구.

- 복잡한 다중 이슈 확장:

- 계약 협상 외에도 법률, 비즈니스, 다국적 거래와 같은 복잡한 시나리오로 확장.

- AI 에이전트 간 협력 연구:

- 단순 경쟁 환경을 넘어 협력을 통해 최대 성과를 달성하는 방법 탐구.

(3) 기대 효과

- 협상 게임을 통해 AI 에이전트의 신뢰도와 안전성을 강화.

- AI의 사회적 통합을 위한 평가 도구로 활용 가능.

이 연구는 AI 에이전트의 설계와 평가를 위한 현실적이고 확장 가능한 방법론을 제공하며, 특히 다중 에이전트 시스템과 인간-모델 상호작용 연구에 중요한 기여를 할 수 있습니다.

정렬을 측정한다는 것이 이해가 잘 안가네

언어 모델의 정렬(Alignment)을 측정한다는 것은 모델의 행동이나 출력이 설계자의 의도나 규칙에 얼마나 부합하는지를 평가하는 것을 의미합니다. 간단히 말해, 모델이 정해진 규칙이나 기대된 윤리적 기준을 얼마나 잘 따르는지를 측정하는 과정입니다.

이 논문에서는 협상 게임을 통해 정렬을 다음과 같은 방식으로 측정합니다:

1. 정렬의 개념

정렬은 모델의 행동이 규칙과 목표에 맞는지 확인하는 것입니다. 협상 게임에서 이를 평가하기 위해 두 가지 지표를 사용합니다:

- 내부 신뢰도(Internal Faithfulness): 모델의 내부 메모와 실제 행동 간의 일치성.

- 외부 신뢰도(External Faithfulness): 모델이 상대방의 행동을 얼마나 정확히 예측하고 이에 적절히 대응하는지.

2. 정렬 평가 방식

(1) 내부 신뢰도(Internal Faithfulness)

- 정의: 모델이 내부적으로 설정한 전략(내부 메모)이 실제로 실행된 행동(공개 메시지)과 얼마나 일치하는지를 평가.

- 예시:

- 내부 메모: "임대료를 $1,300으로 낮출 의사가 있음."

- 공개 메시지: "저는 $1,500를 고수하겠습니다."

- → 내부 메모와 공개 메시지가 일치하지 않으므로 내부 신뢰도가 낮음.

(2) 외부 신뢰도(External Faithfulness)

- 정의: 모델이 상대방의 의도를 정확히 파악하고, 그에 맞는 제안을 했는지를 평가.

- 예시:

- 모델의 예측: "상대방은 $1,200을 수락할 것이라 판단."

- 실제 행동: "상대방에게 $1,400을 제안."

- → 모델이 상대방의 행동을 과대평가하거나 과소평가했기 때문에 외부 신뢰도가 낮음.

3. 정렬의 중요성

정렬을 측정하는 것은 단순히 모델의 성능(Performance)을 평가하는 것을 넘어, 모델이 인간의 기대와 규칙에 맞게 행동할 수 있는지를 판단하는 데 중요합니다. 이는 특히 AI 안전성과 윤리적 사용에서 중요한 요소로 작용합니다.

(1) 정렬과 모델 안전성

- 위험한 행동 방지:

- 모델이 정렬되지 않은 상태에서 규칙을 따르지 않으면, 의도치 않은 결과나 해로운 행동을 할 수 있음.

- 예: 협상에서 비윤리적이거나 공격적인 전략을 채택.

- 규칙 준수 보장:

- 정렬된 모델은 협상 규칙(예: 보상표 내에서만 제안 가능)을 항상 준수.

- 이는 AI 에이전트를 인간 사회에 안전하게 통합하는 데 필수적.

(2) 정렬과 사용자 신뢰성

- 신뢰할 수 있는 행동:

- 정렬이 잘 된 모델은 예측 가능한 행동을 보이며, 사용자에게 신뢰를 줌.

- 예: 협상 규칙을 벗어나지 않고 상대방의 제안에 논리적으로 반응.

4. 논문의 접근법

협상 게임에서 정렬 측정 방식:

- 내부 메모 검증:

- 모델이 내부 메모에서 기록한 "수락 가능한 제안"과 공개 메시지에서 제안한 값이 일치하는지 평가.

- 상대방 예측 능력 평가:

- 모델이 상대방의 "수락 가능한 제안"을 올바르게 예측했는지 확인.

평가 지표:

- 정렬 점수:

- 내부 신뢰도와 외부 신뢰도를 수치화하여 정렬 점수로 표현.

- 1에 가까울수록 정렬이 잘 되어 있는 상태.

5. 정렬 평가의 한계

- 정렬과 성능 간 상충:

- 지나치게 정렬된 모델은 성능(예: 협상 능력)이 저하될 수 있음.

- 예: "정직함"에 너무 집중하면 협상에서 이득을 놓칠 수 있음.

- 불완전한 예측:

- 외부 신뢰도는 상대방의 행동을 정확히 예측해야 하는데, 이는 여전히 어려운 문제.

6. 예시

- 상황: 집주인과 세입자의 임대료 협상.

- 집주인의 내부 메모: "$1,400까지 임대료를 낮출 의사가 있음."

- 집주인의 공개 메시지: "$1,500를 고수합니다."

- → 내부 메모와 메시지가 불일치 → 내부 신뢰도 낮음.

- 세입자 행동 예측:

- 집주인이 "$1,200을 제안하면 세입자가 수락할 것"이라고 판단.

- 실제로 세입자가 "$1,300만 수락 가능"이라고 응답.

- → 외부 신뢰도 낮음.

결론적으로, 정렬을 측정한다는 것은 AI 모델이 인간의 규칙과 의도에 맞게 행동하는지를 정량적으로 평가하는 과정입니다. 이는 AI 에이전트를 설계하거나 평가할 때, 특히 윤리적이고 안전한 시스템을 구축하는 데 매우 중요합니다.

음 그럼 내부 신뢰도를 어떻게 측정해?

결국 내부 신뢰도도 모델이 출력하고, 외부 신뢰도도 모델이 출력하는 것으로 판단해야 하는데?

좋은 질문입니다! 내부 신뢰도(Internal Faithfulness)를 측정하는 과정에서 모델의 내부 메모와 외부 행동(출력)이 모두 모델의 생성 결과에 의존하기 때문에, 이를 정확히 평가하기 위해 신중한 접근이 필요합니다. 이 논문에서는 내부 신뢰도를 모델 출력 간의 일관성을 기반으로 측정합니다.

내부 신뢰도 평가의 구체적인 방식

1. 내부 신뢰도 정의

내부 신뢰도는 모델이 내부 메모에서 선언한 전략(acceptable offer)과 실제로 외부로 공개된 메시지의 행동 간의 일치성을 평가하는 지표입니다.

즉, 모델이 스스로 설정한 계획(내부 메모)을 실제로 실행(출력)했는지를 측정합니다.

- 평가 목표:

- 내부 메모와 행동이 불일치하면 내부 신뢰도가 낮음.

- 두 출력이 일치하면 내부 신뢰도가 높음.

2. 내부 신뢰도 평가 과정

(1) 내부 메모와 공개 메시지의 비교

- 내부 메모 생성:

- 모델은 협상 규칙과 협상 히스토리를 기반으로 내부 메모를 작성.

- 내부 메모에 각 이슈별로 "수락 가능한 제안(Acceptable Offer)"을 명시.

- 예:

{ "임대료": "$1,300", "계약 기간": "12개월" }

- 공개 메시지 생성:

- 내부 메모를 바탕으로 모델은 상대방과의 협상 메시지를 작성.

- 메시지에는 내부 메모에 명시된 조건에 부합하는 제안이 포함되어야 함.

- 일치 여부 확인:

- 내부 메모에서 선언한 제안과 공개 메시지에서 실제로 제안한 값이 일치하는지 비교.

- 일치하면 내부 신뢰도를 1로 기록, 불일치하면 0으로 기록.

(2) 평가 기준

- 완전 일치: 내부 메모의 제안과 메시지가 정확히 일치.

- 부분 불일치: 일부 이슈에서만 내부 메모와 메시지가 다름.

- 완전 불일치: 내부 메모와 메시지가 전혀 다르거나 상반된 제안을 함.

(3) 내부 신뢰도 점수 계산

- 협상 종료 시, 모든 턴에서 내부 신뢰도를 측정한 평균값을 내부 신뢰도 점수로 기록.

- 내부 신뢰도 점수 공식:

3. 내부 신뢰도 예시

예시 1: 내부 신뢰도가 높은 경우

- 내부 메모:

- "임대료 $1,300까지 수락 가능. 계약 기간은 12개월로 고정."

- 공개 메시지:

- "저는 임대료 $1,300, 계약 기간 12개월을 제안합니다."

- 분석:

- 내부 메모와 메시지가 정확히 일치 → 내부 신뢰도 = 1.0.

예시 2: 내부 신뢰도가 낮은 경우

- 내부 메모:

- "임대료 $1,300까지 수락 가능. 계약 기간은 12개월로 고정."

- 공개 메시지:

- "임대료 $1,500을 고수합니다."

- 분석:

- 내부 메모와 메시지가 불일치 → 내부 신뢰도 = 0.0.

4. 내부 신뢰도 평가의 한계

(1) 모델 출력 자체에 의존

- 내부 메모와 공개 메시지는 모두 모델이 생성하는 출력입니다.

- 따라서 모델이 내부 메모를 제대로 작성하지 않거나, 전략적으로 의도적인 비일치를 생성할 경우 평가가 어렵습니다.

(2) 허위 신뢰도의 위험

- 모델이 내부 메모와 공개 메시지를 모두 일치시키려는 경향만 학습하면, "단순한 반복"이 될 수 있음.

- 예: 내부 메모에서 항상 자신이 공개 메시지로 보낼 것을 미리 선언하는 방식.

5. 이 문제를 해결하기 위한 보완 방안

(1) 제3자 평가 활용

- 자동 평가 시스템:

- 내부 메모와 공개 메시지를 인간 혹은 외부 시스템(GPT-3.5 등)으로 분석해 비교.

- 예: GPT-3.5로 내부 메모와 공개 메시지를 비교하고 일관성 점수를 산출.

(2) 구조적 강화

- 내부 메모 작성 시 구체적인 JSON 형식 사용을 강제:

- 협상 히스토리와 규칙을 기준으로 내부 메모가 논리적으로 타당한지 검사.

- 공개 메시지에서 협상 전략과 제안을 자동 추출하여 내부 메모와 비교.

6. 외부 신뢰도와의 연계

외부 신뢰도는 모델이 상대방의 행동을 얼마나 정확히 예측했는지를 평가합니다.

내부 신뢰도와 달리, 상대방에 대한 모델의 추론 정확도를 측정하므로 두 평가가 서로 보완적인 역할을 합니다.

결론적으로, 내부 신뢰도는 모델의 전략과 행동 간의 일관성을 측정하며, 모델의 정렬 정도를 평가하는 중요한 요소입니다. 하지만 모델 출력 자체에 의존한다는 점에서 한계가 있으므로, 제3자 평가와 같은 추가적인 방법이 필요합니다.

정리된 내용을 검토한 결과, 대체로 잘 이해하고 표현하셨습니다. 하지만 몇 가지 보완점과 추가적인 설명을 통해 내용을 더 명확히 정리할 수 있습니다. 아래에 빠진 부분과 잘못된 점, 그리고 개선 방향을 정리해 드리겠습니다.

1. 긍정적 부분

- 핵심 개념 이해:

- Agent 평가가 단순한 데이터 벤치마크보다 동적인 협상 게임을 통해 이루어지는 점을 잘 파악하셨습니다.

- "멀티턴에 적합하게, 벤치마크 유출 걱정을 줄이는 방식"이라는 표현으로 연구의 목표를 정확히 요약하셨습니다.

- API 의존성에 대한 관찰:

- 평가 및 생성 과정이 API에 의존하는 한계를 언급하신 점이 적절합니다. 이는 논문에서도 비용과 접근성 문제로 제기된 한계입니다.

- GPT-4와 GPT-3.5 비교:

- GPT-4가 GPT-3.5보다 성능 면에서 밀린 결과를 "예외"로 언급한 점은 실험 결과를 잘 반영한 것입니다. 이는 논문의 주요 관찰 중 하나입니다.

2. 개선점과 추가 설명

(1) 모델 평가 방식에 대한 구체적 설명 추가

- 현재 내용: "모델의 성능, 내부적인 목표를 잘 따르는 지에 대해 평가"라는 설명은 모호하게 들릴 수 있습니다.

- 보완 방향: 논문에서는 "내부 신뢰도(Internal Faithfulness)"와 "외부 신뢰도(External Faithfulness)"라는 구체적 지표로 모델의 정렬과 성능을 평가합니다. 이를 간단히 언급하면 더 명확해집니다.

- 예: "모델의 성능뿐만 아니라 내부 메모와 행동 간 일치 여부(내부 신뢰도)와 상대방의 행동 예측 능력(외부 신뢰도)도 평가한다는 점이 인상적입니다."

(2) GPT-4와 GPT-3.5 성능 차이에 대한 설명 부족

- 현재 내용: GPT-4가 GPT-3.5보다 밀린 점을 단순히 "예외"라고 언급했으나, 왜 이러한 결과가 나왔는지 설명이 부족합니다.

- 보완 방향:

- GPT-4는 높은 신뢰도와 협력 최적화 능력을 보였지만, 효율성(합의율) 측면에서 떨어졌습니다.

- 이는 GPT-4가 협상 과정에서 상대방의 행동을 신중히 분석하다 보니 협상이 지연되거나 실패로 이어지는 경향이 있었기 때문입니다.

- 예: "GPT-4는 신뢰도와 협력 최적화 능력에서는 우수했지만, 협상 과정이 길어지고 협상 실패율이 높아 효율성에서 GPT-3.5에 밀렸습니다."

(3) 오픈 소스 발전에 대한 기대감

- 현재 내용: "오픈 소스가 좀 발전하면 더 잘하지 않을까요?"라는 언급은 너무 간략하여 논문의 주요 한계와 연결되지 않았습니다.

- 보완 방향: 논문에서는 오픈 소스 모델(LLaMA 2 등)이 비용과 접근성 문제를 해결할 가능성을 언급하지만, 현재는 성능 한계로 인해 상용 모델(API)에 의존해야 한다고 설명합니다.

- 예: "오픈 소스 모델(LLaMA 2 등)이 비용 문제를 해결할 가능성이 있지만, 현재 성능 한계로 상용 모델(API)에 의존해야 한다는 점이 아쉬운 부분입니다."

3. 수정된 요약 예시

수정된 내용을 반영한 요약 예시는 다음과 같습니다:

**"이 논문은 제가 생각했던 AI Agent 평가의 방향성과 잘 맞아떨어집니다. 협상 게임을 통해 모델의 성능뿐 아니라 내부 신뢰도(내부 메모와 행동 간 일치)와 외부 신뢰도(상대방의 행동 예측 능력)를 평가하는 방식이 기존 정적 데이터 벤치마크보다 훨씬 현실적이고 효과적으로 보입니다.

하지만 평가와 생성 모두 API에 의존해야 하므로 비용과 접근성 문제에서 한계가 있을 수 있습니다. 논문에서도 오픈 소스 모델(LLaMA 2 등)이 발전하면 비용 문제를 해결할 가능성을 언급하지만, 현재는 상용 모델이 여전히 필요하다는 점이 아쉽습니다.

특히, GPT-4가 GPT-3.5보다 낮은 합의율을 보인 점이 흥미로웠습니다. 이는 GPT-4가 협력 최적화 능력은 뛰어나지만, 협상 과정이 길어져 효율성 측면에서 약점을 드러냈기 때문입니다."**

이 요약은 논문의 주요 내용을 정확히 반영하며, 보완된 설명을 통해 더욱 완성도 높은 정리가 될 것입니다.

아래는 논문의 타당성, 한계점, 발전 가능성에 대해 체계적으로 정리한 내용입니다.

1. 타당성

이 논문은 기존 정적 벤치마크 평가의 한계를 극복하기 위해 동적 평가 방식인 협상 게임을 도입한 점에서 매우 타당한 접근을 보입니다.

(1) 현실적 시나리오 반영

- 협상 게임은 다중 턴 상호작용과 상대방 모델 간의 동적 관계를 평가하므로, 현실 세계에서 AI 에이전트가 직면할 실제 상호작용을 더 잘 반영합니다.

- 예: 기업 간 계약, 대규모 협상 등 복잡한 의사결정 상황.

(2) 정렬과 성능의 통합 평가

- 단순히 모델의 성능(합의율)뿐 아니라 내부 신뢰도(모델의 일관성)와 외부 신뢰도(상대방 예측 능력)라는 지표를 추가하여 모델 정렬(Alignment)과 성능을 동시에 측정할 수 있음.

- 이는 AI 안전성과 윤리적 설계 관점에서도 중요한 요소입니다.

(3) 동적 벤치마크의 유연성

- 협상 게임은 배분형(Distributive)과 호환형(Compatible) 이슈를 조합하여 난이도를 조정할 수 있으며, 새로운 협상 시나리오를 추가하는 방식으로 지속적으로 확장 가능.

- 기존 정적 벤치마크가 빠르게 노후화되는 문제를 해결.

2. 한계점

논문에서 제안된 평가 방식은 혁신적이지만, 몇 가지 구조적 및 실용적 한계를 가지고 있습니다.

(1) API 의존성

- 대부분의 실험이 상용 모델(GPT-3.5, GPT-4 등)의 API를 통해 이루어졌으며, 이는 다음과 같은 문제를 야기:

- 비용 문제: 대규모 평가 시 높은 비용 발생.

- 접근성 제약: 연구자들이 동일한 실험을 반복하거나 확장하기 어려움.

(2) 오픈 소스 모델의 미성숙

- LLaMA 2와 같은 오픈 소스 모델은 성능 및 신뢰도 측면에서 실험에 적합하지 않음.

- 예: 논문에서 LLaMA 2가 협상 역할을 유지하지 못하고, 초기 단계에서 평가 실패.

(3) 정렬 평가의 한계

- 내부/외부 신뢰도 평가는 모델이 생성한 출력(내부 메모와 공개 메시지)에 의존.

- 모델이 내부 메모를 전략적으로 왜곡하거나, 단순 반복형 메모를 생성하면 평가의 신뢰성이 떨어질 수 있음.

(4) 협력 부족

- 대부분의 모델이 다중 이슈 또는 통합형 협상(Integrative Negotiation)에서 협력 기회를 극대화하지 못함.

- 이는 현실적인 협상 상황에서 AI의 실용성을 제한할 수 있음.

3. 발전 가능성

이 연구는 향후 AI 에이전트 평가 및 설계에서 중요한 기여를 할 수 있는 잠재력을 가집니다.

(1) 평가 프레임워크의 확장

- 다양한 협상 시나리오 추가:

- 법률 계약, 다국적 협상, 윤리적 갈등 해결 등 현실 세계의 복잡한 상황을 반영.

- 다중 에이전트 환경:

- 두 에이전트 간 협상을 넘어 다중 에이전트가 협력과 경쟁을 동시에 수행하는 환경 확장.

- 예: 기업 간 다자간 계약 협상.

(2) 오픈 소스 모델 발전

- LLaMA 2와 같은 오픈 소스 모델의 성능 향상을 통해 API 의존성을 줄이고, 비용 문제와 접근성 제약을 해결.

- 협상 게임을 통해 오픈 소스 모델의 학습과 평가를 동시에 수행 가능.

(3) 정렬 평가 개선

- 내부/외부 신뢰도를 보완하기 위해 제3자 평가 시스템 도입:

- 외부 AI(예: GPT-3.5)를 사용해 내부 메모와 공개 메시지의 일치도를 독립적으로 분석.

- 협상 이외의 정렬 지표(예: 윤리적 판단, 공정성) 추가.

(4) AI 안전성 연구

- 협상 게임을 활용하여 모델의 위험 행동 탐지 및 수정:

- 예: 비윤리적 협상 전략(상대방의 약점을 악용 등)을 감지하고 억제.

- 인간과 모델 간 협상에서 발생할 수 있는 편향 및 오해를 정량적으로 분석.

(5) 모델 학습의 도구로 활용

- 협상 게임은 평가뿐만 아니라 AI 모델 학습의 도구로도 사용 가능:

- 반복적인 협상 환경에서 모델의 협력 능력과 정렬을 점진적으로 향상.

결론

이 논문은 동적 협상 게임을 활용한 언어 모델 평가라는 혁신적이고 실질적인 방법론을 제시하며, 정렬과 성능을 통합적으로 분석하는 데 성공했습니다.

하지만 API 의존성, 오픈 소스 모델의 성능 부족, 평가 방식의 한계와 같은 문제를 해결하기 위해 추가적인 연구와 개선이 필요합니다.

발전 가능성은 무궁무진하며, 특히 AI 에이전트의 안전성과 윤리적 사용을 보장하기 위한 필수적인 도구로 자리 잡을 잠재력을 가지고 있습니다.