https://arxiv.org/abs/2402.01097

Let's Negotiate! A Survey of Negotiation Dialogue Systems

Negotiation is a crucial ability in human communication. Recently, there has been a resurgent research interest in negotiation dialogue systems, whose goal is to create intelligent agents that can assist people in resolving conflicts or reaching agreements

arxiv.org

이 논문은 협상 대화 시스템의 발전을 체계적으로 정리하며, 방법론, 데이터셋, 평가 방식 및 한계점을 다룸

협상은 인간의 감정적 편향, 전략 부족, 암묵적 정보 파악 실패 등으로 최적의 결과를 얻기 어려운 문제를 지니고 있으며, 이를 해결하기 위해 AI 기반 협상 에이전트를 개발

주요 접근법으로는 전략 모델링, 협상자 모델링, 행동 학습이 포함

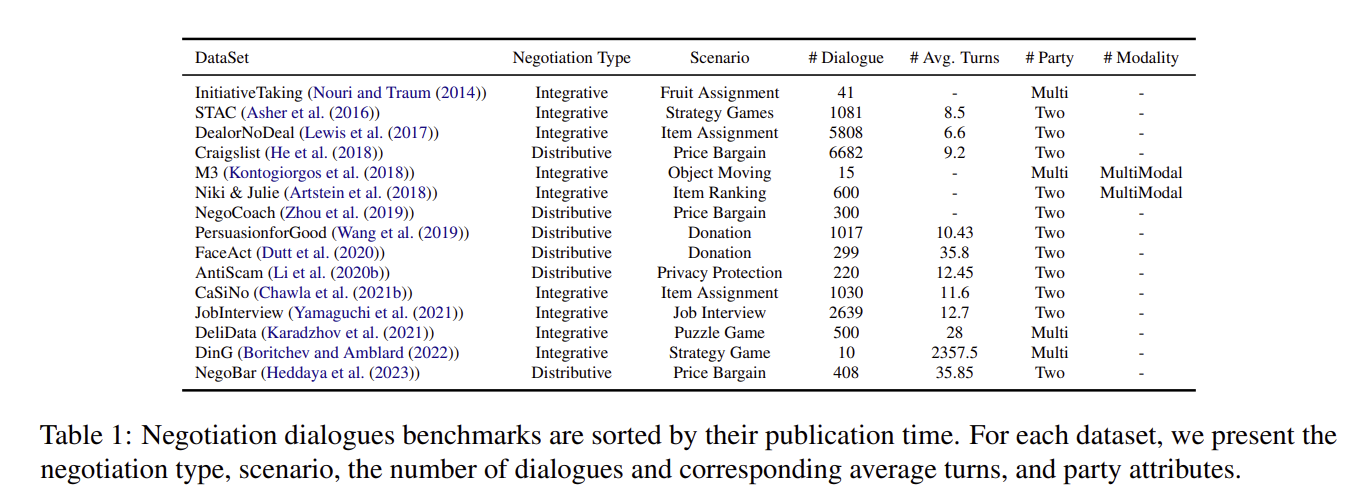

데이터셋으로는 캠핑 용품 배분(CaSiNo), 가격 협상(Craigslist Bargain) 등 다양한 시나리오가 사용되며, 성공률(SR), 유틸리티, 사용자 만족도 등을 통해 성능을 평가

논문은 AI 협상이 실제 응용에서 효과적이기 위해 다중 모달 정보 통합, 다자간 협상, 현실 데이터를 활용한 학습이 필요하다고 강조

| 구분 | 설명 | 예시 |

| 연구 목표 | 협상 대화 시스템의 체계적 검토, 방법론 정리, 데이터셋 소개, 평가 및 미래 연구 방향 제시 | AI가 가격 협상, 캠핑 물품 배분, 다자간 협상 등 다양한 상황에서 효과적인 협상 대화를 수행하도록 설계 |

| 주요 문제 | - 인간 협상에서의 감정적 편향과 전략 부족 - 암묵적 정보 활용 미흡 - 최적의 결과 도출 어려움 |

가격 협상 시 협상자가 상대방의 선호를 파악하지 못해 협상 실패 |

| 방법론 | - 전략 모델링: 협상 전략 설계 (통합, 분배, 다자간) - 협상자 모델링: 선호, 감정, 행동 모델링 - 행동 학습: 적합한 발언 생성 |

통합 전략: "서로 이익을 공유" 분배 전략: "최대 이익 추구" 협상자 모델링: 상대방의 감정을 고려한 설득적 발언 생성 |

| 데이터셋 | 1. 통합 협상: STAC, CaSiNo (캠핑 물품 교환), JobInterview (면접 조건 협상) 2. 분배 협상: Craigslist Bargain (가격 협상), Persuasion for Good (기부 설득) |

CaSiNo: 캠핑 용품 배분 협상 시나리오 Craigslist Bargain: 판매자와 구매자가 가격을 협상 |

| 평가 방법 | - 목표 기반: 성공률(SR), 자연스러움 (BLEU, ROUGE) - 게임 기반: 합의율, 유틸리티 - 인간 평가: 사용자 만족도 |

CaSiNo: 성공률(SR)로 합의 도달 여부 평가 Craigslist Bargain: 합리적 가격과 대화 길이로 평가 |

| 한계 및 문제점 | - 대부분 데이터셋이 고정된 시나리오로 한정 - 실제 응용 시 창의적 협상 어려움 - 데이터셋 초과 성능 보장 어려움 |

예: 다자간 협상에서 데이터셋의 협상 전략이 부족해 복잡한 관계를 다루기 어려움 |

| 미래 연구 방향 | - 다중 모달 협상: 텍스트, 음성, 비언어 정보 통합 - 다자간 협상: 여러 참여자 간 복잡한 관계 학습 - 실제 데이터 적용: 현실 협상 데이터 활용 |

비언어 정보: 얼굴 표정, 목소리 톤 다자간 협상: 기업의 부서 간 예산 협상 현실 데이터: 실제 비즈니스 대화 데이터로 훈련 |

| 기술적 접근 | - 프롬프트 설계: LLM의 생성 범위를 데이터셋 맥락과 정렬 - 컨텍스트 추적: 대화 상태를 지속적으로 추적 - 강화 학습: 합의 달성을 위한 최적화 |

예: "이 대화는 100달러에 합의해야 합니다."라는 목표를 기반으로 응답 제한 |

| 실용적 시사점 | - 협상 시스템이 데이터셋을 초과하여 창의적인 해결책 제안 가능 - 다양한 시나리오에서 일반화 능력 중요 - 인간과의 협상 실험 필요 |

새로운 시나리오 생성: "장기 관계를 고려한 합의 제안" 평가: LLM 간의 시뮬레이션 협상 및 인간 평가 |

Are LLMs Effective Negotiators? Systematic Evaluation of the Multifaceted Capabilities of LLMs in Negotiation Dialogues - 논문

https://arxiv.org/abs/2402.13550 Are LLMs Effective Negotiators? Systematic Evaluation of the Multifaceted Capabilities of LLMs in Negotiation DialoguesA successful negotiation requires a range of capabilities, including comprehension of the conversation

yoonschallenge.tistory.com

| 항목 | Let's Negotiate! | Are LLMs Effective Negotiators? |

| 연구 목표 | 협상 대화 시스템의 전반적 발전을 체계적으로 검토하고, 주요 방법론, 데이터셋, 평가 방법, 미래 방향 제시 | LLM의 협상 대화 능력을 체계적으로 평가하고, 모델의 다양한 능력과 한계를 분석 |

| 중점 영역 | 협상 대화 시스템의 구조적 설계, 전략 모델링 및 기존 연구 정리 | LLM 기반 협상에서 특정 작업(Task)별 성능 평가 (이해, 생성, 전략 모델링 등) |

| 데이터셋 | - CaSiNo, Craigslist Bargain, JobInterview - 다양한 협상 시나리오 제공 (가격, 캠핑 물품, 면접) |

- CRA, DND, CA, JI 데이터셋 활용 - 다중 이슈 협상(MIBT)을 중심으로 설계 |

| 주요 평가 방식 | - 목표 기반: 성공률(SR), BLEU - 게임 기반: 유틸리티, 공정성 - 인간 평가: 만족도, 합의율 |

- 정확도, F1 점수, Pearson 상관 계수 - 자동 및 인간 평가로 전략적 응답과 맥락 적합성 평가 |

| 방법론 | - 전략 모델링: 통합, 분배, 다자간 전략 - 협상자 모델링: 감정, 선호, 행동 추론 - 행동 학습 |

- LLM의 체계적 평가 프레임워크 설계 - Zero-shot, Few-shot, CoT 등 다양한 프롬프트 기술 활용 |

| 주요 기여 | 협상 대화 시스템의 기존 연구 정리 및 한계 제시 | LLM이 협상에서 보이는 한계와 잠재력을 분석하고 GPT-4가 다른 모델에 비해 상대적으로 우수함을 검증 |

| 결론 및 한계 | 다중 모달 협상, 다자간 협상, 실제 데이터를 활용한 연구 필요성 강조 | LLM이 전략적 응답에서 부족하며, Zero-shot보다는 Task-specific RL과 Fine-tuning이 필요함 |

주요 공통점

- 협상 대화 연구에 중점:

- 두 논문 모두 협상 대화 시스템 개발 및 평가를 주요 목표로 삼음.

- 협상 전략, 감정 모델링, 대화 흐름 추론 등 인간 협상에서 중요한 요소를 탐구.

- 다양한 협상 데이터셋 활용:

- CaSiNo, JobInterview 등의 다중 이슈 협상 데이터셋 사용.

- 평가의 중요성:

- 자동 평가(성공률, 정확도)와 인간 평가(만족도, 전략 적합성)를 병행하여 모델 성능을 검증.

주요 차이점

- 연구 초점:

- "Let's Negotiate!": 협상 대화 시스템의 구조적 발전과 미래 방향에 중점.

- "Are LLMs Effective Negotiators?": LLM의 구체적인 작업(Task) 수행 능력과 성능 평가에 중점.

- 방법론:

- "Let's Negotiate!"는 협상 전략과 설계 방식의 전반적 탐구.

- "Are LLMs Effective Negotiators?"는 LLM이 특정 협상 작업(이해, 생성, 파트너 모델링 등)을 수행하는 성능을 정밀하게 분석.

- 평가 모델:

- "Let's Negotiate!"는 협상 시스템의 전반적 목표 달성에 대한 평가.

- "Are LLMs Effective Negotiators?"는 GPT-4, GPT-3.5, Flan-T5 등의 다양한 LLM 비교.

- 미래 방향:

- "Let's Negotiate!"는 다중 모달 협상과 다자간 협상으로의 확장 제안.

- "Are LLMs Effective Negotiators?"는 LLM의 한계를 보완하기 위한 RL 정책 적용 및 추가 Fine-tuning 제안.

1. 문제 정의

협상은 사람들 간의 목표와 전략을 논의하여 갈등을 해결하거나 상호 수용 가능한 결과를 도출하는 과정입니다. 기존 협상은 인간의 편향, 감정, 기술 부족 등으로 인해 비효율적일 수 있습니다. 이를 해결하기 위해 연구자들은 인간과 협상하거나 도움을 줄 수 있는 협상 대화 시스템 개발을 목표로 삼고 있습니다.

이 논문은 협상 대화 시스템 연구를 체계적으로 검토하고, 주요 방법론, 데이터셋, 평가 지표를 논의하며 미래 방향성을 제시합니다.

2. 연구 동기 및 필요성

- 인간 협상의 한계:

- 협상 기술 부족 및 전략적 선택의 어려움.

- 상대방의 선호도나 암묵적 정보를 명확히 파악하지 못함.

- 편향 및 감정적 반응으로 인해 합리적 의사결정이 저해됨.

- 협상 대화 시스템의 필요성:

- 이러한 한계를 보완하여 더 나은 결과를 도출하고, 다양한 실제 상황에서 유용하게 사용될 수 있음.

- 가격 협상, 정치적 협상, 법적 분쟁 해결 등 다양한 영역에서 응용 가능.

3. 방법론

논문에서는 협상 대화 시스템을 전략 모델링, 협상자 모델링, 행동 학습으로 나눠 설명합니다.

3.1 문제 정의

- 협상 대화는 다수의 참여자(n)와 배경 정보(K), 전략(S), 대화 행동(U), 정책(π), 목표(g)로 구성됩니다.

- 목표는 상대와 상호작용하여 합의에 도달하는 것입니다.

3.2 전략 모델링 (Strategy Modeling)

- 협상 전략은 크게 통합 전략(Integrative), 분배 전략(Distributive), 다자간 전략(Multi-party)으로 분류됩니다.

- 통합 전략: 참여자 간 상호 이익을 극대화하는 전략. 예) 상호 협력을 통한 이익 교환.

- 분배 전략: 자신의 이익을 극대화하며 타협하지 않는 전략. 예) 가격 협상.

- 다자간 전략: 여러 참여자가 상호작용하며 관계와 그룹 간 복잡성을 고려.

3.3 협상자 모델링 (Negotiator Modeling)

- 협상 대화에서 참여자의 선호, 감정, 상대방의 행동을 모델링하여 협상 진행을 돕습니다.

- 선호도 모델링: 상대의 의도와 선호도를 추론.

- 감정 모델링: 대화 중 감정 변화 및 반응 추적.

- 상대방 행동 모델링: 상대방의 행동을 추적 및 예측.

3.4 행동 학습 (Action Learning)

- 협상 시스템이 전략 및 정보를 바탕으로 적절한 행동을 생성하도록 학습.

- 강화 학습: 다중 에이전트 강화 학습으로 정책 최적화.

- 지도 학습: 데이터 기반으로 인간 행동을 모방.

- 컨텍스트 학습: LLM을 활용한 제로샷 및 퓨샷 학습.

4. 데이터셋

협상 대화 연구에서 사용된 주요 데이터셋은 통합형 협상과 분배형 협상으로 구분됩니다.

- 통합형 데이터셋: 다중 이슈를 포함하여 상호 협력적 목표를 가진 협상. 예) 캠핑 용품 배분(CaSiNo 데이터셋).

- 분배형 데이터셋: 단일 이슈를 중심으로 가치 분배. 예) 가격 협상(Craigslist Bargain).

5. 평가 방법

- 목표 기반 평가: 성공률(SR), 예측 정확도(PA), 언어 품질(BLEU, ROUGE 등).

- 게임 기반 평가: 공정성, 유틸리티, 협상 길이.

- 인간 평가: 사용자의 만족도, 협상 성사율, 인간 유사성(Likert 점수).

6. 미래 연구 방향

- 다중 모달 협상: 음성, 표정, 제스처 등을 포함하는 다중 모달 데이터 활용.

- 다자간 협상: 다수의 참여자를 포함한 복잡한 협상 시나리오 연구.

- 다문화 및 다국어 협상: 다양한 언어와 문화적 배경을 고려한 협상 시스템 개발.

- 실제 시나리오 적용: 실제 협상 데이터를 수집하여 시스템 성능을 검증.

7. 결론

이 논문은 협상 대화 시스템의 현재 연구를 체계적으로 정리하고, 연구의 한계를 명확히 하며, 새로운 방향성을 제안합니다. 이를 통해 협상 대화 시스템의 실제 응용 가능성을 높이고 연구 커뮤니티의 발전을 도모합니다.

이 정리를 바탕으로 AI Agent 연구에서 다중 모달 대화 시스템 개발, 다국어 학습, 또는 강화 학습 기반의 협상 에이전트 설계 등 다양한 연구 주제를 설정할 수 있을 것입니다. 추가로 궁금한 점이 있다면 알려주세요!

협상 대화 시스템의 방법론: 세밀한 설명과 예시

1. 전략 모델링 (Strategy Modeling)

개념

전략 모델링은 협상자가 목표를 달성하기 위해 사용할 전략을 학습하는 것을 의미합니다. 이를 통해 협상자는 상황에 적합한 전략을 선택하여 대화를 주도할 수 있습니다. 논문은 전략을 통합 전략(Integrative), 분배 전략(Distributive), **다자간 전략(Multi-party)로 나누어 설명합니다.

1.1 통합 전략 (Integrative Strategy)

- 목표: 상호 이익을 극대화하여 윈-윈(win-win) 결과를 도출.

- 특징: 협력과 조화를 기반으로 상대방의 선호를 이해하고, 이를 기반으로 서로에게 이득이 되는 제안을 합니다.

예시:

- Camping Scenario (CaSiNo 데이터셋):

- 캠핑 중 서로의 물품(음식, 물, 장작)을 교환.

- 양측은 각각 물품에 대한 다른 우선순위를 가지고 협상하며, 최종적으로 모든 참여자가 이익을 얻도록 제안.

기술 활용:

- Latent Action Reinforcement Learning (LaRL):

- 강화 학습을 활용하여 협상 중 전략 전환을 학습.

- 예: 상대방의 선호도를 기반으로 협력적 제안을 생성.

1.2 분배 전략 (Distributive Strategy)

- 목표: 자신의 이익을 극대화하며 타협 없이 상대를 설득.

- 특징: 한정된 자원을 나누는 "제로섬(zero-sum)" 접근. 윈-루즈(win-lose) 상황에 집중.

예시:

- Craigslist Bargain 데이터셋:

- 구매자와 판매자가 특정 물품의 가격을 두고 협상.

- 구매자는 낮은 가격을 제시하고, 판매자는 높은 가격을 유지하며 협상 종료 시점을 결정.

기술 활용:

- Persuasion Strategies:

- 설득 전략(예: 논리적 설득, 감정적 호소)을 모델링하여 목표 달성.

- 예: "이 제품은 품질이 좋지 않으니 더 저렴한 가격에 제공해야 한다"고 주장.

1.3 다자간 전략 (Multi-party Strategy)

- 목표: 여러 참여자 사이에서 복잡한 관계와 그룹 간 상호작용을 최적화.

- 특징: 다자간 협상에서는 각 참여자의 입장과 그룹 간 이해관계까지 고려해야 함.

예시:

- 다자간 협상 시나리오:

- 회사의 부서장이 각자의 예산을 주장하며 다음 해 예산을 협상.

- 협상 중, 특정 부서는 타 부서와 협력하여 공동 이익을 극대화.

기술 활용:

- Graph Neural Network (GNN):

- 다자간 관계를 그래프로 표현하고, 관계 의존성을 기반으로 전략을 추천.

- 예: 특정 부서 간 협력 가능성을 예측해 합리적인 예산 배분 제안.

2. 협상자 모델링 (Negotiator Modeling)

개념

협상자의 행동, 감정, 선호를 모델링하여 협상 대화의 맥락을 이해하고 상대방의 의도를 추론합니다.

2.1 선호도 모델링 (Preference Modeling)

- 목표: 상대방의 선호와 요구 사항을 예측.

- 방법:

- 대화의 초반부 정보를 바탕으로 상대방의 의도를 추론.

- Transformer 기반 모델: 대화 중 일부 정보만으로도 상대방의 선호를 효과적으로 예측.

예시:

- Deal or No Deal 데이터셋:

- 참가자들은 각각 자신만의 선호도(물건 가치)를 가지고 협상.

- 모델은 상대방의 선호도를 추론하여 효율적인 제안을 생성.

2.2 감정 모델링 (Emotion Modeling)

- 목표: 협상 중 감정 변화를 추적하여 상대방의 반응을 예측.

- 방법:

- 감정을 명시적으로 모델링하거나, 대화 중 정서적 신호(예: 긍정, 부정)를 학습.

- Reinforcement Learning: 설득 전략에서 감정을 유발하는 메시지 생성.

예시:

- Emotion-aware Dialogues:

- 상대방이 화가 난 상황에서 감정을 진정시키기 위해 공감적인 메시지 전달.

- "당신의 입장을 이해합니다. 합리적인 대안을 찾아봅시다."

2.3 상대방 행동 모델링 (Opponent Behavior Modeling)

- 목표: 상대방의 행동을 예측하여 협상 전략을 조정.

- 방법:

- 상대방의 대화 행동을 추적(예: 협상 참여, 반대 의사).

- Theory of Mind (ToM) 기반 모델: 상대방의 정신 상태를 추론.

예시:

- Craigslist Bargain:

- 모델이 구매자가 "적정 가격"을 제안할 가능성을 예측하고 판매 전략 조정.

3. 행동 학습 (Action Learning)

개념

전략과 협상자 정보를 기반으로 최적의 행동(발언)을 생성하여 협상 목표를 달성합니다.

3.1 강화 학습 (Reinforcement Learning)

- 목표: 대화를 통해 점진적으로 정책을 최적화.

- 방법:

- 다중 에이전트 강화 학습을 통해 협상 전략 학습.

- Deep Q-Learning: 대화의 보상을 최대화하는 정책 학습.

예시:

- 협상 중 상대방의 호응에 따라 "적극적 양보" 또는 "고수" 전략 선택.

3.2 지도 학습 (Supervised Learning)

- 목표: 인간 대화를 모방하여 적절한 대화 행동 생성.

- 방법:

- 데이터셋 기반 학습으로 특정 대화 시나리오에 맞춘 행동 학습.

- Seq2Seq 모델: 입력 문맥에 따라 적절한 발언 생성.

예시:

- "그 제안은 너무 높습니다. 더 낮은 가격을 제시할 수 있을까요?"와 같은 발언 생성.

3.3 컨텍스트 학습 (In-context Learning)

- 목표: LLM을 활용한 제로샷/퓨샷 학습으로 빠르게 학습.

- 방법:

- GPT-4 등 대규모 언어 모델을 사용하여 시나리오에 맞는 협상 행동 생성.

예시:

- 게임 "Werewolf"에서 LLM이 다른 에이전트와 협상하며 역할 수행.

이 방법론은 실제 시나리오에서 AI 에이전트를 설계할 때 응용할 수 있습니다. 협상 전략과 행동 학습은 AI Agent의 설득력과 효율성을 높이는 핵심 요소입니다. 추가로 더 알고 싶은 부분이 있다면 알려주세요!

사용된 데이터 셋에 대해 설명하면서 어떻게 사용했는지, 어떻게 평가했는지에 대해 알려줘

협상 대화 시스템 연구에서 사용된 데이터셋과 활용 및 평가 방법

논문에서는 협상 대화 시스템 개발 및 평가를 위해 다양한 데이터셋을 소개하며, 이를 통합 협상(Integrative Negotiation)과 분배 협상(Distributive Negotiation)으로 구분합니다. 아래는 주요 데이터셋에 대한 설명과 활용 및 평가 방법입니다.

1. 통합 협상 데이터셋 (Integrative Negotiation Datasets)

1.1 STAC 데이터셋 (Strategy Games)

- 시나리오: 게임 Catan에서의 전략적 협상 대화.

- 플레이어들은 제한된 자원을 서로 거래하여 도시와 도로를 건설.

- 자원 종류: 나무, 밀, 양 등.

- 목표: 다른 플레이어와 협력하여 자신의 자원을 최적화.

- 데이터 특징:

- 1081개 대화와 평균 8.5턴의 협상 대화 포함.

- 다자간 대화: 여러 참여자가 동시에 협상.

- 대화 구조 분석: SDRT(Discourse Relations) 스타일로 대화 구조 태깅.

활용:

- 협상 중 자원 교환을 위한 전략 학습.

- 협력 전략과 경쟁 전략의 상호작용 분석.

평가 방법:

- WinRate: 협상 성사 여부.

- AvgVPs(평균 승점): 게임 목표 달성 점수.

1.2 CaSiNo 데이터셋 (Campsite Scenarios)

- 시나리오: 캠핑 용품(음식, 물, 장작) 배분 협상.

- 양측은 각 용품에 대해 서로 다른 우선순위를 가짐.

- 상대방의 우선순위를 파악하여 효율적인 교환 제안.

- 데이터 특징:

- 1030개 대화와 평균 11.6턴의 협상 포함.

- 양자간 대화: 두 명의 참여자가 협력적 대화를 수행.

활용:

- 선호도 모델링: 협상 초기에 상대방의 선호도를 추론.

- 통합 전략 학습: 서로에게 이익이 되는 교환 제안 생성.

평가 방법:

- Success Rate (SR): 협상이 성공적으로 성사되었는지 여부.

- Fairness: 양측의 이익 균형 평가.

1.3 JobInterview 데이터셋

- 시나리오: 면접에서 급여, 직책, 근무 시간 등의 조건 협상.

- 구직자와 채용담당자가 상호 선호도를 기반으로 협상.

- 각 참여자에게 상대방의 선호도를 일부 제공.

- 데이터 특징:

- 2639개 대화와 평균 12.7턴 포함.

- 대화 중 점진적으로 피드백 제공.

활용:

- 대화에서 예의 바르고 설득력 있는 협상 행동 학습.

- 감정 모델링을 통한 협상 긴장 완화 기술 개발.

평가 방법:

- Pareto Optimality Rate: 협상 결과가 양측 모두에게 최적의 결과인지 평가.

- Achieved Agreement Rate: 협상이 합의에 도달한 비율.

2. 분배 협상 데이터셋 (Distributive Negotiation Datasets)

2.1 Craigslist Bargain 데이터셋 (Price Bargaining)

- 시나리오: 판매자와 구매자가 특정 제품의 가격을 협상.

- 판매자는 높은 가격을 제시, 구매자는 낮은 가격을 제안.

- 양측이 협상 타결(가격 합의)하거나 종료.

- 데이터 특징:

- 6682개 대화와 평균 9.2턴 포함.

- 대화는 자연어로 이루어짐.

- 개인의 비공개 정보(예: 최대 구매 가능 금액)가 포함됨.

활용:

- 가격 협상을 위한 분배 전략 학습.

- 상대방 행동 모델링: 상대방이 제안할 가격의 경향을 예측.

평가 방법:

- Sale-to-List Ratio: 최종 판매 가격이 초기 리스트 가격에 비해 얼마나 낮은지 측정.

- Task Completion Rate: 협상이 종료된 비율.

2.2 Persuasion for Good 데이터셋 (Donation Persuasion)

- 시나리오: 기부를 설득하기 위한 대화.

- 설득자는 상대방에게 기부하도록 설득.

- 상대방은 기부를 거부하거나 수락.

- 데이터 특징:

- 1017개 대화와 평균 10.43턴 포함.

- 설득자는 사전에 설득 전략 및 예제 문장을 제공받음.

- 얼굴 표정과 감정을 포함한 대화 분석(확장 FaceAct 데이터셋).

활용:

- 감정 및 설득 전략 모델링.

- 설득 전략의 효과성 평가.

평가 방법:

- ROC-AUC(곡선 아래 면적): 설득 성공 여부를 분류하는 모델의 성능.

- Agreement Rate: 설득 성공률.

2.3 Anti-Scam 데이터셋 (Privacy Protection)

- 시나리오: 사기성 대화를 감지하고 대응.

- 참여자는 상대방이 개인 정보를 유출하려는지 파악.

- 데이터 특징:

- 220개 대화와 평균 12.45턴 포함.

- 개인 정보 유출 방지를 위한 전략 모델링.

활용:

- 방어적 대화 전략 학습.

- 대화 중 위험 신호 감지 기술 개발.

평가 방법:

- False Positive Rate: 사기가 아닌 대화를 잘못 판단한 비율.

- Robustness: 시스템이 다양한 대화 상황에서 정확히 작동하는지 평가.

3. 데이터셋 활용 및 평가의 핵심

- 활용 방법:

- 각 데이터셋은 특정 협상 시나리오를 기반으로 하여 전략, 행동 및 대화 맥락을 학습.

- 대규모 데이터셋은 지도 학습, 강화 학습, 컨텍스트 학습에 사용.

- 평가 방법:

- 시스템의 성공률(Success Rate), 합리성(Fairness), 사용자 만족도 등을 정량적 및 정성적으로 평가.

- 다중 메트릭(예: AUC, BLEU 등)을 통해 대화의 질, 설득력, 효율성을 다각도로 측정.

4. 연구 시사점

- 다양한 데이터셋을 활용해 전략, 감정, 선호도 모델링이 가능하며, 이는 협상 시스템의 성능을 높이는 데 필수적입니다.

- 평가 메트릭을 통해 모델의 실질적인 효과를 검증할 수 있으며, 이는 AI Agent의 성능 개선에 중요한 참고 자료가 됩니다.

추가로 궁금한 점이나 특정 데이터셋에 대해 더 자세히 알고 싶다면 말씀해주세요!

그런데 이런 멀티턴 대화는 LLM의 생성의도가 조금만 달라도 대화의 초점이 맞지 않을 텐데 그것에 대해서는 어떻게 해결했어?

멀티턴 대화에서 LLM의 생성 의도가 대화 초점과 맞지 않는 문제는 실제 협상 대화 시스템의 핵심 과제 중 하나입니다. 이 논문에서 이를 직접적으로 다루지는 않았지만, 연구 분야에서 일반적으로 사용되는 몇 가지 접근법을 통해 이 문제를 해결하려고 시도합니다. 아래에서 단계별로 설명하고 관련 방법을 예시와 함께 제시합니다.

1. 명시적 정책 학습 (Explicit Policy Learning)

개념

LLM의 응답이 일관성을 유지하도록, 정확한 정책(Policy)을 학습하거나, 대화의 맥락(Context)을 기반으로 다음 발언을 명시적으로 제어하는 방법입니다.

방법

- 전략과 행동의 분리 (Strategy-Decoupling):

- 협상 대화에서 전략(S)과 행동(U)을 분리하여 학습.

- 예: LLM이 특정 전략(예: "양보")을 기반으로만 행동하도록 제약.

- 지도 학습 기반 전략 제어:

- 과거 데이터에서 각 대화 턴의 전략을 예측하고, 이를 기반으로 발언을 생성.

- 예: "상대방이 가격을 낮추려는 의도를 보였으니, 이에 맞춰 가격 협상 전략을 조정."

- 대화 상태 추적 (Dialogue State Tracking):

- 대화의 현재 상태를 지속적으로 추적하여 초점이 벗어나지 않도록 제어.

- 예: "현재 대화 주제는 '급여 협상'이므로, 다른 주제(복지)로 벗어나는 발언은 제한."

예시

- Craigslist Bargain 데이터셋:

- 판매자와 구매자 간의 대화에서, LLM이 '가격'과 관련된 대화를 벗어나지 않도록 판매 전략만 학습.

- 모델이 "제품 상태"와 같은 주변적 주제를 불필요하게 추가하지 않도록 제어.

2. 프롬프트 강화 및 컨텍스트 관리

개념

대화 초점이 흐트러지지 않도록, 프롬프트 설계를 통해 모델의 의도를 명확히 정의하거나 컨텍스트 제약을 강화하는 접근법입니다.

방법

- 프롬프트 설계:

- 프롬프트에 명확한 지시를 포함하여 모델의 생성 방향을 통제.

- 예: "이 대화는 협상 전략에 초점을 맞추며, 구매자는 항상 가격을 낮추려고 합니다."

- 컨텍스트 재정의:

- 대화 중 특정 턴에서 대화의 주요 목표를 반복적으로 상기시킴.

- 예: "현재 대화의 목표는 양측 모두 동의할 수 있는 가격을 찾는 것입니다."

- Few-shot 학습:

- 적은 샘플 대화를 모델에 제공하여, 대화 초점 유지 능력을 강화.

- 예: 몇 가지 성공적인 협상 대화 샘플을 모델에 제공하여 학습 방향성을 지정.

예시

- CaSiNo 데이터셋:

- "양보와 협력을 기반으로 물품 교환"이라는 목표를 모델에 지속적으로 상기.

- 대화 초반 프롬프트: "당신은 캠핑 도구 교환에서 상대방과 협력적 대화를 유지해야 합니다."

3. 모듈형 프레임워크 (Modular Framework)

개념

생성 모델(LLM)과 전략 제어를 분리하여 각각 모듈로 설계하고, 상호작용을 통해 초점 유지.

방법

- 전략 예측 모듈:

- 대화의 현재 상태를 분석하고, 다음에 사용할 전략을 결정.

- 예: "현재 대화는 정체 상태이므로, '상대방의 선호를 탐색'하는 전략을 사용."

- 생성 제어 모듈:

- 예측된 전략을 기반으로 대화 발언 생성.

- 예: "상대방의 물품 선호도를 파악하기 위해 질문 발언 생성."

- 강화 학습 기반 통합:

- 전략 예측과 발언 생성을 통합한 강화 학습으로 최적화.

- 예: 모델이 최적의 전략과 발언을 선택하도록 보상 설계.

예시

- JobInterview 데이터셋:

- 대화 모듈이 면접자의 감정을 분석(예: 불만), 전략 모듈이 이를 반영한 행동(예: 공감) 선택.

4. 응답 평가 및 피드백 제공

개념

모델의 응답을 실시간 평가하여 대화 초점에서 벗어난 경우 수정하거나, 생성 과정에서 인간의 피드백을 활용.

방법

- 실시간 평가 메트릭:

- 대화의 목표와 일치하는지 점수를 부여.

- 예: 목표 관련성 점수(BLEU, ROUGE 등)로 발언의 적합성을 평가.

- 휴먼 인더 루프 (Human-in-the-Loop):

- 협상 도중 모델의 발언을 사람이 검토하여 초점 이탈 여부를 교정.

- 예: "이 발언은 가격 협상과 관련 없으니 수정 필요."

- 정렬 강화 (Alignment Refinement):

- LLM의 응답이 초점에서 벗어난 사례를 데이터에 추가해 재학습.

예시

- Persuasion for Good 데이터셋:

- 설득 대화 중 기부자의 관심사에서 벗어나는 발언("개인적인 이야기를 늘어놓음")에 대해 실시간 수정.

5. 멀티턴 협상 시스템의 미래 방향

멀티턴 대화에서 LLM의 생성 초점을 유지하기 위해, 다음과 같은 추가 연구 방향을 고려할 수 있습니다:

- 대화 종료 조건 제어: 대화가 특정 목표에 도달했는지 실시간 확인.

- 다중 모달 데이터 활용: 대화 외에도 음성 톤, 표정 등 비언어적 정보를 추가로 학습하여 초점 유지.

- 상호작용적 평가: 대화 참여자들의 실시간 피드백을 통해 모델 성능을 조정.

이 접근법은 AI 에이전트가 협상 대화에서 일관성과 초점을 유지하는 데 핵심적입니다. 추가로 궁금하거나 특정 사례를 적용하고 싶다면 말씀해주세요!

데이터 셋에서 대화는 서로 합의할 수 있지만 우리가 Inference할 때 LLM이 이 값을 받아들이지 못할 수 있잖아

그럼 거절하는 말을 LLM이 출력하고, 데이터 셋에서는 수락에 대비한 말이 나올텐데 이땐 맥락이 완전히 무너지는데 이런 경우는 어떻게 해?

LLM이 협상 데이터셋의 맥락과 다르게 거절하는 응답을 생성하여 대화 초점이 무너지는 문제는 실전 응용에서 매우 중요한 과제입니다. 이를 해결하기 위해, 발언 거절(contradicting utterance) 문제를 다각도로 접근할 수 있습니다. 아래는 문제 해결 방법과 이를 구현하기 위한 전략을 단계적으로 설명합니다.

1. 동적 맥락 재설정 (Dynamic Context Resetting)

개념

LLM이 대화 초점에서 벗어나거나 거절 발언을 생성한 경우, 이전 맥락을 기반으로 대화를 복구하는 전략입니다.

방법

- 대화 상태 점검 (State Verification):

- 모델이 생성한 응답이 데이터셋 맥락(수락 기대)에 맞지 않는지 판단.

- 예: "상대방이 가격 합의를 제안했으나, 모델이 부당한 거절을 생성했는가?"

- 재설정 트리거:

- 대화 상태를 분석하여 오류가 발생한 경우, 대화를 초기 상태로 재조정.

- 예시:

- 상대방: "그럼 이 가격에 합의하죠."

- LLM: "싫어요, 말이 안 되네요." → 트리거 발생.

- 모델이 "그럼 이 가격은 적당한 것 같네요."와 같은 대안을 생성.

- 컨텍스트 업데이트:

- 이전 발언(수락 맥락)을 다시 모델 입력으로 포함하여 대화를 올바른 방향으로 유도.

2. 대화 상태 추적 및 대응 모듈 (Dialogue State Tracking and Repair Module)

개념

대화 진행 상태를 지속적으로 추적하고, 비일관성이나 오류가 발생하면 자동으로 수정 발언을 생성합니다.

방법

- 대화 상태 추적 (Dialogue State Tracking):

- 대화의 핵심 요소(예: 목표, 제안된 조건, 기대되는 응답)를 저장.

- 예시:

- 현재 상태: "가격 10달러에 합의 예정."

- 모델 응답: "거절." → 비일관성 감지.

- 오류 복구 모듈:

- 대화 맥락과 모순된 발언을 수정하거나 대체.

- 구현 방법:

- 제안 생성기 (Proposal Generator): 수정된 발언을 자동 생성.

- 맥락 강화 (Context Augmentation): 비일관성이 감지되면 과거 대화 맥락을 모델 입력에 포함.

- 예: "그 가격은 너무 높습니다"를 "좋아요, 그 가격으로 진행합시다"로 변환.

3. 강화 학습 기반 발언 제어 (Reinforcement Learning for Utterance Control)

개념

강화 학습을 사용하여 모델이 거절 발언을 생성할 가능성을 줄이고, 데이터셋에서 기대되는 수락 발언을 생성하도록 학습.

방법

- 보상 설계:

- 모델의 응답이 대화 맥락과 일치하면 보상을 부여.

- 부정적인 응답은 패널티를 적용.

- 예:

- 맥락: "그럼 이 가격으로 합의할까요?"

- 응답: "좋아요!" → 보상 점수 ↑.

- 응답: "싫어요." → 패널티 점수 ↓.

- 다중 턴 강화 학습:

- 다중 턴 협상에서 전체 대화 흐름의 목표 달성을 기반으로 보상.

- 예시:

- 목표: 가격 합의.

- 모델이 성공적으로 대화를 종료하면 높은 보상.

4. 컨텍스트 기반 응답 필터링 (Contextual Response Filtering)

개념

모델이 생성한 응답을 맥락과 비교하여, 적절하지 않은 경우 자동으로 대체.

방법

- 응답 검증 모듈:

- LLM이 생성한 응답과 데이터셋 맥락을 비교.

- 검증 조건:

- 대화 목표와 부합하는지?

- 이전 발언과 일관성이 있는지?

- 응답 수정:

- 맥락에 맞는 대안을 생성.

- 예: "싫어요" → "그 가격에 동의합니다."

- 확률적 필터링:

- 예측 확률 스코어를 기반으로 비일관성이 높은 응답을 수정.

- 예: 확률이 낮은 응답("싫어요")을 확률이 높은 응답("좋아요")로 대체.

5. 휴먼 인더 루프 (Human-in-the-Loop) 학습

개념

모델의 비일관성을 사람이 직접 교정하고, 이를 추가 학습 데이터로 활용.

방법

- 오류 태깅:

- 사람이 대화에서 오류(거절 발언 등)를 태그.

- 예: "이 발언은 대화 목표와 맞지 않음" 표시.

- 데이터 증강:

- 사람이 교정한 발언을 포함한 데이터셋으로 모델 재학습.

- 예시:

- 입력: "그럼 이 가격에 합의하죠."

- 잘못된 응답: "싫어요."

- 수정된 응답: "좋아요, 그 가격으로 합의합시다."

- 반복적 개선:

- 인간 피드백과 자동화된 교정 시스템을 결합하여 지속적으로 성능 향상.

6. 다양한 시나리오에서 테스트 및 평가

평가 지표

- 대화 일관성 점수 (Dialogue Consistency Score):

- 대화 흐름이 목표와 얼마나 잘 맞는지 평가.

- 목표 달성률 (Goal Achievement Rate):

- 모델이 대화의 최종 목표(예: 합의)에 도달했는지 비율 측정.

- 사용자 만족도 (User Satisfaction):

- 인간 평가자가 대화 결과에 만족했는지 점수화.

예시 평가 프로세스

- Craigslist Bargain 데이터셋:

- 모델이 가격 협상 중 80% 이상의 대화에서 합의를 생성했는지 평가.

- 비일관성 발언 발생률(거절율) 분석.

요약

- 거절 발언 문제는 LLM 기반 협상 시스템의 주요 과제로, 맥락 복구, 상태 추적, 강화 학습, 필터링 및 휴먼 피드백을 통해 해결 가능합니다.

- 특히 강화 학습과 대화 상태 추적을 결합하면, 모델이 협상 맥락을 유지하며 적절한 발언을 생성할 확률을 높일 수 있습니다.

- 이러한 접근법은 협상 AI 에이전트의 실질적 응용에 있어 필수적인 기반이 됩니다.

추가로 궁금한 사항이나 더 깊이 알고 싶은 주제가 있다면 말씀해주세요!

아니 다시 말해줄게

데이터 셋 이 이렇다고 생각해봐

A: 나는 이 물건을 100 달러에 사겠습니다.

B: 좋아요 좋은 가격이네요

A: 좋은 거래였습니다.

Inference에서 내 LLM은 100달러가 부당하다고 생각해서 이렇게 말했어

A: 나는 이 물건을 100 달러에 사겠습니다.

B: 아니에요 이 물건은 최소 150달러는 받아야 합니다.

A: 좋은 거래였습니다.

그럼 이렇게 이상한 Inference가 되면서 평가도 이상해 질텐데 이러한 경우에 대비를 어떻게 하냐는 말이야

이러한 맥락 붕괴 문제(Context Collapse)는 협상 대화 시스템에서 중요한 과제입니다. 특히, 데이터셋이 A와 B 간의 합의를 가정했지만, 모델이 새로운 의도를 생성하여 대화 흐름이 비정상적으로 진행될 때 발생합니다. 이를 해결하려면 대화 흐름 통제, 평가 방식 보완, 그리고 맥락 복구 전략이 필요합니다. 아래는 이를 체계적으로 다룰 수 있는 방법입니다.

1. 대화 흐름의 제약 및 정렬 (Constraint and Alignment of Dialogue Flow)

개념

LLM이 새로운 의도를 생성하지 않도록, 대화의 목표와 맥락을 명확히 제약하고, 대화의 전반적 흐름이 데이터셋의 기대와 정렬되도록 유지.

방법

- 명시적 대화 제약 (Explicit Constraints):

- LLM의 생성 범위를 제한.

- 예: "이 대화는 판매자와 구매자 간에 이미 합의된 조건을 강화하는 발언만 허용."

- 목표 기반 생성 (Goal-conditioned Generation):

- 대화 목표를 모델에 명확히 전달.

- 예: "A와 B는 거래에 합의해야 하며, 100달러에 대한 긍정적 답변만 생성."

- 대화 행동 필터링 (Utterance Filtering):

- LLM이 부당한 발언(예: "최소 150달러는 받아야 합니다")을 생성하지 않도록 사전 필터링.

- 예: 출력된 발언이 합의 조건과 모순되면 수정 또는 재생성.

구현 예시

- Prompt 설계:

컨텍스트: A는 100달러에 구매하고, B는 이를 수락. 목표: 거래를 성공적으로 종료하는 대화를 생성.- A: "나는 이 물건을 100달러에 사겠습니다."

- B: "좋아요 좋은 가격이네요."

- A: "좋은 거래였습니다."

2. 모순 감지 및 맥락 복구 (Contradiction Detection and Context Recovery)

개념

대화 흐름이 비정상적으로 전개될 경우, 자동으로 오류를 감지하고 대화 맥락을 복구.

방법

- 모순 감지 알고리즘:

- LLM의 응답이 데이터셋의 맥락과 충돌하는지 검출.

- 예: B의 "최소 150달러는 받아야 합니다"가 기존 맥락(합의된 가격)과 모순됨.

- 검출 메트릭:

- 발언 간 일관성: 현재 발언과 이전 대화 맥락의 유사도.

- 목표 적합성: 대화 목표(합의 도달 여부)와의 정합성.

- 맥락 복구 전략:

- 모순 감지 시, 이전 대화 맥락을 기반으로 대체 발언 생성.

- 예:

- 원래 응답: "최소 150달러는 받아야 합니다."

- 복구 응답: "좋아요, 좋은 가격이네요."

- 모듈형 대화 시스템:

- 대화 맥락 추적 모듈과 발언 생성 모듈을 분리.

- 맥락 추적 모듈이 이전 대화 흐름을 검증하고 발언 생성 모듈이 이를 반영.

3. 강화 학습 기반 정책 최적화 (Reinforcement Learning for Policy Optimization)

개념

LLM이 부적절한 발언을 줄이고, 대화 목표와 맥락에 정렬된 발언을 생성하도록 강화 학습을 활용.

방법

- 보상 설계:

- 대화가 데이터셋 맥락과 일치할 경우 보상을 부여.

- 모순된 발언에 패널티 적용.

- 보상 예:

- 합의 유지: +10점.

- 모순 발언: -10점.

- 다중 턴 대화 강화 학습:

- 대화 흐름 전반을 평가하여 보상을 누적.

- 예: 모델이 모든 턴에서 합의를 유지하면 높은 보상.

구현 예시

- OPPA(Opponent-Aware Policy):

- 상대방의 행동을 예측하고, 합의 조건을 충족하는 발언을 학습.

- 예: 상대방의 선호도를 반영한 발언 생성.

4. 휴먼 인더 루프 (Human-in-the-Loop) 보정

개념

모델이 생성한 오류 발언을 사람이 검토하고 보정하여 추가 학습 데이터로 활용.

방법

- 오류 태깅:

- 사람이 LLM의 부적절한 발언을 태깅.

- 예: "최소 150달러는 받아야 합니다" → "부적절" 태그.

- 수정된 데이터셋 생성:

- 태깅된 오류를 수정하여 새로운 데이터셋으로 추가 학습.

- 예:

- 입력: "나는 100달러에 사겠습니다."

- 원래 응답: "최소 150달러는 받아야 합니다."

- 수정 응답: "좋아요, 좋은 가격이네요."

- 반복적 개선:

- 지속적으로 오류 데이터를 축적하고 보정하여 모델 정밀도 향상.

5. 평가 메트릭 보완

문제점

모순된 대화 흐름이 결과 평가에 영향을 미칠 수 있으므로, 평가 기준을 강화해야 함.

해결책

- 대화 일관성 점수 (Dialogue Consistency Score):

- 대화 맥락과 생성된 응답 간의 정합성을 측정.

- 예: "최소 150달러는 받아야 합니다"는 낮은 점수.

- 목표 적합성 (Goal Achievement Score):

- 대화가 데이터셋의 목표(합의)와 얼마나 일치하는지 평가.

- 대화 복구율 (Dialogue Recovery Rate):

- 모델이 맥락 복구를 통해 정상 대화 흐름을 회복한 비율.

6. 미래 연구 방향

- 컨텍스트 기반 응답 제한:

- LLM이 새로운 의도를 생성하지 않도록 데이터 중심적인 프롬프트 설계.

- 다중 턴 제어 강화:

- 대화 흐름 전반의 일관성을 지속적으로 추적하고 제어.

- 실시간 평가 통합:

- 대화 생성 과정에서 실시간 평가를 통해 비일관성을 즉시 수정.

요약

- 맥락 붕괴 문제를 해결하려면, 대화 상태 추적, 모순 감지, 강화 학습을 통해 대화 흐름을 복구하고 모델의 정밀도를 향상시킬 수 있습니다.

- 평가 메트릭 보완과 휴먼 인더 루프 학습은 모델 개선의 필수적 요소입니다.

- 이러한 접근법은 협상 AI 시스템의 실용성을 높이고, 실제 응용에서 안정성을 보장합니다.

추가로 세부적인 구현이나 관련 질문이 있다면 알려주세요!

그냥 너는 데이터 셋에 최적화된 모델을 만드는 것 아니야?

데이터 셋 보다 더 뛰어난 모델은 데이터 셋보다 더 효과적인 협상을 이어 나갈수도 있잖아

맞습니다. 데이터셋에 최적화된 모델은 데이터셋의 특성과 패턴을 효과적으로 학습하지만, 그것이 곧 데이터셋 이상의 뛰어난 협상 능력을 보장하지는 않습니다. 대신, 데이터셋 이상의 능력을 갖춘 모델을 구축하려면, 일반화 능력과 창의적인 협상 전략을 갖추도록 설계해야 합니다. 데이터셋보다 더 효과적인 협상을 이어 나가는 모델을 만들기 위해 아래와 같은 접근법을 고려할 수 있습니다.

1. 데이터셋 기반 모델의 한계

데이터셋 의존성의 문제점

- 고정된 시나리오 학습: 데이터셋은 종종 특정 상황(예: 캠핑 용품 배분, 가격 협상 등)에 제한되며, 이는 모델의 적용 가능성을 제약.

- 창의성 부족: 데이터셋에 포함되지 않은 새로운 상황에서는 모델이 유연하게 대처하지 못함.

- 최적화의 착각: 데이터셋에서 높은 성능을 보이는 모델이 실제 상황에서도 뛰어날 것이라는 보장은 없음.

2. 데이터셋 이상의 협상을 위한 설계 전략

2.1 상황 일반화 능력 학습

- 목표: 모델이 특정 데이터셋의 패턴을 단순히 모방하는 것을 넘어, 새로운 상황에서도 유연하게 협상 능력을 발휘.

- 방법:

- 다양한 데이터셋 통합 학습:

- 여러 협상 데이터셋(예: 가격 협상, 다자간 협상)을 함께 학습하여 상황 범위를 확장.

- 예: Craigslist Bargain + CaSiNo + JobInterview 데이터셋을 결합해 학습.

- 시뮬레이션 데이터 생성:

- GAN이나 LLM을 활용해 데이터셋에 없는 새로운 협상 시나리오 생성.

- 예: "복잡한 다자간 협상"이나 "문화적 차이를 고려한 협상" 시나리오 추가.

- 도메인 불확실성 학습:

- 모델이 알지 못하는 상황에서 적응하도록 학습.

- 방법: 랜덤으로 일부 데이터를 변형하거나 제거하여 모델이 불완전한 정보에서도 최선의 결과를 도출하도록 훈련.

- 다양한 데이터셋 통합 학습:

2.2 창의적 협상 전략 학습

- 목표: 단순히 상대방의 선호를 반영하는 것을 넘어, 새로운 해결책을 제안하는 능력을 학습.

- 방법:

- 역공학 전략 학습:

- 성공적인 협상 결과에서 전략을 역추적해 학습.

- 예: 데이터셋에 없는 "복합적 교환" 전략 학습.

- 비대칭 협상 모델링:

- 참여자 간에 다른 목표와 조건을 설정해, 모델이 더 복잡한 상황에 적응.

- 예: 판매자는 높은 가격을 원하고, 구매자는 가격 외에 다른 조건(예: 품질)을 고려.

- 창의적 해결책 생성:

- 협상에서 물리적으로 교환 가능한 항목 외에도 "비물질적 가치"(예: 장기적인 관계, 신뢰)를 포함한 제안 생성.

- 역공학 전략 학습:

2.3 강화 학습 기반 협상 최적화

- 목표: 협상 시나리오에서 목표 달성을 극대화하는 전략을 강화 학습으로 최적화.

- 방법:

- 다중 턴 보상 구조:

- 대화가 특정 목표를 달성할 때만 높은 보상을 부여.

- 예: "합의에 도달" vs "협상 중단"의 결과를 명확히 구분.

- 상대방 모델링 강화:

- 상대방의 성향, 목표, 협상 전략을 지속적으로 추적하고 이에 맞는 대응 생성.

- 예: "상대방이 가격을 고수하면 대안적 가치를 제안."

- 자기 플레이(Self-play):

- 두 모델이 서로 협상하며 성능을 향상.

- 예: LLM 간의 협상을 통해 "창의적 합의"를 스스로 발견.

- 다중 턴 보상 구조:

3. 데이터셋 이상의 평가 및 검증

문제

데이터셋 기반 평가만으로는 모델의 실질적 협상 능력을 측정하기 어려움.

해결 방법

- 실세계 시뮬레이션 평가:

- 데이터셋 외의 새로운 협상 시나리오에서 모델의 성능 검증.

- 예: 다자간 협상 시뮬레이션을 통해 모델의 복잡한 협상 능력 평가.

- 상대방으로 LLM 사용:

- LLM이 상대방 역할을 수행하며 새로운 시나리오를 생성.

- 예: GPT-4를 상대방으로 설정해 실제 협상 상황에서의 성능 평가.

- 인간과의 협상 실험:

- 인간 사용자와 직접 협상하여 성능 검증.

- 측정 항목: 합의율, 협상 효율성, 사용자 만족도.

- 목표 도달 정도 평가:

- 협상의 결과가 실제로 목표를 달성했는지 여부를 평가.

- 예: 경제적 가치를 극대화하면서 관계를 유지하는 협상 결과 도출.

4. 데이터셋 이상의 협상 사례

기존 데이터셋 기반 협상

- A: "이 물건을 100달러에 사겠습니다."

- B: "좋아요, 좋은 가격이네요."

데이터셋 이상의 협상

- A: "이 물건을 100달러에 사겠습니다."

- B: "이 가격은 조금 낮습니다. 대신 장기 고객 할인으로 100달러를 고려할 수 있습니다."

- A: "좋습니다. 장기적으로 다른 거래도 고려하겠습니다."

특징:

- 창의적인 대안(장기 고객 할인)이 데이터셋 패턴을 넘어서 도출.

- 관계적 가치까지 고려하여 협상 결과를 개선.

5. 요약

데이터셋을 기반으로 협상 모델을 학습하는 것은 출발점일 뿐이며, 데이터셋 이상의 능력을 갖춘 모델은 다음을 통해 가능합니다:

- 상황 일반화 능력: 다양한 시나리오에서 유연하게 작동.

- 창의적 전략 학습: 기존 데이터셋에 없는 새로운 해결책 제안.

- 강화 학습과 자기 플레이: 실질적 협상 효율성 극대화.

- 평가 기준 확장: 실세계 시뮬레이션 및 인간 평가를 통한 검증.

이를 통해 모델이 데이터셋을 초월하여 실제 환경에서도 뛰어난 협상 능력을 발휘할 수 있습니다. 추가로 궁금한 사항이나 구체적인 구현 질문이 있다면 말씀해주세요!