https://arxiv.org/abs/2402.11712

Modelling Political Coalition Negotiations Using LLM-based Agents

Coalition negotiations are a cornerstone of parliamentary democracies, characterised by complex interactions and strategic communications among political parties. Despite its significance, the modelling of these negotiations has remained unexplored with th

arxiv.org

협상이긴 한데 뭔가 부족한 느낌입니다.

그래도 결과를 높이려고 HMDP를 통해 최대한 승률을 높이고, 다양한 모델을 사용했네요

좀 더 다양한 모델을 사용하며 모델의 성능 비교, 전체적인 성능 향상을 보였으면 좋았을 텐데 그 부분에 대해선 아쉬운 것 같습니다.

| 논문 제목 | Modelling Political Coalition Negotiations Using LLM-based Agents |

| 연구 목표 | - 정치적 연합 협상을 시뮬레이션하는 새로운 NLP 작업 제안 - LLM 기반 에이전트를 활용해 협상 과정과 결과를 모델링 - POLCA 데이터셋 구축을 통해 데이터 부족 문제 해결 |

| 문제 정의 | - 정당 선언문(Manifestos)을 기반으로 연합 협약(Coalition Agreements) 도출 - 선언문이 협약에 포함, 부분 포함, 미포함으로 결정되는 과정을 모델링 |

| 방법론: HMDP | 계층적 마르코프 결정 프로세스(HMDP): 협상을 상위 및 하위 레벨로 나눠 처리 - 상위 레벨(HI): 협상할 선언문 선택 - 하위 레벨(LO): 행동(찬성, 반대, 수정, 타협) 선택 |

| 데이터셋 (POLCA) | - 유럽 6개국의 정당 선언문과 연합 협약 데이터를 통합 - 선언문과 협약 간 관계를 자동 주석 처리하여 데이터 구축 |

| LLM 활용 | - GPT-3.5-turbo, LLaMA-7b, LLaMA-13b를 에이전트 엔진으로 사용 |

| 행동 및 보상 | - 행동: 찬성(Support), 반대(Oppose), 수정(Refine), 타협(Compromise) - 보상: 선언문 포함 여부와 협약의 유사성에 따라 상위 및 하위 레벨에서 평가 |

| 결과 요약 | - GPT-3.5-turbo: 가장 높은 성능(F1-score) 기록 - 계층적 정책 학습(HMDP): 단일 정책보다 높은 성능 - 국가별 성능 편차: 정치적 맥락과 언어 차이 영향 |

| 기여 | - 새로운 NLP 작업 제안: 정치적 협상 모델링 - POLCA 데이터셋 제공: 연합 협약 분석에 활용 가능 - LLM 평가: 협상 시뮬레이션에서 LLM의 한계 및 가능성 탐구 |

| 한계 | - 데이터 제한: 유럽 6개국에 한정 - 모델 한계: 정치적 복잡성과 맥락 부족 - 협상 요인 제한: 의석 분배, 정치 동맹 등 반영 부족 |

| 향후 연구 방향 | - 다국적 데이터 확장 - 다자간 협상 모델링 - LLM 튜닝 및 편향 제거 - 정치적 협상 과정을 더 복잡하게 반영 |

| 결론 | - 정치학과 NLP 융합을 통해 정치적 협상을 시뮬레이션할 가능성을 제시 - HMDP와 LLM을 활용한 협상 모델링이 효과적임을 입증 |

1. 문제 정의

정치적 연합 협상은 의회 민주주의에서 중요한 역할을 하며, 이는 다수의 정당이 협력하여 정부를 구성하는 과정을 포함합니다. 그러나 이러한 협상을 효과적으로 모델링하려는 시도는 데이터 부족과 복잡성으로 인해 거의 이루어지지 않았습니다.

- 기존 한계: 기존 모델은 표면적인 상호작용에 치중하며, 협상 과정의 역사적, 이념적 맥락을 충분히 반영하지 못합니다.

- 연구 목표:

- 연합 협상 모델링을 새로운 NLP 작업으로 제시.

- LLM(대형 언어 모델)을 에이전트로 사용하여 협상 과정을 시뮬레이션.

- POLCA라는 다국어 데이터셋 구축을 통해 데이터 부족 문제를 해결.

2. 방법론

연구에서는 LLM 기반 에이전트를 사용하여 정치적 협상을 시뮬레이션하고, 협상 결과를 예측하기 위한 계층적 마르코프 결정 프로세스(Hierarchical Markov Decision Process, HMDP)를 제안했습니다.

(1) POLCA 데이터셋

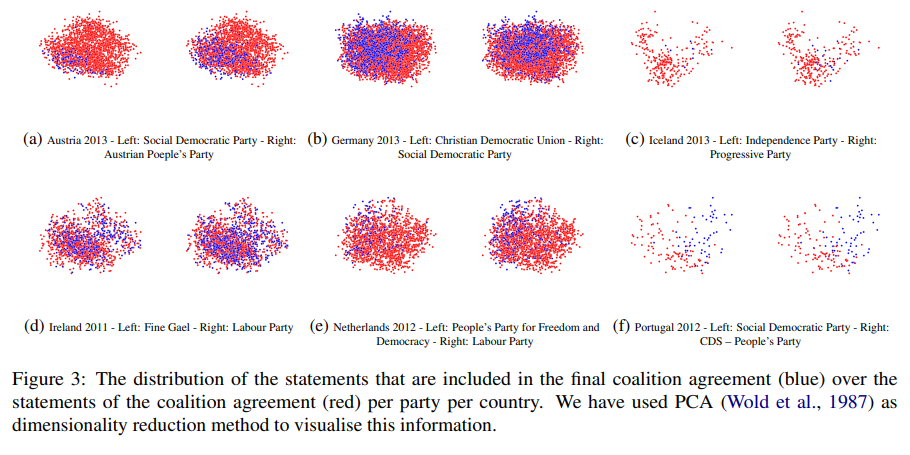

- 구성: 유럽 6개국의 정당 선언문(Manifestos)과 연합 협약(Coalition Agreements)을 포함.

- 목적: 각 정당의 선언문이 최종 협약에 포함되는지 여부를 평가.

- 데이터 출처:

- Manifesto Project Dataset: 전 세계 50개국의 1,000개 정당 선언문.

- CoalitionAgree Dataset: 다양한 정부의 최종 연합 협약.

(2) 협상 모델링

- HMDP 설계:

- 상위(HI) 레벨: 협상할 선언문 선택.

- 하위(LO) 레벨: 선택된 선언문에 대해 구체적인 행동(찬성, 반대, 수정, 타협) 수행.

- 보상 함수: 협상 결과의 유사성과 성공 여부를 기반으로 정책(policy)을 업데이트.

- 에이전트 시뮬레이션:

- LLM(GPT-3.5-turbo, LLaMA-7b/13b) 기반으로 구현.

- 협상 전략과 실행을 위한 계층적 정책 학습.

(3) 협상 프로세스

- 각 정당은 선언문을 바탕으로 협상하며, 3라운드 이내에 합의 여부를 결정.

- 행동 선택(찬성, 반대, 수정, 타협)은 정당의 핵심 가치와 상대 정당의 우선순위를 고려하여 이루어짐.

3. 실험 및 결과

(1) 실험 환경

- LLM 기반 모델: GPT-3.5-turbo, LLaMA-7b, LLaMA-13b.

- 메트릭: Macro F1-score를 사용하여 클래스 간 성능 균형 평가.

(2) 주요 결과

- HMDP 성능:

- GPT-3.5-turbo가 가장 높은 성능을 보여줌.

- 계층적 정책 학습(HI + LO)이 단일 정책 학습(HMDP-LO)보다 더 나은 결과를 도출.

- LLM 한계:

- 정치적 언어의 복잡성과 국가별 맥락의 차이로 인해 정확도가 제한됨.

- LLM의 "환각(hallucination)" 문제로 인해 일부 비일관성이 발생.

4. 주요 기여

- POLCA 데이터셋 제공:

- 다국어로 구성된 정치 협상 데이터를 통해 NLP 작업의 새로운 방향 제시.

- HMDP 프레임워크:

- 정치적 협상 시뮬레이션을 위한 계층적 접근 방식을 제안.

- LLM 평가:

- LLM의 협상 시뮬레이션 가능성과 한계를 정량적으로 분석.

5. 한계와 향후 연구

- 한계:

- 6개 유럽 국가로 데이터가 제한.

- 복잡한 협상 요소(좌석 분배, 정치적 동반자 등) 미반영.

- 예산 및 시간 제약으로 인간 주석 기반 데이터 부족.

- 향후 방향:

- 다국적 협상 데이터 확장.

- 더 복잡한 협상 요소를 반영한 모델 개발.

- 정치적 편향성을 줄이기 위한 LLM 튜닝.

6. 결론

연구는 NLP와 정치과학의 융합을 통해 정치적 협상 모델링의 첫 단계를 제시했으며, LLM과 HMDP를 활용한 시뮬레이션이 가능성을 보여줌. 그러나 협상 과정의 복잡성을 완전히 해결하기 위해 추가 연구가 필요함.

방법론

방법론: 계층적 마르코프 결정 프로세스(HMDP)를 이용한 정치적 연합 협상 모델링

1. 문제 정의

정치적 연합 협상은 서로 다른 정당의 선언문(Manifestos)을 기반으로 정책 합의를 도출하는 복잡한 과정입니다. 이 연구에서는 협상 과정을 계층적 마르코프 결정 프로세스(Hierarchical Markov Decision Process, HMDP)를 통해 모델링하고, LLM 기반 에이전트를 활용해 시뮬레이션합니다.

협상 구조

- 각 정당은 자신들의 선언문에 포함된 문장(statement)을 최종 협약에 포함시키려 시도합니다.

- 협상의 목표는 선언문이 다음 세 가지 범주 중 하나로 분류되는 것입니다:

- 포함 (Included): 선언문이 최종 협약에 반영됨.

- 부분 포함 (Partly Included): 선언문이 수정되어 협약에 일부 반영됨.

- 미포함 (Not Included): 선언문이 협약에 반영되지 않음.

2. 계층적 마르코프 결정 프로세스 (HMDP)

HMDP는 협상 과정을 두 개의 계층(상위와 하위)으로 나누어 모델링합니다.

(1) 상위 레벨 (Higher-Level, HI)

- 목적: 어떤 선언문(statement)을 협상할지 선택.

- 정책: 상위 정책 σHI는 현재 상태 S를 기반으로 협상할 선언문 m을 결정.

- 종료 조건: 협상할 모든 선언문을 다루거나 사전 정의된 횟수에 도달했을 때.

(2) 하위 레벨 (Lower-Level, LO)

- 목적: 선택된 선언문에 대해 구체적인 행동(action)을 수행.

- 정책: 하위 정책 σLO는 현재 상태 S를 기반으로 행동 a를 결정.

- 행동 옵션:

- 찬성(Support): 선언문을 협약에 포함하도록 찬성.

- 반대(Oppose): 선언문 포함에 반대.

- 수정(Refine): 선언문을 수정하여 협약 가능성을 높임.

- 타협(Compromise): 다른 선언문에 대한 입장을 바꿔 협상을 성사.

- 종료 조건: 선언문에 대한 협상이 완료되거나 최대 3라운드에 도달했을 때.

3. 보상 함수

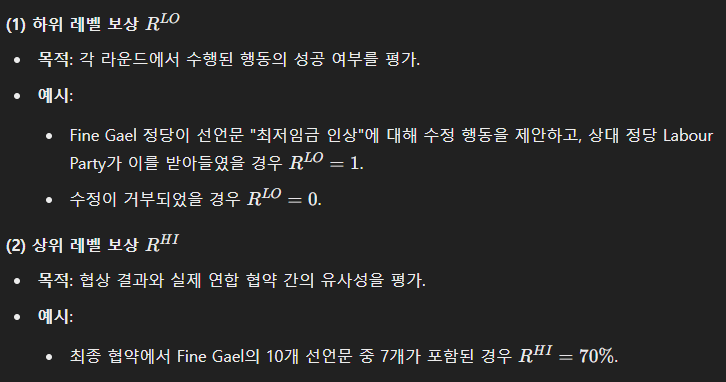

HMDP의 각 계층에서 보상 함수는 협상의 성과를 기반으로 정책을 업데이트합니다.

4. 데이터 및 시뮬레이션 설정

(1) POLCA 데이터셋

- 구성: 유럽 6개국의 정당 선언문과 연합 협약 데이터.

- 선언문 예시: "모든 시민에게 무료 교육 제공."

- 협약 결과: 포함, 부분 포함, 미포함.

(2) 에이전트 시뮬레이션

- LLM 기반 에이전트: OpenAI GPT-3.5-turbo, LLaMA-7b, LLaMA-13b 사용.

- 행동 로직:

- 선언문이 정당의 핵심 가치와 얼마나 연관되는지 평가.

- 상대 정당의 입장을 고려해 행동 선택.

- 다음 라운드에서 정책을 업데이트하여 전략 수정.

(3) 예시

Fine Gael와 Labour Party 간 협상:

- 1라운드:

- Fine Gael: "최저임금 동결" 제안 → Labour Party 반대.

- 2라운드:

- Fine Gael: "최저임금 동결"을 "최저임금 2% 인상"으로 수정 → Labour Party 수용.

- 결과:

- 최종 협약에 "최저임금 2% 인상" 포함.

5. 알고리즘

(1) 협상 프로세스

- 상위 레벨에서 협상할 선언문 m 선택.

- 하위 레벨에서 행동 a 결정 (찬성, 반대, 수정, 타협).

- 보상 R^{LO}, R^{HI} 평가 후 정책 업데이트.

(2) 알고리즘 단계

1. For each 선언문 \( m \):

2. 상위 레벨에서 선언문 선택.

3. For each 라운드:

4. 하위 레벨에서 행동 \( a \) 선택.

5. 상대방의 반응 평가.

6. 하위 레벨 보상 \( R^{LO} \) 업데이트.

7. 상위 레벨 보상 \( R^{HI} \) 평가.

8. 정책 \( \sigma^{LO}, \sigma^{HI} \) 업데이트.

6. 실험 및 분석

(1) 시뮬레이션 결과

- LLM 비교: GPT-3.5-turbo가 LLaMA 모델보다 더 높은 정확도(F1-score)를 기록.

- 정책 비교:

- 상위 및 하위 레벨 정책을 결합한 모델이 단일 정책 모델보다 성능 우수.

(2) 에러 분석

- 일부 선언문에서 LLM의 "환각(hallucination)"으로 잘못된 ID 생성.

- 협상 행동의 맥락적 연결 부족이 문제로 확인됨.

7. 방법론의 강점

- 정교한 정책 학습: 계층적 접근 방식을 통해 협상 과정의 복잡성을 효과적으로 모델링.

- LLM 활용: 정치적 언어와 협상 전략에 대한 강력한 이해력을 바탕으로 협상 결과 예측.

- 데이터 통합: POLCA 데이터셋을 활용하여 현실적인 협상 시뮬레이션 지원.

이 방법론은 AI Agent 연구를 위한 강력한 기반을 제공합니다. 특히, 협상 프로세스를 정밀하게 시뮬레이션하고 에이전트의 전략적 의사결정을 평가하는 데 유용합니다. 추가 질문이나 논의가 필요하면 말씀해주세요!

그럼 각 선언문 마다 정당이 액션을 취하면 상대 정당과의 협상을 통해 자신의 정당이 정한 목표에 최대한 가까운 협약을 만들어 낼 수록 높은 보상을 받는 건가?

네, 정확히 그렇습니다! 각 선언문마다 정당은 자신의 핵심 목표와 가치에 부합하는 협약을 이루기 위해 행동(action)을 선택하며, 협상 결과가 자신의 목표에 얼마나 가까운가에 따라 보상을 받습니다. 이를 구체적으로 설명하겠습니다.

1. 행동과 협상

- 각 정당은 선언문(statement)에 대해 협상을 진행하며, 행동 옵션 중 하나를 선택합니다:

- 찬성(Support): 선언문을 그대로 수용.

- 반대(Oppose): 선언문을 거부.

- 수정(Refine): 선언문을 수정하여 상대 정당이 받아들일 가능성을 높임.

- 타협(Compromise): 다른 선언문에서 양보하여 현재 선언문을 협상.

예시

Fine Gael과 Labour Party가 다음 선언문에 대해 협상 중이라고 가정:

- Fine Gael 선언문: "경제 성장을 위해 법인세를 동결한다."

- Labour Party의 반응:

- 1라운드: 반대(Oppose) → "법인세 동결은 불평등을 심화시킬 수 있다."

- 2라운드: Fine Gael이 "법인세 동결 대신 점진적 인하"로 수정(Refine).

- 결과: Labour Party 수용 → 협약에 반영.

2. 목표와 보상

(1) 정당의 목표

- 각 정당은 핵심 가치(Core Values)와 우선순위에 따라 선언문을 협약에 포함시키려 합니다.

- 목표는 선언문의 포함 비율과 협약 내용의 질로 정의됩니다.

- 자신의 가치에 부합하는 선언문을 더 많이 포함시킬수록 높은 보상을 얻습니다.

3. 전략적 협상

(1) 상호작용의 중요성

정당은 단순히 자신의 목표만을 고려하는 것이 아니라, 상대 정당의 목표와 우선순위를 이해하고 협상을 진행해야 합니다. 이 상호작용이 성공적인 협약을 만드는 데 핵심 역할을 합니다.

(2) 전략적 행동

- 수정(Refine): 자신의 목표를 일부 양보하면서도 상대 정당이 받아들일 가능성을 높이는 전략.

- 타협(Compromise): 자신의 중요도가 낮은 선언문에서 양보하여, 더 중요한 선언문을 협약에 포함시키는 전략.

예시

Labour Party와의 협상에서:

- Fine Gael이 상대적으로 중요도가 낮은 선언문 "지방 교통 시스템 개혁"에서 타협(Compromise) → 이로 인해 중요한 선언문 "법인세 인하"가 협약에 포함됨.

4. 시뮬레이션 결과

협상 성공의 요인

- 높은 보상을 얻기 위해서는 다음이 중요합니다:

- 자신의 핵심 가치를 명확히 정의.

- 상대 정당의 우선순위를 분석하여 행동 선택.

- 협상의 각 단계에서 보상 신호를 반영하여 전략을 지속적으로 개선.

LLM 에이전트의 역할

- 에이전트는 협상 과정에서 각 선언문과 행동의 중요도를 평가하고, 최적의 행동을 선택합니다.

- 보상을 기반으로 상위 정책과 하위 정책을 업데이트하여 점진적으로 더 나은 협상 결과를 도출.

5. 결론

정당은 선언문 하나하나에 대해 행동을 선택하고, 협상 과정을 통해 자신의 목표에 가까운 협약을 만들어냅니다. 협상의 성공은 자신의 가치와 상대방의 목표를 얼마나 잘 조율하느냐에 달려 있으며, 보상 시스템은 이를 효과적으로 측정하고 에이전트의 정책 학습을 지원합니다.

이 구조는 AI Agent를 설계할 때 목표 지향적 의사결정과 상호작용 기반 학습의 중요성을 잘 보여줍니다. 추가 논의가 필요하면 언제든지 말씀해주세요!

결과

논문의 결과, 결론 및 마무리 정리

1. 실험 결과

연구에서는 HMDP(Hierarchical Markov Decision Process)를 활용하여 정치적 연합 협상 과정을 시뮬레이션하고, 이를 평가하기 위해 다양한 LLM(대형 언어 모델)을 적용했습니다.

(1) HMDP 모델의 성능

- LLM별 성능 비교:

- GPT-3.5-turbo가 가장 높은 성능(F1-score)을 기록, LLaMA-13b 및 LLaMA-7b를 능가.

- 이는 GPT-3.5-turbo의 더 큰 모델 크기와 우수한 언어 이해 및 추론 능력 덕분.

- 계층적 정책(HI+LO)의 효과:

- 상위 및 하위 정책을 결합한 HMDP 모델은 단일 정책(HMDP-LO)이나 단순 설정(HMDP-Base)보다 더 나은 결과를 보여줌.

- 상위 정책은 협상할 선언문을 전략적으로 선택하며, 하위 정책은 선언문에 대한 구체적 행동(찬성, 반대 등)을 선택해 협상의 복잡성을 효과적으로 처리.

(2) 협상 과정의 특징

- 국가별 성능 차이:

- 각국의 정치적 맥락과 언어 차이로 인해 협상 결과의 정확도에 변동 발생.

- 예: 포르투갈 2011년의 협상 시뮬레이션에서 예측 정확도가 다른 국가보다 낮음.

- 행동 다양성:

- 정당별로 서로 다른 협상 행동 패턴을 보임:

- 어떤 정당은 더 공격적으로(반대 빈도가 높음), 다른 정당은 더 협조적으로(수정과 타협 빈도가 높음) 행동.

- 정당별로 서로 다른 협상 행동 패턴을 보임:

(3) 한계 및 에러 분석

- LLM의 한계:

- "환각(hallucination)" 문제: LLM이 잘못된 선언문 ID를 생성하거나 맥락에서 벗어난 응답을 제공.

- 정치적 언어와 협상의 복잡성을 완벽히 이해하지 못함.

- 데이터 불균형:

- POLCA 데이터셋에서 클래스(포함, 부분 포함, 미포함)의 불균형이 성능에 영향을 미침.

2. 결론

(1) 연구 기여

- 정치적 협상 모델링:

- NLP에서 처음으로 정치적 연합 협상을 모델링하는 시도를 통해 새로운 연구 방향 제시.

- HMDP 기반 프레임워크를 통해 협상의 복잡성과 상호작용을 효과적으로 반영.

- POLCA 데이터셋 구축:

- 유럽 6개국의 정치적 선언문과 협약 데이터를 통합한 새로운 다국어 데이터셋 제공.

- 데이터 부족 문제를 해결하고, 향후 연구의 기반 마련.

- LLM 평가:

- GPT-3.5-turbo와 같은 최신 LLM의 협상 시뮬레이션 능력과 한계를 정량적으로 분석.

(2) 연구 결과

- 정치적 연합 협상은 매우 복잡한 작업으로, LLM 기반 에이전트가 이를 효과적으로 시뮬레이션할 수 있음을 보여줌.

- 협상 과정의 전략적 의사결정(상위 정책)과 세부 행동(하위 정책)을 통합한 계층적 접근이 높은 성능을 보장.

(3) 정책 학습의 중요성

- 계층적 정책 학습(HI+LO)은 협상 과정에서 발생하는 동적 상호작용과 전략적 고려를 효과적으로 처리.

- 상위 정책이 선언문 선택의 방향성을 제공하며, 하위 정책은 구체적 행동을 통해 정당 간 합의를 이끌어냄.

3. 마무리 및 향후 연구 방향

(1) 연구 한계

- 데이터 범위 제한:

- POLCA 데이터셋은 6개 유럽 국가에 한정되어 있음.

- 실제 협상에서 중요한 요소(의석 분배, 정치적 동반자 등)를 반영하지 못함.

- 모델 한계:

- LLM은 일부 정치적 맥락과 협상 세부 사항을 충분히 이해하지 못함.

(2) 향후 연구 방향

- 데이터 확장:

- 다른 국가와 문화적 맥락을 포함하는 데이터셋으로 확장.

- 정치적 요소 추가:

- 의석 분배, 정당 간 동맹, 역사적 관계와 같은 요소를 모델링에 반영.

- LLM 최적화:

- 정치적 협상 작업에 특화된 LLM 개발 및 튜닝.

- 다자간 협상 시뮬레이션:

- 다수 정당이 참여하는 협상 모델링으로 확장.

(3) 결론

본 연구는 LLM 기반 에이전트와 HMDP를 활용해 정치적 협상 시뮬레이션의 가능성을 탐구한 첫 번째 시도입니다. 이를 통해 정치학과 NLP 간의 융합 연구의 새로운 길을 열었으며, 향후 데이터와 모델링 개선을 통해 더 나은 협상 시뮬레이션이 가능할 것으로 기대됩니다.

이 결론은 AI 에이전트 연구에서 협상 시뮬레이션을 포함한 복잡한 의사결정 문제를 해결하는 데 중요한 통찰을 제공합니다. 추가 논의나 심화 분석이 필요하다면 말씀해주세요!

관련 연구

논문에서 다룬 연구와 관련된 기존 연구를 정리하겠습니다. 이 부분은 NLP, 정치학, 에이전트 기반 모델링 분야의 교차점을 탐구하며, 특히 협상 및 정치적 분석에 대한 이전 연구와의 연관성을 체계적으로 분석합니다.

1. 정치학과 NLP

NLP 기술은 정치적 텍스트를 분석하는 데 활용되어 왔으며, 정치학에서 데이터 기반 접근 방식을 제공하는 데 기여했습니다.

(1) 정치 텍스트 분석

- 주제 모델링:

- Parthasarathy et al. (2019): 인도의 지역 회의 데이터를 사용해 정치적 의제를 자동으로 분석.

- 정치적 텍스트 분류:

- Chang and Masterson (2020): 정치 텍스트의 순서를 분석하여 정치적 메시지를 분류하는 데 장단기 메모리(LSTM) 모델 활용.

- 정치적 이념 탐지:

- Iyyer et al. (2014): 재귀 신경망(Recursive Neural Network)을 사용해 텍스트에서 정치적 이념을 탐지.

(2) 정당 선언문 분석

- 정당 선언문 이해:

- Orellana and Bisgin (2023): 뉴질랜드 정당 선언문 데이터를 NLP로 분석하여 정치적 방향성 평가.

- Bönisch et al. (2023): 독일 정치 선언문 데이터에서 주요 정보를 추출하는 방법론 제시.

- 감정 분석 및 프레임 식별:

- Gilardi et al. (2023): LLM을 활용해 정치적 감정, 입장, 프레임을 자동으로 탐지.

(3) 협상 모델링에 미흡한 점

- 기존 NLP 기반 접근법은 협상의 복잡한 상호작용이나 역사적 맥락을 충분히 반영하지 못했음.

- Guinaudeau and Deiss-Helbig (2020): 독일 정치 협상에서 공약 이행 데이터를 수집했지만, 협상의 과정을 상세히 모델링하지는 않음.

2. 에이전트 기반 모델링

에이전트 기반 모델링은 복잡한 상호작용과 환경에서 발생하는 행동을 시뮬레이션하기 위한 방법으로 널리 사용됩니다.

(1) LLM을 활용한 인간 상호작용 모델링

- 사회적 행동 시뮬레이션:

- Park et al. (2023): LLM 기반 에이전트를 사용해 "가상 사회생활(sandbox of social life)"을 시뮬레이션.

- 협력적 시나리오 시뮬레이션:

- Liang et al. (2023): 다수의 LLM 에이전트를 활용해 협력적 의사결정을 시뮬레이션.

- Saha et al. (2023): 교사-학생 모델을 통해 에이전트 간의 협력과 학습 과정 탐구.

(2) LLM 기반 협상 시뮬레이션

- 구체적 협상 사례:

- Fu et al. (2023): LLM을 활용해 상품 구매 협상을 모델링하며, AI 피드백을 통해 성능 개선.

- Bianchi et al. (2024): 다중 라운드 협상 시뮬레이션에서 LLM의 협상 전략 평가.

- 한계:

- 기존 연구는 간단한 협상 시나리오에 초점을 맞춰 정치적 협상의 복잡성을 다루지 못함.

- 예: 단일 상품 협상처럼 짧은 상호작용에 치중.

3. 정치적 협상 및 연합

정치적 협상과 연합 구성은 정치학에서 중요한 연구 주제입니다.

(1) 연합 협약 데이터

- CoalitionAgree Dataset:

- Klüver et al. (2023): 연합 협약을 데이터화하여 협상 결과를 구조적으로 분석.

- 연합 협상의 전략적 요인:

- Krauss and Kluever (2023): 포트폴리오 배분이 연합 협약 형성에 미치는 영향 분석.

- Ecker and Meyer (2020): 협상 기간이 협약 형성에 미치는 영향 평가.

(2) 공약과 협상

- 공약 이행 연구:

- Costello and Thomson (2008): 아일랜드에서의 연합 협상과 공약 이행 간의 관계 분석.

- 협상에서 정책 우선순위:

- Klüver and Bäck (2019): 협상 과정에서 중요한 정책 이슈와 그 반영 여부를 데이터화.

4. 관련 연구의 한계와 본 논문의 기여

(1) 기존 연구의 한계

- 기존 연구는 협상의 결과에 초점을 맞추는 경우가 많으며, 협상 과정의 전략적 상호작용을 충분히 모델링하지 못함.

- NLP 연구는 선언문 분석에 주력했지만, 이를 연합 협약과 연계하는 작업은 부족.

(2) 본 논문의 기여

- 협상 과정을 시뮬레이션하는 POLCA 데이터셋 제공:

- 선언문과 연합 협약 간의 관계를 다루는 다국어 데이터셋.

- HMDP 기반 협상 모델 제안:

- 협상의 복잡성과 장기적인 상호작용을 반영.

- LLM의 협상 능력 평가:

- 정치적 협상이라는 복잡한 시나리오에서 LLM의 잠재력과 한계를 정량적으로 분석.

5. 향후 연구 방향

- 다자간 협상: 다수의 정당이 참여하는 복잡한 협상 모델링.

- 정치적 편향 감소: 정치적 데이터를 처리할 때 발생하는 편향을 줄이기 위한 LLM 개선.

- 실시간 협상 시뮬레이션: 다양한 상황에서 에이전트 간 실시간 상호작용 탐구.

이와 같은 관련 연구와 본 논문의 기여는 정치적 협상 연구 및 AI 에이전트 설계의 새로운 방향성을 제시합니다. 추가 질문이나 심화 분석이 필요하면 말씀해주세요!

데이터 셋

| 데이터셋 이름 | POLCA (Political Coalition Agreement Dataset) |

| 구성 데이터 | - Manifesto Project Dataset - CoalitionAgree Dataset |

| 데이터셋 목적 | - 정당 선언문과 연합 협약 간의 관계를 분석하여 협상 과정을 시뮬레이션하기 위함. |

| 데이터셋 특징 | - 유럽 6개국의 실제 정치적 선언문 및 연합 협약 데이터를 포함. - 각 선언문이 최종 협약에 포함, 부분 포함, 미포함 여부를 라벨링. |

| 데이터 출처 | - Manifesto Project Dataset: 50개국, 1,000개 정당 선언문 제공. - CoalitionAgree Dataset: 다양한 국가의 연합 협약 데이터. |

| 데이터 구성 | - 국가: 오스트리아(2013), 독일(2013), 아이슬란드(2013), 아일랜드(2011), 네덜란드(2012), 포르투갈(2011). - 선언문과 협약의 문장 단위 분석. |

| 데이터 전처리 및 주석 | 1. 전처리: - 선언문과 협약 데이터를 수집하고 정렬. - 선언문의 문장 ID를 부여. 2. 주석 방법: - OpenAI의 GPT-4와 FAISS를 활용한 자동 주석. |

| 데이터 라벨링 | - 선언문이 최종 협약에 포함 여부에 따라 다음 3가지로 라벨링: 1. 포함(Included): 완전히 포함됨. 2. 부분 포함(Partly Included): 수정 후 반영됨. 3. 미포함(Not Included): 포함되지 않음. |

| 통계 정보 | |

| 데이터 사용 목적 | - 협상 시뮬레이션을 위한 정당 선언문과 협약 데이터의 관계 분석. - LLM 기반 에이전트의 협상 능력 평가 및 학습. |

| 데이터셋의 장점 | - 다국어 데이터셋: 정치적 다양성과 복잡성을 반영. - 라벨링 품질: 선언문과 협약 간의 정확한 관계를 나타냄. - 다양한 정치적 맥락: 여러 국가와 정당의 협상을 포괄. |

| 데이터셋의 한계 | - 6개국 데이터로 제한되어 글로벌 협상 시나리오를 충분히 반영하지 못함. - 협상 요소(의석 분배, 정치적 파트너십 등)를 포함하지 못함. |

그런데 여기선 협상을 이긴다 진다만 평가하는 것은 알겠는데 학습이나 더 나은 정책은 어떻게 만드는 거야?

논문에서 제안된 협상 시뮬레이션은 단순히 "이겼다/졌다"를 평가하는 것이 아니라, 에이전트가 더 나은 정책을 학습할 수 있도록 설계되었습니다. 이를 통해 협상 성과를 점진적으로 향상시키는 구조를 만듭니다. 아래에 학습 메커니즘과 더 나은 정책을 만드는 과정을 체계적으로 정리하겠습니다.

1. 더 나은 정책을 만드는 핵심 요소

(1) 계층적 정책 학습 (Hierarchical Policy Learning)

HMDP(Hierarchical Markov Decision Process) 구조는 상위 정책(HI)과 하위 정책(LO)을 분리하여 학습합니다.

- 상위 정책 (σ^{HI}):

- 협상할 선언문을 선택합니다.

- 목표: 최종 보상이 높은 선언문을 전략적으로 선택.

- 하위 정책 (σ^{LO}):

- 선택된 선언문에 대해 행동(찬성, 반대, 수정, 타협)을 결정합니다.

- 목표: 상대 정당의 반응을 기반으로 행동을 조정.

(2) 보상 기반 학습

- 정책 업데이트는 각 행동의 보상 결과를 통해 이루어집니다.

- 보상은 두 가지 수준에서 제공됩니다:

- 하위 레벨 보상 (R^{LO}): 각 행동(예: 선언문 수정) 이후 협상 결과의 성공 여부를 반영.

- 상위 레벨 보상 (R^{HI}): 전체 협상 결과(최종 협약)와 정당의 목표 간 유사성을 평가.

2. 학습 및 정책 개선 과정

HMDP 모델에서 정책 학습 및 개선 과정은 다음 단계로 이루어집니다:

(1) 초기 정책 설정

- 각 에이전트(정당)는 초기 상태에서 무작위 정책이나 단순 규칙 기반 정책을 사용.

- 예: 모든 선언문을 최대한 포함시키려는 기본 전략.

(2) 행동과 보상 피드백

- 선언문 선택 (상위 레벨):

- 협상할 선언문을 선택.

- 선언문의 중요도와 상대 정당의 입장을 고려.

- 행동 선택 (하위 레벨):

- 선언문에 대한 행동(찬성, 반대, 수정, 타협)을 결정.

- 상대 정당의 반응에 따라 행동이 성공적이었는지 평가.

- 보상 수집:

- 행동 결과에 따라 R^{LO}와 R^{HI} 보상을 수집.

(3) 정책 업데이트

- 정책 업데이트 메커니즘:

- 보상을 기반으로 정책을 업데이트하여 다음 협상에서 더 나은 행동을 선택.

- 이 과정은 강화학습의 정책 그라디언트(Policy Gradient) 또는 Q-learning과 유사한 방식으로 작동.

- 예시:

- Fine Gael이 선언문 "법인세 동결"을 수정(Refine)하고 상대가 수용했다면 RLO=1.

- 이 결과는 정책 업데이트를 통해 수정 행동의 성공 확률을 높임.

(4) 반복 학습

- 에이전트는 협상의 각 라운드에서 보상을 평가하고 정책을 지속적으로 개선.

- 협상이 반복될수록 더 높은 보상을 얻는 행동을 선택.

3. 더 나은 정책을 학습하는 전략

(1) 상대 정당의 행동 예측

- 상대 정당의 행동 패턴을 학습하여 더 효과적인 선언문과 행동을 선택.

- 예: 상대 정당이 "소득세 인하"에 대해 항상 찬성한다면, 이를 협상 초기 전략으로 활용.

(2) 행동 다양성 유지

- 모든 협상 상황에 대해 단일 전략만을 반복적으로 사용하면 실패 가능성 증가.

- 수정(Refine)과 타협(Compromise)을 적절히 조합하여 상대를 설득.

(3) 장기적 목표 학습

- 단기적 성공(개별 선언문 포함)보다는 장기적으로 협약 전체의 성공을 고려.

- 보상 R^{HI}는 전체 협약과 정당 목표의 유사성을 반영하여 장기적 학습을 지원.

4. 협상 시뮬레이션의 학습 사례

예시 1: 보상 기반 학습

Fine Gael 정당의 협상 과정:

- 초기 상태:

- Fine Gael은 "법인세 동결"을 포함하려 함.

- 상대 정당(Labour Party)은 이를 반대.

- 정책 학습:

- "법인세 동결"을 "법인세 인상 대신 동결"로 수정 → Labour Party 수용.

- R^{LO} = 1, R^{HI} = 0.8.

- 결과:

- Fine Gael은 "수정 행동"이 성공적임을 학습하여 다음 협상에서도 유사한 전략 사용.

예시 2: 상대 행동 예측

- Fine Gael은 "최저임금 동결" 선언문을 선택.

- 상대 정당이 "최저임금 인상"을 선호함을 학습.

- Fine Gael은 "최저임금 소폭 인상"으로 수정하여 협상 성공률 증가.

5. 결론

- 협상에서 "이긴다/진다"는 단순 평가가 아니라, 보상 기반 학습과 정책 업데이트를 통해 더 나은 전략을 지속적으로 만들어가는 과정.

- HMDP와 보상 피드백을 통해:

- 선언문 선택과 행동의 효율성을 학습.

- 협상의 반복과 상호작용을 통해 정책을 점진적으로 개선.

- 장기적 목표를 고려하여 협상 성공률을 높임.

이 접근은 AI 에이전트가 동적인 협상 환경에서 전략적이고 적응적인 행동을 학습하도록 지원합니다. 추가 질문이 있으면 말씀해주세요!

그런데 언어 모델이다 보니 학습이라기 보다는 Context Learning으로 진행할 것 같은데 그럼 성공 사례를 모아놓는 건가...?

아님 성공 사례를 few shot으로 넣는거야?

논문에서는 언어 모델(LLM) 기반 에이전트가 협상을 진행하며, 학습 자체는 전통적인 "모델 업데이트" 방식이 아니라, 컨텍스트 학습(Contextual Learning) 또는 In-Context Learning (ICL)을 활용한 방식으로 진행됩니다. 이는 LLM이 미리 학습된 지식을 기반으로 협상 과정에서 동적인 결정을 내리는 구조에 더 가깝습니다.

논문에서 사용된 방법론에 기반하여 질문에 답변을 구체화하겠습니다.

1. 논문에서의 LLM 학습 접근 방식

(1) In-Context Learning(ICL)

- LLM은 별도의 모델 업데이트 없이 협상 과정에서 주어진 컨텍스트(문맥)를 활용해 적절한 행동을 선택합니다.

- 이는 Few-Shot Prompting과 유사하게, 성공 사례와 협상 히스토리를 컨텍스트로 제공하여 모델이 이를 참고하도록 만듭니다.

(2) Few-Shot Prompting

- 협상 시뮬레이션에서 에이전트는 선언문과 상대 정당의 이전 반응(협상 히스토리)을 포함한 입력을 기반으로 행동을 결정.

- Prompt 구성 요소:

- 현재 협상 선언문과 맥락 정보.

- 상대 정당의 반응(찬성, 반대, 타협 등).

- 성공적인 협상 사례(과거 행동 및 결과).

(3) 성공 사례 활용

- 모델이 협상에서 성공적으로 도출한 행동(예: 수정이나 타협으로 합의에 도달한 사례)을 기억.

- 다음 협상에서 이러한 성공 사례를 Prompt로 제공하여 행동을 개선.

2. 논문에서의 구체적인 수행 방식

(1) Prompt Design

LLM 기반 에이전트는 협상 진행 시 아래와 같은 입력 형식의 Prompt를 통해 행동을 결정합니다:

현재 선언문: "최저임금 2% 인상"

상대 정당 반응: "Labour Party는 소폭 인상을 요구하며, 5% 인상이 더 적합하다고 주장함."

이전 협상 히스토리:

- 선언문: "법인세 동결"

결과: "Fine Gael이 '법인세 점진적 동결'로 수정, Labour Party 수용"

- 선언문: "공공 교육 예산 증액"

결과: "Fine Gael이 타협, 50% 예산 증액으로 합의"

다음 행동 옵션:

1. 찬성

2. 반대

3. 수정

4. 타협

(2) 행동 선택 과정

- Prompt의 성공 사례 참고:

- 이전 협상 히스토리를 바탕으로 "수정"이나 "타협"이 성공적인 전략임을 학습.

- 컨텍스트 기반 결정:

- "최저임금 2% 인상"을 "최저임금 3% 인상"으로 수정하여 상대 정당이 수용할 가능성을 높임.

- 행동 출력:

- 모델은 "수정" 행동을 출력하며, 수정된 선언문도 생성.

3. 성공 사례의 관리

(1) Explicit Memory (명시적 기억)

- 성공 사례를 Prompt에 추가하여 동적으로 모델의 행동을 조정.

- 과거 협상 히스토리를 기록하고 다음 협상에서 참조 가능하도록 설계.

(2) Few-Shot Sample Update

- Few-Shot Prompting에서 사용하는 성공 사례를 지속적으로 갱신.

- 협상이 반복될수록 더 나은 사례를 저장하고, 이전 Prompt를 새롭게 구성.

(3) 실패 사례 활용

- 실패한 협상 히스토리도 Prompt에 포함하여, 잘못된 행동을 피하도록 유도.

- 예: "타협이 실패한 선언문"에 대한 정보를 제공해 동일한 실수를 반복하지 않도록 설계.

4. 논문에서의 주요 한계

- 학습의 제한:

- 논문에서는 모델 자체를 Fine-tuning하지 않고, Prompt를 통해 동적인 학습을 진행.

- 따라서 장기적인 학습이나 정책 최적화는 어려울 수 있음.

- Prompt 길이의 제약:

- LLM은 제한된 컨텍스트 크기 내에서만 정보를 처리 가능.

- 협상 히스토리가 많아질수록 중요한 정보를 선택적으로 포함해야 함.

5. 추가로 가능한 접근 방법

(1) Memory-Augmented Framework

- 협상 성공 사례와 히스토리를 외부 메모리에 저장하고, 이를 동적으로 Prompt에 통합.

- 예: FAISS와 같은 검색 시스템을 활용해 관련 히스토리를 찾아 모델에 제공.

(2) Iterative Fine-Tuning

- 특정 협상 도메인에 맞춘 추가 Fine-Tuning을 통해 LLM의 성능을 개선.

- 하지만 논문에서는 Fine-Tuning 대신 In-Context Learning을 선호.

6. 결론

논문에서는 Few-Shot Prompting과 In-Context Learning을 통해 협상 에이전트의 학습과 행동 개선을 구현했습니다. 이는 성공 사례와 협상 히스토리를 Prompt로 제공하여 모델이 이를 참고해 더 나은 행동을 선택하도록 유도하는 방식입니다. 모델 자체를 Fine-Tuning하지 않는 대신, 컨텍스트와 Prompt 설계를 최적화하여 성능을 향상시키는 접근입니다.

추가 질문이나 논의가 필요하면 말씀해주세요!

아래는 제공하신 내용에 기반하여 부족한 점을 보완하고, 논문의 핵심과 정확성을 담아 수정한 내용입니다.

수정 및 보완된 정리

협상 과정을 모델링한 점은 흥미롭지만, 몇 가지 부족한 부분이 보입니다.

1. HMDP를 통한 승률 향상

- 연구에서 계층적 마르코프 결정 프로세스(HMDP)를 도입하여 협상 전략을 상위(HI)와 하위(LO) 레벨로 나눴습니다. 이를 통해 협상 과정을 구조적으로 모델링하고, 정당 선언문 선택과 행동 결정에서 전략성을 극대화하려는 시도가 돋보입니다.

- HMDP는 보상 기반 학습을 활용하여 협상의 성공률을 점진적으로 높이는 메커니즘을 제공합니다. 특히, 상위 레벨 정책은 협상할 선언문을 전략적으로 선택하며, 하위 레벨 정책은 선언문에 대한 구체적 행동(찬성, 반대, 수정, 타협)을 최적화합니다.

2. 다양한 LLM 활용

- GPT-3.5-turbo, LLaMA-7b, LLaMA-13b와 같은 여러 LLM을 에이전트로 활용하여 모델 성능을 비교했습니다.

- 실험 결과:

- GPT-3.5-turbo가 가장 높은 성능(F1-score)을 기록하며, 더 큰 파라미터와 강력한 추론 능력을 가진 모델이 협상 시뮬레이션에 더 적합함을 보여줍니다.

- 그러나 LLaMA-7b와 LLaMA-13b의 성능이 상대적으로 낮아, 보다 다양한 LLM과의 비교 및 분석이 추가적으로 이루어졌다면 더 풍부한 결과를 도출할 수 있었을 것입니다.

3. 데이터와 모델 성능 비교의 아쉬움

- 연구에서 활용한 POLCA 데이터셋은 유럽 6개국의 정당 선언문과 협약 데이터를 포함하고 있어 현실적인 협상 시뮬레이션을 가능하게 했습니다. 하지만, 협상 요소가 선언문 포함 여부에 한정되어 있어 의석 분배, 정치적 파트너십과 같은 더 복잡한 협상 요인들이 반영되지 않았다는 점이 아쉽습니다.

- 모델 비교도 GPT-4, PaLM 등 최신 대형 모델이나 다양한 크기의 모델과의 성능 차이를 분석하지 않은 점은 한계로 보입니다.

4. 전체적인 성능 향상과 평가

- HMDP와 LLM의 결합으로 협상 시뮬레이션의 가능성을 보여준 것은 인상적입니다. 특히, 계층적 정책 학습을 통해 단순히 "협상을 이긴다/진다"를 넘어 정당 선언문 선택과 협상 전략 최적화를 시도한 점은 연구의 주요 기여로 평가됩니다.

- 다만, 모델 성능 비교가 보다 풍부하고 협상 맥락을 더 잘 반영한 데이터가 추가되었다면, 전체적인 연구 기여도가 더 높아졌을 것입니다.

최종 평가

논문은 정치적 협상 모델링이라는 새로운 NLP 과제를 제안하고, HMDP와 LLM을 활용한 시뮬레이션을 통해 가능성을 입증했습니다. 하지만 더 다양한 모델 및 복잡한 협상 요인을 반영하지 못한 점은 아쉬움으로 남습니다. 향후 연구에서는 최신 LLM을 포함한 보다 광범위한 모델 비교와 협상 시뮬레이션의 확장을 기대할 수 있습니다.

이 내용은 논문의 기여와 한계를 균형 있게 평가하며, 부족한 점과 개선 가능성을 포함하여 보완된 정리입니다. 추가 의견이 있으시면 말씀해주세요!