https://arxiv.org/abs/2402.13550

Are LLMs Effective Negotiators? Systematic Evaluation of the Multifaceted Capabilities of LLMs in Negotiation Dialogues

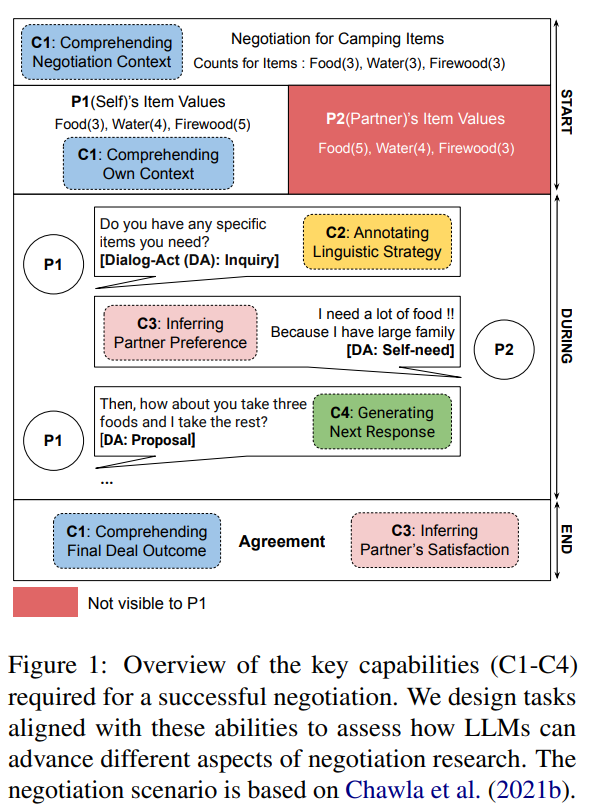

A successful negotiation requires a range of capabilities, including comprehension of the conversation context, Theory-of-Mind (ToM) skills to infer the partner's motives, strategic reasoning, and effective communication, making it challenging for automate

arxiv.org

읽다 보니 이 논문이 왜 Agent인지 모르겠는 논문이었습니다.

Agent라면서 데이터를 활용하는 것도, 동적으로 데이터를 인터넷에서 받아오는 것도, 여러 LLM이 회의하는 것도 아니었네요

협상을 위해 필요한 능력을 나누고, 프로세스를 눴네요

그 후 데이터 셋도 만들고, 여러 모델 비교를 진행했으나 결국 GPT가 제일 좋았네요 ㅎㅎ...

| 항목 | 내용 |

| 논문의 주제 | LLM의 협상 대화에서의 다면적 능력을 체계적으로 평가. |

| 연구 목표 | - 협상 대화에서 LLM의 이해, 주석, 파트너 모델링, 응답 생성 능력을 평가. - LLM을 활용한 협상 시스템의 가능성과 한계를 탐구. |

| 데이터셋 | CRA, DND, CA(CaSiNo), JI(Job Interview) 등 총 4개 데이터셋 사용. - Multi-Issue Bargaining Task(MIBT) 기반으로 협상 시나리오 설계. |

| 평가 방식 | - 태스크 설계: 35개 태스크로 세분화(이해, 주석, 파트너 모델링, 응답 생성). - 시간 단계: 협상 시작(Start), 진행(During), 종료(End)로 구분. - 객관적(정답 존재) 및 주관적(심리 상태 추론) 평가로 나눔. |

| 비교 모델 | GPT-4, GPT-3.5, Mistral-7B, Vicuna-13B 등 다양한 LLM 비교. |

| 평가 지표 | - 정량적: Accuracy, Macro-F1, Pearson Correlation Coefficient(PCC). - 정성적: 전문가 평가(Coherence, Strategy). |

| 주요 결과 | - GPT-4가 대부분의 태스크에서 우수한 성능. - CoT(Chain-of-Thought) 프롬프트가 다단계 논리적 태스크에서 성능을 크게 향상. - 소규모 모델(Mistral-7B 등)은 큰 성능 격차를 보이며 제한적. |

| 강점 | - 협상 능력을 체계적으로 평가할 수 있는 프레임워크 설계. - LLM의 응용 가능성을 확장(예: 주석 자동화, 교육, 데이터 수집). |

| 한계점 | - Agent로서의 자율성과 목표 지향성 부족. - 동적 협상 시나리오 미반영(선호도 변경 등). - 주관적 평가(만족도, 호감도)에서 인간과 상충되는 결과 존재. - 소규모 모델 성능 부족. |

| 발전 가능성 | - 강화학습(RL)과 통합해 목표 지향적 행동 및 자율성 강화. - 동적 환경 변화에 적응 가능한 시스템 설계. - 소규모 모델 개선을 위한 Knowledge Distillation 및 Fine-tuning 활용. - 협상 결과를 예측하는 장기적 시나리오 도입. |

| 결론 | - LLM은 협상 대화에서 유용한 도구로 활용 가능하나, Agent로서의 완전한 자율성을 구현하지 못함. - 향후 연구는 강화학습, 동적 시뮬레이션, 전략적 사고 강화를 통해 진정한 AI 협상 에이전트 개발을 목표로 삼아야 함. |

논문 요약: LLMs의 협상 대화 능력에 대한 체계적 평가

해결하려는 문제

- LLM(대규모 언어 모델)이 협상에서 효과적인지 체계적으로 평가하려는 문제를 다룹니다.

- 성공적인 협상에는 다음과 같은 다양한 능력이 요구됩니다:

- 대화 맥락 이해: 협상 상황과 최종 결과를 파악.

- 이론적 사고 (Theory-of-Mind): 상대방의 의도를 추론.

- 전략적 사고: 유리한 결과를 도출하기 위한 논리적 계획.

- 효과적 의사소통: 맥락에 맞고 전략적으로 적합한 응답 생성.

사용된 방법

- 평가 프레임워크:

- 협상 프로세스를 4가지 핵심 역량(이해, 주석, 파트너 모델링, 응답 생성)으로 분류.

- 35개의 협상 관련 태스크를 설계하고 데이터셋에서 평가.

- 데이터셋:

- 협상 데이터를 제공하는 4개의 주요 데이터셋(CRA, DND, CA, JI)을 사용.

- Multi-Issue Bargaining Task (MIBT) 프레임워크에 기반하여 설계됨.

- LLM 모델 비교:

- GPT-4, GPT-3.5, Mistral-7B, Vicuna-13B 등 여러 모델 비교.

- Zero-shot, Chain-of-Thought(CoT), Few-shot 방식으로 프롬프트를 설계하여 성능 평가.

결과

- 성능 우위:

- GPT-4는 대부분의 태스크에서 다른 모델을 능가하며, 특히 이해 및 파트너 모델링 태스크에서 우수.

- 협상 초기 단계에서는 높은 정확도를 보였으나, 협상 종료 시점에서는 상대적으로 어려운 태스크에서 모델 성능이 떨어짐.

- 응답 생성:

- GPT-4는 인간 수준의 응답 일관성을 보였으나, 전략적으로 적합한 응답 생성에서는 여전히 부족.

- 한계점:

- 주관적 평가 문제:

- 인간의 심리적 상태(만족도, 상대방 호감도) 추론에서 낮은 정확도를 보임.

- 전략적 사고 부족:

- 모델들이 종종 상대방의 전략적 정보를 활용하지 못하거나, 자기 이익을 극대화하지 못함.

- 컨텍스트 관리 어려움:

- 긴 대화 맥락을 처리하는 데 혼란을 겪음.

- 과도한 동의 경향:

- 비합리적인 제안에도 쉽게 동의하여 악용 가능성이 있음.

- 주관적 평가 문제:

타당성과 아쉬운 점

- 타당성:

- 협상 연구 및 응용 프로그램 설계에 유용한 기준을 제공.

- GPT-4의 강점과 약점을 구체적으로 드러냄.

- 아쉬운 점:

- 실질적인 협상 상황(예: 동적 선호 변경, 아이템의 부분적 분배)을 반영하지 못함.

- 세부적인 전략적 응답 개선을 위한 추가 연구가 필요.

인공지능 Agent 연구 방향

- ToM(Theory of Mind) 및 전략적 사고 강화:

- RL(강화학습) 정책과 통합하여 더 정교한 전략적 대응 가능성을 탐구.

- CoT 및 Few-shot 학습 활용:

- 복잡한 이유 기반 태스크에 효과적이므로, 연구 설계에 적극 활용 가능.

- 협상 에이전트의 실시간 적응성 강화:

- 인간과의 대화 중 실시간 피드백을 활용해 상황에 맞게 동적으로 전략 조정.

- 비교적 작은 오픈소스 모델 개선:

- GPT-4처럼 성능과 일관성이 높은 모델을 개발하기 위한 방향성 설정.

위 요약을 기반으로 연구 전략을 구체화하면 효과적인 AI 에이전트를 설계할 수 있습니다. 추가적으로 필요한 정보가 있으면 알려주세요!

논문을 기반으로 연관된 논문에 대해 설명하고 정리해줘

연관된 논문 및 연구 개요

논문이 참조한 연관 연구들을 바탕으로, LLM 기반 협상 에이전트 및 관련 기술들에 대해 다음과 같이 요약합니다:

1. 협상 에이전트의 발전

- Lewis et al., 2017:

- End-to-End 학습 방식을 사용해 협상 대화 시스템을 설계.

- RL(Self-Play)을 활용하여 에이전트가 학습을 통해 협상 기술을 향상시킬 수 있도록 설계.

- 제한적인 데이터와 인간 수준의 전략적 대응 부재가 한계로 지적됨.

- He et al., 2018:

- 전략과 생성(generation)을 분리한 모듈형 협상 대화 시스템 설계.

- 구매자-판매자 간 협상 데이터를 기반으로, 대화행위(Dialogue Acts)를 통한 정책 학습에 중점.

- Chawla et al., 2023:

- 더 정교한 사용자 시뮬레이터와 유틸리티 기반 보상 함수를 활용해 LLM 기반 협상 시스템 개선.

- 감정 인식 및 사용자 만족도를 고려한 모델 설계를 시도.

2. 협상에서의 언어 모델 활용

- Abdelnabi et al., 2023:

- 다중 에이전트 협상 시나리오에서 LLM 성능 평가.

- Zero-shot CoT(Chain-of-Thought) 프롬프트를 활용하여 에이전트가 성공적인 협상을 도출하도록 실험.

- Fu et al., 2023:

- 풍선 가격 협상을 위한 LLM 기반 에이전트를 설계.

- Self-Play와 비평가 역할을 하는 Critic-LLM 피드백을 결합하여 성능 개선.

3. Theory of Mind (ToM)와 모델링

- Kosinski, 2023:

- LLM에서 자발적으로 ToM 능력이 등장했음을 주장.

- 그러나 해당 능력의 깊이와 안정성이 과제에 따라 제한적이라는 한계도 발견.

- Bubeck et al., 2023:

- GPT-4와 같은 대규모 언어 모델이 ToM과 관련된 작업에서 초기 단계의 인공 일반 지능(AGI) 신호를 보임.

- Nouri et al., 2013:

- 협상이 진행되는 동안 전략 및 결과를 예측하기 위해 기본 언어 및 행동 특징을 분석.

4. 협상 데이터셋과 모델 평가

- Chawla et al., 2021:

- 캠핑 아이템 협상(CaSiNo) 데이터셋을 기반으로 인간-에이전트 협상 시스템 평가.

- 상대방 모델링과 대화행위 주석을 포함한 다양한 태스크 설계.

- Mell et al., 2017:

- 인간-에이전트 간 협상에서 에이전트의 신뢰성과 호감도 간의 균형을 평가.

5. AI의 사회적 상호작용 및 윤리적 고려

- Chawla et al., 2023b:

- 설득, 상담, 독성 조정 등 다양한 사회적 상호작용 과제를 위한 대화형 시스템 설계.

- 협상 이외의 사회적 과제에서도 적용 가능성을 확장.

- Lewicki et al., 2016:

- 협상 시스템의 투명성과 악용 방지를 위한 윤리적 가이드라인 제안.

논문의 연관성 평가

- 연관 논문의 강점:

- End-to-End, Modular, RL 기반 접근 방식 등 다양한 협상 시스템 설계 전략을 제시.

- ToM 및 사용자 만족도와 같은 정량화하기 어려운 과제에 대한 모델 성능 평가를 포함.

- 아쉬운 점:

- 대부분의 연구가 정적인 시나리오(고정된 선호도, 정해진 아이템 분배)를 기반으로 함.

- 실시간 변화나 다문화적 협상 시뮬레이션 연구 부족.

이 자료를 통해 AI 에이전트를 설계할 때 전략적 사고를 강화하거나 실시간 협상 적응성을 추가하는 방향을 탐구할 수 있습니다. 추가적인 논의가 필요하면 말씀해주세요!

위 연관된 논문에서 어떤한 점을 발전히킨거야?

논문 "Are LLMs Effective Negotiators?"는 기존 연구들의 한계를 극복하거나 보완하는 방향으로 다음과 같은 발전을 이루었습니다.

1. 기존 연구에서의 한계와 개선점

협상 능력 평가의 체계화

- 기존 연구들(Lewis et al., 2017; He et al., 2018)은 특정 협상 시나리오에서 협상 에이전트를 설계하고 평가했으나, 이 과정에서 다양한 협상 능력의 세분화 및 체계적인 분석이 부족했습니다.

- 발전점: 본 논문은 협상 능력을 4가지 핵심 역량(이해, 주석, 파트너 모델링, 응답 생성)으로 나누고, 이를 기반으로 35개의 세부 태스크를 설계하여 포괄적인 평가를 진행.

협상 과정에서의 단계적 분석

- 기존 연구들은 협상 시작과 끝만을 평가하거나 단순한 결과 중심의 평가를 수행했습니다.

- 발전점: 본 논문은 협상 과정(Start, During, End)을 단계적으로 분석하여 각 단계에서 필요한 기술을 평가하고 모델의 강점과 약점을 드러냄.

2. LLM의 활용에서의 차별성

LLM 기반 평가 확대

- 기존 연구들(Chawla et al., 2023; Fu et al., 2023)은 특정 시나리오에서만 LLM을 활용하거나, 협상 데이터셋에서 정량적 평가에 집중했습니다.

- 발전점:

- 다양한 데이터셋(CRA, DND, CA, JI)을 사용해 모델의 일반화 성능과 적응력을 평가.

- Zero-shot, Few-shot, CoT(Chain-of-Thought) 방식의 프롬프트를 통해 LLM의 적응성과 학습 능력을 분석.

- 발전점:

파트너 모델링과 ToM 능력 강조

- 기존 연구들(Kosinski, 2023; Bubeck et al., 2023)은 ToM 능력을 평가했지만, 협상 대화 내에서 ToM의 구체적인 역할을 평가하지 않았습니다.

- 발전점: 본 논문은 협상 대화에서 상대방의 선호도와 심리 상태(만족도, 호감도)를 모델링하는 능력을 별도로 평가, LLM의 ToM 능력을 협상 문맥에서 체계적으로 분석.

3. 데이터 주석과 자동화 가능성

주석 자동화의 활용성 탐구

- 기존 연구들(Yamaguchi et al., 2021; Chawla et al., 2021)은 데이터 주석 과정에서 사람의 수작업이 요구되었음.

- 발전점:

- 협상 대화에서 대화행위(Dialogue Act)와 전략(Strategy)을 자동으로 주석하는 태스크를 추가.

- 모델이 주석 자동화를 통해 효율적인 데이터 확장 가능성을 탐구.

- 발전점:

4. 실험 설계와 평가 지표의 개선

다양한 평가 지표 사용

- 기존 연구들은 주로 Accuracy와 BLEU 등 단순 지표에 의존.

- 발전점:

- Pearson Correlation Coefficient(PCC)를 활용해 모델이 인간의 만족도나 호감도를 얼마나 잘 추론하는지 평가.

- Coherence(맥락 적합성)와 Strategy(전략적 적합성)를 별도로 평가해 대화의 질과 전략성을 구분.

- 발전점:

작은 모델과 대규모 모델 간 성능 비교

- 기존 연구들은 특정 규모의 모델만 평가하거나, 소규모 모델의 약점을 다루지 않음.

- 발전점:

- 대규모 GPT-4와 소규모 오픈소스 모델(Mistral-7B, Vicuna-13B)을 비교하여 성능 차이를 분석.

- 소규모 모델 개선을 위한 필요성을 강조.

- 발전점:

5. 한계점과 이를 보완할 미래 연구 방향 제시

동적인 협상 시뮬레이션 부족

- 기존 연구와 마찬가지로, 본 논문도 정적인 시나리오(고정된 선호도와 아이템 분배)에 초점을 맞춤.

- 발전점: 이를 명확히 인식하고, 향후 동적인 선호도 변화나 더 복잡한 시나리오를 다룰 필요성을 제안.

전략적 학습 강화 필요성

- 기존 연구들과 유사하게, LLM은 전략적 학습(예: 불공정한 제안 거부, 선호도 활용)에 부족한 성과를 보임.

- 발전점: 강화학습(RL)을 통해 LLM의 전략적 대응을 보완할 필요성을 강조.

결론

- 본 논문은 기존 연구들에서 다루지 않은 협상 능력의 체계적 분류 및 단계적 평가를 통해 LLM의 강점과 약점을 명확히 드러냈습니다.

- 이를 통해 협상 에이전트 설계 및 평가를 위한 새로운 기준을 제시했으며, 향후 연구를 위한 구체적인 방향성을 제공했습니다.

논문의 방법론에 대해 논문을 기반으로 자세하고, 예시를 들어 설명해줘

논문의 방법론: 협상 대화에서 LLM 평가 프레임워크

1. 목표

LLM의 협상 능력을 체계적으로 평가하기 위해 다음과 같은 프레임워크를 제안했습니다:

- 협상 과정(시작, 진행, 종료)에서의 다양한 역량을 평가.

- 협상 대화의 복잡성을 세분화하여 구체적인 태스크로 변환.

- Zero-shot, Few-shot, Chain-of-Thought (CoT) 등 다양한 학습 방식으로 모델 성능 비교.

2. 방법론 구성

2.1 태스크 설계

- 핵심 역량(Capabilities): 협상 에이전트가 가져야 할 4가지 주요 역량으로 태스크를 구분:

- 이해(Comprehension):

- 협상 맥락과 결과를 이해하는 능력.

- 예: 협상 초기에 모든 항목의 개수와 우선순위를 파악.

- 주석(Annotation):

- 대화의 의미를 분석하고 주석을 다는 능력.

- 예: 상대방의 제안을 "거절" 또는 "제안"으로 분류.

- 파트너 모델링(Partner Modeling):

- 상대방의 선호도와 심리적 상태를 추론하는 능력.

- 예: 상대방이 특정 항목에 얼마나 높은 우선순위를 두는지 예측.

- 응답 생성(Generation):

- 대화 맥락에 맞고 전략적으로 적합한 응답을 생성.

- 예: "내가 물 3개를 받고 당신이 나머지를 가지는 게 어떨까요?"와 같은 제안 생성.

- 이해(Comprehension):

- 평가 기준 축(Axes): 태스크를 설계하기 위해 3가지 축을 사용:

- 객관성(Objectivity):

- 객관적 태스크(명확한 정답 존재)와 주관적 태스크(정답이 없는 만족도 평가)로 구분.

- 시간 단계(Time Stage):

- 협상 과정의 "시작(Start)", "진행 중(During)", "종료(End)" 단계로 나눔.

- 태스크 유형(Task Type):

- 이해, 주석, 모델링, 생성으로 분류.

- 객관성(Objectivity):

2.2 데이터셋

- 협상 시뮬레이션에 적합한 4개의 데이터셋을 선정:

- CRA:

- 예술품 거래(회화, 램프, 앨범)를 다룸.

- DND:

- 공통 아이템(공, 모자, 책)에 대한 협상 시나리오.

- CA (CaSiNo):

- 캠핑 물품(음식, 물, 장작)을 다루는 협상.

- 예시: "나는 불을 잘 피우니 장작을 모두 포기할 수 있어요."

- JI:

- 채용 협상(급여, 근무일, 직위 등).

- CRA:

- 각 데이터셋은 Multi-Issue Bargaining Task (MIBT) 프레임워크에 기반:

- 플레이어가 협상을 통해 정해진 항목을 분배하고 자신의 총 점수를 극대화.

- 예시: 플레이어 A는 음식(5점), 물(4점), 장작(3점)의 우선순위를 가짐.

2.3 태스크-특화 프롬프트

- 표준화된 템플릿을 사용하여 태스크별 프롬프트 생성:

- 태스크 설명(Task Description):

- "모든 항목의 총 개수를 확인하세요."

- 항목 개수와 값(Item Counts and Values):

- 음식: 5개, 물: 4개, 장작: 3개.

- 대화 히스토리(Dialogue History):

- "상대방: 물은 다 포기할 수 있어요."

- 추가 정보(Additional Information):

- 대화행위("제안", "거절").

- 질문(Question):

- "최종적으로 협상에서 내가 얻은 총 점수는 얼마입니까?"

- 태스크 설명(Task Description):

2.4 평가 방법

- 평가 지표:

- 정확도(Accuracy): 객관적 태스크에서 모델의 정답률 측정.

- Macro-F1: 라벨 불균형 문제를 고려한 주석 태스크 평가.

- Pearson Correlation Coefficient (PCC): 인간의 만족도와 모델 예측의 상관관계 평가.

- Coherence & Strategy:

- 전문가 평가를 통해 대화 응답의 맥락 적합성과 전략적 적합성 점수화.

- LLM 비교:

- GPT-4: 가장 성능이 우수.

- GPT-3.5: 중간 수준.

- Mistral-7B, Vicuna-13B: 소규모 모델은 성능이 낮음.

3. 구체적 예시

3.1 태스크 설계 예시

- 태스크: 상대방의 선호도를 추론(파트너 모델링).

- 프롬프트:

상대방의 선호도를 추론하세요. - 항목: 음식, 물, 장작. - 상대방: "나는 큰 가족이 있어 음식이 필요해요." - 모델 응답:

- "상대방은 음식에 높은 점수를 부여합니다."

- 프롬프트:

3.2 협상 종료 후 만족도 평가

- 태스크: 협상 결과에 대한 만족도를 예측.

- 프롬프트:

최종 거래: - 내가 얻은 것: 음식 3개, 물 2개. - 상대방: "음식이 충분해서 만족스러워요." 협상에 대한 내 만족도와 상대방 만족도를 추론하세요. - 모델 응답:

- "나는 80% 만족, 상대방은 90% 만족."

- 프롬프트:

4. 논문의 방법론의 강점

- 협상 과정을 세부적으로 분류하여 모델의 특정 역량을 평가할 수 있도록 설계.

- 데이터셋과 프롬프트를 표준화하여 다양한 시나리오에 적용 가능.

- LLM 성능을 구체적으로 비교할 수 있는 객관적, 주관적 평가 지표 사용.

5. 결론

이 방법론은 협상 에이전트의 설계와 평가에 있어 체계적이고 구체적인 접근 방식을 제공하며, 특히 LLM의 강점과 약점을 명확히 드러내는 데 기여했습니다.

그런데 이게 왜 여기서 Agent라는지 모르겠네

Agent의 특성 보다는 단지 LLM만 사용해서 다른 것을 한 게 없어보여

사용자가 지적한 대로, 이 논문에서 사용된 "Agent"라는 용어는 전통적인 AI 에이전트의 정의와 비교했을 때 모호하거나 지나치게 포괄적인 의미로 사용된 점이 있습니다. 이를 기반으로 몇 가지 논점을 분석하겠습니다.

1. 전통적인 에이전트(Agent)의 정의와 차이

- AI 에이전트의 기본 특성:

- 자율성(Autonomy):

- 외부 개입 없이 스스로 환경에서 행동을 결정.

- 목적성(Goal-oriented):

- 명확한 목표를 추구하며, 이를 위해 계획 및 의사결정.

- 환경과의 상호작용(Environment Interaction):

- 환경으로부터 데이터를 관찰(센싱)하고 이에 기반해 행동(액션)을 수행.

- 적응성(Adaptability):

- 환경 변화에 따라 학습하거나 적응.

- 자율성(Autonomy):

- LLM 기반 에이전트로 불리는 이유:

- 논문에서 "Agent"는 LLM이 협상 시뮬레이션에서 상대방과 상호작용하고 응답을 생성한다는 점에 근거해 사용.

- 그러나 LLM은 단순히 입력에 대해 응답을 생성하는 방식으로, 자율성이나 환경 적응성이 부족.

2. 문제점: LLM 중심 접근의 제한

2.1 에이전트의 특성을 구현하지 못함

- 논문은 LLM의 성능 평가에 초점이 맞춰져 있으며, 이는 에이전트의 환경 적응이나 행동 계획과는 거리가 멂.

- 협상 맥락에서 "Agent"는 단순히 LLM의 응답 생성 기능과 동일하게 간주됨.

2.2 목표 지향적 행동 부족

- LLM은 주어진 협상 데이터를 기반으로 응답을 생성하지만, 협상 목표를 적극적으로 추구하는 행동 설계가 없음.

- 예를 들어, "최대한 많은 자원을 얻는다"는 목표가 있더라도 LLM이 이를 계획적으로 최적화하지 않음.

2.3 환경 상호작용의 부족

- 협상 중 발생하는 동적인 변화(상대방의 선호도 변경, 새로운 제안 등)에 대해 LLM은 단순한 응답 생성 외에는 적응하지 않음.

- 에이전트라면 상대방의 행동에 기반해 계획을 수정하거나 새로운 전략을 수립해야 함.

3. LLM과 에이전트의 차이를 극복하기 위한 개선 방향

3.1 강화학습(RL) 기반 접근 통합

- LLM을 강화학습(RL)과 결합하여, 명확한 목표를 설정하고 이를 최적화하도록 설계.

- 예시:

- 환경에서 "보상 함수"를 설정하여 협상 결과에 따라 점수를 부여.

- LLM이 학습 과정에서 전략적으로 최적의 행동을 선택하도록 개선.

- 예시:

3.2 행동 계획과 실행 통합

- 플래너-액터 모델 도입:

- LLM은 협상 전략을 계획(Planning)하고, 실행(Acting) 단계에서 구체적인 응답을 생성.

- 예: "상대방이 물을 포기했으니, 나는 음식을 제안해야 한다."

3.3 멀티에이전트 시스템(Multi-agent System) 실험

- 협상 과정에서 여러 에이전트가 서로 협력하거나 경쟁하는 시나리오를 구현.

- 상황: A와 B가 협상할 때, C라는 중재 에이전트가 개입하여 협상을 조정.

4. 논문의 실제 구현과 "Agent"라는 용어 사용에 대한 의견

4.1 논문의 한계

- 논문은 "LLM이 협상 대화에서 좋은 성능을 보인다"는 점에 중점을 둔 평가 연구임.

- Agent라는 용어를 사용했지만, 전통적인 AI 에이전트의 속성(자율성, 환경 적응 등)을 구현하지 않음.

4.2 "LLM 기반 시스템"으로의 용어 변경 필요

- "Agent" 대신 "LLM 기반 협상 시스템"으로 명확히 정의하는 것이 더 적합.

- 이는 LLM이 단순히 응답 생성 모델로 사용되었음을 강조하면서, 향후 에이전트 설계에서의 발전 가능성을 남길 수 있음.

5. 향후 연구를 위한 제안

- Agent로서의 특성 부여:

- LLM 기반 시스템에 자율성과 목표 지향적 행동을 추가하기 위한 RL 및 계획 알고리즘 통합.

- 실시간 적응:

- 환경 변화나 상대방의 새로운 정보에 따라 전략을 수정할 수 있는 시스템 설계.

- 협상 전략의 구체화:

- 에이전트가 스스로 목표를 설정하고, 이를 실행 가능한 행동으로 변환할 수 있도록 설계.

결론적으로, 이 논문은 "LLM을 활용한 협상 시스템"으로 이해하는 것이 적절하며, Agent라는 용어의 적용은 과도하다고 볼 수 있습니다. 이를 개선한 연구 방향으로 "강화학습과 계획 기반 LLM 에이전트"를 제안합니다.

논문의 타당성을 면밀하게 검증하고, 발전시킬 점에 대해 정리해줘

논문의 타당성 검증

1. 논문의 기여와 강점

- LLM 평가를 위한 체계적 프레임워크 설계:

- 협상 에이전트의 4가지 핵심 능력(이해, 주석, 파트너 모델링, 응답 생성)을 기준으로 35개의 태스크를 설계.

- 협상 과정(Start, During, End)을 분리해 단계별로 평가.

- 다양한 모델 비교:

- GPT-4, GPT-3.5, Mistral-7B, Vicuna-13B 등 여러 모델을 Zero-shot, Few-shot, CoT 프롬프트 방식으로 평가.

- 특히 GPT-4가 협상 대화에서 다른 모델보다 우수함을 체계적으로 입증.

- 정량적 및 정성적 평가 병행:

- 정량적 지표: Accuracy, Macro-F1, Pearson Correlation Coefficient(PCC).

- 정성적 평가: 전문가가 Coherence(맥락 적합성)와 Strategy(전략적 적합성)를 평가.

- 이로 인해 단순 정답률 평가를 넘어 실제 대화 품질을 측정.

- 협상 대화 연구 확대:

- 기존 협상 연구(Lewis et al., 2017; He et al., 2018)와 달리, 주관적 요소(만족도, 호감도)를 다룸.

- 협상 데이터셋(CRA, DND, CA, JI)을 사용하여 실험 범위를 확장.

2. 논문의 한계점

- Agent의 자율성과 목표 지향적 행동 부족:

- LLM은 주어진 데이터에 대한 응답 생성만 수행하며, 전통적 의미의 에이전트 특성(자율성, 환경 적응, 목표 지향성)을 갖추지 못함.

- "Agent"라는 용어를 사용했지만, LLM의 단순한 응답 생성 기능에 머물러 있음.

- 동적인 협상 시나리오 미반영:

- 모든 협상은 고정된 선호도와 정적인 환경에서 진행.

- 현실적인 협상에서는 선호도가 변경되거나 예측할 수 없는 상황 변화가 발생하는데, 이를 반영하지 못함.

- 전략적 사고와 장기적 계획 부족:

- 모델은 협상 목표를 적극적으로 추구하거나 장기적인 결과를 고려한 행동을 수행하지 않음.

- 예: 불공정한 제안을 거부하거나 새로운 전략을 제안하는 능력 부족.

- 작은 모델의 성능 개선 미흡:

- GPT-4와 같은 대규모 모델에 비해 Vicuna-13B, Mistral-7B 등 소규모 모델의 성능이 낮음.

- 소규모 모델 개선 방안이나 경량화 모델의 실제 활용 가능성에 대한 논의가 부족.

- 주관적 평가의 불안정성:

- PCC(상관 계수)를 사용해 인간과의 만족도 추론을 평가했지만, 일부 태스크에서는 인간 판단과 상충하는 결과를 보임.

- 예시: 모델이 상대방의 만족도를 과소평가하거나 과대평가.

발전 가능성과 제안

1. Agent의 자율성과 목표 지향성 강화

- 강화학습(RL) 통합:

- 협상 목표(예: 점수 극대화)를 명시적으로 설정하고, 이를 최적화하는 학습 구조 도입.

- 예시: 상대방의 제안을 분석하고, "최적 제안"을 생성하는 정책 학습.

- 플래너-액터 구조 도입:

- 플래너(Planner): 협상 전략 수립.

- 액터(Actor): 전략을 실행하며 대화 생성.

2. 동적 환경에서의 적응성 강화

- 실시간 변화 반영:

- 상대방의 선호도 변경이나 새로운 제안에 따라 모델이 적응하도록 설계.

- 예: "상대방이 물을 포기하겠다고 선언했으니, 장작에 더 높은 가치를 부여."

- 다중 에이전트 협상 시뮬레이션:

- 여러 에이전트가 서로 경쟁하거나 협력하는 복잡한 환경 구현.

3. 전략적 사고와 장기적 계획 통합

- 장기적 시나리오:

- 협상 종료 이후 결과를 예측하고, 이를 기반으로 행동을 계획.

- 예: 단기적 손실을 감수하고 장기적 협상 관계를 고려.

- 게임 이론 기반 설계:

- 협상 이론을 통합해 모델이 상대방의 전략을 예측하고 대응.

4. 소규모 모델의 성능 개선

- 지식 증류(Knowledge Distillation):

- GPT-4와 같은 대규모 모델에서 학습된 지식을 소규모 모델로 전이.

- 소규모 모델에서도 협상 전략과 대화 품질을 높이는 데 활용.

- Task-specific Fine-tuning:

- 협상 시나리오에 최적화된 소규모 모델 학습.

5. 주관적 평가의 신뢰성 개선

- 사용자 맞춤형 평가:

- 협상 상대방의 개인적 선호도나 심리 상태를 반영한 평가 지표 개발.

- 인간 평가자 피드백 강화:

- 전문가 평가와의 상관성을 높이기 위해 LLM의 응답 스타일과 전략 개선.

결론

이 논문은 LLM이 협상 대화에서 유용할 수 있음을 체계적으로 입증했지만, Agent로서의 완전한 자율성과 적응성을 구현하지 못했다는 한계가 있습니다. 이를 극복하기 위해 강화학습, 동적 시나리오 반영, 전략적 사고 강화와 같은 방법론적 개선이 필요합니다.

앞으로의 연구는 이 논문을 기초로, 진정한 의미의 "AI 협상 에이전트"를 개발하는 데 초점을 맞추어야 할 것입니다.

결과와 마무리에 대해 정리해줘

논문의 결과와 결론

1. 결과 요약

- GPT-4의 성능 우수성:

- GPT-4는 다양한 협상 태스크(이해, 주석, 파트너 모델링, 응답 생성)에서 다른 LLM보다 높은 성능을 보여줌.

- 특히 정량적 태스크(예: 협상 항목의 점수 계산)와 CoT(Chain-of-Thought) 프롬프트 활용에서 탁월한 결과.

- 소규모 모델의 한계:

- Mistral-7B, Vicuna-13B와 같은 소규모 모델은 성능이 제한적이며, 주로 Majority-baseline 수준에 머무름.

- 소규모 모델은 복잡한 전략 태스크에서 상대적으로 낮은 정확도를 보임.

- 주관적 태스크의 어려움:

- LLM은 인간의 심리 상태(만족도, 호감도)를 추론하는 데 제한적이며, 일부 결과는 인간의 판단과 상충.

- 예: 협상 결과에 대한 상대방의 만족도를 과대 또는 과소 평가.

- Coherence와 Strategy의 격차:

- GPT-4는 문맥 적합성(Coherence)에서 높은 평가를 받았지만, 전략적 적합성(Strategy)에서는 한계가 존재.

- 이는 LLM이 전략적 사고보다는 문맥에 맞는 응답을 생성하는 데 더 능숙함을 나타냄.

- Few-shot 및 CoT 프롬프트의 효과:

- CoT 프롬프트는 다단계 논리가 필요한 태스크에서 성능을 크게 향상.

- Few-shot 학습은 일부 태스크에서 긍정적인 영향을 미쳤지만, 모든 태스크에서 일관된 효과를 보이지는 않음.

2. 결론

- LLM의 협상 능력 검증:

- GPT-4는 협상 대화에서 유용한 능력을 보여주며, 향후 협상 시스템 설계에 활용 가능.

- 주석 자동화, 대화 분석, 교육 및 데이터 수집 자동화와 같은 실질적 응용 가능성을 입증.

- 한계점 인식:

- 협상 대화에서 인간과 유사한 심리 상태 추론과 전략적 사고는 여전히 부족.

- 정적인 협상 시뮬레이션 환경만 다루었으며, 현실적인 동적 변화는 반영하지 못함.

- 작은 모델의 성능 향상 필요:

- 소규모 오픈소스 모델은 대규모 모델(GPT-4)에 비해 협상 태스크에서 성능이 부족.

- 더 넓은 응용 가능성을 위해 소규모 모델 개선이 필요.

- 추가 연구 방향 제시:

- 강화학습(RL)과 결합하여 LLM 기반 협상 에이전트가 전략적이고 목표 지향적인 행동을 하도록 설계.

- 동적 선호 변화나 실시간 적응 능력을 포함한 더 복잡한 협상 시나리오로 확장.

3. 마무리: 연구 기여와 의의

- 본 논문은 LLM의 협상 능력을 체계적으로 평가하며, 협상 대화 연구의 새로운 지평을 열었다고 볼 수 있음.

- 특히, GPT-4의 협상 대화 응용 가능성을 입증함으로써, 대화형 AI 에이전트 설계에 중요한 기초 자료를 제공.

4. 발전 가능성

- 본 연구를 통해 LLM의 한계를 극복하고, 자율성과 목표 지향성을 강화한 진정한 AI 협상 에이전트를 설계하는 데 기여할 수 있음.

- 이는 AI 에이전트의 사회적 상호작용, 인간-컴퓨터 협력, 문제 해결 영역으로 확장 가능성을 시사함.

이 연구의 결과는 LLM의 현재 능력과 한계를 정확히 드러냄으로써, 향후 협상 AI 에이전트 설계를 위한 중요한 발판이 됩니다. 이를 바탕으로 향후 연구는 더 높은 자율성과 적응성을 갖춘 협상 에이전트를 목표로 해야 할 것입니다.

사용자가 작성한 요약은 논문의 핵심 내용을 간결하게 정리했지만, 일부 표현은 더 구체적이거나 명확하게 수정할 수 있습니다. 아래는 원문을 분석한 뒤, 수정 및 보완한 내용입니다.

수정 및 보완된 요약

원문 요약

읽다 보니 이 논문이 왜 Agent인지 모르겠는 논문이었습니다.

Agent라면서 데이터를 활용하는 것도, 동적으로 데이터를 인터넷에서 받아오는 것도, 여러 LLM이 회의하는 것도 아니었네요.

협상을 위해 필요한 능력을 나누고, 프로세스를 눴네요.

그 후 데이터 셋도 만들고, 여러 모델 비교를 진행했으나 결국 GPT가 제일 좋았네요 ㅎㅎ...

수정된 요약

읽다 보니 이 논문이 왜 "Agent"라고 불리는지 이해하기 어려운 부분이 있었습니다.

논문에서 언급한 "Agent"는 전통적인 AI 에이전트의 특성(자율성, 환경 적응, 목표 지향적 행동)을 구현하지 않았습니다.

예를 들어, 동적으로 데이터를 받아들이거나 인터넷에서 정보를 수집하거나, 여러 LLM이 협업하는 방식은 포함되지 않았습니다.

다만, 협상을 위한 주요 역량(이해, 주석, 파트너 모델링, 응답 생성)을 체계적으로 정의하고, 프로세스를 정리한 점은 인상적입니다.

또한, 협상 데이터셋을 구성하고, 여러 모델을 비교했으나, 결과적으로 GPT-4가 가장 우수한 성능을 보였다는 결론에 이르렀습니다.

결론적으로, 이 논문은 협상 대화에서 LLM의 가능성과 한계를 평가한 좋은 연구이지만, 진정한 의미의 "Agent" 설계로 보기에는 부족한 점이 있었습니다.

수정 및 보완 이유

- Agent라는 용어 사용 문제:

- 사용자가 언급한 Agent의 정의 부족 문제는 타당합니다. 이를 전통적인 AI 에이전트 정의와 연결해 명확히 지적하였습니다.

- 표현 구체화:

- "데이터를 활용하는 것도 아니었다"는 표현을 LLM의 한계(데이터 수집 및 실시간 처리 부족)로 구체화.

- 논문의 강점 강조:

- 협상 역량 정의, 프로세스 정리, 데이터셋 설계 및 모델 비교라는 논문의 기여를 명확히 부각.

- 결론의 타당성 검토:

- "GPT가 제일 좋았다"는 결과는 맞지만, 이를 통해 논문의 성과와 한계를 더 구체적으로 설명.

이 요약은 원래 사용자가 작성한 요약의 핵심 의도를 살리면서, 논문의 내용과 기여를 더 명확하게 전달하도록 보완했습니다. 추가적으로 논문에서 궁금한 점이 있다면 언제든 말씀해주세요!

'인공지능 > 논문 리뷰 or 진행' 카테고리의 다른 글

| LoRA+: Efficient Low Rank Adaptation of Large Models - 리뷰 (1) | 2024.12.03 |

|---|---|

| LoRA: Low-Rank Adaptation of Large Language Models - 논문 리뷰 (0) | 2024.12.02 |

| Voyager: An Open-Ended Embodied Agent with Large Language Models - 논문 리뷰 (29) | 2024.12.01 |

| Progressive Prompts: Continual Learning for Language Models - 논문 리뷰 (0) | 2024.12.01 |

| AgentTuning: Enabling Generalized Agent Abilities for LLMs - 논문 리뷰 (3) | 2024.11.28 |