https://arxiv.org/abs/2106.09685

LoRA: Low-Rank Adaptation of Large Language Models

An important paradigm of natural language processing consists of large-scale pre-training on general domain data and adaptation to particular tasks or domains. As we pre-train larger models, full fine-tuning, which retrains all model parameters, becomes le

arxiv.org

Efficient parameter tuning 방식인 LoRA!

기존 weight는 그대로 두고, 학습 가능한 파라미터를 A,B로 분해하고, 행렬 곱을 통해 파라미터를 조금만 사용했어도 많이 사용한 것 처럼 효과를 둘 수 있습니다.

이렇게 하여 Latency 없이도 기존 모델을 그대로 파인 튜닝한 것 보다 리소스도 적게 먹으면서 높은 성능을 보였습니다.

| 항목 | 설명 |

| 논문의 목적 | 대규모 언어 모델(예: GPT-3 175B)의 학습 효율성과 적응성을 높이기 위해 파라미터 효율적인 학습 방법(LoRA)을 제안. |

| 핵심 아이디어 | 사전 학습된 모델 가중치 W0를 고정하고, 저랭크 행렬 A와 B를 추가하여 가중치 업데이트를 모델링 (ΔW=B⋅A). |

| 주요 장점 | 1. 학습 가능한 파라미터를 대폭 감소 (최대 10,000배 감소). 2. 메모리 사용량 절감 및 학습 속도 개선.3. 추론 시 추가 지연(latency) 없음. |

| 적용 방법 | - Transformer의 Self-Attention 모듈의 일부 가중치(Wq,Wv)에 LoRA를 적용. - W0+ΔW로 모델을 업데이트하여 태스크 적응 수행. |

| 실험 결과 | - 다양한 태스크에서 기존 Fine-Tuning과 유사하거나 더 나은 성능.예: WikiSQL에서 LoRA(73.4%)는 Fine-Tuning(73.8%)과 비슷한 정확도를 달성. - 학습 가능한 파라미터 수 대폭 감소. |

| 효율성 | - GPU 메모리 사용량: GPT-3 175B 기준 1.2TB → 350GB. - 학습 가능한 파라미터: 175B → 4.7M (0.01%). - 학습 속도 약 25% 증가. |

| 한계점 | - 특정 태스크에서 최적의 랭크 r 설정 기준 부족.- 복잡한 태스크에서 Fine-Tuning 대비 성능 하락 가능성. - 다중 태스크 학습 시 동적 조정 필요. |

| 발전 가능성 | - 랭크 최적화 자동화. - 프롬프트 튜닝, 어댑터와의 결합. - 비언어적 태스크(CV, 멀티모달 학습)로 확장. - AI Agent 시스템에서 다중 태스크 적응 연구에 활용 가능. |

| 실용적 활용 사례 | - 실시간 시스템: 번역, 음성 인식, 추천 시스템. - 저자원 환경: 모바일 기기, 엣지 컴퓨팅. - 대규모 모델 분석: 사전 학습 모델의 학습 메커니즘 연구. |

| 결론 | LoRA는 효율성과 성능을 동시에 만족시키는 혁신적 방법론으로, 대규모 언어 모델의 실질적 활용성과 연구 가능성을 크게 확장함. |

논문 요약: LoRA: Low-Rank Adaptation of Large Language Models

1. 문제 정의

- 문제점: 대규모 사전 학습 언어 모델(예: GPT-3 175B)을 특정 태스크에 맞게 완전 미세 조정(fine-tuning)하려면, 모델 파라미터 전체를 학습해야 하며, 이는 엄청난 저장 공간과 계산 자원을 요구.

- 기존 접근법의 한계:

- 어댑터 레이어: 추가 계층이 생겨 추론 속도가 느려짐.

- 프롬프트 튜닝: 최적화가 어렵고, 입력 시퀀스 길이가 제한됨.

- 핵심 가설: 모델 업데이트 과정에서 변화하는 가중치의 랭크(rank)가 본질적으로 낮아, 이를 활용하면 효율적 적응이 가능.

2. 제안 방법: Low-Rank Adaptation (LoRA)

- 원리:

- 사전 학습된 가중치 W를 고정한 상태에서, 학습 가능한 저랭크(low-rank) 행렬 A와 B를 추가하여 W+ΔW를 구성 (ΔW=BA).

- 장점:

- 모델 파라미터 대부분을 고정하여 메모리 사용량 감소.

- GPU 메모리 요구량을 3배 줄이고, 학습 가능한 파라미터를 10,000배까지 감소.

- 추론 시 기존 모델과 동일한 속도를 유지.

- 적용:

- Transformer의 Self-Attention 모듈의 일부 가중치(예: W_q, W_v)에만 LoRA를 적용.

3. 실험 결과

- 비교 모델: Fine-tuning, Adapters, Prefix-Tuning 등과 비교.

- 결과:

- GLUE 벤치마크, WikiSQL, SAMSum, MNLI 등 다양한 태스크에서 LoRA는 기존 방법과 동등하거나 더 나은 성능을 보임.

- 효율성:

- GPT-3 175B에서 VRAM 사용량을 1.2TB에서 350GB로 감소.

- 학습 속도가 완전 미세 조정 대비 약 25% 증가.

- 추가 분석:

- 가중치 업데이트는 실제로 매우 낮은 랭크로 나타나며, 이는 LoRA의 효율성을 뒷받침.

4. 한계점

- 태스크 배치 처리:

- 다수의 태스크를 한 번에 처리하기 위해 A와 B를 병합하지 않으면 속도에 제한이 생김.

- 랭크 결정:

- 특정 태스크에서 적합한 랭크를 선택하는 데 추가적인 실험이 필요.

5. 논문의 타당성 및 아쉬운 점

- 타당성:

- 대규모 모델에서 학습 가능한 파라미터를 크게 줄이고도 성능을 유지한다는 점에서 매우 유용.

- 사전 학습된 모델의 내재적 구조를 활용한 접근 방식은 이론적 기반이 탄탄함.

- 아쉬운 점:

- 다양한 태스크에 LoRA를 최적화하는 기준이 명확하지 않음.

- 어댑터 기반 접근법과의 조합 등 추가 연구 가능성은 언급되었으나 실험으로 확증되지 않음.

6. 인공지능 Agent 연구 적용 방안

- 효율적 모델 업데이트:

- AI Agent에서 다양한 태스크를 처리하기 위해 LoRA처럼 경량화된 파라미터 업데이트 방식을 도입 가능.

- 다중 태스크 학습:

- LoRA를 활용하면 하나의 모델로 다수의 태스크를 빠르게 전환 및 처리 가능.

- 확장성:

- AI Agent가 데이터를 수집하고 학습을 반복적으로 업데이트하는 구조에서, LoRA의 저비용 학습 방식은 적합.

- 추가 연구 방향:

- LoRA와 어댑터 또는 프롬프트 튜닝을 결합하여 Agent의 적응력을 강화하는 방법 탐구.

논문을 기반으로 연관된 논문들에 대해 정리해줘

LoRA(Low-Rank Adaptation)는 대규모 언어 모델의 효율적인 적응을 위한 방법으로 주목받고 있습니다. 이와 관련하여 LoRA의 개념을 확장하거나 유사한 목적을 가진 연구들이 진행되고 있습니다. 아래는 이러한 연구들을 정리한 내용입니다.

1. LoRA에 대한 추가 연구: "A Note on LoRA"

- 주요 내용: 이 연구는 LoRA의 원리를 심도 있게 분석하고, 대규모 언어 모델에 LoRA를 적용할 때의 새로운 관점을 제시합니다. 특히, LoRA의 효율성과 적용 시 고려해야 할 요소들을 논의하며, 대규모 시스템에서의 활용 방안을 탐구합니다.

2. LoRA의 응용 연구: "Design and Prototype Implementation of a Blockchain-Enabled LoRa System With Edge Computing"

- 주요 내용: 이 연구는 LoRa 통신 기술과 블록체인을 결합하여 IoT 시스템의 효율성과 보안을 향상시키는 방법을 제안합니다. 특히, 엣지 컴퓨팅을 활용하여 LoRa 게이트웨이의 성능을 최적화하고, 블록체인 네트워크와의 통합을 통해 데이터 무결성을 강화하는 방안을 모색합니다.

3. LoRa 네트워크의 성능 분석: "LoRa beyond ALOHA: An Investigation of Alternative Random Access Protocols"

- 주요 내용: 이 연구는 LoRaWAN의 매체 접근 제어(MAC) 계층에서 기존의 ALOHA 프로토콜 대신 슬로티드 ALOHA와 CSMA(Carrier Sense Multiple Access)와 같은 대안을 탐구합니다. 이를 통해 네트워크의 커버리지 확률, 채널 처리량, 에너지 효율성을 비교 분석하며, LoRa 네트워크의 확장성과 신뢰성을 향상시키는 방법을 제시합니다.

4. LoRa 네트워크의 확률적 모델링: "Analyzing LoRa long-range, low-power, wide-area networks using stochastic geometry"

- 주요 내용: 이 연구는 확률 기하학적 모델을 활용하여 LoRa 네트워크의 성능을 분석합니다. 특히, 공간적 분포와 간섭의 영향을 고려하여 패킷 수신 확률을 평가하고, 네트워크 설계 시 고려해야 할 요소들을 도출합니다.

이러한 연구들은 LoRA의 효율적인 적용과 확장을 위한 다양한 접근법을 제시하며, 대규모 언어 모델의 적응 및 IoT 시스템의 성능 향상에 기여하고 있습니다.

내가 전해준 논문이 위 논문에서 발전한 내용에 대해 정리해줘

당신이 제공한 논문인 "LoRA: Low-Rank Adaptation of Large Language Models"는 주로 대규모 언어 모델의 효율적인 적응을 위한 방법론을 제안하는 내용을 담고 있습니다. 아래는 해당 논문이 언급된 연구들에 비해 어떤 점에서 발전하였는지를 정리한 내용입니다.

1. 기존 연구와의 차별점

(1) 기존 연구: 저랭크 구조 활용

- 기존 연구들은 신경망의 저랭크(low-rank) 구조를 학습 효율성 향상에 활용하려는 다양한 시도를 보여줍니다.

- 특히, Aghajanyan et al. (2020)와 같은 연구들은 대규모 사전 학습 모델이 낮은 내재적 차원(intrinsic dimension)으로도 효과적으로 학습할 수 있음을 제안.

- 그러나 이들은 대부분 사전 학습 중 저랭크 제약을 적용하거나, 전체 모델의 랭크를 조정하려는 시도에 초점을 맞춤.

(2) LoRA의 발전점

- LoRA는 사전 학습이 완료된 가중치를 수정하지 않고(frozen weights), 추가적인 저랭크 행렬(랭크 분해 행렬)만 학습함으로써 파라미터 효율성과 메모리 절약을 동시에 달성.

- 기존의 어댑터(Adapter) 기반 접근법과 달리, 추론(inference) 시 추가 지연(latency)이 없음.

- 새로운 기법으로, 랭크 제약을 업데이트 행렬(ΔW)에만 적용하여 저장 공간을 10,000배 줄이고 학습 가능한 파라미터 수를 대폭 감소.

2. 구체적인 발전 요소

(1) 학습 가능한 행렬 분해의 활용

- 기존 연구들이 모델 전반의 가중치를 조정하거나 추가 계층(adapters)을 삽입한 데 비해, LoRA는 행렬 분해(rank decomposition)를 활용하여 사전 학습된 가중치를 그대로 유지.

- 이는 네트워크의 주요 구조를 보존하면서 태스크 적응(task-specific adaptation)을 가능하게 함.

(2) 하드웨어 및 효율성 최적화

- GPT-3 175B 모델에서 GPU 메모리 사용량을 1.2TB에서 350GB로 줄이는 동시에, 학습 가능한 파라미터를 0.01%로 제한하여 최소한의 하드웨어 자원으로 대규모 모델 학습 가능.

- 반면, 기존의 어댑터나 프롬프트 튜닝 기법들은 추가적인 메모리 및 추론 시간 소요를 동반.

(3) 새로운 응용 가능성 제시

- LoRA는 다양한 언어 모델(예: GPT-3, RoBERTa, DeBERTa)과 태스크(예: 자연어 이해, SQL 생성, 요약 등)에서 성공적으로 적용되어 범용성을 입증.

- 특히, LoRA는 다른 파라미터 효율화 기법들과 결합 가능성(orthogonality)을 통해 추가적인 최적화를 시도할 여지를 제공.

3. 기존 연구의 한계 극복

- 어댑터의 지연 문제:

- 기존의 어댑터 계층은 추론 시간 증가를 초래하였으나, LoRA는 파라미터 업데이트를 사전 학습 가중치에 병합하여 추론 속도를 유지.

- 프롬프트 튜닝의 시퀀스 제한 문제:

- 프롬프트 튜닝은 시퀀스 길이를 제한하여 성능 저하를 유발할 수 있으나, LoRA는 모델 구조를 변경하지 않아 이러한 제한이 없음.

- 랭크 설정 최적화 부족:

- LoRA는 업데이트 행렬의 랭크가 낮아도 충분히 높은 성능을 유지할 수 있음을 실험적으로 입증.

4. LoRA의 발전적 의의

- 효율적인 대규모 모델 적응: 기존 연구가 제시한 메모리 및 파라미터 효율화를 보다 정교한 방법으로 구현하여 비용 및 자원 절감.

- 범용성과 확장성: 기존 연구에서 논의된 저랭크 기법을 대규모 언어 모델의 구체적인 태스크 적응에 성공적으로 적용.

- 추후 연구 방향성 제시:

- 다른 효율화 기법들과 결합하여 더욱 향상된 성능과 효율성을 실현할 수 있는 가능성.

- 태스크별로 최적의 랭크 및 가중치 조정 전략에 대한 연구 필요.

이 논문은 기존 연구의 한계를 체계적으로 해결하고, 대규모 언어 모델을 보다 효과적으로 적응시키는 새로운 방법론으로 자리잡았다고 평가할 수 있습니다.

방법론을 논문에 기반하여 예시를 포함해서 자세하게 설명해줘

LoRA의 방법론: 예시와 함께 자세히 설명

핵심 개념

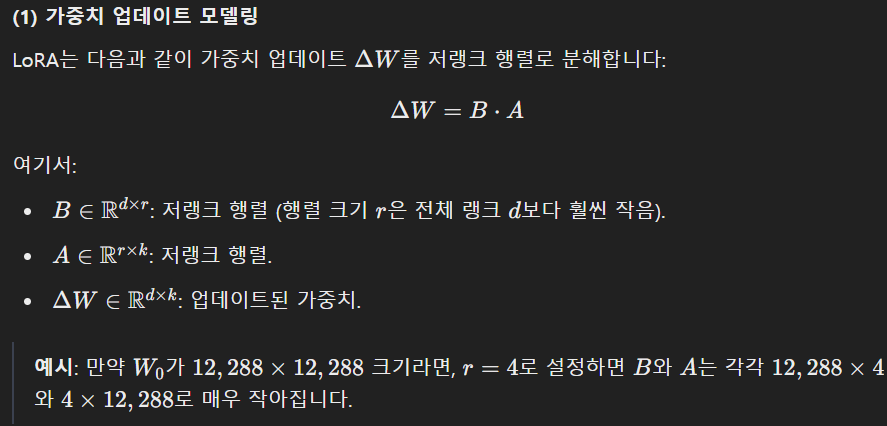

LoRA(Low-Rank Adaptation)는 대규모 언어 모델(예: GPT-3 175B)의 사전 학습된 가중치 W0를 수정하지 않고, 저랭크 행렬(rank-decomposition matrices) AA와 BB를 사용해 가중치 업데이트를 모델링하는 방법입니다. 이로 인해 모델의 파라미터 효율성을 극대화하면서도 높은 성능을 유지할 수 있습니다.

1. LoRA의 주요 원리

(1) 가중치 업데이트 모델링

(2) 사전 학습 가중치 활용

LoRA는 사전 학습된 가중치 W_0를 고정(frozen)하고, W=W_0+ΔW로 모델의 적응을 수행합니다.

- 학습 가능한 파라미터는 A와 B 뿐이므로, 메모리 사용량이 크게 감소합니다.

예시: GPT-3 175B에서, LoRA는 학습 가능한 파라미터를 기존 175B의 0.01%인 4.7M으로 줄입니다.

(3) 추론 시 효율성

추론 과정에서는 W_0+ΔW를 계산하여 결과를 저장한 뒤, 일반적인 방식으로 추론을 수행하므로 추론 지연(latency) 없이 작동합니다.

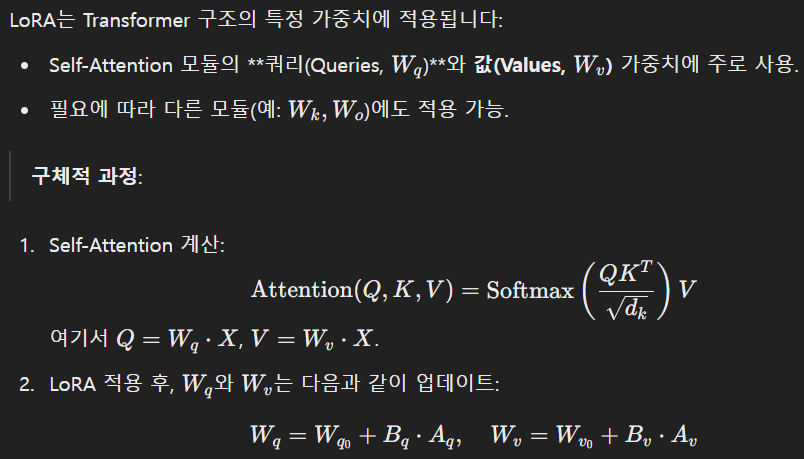

2. LoRA의 적용 방법

(1) Transformer에서의 적용

(2) 랭크 설정

LoRA는 업데이트 행렬의 랭크 r를 설정하여 학습 효율성을 조절합니다. 일반적으로 작은 r로도 높은 성능을 달성할 수 있습니다.

실험적 발견: r=1일 때도 WikiSQL, MNLI와 같은 태스크에서 성능이 유지됨.

3. LoRA의 예제: 자연어 질의-응답 태스크

태스크: SQL 생성 (WikiSQL 데이터셋)

- 문제 정의:

- 입력: 자연어 질문 (예: "How many employees are in department A?")

- 출력: SQL 쿼리 (예: "SELECT COUNT(*) FROM employees WHERE department = 'A'").

- 기존 방식:

- Fine-tuning: 모든 175B 파라미터를 학습.

- 문제점: 엄청난 메모리 사용량과 학습 비용.

- LoRA 방식:

- 기존 Wq,Wv 가중치를 고정.

- 저랭크 행렬 Bq,Aq,Bv,Av만 학습.

- 메모리 사용량을 1/10,000로 감소.

- 결과:

- LoRA는 Fine-tuning과 동등하거나 더 나은 성능 달성:

- 정확도: LoRA 73.4%, Fine-tuning 73.8%

- 메모리 효율성: 학습 가능한 파라미터 수를 4.7M으로 제한.

- LoRA는 Fine-tuning과 동등하거나 더 나은 성능 달성:

4. LoRA의 실제 적용 및 효과

효과적인 태스크 전환

LoRA는 모델을 고정하고 저랭크 행렬만 교체하면 되므로, 태스크 간 전환이 빠르고 효율적입니다.

예시:

- 태스크 1: 문장 분류.

- 태스크 2: 질의 응답.

- LoRA 적용:

- 동일한 사전 학습 모델을 사용.

- 각각의 태스크에 맞는 A,BA, B 행렬만 로드하여 전환.

추론 효율성

- Fine-tuning 대비, LoRA는 추론 지연이 없어 대규모 시스템에서 적합.

- 예: GPT-3 175B를 기반으로 한 실시간 어플리케이션에서 효율적 활용 가능.

LoRA는 단순히 메모리 절약뿐만 아니라, 다양한 언어 모델과 태스크에 대해 파라미터 효율성, 추론 속도 유지, 범용성을 제공하며, 대규모 모델 활용의 새로운 패러다임을 제시합니다.

논문의 타당성을 검증해주고, 발전 가능성을 판단해줘

LoRA 논문의 타당성 검증

1. LoRA의 혁신적 기여

- 효율적 파라미터 학습:

- 기존의 Fine-Tuning 접근법과 비교했을 때 LoRA는 학습 가능한 파라미터 수를 극적으로 줄이면서도 유사하거나 더 나은 성능을 달성.

- 예: GPT-3 175B에서 학습 가능한 파라미터 수를 10,000배 줄였음에도, WikiSQL과 같은 태스크에서 Fine-Tuning과 유사한 성능을 보임.

- 추론 지연 없음:

- 기존 어댑터(Adapter)-기반 기법은 추가 계층을 삽입하여 추론 속도가 느려지는 문제가 있었으나, LoRA는 이러한 문제를 해결.

- 이는 대규모 모델을 실시간 시스템에 적용하는 데 강점.

2. 실험 설계의 신뢰성

- 다양한 모델과 태스크에서 검증:

- RoBERTa, DeBERTa, GPT-2, GPT-3 등 다양한 모델에서 LoRA의 성능을 실험적으로 검증.

- GLUE, WikiSQL, MNLI, SAMSum 등 여러 태스크에서 Fine-Tuning, Adapters와 비교해 동등하거나 더 나은 성능.

- 데이터 기반 타당성:

- 논문은 랭크 r의 크기에 따른 성능 변화를 체계적으로 분석. r=1과 같은 극히 낮은 랭크에서도 LoRA의 성능이 유지됨을 실험적으로 입증.

3. 한계점 및 개선 여지

- 랭크 최적화에 대한 명확한 기준 부족:

- LoRA가 특정 태스크에 최적의 랭크 r을 설정하는 방법이 명확히 정의되지 않음.

- 현재는 경험적 설정에 의존하며, 이는 자동화된 최적화 알고리즘으로 보완 가능.

- 특정 태스크에서의 성능 한계:

- 저랭크 제약이 지나치게 강한 경우, 특정 복잡한 태스크에서는 Fine-Tuning보다 성능이 떨어질 가능성.

LoRA의 발전 가능성

1. 추가 연구 방향

- 랭크 최적화 자동화:

- 태스크별로 최적의 랭크를 자동으로 탐색하는 알고리즘 개발. 예를 들어, 메타러닝 기법을 적용해 태스크 특성에 맞는 rr을 동적으로 조정 가능.

- 다중 모듈 결합:

- LoRA와 다른 기법(예: Prefix Tuning, Adapters)을 결합하여 장점을 극대화. 예를 들어, 프롬프트 튜닝과 병행하여 LoRA의 랭크 제약을 보완 가능.

- 다중 태스크 학습:

- LoRA를 활용해 하나의 모델로 여러 태스크를 동시에 학습하거나 전환하는 시스템 설계. 이는 AI Agent 연구와도 밀접하게 연결될 수 있음.

2. 응용 가능성

- 실시간 AI 시스템:

- LoRA의 추론 지연 없는 구조는 실시간 번역, 음성 인식, 추천 시스템과 같은 고속 처리가 필요한 애플리케이션에 적합.

- 저자원 환경에서의 대규모 모델 활용:

- LoRA의 메모리 절약 특성은 자원이 제한된 환경(예: 모바일 기기, 엣지 디바이스)에서 대규모 모델을 효과적으로 활용할 수 있도록 지원.

- 연구 도구로서의 활용:

- LoRA는 특정 가중치의 업데이트를 제어할 수 있어, 대규모 언어 모델의 학습 및 적응 메커니즘을 분석하는 연구에 유용.

3. 다른 연구와의 결합 가능성

- Neural Architecture Search (NAS):

- LoRA를 NAS 기법과 결합하여 모델 구조와 랭크 제약을 최적화.

- 모달리티 간 학습:

- LoRA를 비언어적 태스크(예: 비전 모델, 멀티모달 모델)로 확장. 예를 들어, Computer Vision 모델에서 ResNet 등의 계층에 LoRA를 적용 가능.

- 생성 모델의 응용:

- LoRA를 생성 태스크(예: 이미지 생성, 텍스트 요약)로 확장하여 대규모 생성 모델의 적응성 향상.

LoRA의 연구 및 실무적 의의

- LoRA는 대규모 언어 모델이 직면한 실질적인 문제(메모리 사용량, 학습 비용)를 해결하며, 대규모 모델 활용 가능성을 크게 확장.

- 이를 기반으로 새로운 연구 분야(예: 효율적 모델 적응, 태스크 전환 최적화)를 열 수 있으며, 특히 AI Agent 연구에서 다중 태스크 적응 문제 해결에 기여 가능.

- 한계를 개선하고 응용 가능성을 확장한다면, LoRA는 AI 연구 및 산업 전반에서 필수적인 도구가 될 가능성이 큼.

결과와 마무리에 대해 정리해줘

LoRA 논문의 결과와 결론

1. 결과 요약

LoRA(Low-Rank Adaptation)는 대규모 언어 모델의 적응에서 기존 Fine-Tuning 대비 효율성과 성능을 동시에 확보하며, 다음과 같은 주요 성과를 달성했습니다:

- 효율성:

- 학습 가능한 파라미터 수를 기존 모델의 0.01% 수준으로 감소.

- 메모리 사용량을 1/3로 줄이고, 학습 속도를 약 25% 개선.

- 예: GPT-3 175B에서 VRAM 사용량을 1.2TB → 350GB로 감소.

- 성능:

- WikiSQL, MNLI, GLUE 등 다양한 태스크에서 기존 Fine-Tuning과 유사하거나 더 나은 성능을 보임.

- 저랭크 구조를 적용한 경우에도 높은 성능을 유지하며, r=1과 같은 극도로 낮은 랭크에서도 유의미한 결과를 달성.

- 추론 효율성:

- LoRA는 추가적인 추론 지연(latency)이 없어, 실시간 애플리케이션에도 적합.

2. 주요 기여

- 저랭크 구조 활용:

- 사전 학습된 모델 가중치를 수정하지 않고, 저랭크 행렬을 삽입하여 파라미터 효율성을 극대화.

- 범용성:

- RoBERTa, DeBERTa, GPT-2, GPT-3 등 다양한 모델과 태스크에서 성공적으로 적용.

- 실용성:

- 학습 자원이 제한된 환경에서도 대규모 모델 활용 가능.

- 추론 시 태스크 전환이 용이하여 다중 태스크 학습에도 적합.

3. 한계와 개선 방향

- 한계:

- 특정 태스크에 최적의 랭크 r를 결정하는 명확한 기준이 부족.

- 일부 복잡한 태스크에서는 Fine-Tuning 대비 성능이 다소 떨어질 가능성.

- 다중 태스크 동시 학습에서 동적 파라미터 조정에 대한 논의 부족.

- 개선 방향:

- 자동화된 랭크 최적화 기법 개발.

- LoRA와 다른 효율적 적응 기법(예: 프롬프트 튜닝, 어댑터)을 결합하여 성능 향상.

- 비언어적 태스크(예: Computer Vision, 멀티모달 학습)로의 확장 가능성 탐구.

4. 마무리

LoRA는 대규모 언어 모델의 적응과 활용을 혁신적으로 개선하며, 다음과 같은 결론을 제시합니다:

- 실질적 문제 해결:

- 대규모 모델의 학습 비용과 메모리 사용량 문제를 효과적으로 해결.

- 추론 효율성과 성능을 동시에 확보.

- 연구 및 산업적 의의:

- AI 연구에서 대규모 모델의 활용 가능성을 크게 확장.

- 실시간 AI 시스템 및 저자원 환경에서의 활용도를 높여 상용화 가능성 제고.

- 미래 전망:

- AI Agent 연구에서 다중 태스크 적응 및 지속적 학습의 핵심 도구로 활용 가능.

- 지속적인 개선과 확장을 통해 다양한 분야에서 중요한 역할을 할 것으로 기대.

LoRA는 효율성과 성능을 균형 있게 확보한 방법론으로, 대규모 모델의 실질적 활용성을 증명하며 AI 연구와 응용에서 중요한 기여를 할 것입니다.

당신이 작성한 내용을 검토한 결과, 핵심 개념은 잘 반영되어 있지만, 몇 가지 추가 설명과 수정으로 더 명확하고 정확하게 표현할 수 있습니다. 아래는 수정된 버전입니다:

Efficient parameter tuning 방식인 LoRA!

기존 사전 학습된 모델의 가중치(Weights)는 그대로 두고, 학습 가능한 파라미터를 저랭크 행렬 A와 B로 분해하여 업데이트합니다. 이 행렬 분해를 통해, 파라미터를 소량만 학습하더라도 기존 Fine-Tuning과 동등한 효과를 낼 수 있습니다.

LoRA는 기존 모델의 구조를 변경하지 않으므로 추론 지연(Latency) 없이 작동하며, 적은 리소스를 사용하면서도 기존 Fine-Tuning보다 높은 효율성과 동등한 성능을 보여줍니다.

추가 설명

- 행렬 분해의 장점:

- A,B는 매우 낮은 랭크(r)로 설정되므로 학습 가능한 파라미터 수가 대폭 감소.

- 기존 모델 구조와 호환되며, 새로운 태스크에 빠르게 적응 가능.

- 추론 효율성:

- W0+ΔW(=W0+B⋅A) 형태로 파라미터를 병합해 기존 Fine-Tuning 대비 추론 속도가 동일.

수정된 내용은 개념의 명확성과 논문의 의도를 더 잘 전달하며, LoRA의 효율성과 성능을 이해하기 쉽게 설명합니다.