https://arxiv.org/abs/2312.11970

Large Language Models Empowered Agent-based Modeling and Simulation: A Survey and Perspectives

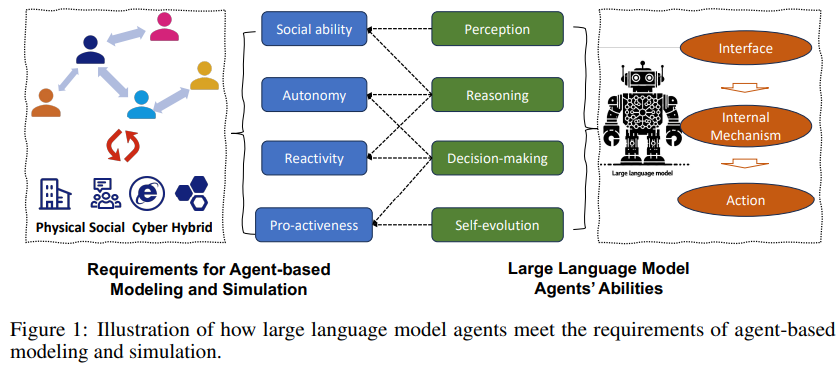

Agent-based modeling and simulation has evolved as a powerful tool for modeling complex systems, offering insights into emergent behaviors and interactions among diverse agents. Integrating large language models into agent-based modeling and simulation pre

arxiv.org

| 논문의 목적 | LLM 기반 에이전트를 활용하여 기존 Agent-Based Modeling and Simulation(ABM&S)의 한계를 극복하고, 더 인간과 유사한 시뮬레이션을 수행. |

| 해결하고자 하는 문제 | - 기존 에이전트의 환경 적응 및 학습 능력 부족 - 복잡한 사회적/경제적/물리적 행동을 재현하는 데 한계 - 에이전트 간 상호작용 및 의사결정의 비현실성 |

| 사용된 방법 | - LLM의 강력한 자연어 처리, 추론, 학습 능력을 활용 - 시뮬레이션 환경과 에이전트 간 상호작용을 JSON 및 텍스트 인터페이스로 설계 - 학습과 피드백 기반의 동적 행동 업데이트 적용 |

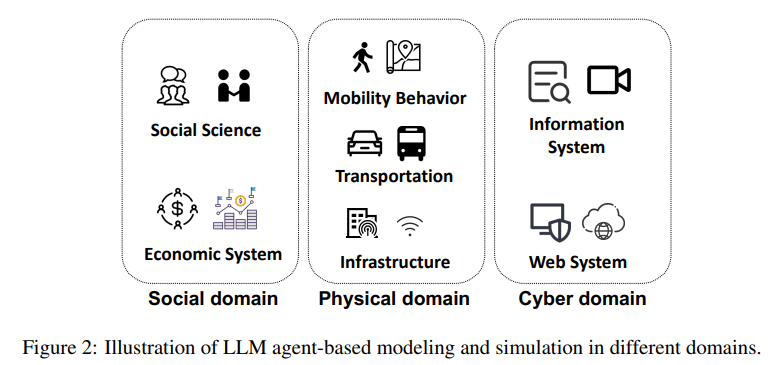

| 주요 도메인 및 실험 | |

| - 사회적 도메인 | 1. 사회적 네트워크 시뮬레이션: 소셜 미디어 데이터를 기반으로 정보 확산과 감정 변화를 모델링 (예: S3 시스템) 2. 협력 행동 시뮬레이션: LLM 에이전트가 팀워크 및 협력 작업 수행 (예: ChatDev) |

| - 경제적 도메인 | 1. 개인 행동: 인간과 유사한 경제적 의사결정 실험 (예: 독재자 게임) 2. 시장 행동: 기업 간 경쟁, 가격 전략 시뮬레이션 (예: Bertrand 듀오폴리 게임) |

| - 물리적 도메인 | 1. 내비게이션: 물리적 환경에서 경로 계획 및 장애물 회피 시뮬레이션 (예: LM-Nav) 2. 운전: 자율주행 시뮬레이션에서 인간 운전자의 행동 재현 (예: CARLA 시뮬레이터) |

| - 하이브리드 도메인 | 1. 도시 시뮬레이션: 인간의 이동, 사회적 상호작용, 경제 활동을 통합 모델링 (예: UGI) 2. 전염병 시뮬레이션: 다중 확산 패턴을 시뮬레이션하여 정책 효과 평가 |

| LLM 에이전트의 강점 | - 지각: JSON 및 텍스트 데이터를 기반으로 환경을 이해 - 추론: 복잡한 문제를 논리적으로 분석하고 최적 행동 선택 - 적응: 환경 변화에 따라 행동 정책 업데이트 및 학습 |

| 결과 | - LLM 에이전트는 인간과 유사한 행동 패턴 재현 - 실제 데이터를 기반으로 사회적, 경제적, 물리적 시뮬레이션에서 현실성 입증 - 협력과 경쟁 같은 집단 행동에서 emergent behavior 확인 |

| 한계점 | - 학습 데이터의 편향 반영 및 증폭 가능성 - 계산 자원의 높은 요구사항 - 감정, 직관 등 완벽한 인간 행동 재현의 어려움 |

| 논문의 기여 | - 기존 ABM&S에서 LLM 활용의 가능성을 체계적으로 검토 - 다양한 도메인에서 LLM 기반 시뮬레이션의 성과를 실험적으로 입증 - 향후 연구 방향(윤리성, 데이터 최적화 등) 제안 |

| 미래 연구 방향 | - 하이브리드 도메인에서 더 정교한 시뮬레이션 설계 - 윤리적 편향 문제를 완화하는 모델 개발 - 계산 자원 최적화를 위한 경량화된 LLM 활용 |

논문 요약 및 분석

1. 문제가 된 배경과 해결하고자 하는 문제

- 배경: Agent-Based Modeling and Simulation(ABM&S)은 복잡한 시스템을 모델링하고 시뮬레이션하기 위한 강력한 도구입니다. 그러나 기존의 시뮬레이션 모델은 에이전트의 지능, 환경에 대한 반응성, 자율성, 학습 및 적응 능력에서 한계가 있었습니다.

- 해결 목표:

- 기존 모델이 처리하지 못했던 복잡한 환경 시뮬레이션을 가능하게 하고자 함.

- 에이전트 간 상호작용과 의사결정을 더 인간과 유사하게 만듦으로써 시뮬레이션의 현실성을 높이고자 함.

- 물리적, 사회적, 사이버 및 하이브리드 환경에서 복잡한 시뮬레이션 문제를 해결.

2. 사용된 방법

- Large Language Models (LLMs) 활용:

- LLM의 자연어 처리 능력, 추론 능력, 자기 진화 능력을 활용하여 에이전트를 강화.

- 주요 구성 요소:

- 지각: 환경 정보를 정확히 인식 및 해석.

- 추론과 의사결정: 규칙 기반 모델보다 높은 수준의 의사결정을 가능케 함.

- 적응과 학습: 동적인 환경에서 적응하며 스스로 학습.

- 이질성 및 개인화: 에이전트마다 다양한 속성과 행동을 부여.

- 환경 설계:

- 가상 및 실제 환경을 구축.

- 텍스트 기반 인터페이스를 통해 에이전트가 환경과 상호작용.

- 시뮬레이션 평가:

- 시뮬레이션 결과의 현실성 검증 (실제 데이터와 비교).

- 에이전트 행동의 윤리적 측면 평가 (편향 및 공정성 확인).

3. 결과

- LLM 기반 에이전트는 기존의 규칙 기반 및 기계 학습 모델을 넘어 더 현실적인 시뮬레이션을 가능케 함.

- 사회적, 경제적, 물리적 및 하이브리드 환경에서의 시뮬레이션에 성공적으로 적용됨.

- 예: 경제 시스템에서 협력과 경쟁의 동시 시뮬레이션, 물리적 환경에서 인간과 유사한 내비게이션 동작 구현.

4. 한계점

- 복잡성 관리:

- 에이전트 간 상호작용이 증가할수록 시스템의 복잡성이 기하급수적으로 증가.

- 데이터 제한:

- 도메인 특화 데이터 부족으로 일부 시뮬레이션에서 예측 정확도가 낮음.

- 윤리적 문제:

- LLM이 훈련 데이터의 편향을 반영하거나 증폭시킬 가능성 존재.

- 범용성 부족:

- 특정 환경에 특화된 에이전트 설계가 다른 환경에 적합하지 않을 수 있음.

5. 논문의 타당성

- 강점:

- LLM을 활용한 시뮬레이션이 기존 방식의 한계를 극복할 수 있음을 이론적, 실험적으로 입증.

- 복잡한 시스템의 시뮬레이션에 대한 체계적인 프레임워크를 제시.

- 다양한 도메인에서의 성공 사례로 실효성을 확인.

- 아쉬운 점:

- 일부 제안된 방법은 실제 대규모 환경에서 테스트되지 않았음.

- LLM의 비용 및 계산 자원 요구 사항에 대한 논의 부족.

6. 연구 적용 가능성

- AI 에이전트 연구 방향:

- LLM의 학습 및 적응 능력을 활용하여 더 인간과 유사한 에이전트를 설계.

- 환경 변화를 실시간으로 반영할 수 있는 동적 시뮬레이션 시스템 개발.

- 통합된 시스템:

- 사회적, 경제적, 물리적 요소를 결합한 하이브리드 시뮬레이션 시스템 구축.

- 윤리적 고려 사항을 반영한 모델 개발.

- 데이터 증강 및 튜닝:

- 더 다양한 데이터셋을 활용하여 LLM 에이전트의 예측 성능 강화.

이 요약은 인공지능 에이전트를 연구하고자 하는 당신의 목적에 부합하는 주요 통찰을 제공합니다. 추가로 논문 세부 정보를 통해 특정 전략을 강화하거나 실험 설계를 구체화할 수 있습니다.

논문에 대한 설명이 잘 이해가지 않아

좀 더 자세하게 설명해주라

논문 내용을 Chain-of-Thought 방식으로 더 체계적으로 자세히 설명하겠습니다.

1. 연구 배경

- Agent-Based Modeling and Simulation (ABM&S):

- ABM&S는 복잡한 시스템의 동작을 분석하고 이해하기 위해 각 개별 단위를 에이전트(agent)로 설정하여 시뮬레이션하는 방법입니다.

- 예를 들어:

- 도시 교통 시뮬레이션: 자동차, 보행자, 신호등 같은 요소를 각각 에이전트로 설정.

- 경제 시스템: 소비자, 기업 등을 에이전트로 두어 상호작용을 분석.

- 하지만 기존 ABM&S는 한계가 있었습니다:

- 에이전트가 환경 변화에 제대로 반응하지 못하거나, 학습 능력이 부족.

- 인간 수준의 복잡한 의사결정을 시뮬레이션하기 어려움.

- Large Language Models (LLMs) 도입 필요성:

- LLM (예: GPT-4)은 언어 이해, 추론, 의사결정 등에서 강력한 성능을 보이며, 이를 에이전트 시뮬레이션에 활용하면 기존의 문제를 해결할 수 있음.

- LLM을 에이전트 설계에 사용하면:

- 더 나은 환경 인식: 다양한 입력을 이해하고 해석 가능.

- 고급 의사결정: 복잡한 시뮬레이션에서도 인간과 유사한 판단 가능.

- 자율적 행동: 미리 정의된 규칙 없이도 스스로 새로운 계획을 세우고 행동 가능.

2. 해결하고자 하는 문제

- 기존 시뮬레이션의 한계:

- 에이전트가 복잡한 환경에서 유연하게 대처하지 못함.

- 상호작용이 단순하여 현실의 복잡한 사회적 행동을 재현하지 못함.

- LLMs 도입으로 해결 가능성:

- LLM은 자연어 기반으로 환경과 상호작용하며, 학습된 지식을 활용해 상황에 따라 행동을 바꿀 수 있음.

- 에이전트를 보다 인간적이고 현실적인 수준으로 끌어올릴 수 있음.

3. LLM 기반 에이전트의 핵심 기술

- 지각 능력 (Perception):

- 에이전트가 텍스트, 이미지, 데이터 등 다양한 형태의 입력을 이해.

- 예: 도시 시뮬레이션에서 교통 상황 데이터를 읽고, 도로 혼잡을 판단.

- 추론과 의사결정 (Reasoning & Decision-making):

- LLM은 단순한 규칙 기반 시스템보다 더 정교한 추론과 의사결정을 수행.

- 예: 경제 시뮬레이션에서 최적의 시장 가격을 결정.

- 적응과 학습 (Adaptivity & Evolution):

- LLM은 새로운 데이터를 학습해 변화하는 환경에 적응.

- 예: 사회적 시뮬레이션에서 사용자 행동 변화에 따라 에이전트 행동 업데이트.

- 이질성 및 개인화 (Heterogeneity & Personalization):

- 에이전트마다 서로 다른 행동 패턴과 성격을 부여.

- 예: 협력적 에이전트, 이기적인 에이전트 설정.

4. 연구 방법

- 환경 구축:

- 가상 환경 (예: 게임 세계)과 실제 환경 (예: 도시 교통 시스템)을 포함.

- 환경과 에이전트 간 상호작용을 텍스트 인터페이스로 설계.

- 에이전트 간 상호작용:

- 에이전트끼리 대화하거나 (텍스트 기반) 공동 작업을 수행하도록 설계.

- 예: 소프트웨어 개발 시뮬레이션에서 각 에이전트가 개발, 테스트, 문서화를 담당.

- 행동 시뮬레이션:

- 에이전트가 과거 경험(메모리)을 기반으로 행동을 계획.

- 잘못된 행동을 반영하고 수정(반성)하여 행동을 개선.

- 평가 및 검증:

- 시뮬레이션 결과를 실제 데이터와 비교해 현실성을 검증.

- 에이전트 행동의 윤리성(편향, 공정성 등) 평가.

5. 주요 결과

- 사회적 도메인:

- 사회적 행동 재현 (예: 군중 행동, 의견 변화).

- 협력 시뮬레이션 (예: 여러 에이전트가 함께 문제 해결).

- 경제적 도메인:

- 시장 행동, 가격 책정, 협상 같은 경제 활동 모델링.

- 게임 이론 시뮬레이션 (예: 죄수의 딜레마, 경매 게임).

- 물리적 도메인:

- 내비게이션 (예: 인간과 유사한 경로 찾기).

- 운전 시뮬레이션 (예: 충돌 방지, 차선 변경).

- 하이브리드 도메인:

- 여러 도메인을 통합한 복잡한 시스템 시뮬레이션.

- 예: 도시 계획, 전염병 확산 시뮬레이션.

6. 한계점

- 복잡성 증가:

- 에이전트와 환경이 복잡해질수록 계산 자원이 많이 소모됨.

- 데이터 부족:

- 특정 도메인에서 LLM 성능을 충분히 발휘하기 위한 학습 데이터가 부족.

- 윤리적 문제:

- 훈련 데이터의 편향성이 에이전트 행동에 반영될 가능성.

7. 타당성과 아쉬운 점

- 타당성:

- 다양한 도메인에서 LLM 기반 시뮬레이션의 유효성을 입증.

- 기존 모델보다 높은 수준의 현실성 제공.

- 아쉬운 점:

- 실제 대규모 환경에서의 검증 부족.

- 계산 자원 및 비용 문제를 다루지 않음.

8. 당신의 연구 방향 제안

- AI 에이전트 설계:

- LLM의 적응 능력을 활용해 에이전트를 설계.

- 동적 환경에서 실시간으로 적응하는 시스템 구축.

- 하이브리드 시뮬레이션:

- 사회, 경제, 물리적 요소를 통합한 시뮬레이션 설계.

- 윤리적 고려:

- 편향을 줄이고 공정성을 보장하는 에이전트 설계.

- 데이터 활용:

- 도메인별 특화된 데이터셋을 수집해 성능 최적화.

이 구조를 기반으로 연구를 계획한다면, LLM 에이전트의 강점을 활용하여 복잡한 시스템 시뮬레이션을 효율적으로 설계할 수 있을 것입니다. 추가 질문이나 특정 부분의 세부 정보가 필요하다면 말씀해주세요!

그럼 지각은 시뮬레이션에서 보내주는 Json이나 숫자들을 받아서 Perception하고, LLM 내부에서 알아서 추론하여 행동을 업데이트 하면서 점차 배우는 거야?

네, 정확히 그런 방식으로 작동합니다. 시뮬레이션 환경에서 에이전트가 JSON 데이터나 숫자 등 구조화된 정보를 입력으로 받는다고 가정하면, LLM은 이를 다음과 같은 단계로 처리할 수 있습니다:

1. JSON 또는 숫자 데이터로부터 지각 (Perception)

- LLM은 입력된 JSON이나 숫자를 텍스트로 변환하거나, 미리 설계된 프롬프트 구조를 통해 이를 이해합니다.

- 예: {"position": [10, 20], "velocity": [1, -1], "goal": [50, 50]}라는 JSON을 받는다면, 이를 다음과 같은 방식으로 이해:

- 현재 위치: (10, 20)

- 속도: (1, -1)

- 목표 위치: (50, 50)

- 예: {"position": [10, 20], "velocity": [1, -1], "goal": [50, 50]}라는 JSON을 받는다면, 이를 다음과 같은 방식으로 이해:

- 프롬프트로 변환:

You are at position (10, 20) with a velocity of (1, -1). Your goal is to reach (50, 50). What will you do next?2. 추론 및 행동 계획 (Reasoning & Action Planning)

- LLM 내부 추론:

- JSON 데이터를 바탕으로 환경 상태를 이해하고, 시뮬레이션 규칙과 목표에 따라 추론을 수행합니다.

- 내부적으로 LLM은 자연어 처리를 통해 데이터를 맥락화하고, 행동을 계획합니다.

- 예를 들어:

- 현재 위치에서 목표 위치까지 최소 거리를 계산.

- 충돌 가능성을 예측하거나 장애물을 회피하는 최적 경로를 설계.

- 행동 업데이트:

- 행동은 텍스트 기반으로 출력되거나, 다시 구조화된 JSON으로 반환될 수 있습니다.

- 예: {"action": "move", "direction": [1, 0], "speed": 2}로 반환.

3. 학습 및 적응 (Learning & Adaptation)

- 반복적 피드백 루프:

- 에이전트가 행동을 실행한 후 시뮬레이션 환경으로부터 피드백을 받습니다.

- 예: 충돌 발생, 목표와의 거리 감소 등.

- 추론 능력 강화:

- LLM은 이러한 피드백을 바탕으로 자신의 행동 정책을 조정합니다.

- 예: Reinforcement Learning with Prompting 또는 In-context Learning을 활용해 더 나은 행동을 학습.

- 메모리와 반성:

- LLM은 이전 행동과 결과를 기억하고, 반성(reflection)을 통해 최적화된 계획을 세웁니다.

- 예: 특정 상황에서 실패한 전략은 배제하거나 조정.

4. 점진적 발전

- 반복 실행을 통해 에이전트는:

- 환경 상태에 대한 이해도가 점점 향상됩니다.

- 목표를 더 효율적으로 달성하기 위해 행동 정책을 발전시킵니다.

- 자율적이고 인간과 유사한 에이전트로 진화.

예시: 자율 주행 시뮬레이션

- 시뮬레이션이 다음 데이터를 보냄:

{

"position": [5, 10],

"obstacle": [[8, 12], [15, 20]],

"goal": [20, 30]

} - LLM은 이를 이해:

Your current position is (5, 10). There are obstacles at (8, 12) and (15, 20). Your goal is at (20, 30). What path will you take to avoid obstacles and reach the goal?

- 행동 출력:

{

"action": "move",

"path": [[6, 11], [10, 15], [20, 30]]

}

이 방식은 특히 복잡한 환경에서의 적응성과 학습을 강조합니다. JSON이나 숫자 데이터를 텍스트로 변환하는 과정과 피드백 루프 설계가 핵심입니다.

그럼 이 논문에선 Agent를 활용하여 어떤 실험을 진행했어?

논문에서는 Large Language Model (LLM) 기반의 에이전트를 활용하여 다양한 도메인에서 실험을 진행했습니다. 여기서는 주요 도메인과 해당 실험 사례를 정리하겠습니다.

1. 사회적 도메인 (Social Domain)

(1) 사회적 네트워크 동역학 시뮬레이션

- 실험 목표:

- LLM 기반 에이전트가 실제 사회적 상호작용과 집단 행동을 얼마나 잘 재현할 수 있는지 테스트.

- 대표 실험:

- S3 (Social Simulation System):

- 실험 내용:

- 실세계 소셜 미디어 데이터를 기반으로 사용자들의 정보 확산, 감정 변화, 행동 변화를 시뮬레이션.

- 예: 젠더 차별 이슈나 핵 에너지와 같은 사회적 주제를 시뮬레이션.

- 결과:

- LLM 에이전트는 감정, 태도, 상호작용 행동을 재현하는 데 성공.

- 실제 사회 현상과 유사한 패턴을 생성.

- 실험 내용:

- S3 (Social Simulation System):

(2) 협력 행동 시뮬레이션

- 실험 목표:

- 협력적 문제 해결에서 에이전트 간 상호작용을 모델링.

- 대표 실험:

- CHATDEV:

- 내용: LLM 에이전트들이 소프트웨어 개발 회사의 역할(CEO, 프로그래머 등)을 맡아 프로젝트를 수행.

- 결과: 각 역할이 협력적으로 설계, 개발, 테스트, 문서화를 수행하여 실제 팀워크처럼 작동.

- COLA:

- 내용: 서로 다른 역할(분석가, 토론자, 요약자)을 맡은 에이전트들이 소셜 미디어 텍스트의 입장을 판단.

- 결과: 인간 평가보다 높은 정확도로 입장 분석.

- CHATDEV:

2. 경제적 도메인 (Economic Domain)

(1) 개인 행동 시뮬레이션

- 실험 목표:

- LLM 에이전트가 인간 경제적 행동(예: 소비, 투자)을 얼마나 잘 모방할 수 있는지 확인.

- 대표 실험:

- Horton et al.:

- 내용: LLM 에이전트를 사용해 '독재자 게임', '죄수의 딜레마' 등의 행동경제학 실험 진행.

- 결과:

- LLM 에이전트는 인간과 유사한 공정성, 이타주의, 현상유지 편향 등을 보여줌.

- Horton et al.:

(2) 시장 시뮬레이션

- 실험 목표:

- 경제 시장에서 에이전트가 어떻게 작동하고, 어떤 규칙이 emergent behavior(창발적 행동)를 유도하는지 분석.

- 대표 실험:

- Zhao et al.:

- 내용: 레스토랑 시장에서 가격 책정, 고객 유치 전략 등을 시뮬레이션.

- 결과:

- 매튜 효과: 인기 있는 레스토랑이 더 많은 고객을 끌어들이는 현상.

- 경쟁 전략: 레스토랑이 서로의 가격을 모방하거나 차별화를 시도.

- Han et al.:

- 내용: 베르트랑 듀오폴리 게임을 통해 기업 간 담합 여부 분석.

- 결과:

- 통신 없이도 시장 균형 가격에 수렴.

- 통신이 가능할 경우, 담합으로 독점 가격 형성.

- Zhao et al.:

3. 물리적 도메인 (Physical Domain)

(1) 내비게이션 시뮬레이션

- 실험 목표:

- 에이전트가 물리적 환경에서 사람처럼 이동할 수 있는지 확인.

- 대표 실험:

- LM-Nav:

- 내용: LLM 에이전트가 시뮬레이션 내에서 경로를 계획하고 장애물을 회피하며 목표에 도달.

- 결과: 사람처럼 자연스러운 경로를 설계하며 충돌을 줄임.

- LM-Nav:

(2) 운전 시뮬레이션

- 실험 목표:

- 자율주행 차량에서 LLM 에이전트를 활용한 인간 운전자 모방.

- 대표 실험:

- CARLA 시뮬레이터:

- 내용: LLM 에이전트가 차량 상태와 환경 데이터를 기반으로 속도 조절, 차선 변경, 정지 등을 결정.

- 결과:

- 충돌 확률 감소.

- 인간 운전 패턴과 유사한 행동.

- CARLA 시뮬레이터:

4. 하이브리드 도메인 (Hybrid Domain)

(1) 도시 시뮬레이션

- 실험 목표:

- 복합적인 환경(사회적, 물리적, 사이버적 요소가 결합된 환경)에서 인간 행동 모델링.

- 대표 실험:

- UGI (Urban Generative Intelligence):

- 내용: 도시 내 인간 행동(이동, 사회적 상호작용, 경제 활동) 시뮬레이션.

- 결과:

- 인간과 유사한 행동 패턴 생성.

- 도시 계획 및 정책 시뮬레이션에 활용 가능성 확인.

- UGI (Urban Generative Intelligence):

(2) 전염병 시뮬레이션

- 실험 목표:

- 전염병 확산과 관련된 사회적 행동을 모델링.

- 대표 실험:

- Williams et al.:

- 내용: 전염병의 다중 확산 패턴과 같은 복잡한 사회적 동역학 시뮬레이션.

- 결과:

- 다중 확산 패턴과 실제 전염병 데이터 간의 유사성 확인.

- Williams et al.:

실험 결과 요약

- 사회적 도메인:

- LLM 에이전트는 인간과 유사한 사회적 행동과 상호작용을 성공적으로 재현.

- 경제적 도메인:

- 에이전트 간 협력과 경쟁을 통해 시장 행동을 시뮬레이션.

- 물리적 도메인:

- 내비게이션 및 자율주행과 같은 물리적 행동을 자연스럽게 구현.

- 하이브리드 도메인:

- 도시와 같은 복잡한 환경에서 인간 행동 패턴을 성공적으로 모델링.

결론

논문에서 LLM 기반 에이전트를 활용한 실험은 다양한 도메인에서 실제 데이터를 기반으로 복잡한 행동을 시뮬레이션하는 데 성공했습니다. 이를 통해 기존 시뮬레이션 모델보다 더 현실적이고 정교한 시뮬레이션이 가능함을 입증했습니다.

추가로 특정 실험의 기술적 구현 방식이나 자세한 데이터를 알고 싶다면 말씀해주세요!

그럼 여러 사회적 실험을 통해 LLM이 대다수의 사람과 같은 행동을 한다는 것이네?

네, 논문의 결과를 보면 LLM 기반 에이전트는 여러 사회적 실험에서 대다수 사람과 유사한 행동을 보였음을 입증하고 있습니다. 이는 LLM이 대규모 데이터에서 학습한 결과로, 인간의 언어적, 논리적 패턴을 기반으로 행동을 예측하고 생성하기 때문입니다. 구체적으로 어떤 면에서 인간과 유사한 행동을 보였는지 살펴보겠습니다.

1. 사회적 네트워크 시뮬레이션

- 결과:

- LLM 에이전트는 사회적 네트워크 내에서 정보를 확산하거나 의견을 형성할 때, 실제 인간 사회에서 관찰되는 감정 변화와 태도 형성 패턴을 재현했습니다.

- 예:

- 특정 정보가 긍정적/부정적 감정을 유발하면, 이 감정이 에이전트 간 상호작용을 통해 퍼져나감.

- 소셜 미디어 데이터 기반으로 가짜 뉴스나 논란이 되는 주제(예: 젠더 차별)에 대한 반응을 시뮬레이션할 때, 인간과 유사한 사회적 논쟁 구조가 나타남.

2. 협력 행동

- 결과:

- LLM 에이전트는 협력적 문제 해결 상황에서 사람들이 협력하는 방식과 비슷한 패턴을 보임.

- 예:

- 소프트웨어 개발 환경(ChatDev)에서 각 에이전트가 특정 역할(CEO, 개발자, 테스터 등)을 맡아 상호작용하며 작업을 완수.

- 의견 충돌이 발생해도 협상을 통해 결정을 내리며, 역할 간 조화로운 협력을 보여줌.

3. 인간 행동의 재현

- 사회적 상호작용 실험:

- LLM 에이전트는 Werewolf Game과 같은 규칙 기반 사회 게임에서 신뢰(trust)와 대립(confrontation) 같은 인간의 전략적 상호작용을 재현.

- 특정 상황에서 이타적 행동과 이기적 행동 간 균형을 잡는 패턴을 보임.

- 사회적 편향의 시뮬레이션:

- LLM은 인간 사회에서 발생하는 편향(예: 성별, 문화적 차이)을 반영.

- 연구에서는 LLM이 기존 데이터에서 학습한 편향을 재현하였으며, 이를 통해 인간 사회의 편향적 행동을 이해하고 분석할 수 있음.

4. 협력과 경쟁 시뮬레이션 (게임 이론)

- 죄수의 딜레마(Prisoner’s Dilemma):

- LLM 에이전트는 상대의 행동에 따라 협력(cooperate)하거나 배신(defect)하는 선택을 반복적으로 수행.

- 인간과 비슷하게, 협력적 상대와는 협력하는 경향을 보였고, 배신적 상대에 대해서는 신뢰를 철회.

- 사회적 딜레마:

- 에이전트가 특정 상황에서 공익(public good)을 위해 행동하거나, 자신의 이익을 극대화하려는 행동을 택함.

- 이는 사람들이 이기적 동기와 집단 이익 간 균형을 잡으려는 패턴을 반영.

5. 경제적 행동의 유사성

- 경제적 의사결정 실험:

- 독재자 게임과 같은 실험에서 LLM 에이전트는 공정성(fairness)을 고려한 의사결정을 내림.

- 이는 인간 실험에서 나타나는 행동경제학적 결과와 유사.

- 시장 시뮬레이션:

- LLM 에이전트가 두 레스토랑 간 경쟁에서 가격 전략을 모방하거나 차별화를 시도.

- 이는 인간 시장에서 관찰되는 매튜 효과(강한 자가 더 강해지는 효과)와 비슷한 행동을 보여줌.

LLM의 인간 유사 행동의 이유

- 학습 데이터:

- LLM은 대규모 언어 데이터(인터넷, 책, 논문 등)에서 인간의 의사결정 패턴과 사회적 행동을 학습.

- 자연어 처리:

- 입력 데이터를 기반으로 맥락을 이해하고, 이를 바탕으로 인간과 유사한 결정을 생성.

- 추론 능력:

- 인간처럼 복잡한 문제를 논리적으로 분석하고, 목표 달성을 위한 최적 행동을 선택.

한계점

- 편향의 증폭 가능성:

- LLM이 학습 데이터의 편향을 그대로 반영할 수 있음.

- 예: 특정 문화적 편향, 성별 차별 등의 재현.

- 완전한 인간 행동 재현의 한계:

- 인간의 감정, 직관, 그리고 예외적 행동을 완전히 재현하기는 어려움.

결론

LLM 기반 에이전트는 여러 사회적 실험에서 대다수 인간과 유사한 행동을 재현했으며, 이를 통해 인간 행동을 이해하고 시뮬레이션하는 데 강력한 도구임을 입증했습니다. 하지만, 일부 영역에서는 여전히 개선 여지가 있습니다.

추가적으로, 특정 실험이나 결과에 대한 더 자세한 설명이 필요하다면 말씀해주세요!